OllamaでGemma 3をローカルで実行すると、クラウドサービスに依存せずにAI環境を完全に制御できます。このガイドでは、Ollamaの設定、Gemma 3のダウンロード、およびマシンでの実行方法を説明します。

さあ、始めましょう。

なぜOllamaでGemma 3をローカルで実行するのか?

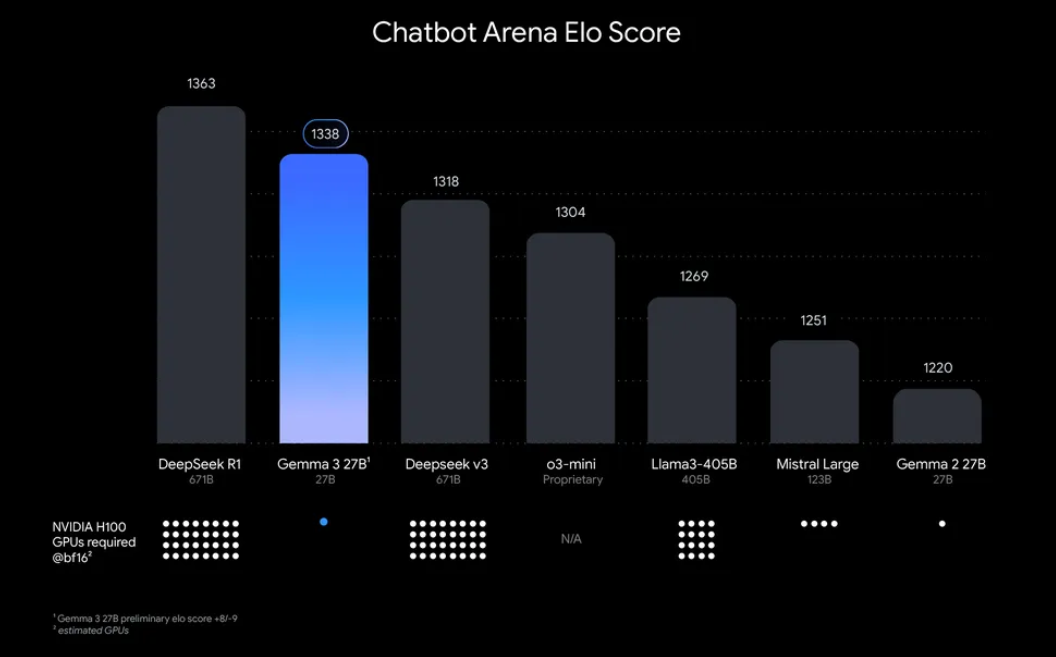

「なぜGemma 3をローカルで実行するのか?」さて、確かに魅力的な理由があります。まず、ローカルデプロイメントにより、データとプライバシーを完全に制御でき、機密情報をクラウドに送信する必要がありません。さらに、API使用料がかからないため、コスト効果があります。また、Gemma 3の効率性により、27Bモデルでも単一のGPUで実行可能で、モデストなハードウェアを持つ開発者にもアクセスしやすくなります。

Ollamaは、多言語モデル(LLM)をローカルで実行するための軽量プラットフォームであり、このプロセスを簡素化します。モデルのウェイト、設定、および依存関係を、使いやすい形式にパッケージにします。このGemma 3とOllamaの組み合わせは、マシン上での実験、アプリケーションの構築、またはAIワークフローのテストに最適です。さあ、袖をまくりあげて始めましょう!

OllamaでGemma 3を実行するために必要なもの

設定に入る前に、以下の前提条件を確認しましょう:

- 互換性のあるマシン: GPU(最適なパフォーマンスのためにはNVIDIAを推奨)または強力なCPUを搭載したコンピュータが必要です。27Bモデルは大量のリソースを必要としますが、1Bや4Bなどの小さいバージョンは、より性能の低いハードウェアでも実行可能です。

- Ollamaのインストール: MacOS、Windows、およびLinux用のOllamaをダウンロードしてインストールします。ollama.comから入手できます。

- 基本的なコマンドラインスキル: ターミナルまたはコマンドプロンプトを介してOllamaと対話します。

- インターネット接続: 最初にGemma 3モデルをダウンロードする必要がありますが、一度ダウンロードすればオフラインで実行できます。

- オプション: APIテスト用のApidog: Gemma 3をAPIと統合したり、そのレスポンスをプログラムでテストしたりする予定がある場合、Apidogの直感的なインターフェースが時間と手間を省いてくれます。

さあ、準備が整ったので、インストールと設定プロセスに入っていきましょう。

ステップバイステップガイド: OllamaのインストールとGemma 3のダウンロード

1. お使いのマシンにOllamaをインストールする

OllamaはローカルLLMのデプロイを簡単にし、インストールも簡単です。手順は以下の通りです:

- MacOS/Windowsの場合: ollama.comにアクセスして、オペレーティングシステム用のインストーラーをダウンロードします。画面の指示に従ってインストールを完了してください。

- Linux(例: Ubuntu)の場合: ターミナルを開いて、次のコマンドを実行します:

curl -fsSL https://ollama.com/install.sh | sh

このスクリプトは、ハードウェア(GPUを含む)を自動的に検出し、Ollamaをインストールします。

インストールが完了したら、次のコマンドを実行してインストールを確認します:

ollama --version

現在のバージョン番号が表示され、Ollamaの準備が整ったことを確認できます。

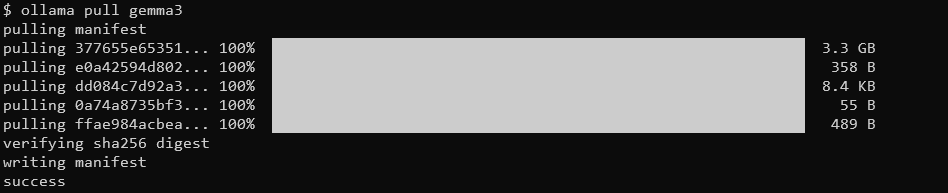

2. Ollamaを使用してGemma 3モデルをプルする

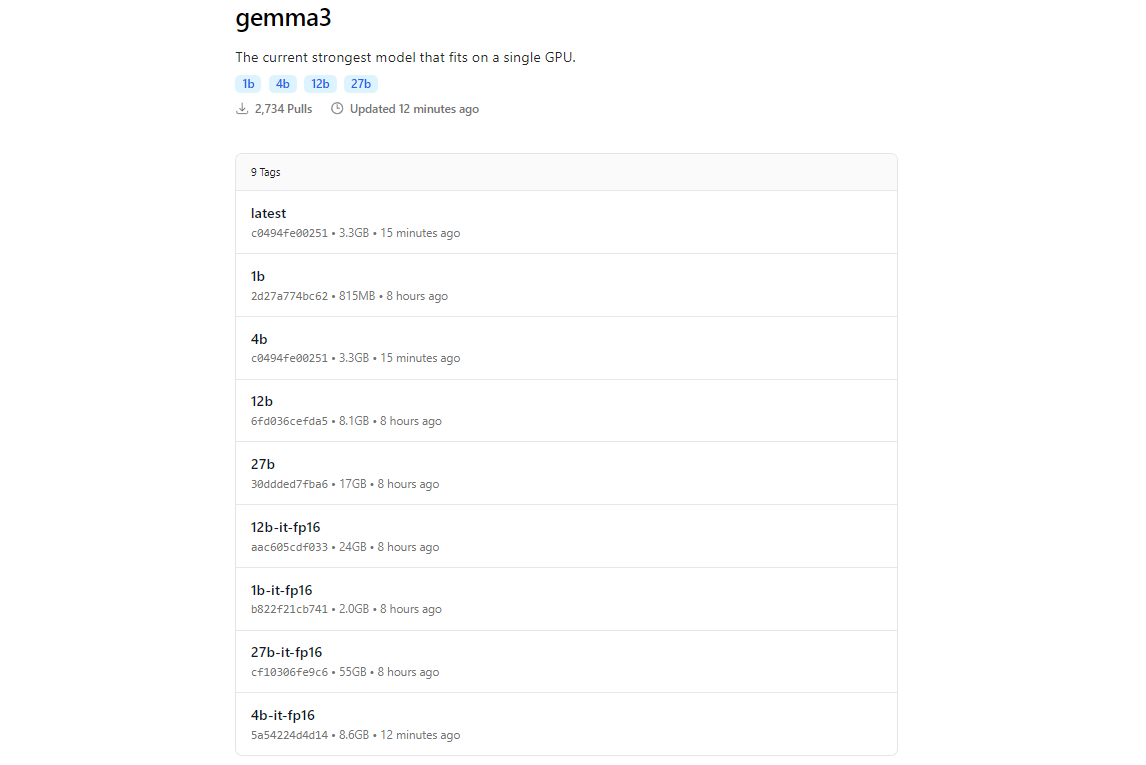

Ollamaのモデルライブラリには、Hugging FaceやGoogleのAI提供サービスとの統合によりGemma 3が含まれています。Gemma 3をダウンロードするには、ollama pullコマンドを使用します。

ollama pull gemma3

小さいモデルの場合は、次のように使用できます:

ollama pull gemma3:12bollama pull gemma3:4bollama pull gemma3:1b

ダウンロードサイズはモデルによって異なり、27Bモデルは数GBになるため、十分なストレージが必要です。Gemma 3モデルは効率性が最適化されていますが、大きなバリエーションには適切なハードウェアを必要とします。

3. インストールの確認

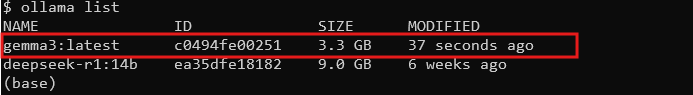

ダウンロードが完了したら、すべてのモデルをリスト表示して、モデルが利用可能であることを確認します:

ollama list

リストにgemma3(または選択したサイズ)が表示されているはずです。それがあれば、Gemma 3をローカルで実行する準備が整いました!

OllamaでのGemma 3の実行: インタラクティブモードとAPI統合

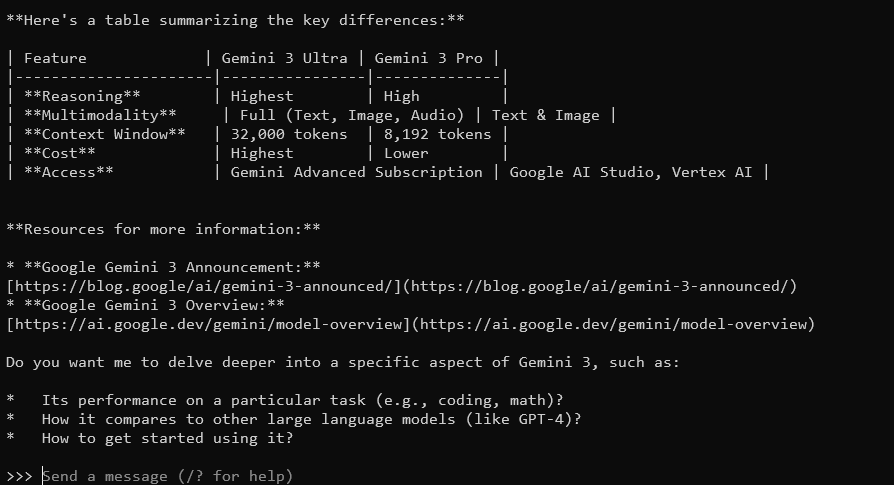

インタラクティブモード: Gemma 3とのチャット

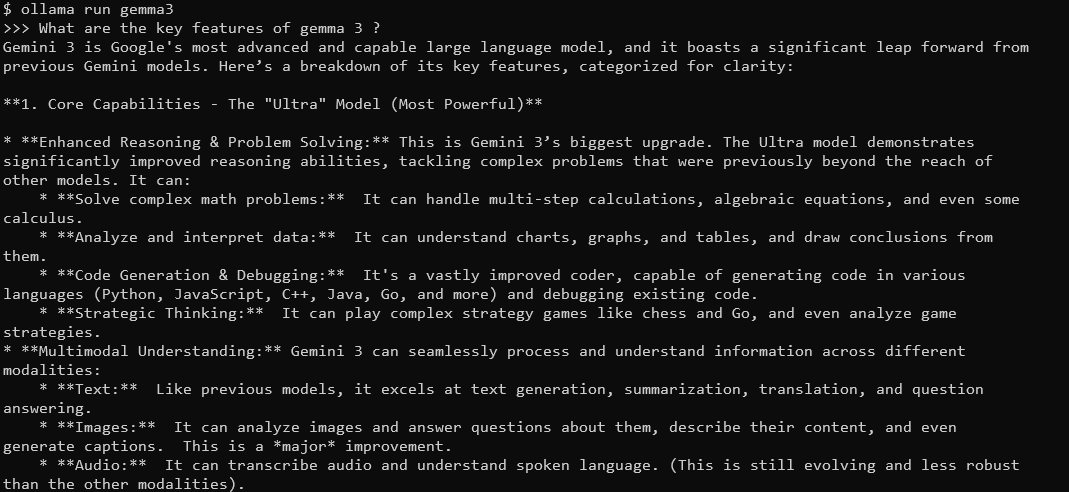

Ollamaのインタラクティブモードを使用すると、ターミナルから直接Gemma 3とチャットできます。開始するには、次のコマンドを実行します:

ollama run gemma3

ここで、クエリを入力できるプロンプトが表示されます。たとえば、次のように試してみてください:

Gemma 3の主要な機能は何ですか?

128Kのコンテキストウィンドウを持つGemma 3は、詳細で文脈に応じた回答を提供します。140以上の言語をサポートし、テキスト、画像、さらには(特定のサイズ用に)動画入力も処理できます。

終了するには、Ctrl+Dまたは/byeと入力してください。

Ollama APIとのGemma 3の統合

アプリケーションを構築したり、インタラクションを自動化したりしたい場合、Ollamaは使用できるAPIを提供します。ここで、Apidogが力を発揮します。そのユーザーフレンドリーなインターフェースにより、APIリクエストを効率的にテストおよび管理できます。開始する方法は以下の通りです:

Ollamaサーバーの開始: OllamaのAPIサーバーを起動するには、次のコマンドを実行します:

ollama serve

これにより、デフォルトでlocalhost:11434にサーバーが開始されます。

APIリクエストの実行: HTTPリクエストを介してGemma 3と対話できます。たとえば、次のようにcurlを使用してプロンプトを送信します:

curl http://localhost:11434/api/generate -d '{"model": "gemma3", "prompt": "フランスの首都はどこですか?"}'

レスポンスには、Gemma 3の出力がJSON形式で含まれます。

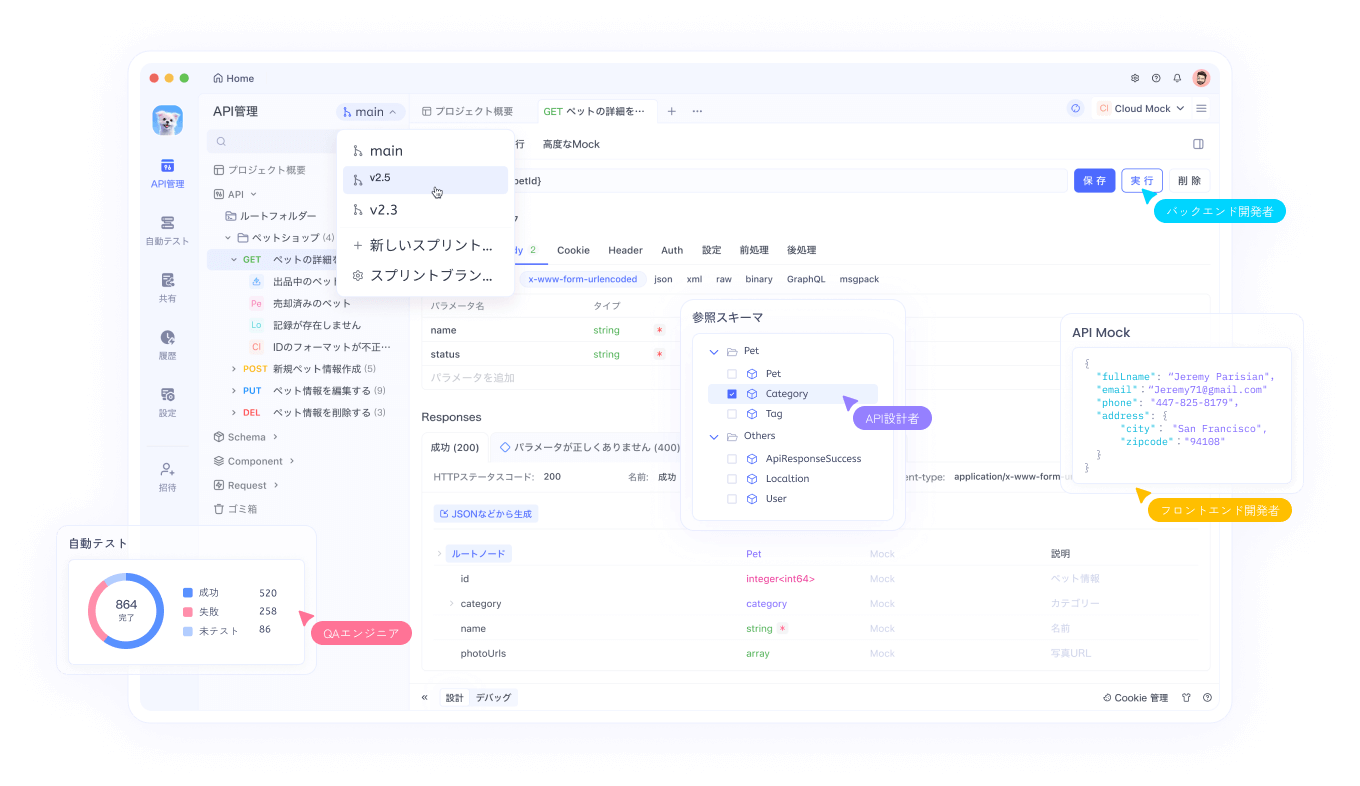

テスト用のApidogの使用: Apidogを無料でダウンロードし、Gemma 3のレスポンスをテストするAPIリクエストを作成します。Apidogのビジュアルインターフェースを使用すると、エンドポイント(http://localhost:11434/api/generate)を入力し、JSONペイロードを設定し、複雑なコードを書くことなくレスポンスを分析できます。これは特にデバッグや統合の最適化に役立ちます。

ApidogでのSSEテストの使用に関するステップバイステップガイド

ApidogのオプティマイズされたSSEテスト機能の使用プロセスを説明しましょう。新しい自動マージ機能を備えています。リアルタイムのデバッグ体験を最大化するために、これらのステップに従って設定してください。

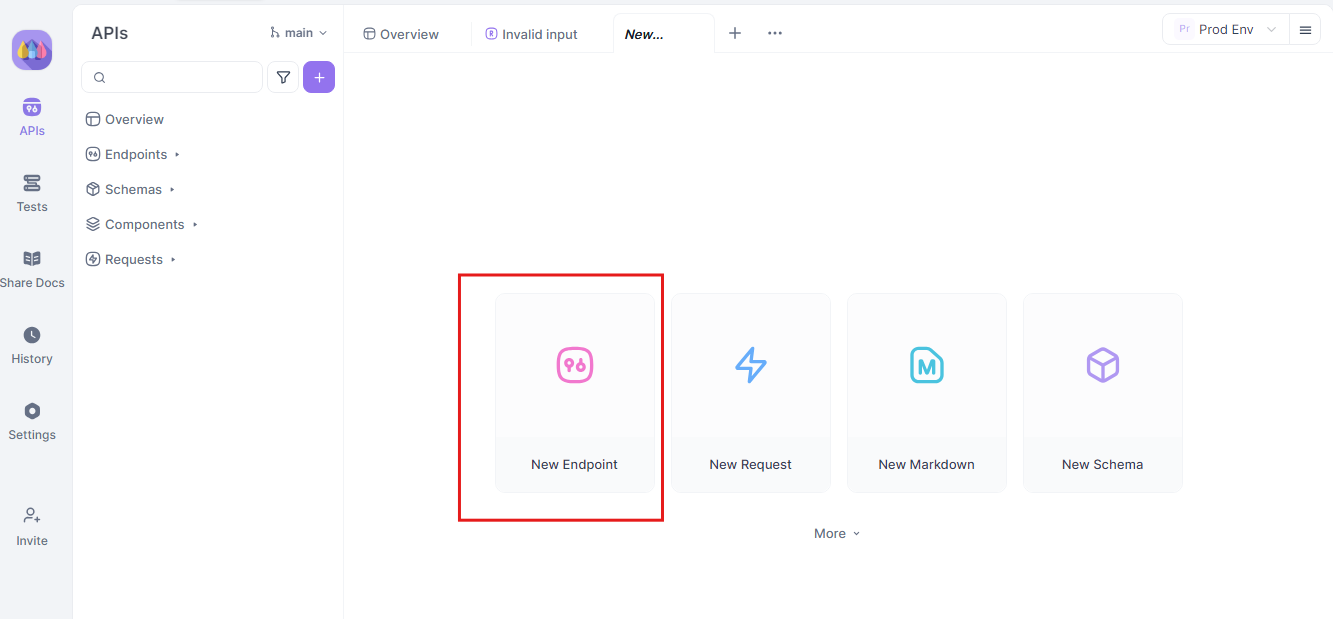

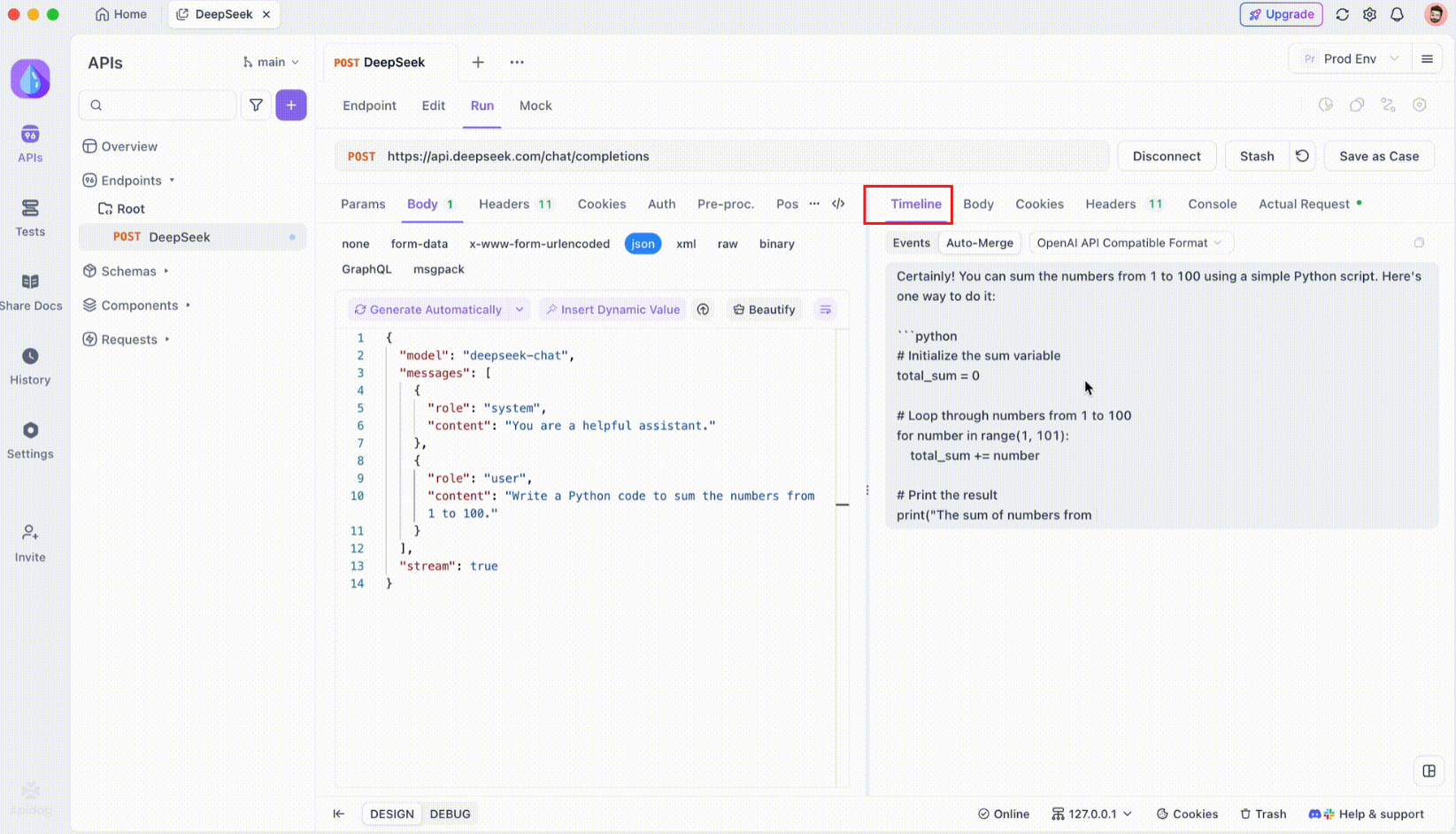

ステップ1: 新しいAPIリクエストを作成する

Apidogで新しいHTTPプロジェクトを立ち上げ、新しいエンドポイントを追加し、APIまたはAIモデルのエンドポイント用のURLを入力します。これがリアルタイムのデータストリームのテストとデバッグの出発点です。

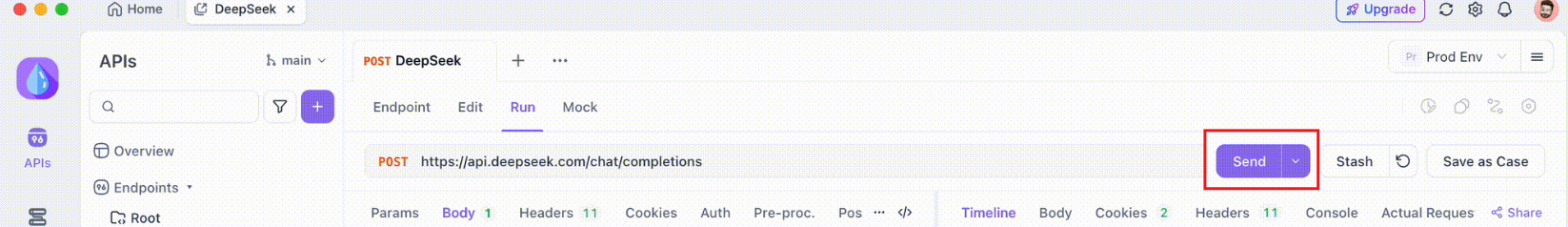

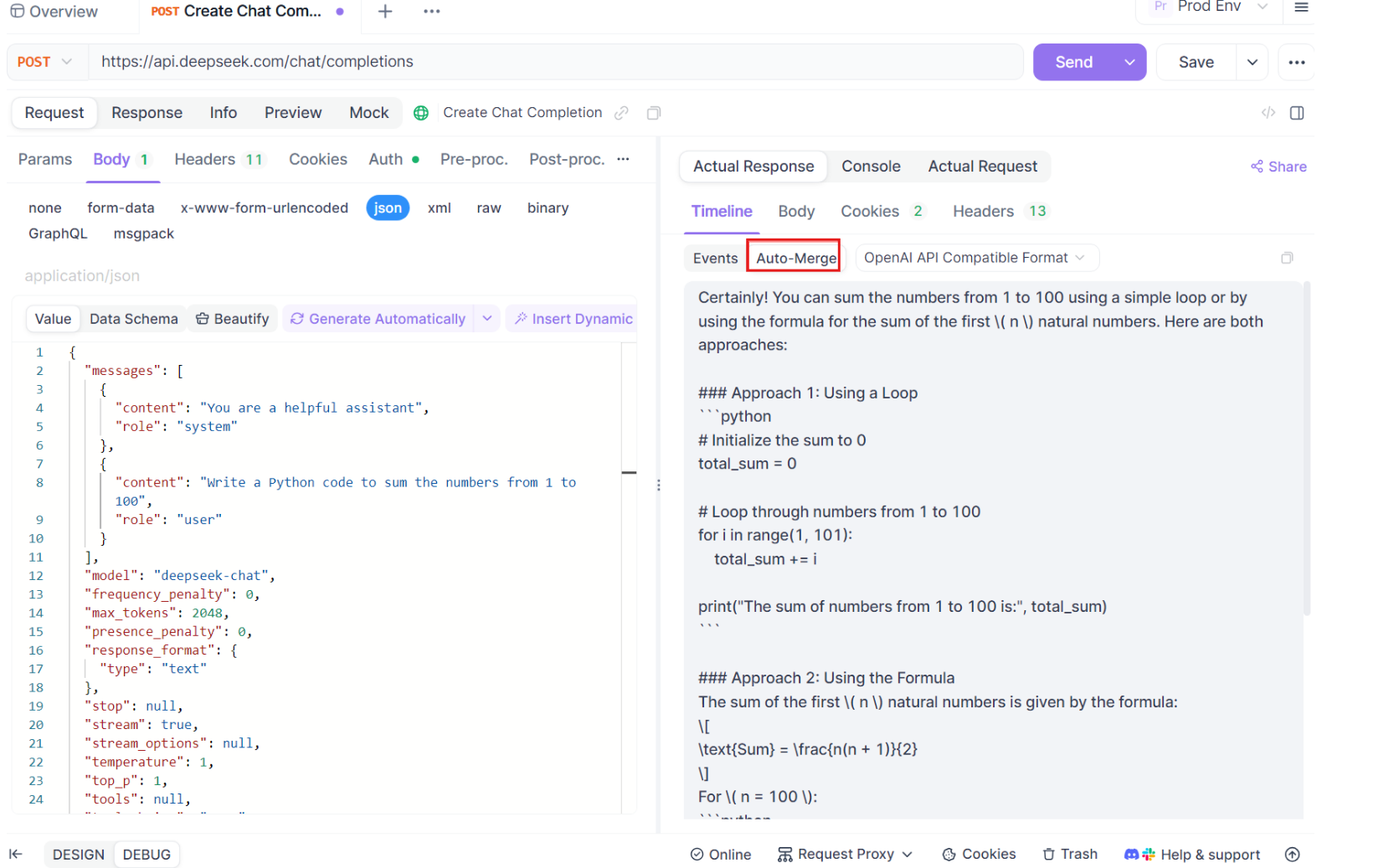

ステップ2: リクエストを送信する

エンドポイントの設定が完了したら、APIリクエストを送信します。レスポンスヘッダーを注意深く観察してください。ヘッダーにContent-Type: text/event-streamが含まれている場合、Apidogは自動的に応答をSSEストリームとして認識し、解釈します。この検出は、後の自動マージプロセスにとって重要です。

ステップ3: リアルタイムタイムラインを監視する

SSE接続が確立すると、Apidogはすべての受信SSEイベントをリアルタイムで表示する専用のタイムラインビューを開きます。このタイムラインは、新しいデータが到着するにつれて継続的に更新され、データの流れを正確に監視できます。タイムラインは単なる生データのダンプではなく、データが伝送される正確なタイミングと方法を視覚化したものです。

ステップ4: 自動マージメッセージ

ここが魔法が起こる場所です。自動マージ機能を持つApidogは、一般的なAIモデル形式を自動的に認識し、断片化されたSSEレスポンスを完全な応答にマージします。このステップには以下が含まれます:

- 自動認識: Apidogは、レスポンスがサポートされているフォーマット(OpenAI、Gemini、Claudeなど)であるかどうかをチェックします。

- メッセージマージ: フォーマットが認識されると、プラットフォームはすべてのSSE断片を自動的に結合し、シームレスで完全な応答を提供します。

- 強化された視覚化: DeepSeek R1などの特定のAIモデルの場合、タイムラインはモデルの思考プロセスも表示し、生成された応答の背後にある理由に対する洞察を提供します。

この機能は、AI駆動のアプリケーションを扱う際に特に役立ち、各レスポンスのすべての部分を手動の介入なしに完全にキャプチャおよび提示することを保証します。

ステップ5: JSONPath抽出ルールの設定

すべてのSSEレスポンスが自動的に組み込み形式に準拠するわけではありません。カスタム抽出が必要なJSONレスポンスを扱う場合、ApidogはJSONPathルールを設定できるようにします。たとえば、生のSSEレスポンスにJSONオブジェクトが含まれ、contentフィールドを抽出する必要がある場合、次のようにJSONPath構成を設定できます:

- JSONPath:

$.choices[0].message.content - 説明:

$はJSONオブジェクトのルートを示します。choices[0]はchoices配列の最初の要素を選択します。message.contentはメッセージオブジェクト内のコンテンツフィールドを指定します。

この構成は、ApidogにSSEレスポンスから必要なデータを抽出する方法を指示し、非標準のレスポンスも効果的に処理されるようにします。

結論

OllamaでのGemma 3のローカル実行は、Googleの先進的なAI機能を自分のマシンで試すエキサイティングな方法です。Ollamaのインストールとモデルのダウンロードから、ターミナルやAPIを介した対話まで、このガイドはすべてのステップを案内しています。そのマルチモーダル機能と多言語サポート、印象的なパフォーマンスにより、Gemma 3は開発者やAI愛好者にとってゲームチェンジャーです。APIテストと統合のシームレスな体験のために、Apidogのようなツールを活用することをお忘れなく。無料でダウンロードし、Gemma 3プロジェクトを向上させましょう!

ラップトップで1Bモデルを試している場合でも、GPUリグで27Bモデルの限界を押し上げている場合でも、可能性を探る準備ができました。コーディングを楽しんで、Gemma 3で素晴らしいものを作りましょう!