高度なコーディングモデルをローカルで実行することは、開発者がクラウドサービスに頼ることなく最先端のAIを活用できるようにします。DeepCoderは、完全にオープンソースの14Bパラメータコーディングモデルであり、O3-miniと同等の優れた性能を提供します。Ollamaと組み合わせることで、大規模言語モデル(LLM)を効率的にローカルのマシンでデプロイできます。この技術ガイドでは、セットアップから実行までのプロセスを説明し、APIdogなどのツールをAPIテストに統合する方法を解説します。

DeepCoderとは何ですか?

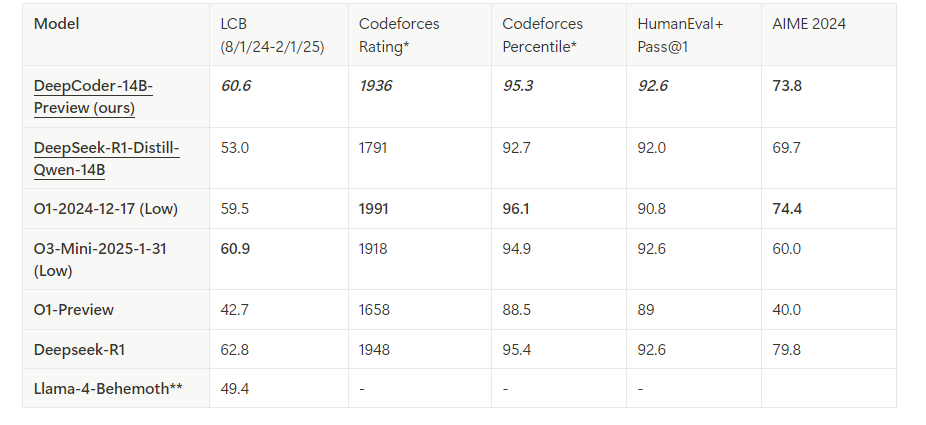

DeepCoderは、AgenticaとTogether AIの協力によって開発された14Bパラメータのオープンソースコーディングモデルです。Distributed reinforcement learning(RL)を用いてDeepseek-R1-Distilled-Qwen-14Bを微調整して構築され、コードの推論および生成タスクに優れています。また、リソース制約のある環境用に小型の1.5Bバージョンも存在します。商用モデルとは異なり、DeepCoderのオープンソースの特性は完全な透明性とカスタマイズを可能にし、開発者にとって人気があります。

Ollamaは、DeepCoderのようなLLMのデプロイを簡素化します。軽量のランタイムとAPIを提供し、開発ワークフローへのシームレスな統合を実現します。これらのツールを組み合わせることで、強力なローカルコーディングアシスタントを作成できます。

DeepCoderをローカルで実行するための前提条件

先に進む前に、あなたのシステムが次の要件を満たしていることを確認してください。必要なものは次の通りです:

ハードウェア:

- 少なくとも32GBのRAMを持つマシン(14Bモデルには64GB推奨)。

- 最適な性能のために24GB以上のVRAMを備えた最新のGPU(例:NVIDIA RTX 3090以上)。

- または、1.5Bモデルには十分なコアを持つCPU(例:Intel i9またはAMD Ryzen 9)が必要です。

ソフトウェア:

- オペレーティングシステム:Linux(Ubuntu 20.04+)、macOS、またはWindows(WSL2経由)。

- Git:リポジトリをクローンするために必要。

- Docker(オプション):コンテナ化されたデプロイのため。

- Python 3.9+:スクリプトとAPIの相互作用のため。

依存関係:

- Ollama:インストールされ、構成されている。

- DeepCoderモデルファイル:公式のOllamaライブラリからダウンロードされている。

これらが整い次第、環境のインストールと構成を開始できます。

ステップ1:あなたのマシンにOllamaをインストールする

OllamaはDeepCoderをローカルで実行するための基盤となります。以下の手順に従ってインストールしてください:

Ollamaをダウンロード:

公式のOllamaウェブサイトにアクセスするか、パッケージマネージャを使用します。Linuxの場合は、次のコマンドを実行します:

curl -fsSL https://ollama.com/install.sh | sh

macOSの場合は、Homebrewを使用してください:

brew install ollama

インストールの検証:

Ollamaが正しくインストールされたことを確認するために、バージョンをチェックします:

ollama --version

Ollamaサービスの開始:

Ollamaをバックグラウンドで起動します:

ollama serve &

これにより、localhost:11434でサーバーが実行され、モデルの相互作用のためのAPIが公開されます。

Ollamaが動作しています。次に、DeepCoderモデルを取得します。

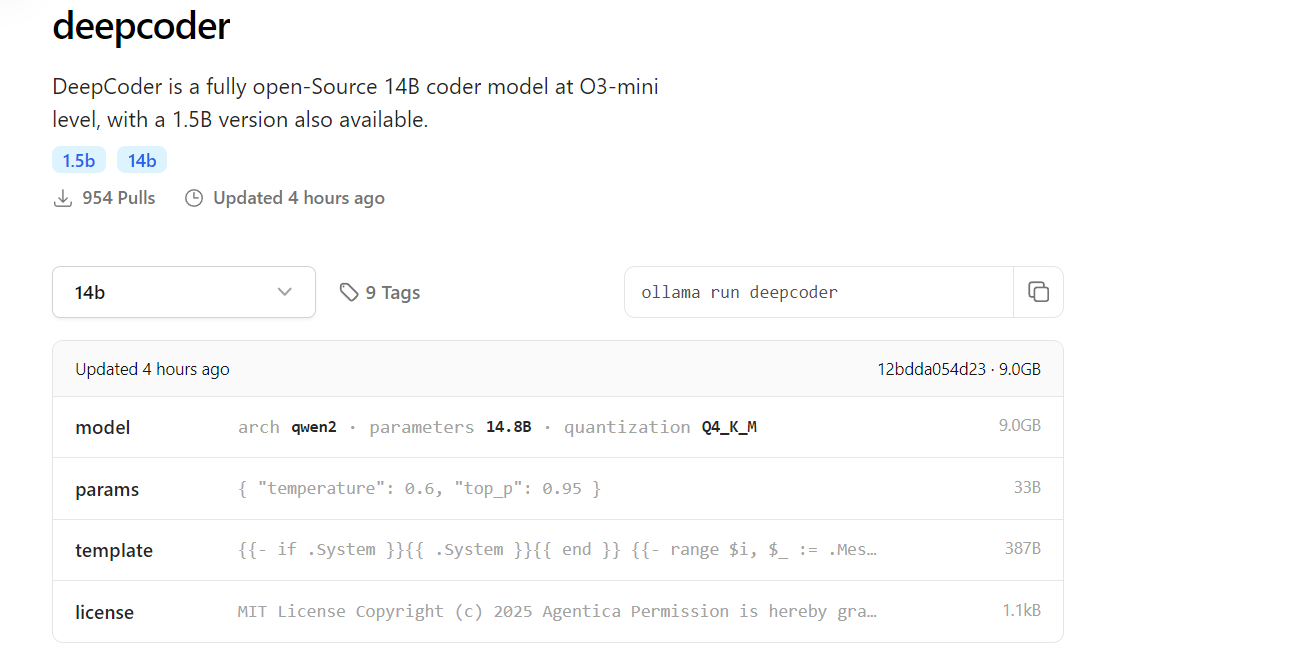

ステップ2:OllamaライブラリからDeepCoderをダウンロードする

DeepCoderはOllamaモデルライブラリにあります。次のように取得します:

DeepCoderを引き出す:

14Bモデル(または軽量セットアップ用の1.5Bモデル)をダウンロードします:

ollama pull deepcoder

このコマンドは、最新のタグ付けされたバージョンを取得します。特定のタグを指定するには、次のようにします:

ollama pull deepcoder:14b-preview

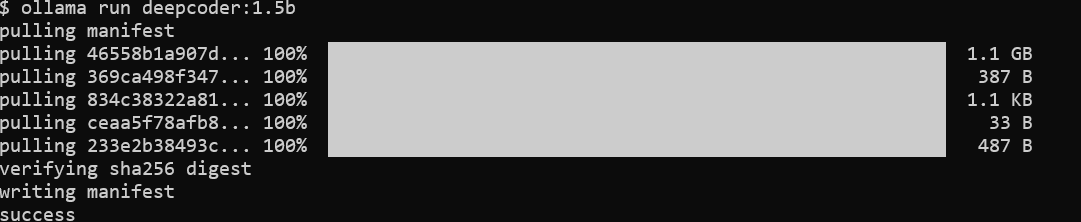

ダウンロード進行状況の監視:

プロセスは更新をストリーミングし、ファイルダイジェストと完了ステータスを表示します。14Bモデルの場合は、多ギガバイトのダウンロードが予想されるため、安定したインターネット接続を確保してください。

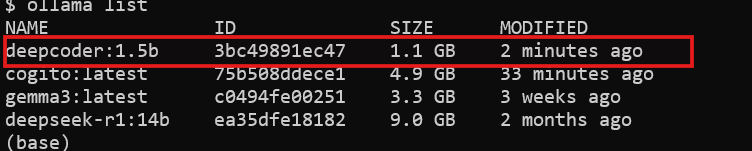

インストールの検証:

DeepCoderが利用可能か確認します:

ollama list

deepcoderがインストールされたモデルの中に表示されます。

DeepCoderをダウンロードしたので、実行の準備が整いました。

ステップ3:Ollamaを使ってDeepCoderをローカルで実行する

次に、DeepCoderを実行してその機能をテストします:

DeepCoderを起動:

モデルをインタラクティブセッションで起動します:

ollama run deepcoder

これにより、コーディングクエリを入力できるプロンプトが開きます。

パラメータの調整(オプション):

高度な使用のために、設定ファイルまたはAPIコールを介して温度のような設定を調整できます(後述)。

DeepCoderがローカルで実行されています。ただし、ワークフローに統合するためには、そのAPIを使用します。

ステップ4:Ollama API経由でDeepCoderと対話する

OllamaはプログラムによるアクセスのためにRESTful APIを提供します。以下の手順で活用します:

APIの可用性を確認:

Ollamaサーバーが実行されていることを確認します:

curl http://localhost:11434

レスポンスがサーバーがアクティブであることを確認します。

リクエストを送信:curlを使用してDeepCoderにクエリを送信します:

curl http://localhost:11434/api/generate -d '{

"model": "deepcoder",

"prompt": "FlaskでREST APIエンドポイントを生成",

"stream": false

}'

レスポンスには生成されたコードが含まれます:

from flask import Flask, jsonify

app = Flask(__name__)

@app.route('/api/data', methods=['GET'])

def get_data():

return jsonify({"message": "Hello, World!"})

if __name__ == "__main__":

app.run(debug=True)

Pythonと統合:

Pythonのrequestsライブラリを使用してクリーンな相互作用を実現します:

import requests

url = "http://localhost:11434/api/generate"

payload = {

"model": "deepcoder",

"prompt": "Node.jsのExpress APIを書く",

"stream": False

}

response = requests.post(url, json=payload)

print(response.json()["response"])

APIはDeepCoderの自動化と統合の可能性を開きます。

ステップ5:APIdogでAPIテストを強化

DeepCoderはAPIコードの生成に優れていますが、これらのAPIのテストも重要です。APIdogはこのプロセスを簡素化します:

APIdogをインストール:

公式サイトからAPIdogをダウンロードしてインストールします。

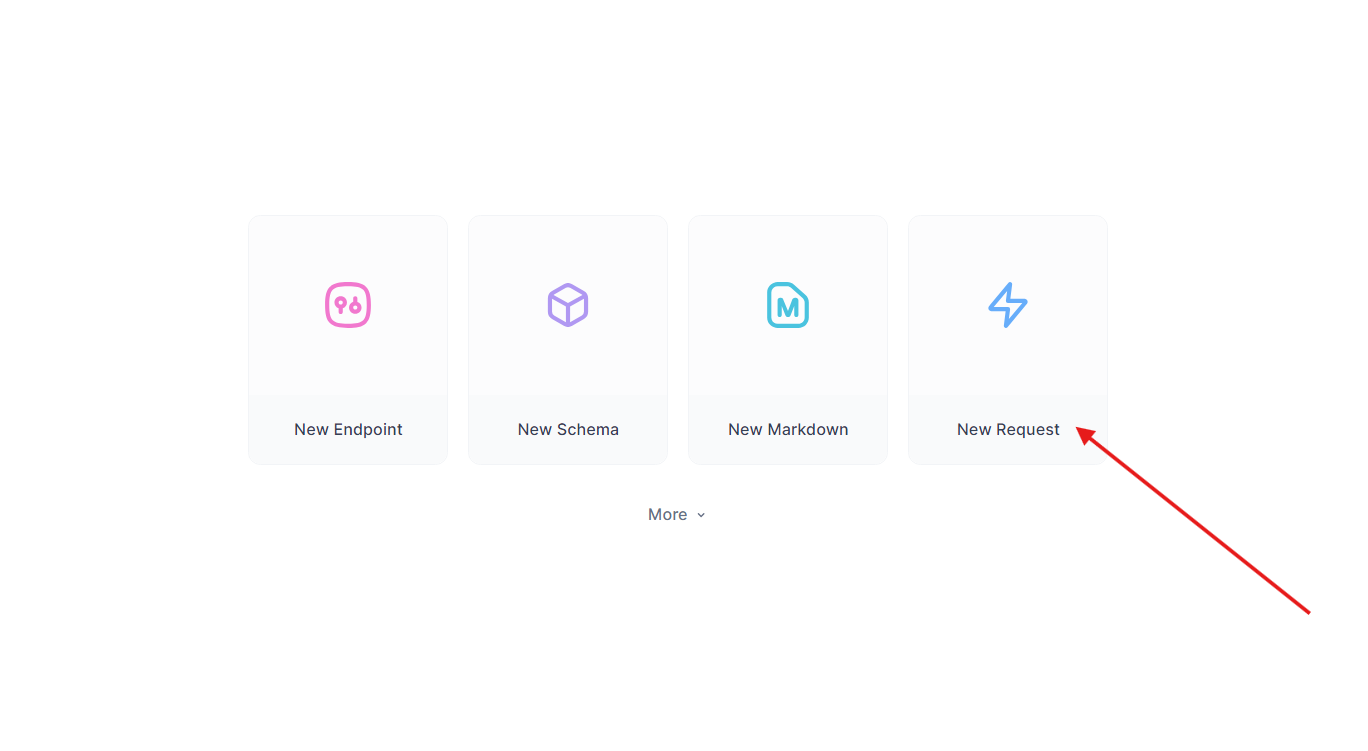

生成されたAPIをテスト:

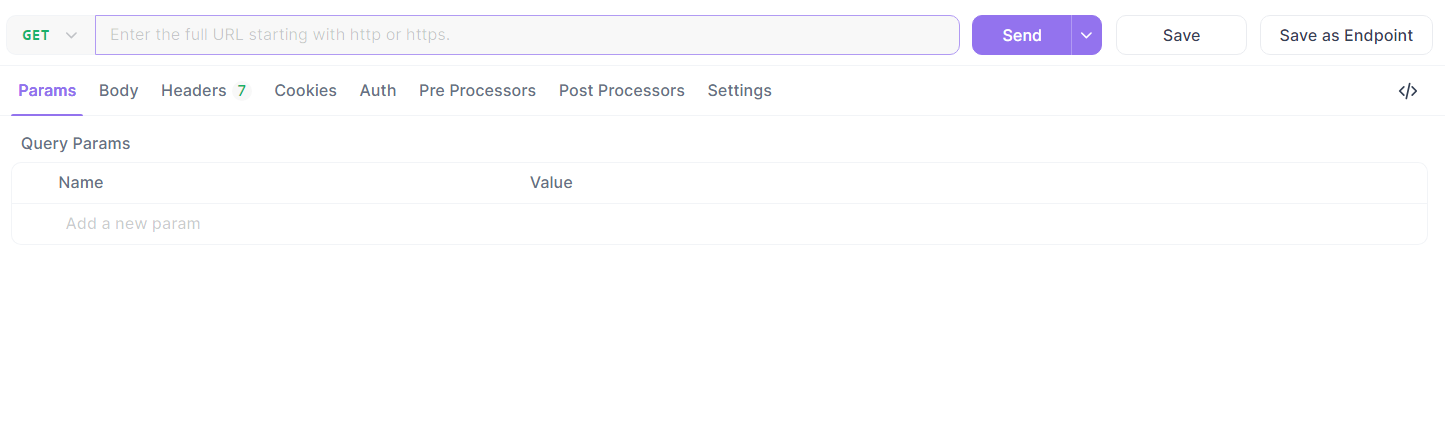

以前のFlaskエンドポイントを取得します。APIdogでは:

- 新しいリクエストを作成します。

- URLを

http://localhost:5000/api/dataに設定し、GETリクエストを送信します。

- レスポンスを検証:

{"message": "Hello, World!"}。

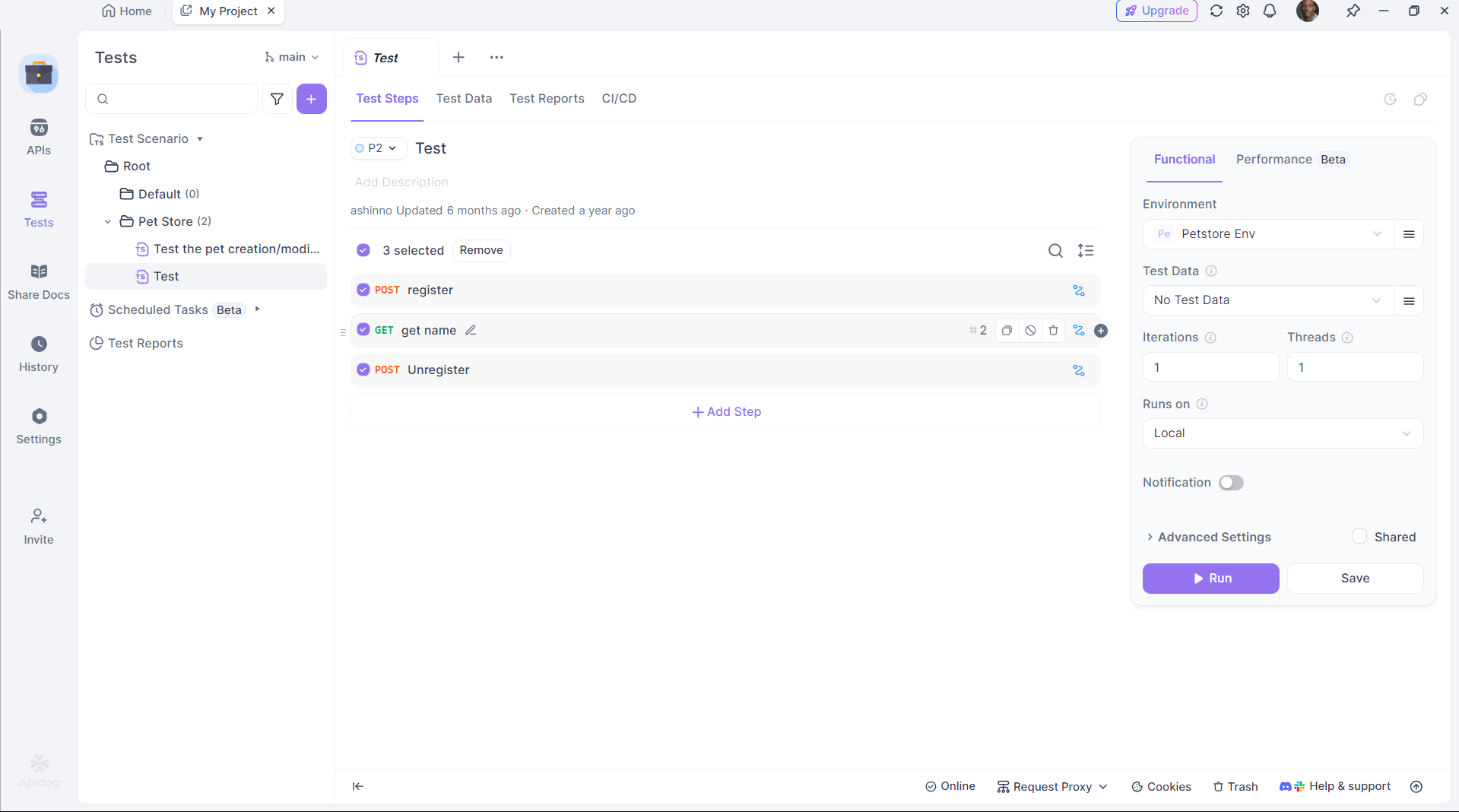

テストの自動化:

APIdogのスクリプティングを使用して検証を自動化し、DeepCoderの出力が期待に応えることを確認します。

APIdogはコード生成とデプロイメントのギャップを埋め、生産性を向上させます。

ステップ6:DeepCoderのパフォーマンスを最適化

効率を最大化するために、DeepCoderの設定を微調整します:

GPUアクセラレーション:

Ollamaが計算をGPUにオフロードすることを確認します。次のコマンドで確認します:

nvidia-smi

GPUの使用率が成功したアクセラレーションを示します。

メモリ管理:

14Bモデルの場合、十分なVRAMを割り当てます。必要に応じてLinuxでスワップスペースを調整します:

sudo fallocate -l 32G /swapfile

sudo chmod 600 /swapfile

sudo mkswap /swapfile

sudo swapon /swapfile

モデルの量子化:

1.5Bモデルには小型の量子化(例:4ビット)を使用します:

ollama pull deepcoder:1.5b-q4

これらの調整により、DeepCoderがあなたのハードウェアでスムーズに動作します。

なぜOllamaとDeepCoderを選ぶべきか?

DeepCoderをローカルで実行することには明確な利点があります:

- プライバシー:機密コードをクラウドサーバーから保つ。

- コスト:サブスクリプション料金を回避する。

- カスタマイズ:モデルをあなたのニーズに合わせて調整する。

Ollamaの軽量フレームワークとAPIdogのテスト機能を組み合わせることで、強力で自己完結型の開発エコシステムが生まれます。

結論

Ollamaを使用してDeepCoderをローカルにセットアップすることは、簡単でありながら変革的です。Ollamaをインストールし、DeepCoderを取得、実行し、API経由で統合する—すべて数ステップで行えます。APIdogのようなツールは、生成されたAPIが完全に機能することを保証し、体験をさらに向上させます。あなたが個人開発者であろうとチームの一員であろうと、このセットアップは堅牢でオープンソースのコーディングアシスタントを提供します。