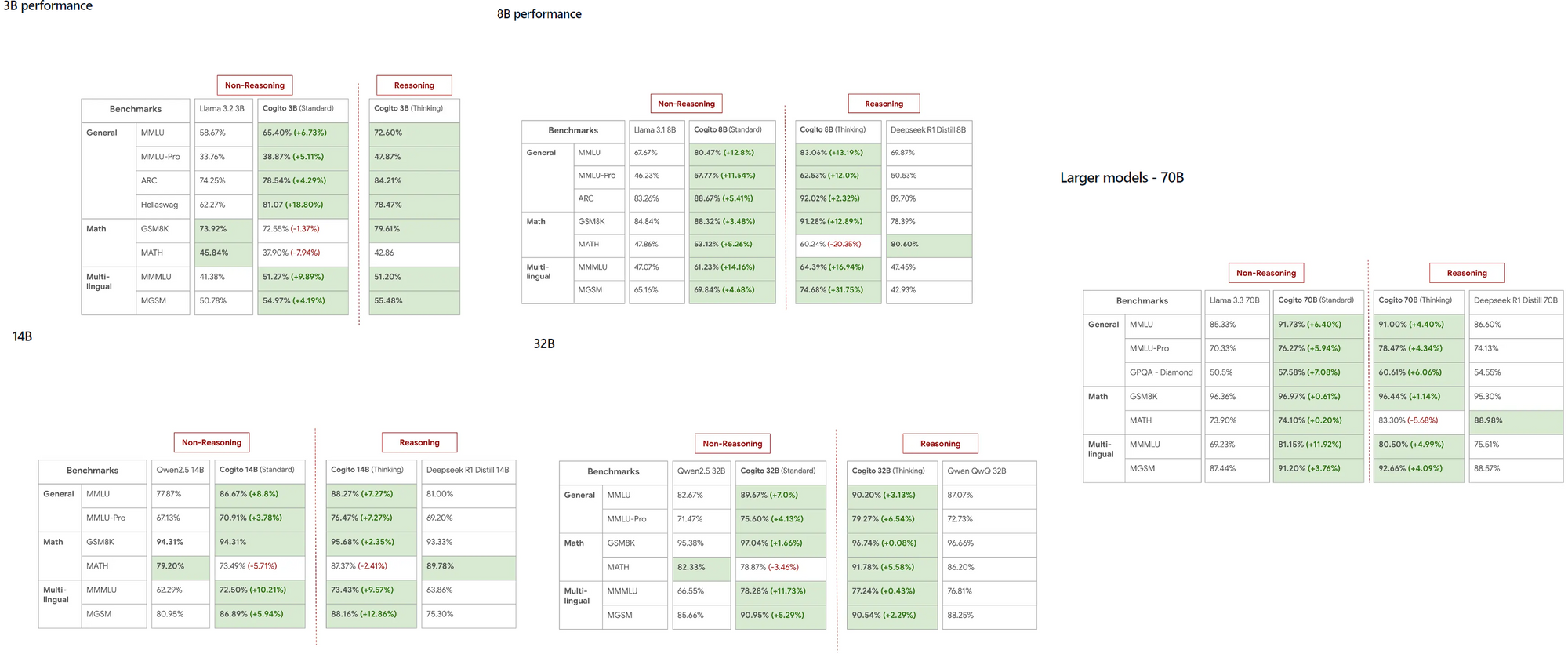

DeepCogitoによって開発されたCogitoモデルは、さまざまなスケールにおいてLLaMAやDeepSeekなどの確立されたモデルを上回る驚異的な能力が評価され、AIコミュニティで急速に注目を集めています。これらのオープンソースモデルは、3Bから70Bのパラメータを持ち、開発者に対してローカルマシン上で一般的なスーパーインテリジェンスを探求するための強力なツールを提供します。

CogitoとOllamaについて知っておくべきこと

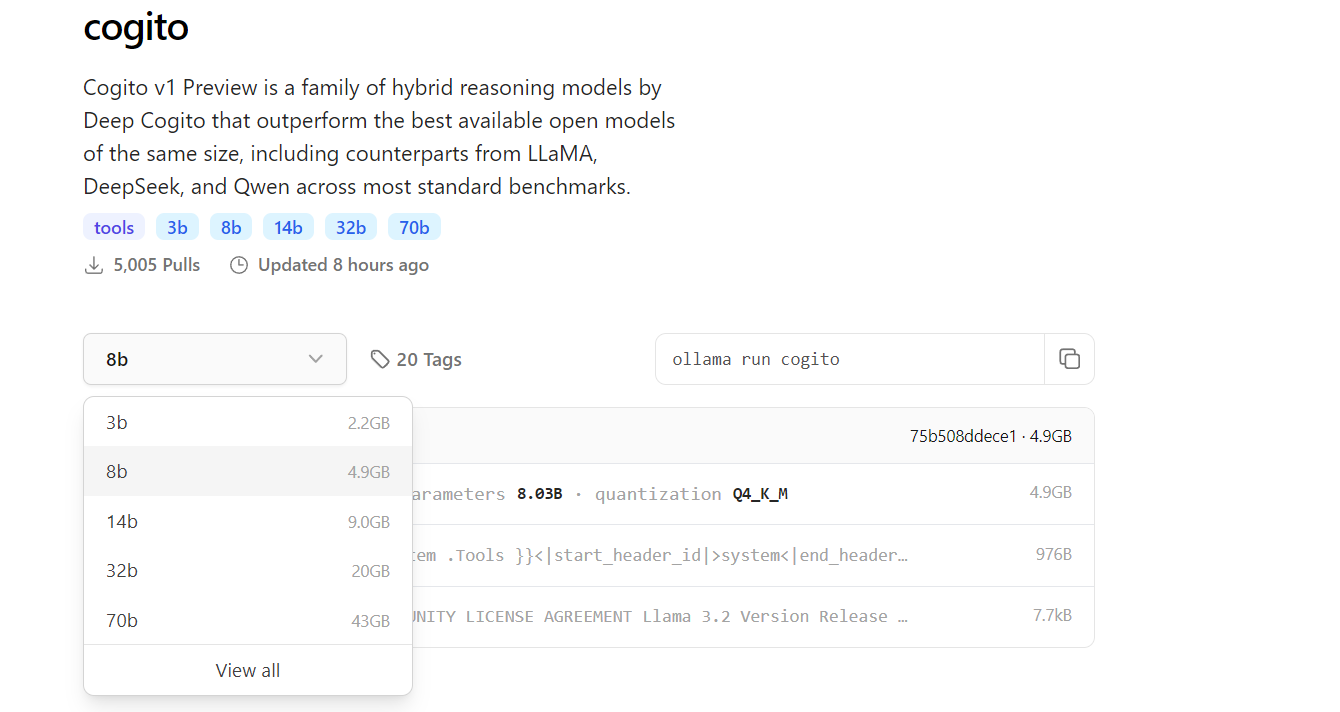

Cogitoは、DeepCogitoチームによって開発された一連のオープンソースAIモデルを表し、一般的なスーパーインテリジェンスの実現に明確に焦点を当てています。これらのモデルは反復蒸留と増幅(IDA)と呼ばれる手法を活用し、より多くの計算を使用してより良い解決策に至る過程をモデルのパラメータに蒸留して、モデルの推論能力を段階的に向上させます。サイズは3B、8B、14B、32B、70Bなどがあり、Cogitoモデルは今後109Bおよび400Bパラメータモデルのリリースでさらに拡大する予定です。

一方、Ollamaは、開発者がローカルでLLMsを実行できる多用途のフレームワークであり、クラウドベースのAPIを必要としません。MacOS、Windows、Linuxなどの複数のプラットフォームをサポートし、Ollamaは広範なユーザーに対するアクセシビリティを確保しています。Ollamaを使ってCogitoをローカルで実行することで、高度なAIモデルをオンデバイスで実験することができ、コストを節約するだけでなく、敏感なアプリケーションのデータプライバシーを向上させます。

なぜCogitoをローカルで実行するのか?

Cogitoをローカルで実行することは、開発者にいくつかの利点を提供します。まず、外部APIへの依存を排除することで、待機時間を減少させ、データがプライベートであることを保証します。これは、データセキュリティが優先されるアプリケーションにとって特に重要です。さらに、Cogitoモデルは、LLaMA 4 Scoutのような競合モデルと比較しても、より小規模なスケールでさえ優れたパフォーマンスを示しており、高パフォーマンスなタスクに非常に適しています。

ローカルでの実行は、リソースが制約された環境やインターネット接続が限られた地域で作業している開発者にとっても理想的であり、接続なしでシームレスに操作できます。さらに、Ollamaの簡潔なコマンドラインインターフェースは、Cogitoを含む複数のモデルを管理および実行するプロセスを簡素化します。最後に、ローカルのセットアップでは、特にAPI統合をテストしているときに、開発中の迅速な反復が可能になり、エンドポイントを設計およびデバッグするためにApidogのようなツールを効率的に活用できます。

OllamaでCogitoを実行するための前提条件

セットアッププロセスに入る前に、システムが必要な要件を満たしていることを確認してください。3Bまたは8Bパラメータバージョンのような小さいモデルの場合、マシンには少なくとも16GBのRAMが必要ですが、70Bのような大きいモデルではスムーズに動作するために64GB以上が必要になることがあります。NVIDIAのCUDAサポート付きのGPUなどの互換性のあるGPUは、モデルの推論を大幅に加速させるため強く推奨されます。

また、OllamaのPythonライブラリおよびその他関連ツールの依存関係として、Python 3.8以上をインストールする必要があります。

次に、Ollamaを公式ウェブサイトまたはGitHubリポジトリからダウンロードしてインストールし、オペレーティングシステムに特有の手順に従ってください。ストレージも重要な要素です。Cogitoモデルは3Bモデルのために数GBから70Bモデルのために100GB以上まで幅広くあるため、システムに十分なスペースがあることを確認してください。最後に、CogitoをAPIと統合する予定の場合は、ApidogをインストールしておくことでAPIエンドポイントの設計とテストが効率的に行え、スムーズな開発体験が保証されます。

ステップ1: Ollamaをマシンにインストールする

Cogitoをローカルで実行するための最初のステップは、マシンにOllamaをインストールすることです。OllamaのウェブサイトまたはGitHubページを訪れて、使用しているオペレーティングシステム用のインストーラーをダウンロードしてください。MacOSおよびWindowsのユーザーは、インストーラーを実行し、画面の指示に従ってセットアップを完了します。Linuxを使用している場合は、ターミナルで次のコマンドを実行してOllamaを直接インストールできます:

curl -fsSL https://ollama.com/install.sh | sh

インストールが完了したら、ターミナルを開き、ollama --versionと入力して、Ollamaが正しくインストールされたことを確認します。

Ollamaが実行されていることを確認するには、ollama serveを実行し、モデル管理のためのローカルサーバーを開始します。このステップでは、次のステップでCogitoのようなモデルを引き出して実行するために必要なOllamaのコマンドラインインターフェースも設定されます。

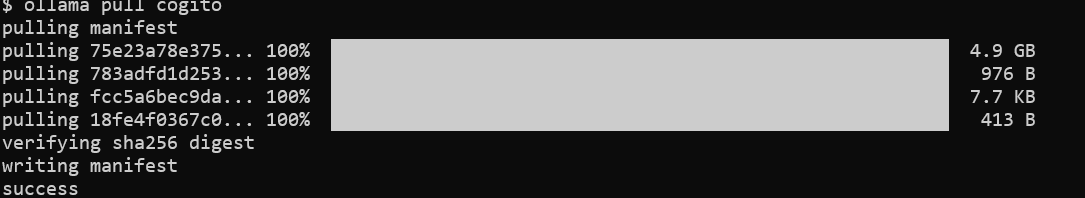

ステップ2: OllamaのライブラリからCogitoモデルを取得する

Ollamaがインストールされたので、次のステップはCogitoモデルをダウンロードすることです。ターミナルを開き、コマンドollama pull cogitoを実行してOllamaのライブラリからCogitoモデルを取得します。

デフォルトでは、このコマンドはCogitoモデルの最新バージョンを取得しますが、タグを使用して特定のサイズを指定することもできます。たとえば、3Bパラメータモデルの場合はollama pull cogito:3bです。利用可能なモデルサイズについてはhttps://ollama.com/library/cogitoを参照してください。

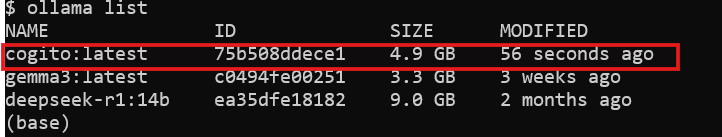

インターネット速度やモデルのサイズによって、ダウンロードプロセスには時間がかかることがあります。3Bモデルの場合は約2.2GB、70Bモデルの場合は最大43GBを見込んでください。ダウンロードが完了したら、ollama listを実行して、モデルがシステムにインストールされていることを確認します。この時点で、Cogitoはローカルで実行する準備が整いましたので、次のステップに進みます。

ステップ3: OllamaでローカルにCogitoを実行する

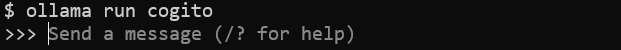

モデルのダウンロードが完了したので、マシンでCogitoを実行する準備が整いました。ターミナルでコマンドollama run cogitoを実行してCogitoモデルを起動します。

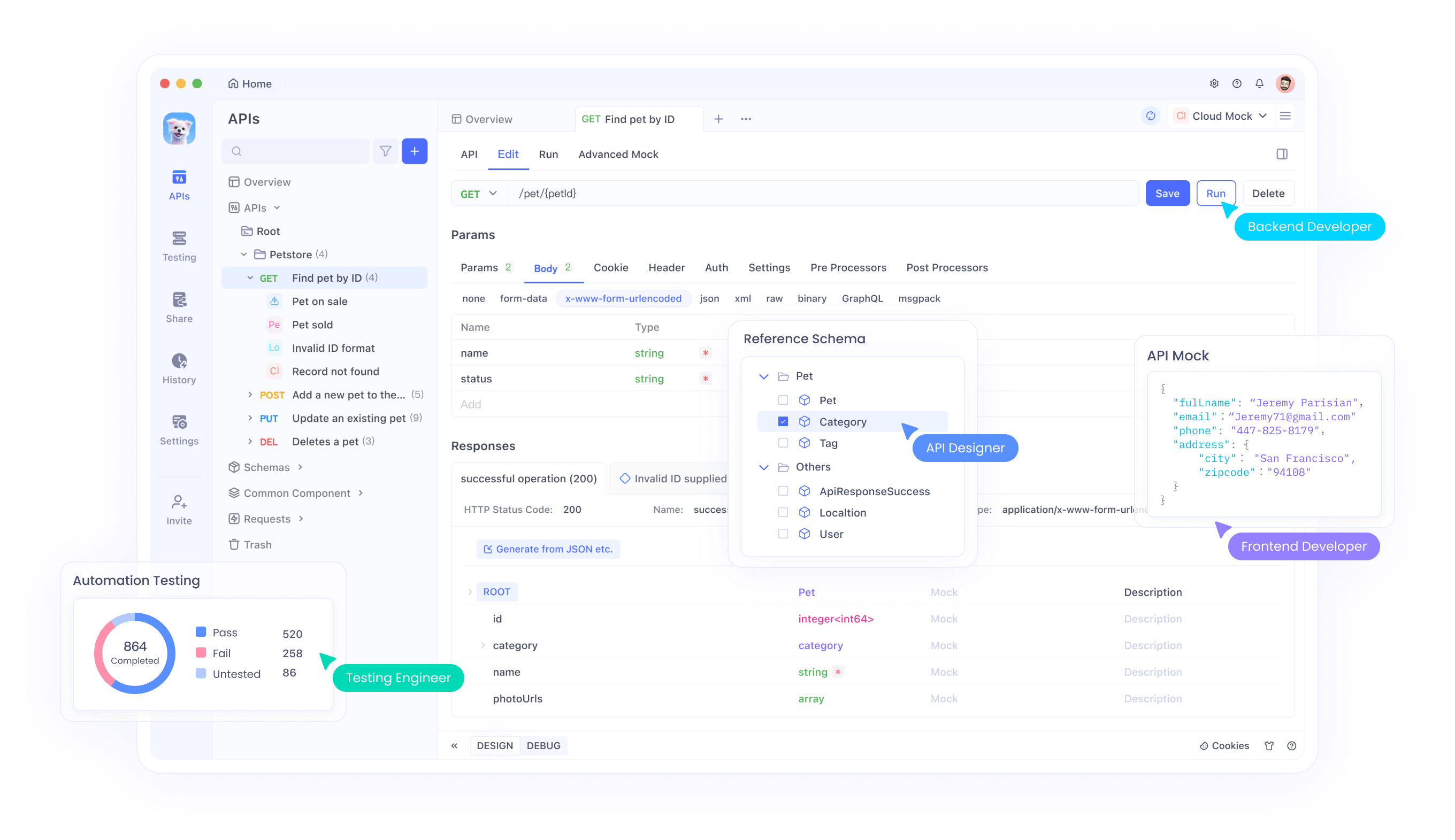

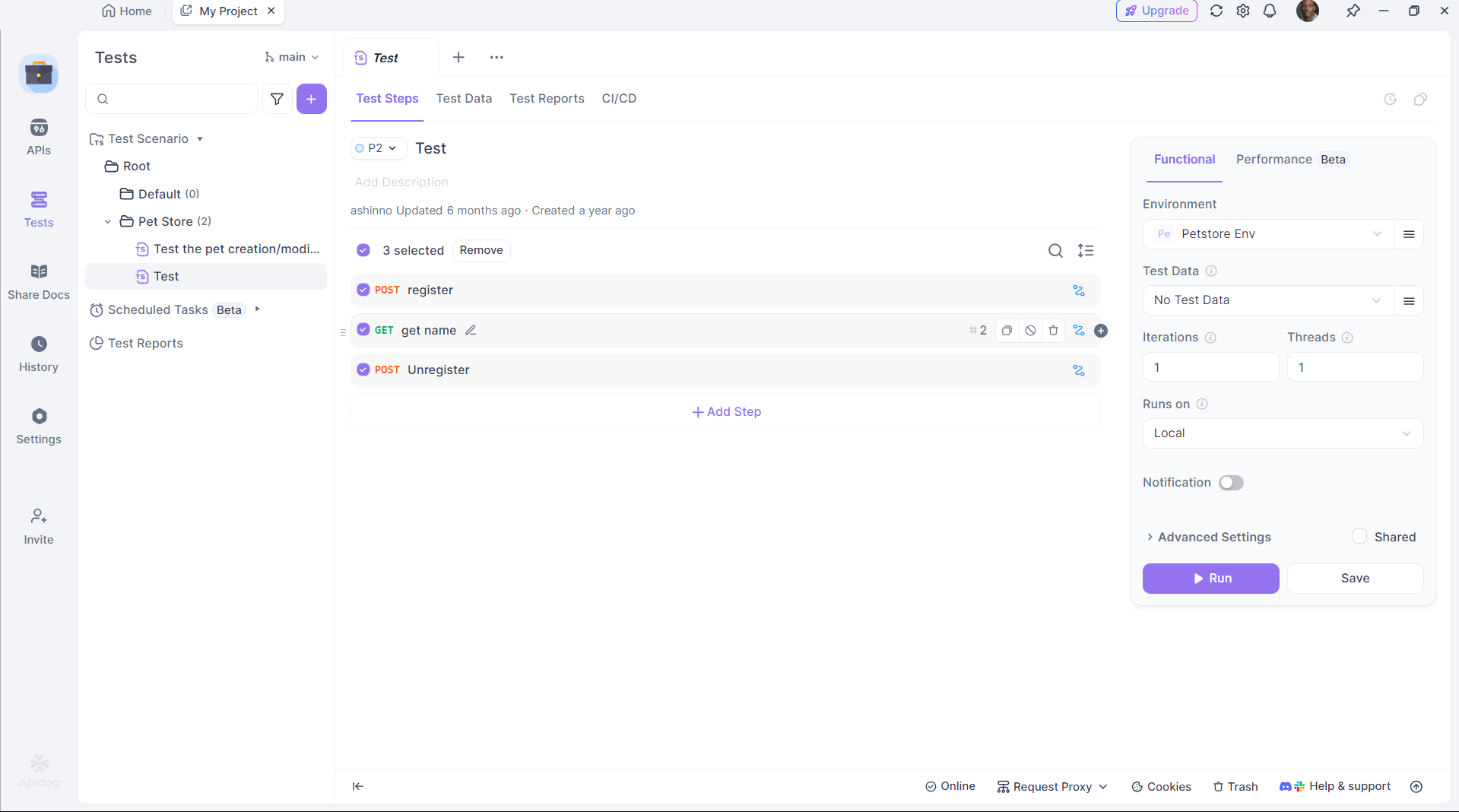

ステップ4: ApidogでAPIテストを強化する

CogitoはAPIコードの生成に優れていますが、これらのAPIをテストすることが重要です。Apidogはこのプロセスを簡素化します:

Apidogをインストール:

公式サイトからApidogをダウンロードしてインストールします。

生成されたAPIをテスト:

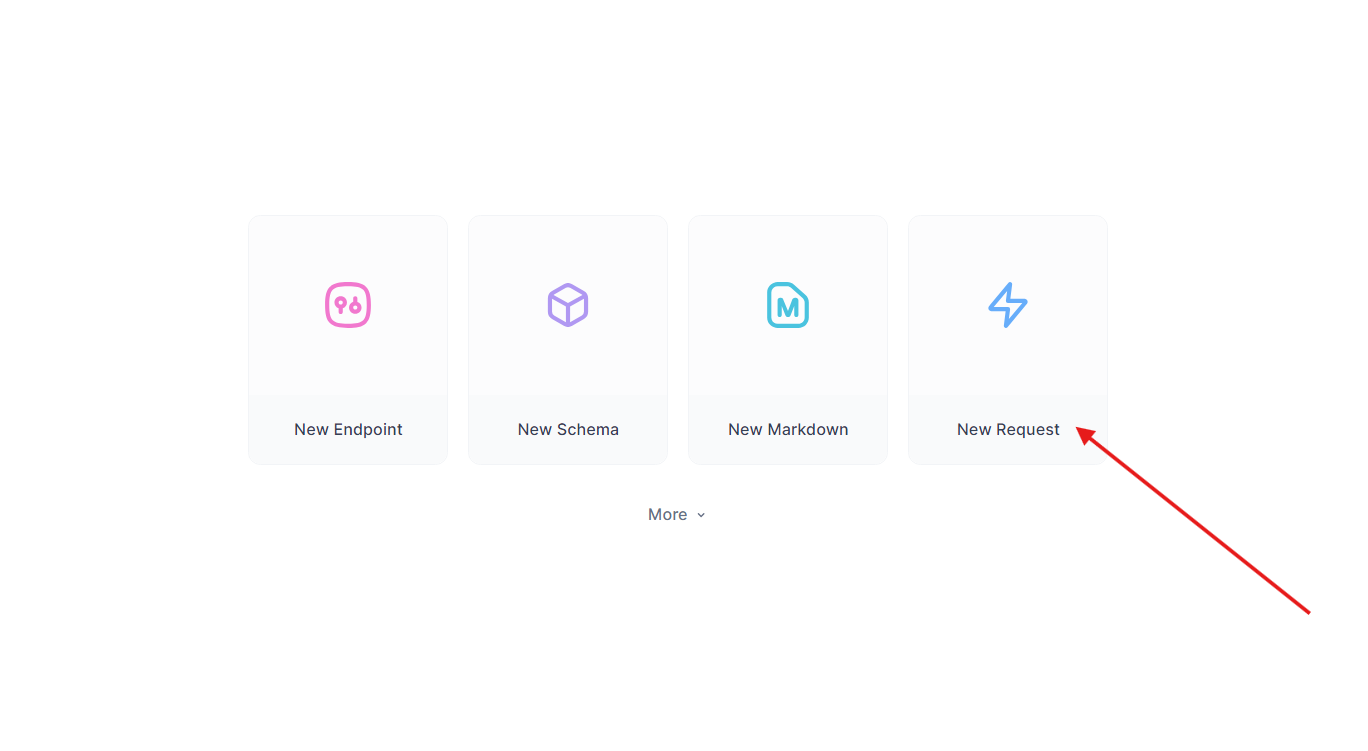

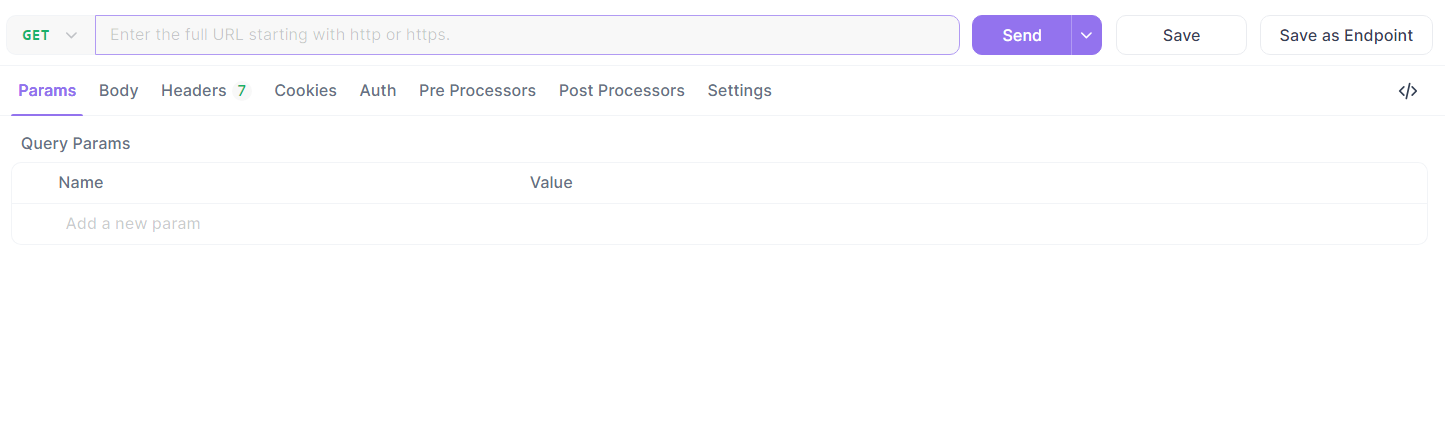

以前のFlaskエンドポイントを受け取ります。Apidogで:

- 新しいリクエストを作成します。

- URLを

http://localhost:5000/api/dataに設定し、GETリクエストを送信します。

- レスポンスを確認します:

{"message": "Hello, World!"}。

テストを自動化:

Apidogのスクリプト機能を使用して検証を自動化し、DeepCoderの出力が期待に応えることを確保します。

Apidogはコード生成とデプロイメントのギャップを埋め、生産性を向上させます。

一般的な問題のトラブルシューティング

Cogitoをローカルで実行する際に時折課題が発生することがありますが、ほとんどの問題は少しの確認で解決できます。Ollamaが起動しない場合は、ポート11434を他のプロセスが使用していないか確認してください。競合しているプロセスを終了させるか、Ollamaの設定でポートを変更してください。「メモリ不足」エラーが発生した場合は、モデルサイズを小さくするか、より大きなモデルに対応するためにシステムのスワップスペースを増やすことを検討してください。モデルが応答しない場合は、ollama pull cogitoを使用して正しく取得したことを確認し、ollama listで表示されるか確認してください。推論時間が遅い場合は、CPUのみで実行している可能性があるため、nvidia-smiを実行してCUDAがアクティブであることを確認してください。

Apidogを使用してAPI統合を行う場合、不正なJSONペイロードからエラーが発生することがあるので、Apidogのエディタでスキーマを再確認してください。詳細な診断のためには、~/.ollama/logsのOllamaのログをレビューして、問題を迅速に特定して解決します。

結論

OllamaでCogitoをローカルで実行することにより、一般的なスーパーインテリジェンスを探求しようとする開発者にとって、さまざまな可能性が開かれます。このガイドに記載されている手順に従うことで、マシン上でCogitoをセットアップし、その性能を最適化し、さらにはApidogで管理されたAPIを使用して大規模なアプリケーションに統合することもできます。RAGシステム、コーディングアシスタント、またはWebアプリケーションを構築する際に、Cogitoの高度な機能は革新のための強力なツールとなります。DeepCogitoチームがより大きなモデルをリリースし、手法を洗練し続けることで、ローカルAI開発の可能性はさらに広がり、開発者が画期的なソリューションを生み出す力を得るでしょう。