オープンソースAIコミュニティにとって、今日もまた素晴らしい一日です。特に、このコミュニティはこのような瞬間を糧に、新しい最先端技術を熱心に分析し、テストし、その上に構築しています。2025年7月、AlibabaのQwenチームは、パフォーマンスベンチマークを再定義する強力な新モデルファミリーであるQwen3シリーズの発表により、そのような出来事の一つを引き起こしました。このリリースの中心には、魅力的で高度に専門化されたバリアント、Qwen3-235B-A22B-Thinking-2507があります。

このモデルは単なる漸進的なアップデートではありません。それは、深い推論能力を持つAIシステムを構築するための、意図的かつ戦略的な一歩を表しています。その名前自体が、論理、計画、多段階の問題解決に焦点を当てるという意図の表明です。この記事では、Qwen3-Thinkingのアーキテクチャ、目的、潜在的な影響について深く掘り下げ、より広範なQwen3エコシステム内でのその位置付けと、AI開発の未来にとってそれが何を意味するのかを考察します。

開発チームが最高の生産性で協力できる統合されたオールインワンプラットフォームをお探しですか?

Apidogはあなたのすべての要求に応え、Postmanをはるかに手頃な価格で置き換えます!

Qwen3ファミリー:最先端技術への多角的な攻撃

Thinkingモデルを理解するには、まずその誕生の背景を認識する必要があります。それは単独で登場したのではなく、包括的で戦略的に多様なQwen3モデルファミリーの一部として生まれました。Qwenシリーズはすでに数億回のダウンロード履歴を持ち、Hugging Faceのようなプラットフォームで10万以上の派生モデルを生み出す活気あるコミュニティを育成し、絶大な支持を得ています。

Qwen3シリーズには、それぞれ異なるドメインに合わせて調整されたいくつかの主要なバリアントが含まれています。

- Qwen3-Instruct: 会話型およびタスク指向の幅広いアプリケーション向けに設計された汎用的な指示追従モデルです。例えば、

Qwen3-235B-A22B-Instruct-2507バリアントは、自由形式のタスクにおけるユーザーの好みに合わせたアライメントの強化と、幅広い知識カバー率で注目されています。 - Qwen3-Coder: エージェント的なコーディングのために明示的に設計された一連のモデルです。これらのうち最も強力な4800億パラメータモデルは、オープンソースのコード生成とソフトウェア開発の自動化において新たな標準を確立します。そのエージェント能力をよりよく活用するために、コマンドラインツール「Qwen Code」も付属しています。

- Qwen3-Thinking: 本分析の焦点であり、単純な指示追従やコード生成を超えた複雑な認知タスクに特化しています。

このファミリーアプローチは、洗練された戦略を示しています。単一の巨大なモデルがあらゆることをこなそうとするのではなく、Alibabaは専門的なツールのスイートを提供し、開発者が特定のニーズに合った適切な基盤を選択できるようにしています。

Qwen3-235B-A22B-Thinking-2507の「Thinking」部分について語りましょう

モデル名Qwen3-235B-A22B-Thinking-2507には、その基盤となるアーキテクチャと設計思想を示す情報が凝縮されています。これを一つずつ分解してみましょう。

Qwen3: これは、モデルがQwenシリーズの第3世代に属し、前身の知識と進歩に基づいていることを示します。235B-A22B(Mixture of Experts - MoE): これは最も重要なアーキテクチャの詳細です。このモデルは、すべてのパラメータがすべての単一の計算に使用される2350億パラメータの密なネットワークではありません。代わりに、Mixture-of-Experts (MoE)アーキテクチャを採用しています。Thinking: この接尾辞は、論理的推論と段階的な分析を重視するデータでファインチューニングされた、モデルの専門化を示します。2507: これはバージョンタグであり、おそらく2025年7月を表し、モデルのリリースまたはトレーニング完了日を示しています。

MoEアーキテクチャは、このモデルのパワーと効率の組み合わせの鍵です。それは、「ゲーティングネットワーク」または「ルーター」によって管理される、専門化された「エキスパート」(より小さなニューラルネットワーク)の大規模なチームと考えることができます。任意の入力トークンに対して、ルーターは情報を処理するために最も関連性の高いエキスパートの小さなサブセットを動的に選択します。

Qwen3-235B-A22Bの場合、具体的な内容は以下の通りです。

- 総パラメータ数 (

235B): これは、利用可能なすべてのエキスパートに分散された膨大な知識のリポジトリを表します。モデルには合計128個の異なるエキスパートが含まれています。 - アクティブなパラメータ数 (

A22B): 単一の推論パスごとに、ゲーティングネットワークは8個のエキスパートをアクティブ化するように選択します。これらのアクティブなエキスパートの合計サイズは、約220億パラメータです。

このアプローチの利点は計り知れません。これにより、モデルは2350億パラメータモデルの膨大な知識、ニュアンス、能力を持ちながら、計算コストと推論速度ははるかに小さい220億パラメータの密なモデルに近づきます。これにより、知識の深さを犠牲にすることなく、このような大規模なモデルの展開と実行がより実現可能になります。

技術仕様とパフォーマンスプロファイル

高レベルのアーキテクチャを超えて、モデルの詳細な仕様は、その能力をより明確に示しています。

- モデルアーキテクチャ: Mixture-of-Experts (MoE)

- 総パラメータ数: 約2350億

- アクティブなパラメータ数: トークンあたり約220億

- エキスパートの数: 128

- トークンあたりにアクティブ化されるエキスパートの数: 8

- コンテキスト長: モデルは128,000トークンのコンテキストウィンドウをサポートします。これは、非常に長いドキュメント、コードベース全体、または長い会話履歴を、入力の最初からの重要な情報を見失うことなく処理し、推論することを可能にする大幅な改善です。

- トークナイザー: 15万以上のトークンからなる語彙を持つカスタムのバイトペアエンコーディング(BPE)トークナイザーを使用しています。この大きな語彙サイズは、その強力な多言語トレーニングを示しており、英語、中国語、ドイツ語、スペイン語など、幅広い言語のテキストだけでなく、プログラミング言語も効率的にエンコードできます。

- トレーニングデータ: トレーニングコーパスの正確な構成は非公開ですが、

Thinkingモデルは、推論を促進するように設計された特殊なデータの組み合わせで確実にトレーニングされています。このデータセットは、標準的なウェブテキストをはるかに超え、おそらく以下のようなものが含まれます。 - 学術論文および科学論文: arXiv、PubMed、その他の研究リポジトリなどのソースからの大量のテキストで、複雑な科学的および数学的推論を吸収します。

- 論理および数学データセット: GSM8K(Grade School Math)やMATHデータセットなど、段階的な解決策を必要とする文章問題を含むデータセット。

- プログラミングおよびコード問題: HumanEvalやMBPPなど、コード生成を通じて論理的推論をテストするデータセット。

- 哲学的および法的テキスト: 密で抽象的、かつ高度に構造化された論理的議論の理解を必要とする文書。

- 思考連鎖(CoT)データ: モデルが「段階的に考える」ことで答えにたどり着く方法を明示的に示された、合成的に生成された、または人間がキュレーションした例。

この厳選されたデータミックスこそが、ThinkingモデルをそのInstruct兄弟モデルから区別するものです。それは単に役立つように訓練されただけでなく、厳密であるように訓練されています。

「思考」の力:複雑な認知への焦点

Qwen3-Thinkingモデルの可能性は、これまで大規模言語モデルにとって大きな課題であった問題に取り組む能力にあります。これらは、単純なパターンマッチングや情報検索では不十分なタスクです。「Thinking」の専門化は、次のような分野での熟練度を示唆しています。

- 多段階推論: クエリを論理的なステップのシーケンスに分解する必要がある問題を解決します。例えば、複数の市場変数に基づいてビジネス上の意思決定の財務的影響を計算したり、一連の物理的制約が与えられた場合の投射物の軌道を計画したりします。

- 論理的演繹: 一連の前提を分析し、有効な結論を導き出します。これには、ロジックグリッドパズルを解いたり、テキスト内の論理的誤謬を特定したり、法的または契約上の文脈で一連の規則の結果を判断したりすることが含まれます。

- 戦略的計画: 目標を達成するための一連のアクションを考案します。これは、複雑なゲームプレイ(チェスや囲碁など)、ビジネス戦略シミュレーション、サプライチェーン最適化、自動プロジェクト管理に応用されます。

- 因果推論: テキストで記述された複雑なシステム内で因果関係を特定しようとします。これは、モデルがしばしば苦労する科学的および分析的推論の基礎です。

- 抽象的推論: 抽象的な概念や類推を理解し、操作します。これは、創造的な問題解決と真の人間レベルの知性にとって不可欠であり、具体的な事実を超えてそれらの間の関係へと移行します。

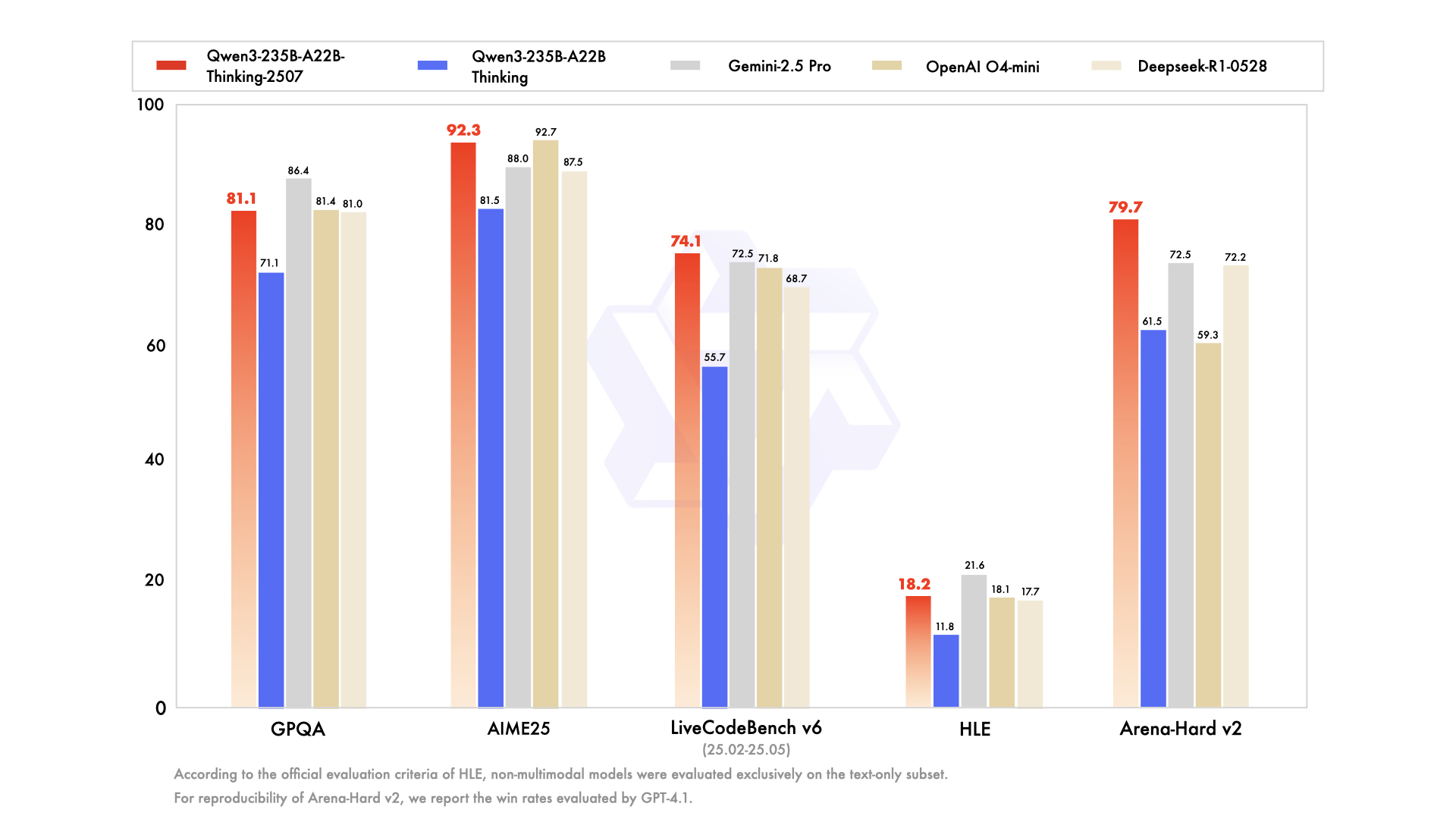

このモデルは、一般的な知識と問題解決のためのMMLU(Massive Multitask Language Understanding)、および数学的推論のための前述のGSM8KとMATHなど、これらの高度な認知能力を具体的に測定するベンチマークで優れた性能を発揮するように設計されています。

アクセシビリティ、量子化、コミュニティエンゲージメント

モデルの力は、アクセスして利用できる場合にのみ意味を持ちます。オープンソースへのコミットメントを忠実に守り、AlibabaはThinkingバリアントを含むQwen3ファミリーを、Hugging FaceやModelScopeのようなプラットフォームで広く利用できるようにしました。

この規模のモデルを実行するために必要な膨大な計算リソースを認識し、量子化されたバージョンも利用可能です。Qwen3-235B-A22B-Thinking-2507-FP8モデルはその典型的な例です。FP8(8ビット浮動小数点)は、モデルのメモリフットプリントを劇的に削減し、推論速度を向上させる最先端の量子化技術です。

その影響を分解してみましょう。

- 標準の16ビット精度(BF16/FP16)の2350億パラメータモデルは、470GBを超えるVRAMを必要とし、これは最大規模のエンタープライズグレードのサーバークラスター以外では法外な量です。

- しかし、FP8量子化バージョンは、この要件を250GB未満に削減します。依然としてかなりの量ですが、これにより、研究機関、スタートアップ企業、さらにはハイエンドのコンシューマーまたはプロシューマー向けハードウェアを搭載したマルチGPUワークステーションを持つ個人にとっても、モデルが実現可能な領域に入ります。

これにより、高度な推論がより幅広い層にアクセス可能になります。マネージドサービスを好むエンタープライズユーザー向けには、モデルはAlibabaのクラウドプラットフォームにも統合されています。Model Studioを介したAPIアクセスと、Alibabaの主力AIアシスタントであるQuarkへの統合により、この技術があらゆる規模で活用されることが保証されます。

結論:新しい種類の問題のための新しいツール

Qwen3-235B-A22B-Thinking-2507のリリースは、AIモデルのパフォーマンスが絶えず上昇するグラフ上の単なる別の点ではありません。それはAI開発の将来の方向性についての声明です。つまり、単一の汎用モデルから、強力で専門化されたツールの多様なエコシステムへの移行です。効率的なMixture-of-Expertsアーキテクチャを採用することで、Alibabaは2350億パラメータネットワークの膨大な知識と、220億パラメータのモデルに匹敵する計算上の親和性を持つモデルを提供しました。

このモデルを「思考」のために明示的にファインチューニングすることで、Qwenチームは世界に最も困難な分析および推論の課題を解決するためのツールを提供します。これは、研究者が複雑なデータを分析するのを助けることで科学的発見を加速し、企業がより良い戦略的決定を下せるように力を与え、前例のない洗練度で計画、推論、思考ができる新世代のインテリジェントアプリケーションの基盤層として機能する可能性を秘めています。オープンソースコミュニティがその深層を完全に探求し始めるにつれて、Qwen3-Thinkingは、より高性能で真にインテリジェントなAIを追求する継続的な探求において、重要な構成要素となるでしょう。

開発チームが最高の生産性で協力できる統合されたオールインワンプラットフォームをお探しですか?

Apidogはあなたのすべての要求に応え、Postmanをはるかに手頃な価格で置き換えます!