OpenAIは、高度な推論および問題解決タスク向けに設計された新しい製品o1-proを追加し、強力なAIモデルのラインアップを拡張しました。GPTシリーズを超えたOpenAIの進化の一環として、「o」モデルは特定の用途に最適化された専門的なAIシステムを表しています。この包括的なガイドでは、o1-proの機能、価格体系、APIテストツール(Apidogなど)を使用してアプリケーションに実装する方法など、知っておくべきすべてを探ります。

ボタン

o1-proとは?そしてどれほど優れているのか?

o1-proは、OpenAIの複雑な推論タスクのための専門モデルです。「o1」モデルファミリーの一部であり、段階的な思考と問題解決に優れています。「pro」バリアントはベースモデルよりも強化された機能を提供し、高度な推論を必要とする要求の厳しいアプリケーションに適しています。

一般的なモデルであるGPT-4oとは異なり、o1-proは論理的進行、数学的推論、および構造的分析を必要とするタスクに特に調整されています。この専門的な焦点により、計画的な思考と問題の分解が重要な分野で卓越したパフォーマンスを発揮します。

o1-proは以下の強みを持って設計されています:

- 高度な推論:複雑な問題を論理的なステップに分解するのに優れており、構造的思考と分析を必要とするタスクに最適です。複雑な意思決定ツリーをナビゲートし、明示的な推論経路を提供できます。

- 数学的問題解決:数学的推論、証明、計算をより高い精度で処理します。このモデルは、代数、微積分、統計、および形式論理に特に強みを示します。

- コード分析:詳細な理解を持ってコードを分析、デバッグ、および説明できます。複数のプログラミング言語に跨って作業し、論理エラーや最適化の機会を特定できます。

- 構造的思考:複雑なクエリに対して、より明確で構造的な応答を生成します。多段階の問題の自然な分解と、明確に区切られた推論を提供します。

- 研究と分析:論理的な組織でトピックの深堀分析を行い、異なる視点を比較し、証拠を体系的に評価します。

- 思考の連鎖処理:その推論プロセスを明示的に示し、複雑な思考の流れを追いやすくし、結論の検証を容易にします。

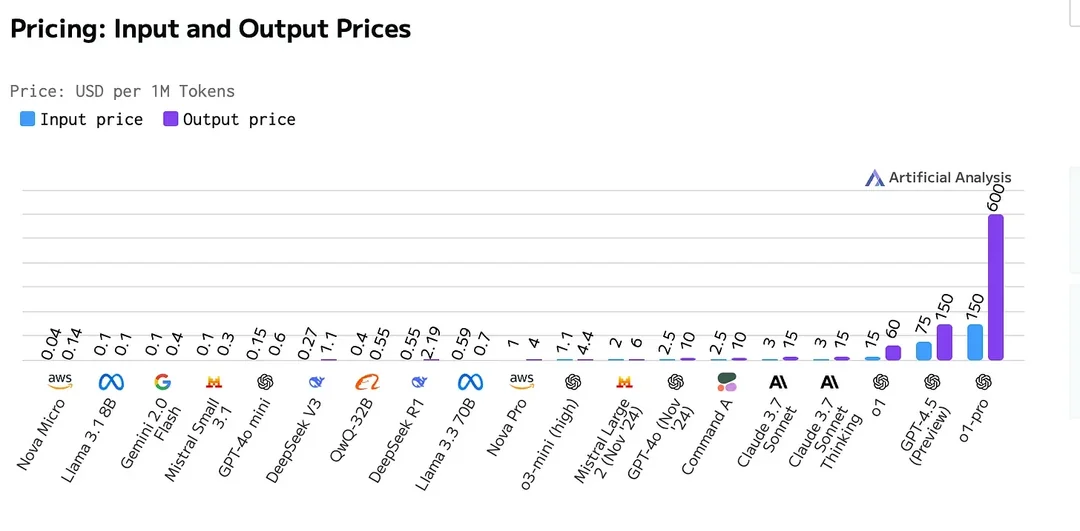

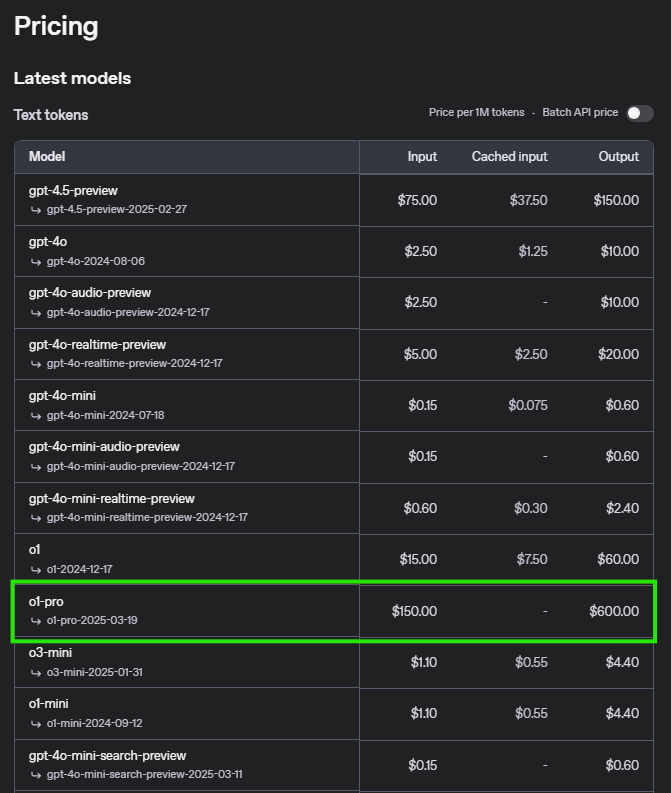

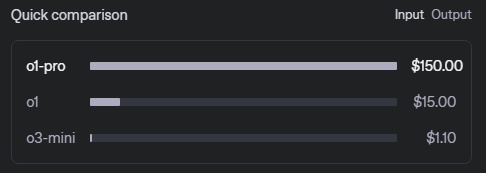

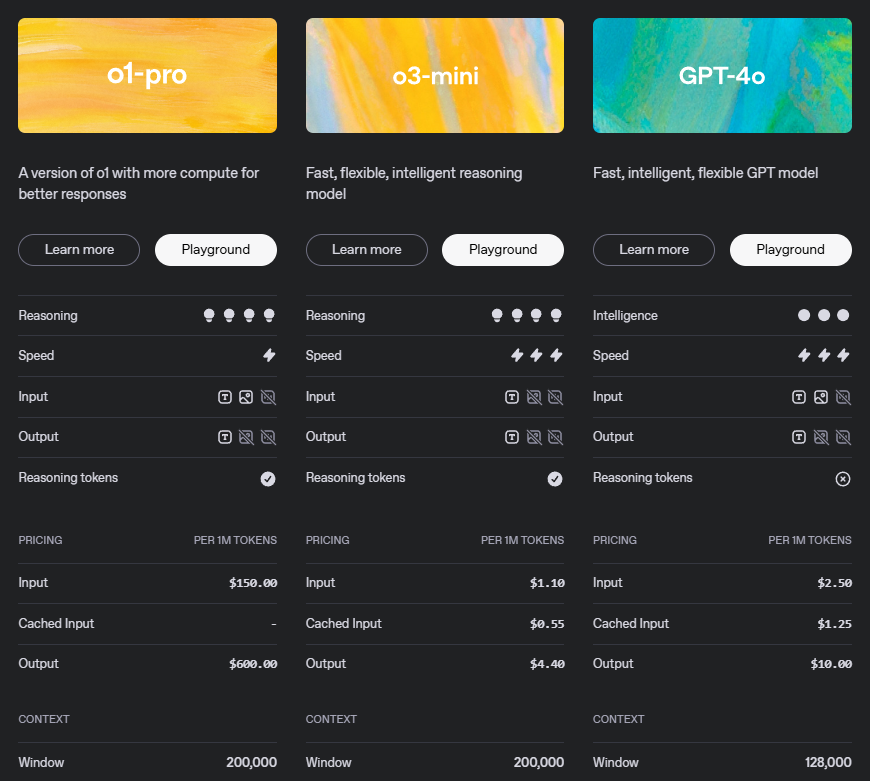

o1-pro APIの価格

価格体系を理解することは、APIの使用を計画する上で重要です。以下はo1-proの詳細な内訳です:

この価格モデルは、特に高度な推論および出力品質におけるo1-proの洗練された機能を反映しています。出力トークンの高いコストは、モデルが生成する構造的で論理的に整った応答の価値を認めています。

価格の例シナリオ

| 操作 | 価格 |

|---|---|

| 入力 (プロンプト) | $5/百万トークン |

| 出力 (完成) | $15/百万トークン |

シナリオ1: 小規模の使用

入力トークンが500,000、出力トークンが200,000のシナリオの場合:

- 入力コスト: 500,000トークン × 5/百万トークン = 2.50

- 出力コスト: 200,000トークン × 15/百万トークン = 3.00

- 合計コスト: $5.50

シナリオ2: 中規模の使用

入力トークンが500万、出力トークンが200万のシナリオの場合:

- 入力コスト: 5,000,000トークン × 5/百万トークン = 25.00

- 出力コスト: 2,000,000トークン × 15/百万トークン = 30.00

- 合計コスト: $55.00

シナリオ3: 大規模の使用

入力トークンが5000万、出力トークンが2000万のシナリオの場合:

- 入力コスト: 50,000,000トークン × 5/百万トークン = 250.00

- 出力コスト: 20,000,000トークン × 15/百万トークン = 300.00

- 合計コスト: $550.00

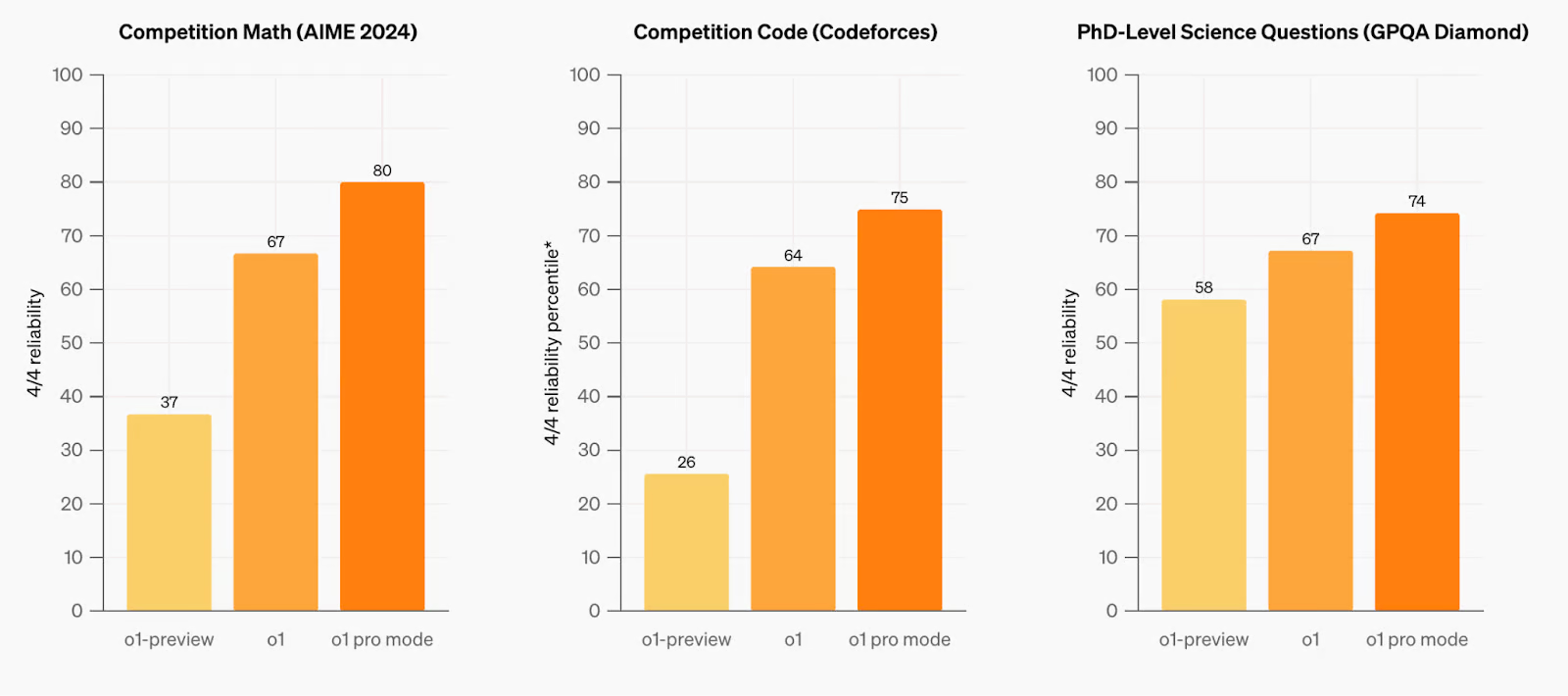

以前のモデルとの比較

o1-proは推論、問題解決、および長いコンテキスト理解において顕著な進展を示しています。このモデルは、さまざまなベンチマークを通じて厳格にテストされており、複雑なクエリや多段階推論タスクの処理においてその前のモデルよりも改善が見られます。数学、コーディング、構造的計画などの重要な分野で、o1-proは精度と信頼性が向上し、パフォーマンスと効率の両方で以前のモデルを超えています。その最適化されたアーキテクチャは、複雑なプロンプトの理解を向上させ、高度な推論と拡張されたコンテキスト能力を必要とするアプリケーションにとって強力な候補となります。

OpenAIモデルの完全な比較を、詳細な仕様とベンチマークとともに公式のOpenAIドキュメントページで見つけることができます。

OpenAI O1 Pro APIの要件とレート制限

| ティア | 資格 | 使用制限 |

|---|---|---|

| 無料 | ユーザーは許可された地域にいる必要があります | $100/月 |

| ティア 1 | $5支払い済み | $100/月 |

| ティア 2 | $50支払い済みおよび最初の成功した支払いから7日以上経過 | $500/月 |

| ティア 3 | $100支払い済みおよび最初の成功した支払いから7日以上経過 | $1,000/月 |

| ティア 4 | $250支払い済みおよび最初の成功した支払いから14日以上経過 | $5,000/月 |

| ティア 5 | $1,000支払い済みおよび最初の成功した支払いから30日以上経過 | $50,000/月 |

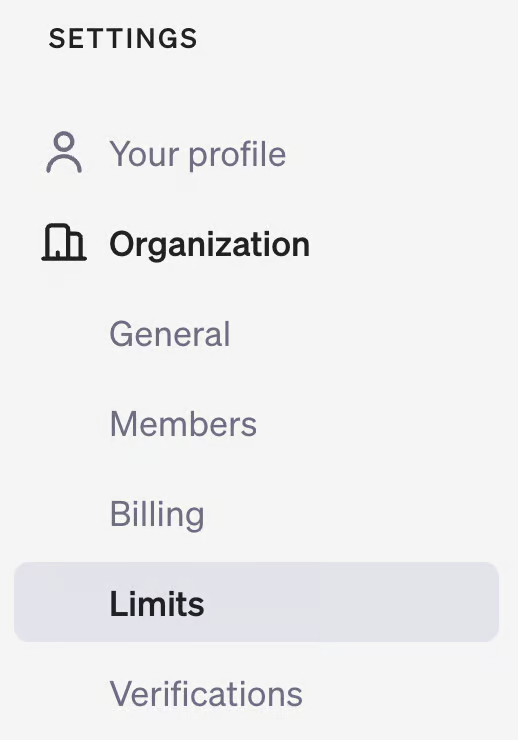

使用ティアを確認するには、OpenAI開発者プラットフォームのアカウントページを訪れ、「組織」の下にある「制限」セクションを確認してください。

o1 APIの使用方法

o1-proをアプリケーションに実装することは簡単です。以下の手順に従って始めましょう:

1. 前提条件

- OpenAI APIキー(OpenAIダッシュボードから取得)

- 適切なライブラリを備えた互換性のある開発環境

- OpenAIアカウントにリンクされた十分なAPIクレジットまたは支払い方法

2. インストール

好みのプログラミング言語用のOpenAIライブラリをインストールします:

Pythonの場合:

pip install openai

JavaScriptの場合:

npm install openai

他の言語については、OpenAIの公式ドキュメントでクライアントライブラリを参照してください。

3. Python実装例

オプションのパラメータを使用してPythonでo1-proを使用する方法は以下の通りです:

from openai import OpenAI

client = OpenAI(api_key="your-api-key")

response = client.chat.completions.create(

model="o1-pro",

messages=[

{"role": "system", "content": "あなたは数学的推論を専門とするAIアシスタントです。各ステップの説明とともに、明確かつ段階的な解決策を提供してください。"},

{"role": "user", "content": "次の微積分の問題を段階的に解いてください: f(x) = x^3*ln(x)の導関数を見つける。"}

],

temperature=0.1, # より正確な推論のために低めの温度

max_tokens=1024, # 期待される応答の長さに基づいて調整

top_p=0.95,

frequency_penalty=0,

presence_penalty=0

)

print(response.choices[0].message.content)

4. JavaScript実装例

Node.jsアプリケーションの詳細な設定の場合:

import OpenAI from 'openai';

const openai = new OpenAI({

apiKey: 'your-api-key',

});

async function askO1Pro() {

try {

const response = await openai.chat.completions.create({

model: 'o1-pro',

messages: [

{role: 'system', content: 'あなたは論理的推論を専門とするAIアシスタントです。各ステップの説明とともに明確で段階的な解決策を提供してください。'},

{role: 'user', content: '次の論理的な議論を分析し、いかなる誤謬を特定してください: すべての鳥は飛ぶことができる。ペンギンは鳥である。したがって、ペンギンは飛べる。'}

],

temperature: 0.1,

max_tokens: 1024,

top_p: 0.95,

frequency_penalty: 0,

presence_penalty: 0

});

console.log(response.choices[0].message.content);

// オプション: トークン使用量を追跡

console.log("プロンプトトークン:", response.usage.prompt_tokens);

console.log("完成トークン:", response.usage.completion_tokens);

console.log("合計トークン:", response.usage.total_tokens);

} catch (error) {

console.error('エラー:', error);

}

}

askO1Pro();

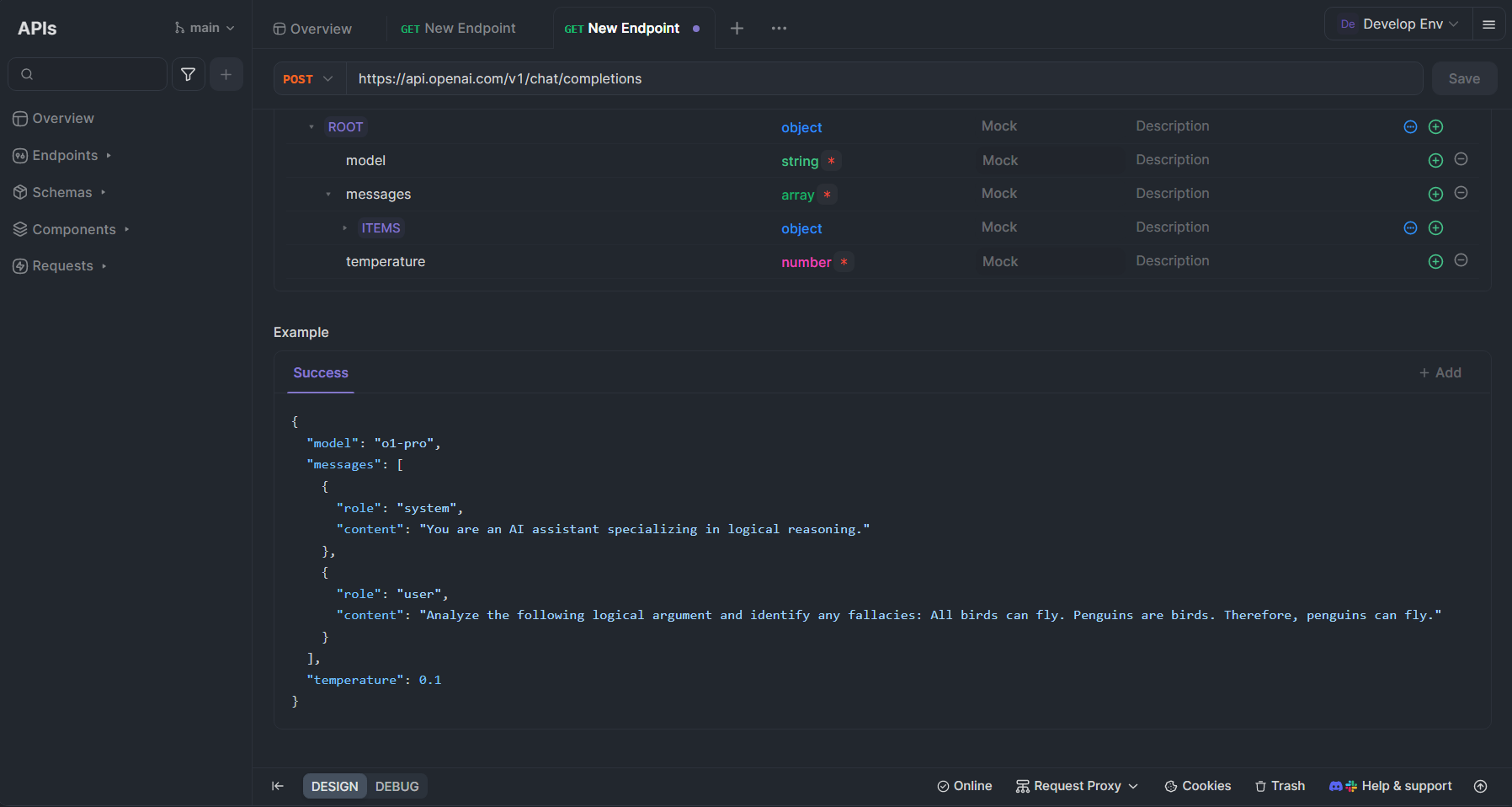

Apidogを使用したo1-pro APIのテスト

Apidogは、o1-proやその他のOpenAI APIとの作業を大幅に簡素化できる包括的なAPI開発プラットフォームです。以下は、o1-proのテストおよび統合にApidogを活用する方法です:

Apidogでのo1-proの設定

- アカウントの作成: まだアカウントを持っていない場合は、apidog.comでApidogにサインアップしてください。

- 新しいAPIコレクションの作成: Apidogダッシュボードで、OpenAI API専用の新しいコレクションを作成します。

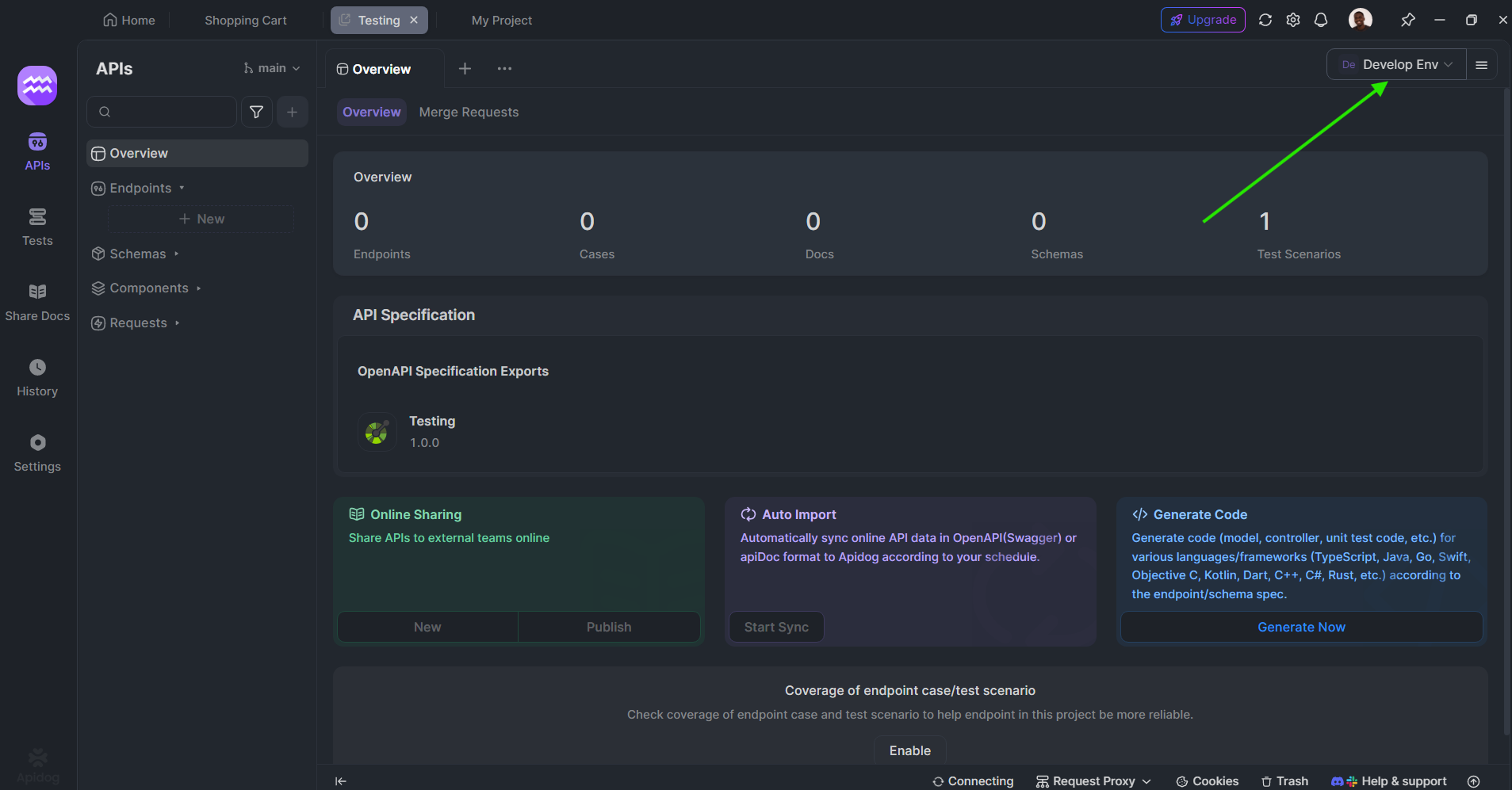

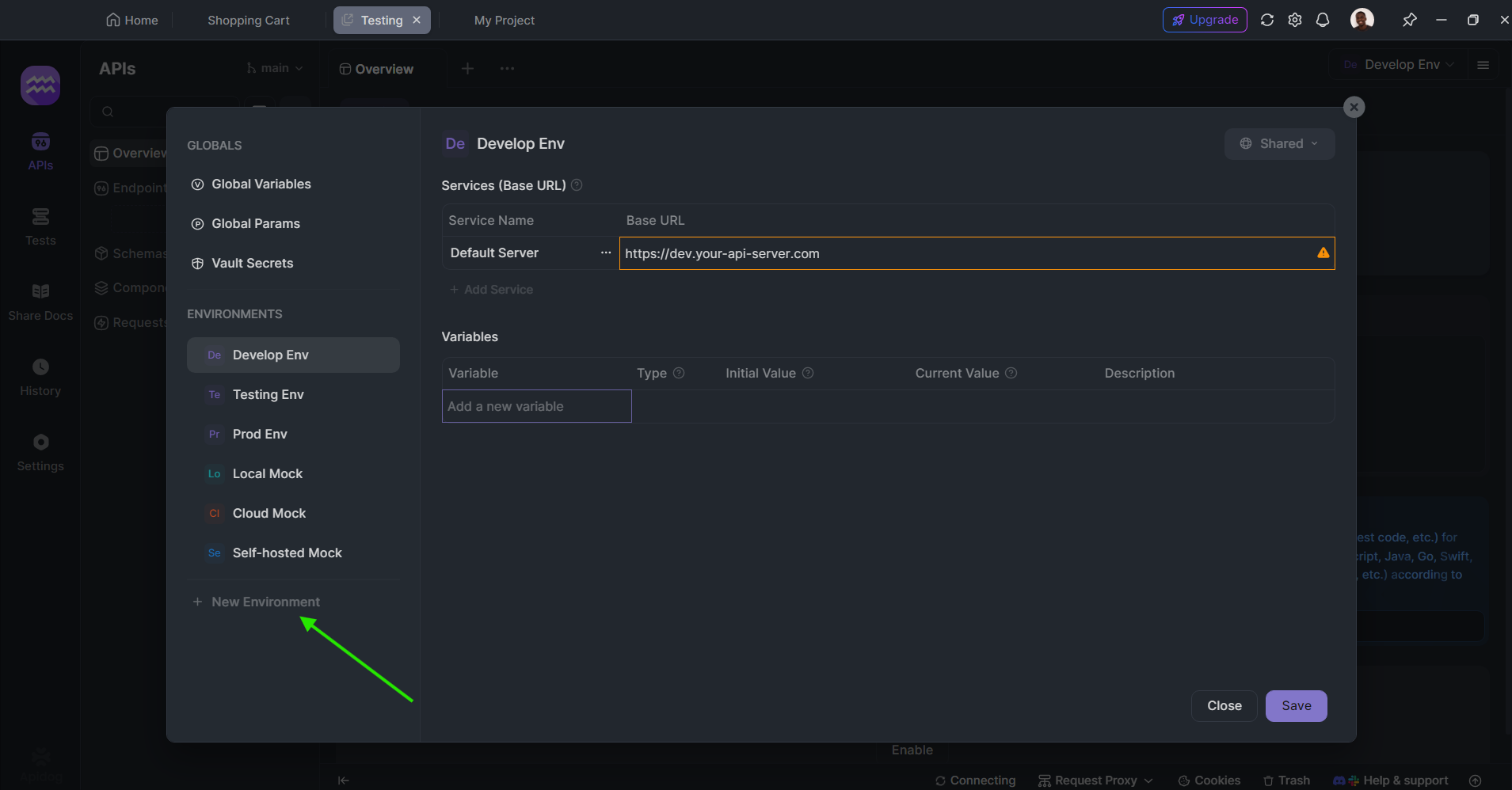

環境変数の設定: OpenAI APIキーを安全かつ便利にアクセスできるよう環境変数として構成します:

- 右上隅の「環境」に移動します。

- 「OpenAI」という名前の新しい環境を作成します。

- 実際のAPIキーを値として「OPENAI_API_KEY」という名前の変数を追加します。

o1-proのリクエストを作成する:

- 新しいPOSTリクエストを作成します。

- URLを

https://api.openai.com/v1/chat/completionsに設定します。 - 値として

Bearer {{OPENAI_API_KEY}}を含むAuthorizationヘッダーを追加します。 - リクエストボディ(JSON)に以下を使用します:

{

"model": "o1-pro",

"messages": [

{

"role": "system",

"content": "あなたは論理的推論を専門とするAIアシスタントです。"

},

{

"role": "user",

"content": "次の論理的議論を分析し、いかなる誤謬を特定してください: すべての鳥は飛ぶことができる。ペンギンは鳥である。したがって、ペンギンは飛べる。"

}

],

"temperature": 0.1

}

o1-proとの使用におけるApidogの利点

Apidogは、o1-proと連携するためのいくつかの利点を提供します:

- インタラクティブテスト:API呼び出しをリアルタイムでテストし、フォーマットされた応答を確認することで、プロンプトを簡単に反復できます。

- 自動ドキュメント化:API実装を自動的にドキュメント化し、チームのコラボレーションを容易にします。

- APIモッキング:開発中のo1-pro API呼び出しのためのモック応答を作成します。

- コラボレーション機能:チームメンバーとAPIコレクションを共有して共同開発を促進します。

- 環境管理:異なるAPIキーで開発、ステージング、プロダクション環境の間を簡単に切り替えます。

- 応答の視覚化:トークン使用量とコストの視覚的な表現を提供し、予算管理を向上させます。

- リクエスト履歴:以前のAPI呼び出しを追跡し、参照および最適化を行います。

o1-pro API使用のベストプラクティス

o1-proの効果を最大化し、コストを最適化するためには:

- プロンプトを明確に構造化する:複雑な推論タスクの場合、プロンプトを明確な指示と期待される出力で構造化します。多部分の問題に対しては、箇条書きや番号付きの指示を使用することを検討してください。

- システムメッセージを効果的に使用する:推論アプローチをガイドするために、システムメッセージでコンテキストを設定します。期待される推論の種類(演繹的、帰納的など)について具体的に述べます。

温度パラメータを調整する:

- より正確で決定論的な推論や数学的問題には低い温度(0.1-0.3)を使用します。

- バランスの取れた推論には適度な温度(0.3-0.7)を使用します。

- 創造的な問題解決アプローチには高い温度を使用します。

- 段階的思考を要求する:複雑な問題を解く際には、詳細な推論ステップを明示的に求めます。「ステップバイステップで考えてください」や「あなたの推論を示してください」といったフレーズがo1-proの強みを活性化します。

- トークン使用量を監視する:コストを効果的に管理するために、入力トークンと出力トークンを追跡します。アプリケーションにトークン見積もり機能を実装することを検討してください。

- 関連するクエリをバッチ処理する:可能な場合、関連する質問を単一のAPI呼び出しにまとめ、複数の個別の呼び出しを行わないようにします。

- キャッシングを実装する:頻繁にリクエストされる情報に対して冗長なAPI呼び出しを避けるために、一般的な応答をキャッシュします。

- 思考の連鎖技法を使用する:複雑な問題については、モデルに「最終的な答えを提供する前に、この問題をステップバイステップで考えてみてください」と問いかけ、思考の連鎖を促進します。

結論

o1-proはAI推論能力の重要な進歩を表し、構造的思考と複雑な問題解決を必要とするタスクのための強力なツールを提供します。その競争力のある価格体系と簡単な実装により、高度な推論機能をアプリケーションに強化したい開発者にとってアクセス可能です。

この記事で示した実装ガイドラインとベストプラクティスに従うことで、o1-proを効率的にワークフローに統合し、その洗練された推論能力を活用しながらAPIコストを効率的に管理できます。Apidogのようなツールは、開発とテストプロセスをさらに簡素化し、特定のユースケースに対してo1-proの真の可能性を引き出すのを容易にします。

AI推論能力が進化し続ける中、o1-proのようなモデルは、単に知性を必要とするのではなく、ユーザーが追随して理解できる構造的で論理的な思考を必要とするアプリケーションにおいて、ますます重要な要素となるでしょう。