Llama 3.1やMistralのような強力な言語モデルと、ターミナルに縛られることなくチャットしたいですか?Open WebUIは、OllamaのLLMとの対話を楽しく直感的にする、洗練されたChatGPTのようなインターフェースへの切符です。チャット履歴の保存、プロンプトの保存、さらにドキュメントをアップロードしてより賢い応答を得ることも、すべてブラウザで行えます。この初心者向けガイドでは、Ollamaのインストール、ターミナルでのモデルテスト、そしてOpen WebUIを使ってよりユーザーフレンドリーな体験にレベルアップする方法を順を追って説明します。迅速なセットアップのためにDockerを使用し、楽しいプロンプトでテストします。AIチャットを簡単に始める準備はできましたか?さあ、始めましょう!

Open WebUIとは?あなたのLLMコマンドセンター

Open WebUIは、Ollamaに接続するオープンソースのセルフホスト型ウェブインターフェースで、Llama 3.1やMistralのような大規模言語モデル(LLM)とブラウザベースのダッシュボードで対話できます。Ollamaのコマンドラインインターフェースとは異なり、Open WebUIはChatGPTのように感じられ、以下の機能を提供します。

- チャット履歴: 会話を保存し、後で参照できます。

- プロンプト保存: よく使うプロンプトを保存し、再利用できます。

- ドキュメントアップロード: コンテキストを考慮した応答(検索拡張生成、RAG)のためにファイルを添付できます。

- モデル切り替え: ワンクリックでモデルを簡単に切り替えられます。

5万以上のGitHubスターを獲得しているOpen WebUIは、LLMをローカルで共同作業的かつグラフィカルに操作したい開発者やAI愛好家に人気です。まず、Ollamaを起動して、なぜOpen WebUIを追加する価値があるのかを見てみましょう!

Ollamaのインストールとテスト

Open WebUIに入る前に、Ollamaをセットアップし、Llama 3.1やMistralのようなモデルをターミナルでテストしてみましょう。これにより、Open WebUIの直感的なインターフェースの良さを理解するための基準が得られます。

1. システム要件の確認:

- OS: Windows、macOS、またはLinux(Ubuntu 24.04など)。

- ハードウェア: モデル用に少なくとも16GBのRAMと10GBの空きストレージ(Llama 3.1 8Bは約5GB必要)。GPU(例: NVIDIA 1060 4GB)はパフォーマンス向上のためにオプションです。

- ソフトウェア: Ollama、ollama.comからダウンロード可能。

2. Ollamaのインストール: ollama.comからお使いのOS用のOllamaをダウンロードしてインストールします。インストーラーの指示に従ってください。素早くセットアップできます。インストールを確認するには、以下を実行します。

ollama --version

0.1.44(2025年4月)のようなバージョンが表示されるはずです。失敗する場合は、OllamaがPATHに含まれていることを確認してください。

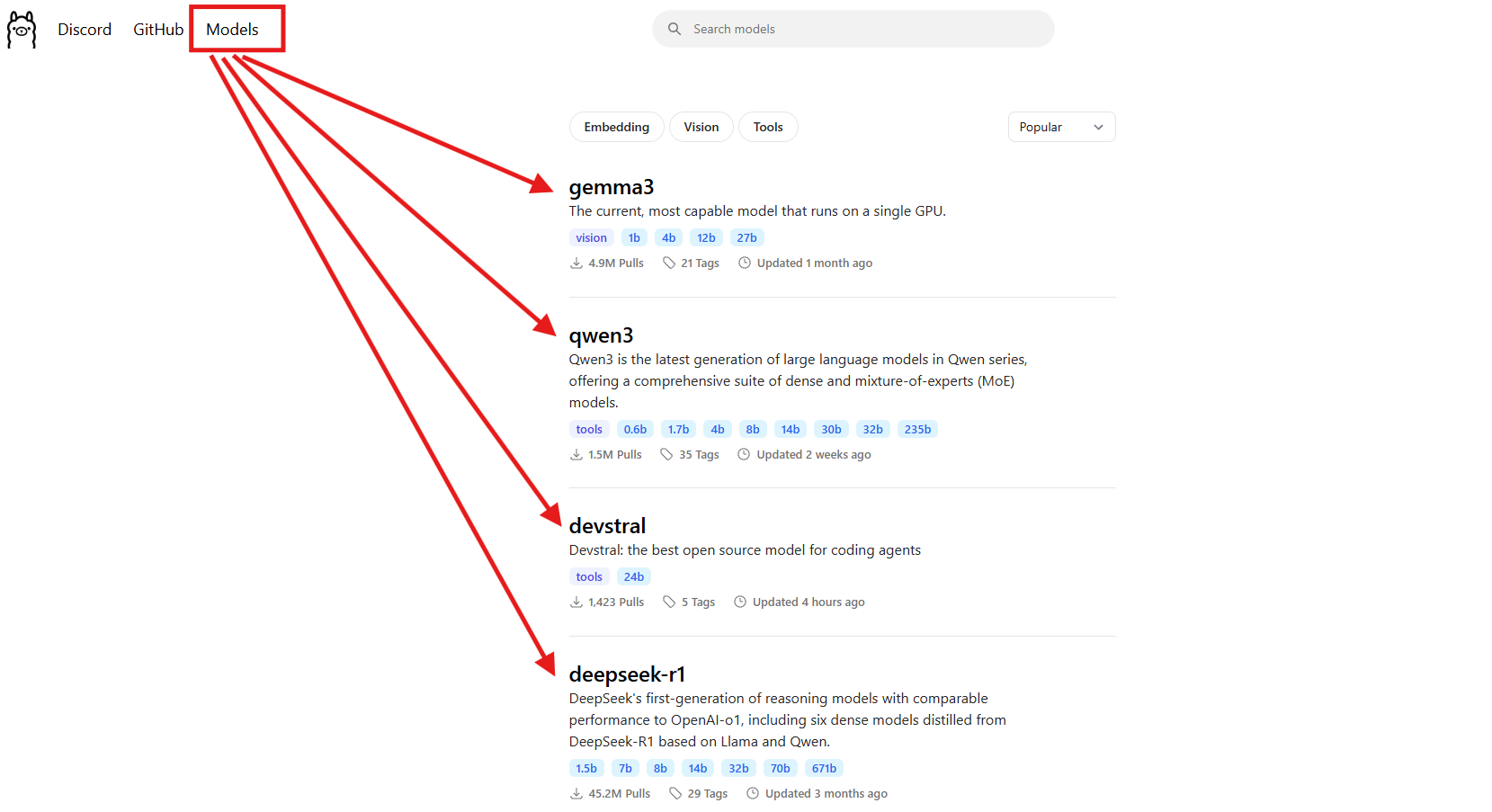

3. モデルのダウンロード: Llama 3.1 (8B) または Mistral (7B) のようなモデルを選択します。このガイドでは、Llama 3.1を使用します。

ollama pull llama3.1

これは約5GBをダウンロードするため、インターネットが遅い場合はコーヒーでも飲みましょう。インストールされたことを確認するには:

ollama list

llama3.1:latestを探してください。Mistral(ollama pull mistral)も、より軽量なモデル(約4GB)が必要な場合は素晴らしい選択肢です。

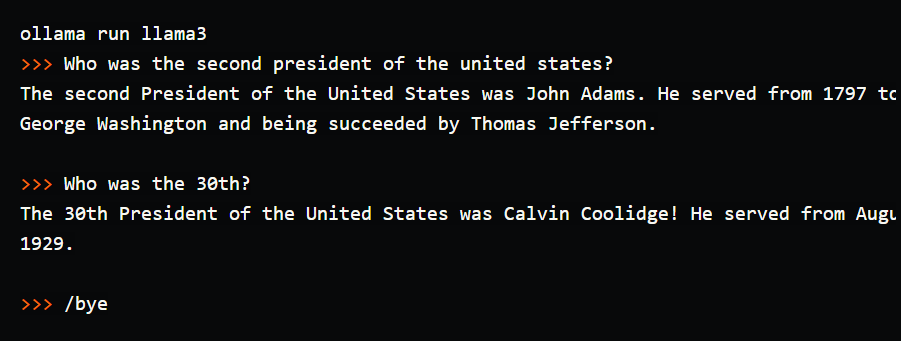

4. ターミナルでモデルをテスト: Ollamaの動作を確認するために簡単なプロンプトを試してみましょう。

ollama run llama3.1

プロンプト(>>>)で、「Tell me a dad joke about computers.」(コンピューターに関する親父ギャグを教えてください。)と入力し、Enterを押します。「Why did the computer go to the doctor? It had a virus!」(なぜコンピューターは医者に行ったの?ウイルスにかかったんだ!)のような応答が得られるかもしれません。/byeで終了します。これを実行したところ、思わず笑ってしまうジョークが得られましたが、ターミナルでの入力はぎこちなく感じました。チャット履歴もなく、プロンプトも保存されません。ここでOpen WebUIが輝きを放ちます。会話を保存したり、プロンプトを再利用したり、より豊かな応答のためにドキュメントをアップロードしたりできる視覚的なインターフェースを提供します。セットアップしましょう!

Open WebUIのための環境設定

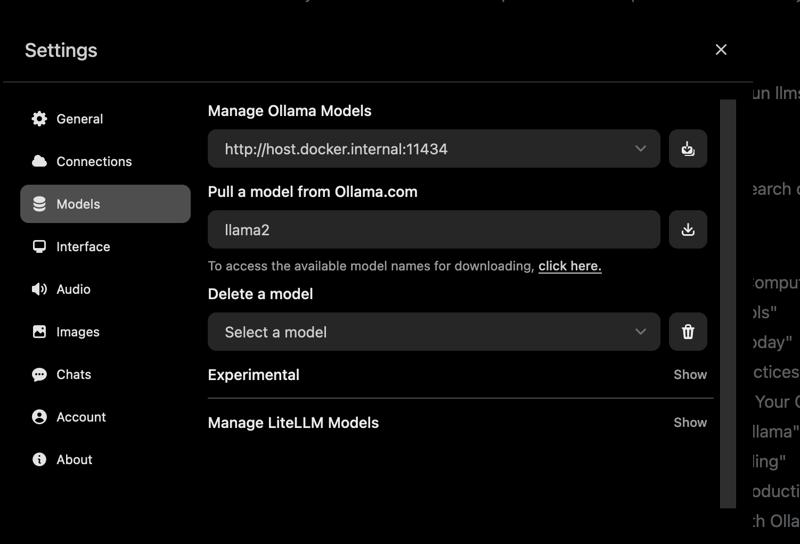

Ollamaのターミナルインターフェースを確認したので、LLM体験をより直感的にするためにOpen WebUIの準備をしましょう。Open WebUIのセットアップにはDockerが必要なので、Dockerがインストールされていることを前提とします。

1. Dockerの確認: Dockerがインストールされ、実行されていることを確認します。

docker --version

Docker 27.4.0のようなものが表示されるはずです。Dockerがない場合は、公式ウェブサイトからDocker Desktopをダウンロードしてインストールしてください。Windows、macOS、Linuxで素早くセットアップできます。

2. プロジェクトフォルダの作成: 物事を整理しておきましょう。

mkdir ollama-webui

cd ollama-webui

このフォルダがOpen WebUIを実行するための拠点となります。

3. Ollamaが実行されていることを確認: 別のターミナルでOllamaを起動します。

ollama serve

これにより、OllamaのAPIがhttp://localhost:11434で実行されます。Open WebUIはモデルに接続するためにこれが必要なので、このターミナルは開いたままにしておいてください。

Dockerを使ったOpen WebUIのインストール

OllamaとLlama 3.1の準備ができたので、高速で信頼性の高いセットアップのために、単一のDockerコマンドを使用してOpen WebUIをインストールしましょう。

1. Open WebUIの実行: ollama-webuiフォルダで、以下を実行します。

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

このコマンドは以下を行います。

- Open WebUIイメージ(

ghcr.io/open-webui/open-webui:main、約3.77GB)をプルします。 - ブラウザからのアクセス用に、ポート3000(ローカル)を8080(コンテナ)にマッピングします。

- OllamaのAPI(

localhost:11434)に接続するためにhost.docker.internalを追加します。 - チャット履歴と設定を永続化するためにボリューム(

open-webui)を使用します。 - コンテナに

open-webuiという名前を付け、自動的に再起動するように設定します。

ダウンロードには数分かかります。docker psで実行中か確認してください。open-webuiコンテナを探します。

2. Open WebUIへのアクセス: ブラウザを開き、http://localhost:3000にアクセスします。Open WebUIのウェルカムページが表示されます。「Sign Up」をクリックしてアカウントを作成します(最初のユーザーが管理者権限を得ます)。強力なパスワードを使用し、安全に保存してください。これでチャットの準備ができました!ページがロードされない場合は、コンテナが実行されていること(docker logs open-webui)、およびポート3000が空いていることを確認してください。

Open WebUIの使用:チャットと機能の探索

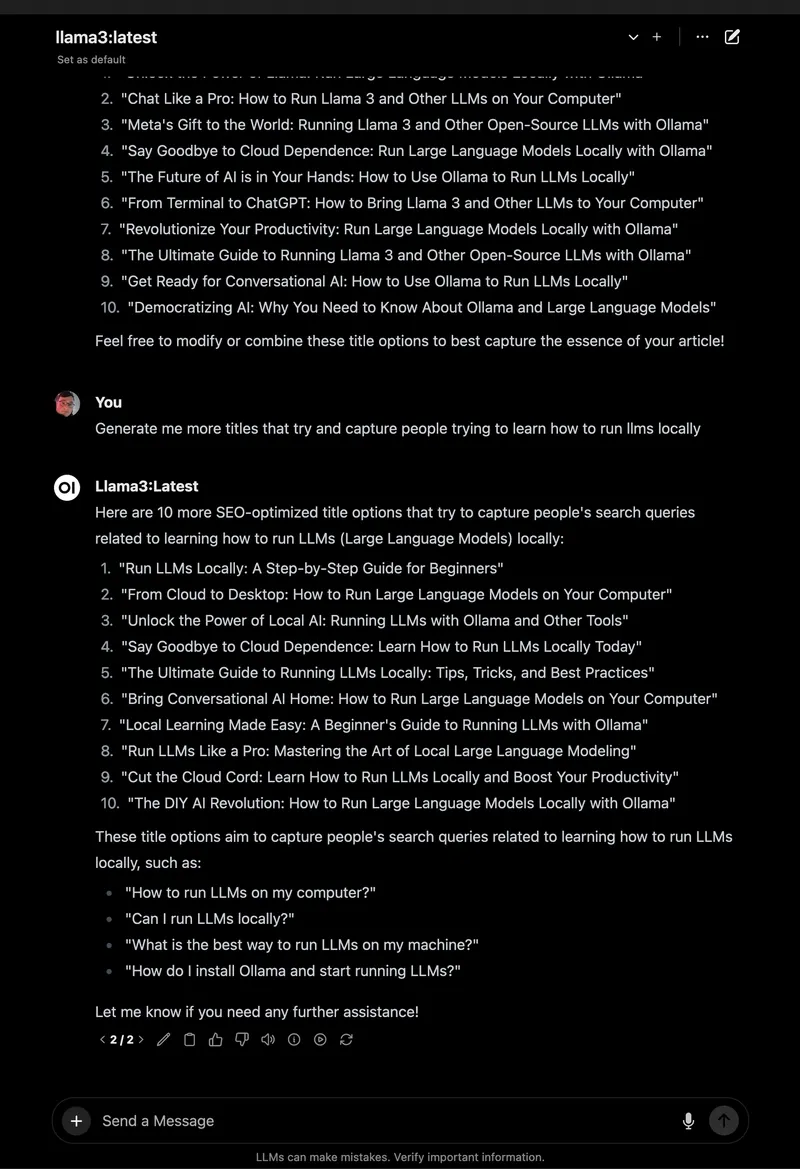

Open WebUIが実行されたので、Llama 3.1とのチャットや、ターミナルよりも大幅にアップグレードされた素晴らしい機能を探索しましょう。

1. チャットを開始:

- Open WebUIで、左上のモデルセレクターから

llama3.1:8bを選択します(プル済みなので表示されるはずです)。 - サイドバーの「New Chat」をクリックします。

- 同じプロンプト「Tell me a dad joke about computers.」を入力します。

- Enterを押します。「Why did the computer go to art school? Because it wanted to learn to draw a better byte!」のような応答が得られます。

インターフェースはすっきりしており、プロンプトと応答はチャット履歴に自動的に保存されます。

2. チャットの保存と整理: 左サイドバーのピンアイコンをクリックしてチャットを保存します。(例:「Dad Jokes」)のように名前を変更すると、簡単にアクセスできます。サイドバーからチャットをアーカイブまたは削除でき、実験を整理できます。ターミナルでスクロールするよりもはるかに優れています!

3. プロンプトの保存: 親父ギャグのプロンプトを再利用するために保存します。

- Settings > Promptsに進みます。

- 「New Prompt」をクリックし、「Dad Joke」と名前を付け、「Tell me a dad joke about computers.」を貼り付けます。

- 保存します。これで、ワンクリックで任意のチャットに適用できます。

4. RAGのためにドキュメントをアップロード: チャットにコンテキストを追加します。

- チャット入力欄の「#」アイコンをクリックしてドキュメントライブラリを開きます。

- テキストファイル(例:Spring Boot 3.2ガイド)をアップロードします。

- 「How do I use the REST Client in Spring Boot 3.2?」(Spring Boot 3.2でREST Clientを使用するにはどうすればいいですか?)と質問します。Llama 3.1はドキュメントを参照し、

RestClient.create().get().uri("/users").retrieve()のようなコードスニペットを提供します。

私はこれをPythonチュートリアルのPDFでテストしましたが、Open WebUIはターミナルの基本的な応答とは異なり、コンテキストを考慮した回答を見事に生成しました。

5. その他の機能を探索:

- モデルの切り替え: モデルセレクターを使用して、Mistralやプルした他のモデル(

ollama pull mistral)を試します。 - 応答のカスタマイズ: 「Chat Control」をクリックして、トーン(例:「funny」)や長さを調整します。

- 管理者ツール: Settings > Adminで、ユーザーを管理したり、モデルへのアクセスを制限したりできます(チームに最適です)。

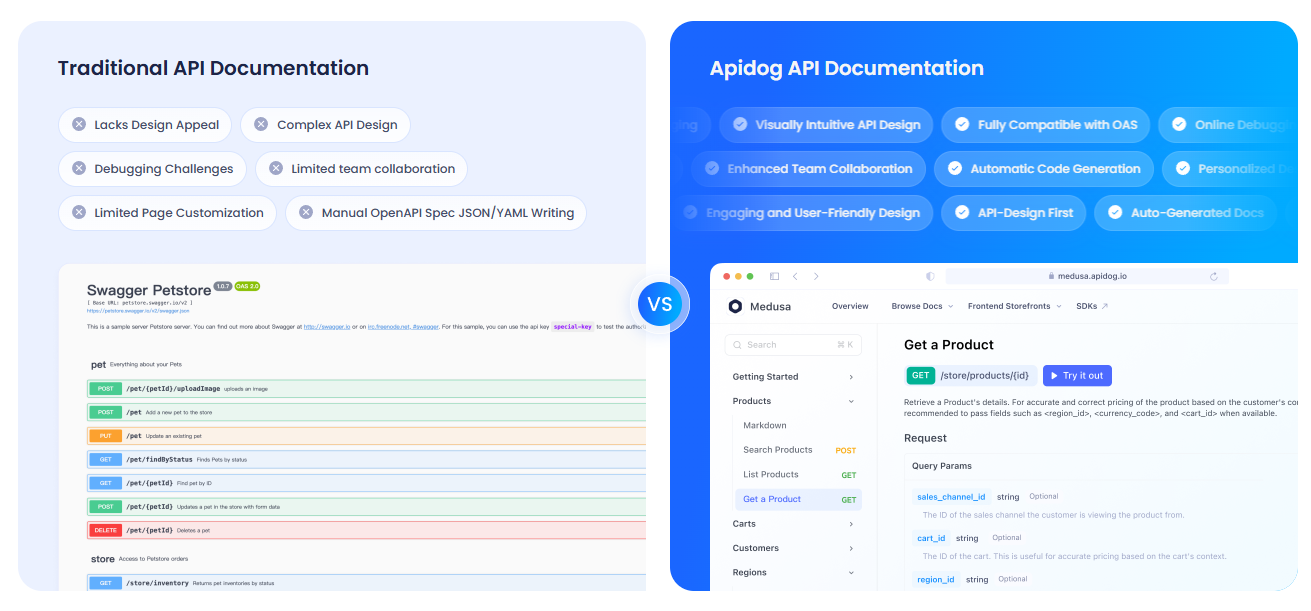

APIdogを使ったAPIのドキュメント化

OllamaのAPIと対話するためにOpen WebUIを使用しており、そのセットアップをドキュメント化したいですか?Apidogは、インタラクティブなAPIドキュメントを作成するための素晴らしいツールです。洗練されたインターフェースとセルフホスティングオプションにより、AIプロジェクトを共有するのに理想的です。ぜひチェックしてみてください!

トラブルシューティングとヒント

- 接続の問題: Open WebUIがOllamaを見つけられない場合は、

ollama serveが実行されており、ポート11434が開いていることを確認してください。Dockerログを確認します:docker logs open-webui。 - ポートの競合: ポート3000が使用されている場合は、コンテナを停止し(

docker stop open-webui)、削除し(docker rm open-webui)、新しいポート(例:-p 3001:8080)でdocker runコマンドを再実行します。 - 応答が遅い: Ollamaの

:cudaタグ付きGPUまたはMistralのようなより小さなモデルを使用して速度を向上させます。 - コミュニティ: Open WebUIのGitHub DiscussionsまたはDiscordに参加して、サポートやアイデアを得ましょう。

Open WebUIを選ぶ理由

Open WebUIは、Ollamaを扱いにくいターミナルツールから、強力でユーザーフレンドリーなプラットフォームに変身させます。

- 直感的なインターフェース: ブラウザベースのダッシュボードは初心者にもプロにも最適です。

- 整理機能: 保存されたチャットやプロンプトは、ターミナルログとは異なり、作業を整理整頓できます。

- コンテキスト認識: ドキュメントのアップロードによりRAGが可能になり、より賢い回答が得られます。

- プライバシー: ローカルで実行されるため、データは安全に保たれます。

ターミナルとOpen WebUIの両方をテストした結果、私はGUIの使いやすさと機能に納得しました。それはフリップフォンからスマートフォンにアップグレードするようなものです!

まとめ:Open WebUIの冒険があなたを待っています

ターミナルでのチャットから、Ollamaを使った本格的なOpen WebUIセットアップへと進み、LLMとの対話がスムーズで楽しいものになりました!Llama 3.1、保存されたチャット、ドキュメントのアップロードにより、これまでにない方法でAIを探索する準備が整いました。新しいモデルを試したり、プロンプトをさらに保存したり、APIdogでAPIをドキュメント化したりしましょう。Open WebUIの成果をOpen WebUIのGitHubで共有してください。皆さんが何を作成するか楽しみにしています!ハッピーなAIいじりを!