Ollamaは、新しいWeb検索APIとMCPサーバーにより、ローカルAI機能を強化します。開発者はリアルタイム情報にアクセスしてモデルのパフォーマンスを向上させることができます。さらに、このアップデートにより、さまざまなクライアント間でのツール統合が合理化されます。

Ollamaは、大規模言語モデルをローカルで実行するための堅牢なプラットフォームです。エンジニアはクラウドサービスに依存することなくモデルをデプロイするためにOllamaを活用しています。しかし、Web検索APIの追加により、その適用範囲は拡大します。このAPIにより、モデルはインターネットを直接クエリできるようになります。結果として、アプリケーションは最新のイベントや動的なデータをより効果的に処理できます。

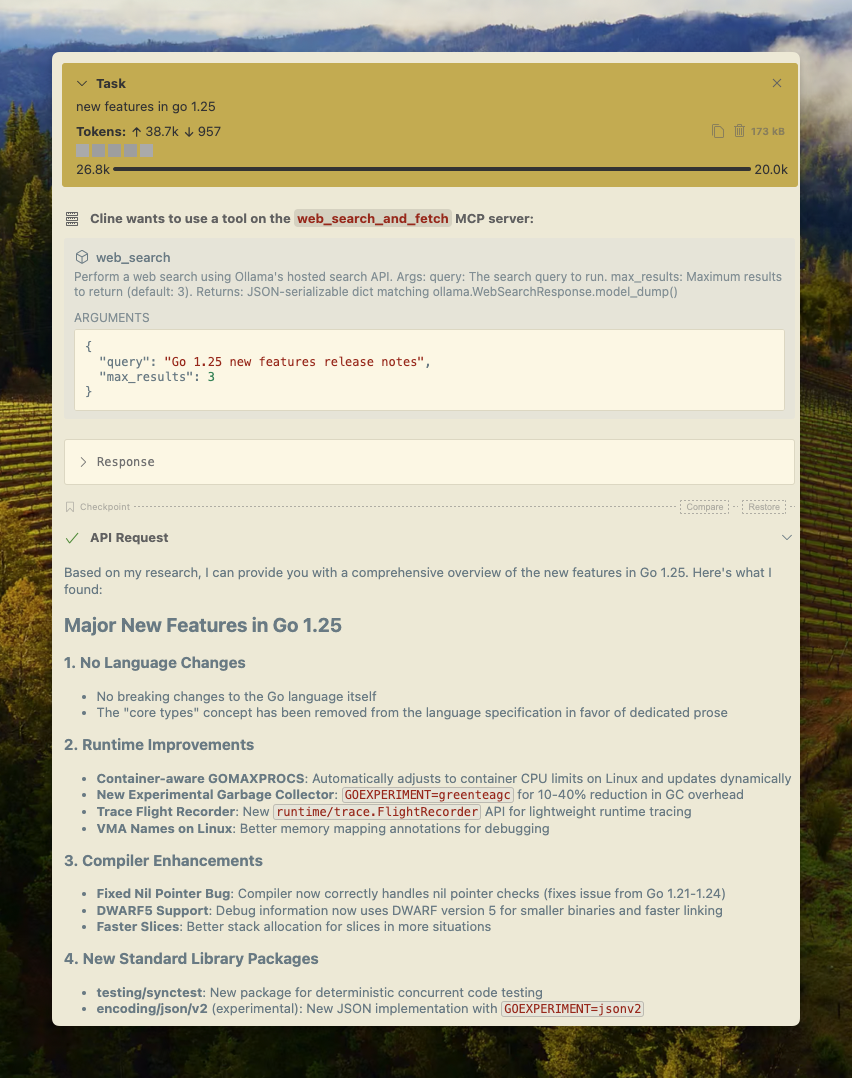

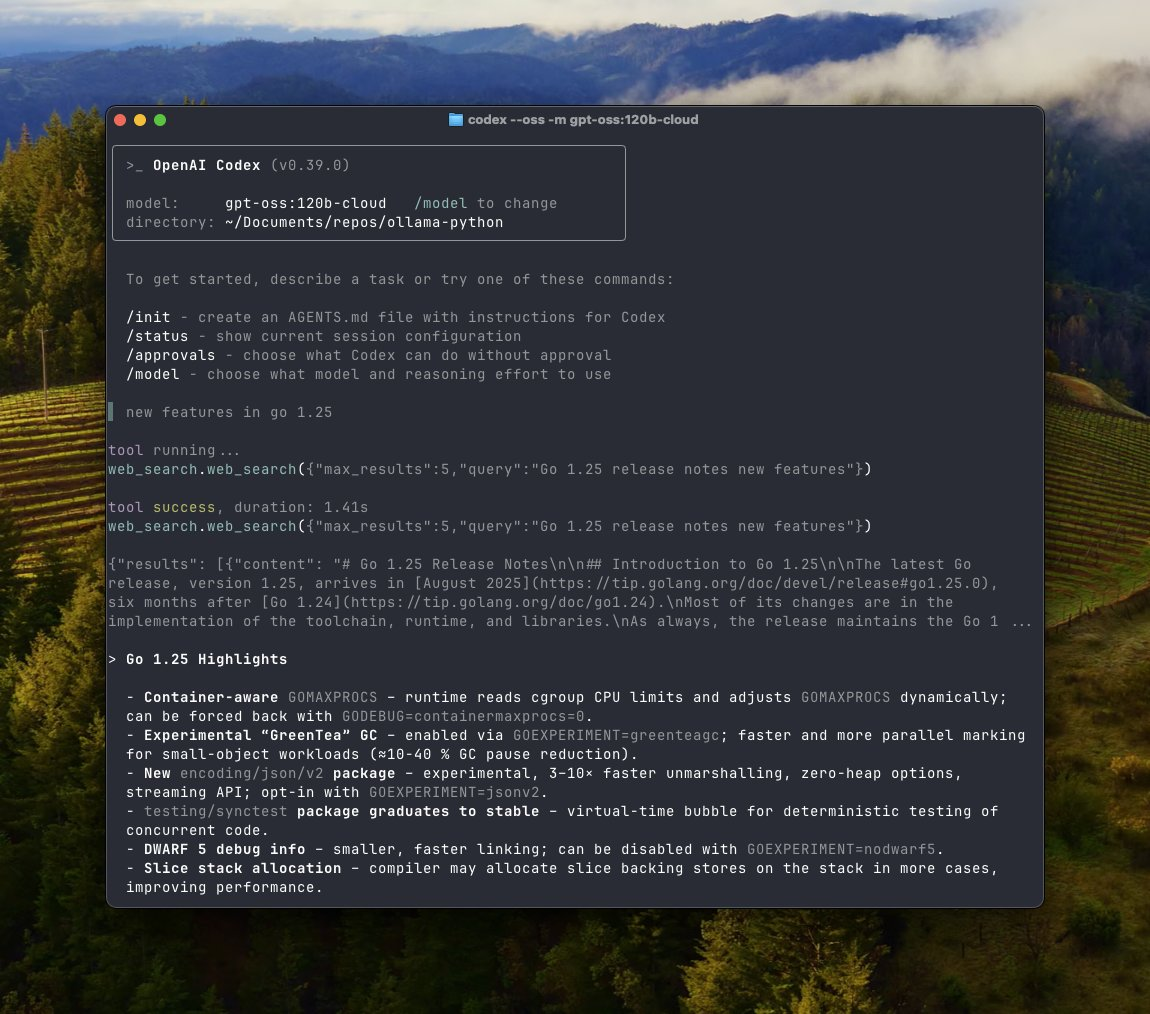

MCPサーバーは、コンテキスト交換のための標準化されたプロトコルを提供することで、これを補完します。開発者はモデルを外部ツールに簡単に接続できます。例えば、MCPサーバーはCline、Codex、Gooseなどのクライアントと統合します。この設定により、モデルがWeb検索結果とリアルタイムで対話する複雑なワークフローが可能になります。

技術的な詳細に移ると、OllamaのWeb検索APIはRESTエンドポイントを介して動作します。ユーザーはクエリパラメータとともにhttps://ollama.com/api/web_searchにPOSTリクエストを送信します。システムは関連する結果を返しますが、デフォルトでは最大10件に制限されます。さらに、https://ollama.com/api/web_fetchにあるWebフェッチAPIは、特定のURLからコンテンツを取得します。どちらもOllamaアカウントのAPIキーが必要です。

Ollamaはプラットフォーム間のアクセシビリティを保証します。macOSでは、ユーザーはHomebrewを介してインストールします。Windowsユーザーは実行ファイルを直接ダウンロードします。Linuxは簡単なパッケージマネージャーをサポートしています。どのプラットフォームでも、APIは統一的に統合されます。

開発者がOllamaについて知っておくべきこと

Ollamaは、LlamaやQwenのようなモデルのローカル推論を可能にします。量子化されたモデルを効率的にダウンロードします。ユーザーは`ollama pull qwen3:4b`のようなコマンドでモデルをプルします。このプロセスは、NVIDIA GPUやApple Siliconのようなハードウェアに最適化されています。

さらに、Ollamaはマルチモーダルタスクをサポートしています。例えば、テキストとともに画像や動画を処理します。プラットフォームは急速に進化しており、スケジューリングとコンテキスト処理を強化するアップデートが行われています。

開発者はOllamaのオープンソース性を高く評価しています。ベンダーロックインなしでモデルをカスタマイズできます。しかし、静的な知識には限界があります。過去のデータで訓練されたモデルは、最新の情報に対応するのに苦労します。ここでWeb検索APIが介入します。

OllamaのAPIはこのギャップに対処します。新しいデータで応答を補強します。その結果、ハルシネーションが大幅に減少します。エンジニアは研究や自動化のための信頼性の高いアプリケーションを構築できます。

MCPサーバーに移行すると、このコンポーネントはインタラクションを標準化します。MCP、つまりModel Context Protocolは、モデルとシステム間のデータ交換を促進します。OllamaはPythonでMCPサーバーを実装しており、シームレスなツール使用を可能にします。

例えば、MCPサーバーはファイル操作、計算、Webアクセスを可能にします。開発者はローカルLLM向けにこれを構成し、基本的な推論を超えた機能を拡張できます。

OllamaのWeb検索APIを深く掘り下げる

OllamaのWeb検索APIは構造化された結果を提供します。ユーザーはクエリとオプションのmax_resultsを指定します。応答にはスニペット、URL、メタデータが含まれます。この形式はエージェントの解析に役立ちます。

統合するには、開発者はPythonライブラリを使用します。`pip install ollama`でインストールします。次に、`ollama.web_search(query="example")`を呼び出します。この関数は環境変数を通じて認証を処理します。

同様に、JavaScriptユーザーは`ollama-js`を活用します。モジュールをインポートし、`Ollama().webSearch({query: "example"})`を呼び出します。リポジトリの例では、エラー処理とリトライが示されています。

cURLは低レベルのオプションを提供します。Authorizationヘッダー付きでリクエストを作成します。このアプローチはスクリプト作成やテストに適しています。

しかし、Apidogはこのプロセスを強化します。API管理ツールとして、Apidogはエンドポイントとパラメータを視覚化します。OllamaのAPI用のコードスニペットを生成し、開発を加速させます。

このAPIは長いコンテキストをサポートしています。結果は何千ものトークンに及ぶことがあります。したがって、拡張されたウィンドウを持つモデルが最高のパフォーマンスを発揮します。Ollamaは最低32,000トークンを推奨しています。

さらに、フェッチエンドポイントは検索を補完します。URLからコンテンツを抽出し、直接ブラウザを必要としません。包括的なエージェントのために両方を組み合わせます。

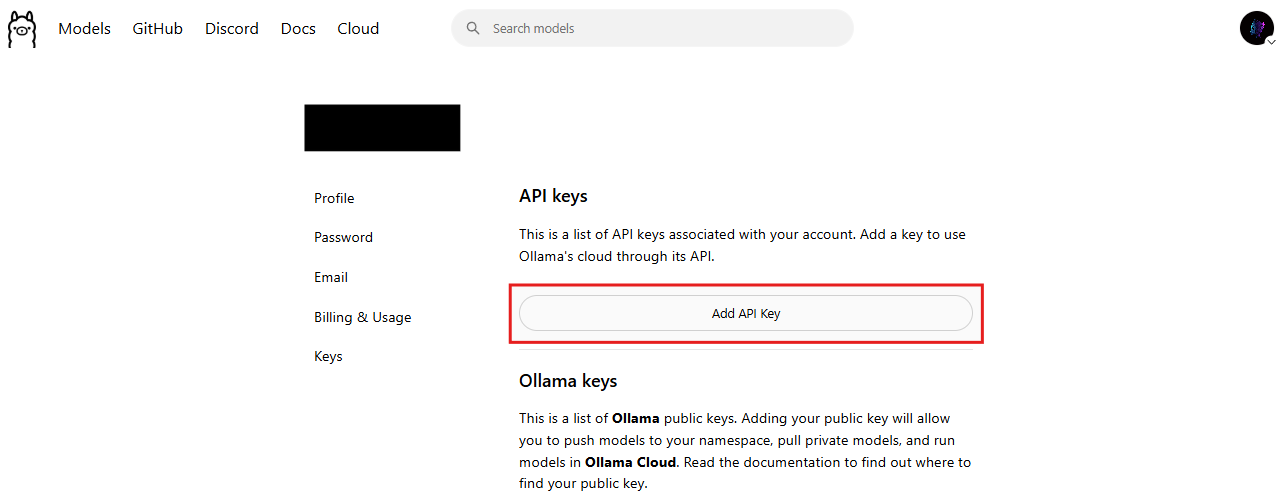

セキュリティは依然として最重要です。OllamaはAPIキーを要求し、不正アクセスを防止します。ユーザーはhttps://ollama.com/settings/keysでキーを生成します。

実用的な使用例に移行すると、リサーチエージェントを検討してください。エージェントはWeb検索をクエリし、ページを取得し、回答を統合します。このワークフローは静的なモデルよりも優れています。

OllamaユーザーのためのMCPサーバーを解き明かす

MCPサーバーはモデルとツールを橋渡しします。コンテキスト共有のためのフレームワークであるModel Context Protocolを実装しています。Ollamaでは、Pythonスクリプトがサーバーを実行します。

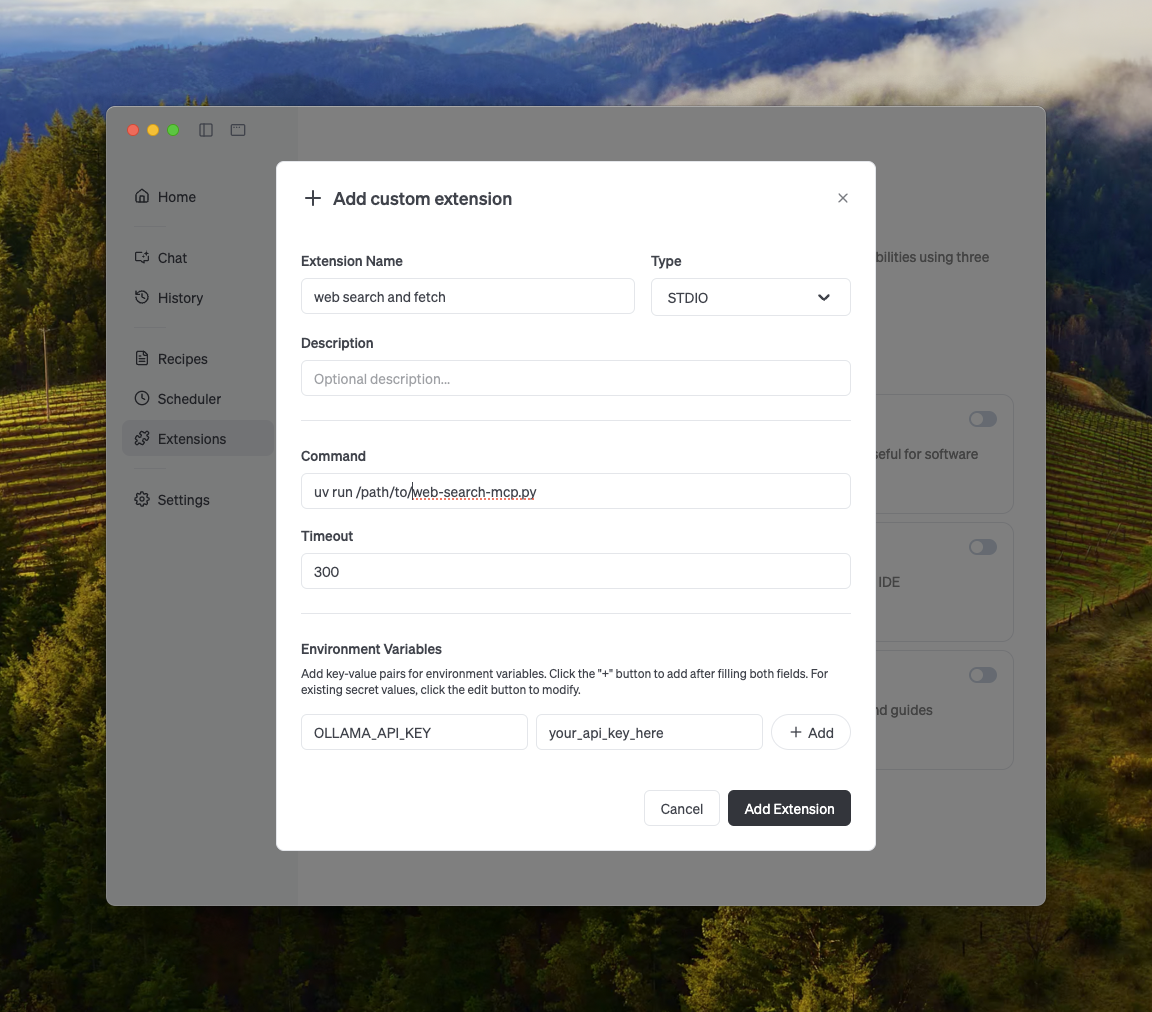

セットアップには、リポジトリのクローン作成と環境設定が含まれます。例えば、`uv run web-search-mcp.py`で起動します。クライアントは互換性のあるインターフェースを介して接続します。

Clineは設定内のコマンドで構成します。環境にOLLAMA_API_KEYを追加します。Codexはconfig.tomlファイルを編集します。Gooseも同様のパターンに従います。

この統合により、クライアントでのWeb検索が可能になります。モデルはツールを動的に呼び出し、インタラクティブ性を高めます。

さらに、MCPサーバーは拡張機能をサポートしています。開発者はメール、GitHub、画像などのカスタムツールを追加できます。この柔軟性により、Ollamaはエージェントのためのインフラストラクチャとしての地位を確立します。

NVIDIAを搭載したWindowsでは、インストールにはCUDAドライバーが含まれます。Linuxは隔離のためにDockerを使用します。macOSはネイティブアクセラレーションの恩恵を受けます。

高度なセットアップに移行すると、複数のMCPサーバーをクラスター化します。これにより、エンタープライズ規模の負荷分散が可能になります。

OllamaのAPIとMCPサーバーを統合する方法

統合はアカウント作成から始まります。Ollamaのサイトで無料でサインアップしてください。すぐにAPIキーを生成できます。

次に、Ollamaをローカルにインストールします。`ollama serve`を実行してサーバーを起動します。`gpt-oss`のようなツールに適したモデルをプルします。

Web検索の場合、OLLAMA_API_KEYを設定します。Pythonでテストします。

import ollama

response = ollama.web_search(query="latest AI news", max_results=5)

print(response)

これにより、結果を含むJSONが返されます。

MCPサーバーを組み込むには、GitHubから例をダウンロードします。スクリプトを実行し、クライアントを構成します。

Clineの場合:MCPエンドポイントを指すように設定を編集します。検索を呼び出すプロンプトをテストします。

Codexはtomlの更新が必要です。コマンドと引数を指定します。

GooseはMCP設定を介して統合され、Webツールを有効にします。

さらに、カスタムエージェントを構築します。ループを使用して複数ターンの対話を処理します。ツール呼び出しを解析し、結果をフィードバックします。

エラー処理は非常に重要です。レート制限のためにリトライを実装します。ティア内に留まるために使用状況を監視します。

Apidogがここで役立ちます。応答のモック、認証のテスト、ワークフローの文書化を行います。Apidogをダウンロードして、Ollamaの統合を迅速にプロトタイプ作成してください。

Ollamaで強力な検索エージェントを構築する

エージェントは主要なユースケースです。OllamaはQwen 3の例を提供しています。

モデルをプルする:`ollama pull qwen3:4b`。

Pythonでツールを定義します。

tools = [

{"type": "function", "function": {"name": "web_search", "description": "Search the web"}},

{"type": "function", "function": {"name": "web_fetch", "description": "Fetch URL content"}}

]

チャットループはメッセージを処理し、ツールを呼び出し、結果を追加します。

このエージェントは、「東京の現在の天気は?」のようなクエリに対して、検索とフェッチによって回答します。

ビジョンに拡張:マルチモーダルモデルを介して画像を分析し、コンテキストを検索します。

最適化に移行すると、コンテキスト長を増やします。クラウドモデルはフル容量まで処理できます。

エージェントは不要な呼び出しを最小限に抑えることでコストを削減します。結果をローカルにキャッシュします。

さらに、他のAPIと組み合わせます。MCPを介してデータベースや計算ツールを統合します。

プラットフォームごとのOllamaの料金詳細

Ollamaは段階的な料金設定を提供しています。基本は無料で、寛大な検索制限があります。これは愛好家やテストに適しています。

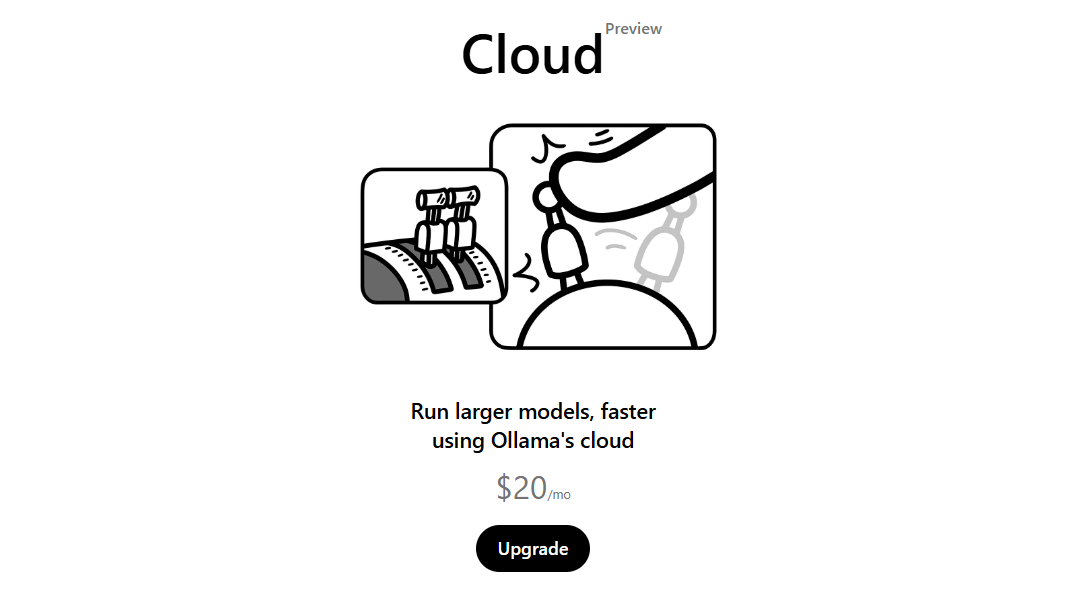

本番環境では、サブスクリプションをアップグレードしてください。コミュニティの議論に基づくと、クラウドアクセスは月額約20ドルから始まります。上位ティアでは無制限のクエリと優先サポートが提供されます。

プラットフォームは間接的にコストに影響を与えます。macOS、Windows、Linuxでのローカル実行はハードウェア以外に追加料金は発生しません。クラウドモデルは使用量に応じて課金されます。

Web検索APIは、高度なプランでは呼び出しごとに課金されます。ただし、無料ティアでほとんどのニーズをカバーできます。

代替案と比較:OpenAIの検索は1,000回呼び出しあたり10ドルかかります。Ollamaはローカル優先のユーザーにとってこれを下回ります。

企業はROIを計算します。ローカル推論はデータ転送を節約し、APIは最小限のオーバーヘッドを追加します。

予算編成に移行すると、ダッシュボードを介して監視します。Ollamaは使用状況の統計を提供します。

実世界のユースケースと例

開発者はこれをチャットボットに適用します。ボットはニュースを検索し、記事を取得し、要約します。

教育では、ツールが事実をクエリし、エラーを減らします。

研究者は文献レビューのためにエージェントを構築します。学術サイトを検索し、PDFを取得します。

Eコマースは製品推奨のために統合されます。トレンドを検索し、レビューを取得します。

import ollama

import json

def run_agent(prompt):

messages = [{"role": "user", "content": prompt}]

while True:

response = ollama.chat(model="qwen3:4b", messages=messages, tools=tools)

if "tool_calls" in response["message"]:

for call in response["message"]["tool_calls"]:

if call["function"]["name"] == "web_search":

args = json.loads(call["function"]["arguments"])

result = ollama.web_search(**args)

messages.append({"role": "tool", "content": str(result)})

else:

return response["message"]["content"]

このループは反復を処理します。

さらに、ビジョン利用:画像を記述し、一致するものを検索します。

企業はレポートを自動化します。エージェントはWebソースからデータを収集します。

Ollamaの新機能を採用するメリット

Ollamaはプライバシーを強化します。データはローカルに保持され、API呼び出しはオプションです。

リアルタイムの拡張により精度が向上します。モデルは進化するトピックに対応します。

スケーラビリティも向上します。MCPサーバーがタスクを分散します。

コスト効率が際立っています。無料ティアは費用を最小限に抑えます。

開発者の生産性が向上します。Apidogのような統合はワークフローを加速します。

コミュニティに移行すると、フォーラムで最適化が議論されます。

エコシステムが成長します。OpenWebUIのようなツールがOllamaと連携します。

潜在的な課題と解決策

課題にはレート制限が含まれます。解決策:サブスクリプションをアップグレードする。

ハードウェアの制約がモデルを制限します。クラウドバリアントを使用する。

統合の複雑さが発生します。ドキュメントと例に従う。

セキュリティ:APIキーを定期的にローテーションする。

エージェントのデバッグにはロギングが必要です。詳細モードを実装する。

さらに、一貫性のために複数のプラットフォームでテストする。

Ollamaの進歩をまとめる

OllamaのWeb検索APIとMCPサーバーは、大きな進歩を示しています。開発者はこれらを強力なアプリケーションのために活用します。無料ティアとクロスプラットフォームサポートにより、導入が加速します。さらに探求し、Apidogと統合して、次世代のAIツールを構築してください。