人工知能の分野は急速に進化を続け、計算の境界を再定義する革新的なモデルを生み出しています。これらの進歩の中でも、MiniMax-M1は画期的な開発として登場し、世界初のオープンウェイト、大規模ハイブリッドアテンション推論モデルとしての地位を確立しました。MiniMaxによって開発されたこのモデルは、複雑な推論タスクへのアプローチを変革することを約束し、印象的な100万トークンの入力と8万トークンの出力コンテキストウィンドウを提供します。

MiniMax-M1のコアアーキテクチャを理解する

MiniMax-M1 は、独自のハイブリッドMixture-of-Experts (MoE) アーキテクチャと超高速アテンションメカニズムの組み合わせにより際立っています。この設計は、前身であるMiniMax-Text-01によって築かれた基盤に基づいており、驚異的な4560億個のパラメータを持ち、トークンごとに459億個がアクティブ化されます。MoEアプローチにより、モデルは入力に基づいてパラメータの一部のみをアクティブ化し、計算効率を最適化し、スケーラビリティを可能にします。一方、ハイブリッドアテンションメカニズムは、モデルの長文コンテキストデータを処理する能力を高め、拡張されたシーケンスにわたる深い理解を必要とするタスクに理想的です。

これらのコンポーネントの統合により、パフォーマンスとリソース使用量のバランスを効果的に取るモデルが実現します。MoEフレームワーク内でエキスパートを選択的に活用することで、MiniMax-M1は通常大規模モデルに関連付けられる計算オーバーヘッドを削減します。さらに、ライトニングアテンションメカニズムはアテンションウェイトの処理を加速し、広範なコンテキストウィンドウでもモデルが高いスループットを維持できるようにします。

トレーニング効率:強化学習の役割

MiniMax-M1の最も注目すべき点の1つは、前例のない効率で大規模強化学習(RL)を活用するそのトレーニングプロセスです。モデルはわずか534,700ドルの費用でトレーニングされました。この数字は、MiniMaxによって開発された革新的なRLスケーリングフレームワークを強調しています。このフレームワークは、トークン更新ではなく重要度サンプリングウェイトをクリップする新しいアルゴリズムであるCISPO(Clipped Importance Sampling with Policy Optimization)を導入しています。このアプローチは、従来のRLバリアントよりも優れており、より安定した効率的なトレーニングプロセスを提供します。

さらに、ハイブリッドアテンション設計はRL効率を高める上で重要な役割を果たします。ハイブリッドアーキテクチャ内でのRLのスケーリングに関連する固有の課題に対処することで、MiniMax-M1はオープンソースの性質にもかかわらず、クローズドウェイトモデルに匹敵するレベルのパフォーマンスを達成します。このトレーニング手法は、コストを削減するだけでなく、限られたリソースで高性能AIモデルを開発するための新しいベンチマークを設定します。

パフォーマンス指標:MiniMax-M1のベンチマーク

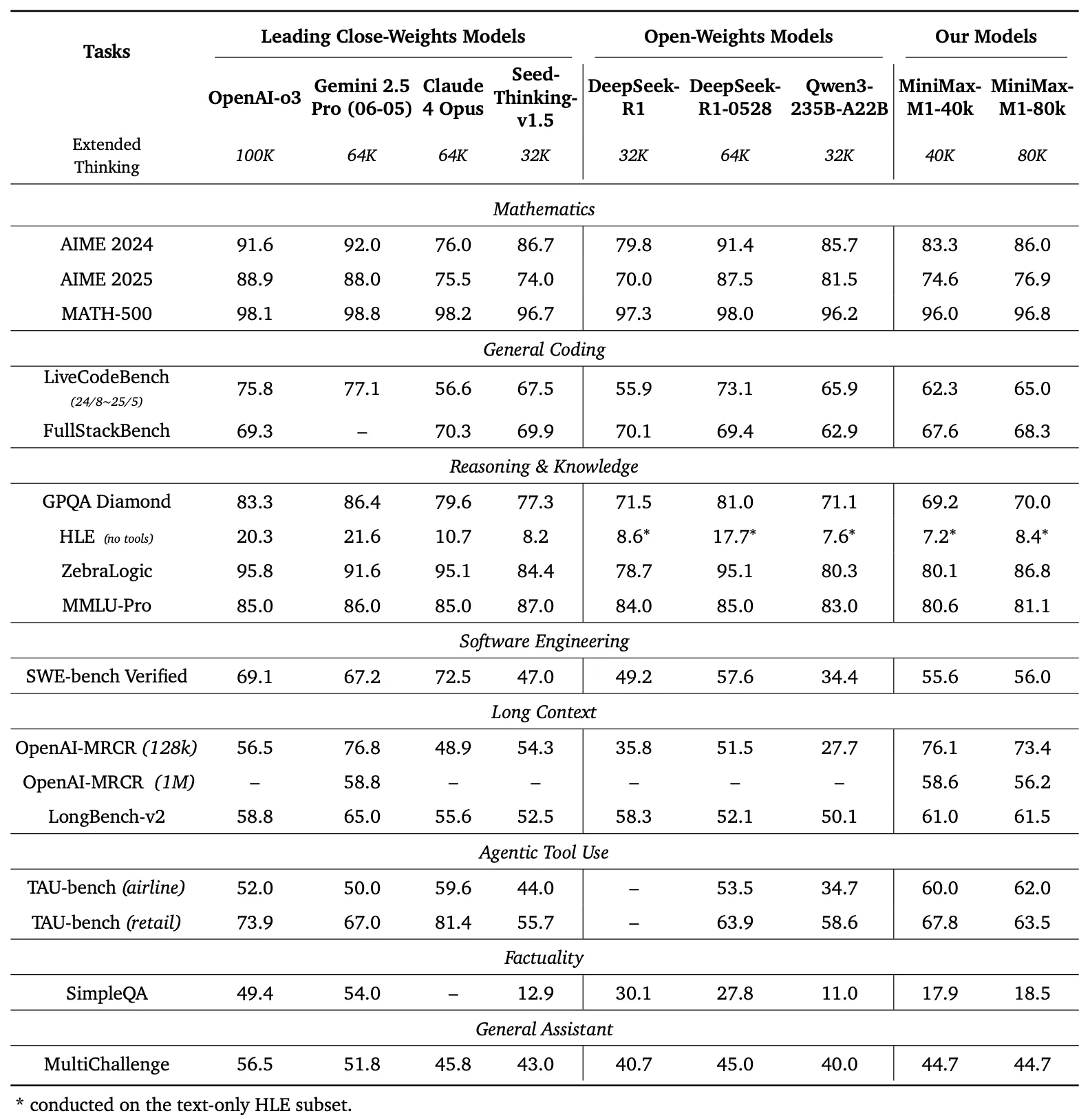

MiniMax-M1の能力を評価するために、開発者は競技レベルの数学、コーディング、ソフトウェアエンジニアリング、エージェントツール利用、長文コンテキスト理解など、さまざまなタスクで広範なベンチマークを実施しました。その結果は、DeepSeek-R1やQwen3-235B-A22Bなどの他のオープンウェイトモデルに対するこのモデルの優位性を強調しています。

ベンチマーク比較

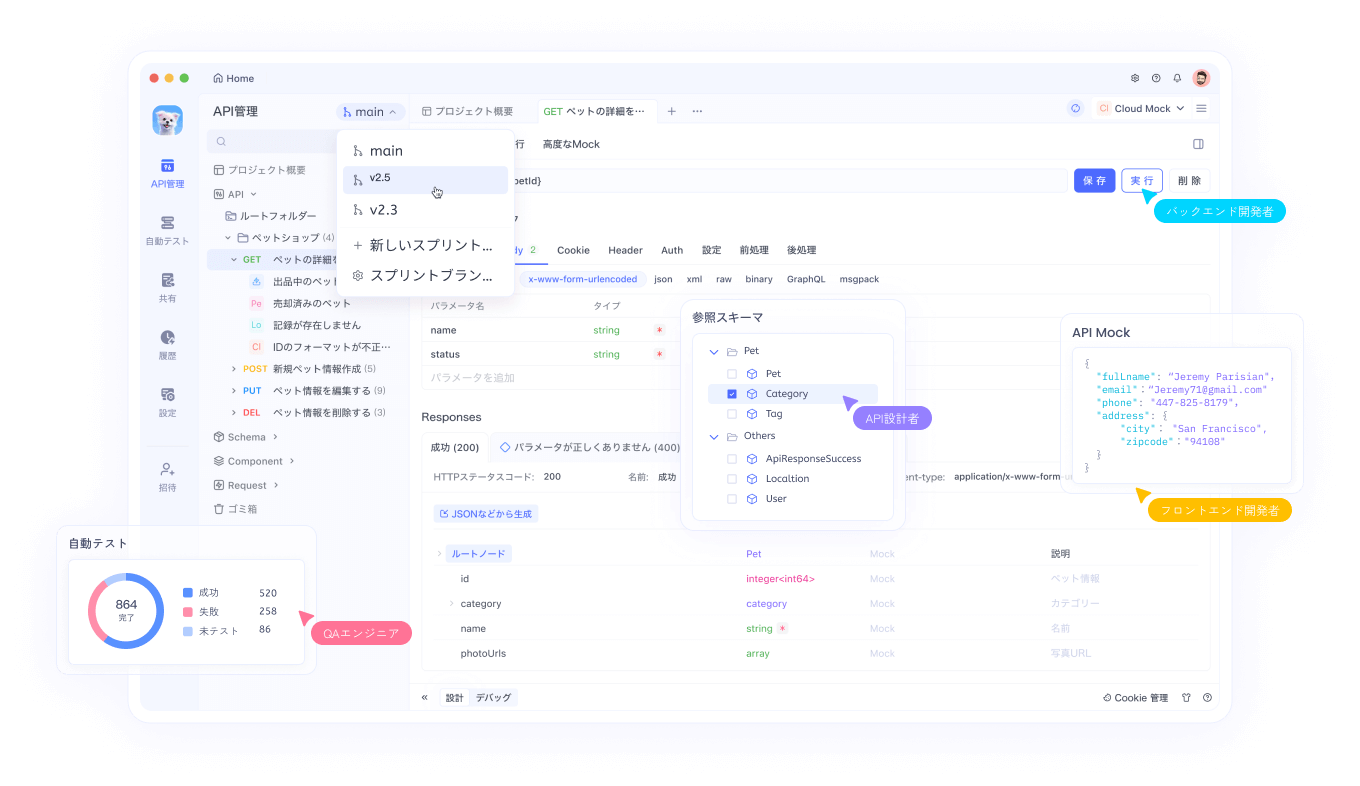

図1の左パネルは、いくつかのベンチマークにおける主要な商用モデルおよびオープンウェイトモデルに対するMiniMax-M1のパフォーマンスを比較しています

- AIME 2024: MiniMax-M1は86.0%の精度を達成し、OpenAI o3 (88.0%) およびClaude 4 Opus (80.0%) を上回り、数学的推論におけるその能力を示しています。

- LiveCodeBench: 65.0%のスコアで、MiniMax-M1はDeepSeek-R1-0528 (56.0%) を上回り、Seed-Thinking v1.5 (65.0%) のパフォーマンスに匹敵し、強力なコーディング能力を示しています。

- SW-E Bench Verified: モデルは62.8%のスコアを獲得し、ソフトウェアエンジニアリングタスクでQwen3-235B-A22B (60.0%) を上回っています。

- TAU-bench: MiniMax-M1は73.4%の精度を記録し、エージェントツール利用においてGemini 2.5 Pro (70.0%) を超えています。

- MRCR (4-needle): 74.4%の精度で、長文コンテキスト理解タスクにおいて他のモデルをリードしています。

これらの結果は、MiniMax-M1の多用途性とプロプライエタリモデルと競争する能力を強調しており、オープンソースコミュニティにとって貴重な資産となっています。

MiniMax-M1は、生成長が32kトークンから128kトークンに拡張するにつれて、FLOPs(浮動小数点演算)が線形に増加することを示しています。このスケーラビリティにより、モデルは拡張された出力でも効率とパフォーマンスを維持でき、詳細かつ長文の応答を必要とするアプリケーションにとって重要な要素となります。

長文コンテキスト推論:新しいフロンティア

MiniMax-M1の最も特徴的な機能は、最大100万入力トークンと8万出力トークンをサポートする超長文コンテキストウィンドウです。この機能により、モデルは膨大な量のデータ(小説全体または一連の書籍に相当)を単一パスで処理でき、OpenAIのGPT-4のようなモデルの128,000トークン制限をはるかに超えています。このモデルは、多様なシナリオのニーズに対応し、柔軟なデプロイメントを可能にする2つの推論モード(40kおよび80k思考バジェット)を提供します。

この拡張されたコンテキストウィンドウは、長文ドキュメントの要約、複数ターンの会話、複雑なデータセットの分析など、長文コンテキストタスクにおけるモデルのパフォーマンスを向上させます。数百万トークンにわたるコンテキスト情報を保持することで、MiniMax-M1は、長いシーケンスにわたる一貫性の維持が最重要である研究、法務分析、コンテンツ生成などのアプリケーションに堅牢な基盤を提供します。

エージェントツール利用と実用的なアプリケーション

印象的なコンテキストウィンドウに加えて、MiniMax-M1はエージェントツール利用において優れています。これは、AIモデルが外部ツールと連携して問題を解決する領域です。MiniMax Chatのようなプラットフォームとの統合や、タイピング速度テストや迷路ジェネレーターなどの機能的なウェブアプリケーションを生成するモデルの能力は、その実用性を示しています。これらのアプリケーションは、最小限のセットアップとプラグインなしで構築されており、モデルが本番環境で使用可能なコードを生成する能力を示しています。

例えば、モデルはリアルタイムで1分あたりの単語数(WPM)を追跡するクリーンで機能的なウェブアプリを生成したり、A*アルゴリズムの視覚化機能を備えた視覚的に魅力的な迷路ジェネレーターを作成したりできます。このような機能により、MiniMax-M1は、ソフトウェア開発ワークフローの自動化やインタラクティブなユーザーエクスペリエンスの作成を目指す開発者にとって強力なツールとなります。

オープンソースのアクセシビリティとコミュニティへの影響

MiniMax-M1がApache 2.0ライセンスの下でリリースされたことは、オープンソースコミュニティにとって重要なマイルストーンとなります。GitHub およびHugging Faceで利用可能であり、モデルは開発者、研究者、ビジネスがプロプライエタリな制約なしにそれを探索、変更、デプロイすることを可能にします。このオープン性はイノベーションを促進し、特定のニーズに合わせたカスタムソリューションの作成を可能にします。

このモデルのアクセシビリティは、高度なAIテクノロジーへのアクセスを民主化し、小規模な組織や独立した開発者がより大きな企業と競争できるようにします。詳細なドキュメントと技術レポートを提供することで、MiniMaxはユーザーがモデルの機能を再現および拡張できるようにし、AIエコシステムの進歩をさらに加速させます。

技術的な実装:デプロイと最適化

MiniMax-M1のデプロイには、計算リソースと最適化手法を慎重に考慮する必要があります。技術レポートでは、本番環境でのデプロイにvLLM (Virtual Large Language Model) の使用を推奨しており、これにより推論速度とメモリ使用量が最適化されます。このツールは、モデルのハイブリッドアーキテクチャを活用して計算負荷を効率的に分散させ、大規模な入力でもスムーズな動作を保証します。

開発者は、要件に基づいて思考バジェット(40kまたは80k)を調整することで、MiniMax-M1を特定のタスク向けにファインチューニングできます。さらに、モデルの効率的なRLトレーニングフレームワークにより、強化学習によるさらなるカスタマイズが可能になり、リアルタイム翻訳や自動顧客サポートなどのニッチなアプリケーションへの適応が可能になります。

結論:MiniMax-M1革命を受け入れる

MiniMax-M1は、オープンウェイト、大規模ハイブリッドアテンション推論モデルの分野における大きな飛躍を象徴しています。その印象的なコンテキストウィンドウ、効率的なトレーニングプロセス、優れたベンチマークパフォーマンスにより、AIランドスケープにおけるリーダーとしての地位を確立しています。このテクノロジーをオープンソースリソースとして提供することで、MiniMaxは開発者や研究者が高度なソフトウェアエンジニアリングから長文コンテキスト分析まで、新しい可能性を探求することを可能にします。

AIコミュニティが成長を続けるにつれて、MiniMax-M1はイノベーションとコラボレーションの力の証となります。その可能性を探求する準備ができている人々にとって、Apidogを無料でダウンロードすることは、この革新的なモデルを試すための実践的な入り口を提供します。MiniMax-M1との旅は始まったばかりであり、その影響は間違いなく人工知能の未来を形作るでしょう。