あなたのコードが専門のAIエージェントのチームによって作成される開発環境を想像してみてください。Claudeがアーキテクチャを設計し、Geminiがテストを書き、DeepSeekが完璧に機能を実装します。これは未来的なファンタジーではなく、MCP逐次思考とOpenRouterの組み合わせの力です。このガイドでは、複雑なプロジェクトに取り組むための秘密の武器にする方法を示します。

MCP逐次思考とは?

MCP(モデルコンテキストプロトコル)逐次思考は、複雑なコーディングの課題を明確で論理的かつ相互に関連する一連のステップに分解して取り組む、革命的な問題解決アプローチです。これは単なるコーディング以上のものであり、開発プロセスの各段階で異なるAIモデルの強みを活用するための思考の構造化に関するものです。情報に飛び込む代わりに、MCP逐次思考は次の点を強調します:

1. 正確な問題定義: 解決したい問題を明確に表現し、曖昧さの余地を残しません。

2. 原子サブタスクの分解: 問題を小さく管理しやすく独立したサブタスクに分解します。

3. 依存関係のシーケンシング: これらのサブタスク間の依存関係を特定し整理して、論理的な実行フローを確保します。

4. 最適化された実行フロー: 最大の効率と効果のためにこれらのサブタスクの実行を簡素化します。

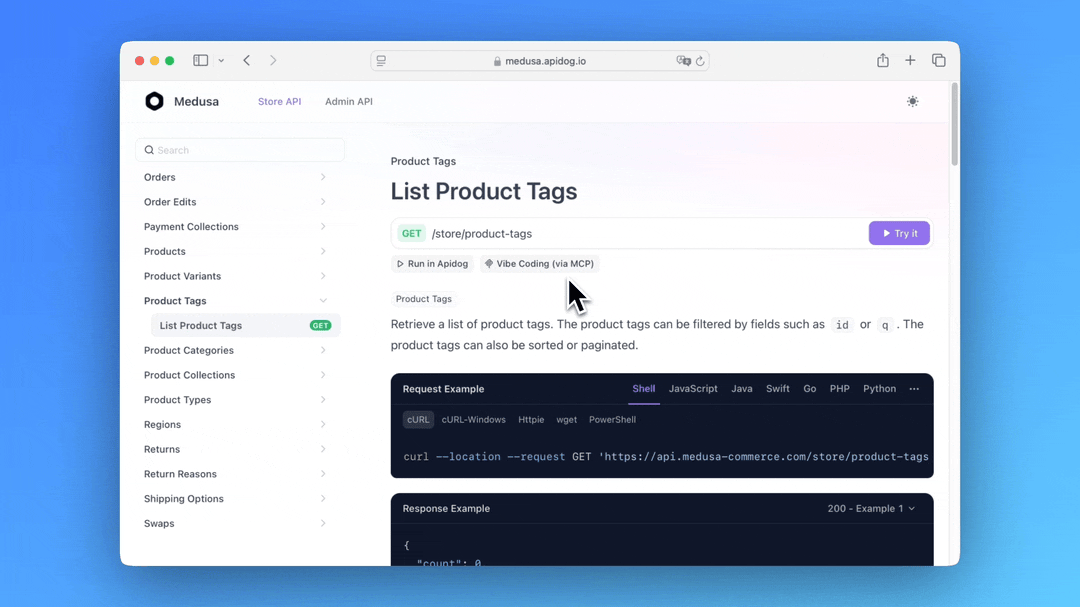

Apidog MCPサーバーが提供するものの簡単なリストは次のとおりです:

- API仕様に基づいてコードを生成または修正します

- API仕様のコンテンツを検索します

- API設計にシームレスに合わせたデータモデルとDTOを作成します

- API仕様に基づく関連するコメントとドキュメントを追加します

ApidogプロジェクトとCursorの間の橋渡しを行うことにより、Apidog MCPサーバーはAIアシスタントが最新のAPI設計にアクセスできることを保証します。この統合は、開発中にCursorが参照できる構造化されたAPI情報を提供することによって、メモリーバンク機能を強化します。

詳細については、ドキュメントをチェックするか、NPMページを訪れてください。

また、Postmanの統合された強力でコスト効果の高い代替手段であるApidogを試してみることも検討してください!

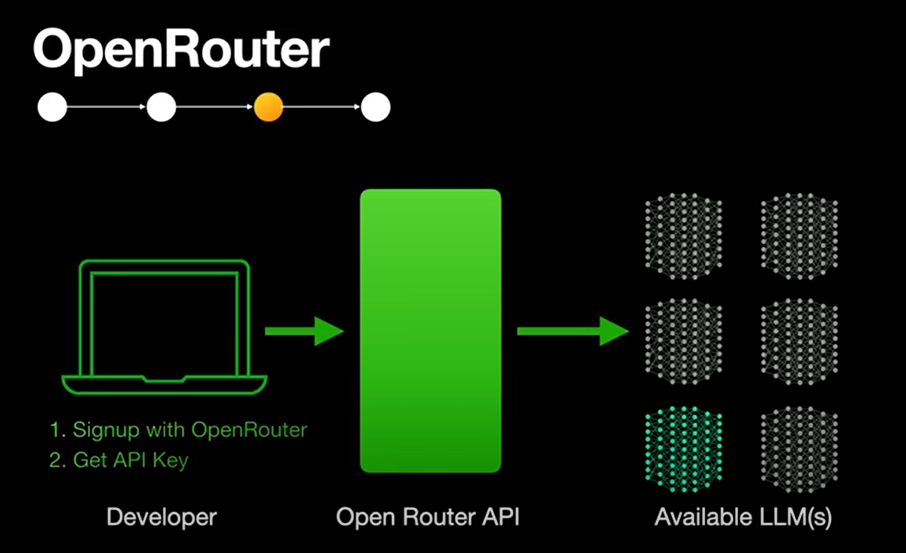

OpenRouter AIがこのプロセスを改善する方法

OpenRouter AIは、MCP逐次思考を強化する上で重要な役割を果たします。これは、さまざまなAIモデル(GPT-4、Claude、Mistralなど)へのアクセスを提供する統一APIゲートウェイとして機能します。これにより、各シーケンスのステップごとに異なるモデルの独自の強みを活用することができます。OpenRouter AIは次のようにプロセスを改善します:

- 反復的なコーディングステップの自動化: 煩雑なタスクから解放されることで、自動的にボイラープレートコードを生成し、プロジェクト構造を設定し、開発環境を構成します。

- ボイラープレートコードの生成: 各タスクの基本的なコード構造と初期コンポーネントを自動的に作成することにより、開発時間を大幅に短縮します。

- 最適化の提案: コードの効率、パフォーマンス、およびセキュリティを改善するためのインテリジェントな提案を提供します。

- リアルタイムのデバッグ: リアルタイムコード分析とインテリジェントなデバッグ提案を使用して、エラーを迅速に特定し解決します。

MCP逐次思考101

何が違うのか?

従来のAIコーディングは、単一モデルの会話が関連しています。つまり、単一のAIがタスク全体を担当します。それに対して、逐次思考はAIの組立ラインのようなものです:

タスク --> [プランナー] --> [リサーチャー] --> [コーダー] --> [レビュアー]フォーラムスレッドからの実例:

ユーザー: "リアルタイムの暗号価格を表示するReactダッシュボードを構築する"

1. Claude-3.5-Sonnet: アーキテクチャプランを作成

2. Gemini-2.0-Flash-Thinking: 最適なWebSocket APIを調査

3. DeepSeek-R1: Reactコンポーネントを実装

4. GPT-4-Omni: セキュリティの欠陥についてコードをレビュー主要なコンポーネント

1. MCPサーバーネットワーク: 異なるAIモデル間でタスクのハンドオフを管理します。

2. OpenRouterゲートウェイ: 最もコスト効率の良い適切なAIモデルにタスクをルーティングします。

3. Cursor IDE統合: 開発環境内で直接ネイティブなワークフロー制御を提供します。

プロのようにMCP逐次思考とOpenRouterを設定する

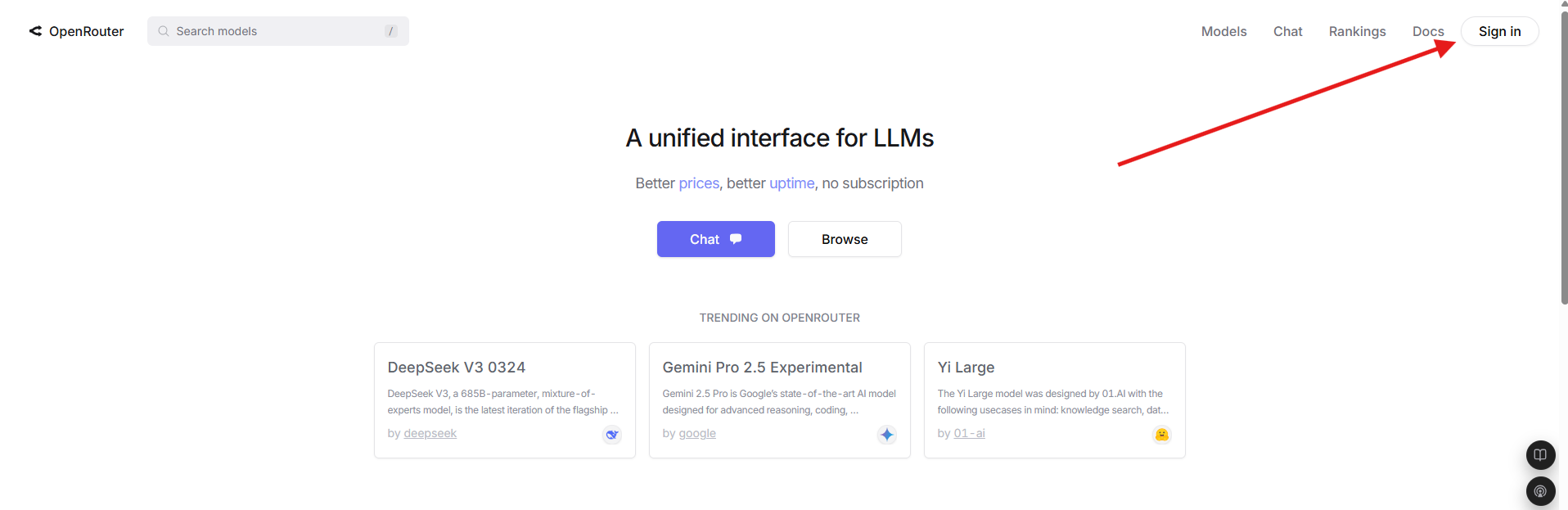

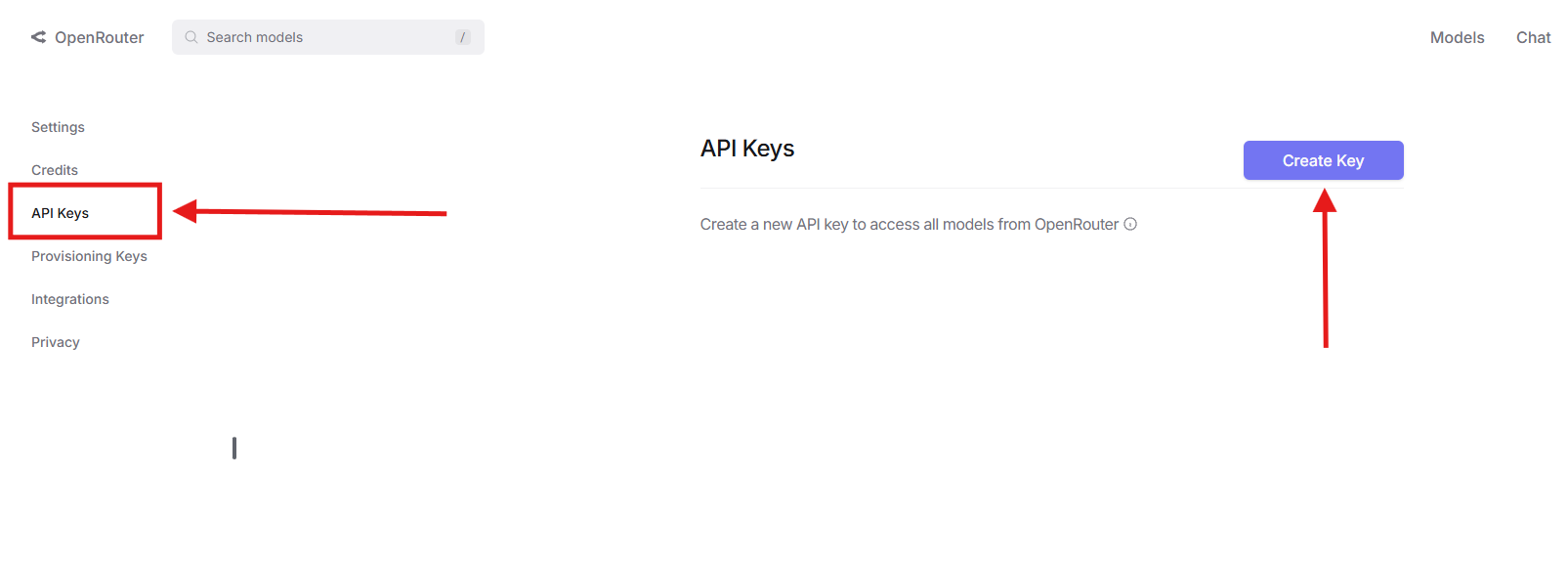

ステップ1:OpenRouter APIキーを取得する

2. サインアップ → アカウント設定 → APIキーに移動

3. キーを作成をクリック → クリップボードにコピー

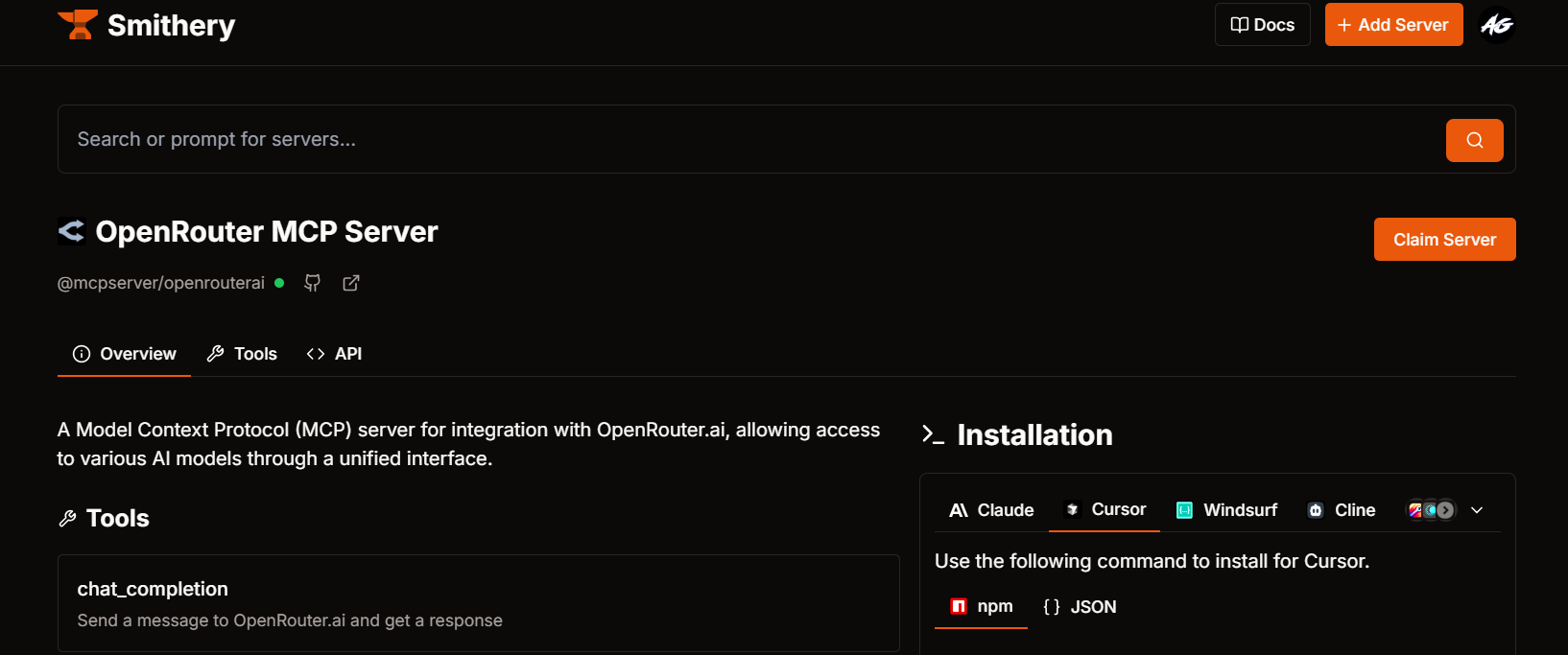

ステップ2:Smithery AIでOpenRouterを設定する

- Smithery AIを開く

- "OpenRouter MCP"を検索

- 設定パネルに次を貼り付け:

{

"api_key": "あなたのコピーしたキー",

"default_model": "google/gemini-pro" // 無料プランがおすすめ

}

4. どちらかをコピー:

- NPMコマンド:

npx -y @smithery/cli@latest install @mcpserver/openrouterai --client cursor --config "{\"openrouterApiKey\":\"YOUR_API_KEY\",\"openrouterDefaultModel\":\"deepseek/deepseek-chat-v3-0324:free\"}"- またはJSON設定(手動設定用):

{

"mcpServers": {

"openrouterai": {

"command": "npx",

"args": [

"-y",

"@smithery/cli@latest",

"run",

"@mcpserver/openrouterai",

"--config",

"{\"openrouterApiKey\":\"YOUR_API_KEY\",\"openrouterDefaultModel\":\"deepseek/deepseek-chat-v3-0324:free\"}"

]

}

}

}

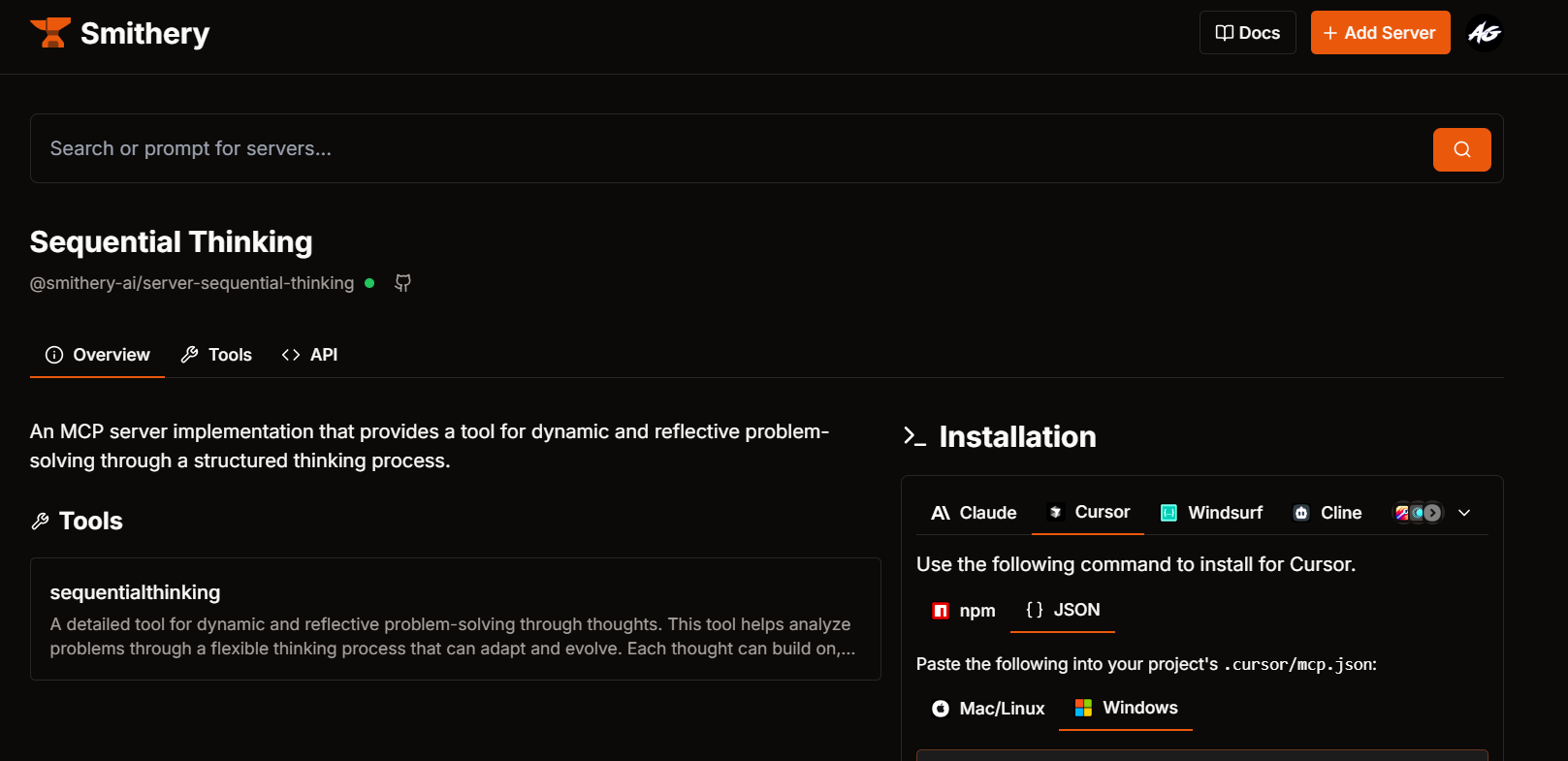

ステップ3:逐次思考MCPを追加する

- Smithery AIで"Sequential Thinking MCP Server"を検索

- 希望の形式を選択:

- NPMクイックインストール:

npx -y @smithery/cli@latest install @smithery-ai/server-sequential-thinking --client cursor --key YOUR_API_KEY- またはJSON設定(上級者向け):

{

"mcpServers": {

"server-sequential-thinking": {

"command": "cmd",

"args": [

"/c",

"npx",

"-y",

"@smithery/cli@latest",

"run",

"@smithery-ai/server-sequential-thinking",

"--key",

"YOUR_API_KEY"

]

}

}

}

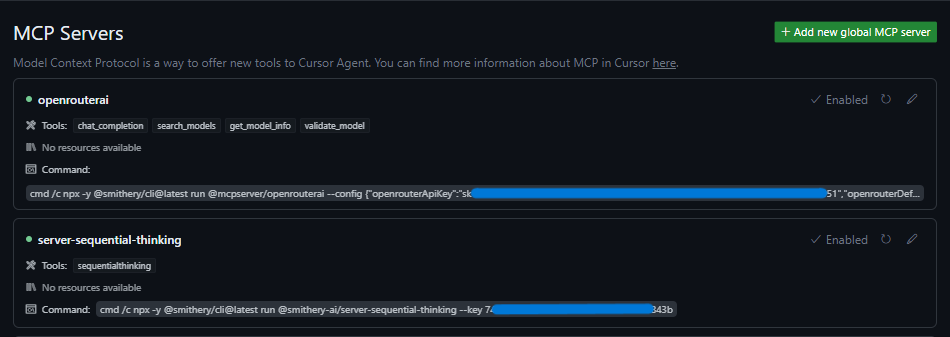

ステップ4:Cursor IDEでアクティブにする

NPMユーザー向け:

- Cursorを開く → ターミナル(

Ctrl + j) - コマンドを一度に一つずつ貼り付ける

- ✅成功確認を待つ

JSON設定ユーザー向け:

- Cursor設定を開く(

Ctrl + shift + j) - MCP → サーバーに移動

- サーバーを追加をクリック → JSONを貼り付ける

- 保存 → 緑の● 接続済みステータスを探す

インストールの確認:

サーバーを追加した後、MCPサーバーリストの「逐次思考」の横に緑の点が表示されているか確認してください。これは接続が成功したことを示しています。

これらのステップに従うことで、OpenRouterと逐次思考MCPサーバーをCursorに効果的に統合し、先進的なAI駆動のツールで開発環境を強化します。

最初のOpenRouterとMCP逐次思考ワークフローを構築する

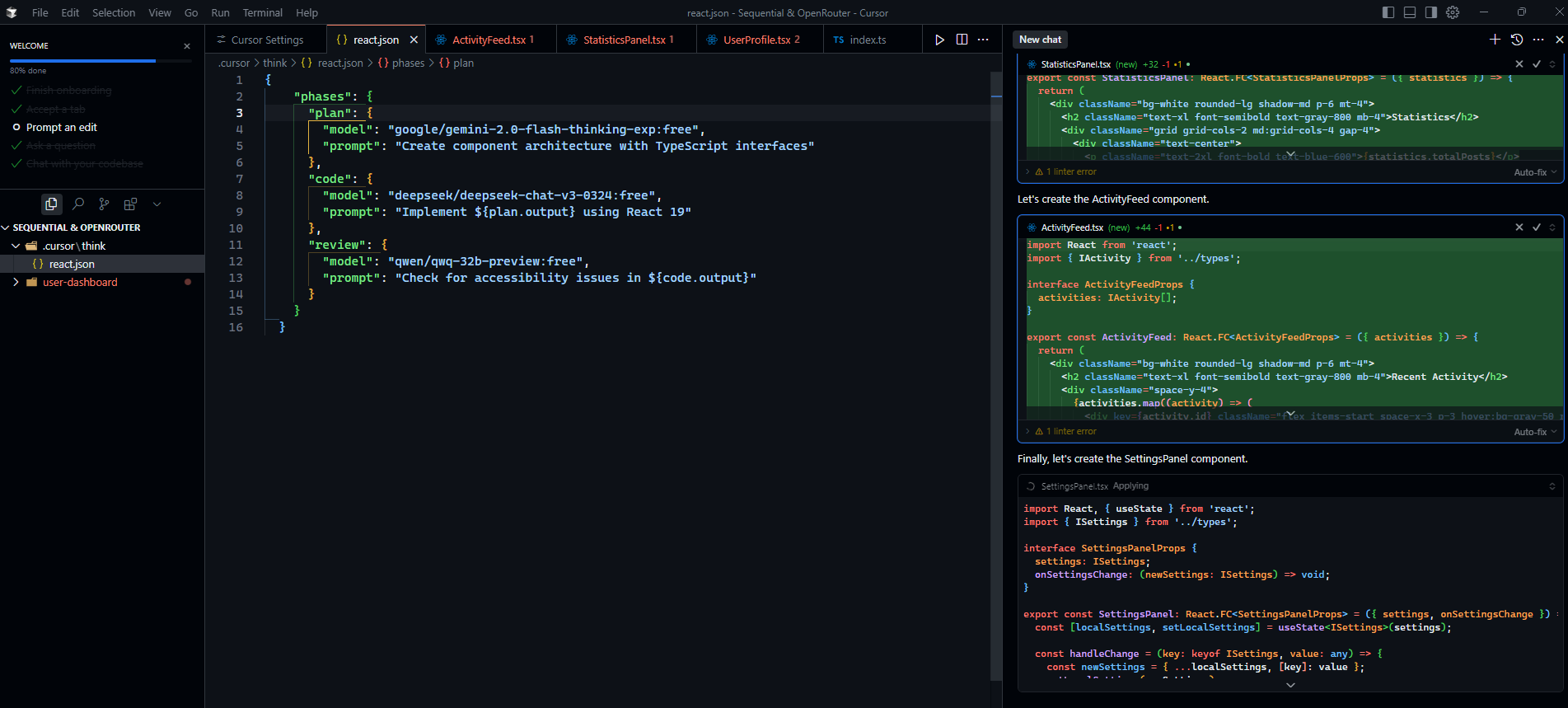

Reactプロジェクトのテンプレートを作成:

Cursorで新しいプロジェクトを開き、次の内容で .cursor/think/react.json というファイルを作成します:

{

"phases": {

"plan": {

"model": "google/gemini-2.0-flash-thinking-exp:free",

"prompt": "TypeScriptインターフェースを使用してコンポーネントアーキテクチャを作成"

},

"code": {

"model": "deepseek/deepseek-chat-v3-0324:free",

"prompt": "${plan.output}をReact 19を使用して実装"

},

"review": {

"model": "qwen/qwq-32b-preview:free",

"prompt": "${code.output}のアクセシビリティ問題を確認"

}

}

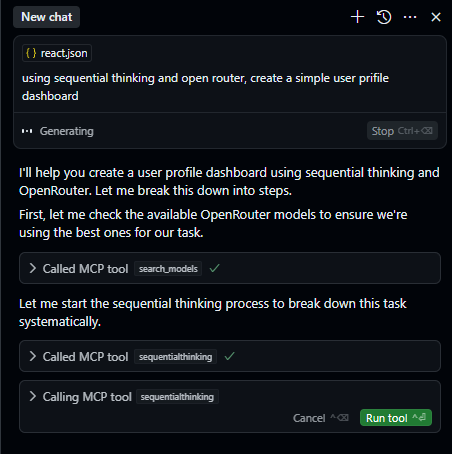

}使用方法: このワークフローを実行するには、次のコマンドを実行します:

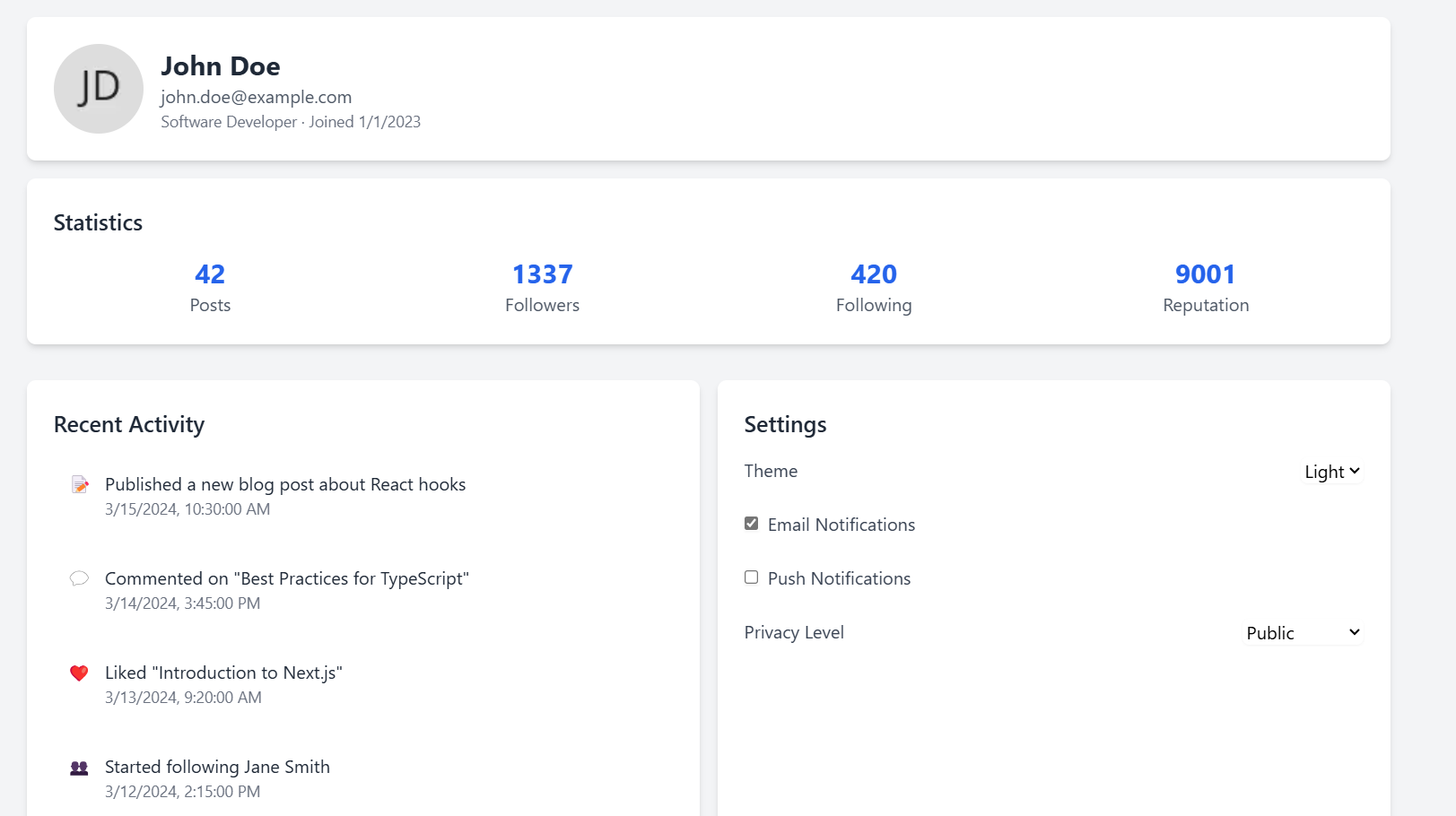

/think react "シンプルなユーザープロファイルダッシュボード"ワークフローの内訳:

- Gemini 2.0フラッシュ思考による計画フェーズ: Gemini 2.0フラッシュ思考モデルを利用して、TypeScriptインターフェースを持つ詳細なコンポーネントアーキテクチャを作成します。このステップでReactプロジェクトのための十分に構造化された基盤を確保します。

- DeepSeek Chat V3によるコーディングフェーズ: DeepSeek Chat V3モデルを活用してReact 19を使用し、計画したアーキテクチャを実装します。このフェーズは、設計を機能的なコードコンポーネントに変換することに焦点を当てています。

- Qwen 32Bプレビューによるレビュー段階: 実装されたコードの徹底的なレビューを行い、アクセシビリティの問題を特定して解決し、アプリケーションがユーザーフレンドリーであり、アクセシビリティ基準に準拠していることを確認します。

コード実行: 定義されたワークフローを実行する際、Cursorは指定されたMCP(モデルコンテキストプロトコル)ツールである逐次思考およびOpenRouter AIを利用して指示されたタスクを順次実行します。

このプロセス中、Cursorは各MCPサーバーを利用する前に明示的な許可を求め、これらのツールを開発ワークフローに統合するための制御を維持します。

結果: 手動で行った場合にかかる時間(数時間または数日)の代わりに、数分でプロダクション準備が整ったユーザープロファイルダッシュボードを得られます。

最後の考え:コーディングの未来はここにある

MCP逐次思考は単なるトレンドではなく、ソフトウェア開発へのアプローチの根本的な変化です。複数のAIモデルの力を体系的かつ効率的に活用することで、前例のないレベルの生産性、コードの質、そして革新を達成できます。あなたのコードは以前とは異なるものになるでしょう。MCP逐次思考を用いてAI支援の開発の未来を受け入れ、チームの可能性を最大限に引き出しましょう。重要なポイントは、複雑なプロジェクトを小さな管理可能なタスクに分解し、それらのタスクを特定の分野に特化したAIモデルに割り当て、全体の開発ライフサイクルを効率化する能力です。AIの進歩とOpenRouterやCursorなどのツールの継続的な進化により、ソフトウェア開発の未来は間違いなくMCP逐次思考と密接に結びついており、前向きな開発者にとって必須のスキルとなるでしょう。 🚀