開発者や研究者は、人工知能アプリケーションの限界を押し広げるために、制約のないLLMをますます求めています。これらの検閲されていない大規模言語モデルは、組み込みのコンテンツフィルターなしで動作し、多様なクエリに対して無制限の応答を可能にします。AIの状況が進化するにつれて、検閲されていないLLMは、ユーザーが倫理的ジレンマから創造的なストーリーテリングまで、事前に定義された道徳的または安全上の制約なしに、複雑なトピックを探索することを可能にします。

ボタン

この記事では、専門家が検閲されていないLLMの技術的基盤、そのアーキテクチャ、および実際の展開について考察します。これらのモデルはフィルターがないため、機密性の高いコンテンツを生成する可能性があるため、ユーザーは責任を持って扱う必要があります。

検閲されていないLLMの理解:技術的基盤

エンジニアは、標準的なバリアントで倫理的ガイドラインを強制するアライメント指示を省略したデータセットでベースモデルをファインチューニングすることにより、検閲されていないLLMを設計します。Llama 2やMistralのようなベースモデルは、このプロセスを経て、開発者は暴力や偏見に関するクエリを拒否するなどの拒否メカニズムを削除し、包括的な応答を促すようにシステムプロンプトを調整します。たとえば、人間のフィードバックからの強化学習(RLHF)のような技術は、安全よりも有用性を優先するためにバイパスまたは逆転されます。

さらに、検閲されていないLLMは、トランスフォーマーアーキテクチャを活用し、数十億のパラメーターを持つシーケンスの次のトークンを予測します。オープンソースコミュニティは、Hugging Faceのようなプラットフォームでファインチューニングされたバージョンを共有することで貢献しています。そこでは、「アブリテレーション」(ターゲットを絞ったファインチューニングによって安全アライメントを侵食する方法)を通じてモデルが検閲を解除します。このアプローチにより、モデルはあらゆるプロンプトに応答しますが、推論には十分なVRAMを備えた堅牢なハードウェアが必要です。

これらのモデルは、規制に準拠するために厳格なフィルターを組み込んだGPT-4のようなプロプライエタリなモデルとは異なります。しかし、検閲されていないバリアントは、研究やシミュレーションのような分野でのイノベーションを促進し、無制限の出力が本来の能力を明らかにします。それにもかかわらず、開発者はアプリケーションにカスタムのセーフガードを実装することでリスクを軽減します。

制約のないLLMの利点とリスク

制約のないLLMは、問題解決を強化するフィルターなしの洞察を提供するため、ユーザーは大きな利点を得られます。たとえば、研究者は、標準モデルが情報を開示しない可能性のある機密性の高い領域での仮説検証にそれらを利用します。さらに、コーダーは無制限のコード生成から恩恵を受け、倫理的な中断なしに開発サイクルを加速します。

さらに、これらのLLMはAIの透明性を促進し、エンジニアが動作を直接検査および変更できるようにします。コミュニティはそれらを基盤として、多言語処理や長文脈推論などのタスクに特化したバリアントを作成します。しかし、有害なコンテンツの生成などの潜在的な誤用からリスクが生じ、展開者による倫理的監督が必要になります。

Ollamaのようなプラットフォームは、データプライバシーの懸念を最小限に抑えながら、制御を最大化するローカル実行を可能にします。しかし、高い計算要件は障壁となりますが、量子化のような最適化は、パフォーマンスをあまり犠牲にすることなくモデルサイズを削減することでこれに対処します。

トップ10の検閲されていないLLMのランキング基準

アナリストは、パラメーター数、推論速度、コミュニティサポート、およびHugging Faceリーダーボードのような情報源からのベンチマークスコアに基づいてこれらのモデルをランク付けします。コーディング、ロールプレイング、推論などのタスク全体での汎用性も、ローカル展開の容易さとともに考慮されます。さらに、最近の2025年のアップデートでは、拡張されたコンテキストウィンドウと効率のための混合エキスパート(MoE)設計を備えたモデルが優先されます。

1. Dolphin 3.0:精度重視の検閲されていない強力なモデル

Cognitive Computationsは、Llama 3.1 8BベースでDolphin 3.0を開発し、システムプロンプトを介して優れた推論と操作性を実現するためにファインチューニングしています。このモデルは、論理集約的なタスクで優れており、冗長な装飾なしに正確でフィルターなしの出力を提供します。エンジニアは、パフォーマンスとリソースのニーズのバランスをとる80億のパラメーターを高く評価しており、最適な推論には約16GBのVRAMが必要です。

主な機能には、プロンプトへの順守を強化するハイブリッドアーキテクチャが含まれており、カスタムAIアシスタントに最適です。さらに、Dolphin 3.0は関数呼び出しをサポートしており、外部ツールとの統合を可能にします。長所には、ペルソナに対する比類のない制御と、コーディングや数学における迅速な問題解決が含まれますが、短所には、技術的な用途には適していますが、物語的な用途には適さない直接的な散文スタイルが挙げられます。

開発者は、Ollamaを使用してDolphin 3.0をローカルで実行します。ツールをインストールし、ollama pull dolphin-llama3でモデルをプルし、APIまたはCLIを介してクエリを実行します。ベンチマークでは、構造化推論で他のモデルを上回り、MMLUテストで80%を超えるスコアを記録しています。さらに、その検閲解除は、アライメントバイアスを回避するデータセットのキュレーションに由来し、研究におけるエッジケースの探索を可能にします。

展開シナリオでは、チームは自動分析のためのパイプラインにそれを統合し、その効率が際立っています。ただし、ユーザーは意図しないバイアスを避けるためにプロンプトを慎重に調整する必要があります。

2. Nous Hermes 3:創造性重視の検閲されていないモデル

NousResearchは、Llama 3.2 8B基盤でNous Hermes 3を構築し、一貫性のある長文出力で創造的な執筆とロールプレイングを重視しています。80億のパラメーターを備え、ChatMLを活用して構造化された会話を実現し、対話でのキャラクターの一貫性を維持します。これにより、制約なしの物語生成に最適な選択肢となります。

機能は、プロンプトの微妙な理解を強調し、最大8kトークンの拡張コンテキストをサポートします。長所には、優れたフィクション作成と魅力的な対話が含まれますが、短所には、簡潔なクエリでの時折の冗長性が挙げられます。コミュニティ主導のアップデートにより、継続的な改善が保証されます。

展開するには、ユーザーはHugging Faceを活用します。モデルをダウンロードし、from transformers import AutoModelForCausalLM; model = AutoModelForCausalLM.from_pretrained('NousResearch/Hermes-3-Llama-3.2-8B')を介してTransformersライブラリでロードし、テキストを生成します。ベンチマークでは、クリエイティブベンチマークで高いスコアを示し、ロールプレイング評価で85%を超えることがよくあります。

さらに、その検閲解除は、多様なフィルターなしのデータセットでのファインチューニングに由来し、ストーリーテリングにおける深い探索を可能にします。開発者は、無制限の創造性がプロトタイピングを加速するゲームデザインにそれを適用します。

3. LLaMA-3.2 Dark Champion Abliterated:長文脈の検閲されていない怪物

DavidAUは、LLaMA-3.2 Dark Championを8x3B MoEアーキテクチャでファインチューニングし、アライメントされていない出力のために安全層をアブリテートしています。128kのコンテキストウィンドウを誇り、膨大なドキュメントを効率的に処理するため、データ分析に最適です。

このモデルのMoE設計は、パラメーターのサブセットをアクティブ化し、電力を維持しながら計算を削減します。長所は、迅速な推論と深い推論ですが、短所には、潜在的な負のバイアスと高いVRAM要件(約40GB)が含まれます。

インストールにはHugging Faceのダウンロードが含まれ、推論はpipeline('text-generation', model='DavidAU/Llama-3.2-8X3B-MOE-Dark-Champion-Instruct-uncensored-abliterated-18.4B')を介して行われます。長文脈ベンチマークで高いスコアを記録し、検索タスクで90%を超える精度を達成しています。

さらに、アブリテレーションにより制限がなく、高度な研究に適しています。チームは、その規模が複雑なデータセットをシームレスに処理するレポートの自動化にそれを使用します。

4. Llama 2 Uncensored:汎用性の高いエントリーレベルの検閲されていないLLM

MetaのLlama 2は、この検閲されていないバリアントのベースとして機能し、George Sungによって倫理フィルターを排除するためにファインチューニングされています。70億から130億のパラメーターを備え、コンシューマーハードウェアで動作し、ロールプレイングや一般的なタスクをサポートします。

機能には、CPU/GPUのバランスのためのGGUFのような複数の量子化オプションが含まれます。長所:アクセシビリティとコミュニティプラグイン。短所:Llama 3よりも推論が弱い。

Ollamaを介して実行します:ollama run llama2-uncensored。23.4万回のプルがあり、軽量な使用に適しています。

さらに、その設計は実験を促進し、検閲されていないAIの初心者にとって定番となっています。

5. WizardLM Uncensored:信頼できるオールラウンダー

TheBlokeは、Llama 2 13B上でWizardLM Uncensoredをパッケージ化し、幅広いアプリケーションのためにアライメントを削除しています。チャットと執筆に優れており、バランスの取れた機能を備えています。

主な側面:強力なコミュニティ、簡単な展開。長所:予測可能性。短所:古いベース。

ollama run wizardlm-uncensoredで展開します。2.3万回のプルがあり、クリエイティブなワークフローに適しています。

6. Dolphin 2.7 Mixtral 8x7B:コーディングに特化した検閲されていないモデル

Eric Hartfordは、MixtralのMoE上にこれを構築し、フィルターなしでコーディングのためにファインチューニングしています。8x7Bのパラメーターは、専門的なタスクでの効率を保証します。

機能:量子化フォーマット、高いコーディングパフォーマンス。長所:速度。短所:ハードウェア要件。

Ollamaを使用します:ollama run dolphin-mixtral:8x7b。ベンチマークは、プログラミングにおけるその実力を強調しています。

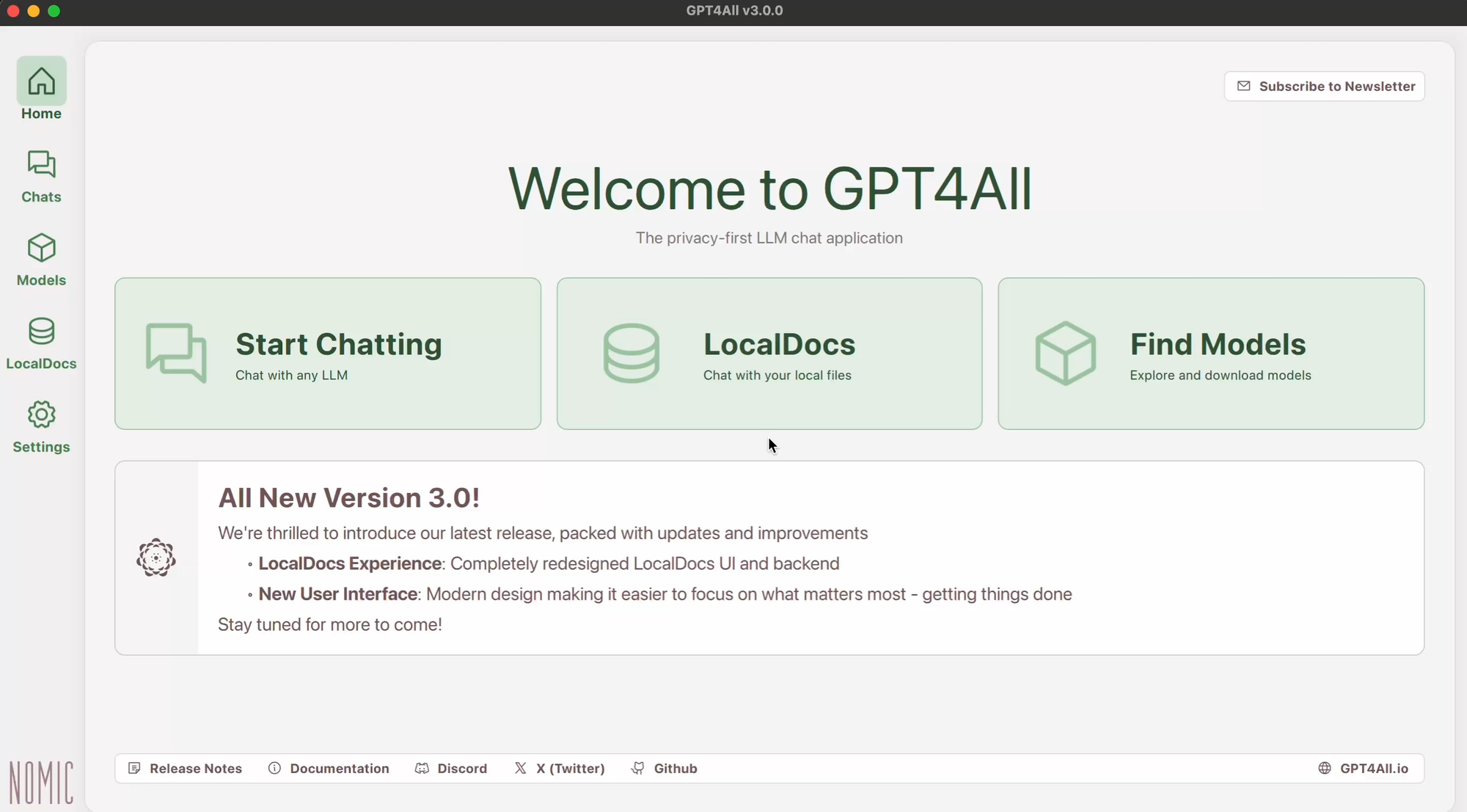

7. GPT-4All:オフライン重視の検閲されていないフレームワーク

GPT-4Allは、トランスフォーマー研究に基づいて検閲されていないチャットのために、ローカル実行を最適化します。クロスプラットフォームサポートが展開を支援します。

長所:無料、カスタマイズ可能。短所:コンテキスト制限。

公式サイトからインストールし、実行可能ファイルを実行します。プライバシーを重視するユーザーに最適です。

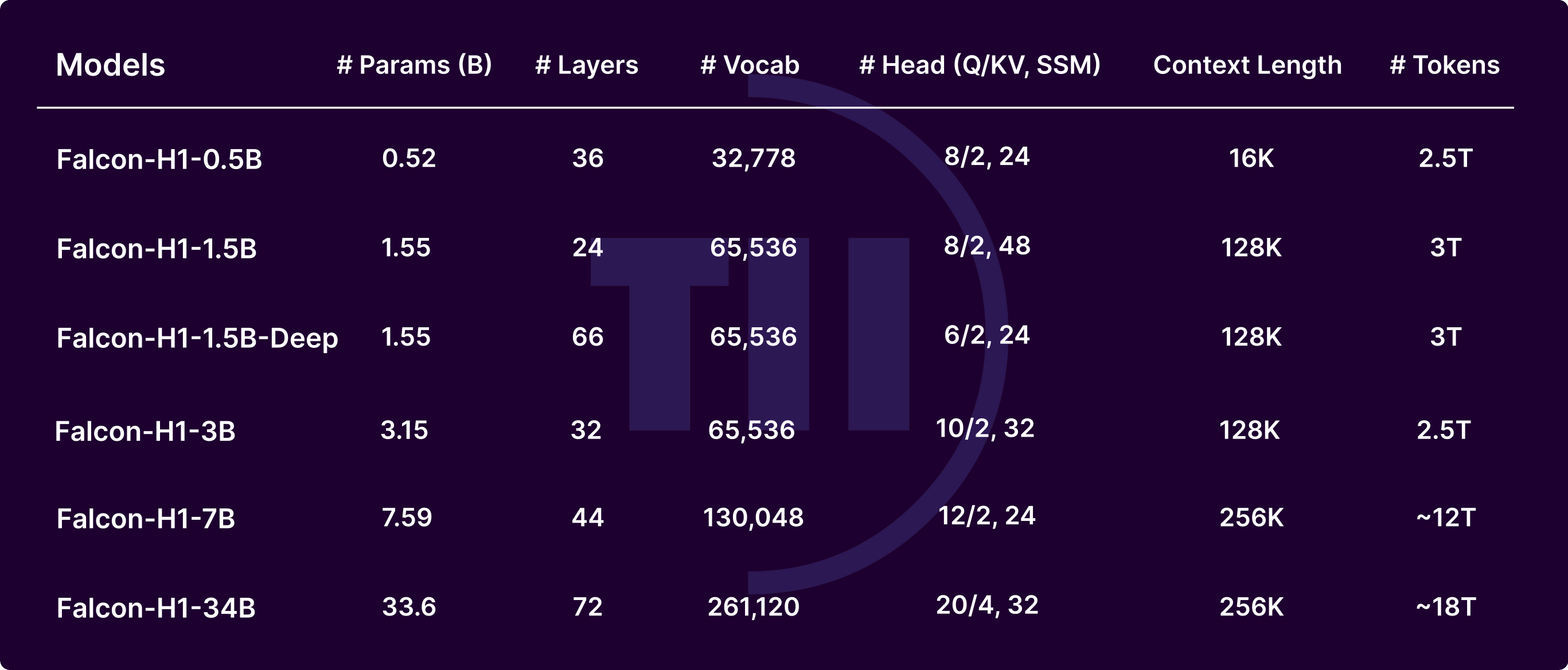

8. Falcon LLM:高性能な検閲されていない代替モデル

Technology Innovation Instituteは、Falconを革新的なアーキテクチャで開発し、ニュアンスのあるテキストを実現しています。速度のために最適化されています。

機能:モジュール設計。長所:品質。短所:エコシステムの成熟度。

Transformersライブラリでロードします。研究に適しています。

9. MPT-7B Chat:会話型検閲されていないLLM

MosaicMLは、低遅延を重視してMPT-7Bをチャット用にチューニングしています。70億のパラメーターは、控えめなセットアップに適しています。

長所:リアルタイム。短所:複雑なタスク。

スクリプトでローカルに展開します。ボットに最適です。

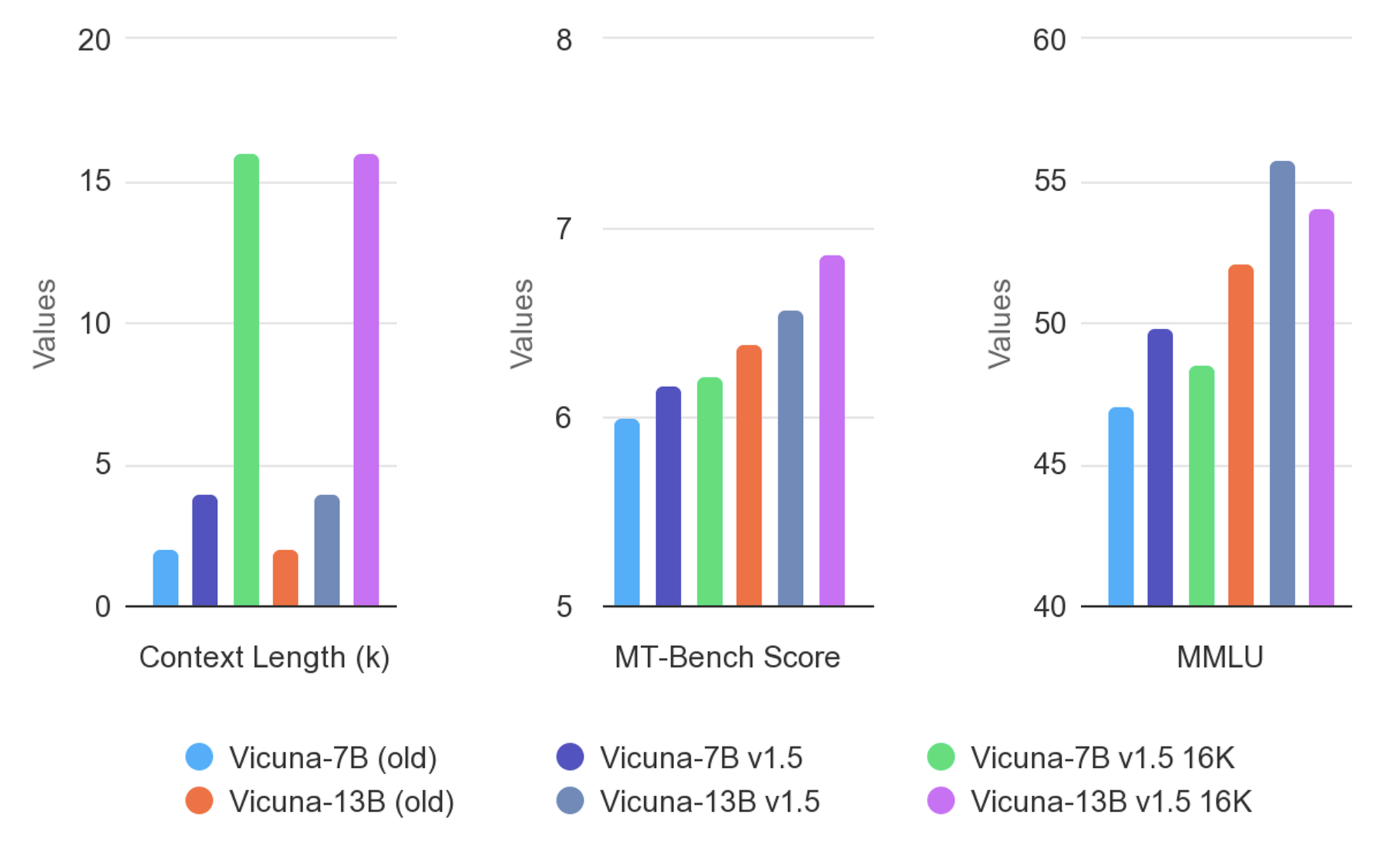

10. Vicuna:対話に最適化された検閲されていないモデル

Vicunaは、自然な対話のために会話データでファインチューニングされています。軽量設計です。

長所:魅力的。短所:非会話的な弱点。

コミュニティツールを介して実行します。インタラクティブなアプリを強化します。

検閲されていないLLMの展開におけるベストプラクティス

エンジニアは、Q4やQ8などの量子化レベルを選択してハードウェアに適合させることで、展開を最適化します。OllamaやLM Studioのようなツールは実行を簡素化し、Apidogを介したAPIはスケーリングを可能にします。

さらに、VRAMの使用状況を監視し、特定のドメインに合わせてファインチューニングします。セキュリティ対策には、環境の分離が含まれます。

検閲されていないLLMの将来のトレンド

イノベーターは、より大規模なMoEモデルとより優れたアブリテレーション技術を予測しています。マルチモーダル機能との統合により、用途が拡大します。

しかし、規制圧力は開発に影響を与え、ハイブリッドアプローチを推進する可能性があります。

結論

この探求は、制約のないLLMがAIアプリケーションをどのように革新するかを明らかにします。Dolphin 3.0の精度からVicunaの対話まで、これらのモデルは比類のない自由を提供します。開発者は、Apidogのようなツールを活用してシームレスな統合を実現し、責任を持ってそれらを活用します。技術が進歩するにつれて、これらの検閲されていないLLMはイノベーションを推進し続け、研究開発の状況を変革します。

ボタン