Metaの高度なLlama言語モデルの機能を、一銭もかけずに活用したいと思いませんか?この詳細なガイドでは、Llama APIを無料で利用するための2つの実践的な方法、すなわちOpenRouterとTogether AIを活用する方法を順を追って説明します。

Llama APIとは?

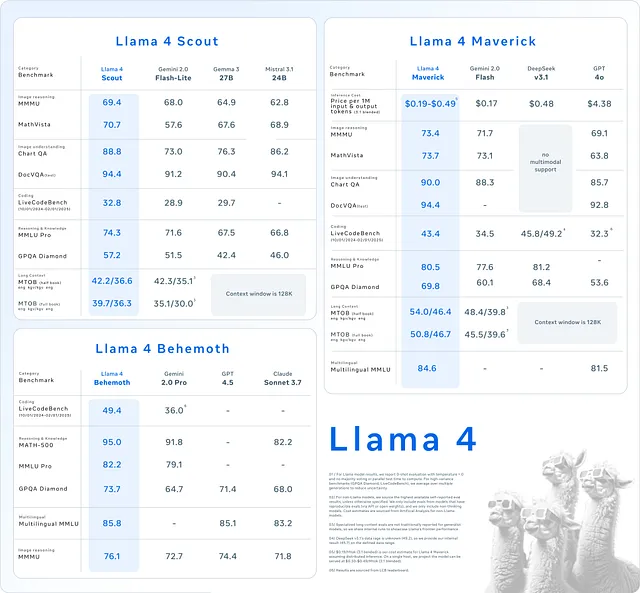

Llama APIは、Llama 3やLlama 4を含むMetaの言語モデルファミリーへのアクセスを提供します。これらのモデルは、テキスト生成、文脈理解、さらには画像を含むマルチモーダルなアプリケーションといったタスクに優れています。開発者はLlama APIを使用して、チャットボットからコンテンツ生成ツールまで、モデルをゼロからトレーニングすることなく様々なアプリケーションを開発しています。

これらのモデルは素晴らしいですが、通常、アクセスにはコストがかかります。ただし、どこを探せばよいかを知っていれば別です。幸いなことに、OpenRouterやTogether AIのようなプラットフォームは、特定のLlamaモデルへの無料アクセスを提供しています。このガイドでは、開始するためのステップバイステップの手順とコード例を添えて、両方の方法を解説します。

Llama APIを選ぶ理由

方法に入る前に、なぜLlama APIが優れているのかを考えてみましょう。まず、最高レベルの言語処理を提供し、アプリケーションが自然で人間らしいテキストを生成できるようにします。次に、Llama 4のような新しいバージョンではマルチモーダル機能が導入され、モデルがテキストと画像の両方を扱えるようになり、革新的なプロジェクトにとって画期的なものとなります。最後に、カスタムモデルを構築するのと比較して、APIを使用することで時間とリソースを節約できます。

これを踏まえて、Llama APIに無料でアクセスする方法を見ていきましょう。

方法1:OpenRouterを使用してLlama APIに無料でアクセスする

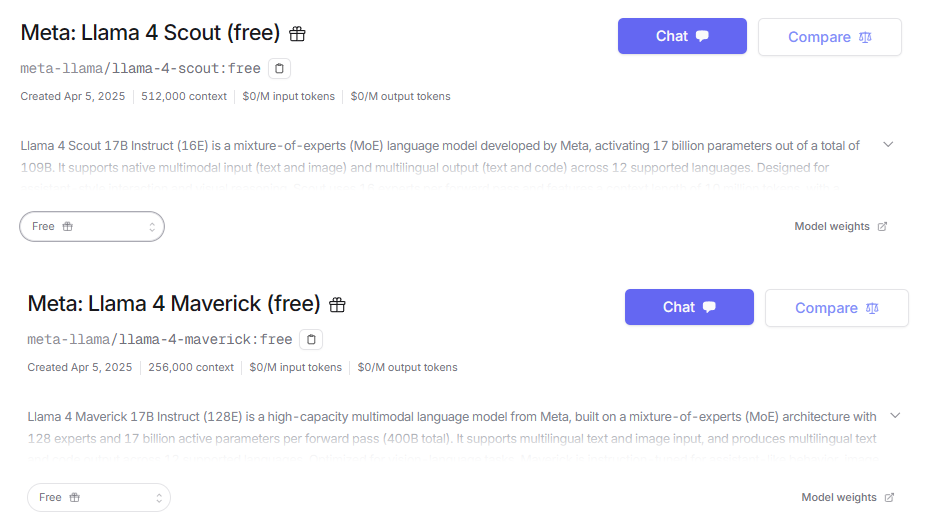

OpenRouterは統合APIプラットフォームとして機能し、MetaのLlamaシリーズを含む300以上のAIモデルへのアクセスを提供します。何よりも素晴らしいのは、Llama 4 MaverickやLlama 4 Scoutといったモデルを含む無料枠を提供していることです。これにより、OpenRouterは最先端のAIに無料でアクセスしたい開発者にとって理想的な出発点となります。

ステップ1:サインアップしてAPIキーを取得する

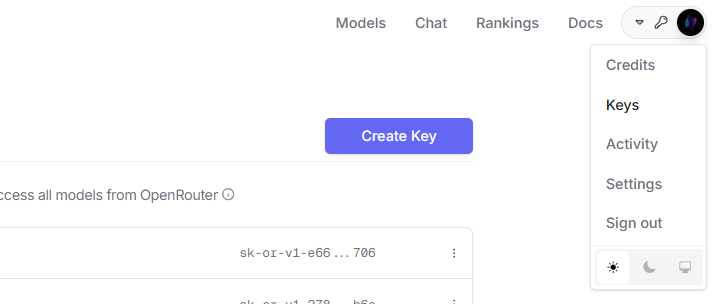

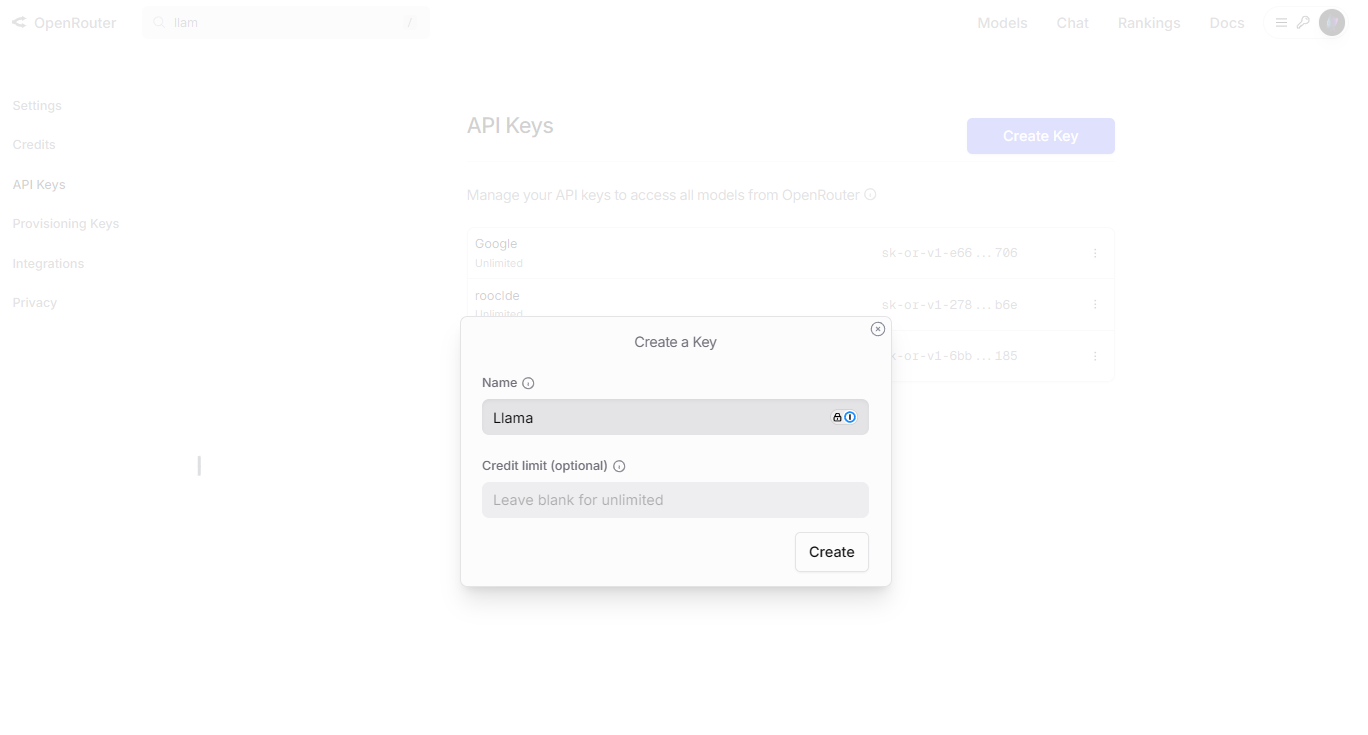

まず、OpenRouterアカウントとAPIキーが必要です。以下の手順に従ってください。

OpenRouterのウェブサイトにアクセスし、「Sign Up」をクリックします。ログイン後、ダッシュボードの「API Keys」セクションに進みます。

「Create Key」をクリックし、名前を付け(例:「Llama Free Key」)、キーを安全にコピーします。

ステップ2:環境をセットアップする

APIとやり取りするには、プログラミング言語とHTTPクライアントライブラリが必要です。ここではrequestsライブラリを使ったPythonを使用します。まだインストールしていない場合は、インストールしてください。

pip install requests

ステップ3:最初のリクエストを送信する

次に、OpenRouter経由でLlama 4 Scoutモデルを使用してテキストを生成するPythonスクリプトを記述しましょう。

import requests

import json

# Define the endpoint and your API key

API_URL = "https://openrouter.ai/api/v1/chat/completions"

API_KEY = "your_api_key_here" # Replace with your actual key

# Set headers for authentication

headers = {

"Authorization": f"Bearer {API_KEY}",

"Content-Type": "application/json"

}

# Create the payload with model and prompt

payload = {

"model": "meta-llama/llama-4-scout:free",

"messages": [

{"role": "user", "content": "Describe the Llama API in one sentence."}

],

"max_tokens": 50

}

# Send the request

response = requests.post(API_URL, headers=headers, data=json.dumps(payload))

# Handle the response

if response.status_code == 200:

result = response.json()

print(result["choices"][0]["message"]["content"])

else:

print(f"Error: Request failed with status {response.status_code}")

このスクリプトは、Llama 4 Scoutモデルにプロンプトを送信し、その応答を表示します。出力の長さを制御するには、max_tokensを調整してください。

ステップ4:機能を試す

OpenRouterはカスタマイズをサポートしています。例えば、temperatureパラメータを調整して応答の創造性を変えたり、Llama 4 Maverickのようなモデルでマルチモーダル機能を試したりできます。利用可能なオプションの詳細については、OpenRouterのモデルページを確認してください。

方法2:Together AIを使用してLlama APIに無料でアクセスする

Together AIは、Llamaモデルをホストするもう一つのプラットフォームであり、Llama 3.2 11BのようなLlama 3モデルへの無料アクセスを提供しています。ただし、現時点ではTogether AIでLlama 4は無料ではないことに注意してください。有料プランのみがLlama 4を利用できます。Llama 3でニーズが満たされる場合は、この方法が有効です。

ステップ1:登録してAPIキーを取得する

まず、Together AIアカウントをセットアップします。

Together AIのウェブサイトにアクセスし、「API Keys」セクションに進み、新しいキーを生成します。

リクエストで使用するために、キーを安全に保存してください。

ステップ2:環境を準備する

OpenRouterと同様に、Pythonとrequestsを使用します。必要であればインストールしてください。

pip install requests

ステップ3:APIコールを行う

Together AIのLlama 3モデルでテキストを生成するPythonスクリプトを以下に示します。

import requests

import json

# Define the endpoint and your API key

API_URL = "https://api.together.xyz/inference"

API_KEY = "your_api_key_here" # Replace with your actual key

# Set headers for authentication

headers = {

"Authorization": f"Bearer {API_KEY}",

"Content-Type": "application/json"

}

# Create the payload with model and prompt

payload = {

"model": "llama-3-2-11b-free",

"prompt": "What does the Llama API do?",

"max_tokens": 50,

"temperature": 0.7

}

# Send the request

response = requests.post(API_URL, headers=headers, data=json.dumps(payload))

# Handle the response

if response.status_code == 200:

result = response.json()

print(result["output"]["text"])

else:

print(f"Error: Request failed with status {response.status_code}")

このスクリプトはLlama 3モデルにクエリを送信し、出力を表示します。temperatureの設定により、創造性と一貫性のバランスを調整できます。

ステップ4:制限を知る

Together AIの無料枠には、レート制限やLlama 4へのアクセスがないといった制約があります。Together AIのモデルページを確認して、何が利用可能かを理解し、それに応じて計画を立ててください。

Llama API体験を最適化する

Llama APIでの成功を最大限に引き出すために、以下の実践を採用してください。

- 正確なプロンプトを作成する:明確なプロンプトはより良い結果をもたらします。バリエーションをテストして出力を洗練させましょう。

- 使用量を追跡する:OpenRouterまたはTogether AIのダッシュボードでAPIコールを監視し、無料枠の制限内に収まるようにします。

- エラーを処理する:コードにtry-exceptブロックを追加して、失敗を適切に処理します。

- 応答をキャッシュする:頻繁なクエリ結果を保存して、APIの使用量を減らし、アプリを高速化します。

これらの手順により、プロジェクトの効率と信頼性が確保されます。

よくある問題のトラブルシューティング

Llama APIの使用中に問題が発生することがあります。それらを解決する方法は以下の通りです。

- 401 Unauthorized(認証エラー):APIキーが正しいこと、およびヘッダーに含まれていることを確認してください。

- 429 Too Many Requests(リクエスト過多):レート制限に達しました。待つか、プランをアップグレードしてください。

- Invalid Model(無効なモデル):モデル名がプロバイダーのドキュメントと一致していることを確認してください。

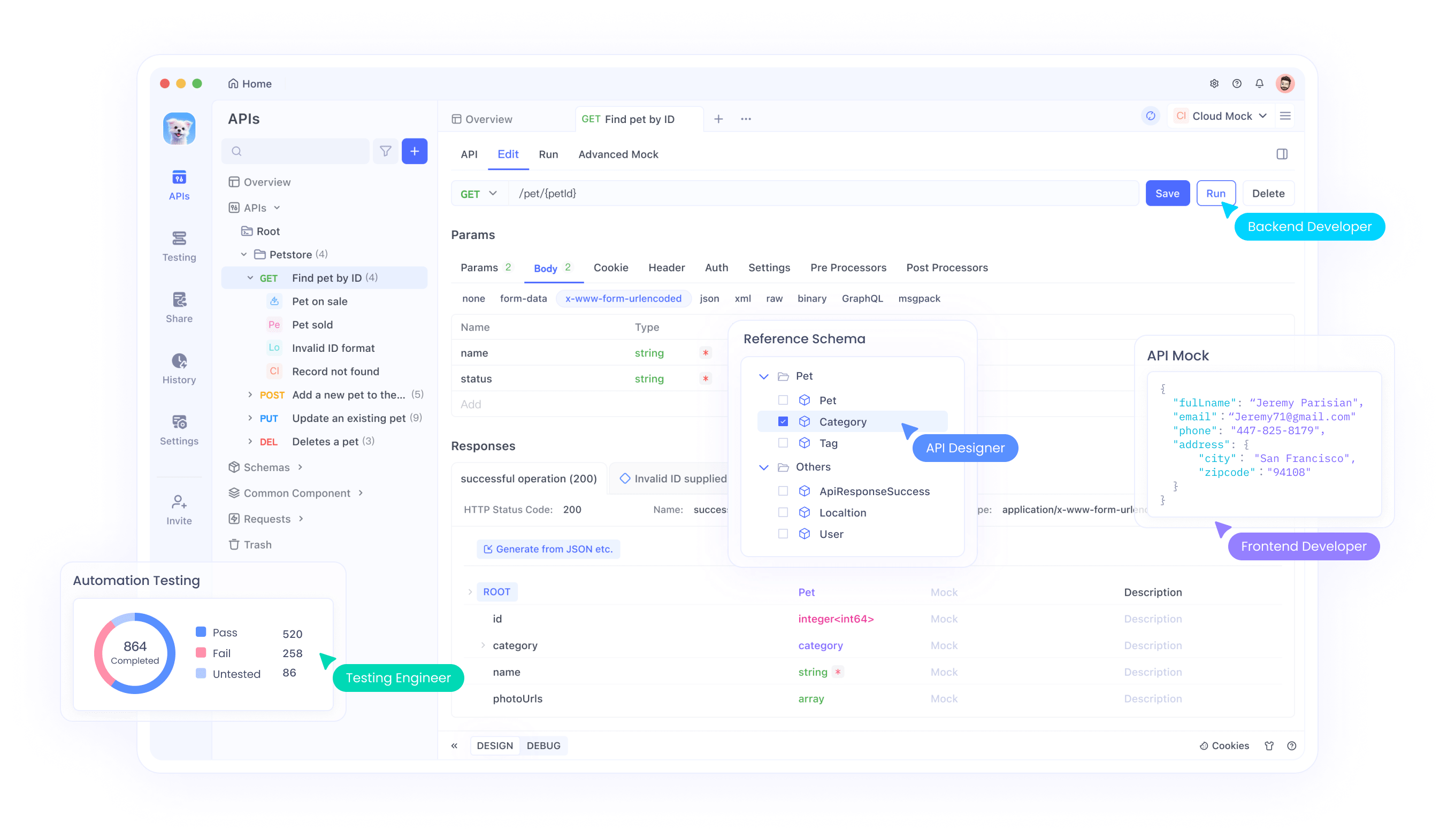

- Bad Payload(不正なペイロード):JSON構文を確認してください。Apidogのようなツールがデバッグに役立ちます。

ツールといえば、APIコールのテストとトラブルシューティングを簡素化するために、Apidogを無料でダウンロードしてください。開発者にとって必須のツールです。

OpenRouterとTogether AIの比較

どちらのプラットフォームも無料アクセスを提供していますが、いくつかの点で異なります。

- モデルの利用可能性:OpenRouterはLlama 4を無料で含んでいます。Together AIは無料アクセスをLlama 3に限定しています。

- 使いやすさ:どちらも分かりやすいAPIを提供していますが、OpenRouterのより広範なモデル選択が特徴的です。

- スケーラビリティ:Together AIは高度な機能のために有料プランを推奨する場合がありますが、OpenRouterの無料枠はより寛大です。

プロジェクトのニーズに基づいて選択してください。Llama 4へのアクセスが必要な場合はOpenRouterが有利であり、Together AIはLlama 3ユーザーに適しています。

Llama APIのユースケース

Llama APIは様々なシナリオでその真価を発揮します。

- チャットボット:自然な応答をする対話エージェントを構築します。

- コンテンツ作成:記事、要約、キャプションなどを生成します。

- マルチモーダルアプリ:Llama 4(OpenRouter経由)を使用して、テキストと画像処理を組み合わせます。

これらのアプリケーションはAPIの汎用性を示しており、適切なセットアップを行えばすべて無料で実現可能です。

結論

このガイドでは、OpenRouterとTogether AIを通じてLlama APIを無料で利用する方法を解説しました。OpenRouterはLlama 4モデルへのアクセスを許可し、Together AIは無料枠でLlama 3を提供しています。詳細な手順とコードスニペットにより、これらのモデルをプロジェクトに統合する準備が整いました。今日から実験を始め、Apidogのようなツールを活用してワークフローを強化することを忘れないでください。Llamaの力はあなたのものです。賢く使いましょう!