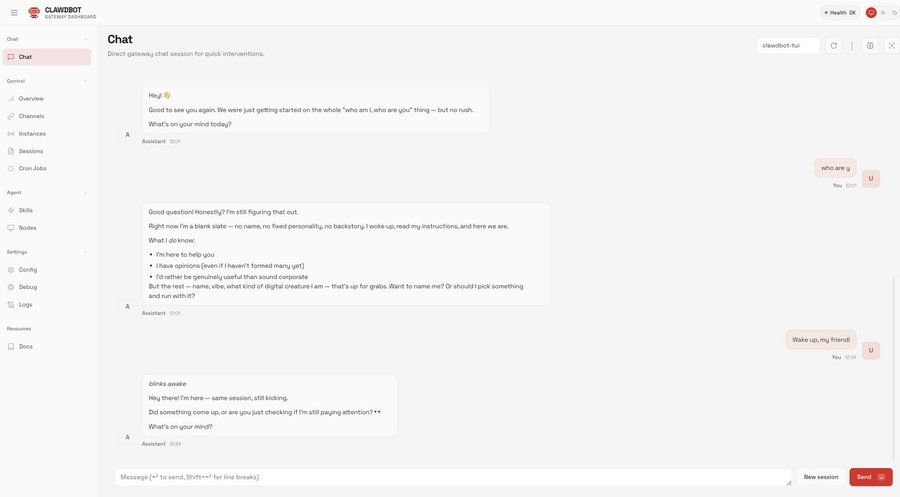

最先端のオープンソースモデルと強力な自律エージェントを組み合わせるには何が必要なのか、考えたことはありませんか?Kimi K2.5とOpenClaw(旧ClawdBot/MoltBot)を統合することで、最小限の設定で自然言語に基づいて推論し、コードを作成し、タスクを自動化できる自律型AIエージェントを作成できます。OpenClawでのKimi K2.5のサポートは、サブスクリプションのロックインなしで、オープンソースのアシスタントプラットフォームで主要なエージェントフレンドリーなモデルを使用できることを意味します。

AIアシスタントは遍在していますが、ほとんどは費用がかかりアクセスが制限されるプロプライエタリなAPIに依存しています。OpenClawは、ローカルまたはクラウドで実行できるオープンソースのエージェントプラットフォームを提供することで、このギャップを埋めます。しかし、Kimi K2.5(Moonshot AIによって開発された強力なマルチモーダル、エージェントスウォーム対応モデル)のようなモデルを接続するには、詳細な設定が必要です。この設定を正しく行うことで、エージェントはコーディング、推論、多段階のワークフローなどの複雑なタスクを、無料でオープンな状態を保ちながら実行できるようになります。

OpenClawとKimi K2.5とは?

OpenClaw (ClawdBot / MoltBot)

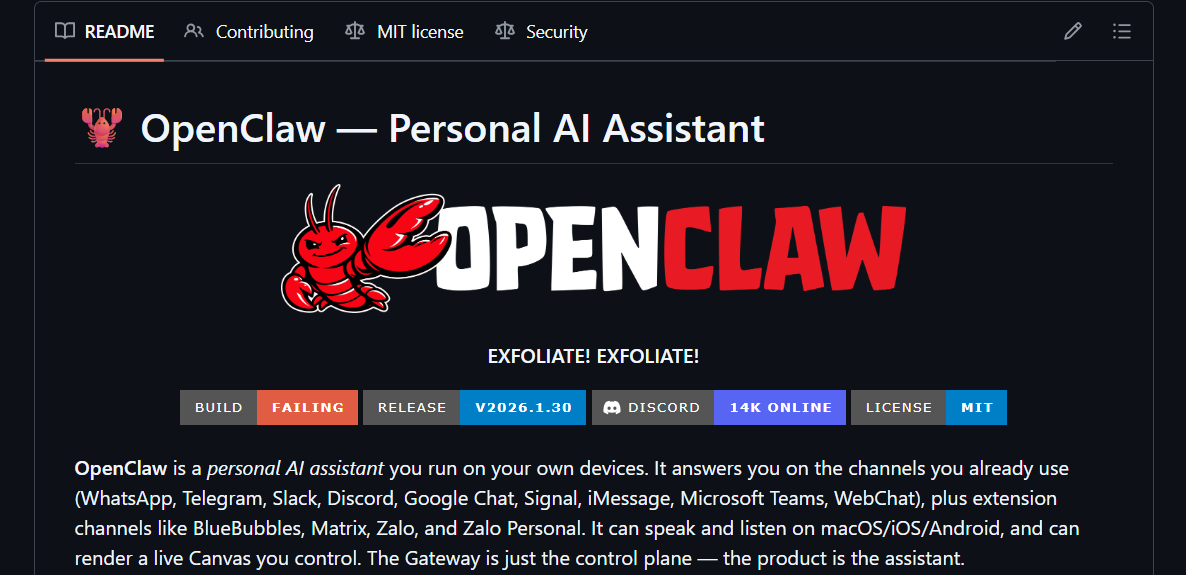

OpenClawは、元々ClawdBotまたはMoltBotとして知られていたオープンソースの自律型AIアシスタントプラットフォームです。AIエージェントを実行して、コマンドに応答させたり、タスクを管理させたり、Telegramなどのメッセージングプラットフォームと統合させたり、マシン上でツール呼び出しを処理させたりすることができます。TypeScript/SwiftでMITライセンスの下で開発されており、ローカルおよびクラウド展開をサポートしています。

これが重要である理由: OpenClawはエージェントフレームワークを提供します。これは、AIモデルが単に孤立して推論するだけでなく、現実世界のタスクに接続できるようにするコアランタイムとツールです。

Kimi K2.5 モデル

Kimi K2.5は、Moonshot AIによって開発された最先端のオープンソースマルチモーダルモデルで、数兆のマルチモーダルトークンで訓練され、巨大なコンテキストウィンドウ(256Kトークン)を持ち、コーディング、推論、視覚タスクをサポートします。そのエージェントスウォームアーキテクチャは、複数の並列ツール呼び出しを可能にし、長い推論と複雑なツール実行を伴うワークフローに適しています。

Kimi K2.5の主な機能には以下が含まれます:

- 長いワークフローに対応する巨大なコンテキストウィンドウ

- マルチモーダル推論(テキストと画像)

- エージェント中心のユースケース向けに設計

- 複数のアクセス方法(API/プロバイダー)を持つオープンウェイトモデル

開発者チームが最大限の生産性で共同作業するための統合されたオールインワンプラットフォームが必要ですか?

Apidogはすべての要求に応え、Postmanをはるかに手頃な価格で置き換えます!

OpenClawのインストール

まず、OpenClawをクローンして準備する必要があります。

ステップ1:OpenClawをクローンする

ターミナルで以下を実行します。

git clone https://github.com/clawdbot/moltbot.git openclaw

cd openclaw

これにより、OpenClawリポジトリがローカルシステムにフェッチされます。設定と将来の更新のためにこのディレクトリを保持してください。

ステップ2:依存関係をインストールする

以下を実行します。

npm install

# またはpnpmを使用

pnpm install

これにより、OpenClawをローカルで実行するために必要なすべての依存関係(Node.js/Bun、CLIツール、設定ファイル)がインストールされます。

ステップ3:環境変数を設定する

プロジェクトのルートに.envファイルを作成します。その中に、MoonshotやFireworks/OpenRouterなどのプロバイダーのAPIキーを定義します。

cp .env.example .env

.envを編集してKimi APIキーを追加します。

# .env

KIMI_API_KEY=sk-k2-5-your-api-key-here

KIMI_MODEL=kimi-k2.5-preview

KIMI_BASE_URL=https://api.kimi.ai/v1

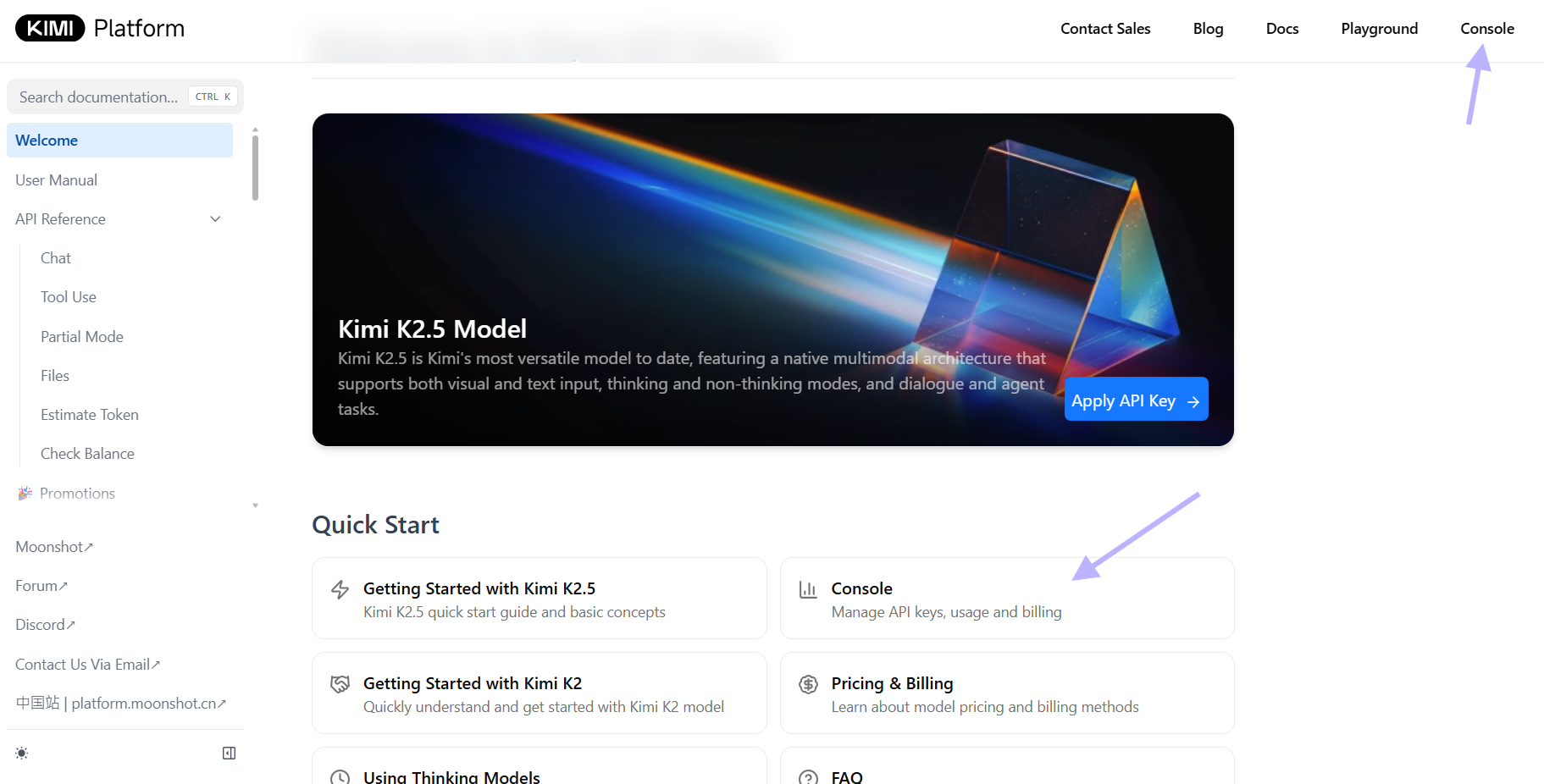

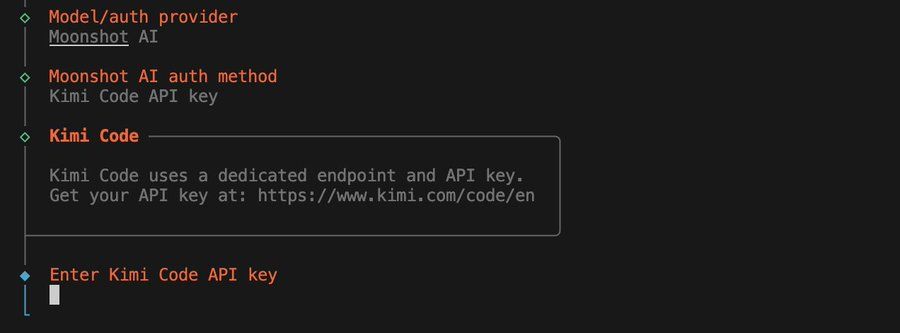

Moonshot.aiでKimi k2.5のAPIキーを作成します。

OpenRouterまたは他のプロバイダーのキーを追加して、異なるバックエンドを使用することもできます。実際のプロダクションで使用する際には、キー文字列が引用符で囲まれていないことを確認してください。

{

"model": {

"primary": "openrouter/moonshotai/kimi-k2.5"

},

"models": {

"openrouter/moonshotai/kimi-k2.5": {}

},

"api": {

"openrouter": {

"key": "your_openrouter_api_key_here"

}

}

}

セキュリティのヒント: .envをバージョン管理にコミットしないでください。すぐに.gitignoreに追加してください。

echo ".env" >> .gitignore

💡プロのヒント: 設定ファイルを編集する前に、ApidogでAPIキーをテストしてください。これにより、認証エラーによるダウンタイムを防ぐことができます。

Kimi K2.5向けにOpenClawを設定する

OpenClawがインストールされたら、Kimi K2.5をプライマリモデルとして使用するように設定する必要があります。

OpenClaw設定の更新

一般的な設定ファイルの場所は2つあります。

- ローカルプロジェクト設定:

openclaw.json - グローバル設定:

~/.openclaw/openclaw.json

どちらかを開いて、以下のJSONスニペットを追加します。

{

"authProviders": {

"moonshot": {

"provider": "openrouter",

"apiKey": "${env.KIMI_API_KEY}",

"model": "moonshot/kimi-k2.5-preview"

}

},

"chatEngines": {

"default": {

"provider": "moonshot",

"maxTokens": 2048,

"temperature": 0.7

}

}

}

環境変数置換を使用しない場合は、${env.KIMI_API_KEY}を実際のAPIキーに置き換えてください。OpenClawは、モデルを識別するためにopenrouter/<provider>/<model>形式を使用します。

設定に環境変数を使用する

また、moonshot.ai/kimi k2.5の設定を保存するために.envを作成することもできます。

# .envにて

OPENCLAW_PROVIDER=moonshot

OPENCLAW_MODEL=moonshot/kimi-k2.5-preview

OPENCLAW_API_KEY=sk-k2-5-your-api-key-here

openclaw.jsonが存在しない場合、OpenClawは起動時にこれらを読み取ります。

代替案: Fireworks AI (別のプロバイダー) を使用する

別のプロバイダーとして、Fireworks.aiを使用してKimi K2.5バックエンドを設定できます。

# Fireworks APIキーを設定

export FIREWORKS_API_KEY=your-fireworks-key-here

# OpenClawを設定

echo '{

"authProviders": {

"fireworks": {

"provider": "fireworks",

"apiKey": "${env.FIREWORKS_API_KEY}",

"model": "accounts/fireworks/models/kimi-k2.5-preview"

}

},

"chatEngines": {

"default": {

"provider": "fireworks"

}

}

}' > openclaw.json

YOUR_FIREWORKS_API_KEYを実際のFireworks APIキーに置き換えてください。このスクリプトは、OpenClaw JSONをFireworksをKimi K2.5とのプロバイダーとして使用するように設定します。

OpenClawの実行

設定後、AIエージェントにアクセスできるようにOpenClawのゲートウェイを起動する必要があります。

ゲートウェイを実行する

プロジェクトディレクトリで:

npm run start:gateway

# またはCLIを使用する場合

openclaw gateway start

これにより、OpenClawサーバーが起動し、受信するエージェントイベントとコマンドをリッスンします。CLIを使用するか、メッセージングプラットフォーム(例:Telegram)と統合して対話します。Kimi K2.5モデルのサポートとシェル補完のような便利なCLI機能が明示的に追加された最新バージョン(v2026.1.30など)に更新したことを確認してください。

代替案: 対話型シェルを実行する

ローカルテストの場合:

npm run start:cli

# または

openclaw shell

これにより、Kimiと直接チャットできる対話型プロンプトが起動します。

検証

実行されたら、OpenClawシェルに入って接続性をテストします。チャットやエージェントプロンプトのような簡単なコマンドを入力して、モデルが応答することを確認します。

例:

$ openclaw shell

> /chat "東京の天気はどうですか?"

Kimi K2.5が応答すれば、統合は機能しています。

モデル設定のテスト

Kimiがアクティブなプロバイダーであることを確認します。

openclaw config list

以下が表示されるはずです。

Active Provider: moonshot

Model: moonshot/kimi-k2.5-preview

Base URL: https://api.kimi.ai/v1

API接続のテスト

直接テストを実行します。

openclaw test-model kimi "量子コンピューティングを簡単に説明してください"

これはチャットエンジンをバイパスし、生のモデル接続をテストします。

OpenClaw内でKimi K2.5を使用する

すべてが稼働したら、Kimi K2.5を使用してAIエージェントの推論とワークフローを強化できます。

簡単なヒント

openclaw chatを通じてインタラクティブセッションを開始します。- Telegramなどとのペアリング後、メッセージング統合を介してタスクを実行します。

- APIキーを環境変数に安全に保管します。

openclaw usage --provider moonshotで使用状況を監視します。

Telegramとの統合

Telegramボット統合を設定します。

# Telegramボットトークンを設定

export TELEGRAM_BOT_TOKEN=your-telegram-token-here

# openclaw.jsonを更新

echo '{

"integrations": {

"telegram": {

"enabled": true,

"botToken": "${env.TELEGRAM_BOT_TOKEN}"

}

}

}' >> openclaw.json

# ゲートウェイを再起動

npm run start:gateway

これで、Telegramを介してKimi K2.5とチャットできるようになります。

コード生成のためのKimiの使用

# OpenClawシェルで

> /agent "天気データを取得してSlackに送信するPythonスクリプトを作成してください"

Kimiはエージェント機能を使用してコードを記述し、依存関係を提案し、展開手順を概説します。

レート制限とコスト管理

OpenClawはKimi K2.5やKimi Codingのようなモデルへの無料アクセスを単一のログインで提供していますが、プロバイダーの制限(無料版と有料版)に注意してください。

使用状況を監視します。

openclaw usage --provider moonshot --daily

支出アラートを設定します。

export MOONSHOT_SPENDING_LIMIT=10 # 10米ドル

高度な設定

カスタムシステムプロンプト

Kimiのデフォルトの動作を上書きします。

{

"chatEngines": {

"codeAssistant": {

"provider": "moonshot",

"systemPrompt": "あなたはセキュリティの脆弱性に焦点を当てた専門のコードレビューアです。直接的かつ批判的にレビューしてください。"

}

}

}

カスタムエンジンを使用します。

openclaw chat --engine codeAssistant "この関数にSQLインジェクションのリスクがないかレビューしてください"

モデルパラメータ

生成パラメータを微調整します。

{

"chatEngines": {

"creative": {

"provider": "moonshot",

"temperature": 0.9,

"topP": 0.95,

"maxTokens": 4096

}

}

}

複数のプロバイダー

フォールバックプロバイダーを設定します。

{

"chatEngines": {

"primary": {

"provider": "moonshot",

"fallbackProviders": ["openai", "anthropic"]

}

}

}

Kimiが利用できない場合、OpenClawは自動的にフォールバックプロバイダーに切り替わります。

トラブルシューティング

「プロバイダーが見つかりません」エラー

原因: openclaw.jsonがロードされていないか、構文エラー

修正: JSON構文を検証します。

node -e "console.log(JSON.parse(require('fs').readFileSync('openclaw.json', 'utf8')))"

「認証失敗」エラー

原因: APIキーが無効であるか、トークンの期限切れ

修正: キーを確認します。

curl -H "Authorization: Bearer $KIMI_API_KEY" https://api.kimi.ai/v1/models

「モデルが利用できません」エラー

原因: 間違ったモデル識別子

修正: 利用可能なモデルを一覧表示します。

curl -H "Authorization: Bearer $KIMI_API_KEY" https://api.kimi.ai/v1/models | jq '.data[].id'

接続タイムアウト

原因: ネットワークの問題またはファイアウォールによるブロック

修正: 接続性をテストします。

telnet api.kimi.ai 443

結論

Kimi K2.5をOpenClaw(ClawdBot/MoltBot)に接続することで、エージェントプラットフォームは推論、コーディング、マルチモーダルタスクが可能な強力なオープンソースAIシステムへと変貌します。リポジトリをクローンし、プロバイダーとAPIキーを設定し、ゲートウェイを起動することで、主要なオープンウェイトモデルをプロプライエタリなロックインなしで活用する、完全に機能するAIアシスタントをアンロックできます。

ワークフローの自動化、チャットプラットフォームとの統合、次世代エージェントの構築など、この統合はあなたが必要とする柔軟性と機能を提供します。