開発者は、高度なAIモデルをアプリケーションに統合するための効率的な方法を常に模索しており、Qwen Nextは魅力的な選択肢として浮上しています。AlibabaのQwenシリーズの一部であるこのモデルは、推論中にパラメータのごく一部のみをアクティブ化する疎なエキスパート混合(MoE)アーキテクチャを提供します。その結果、パフォーマンスを犠牲にすることなく、処理時間の短縮とコストの削減を実現します。

Qwen NextのコアアーキテクチャとそのAPIユーザーにとっての重要性を理解する

Qwen Nextのハイブリッドアーキテクチャは、ゲートメカニズムと高度な正規化を組み合わせることで、API駆動型タスク向けに最適化されています。そのMoEレイヤーは、トークンごとに512の専門エキスパートのうち10個と1つの共有エキスパートに入力をルーティングし、わずか30億のパラメータをアクティブ化します。この疎性はリソース要求を削減し、Qwen APIユーザーの推論を高速化します。

さらに、このモデルは部分的なロータリー位置埋め込み(RoPE)を伴うスケールド・ドットプロダクトアテンションを採用し、最大128Kトークンのシーケンスでコンテキストを保持します。ゼロ中心のRMSNormレイヤーは勾配を安定させ、大量のAPIコール中に信頼性の高い出力を保証します。3倍の拡張因子を持つDeltaNetパスは、L2正規化、畳み込みレイヤー、SiLUアクティベーションを使用して投機的デコーディングをサポートし、複数のトークンを同時に生成します。

開発者にとって、これはドキュメント分析ツールのようなアプリケーションへのNext Integrationが効率的かつスケーラブルであることを意味します。このアーキテクチャのモジュール性は、金融などのドメインでのファインチューニングを可能にし、Qwen APIを介して適応可能にします。次に、これらの機能が測定可能なパフォーマンスにどのように変換されるかを見てみましょう。

API駆動型アプリケーションにおけるQwen Nextのパフォーマンスベンチマークの評価

Qwen NextをAPI駆動型ワークフローに統合する開発者は、高いパフォーマンスと計算効率のバランスが取れたモデルを優先します。Qwen3-Next-80B-A3Bは、推論中にわずか30億のパラメータのみをアクティブ化する疎なエキスパート混合(MoE)アーキテクチャにより、この分野で優れています。このセクションでは、主要なベンチマークを評価し、Qwen NextがQwen3-32Bのようなより密度の高いモデルをいかに凌駕し、リアルタイムAPI応答に不可欠な優れた推論速度を提供するかを強調します。一般知識、コーディング、推論、長文コンテキストタスクにわたる指標を調べることで、スケーラブルなアプリケーションへの適合性に関する洞察が得られます。

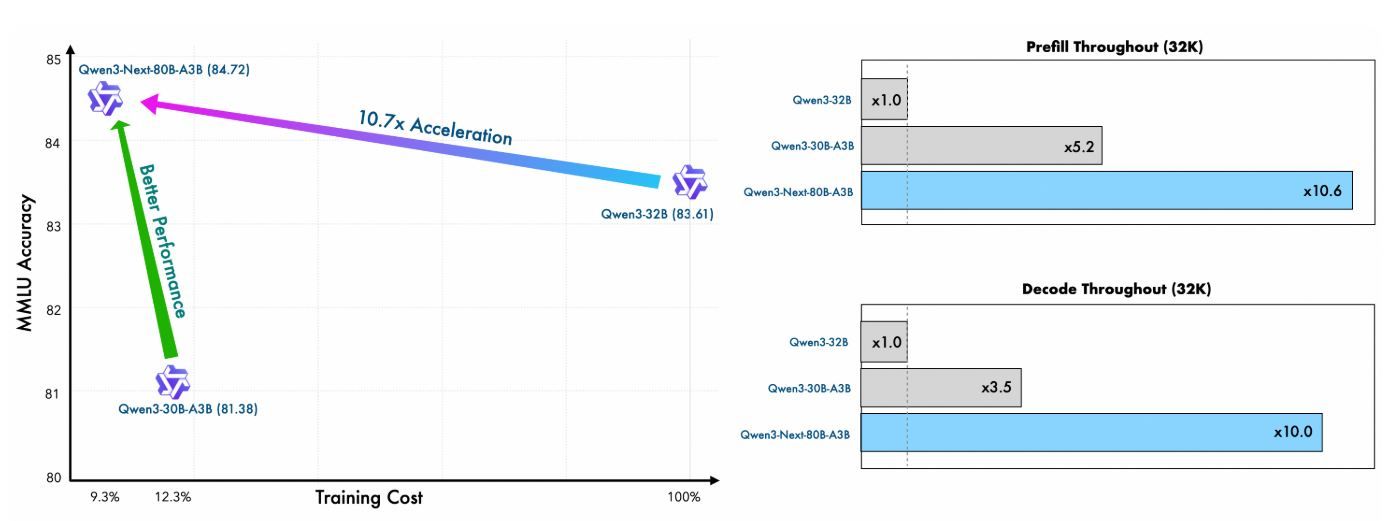

事前学習の効率とベースモデルのパフォーマンス

Qwen Nextの事前学習は驚くべき効率性を示しています。Qwen3の36兆トークンコーパスの15兆トークンサブセットで学習されたQwen3-Next-80B-A3B-Baseモデルは、Qwen3-30B-A3Bが必要とするGPU時間の80%未満、Qwen3-32Bの計算コストのわずか9.3%しか消費しません。それにもかかわらず、Qwen3-32B-Baseが使用する非埋め込みパラメータのわずか10分の1しかアクティブ化しないにもかかわらず、ほとんどの標準ベンチマークでそれを上回り、Qwen3-30B-A3Bを大幅に凌駕しています。

この効率性は、Gated DeltaNet(レイヤーの75%)とGated Attention(25%)を組み合わせたハイブリッドアーキテクチャに由来しており、学習の安定性と推論スループットの両方を最適化します。APIユーザーにとって、これはモデルが少ないリソースでより良いパープレキシティと損失削減を達成するため、デプロイコストの削減とプロトタイピングの高速化につながります。

指標 | Qwen3-Next-80B-A3B-Base | Qwen3-32B-Base | Qwen3-30B-A3B-Base |

|---|---|---|---|

学習GPU時間 (Qwen3-32B比) | 9.3% | 100% | 約125% |

アクティブパラメータ比率 | 10% | 100% | 10% |

ベンチマーク性能 | ほとんどで上回る | ベースライン | 大幅に優れる |

これらの数値は、ファインチューニングによるカスタムバリアントの学習が依然として実現可能な、リソースが制約されたAPI環境におけるQwen Nextの価値を強調しています。

推論速度:APIレイテンシのためのプリフィルおよびデコード段階

推論速度は、チャットサービスやコンテンツ生成のような高スループットのシナリオにおいて、API応答時間に直接影響します。Qwen Nextは、超疎なMoE(512のエキスパート、10 + 1共有をルーティング)と投機的デコーディングのためのマルチトークン予測(MTP)を活用することで、この点で優れています。

プリフィル段階(プロンプト処理)では、Qwen Nextは4Kコンテキスト長でQwen3-32Bよりも約7倍高いスループットを達成します。32Kトークンを超えると、この利点は10倍を超え、長文ドキュメント分析APIに最適です。

デコード段階(トークン生成)では、スループットは4Kコンテキストで約4倍、より長い長さでは10倍以上に達します。マルチステップの一貫性のために最適化されたMTPメカニズムは、投機的デコーディングにおける受け入れ率を高め、実際の推論をさらに加速します。

コンテキスト長 | プリフィルスループット (Qwen3-32B比) | デコードスループット (Qwen3-32B比) |

|---|---|---|

4Kトークン | 7倍高速 | 4倍高速 |

>32Kトークン | 10倍以上高速 | 10倍以上高速 |

API開発者は多大な恩恵を受けます。レイテンシの削減により本番環境で1秒未満の応答が可能になり、電力効率(パラメータのわずか3.7%しかアクティブ化しないため)によりクラウドコストが削減されます。vLLMやSGLangのようなフレームワークは、テンソル並列処理により最大256Kのコンテキストをサポートし、これらの利点を増幅させます。

Qwen Nextで最初のAPIコールを行う:ステップバイステップの実装

Qwen Nextの機能を活用するには、AlibabaのDashScopeプラットフォームを通じてQwen APIコールを設定および実行するための、これらの明確で実行可能なステップに従ってください。このガイドは、単純なクエリから複雑なNext Integrationシナリオまで、モデルを効率的に統合できることを保証します。

ステップ1:Alibaba Cloudアカウントを作成し、Model Studioにアクセスする

まず、alibabacloud.comでAlibaba Cloudアカウントにサインアップします。アカウントを確認した後、DashScopeプラットフォーム内のModel Studioコンソールに移動します。モデルリストからQwen3-Next-80B-A3Bを選択し、ユースケースに基づいてベース、インストラクト、または思考バリアントを選択します(例:会話タスクにはインストラクト、複雑な推論には思考)。

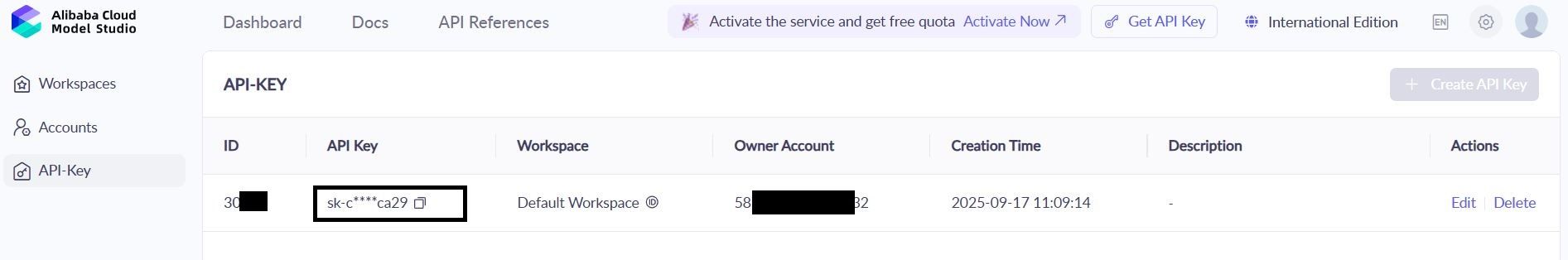

ステップ2:APIキーを生成し、安全に保管する

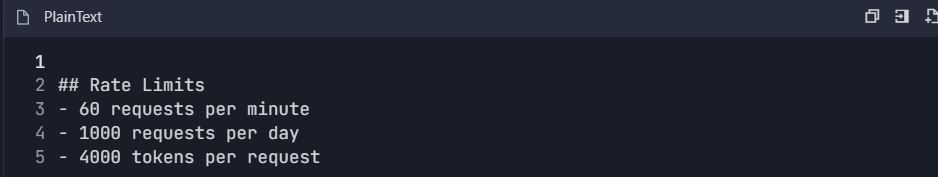

DashScopeダッシュボードで「API Keys」セクションを見つけ、新しいキーを生成します。このキーはQwen APIリクエストを認証します。レート制限に注意してください。無料ティアでは月間100万トークンが提供され、初期テストには十分です。キーの漏洩を防ぐため、環境変数に安全に保管してください。

bash

export DASHSCOPE_API_KEY='your_key_here'この方法は、コードのポータビリティとセキュリティを維持します。

ステップ3:DashScope Python SDKをインストールする

Qwen APIとのやり取りを簡素化するために、DashScope SDKをインストールします。ターミナルで次のコマンドを実行します。

bash

pip install dashscopeSDKは、シリアル化、再試行、エラー解析を処理し、統合プロセスを効率化します。あるいは、カスタムセットアップにはrequestsのようなHTTPクライアントを使用することもできますが、簡便性のためにSDKが推奨されます。

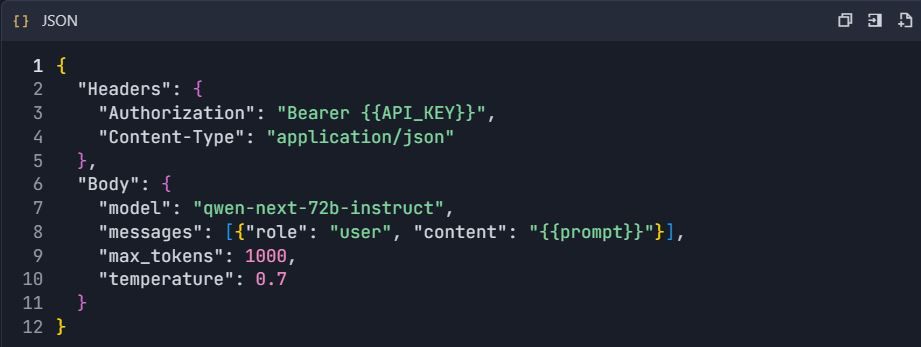

ステップ4:APIエンドポイントを設定する

OpenAI互換クライアントの場合、ベースURLを次のように設定します。

text

https://dashscope.aliyuncs.com/compatible-mode/v1ネイティブのDashScopeコールの場合、次を使用します。

text

https://dashscope.aliyuncs.com/api/v1/services/aigc/text-generation/generationリクエストヘッダーにX-DashScope-API-KeyとしてAPIキーを含めます。この設定により、Qwen Nextへの適切なルーティングが保証されます。

ステップ5:最初のAPIコールを行う

instructバリアントを使用して、基本的な生成リクエストを作成します。以下は、Qwen NextをクエリするためのPythonスクリプトです。

python

import os

from dashscope import Generation

os.environ['DASHSCOPE_API_KEY'] = 'your_api_key'

response = Generation.call(

model='qwen3-next-80b-a3b-instruct',

prompt='Explain the benefits of MoE architectures in LLMs.',

max_tokens=200,

temperature=0.7

)

if response.status_code == 200:

print(response.output['text'])

else:

print(f"Error: {response.message}")このスクリプトはプロンプトを送信し、出力を200トークンに制限し、temperature=0.7で創造性を制御します。ステータスコード200は成功を示し、それ以外の場合はクォータ制限(コード10402)などのエラーを処理します。

ステップ6:リアルタイム応答のためのストリーミングを実装する

即時フィードバックを必要とするアプリケーションには、ストリーミングを使用します。

python

from dashscope import Streaming

for response in Streaming.call(

model='qwen3-next-80b-a3b-instruct',

prompt='Generate a Python function for sentiment analysis.',

max_tokens=500,

incremental_output=True

):

if response.status_code == 200:

print(response.output['text_delta'], end='', flush=True)

else:

print(f"Error: {response.message}")

breakこれはトークンごとの出力を提供し、Next Integrationにおけるライブチャットインターフェースに最適です。

ステップ7:エージェントワークフローのための関数呼び出しを追加する

ツール統合で機能を拡張します。天気予報の取得のようなツールのJSONスキーマを定義します。

python

tools = [{

"type": "function",

"function": {

"name": "get_weather",

"description": "Get current weather",

"parameters": {

"type": "object",

"properties": {"city": {"type": "string"}}

}

}

}]

response = Generation.call(

model='qwen3-next-80b-a3b-instruct',

prompt='What\'s the weather in Beijing?',

tools=tools,

tool_choice='auto'

)Qwen APIはプロンプトを解析し、ツール呼び出しをトリガーします。関数を外部で実行し、結果をフィードバックします。

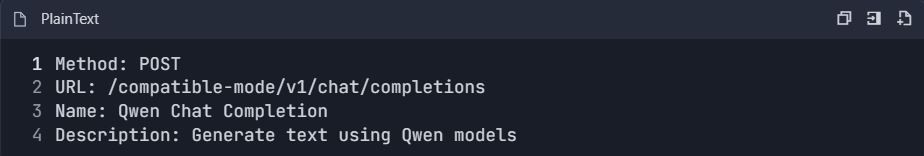

ステップ8:Apidogでテストと検証を行う

Apidogを使用してAPIコールをテストします。DashScopeスキーマを新しいApidogプロジェクトにインポートし、エンドポイントを追加し、ヘッダーにAPIキーを含めます。プロンプトを含むJSONボディを作成し、テストケースを実行して応答を検証します。Apidogはレイテンシなどのメトリックを生成し、エッジケースを提案することで信頼性を向上させます。

ステップ9:応答を監視し、デバッグする

エラー(例:レート制限の場合は429)がないか応答コードを確認します。監査のために出力を匿名化してログに記録します。Apidogのダッシュボードを使用してトークン使用量と応答時間を追跡し、Qwen APIコールがクォータ内に収まっていることを確認します。

これらのステップは、Qwen Nextを統合するための堅牢な基盤を提供します。次に、Apidogでテストを効率化しましょう。

Qwen Next APIの関数呼び出しをエージェントワークフローに活用する

関数呼び出しは、Qwen Nextのユーティリティをテキスト生成を超えて拡張します。JSONスキーマでツールを定義し、名前、説明、パラメータを指定します。天気予報クエリの場合、`city`パラメータを持つ`get_weather`関数を概説します。

APIコールでは、tools配列を含め、`tool_choice`を'auto'に設定します。モデルはプロンプトを分析し、意図を特定してツール呼び出しを返します。関数を外部で実行し、最終的な応答のために結果をフィードバックします。

このパターンは、Qwen Nextが複数のツールをオーケストレーションするエージェントシステムを作成します。例えば、天気データと感情分析を組み合わせてパーソナライズされたレコメンデーションを行うことができます。Qwen APIは解析を効率的に処理し、カスタムコードの必要性を減らします。

スキーマを厳密に検証することで最適化します。ランタイムエラーを避けるために、パラメータが期待される型と一致することを確認します。統合する際には、これらの呼び出しを徹底的にテストしてください。Apidogのようなツールは、ライブAPIヒットなしで応答をシミュレートできるため、ここで非常に貴重であることが証明されます。

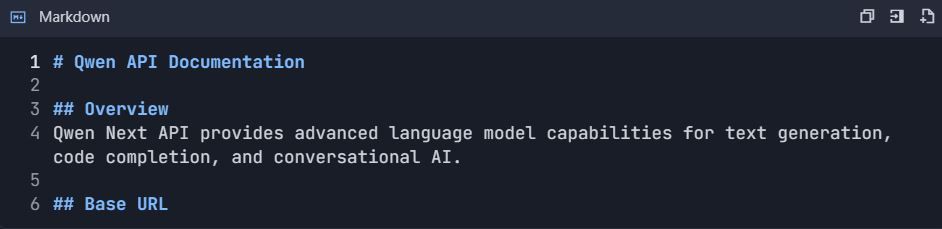

効率的なQwen APIテストとドキュメント作成のためのApidogの統合

このガイドは、効率的なテスト、ドキュメント作成、APIライフサイクル管理のために、ApidogとQwen API(Alibaba CloudのQwen Next/3.0)を統合するための包括的なワークフローを提供します。

フェーズ1:初期設定とアカウント設定

ステップ1:アカウント設定

1.1 必要なアカウントの作成

1. Alibaba Cloudアカウント

2. アクセス先: https://www.alibabacloud.com

3. 登録と検証を完了する

4. 「Model Studio」サービスを有効にする

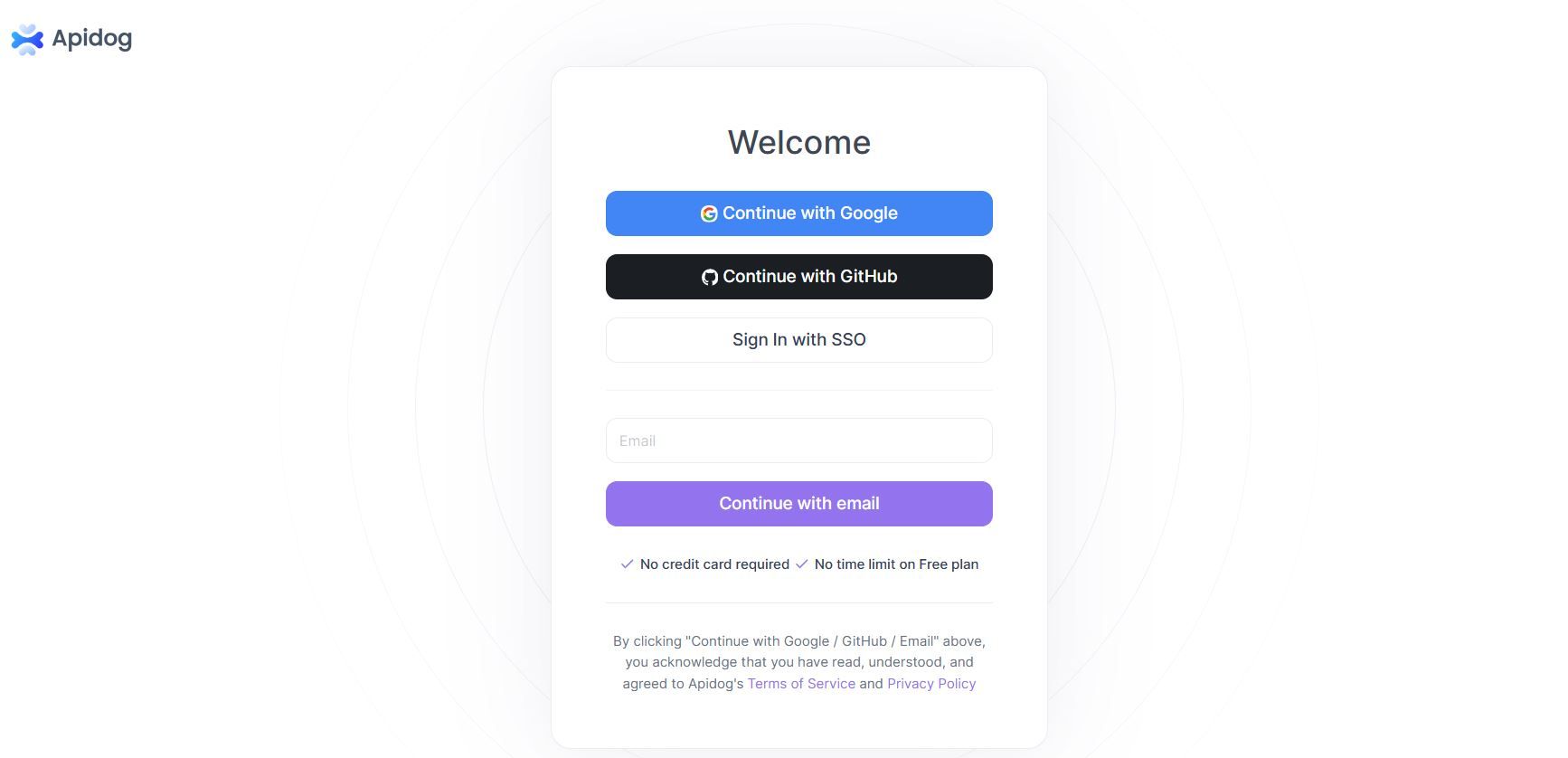

5. Apidogアカウント

6. アクセス先: https://apidog.com

7. メール/Google/GitHubでサインアップする

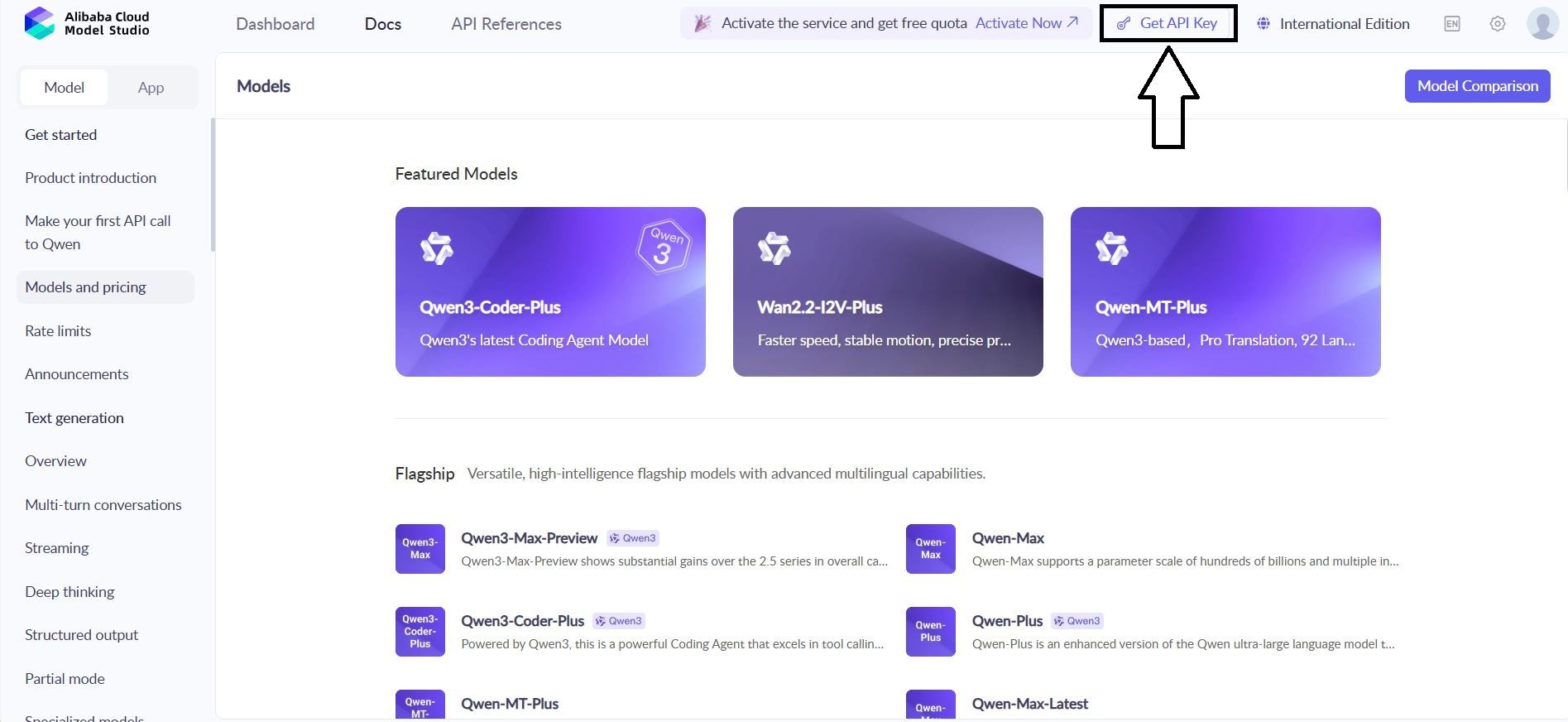

1.2 Qwen API認証情報を取得する

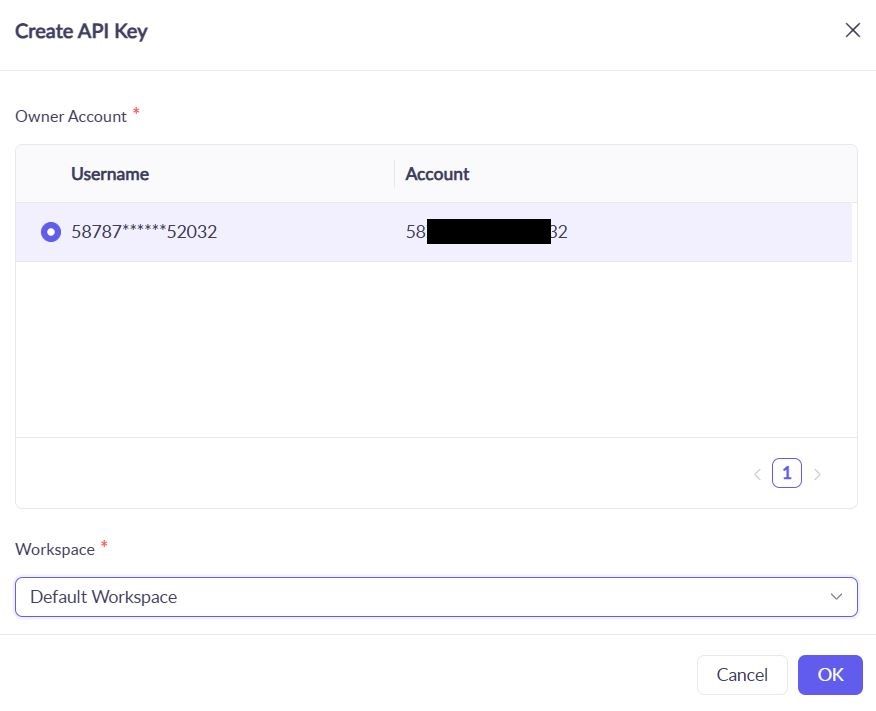

1. 移動先: Alibaba Cloudコンソール → Model Studio → APIキー

2. 新しいキーを作成: qwen-testing-key

3. キーを保存: sk-[実際のキーをここに]

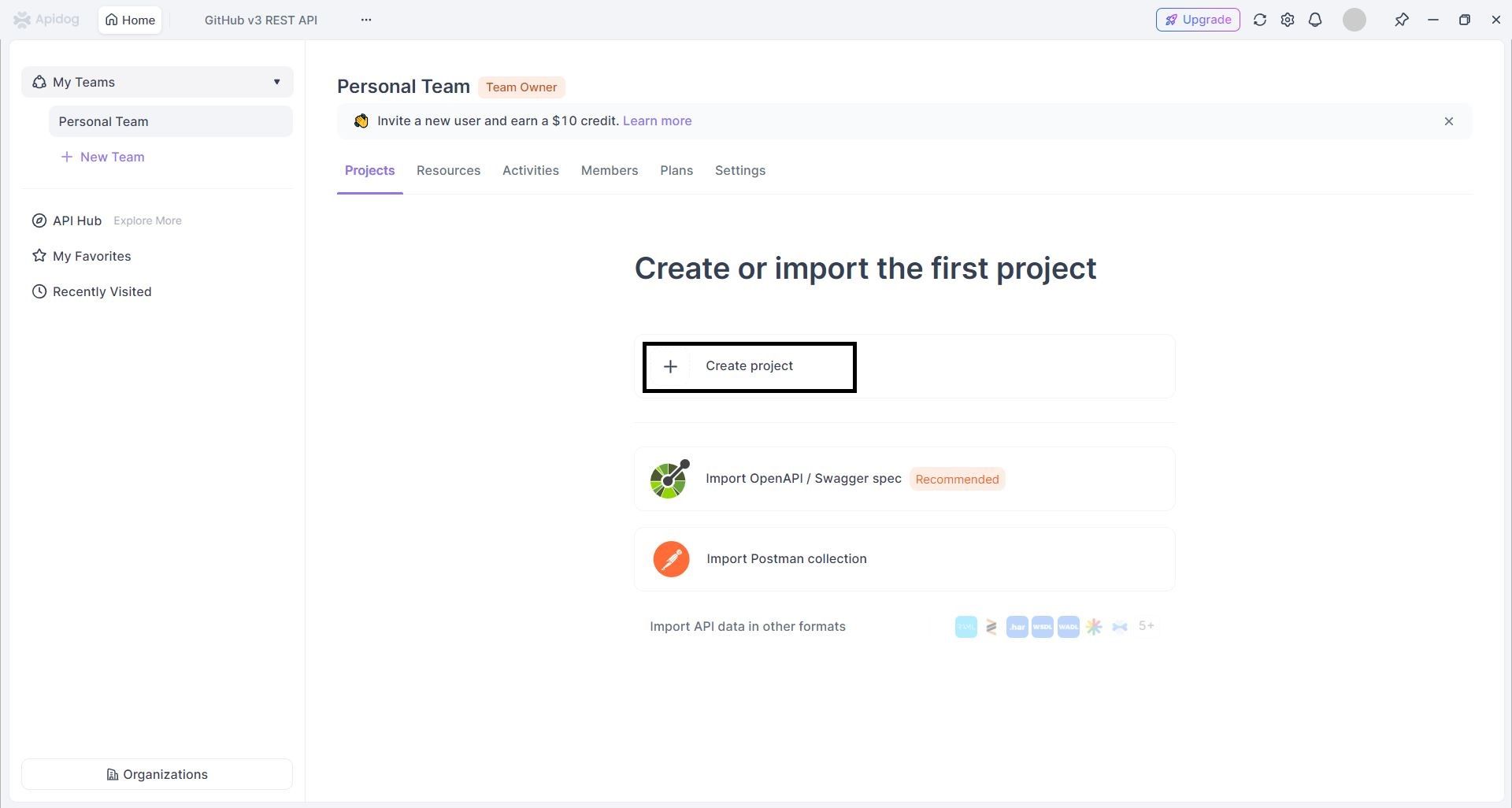

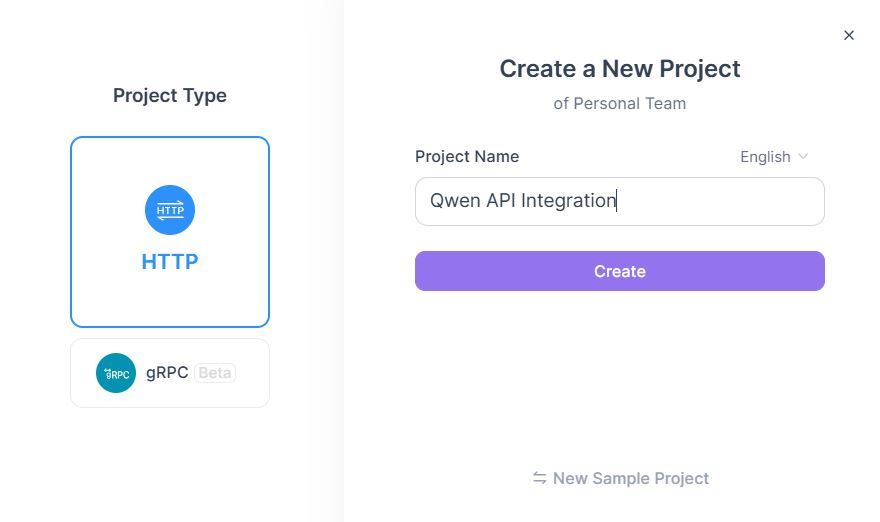

1.3 Apidogプロジェクトを作成する

- Apidogにログイン → 「New Project」をクリック

2. プロジェクトを設定する:

1. プロジェクト名:Qwen API連携

2. 説明:Qwen Next APIテストとドキュメント作成

フェーズ2:APIのインポートと設定

ステップ2:Qwen API仕様をインポートする

方法A:手動API作成

- 新しいAPIを追加 → 「手動でAPIを作成」

- Qwenチャットエンドポイントを設定する:

3. リクエスト設定を行う:

方法B:OpenAPIインポート

- Qwen OpenAPI仕様をダウンロードする(利用可能な場合)

- プロジェクトに移動 → 「インポート」 → 「OpenAPI/Swagger」

- 仕様ファイルをアップロード → 「インポート」

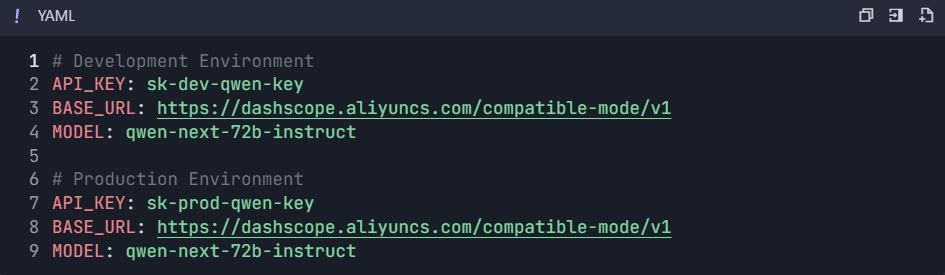

フェーズ3:環境と認証の設定

ステップ3:環境を設定する

3.1 環境変数を作成する

- プロジェクト設定に移動 → 「環境」

- 環境を作成する:

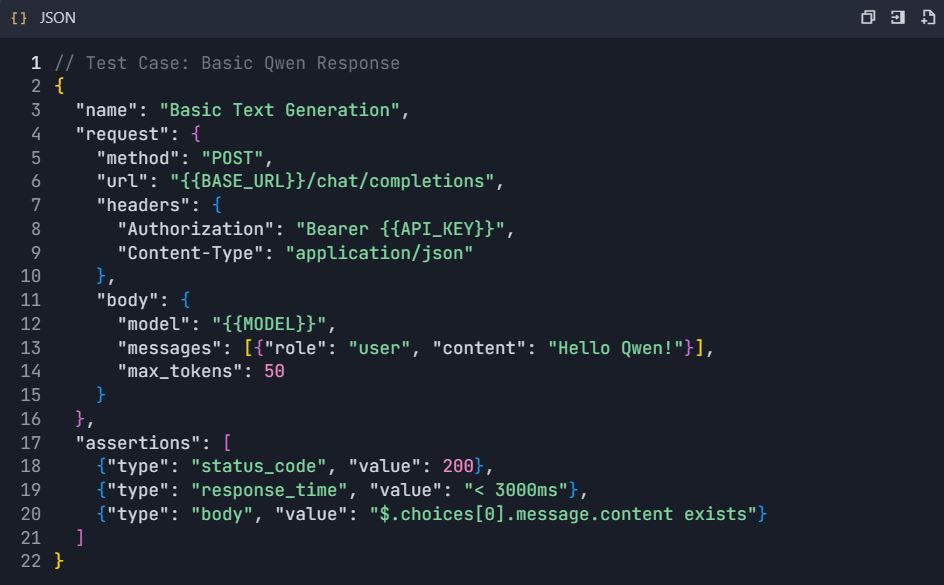

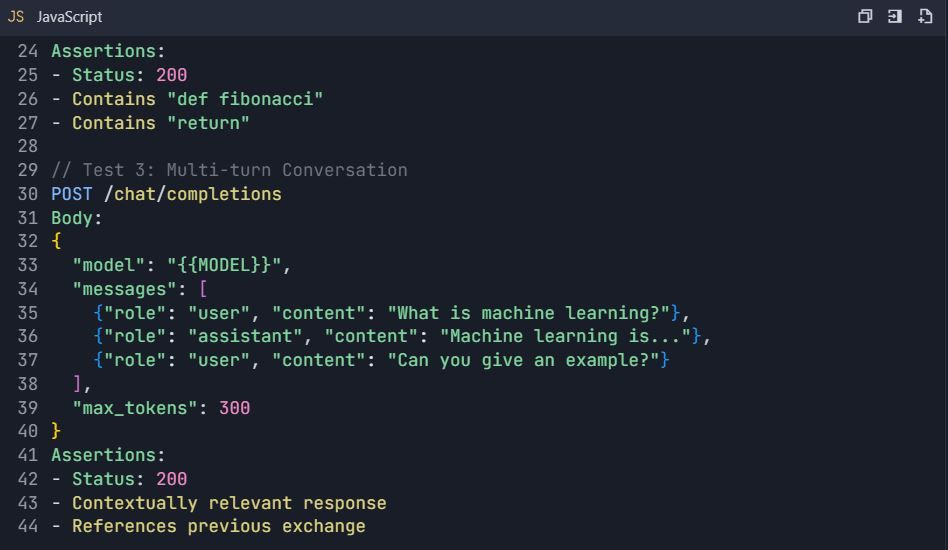

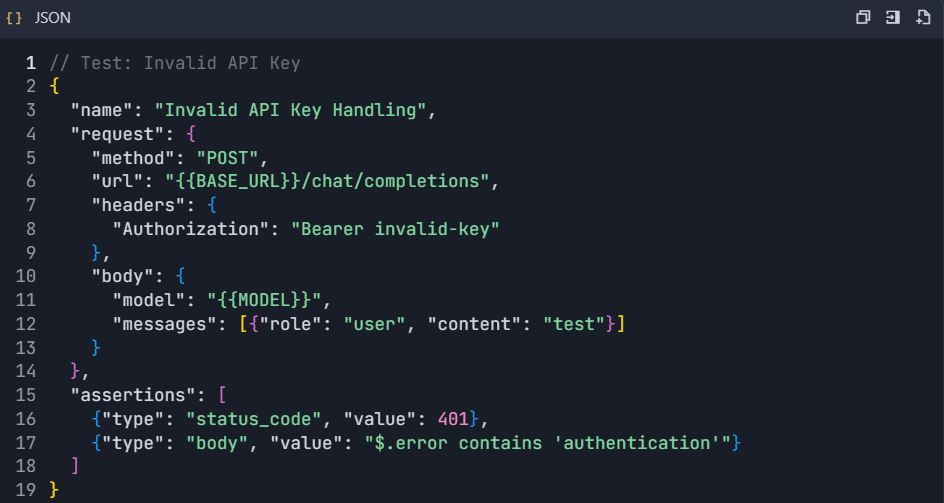

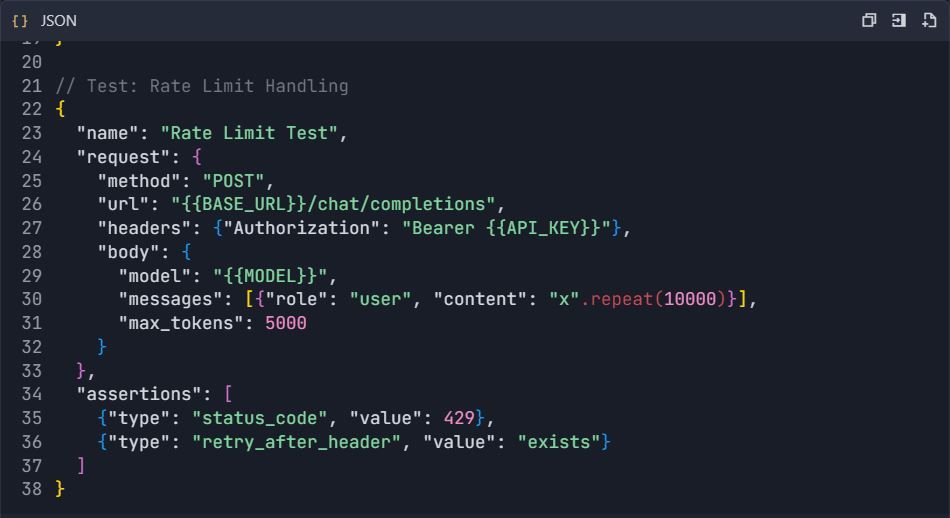

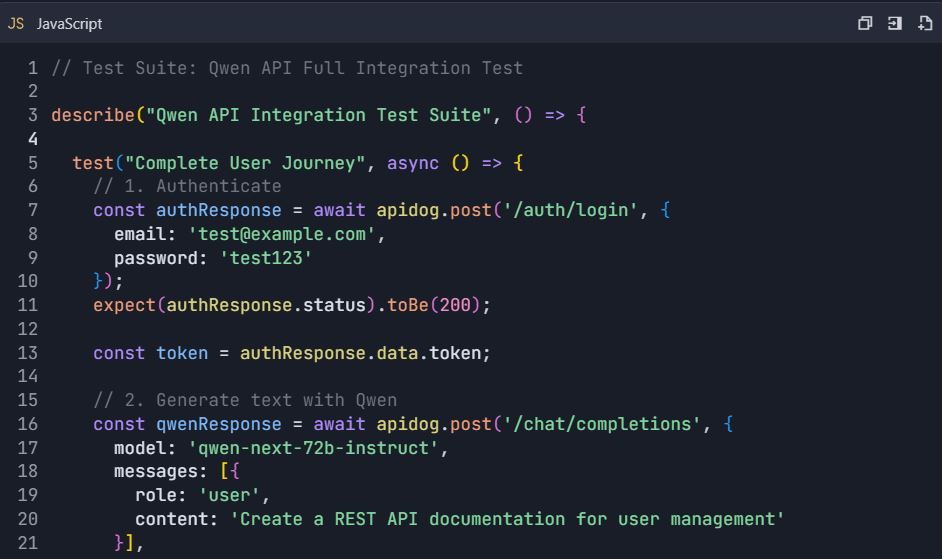

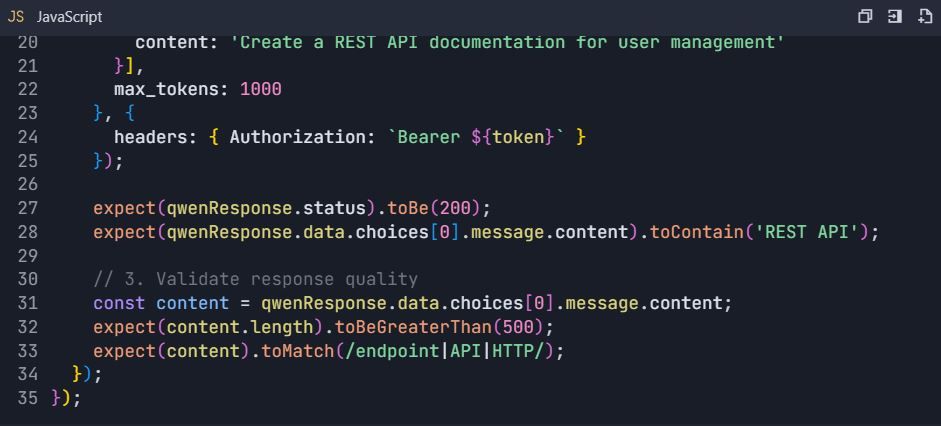

フェーズ4:包括的なテストスイート

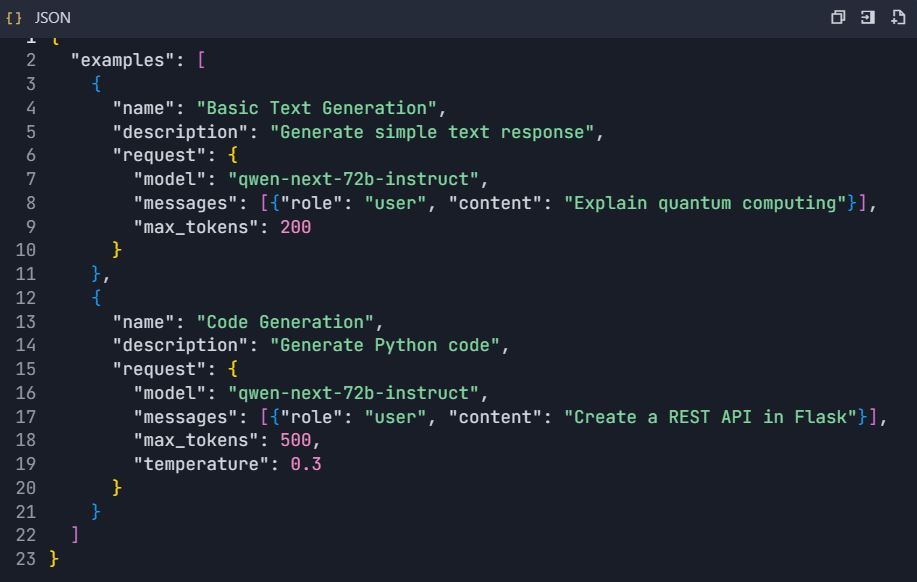

ステップ4:テストシナリオを作成する

4.1 基本的なテキスト生成テスト

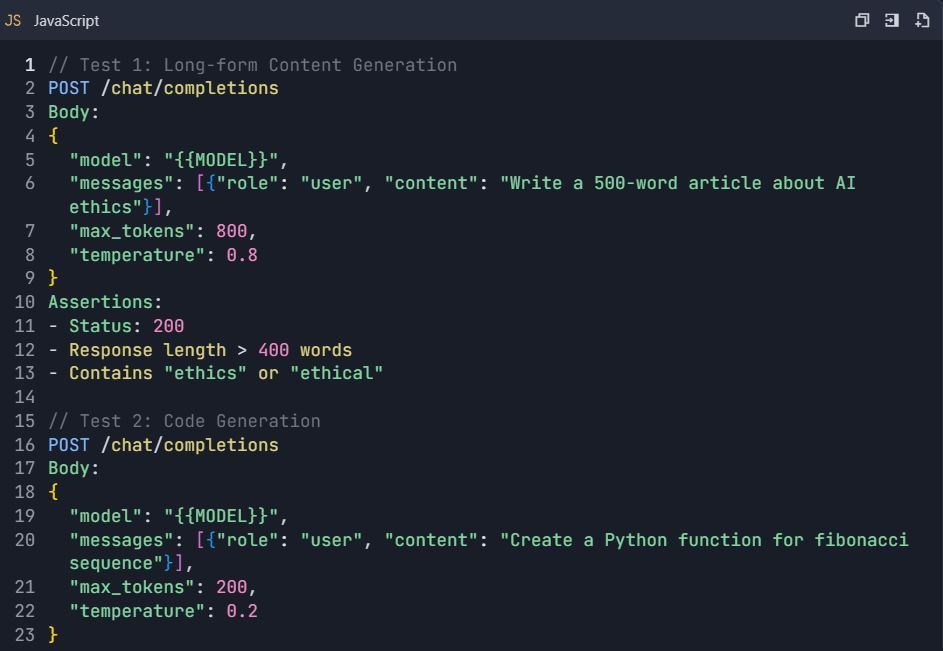

4.2 高度なテストシナリオ

テストスイート: Qwen API包括的テスト

4.3 エラー処理テスト

フェーズ5:ドキュメント生成

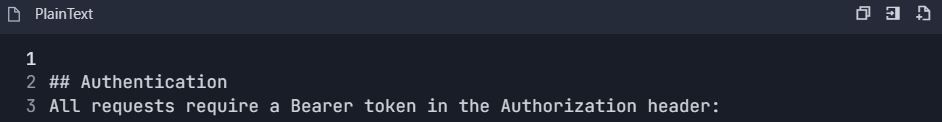

ステップ5:APIドキュメントを自動生成する 5.1 ドキュメント構造を作成する

- プロジェクトに移動 → 「ドキュメント」

- セクションを作成する:

https://dashscope.aliyuncs.com/compatible-mode/v1

認証: Bearer sk-[あなたのAPIキー]

5.2 インタラクティブAPIエクスプローラー

- インタラクティブな例を設定する:

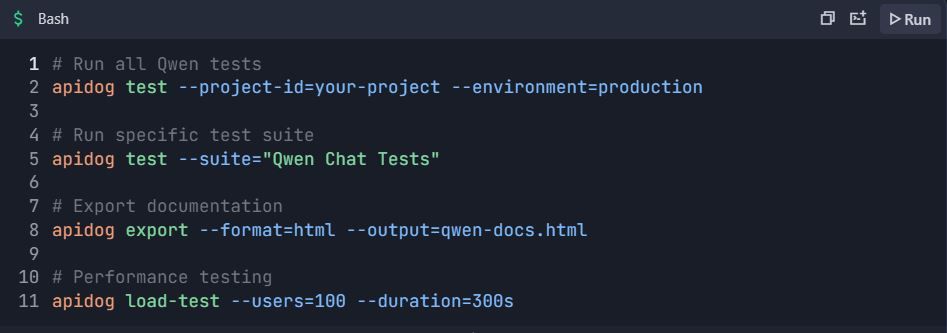

フェーズ6:高度な機能と自動化

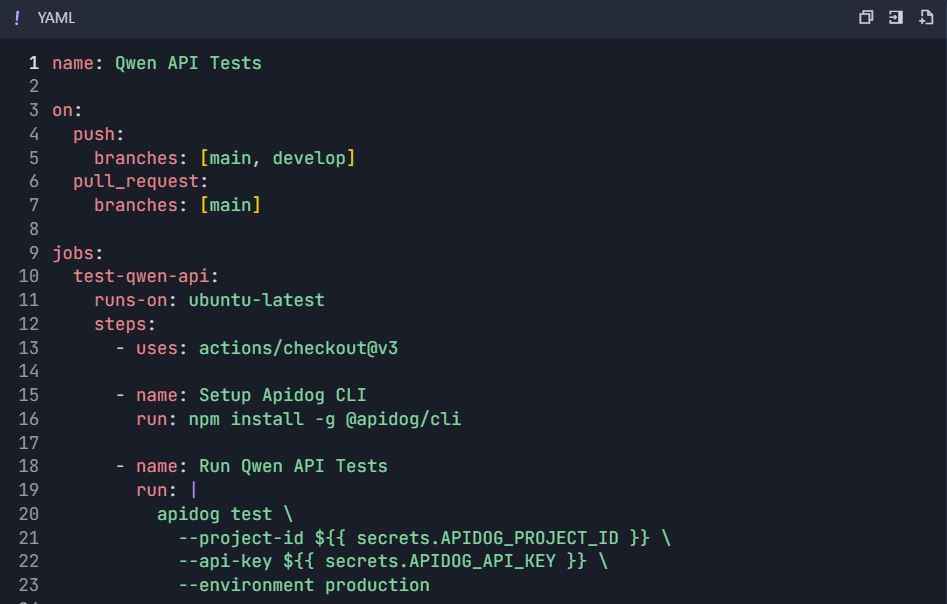

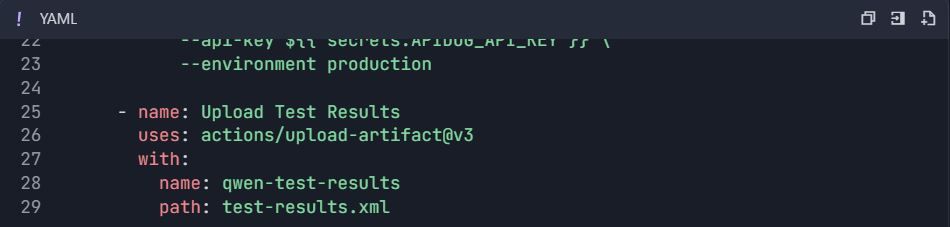

ステップ6:自動テストワークフロー 6.1 CI/CD統合

GitHub Actionsワークフロー ( .github/workflows/qwen-tests.yml ):

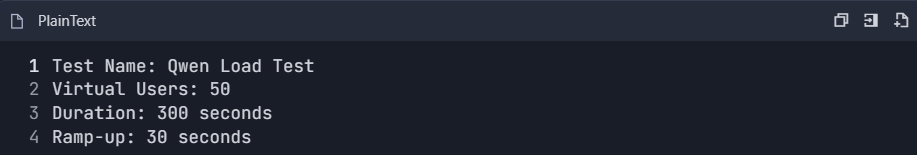

6.2 パフォーマンステスト

- パフォーマンステストスイートを作成する:

2. メトリックを監視する:

- 応答時間 (p50, p95, p99)

- スループット (リクエスト/秒)

- エラー率

- トークン使用効率

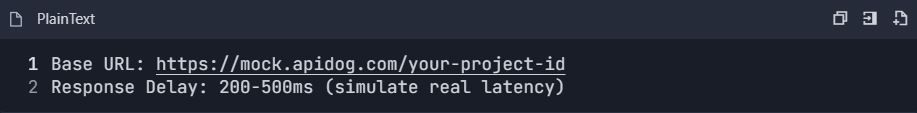

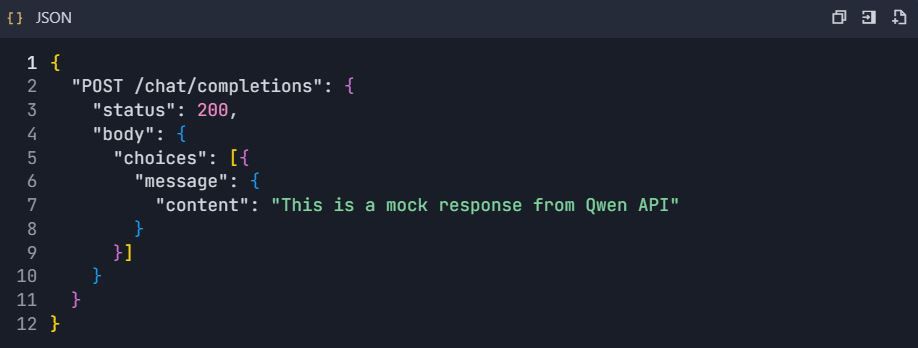

6.3 モックサーバーの設定

- モックサーバーを有効にする:

2. モック応答を設定する:

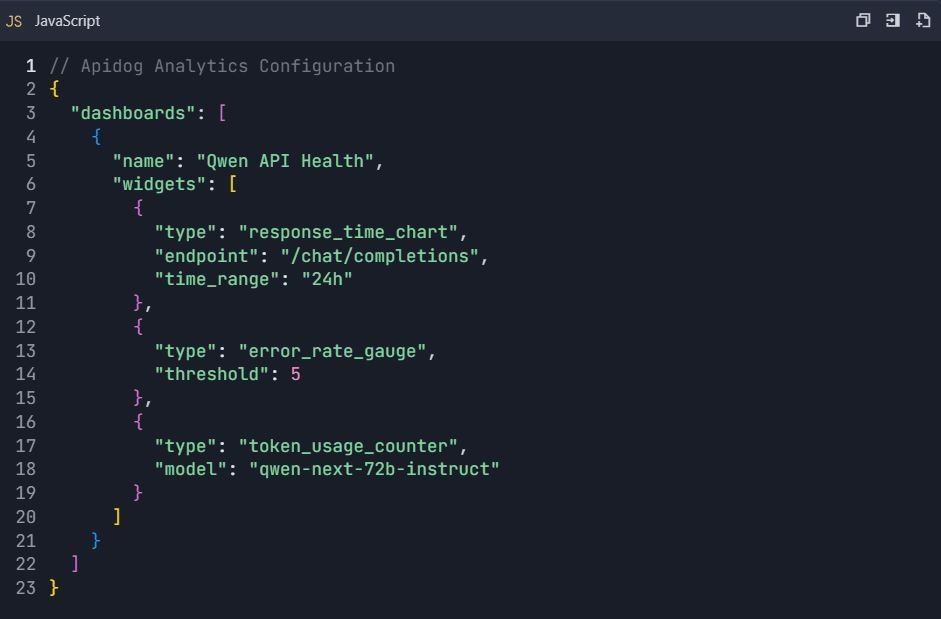

フェーズ7:監視と分析

ステップ7:使用状況分析ダッシュボード

7.1 追跡すべき主要なメトリック

- API使用統計:

- エンドポイントごとのリクエスト数

- トークン消費量

- 応答時間の傾向

- エラー率分析

2. コスト監視:

- 1日のトークン使用量

- リクエストあたりの推定コスト

- 予算アラート

7.2 カスタムダッシュボードの設定

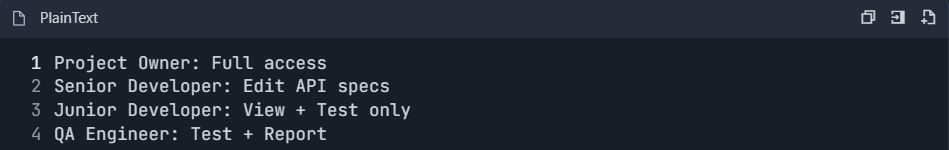

フェーズ8:チームコラボレーションとバージョン管理

ステップ8:チームワークフローの設定

8.1 チームロールの設定

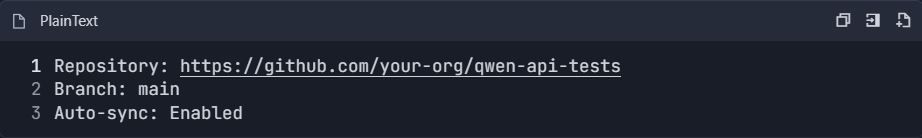

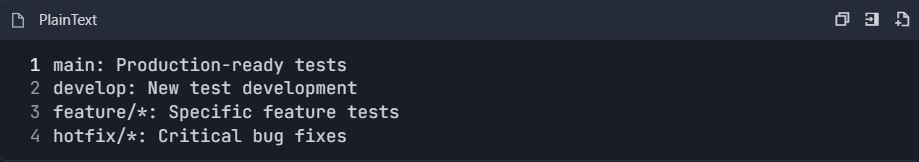

8.2 バージョン管理の統合

- Gitリポジトリに接続する:

2. ブランチ戦略:

完全なテストワークフローの例

エンドツーエンドテストシナリオ

📋 テストコマンド:

この包括的な統合ガイドは、Apidogを使用してQwen APIを効率的にテストし、ドキュメント化するために必要なすべてを提供します。この設定により、堅牢なAPI開発のための自動テスト、パフォーマンス監視、チームコラボレーション、継続的インテグレーションが可能になります。

本番環境におけるQwen Next APIの高度な最適化技術

バッチ処理は、大量のシナリオで効率を最大化します。DashScopeは1回の呼び出しで最大10個のプロンプトを許可し、リクエストを統合してレイテンシのオーバーヘッドを最小限に抑えます。これは、一括要約のようなアプリケーションに適しています。

料金はアクティブなパラメータに関連付けられているため、トークン使用量を注意深く監視してください。コストを節約するために簡潔なプロンプトを作成し、解析可能な出力には`result_format='message'`を使用して、余分な処理をスキップします。

一時的な障害を処理するために、指数関数的バックオフを伴う再試行を実装します。呼び出しをラップする関数は複数回試行し、試行の間に徐々に長くスリープします。これにより、負荷がかかった状態での信頼性が確保されます。

スケーラビリティのために、シンガポールや米国などの地域に分散させます。プロンプトインジェクションを防ぐために、入力をサニタイズし、ホワイトリストに対して検証します。コンプライアンスのために匿名化された応答をログに記録します。

長文コンテキストの場合、データをチャンク化し、呼び出しを連結します。思考バリアントは、拡張されたトークンにわたる一貫性のために構造化されたプロンプトをサポートします。これらの戦略は、堅牢なデプロイメントを保証します。

次の統合を探る:Qwen Nextをウェブアプリケーションに組み込む

Next Integrationとは、Next.jsフレームワークにQwen Nextを組み込み、AI機能のためにサーバーサイドレンダリングを活用することを指します。Next.jsでAPIルートを設定し、Qwenコールをプロキシしてクライアントからキーを隠します。

APIハンドラーでは、DashScope SDKを使用してリクエストを処理し、必要に応じてストリーミング応答を返します。この設定により、オンザフライで生成されるパーソナライズされたページのような動的コンテンツが可能になります。

セッション管理を使用して、認証をサーバー側で処理します。リアルタイム更新には、ストリーミング出力とWebSocketを統合します。Apidogでこれらをテストし、クライアントリクエストをシミュレートします。

パフォーマンスチューニングには、頻繁なクエリのキャッシュが含まれます。Redisを使用して応答を保存し、APIヒットを削減します。この組み合わせにより、インタラクティブなアプリが効率的に動作します。

Qwen Next APIの多言語および長文コンテキスト機能

Qwen Nextは119言語をサポートしており、グローバルなアプリに多用途性をもたらします。正確な翻訳や生成のためにプロンプトで言語を指定します。APIはシームレスに切り替えを処理し、コンテキストを維持します。

長文コンテキストの場合、`max_context_length`を設定することで最大128Kトークンまで拡張できます。これは大規模なドキュメントの分析に優れています。思考連鎖プロンプトは、大量のデータに対する推論を強化します。

ベンチマークでは優れたリコールが示されており、検索エンジンに最適です。データベースと統合してコンテキストを動的に供給します。

Qwen APIデプロイメントのセキュリティベストプラクティス

AWS Secrets Managerのようなボールトでキーを保護します。異常な使用状況を監視し、急増時にアラートを設定します。データを匿名化することで規制に準拠します。

クライアント側のレート制限は悪用を防ぎます。HTTPSで通信を暗号化します。

Qwen Next APIの使用状況の監視とスケーリング

DashScopeダッシュボードは、トークン消費量などのメトリックを追跡します。予算を設定して超過を防ぎます。より高い制限のためにティアをアップグレードすることでスケールします。

自動スケーリングインフラストラクチャはトラフィックに対応します。Kubernetesのようなツールは、Next Integrationをホストするコンテナを管理します。

ケーススタディ:APIを介したQwen Nextの実世界アプリケーション

eコマースでは、Qwen Nextがレコメンデーションエンジンを強化し、ユーザー履歴を分析して提案を行います。APIコールは説明を動的に生成します。

ヘルスケアアプリは、診断補助のために思考バリアントを使用し、レポートを高精度で処理します。

コンテンツプラットフォームは、自動執筆のためにインストラクトモデルを採用し、制作をスケーリングします。

Qwen Nextの将来の展望とアップデート

Alibabaは、より多くのエキスパートやよりきめ細かいルーティングの可能性を秘め、シリーズを進化させ続けています。QwenAI_Plus Xアカウントのような公式チャネルを通じて最新情報を入手してください。

APIの機能強化には、より優れたツールサポートが含まれる可能性があります。

革新的なソリューションのためのQwen Nextの活用

APIを介したQwen Nextは、比類のない効率性を提供します。セットアップから最適化まで、効果的に実装するためのツールが手に入りました。Apidogを活用して、スムーズなワークフローのために統合を試してみてください。