AI愛好家の皆さん、こんにちは!Open AIが新しいオープンウェイトモデル、GPT-OSS-120Bを発表し、AIコミュニティで大きな話題となっています。Apache 2.0ライセンスの下でリリースされたこの強力なモデルは、推論、コーディング、エージェントタスクのために設計されており、すべて単一のGPUで動作します。このガイドでは、GPT-OSS-120Bが特別な理由、その優れたベンチマーク、手頃な価格、そしてOpenRouter API経由での使用方法について詳しく見ていきます。このオープンソースの逸品を探求し、すぐにコーディングを始めましょう!

最高の生産性で開発チームが協力できる統合されたオールインワンプラットフォームをお探しですか?

Apidogはあなたのすべての要求に応え、Postmanをはるかに手頃な価格で置き換えます!

button

GPT-OSS-120Bとは?

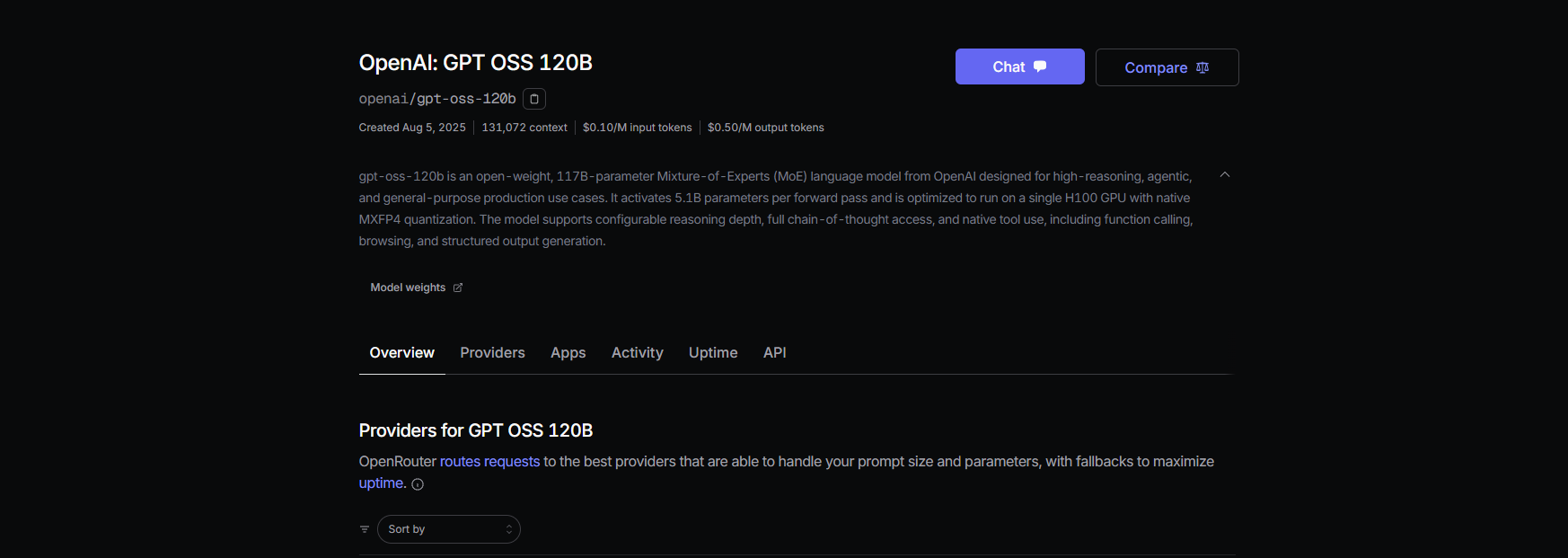

Open AIのGPT-OSS-120Bは、同社の新しいオープンウェイトGPT-OSSシリーズの一部である1170億パラメータの言語モデル(トークンあたり51億がアクティブ)で、より小型のGPT-OSS-20Bと並びます。2025年8月5日にリリースされたこのモデルは、効率のために最適化されたMixture-of-Experts(MoE)モデルであり、単一のNVIDIA H100 GPU、またはMXFP4量子化を使用すれば消費者向けハードウェアでも動作します。複雑な推論、コード生成、ツール使用などのタスク向けに構築されており、300〜400ページに相当する128Kトークンという巨大なコンテキストウィンドウを備えています!Apache 2.0ライセンスの下で、カスタマイズ、デプロイ、さらには商用利用も可能であり、制御とプライバシーを求める開発者や企業にとって夢のような存在です。

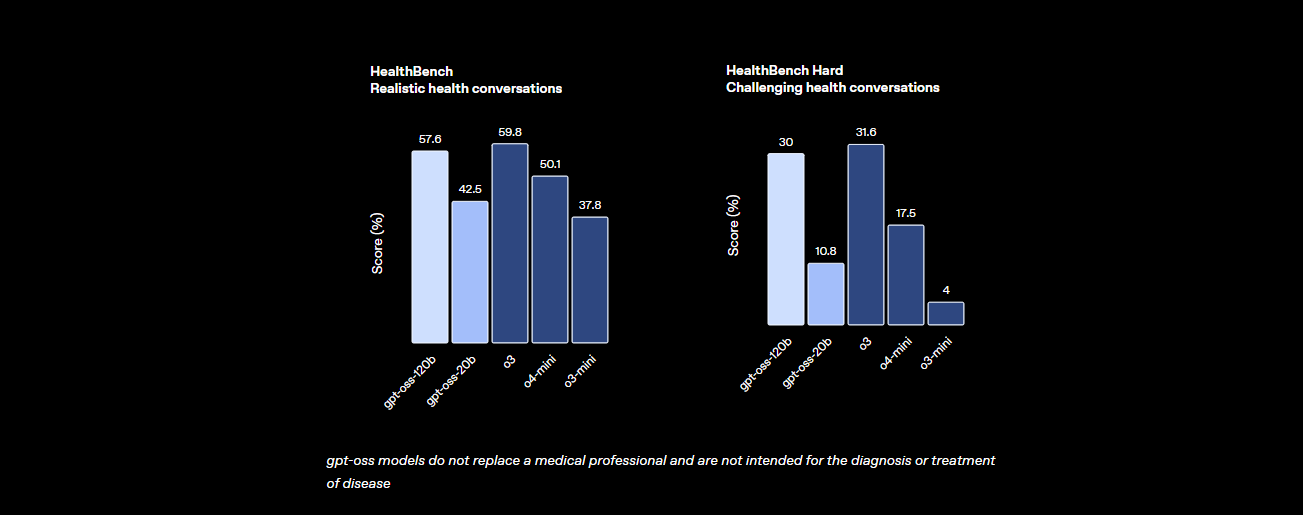

ベンチマーク:GPT-OSS-120Bの性能は?

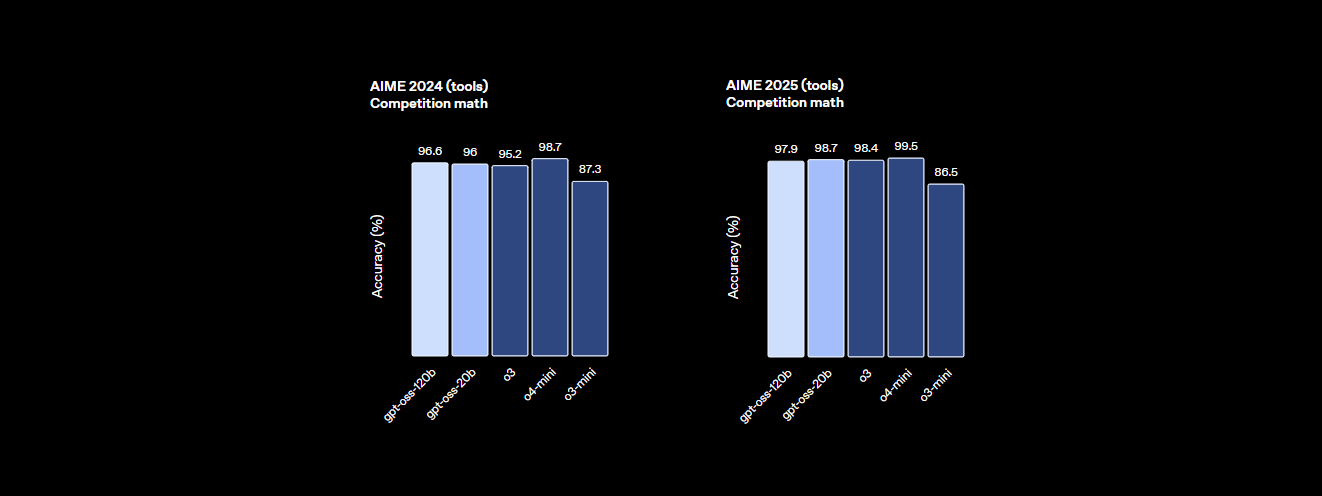

GPT-OSS-120Bは、性能に関して一切手抜きがありません。Open AIのベンチマークは、同社のo4-miniやClaude 3.5 Sonnetのようなプロプライエタリモデルに対しても強力な競争相手であることを示しています。詳細はこちらです。

- 推論能力: MMLU(大規模マルチタスク言語理解)で94.2%を記録し、GPT-4の95.1%にわずかに及ばないものの、AIME数学コンテストでは96.6%を達成し、多くのクローズドモデルを上回っています。

- コーディング能力: Codeforcesでは2622のEloレーティングを誇り、コード生成のHumanEvalでは87.3%の合格率を達成しており、プログラマーにとって最高の相棒です。

- ヘルスケアとツール使用: HealthBenchでは健康関連のクエリでo4-miniを上回り、思考の連鎖(CoT)推論とツール呼び出し機能により、TauBenchのようなエージェントタスクで優れた性能を発揮します。

- 速度: H100 GPUでは1秒あたり45トークンを処理し、Cerebrasのようなプロバイダーは大量のニーズに対応するために最大3,000トークン/秒を達成します。OpenRouterは約500トークン/秒を提供し、多くのクローズドモデルを凌駕しています。

これらの統計は、GPT-OSS-120Bがオープンでカスタマイズ可能でありながら、トップティアのプロプライエタリモデルとほぼ同等の性能を持つことを示しています。数学、コーディング、一般的な問題解決において強力であり、敵対的ファインチューニングによって安全性が組み込まれており、リスクを低く抑えています。

価格:手頃で透明性のある料金体系

GPT-OSS-120Bの最も良い点の一つは?特にプロプライエタリモデルと比較して、費用対効果が高いことです。131Kのコンテキストウィンドウに関する最近のデータに基づいた、主要プロバイダーごとの内訳は以下の通りです。

- ローカルデプロイメント: 自身のハードウェア(例:H100 GPUまたは80GB VRAMセットアップ)で実行すれば、APIコストはゼロです。GMKTEC EVO-X2のセットアップは約2000ユーロで、消費電力は200W未満であり、プライバシーを優先する小規模企業に最適です。

- Baseten: 入力トークン$0.10/M、出力トークン$0.50/M。レイテンシ:0.20秒、スループット:491.1トークン/秒。最大出力:131Kトークン。

- Fireworks: 入力$0.15/M、出力$0.60/M。レイテンシ:0.56秒、スループット:258.9トークン/秒。最大出力:33Kトークン。

- Together: 入力$0.15/M、出力$0.60/M。レイテンシ:0.28秒、スループット:131.1トークン/秒。最大出力:131Kトークン。

- Parasail: 入力$0.15/M、出力$0.60/M(FP4量子化)。レイテンシ:0.40秒、スループット:94.3トークン/秒。最大出力:131Kトークン。

- Groq: 入力$0.15/M、出力$0.75/M。レイテンシ:0.24秒、スループット:1,065トークン/秒。最大出力:33Kトークン。

- Cerebras: 入力$0.25/M、出力$0.69/M。レイテンシ:0.42秒、スループット:1,515トークン/秒。最大出力:33Kトークン。高速処理のニーズに最適で、一部のセットアップでは最大3,000トークン/秒を達成します。

GPT-OSS-120Bを使用すると、GPT-4のコスト(約$20.00/Mトークン)のほんの一部で高性能を得ることができ、GroqやCerebrasのようなプロバイダーはリアルタイムアプリケーション向けに驚異的なスループットを提供します。

OpenRouter経由でClineとGPT-OSS-120Bを使用する方法

コーディングプロジェクトでGPT-OSS-120Bのパワーを活用したいですか?Claude DesktopとClaude CodeはAnthropicのエコシステムに依存しているため、GPT-OSS-120BのようなOpenAIモデルとの直接統合をサポートしていませんが、無料のオープンソースVS Code拡張機能であるClineとOpenRouter APIを介してこのモデルを簡単に使用できます。さらに、Cursorは最近、非Proユーザー向けのBring Your Own Key (BYOK)オプションを制限し、AgentやEditモードなどの機能を月額20ドルのサブスクリプションの背後にロックしました。これにより、ClineはBYOKユーザーにとってより柔軟な代替手段となります。以下に、GPT-OSS-120BをClineおよびOpenRouterでセットアップする方法をステップバイステップで説明します。

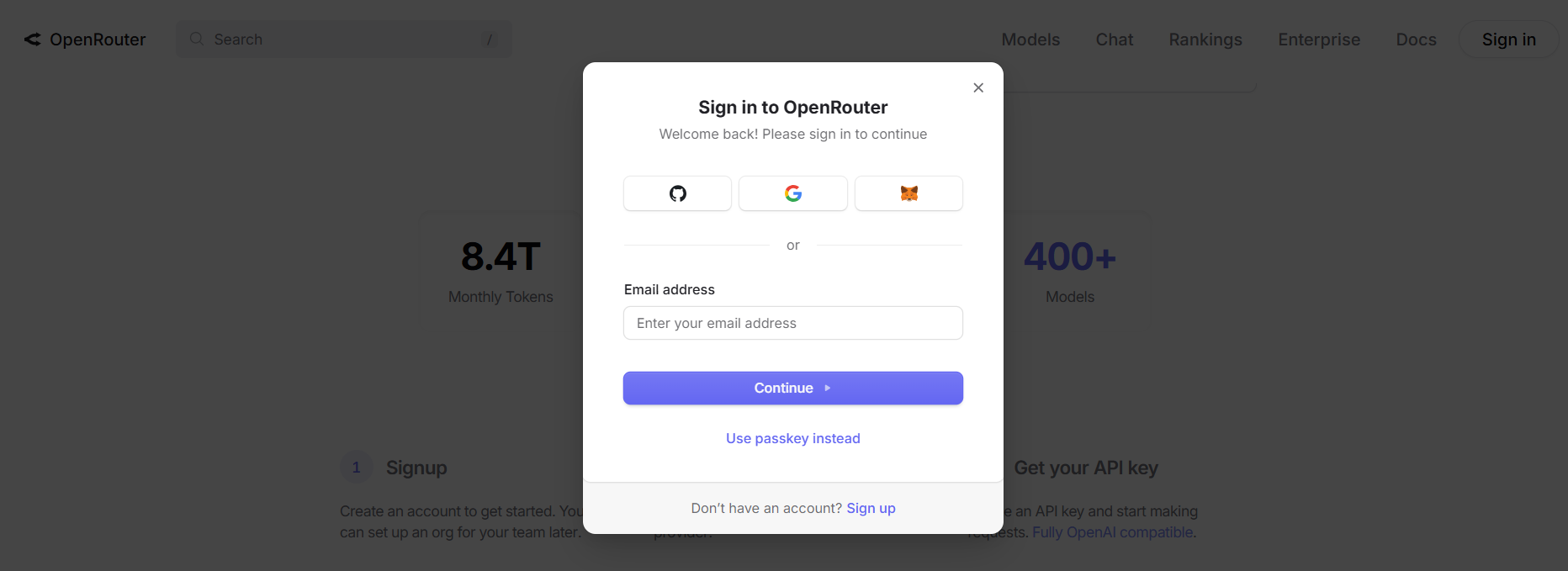

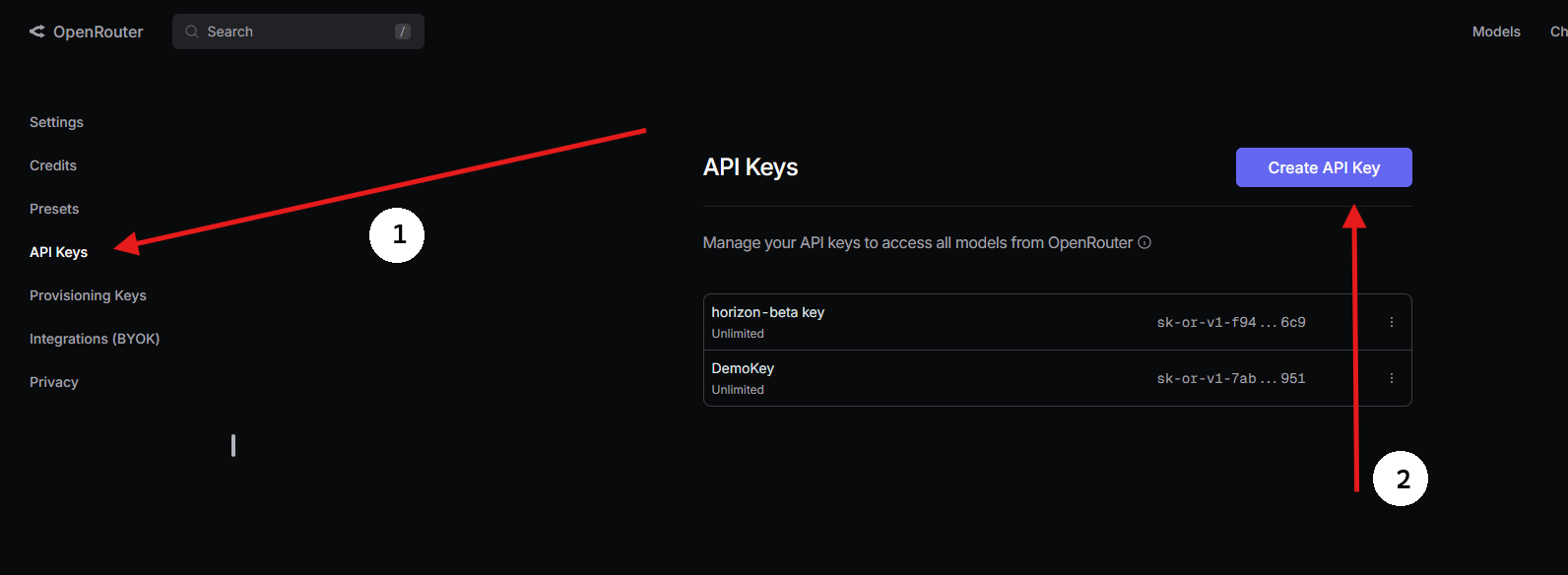

ステップ1:OpenRouter APIキーの取得

- OpenRouterにサインアップ:

- openrouter.aiにアクセスし、GoogleまたはGitHubを使用して無料アカウントを作成します。

2. GPT-OSS-120Bを見つける:

- Modelsタブで「gpt-oss-120b」を検索し、選択します。

3. APIキーを生成する:

- Keysセクションに移動し、Create API Keyをクリックし、名前を付け(例:「GPT-OSS-Cursor」)、コピーします。安全に保存してください。

ステップ2:BYOKでVS CodeにてClineを使用する

無制限のBYOKアクセスには、Cline(オープンソースのVS Code拡張機能)が優れたCursorの代替となります。機能制限なしでOpenRouter経由でGPT-OSS-120Bをサポートしています。セットアップ方法は以下の通りです。

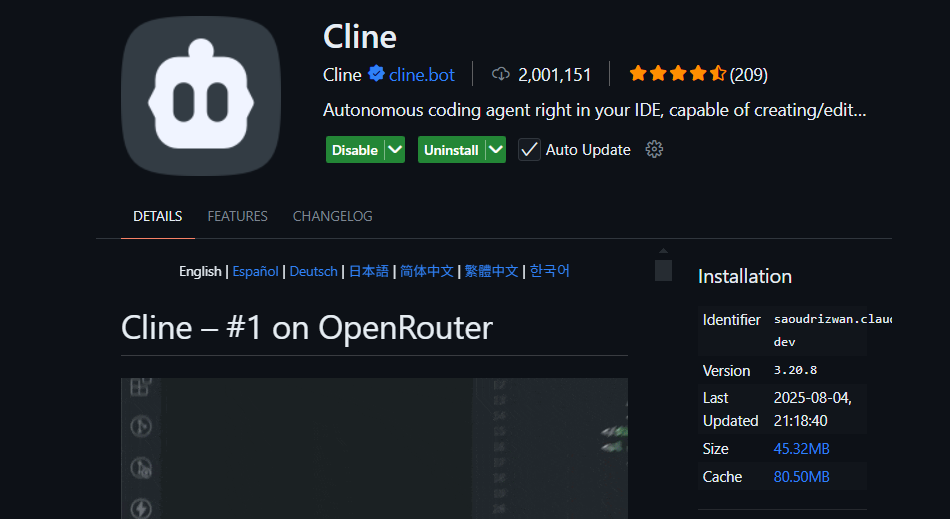

- Clineをインストール:

- VS Code(code.visualstudio.com)を開きます。

- 拡張機能パネル(

Ctrl+Shift+XまたはCmd+Shift+X)に移動します。 - 「Cline」を検索し、インストールします(nickbaumann98による、github.com/cline/cline)。

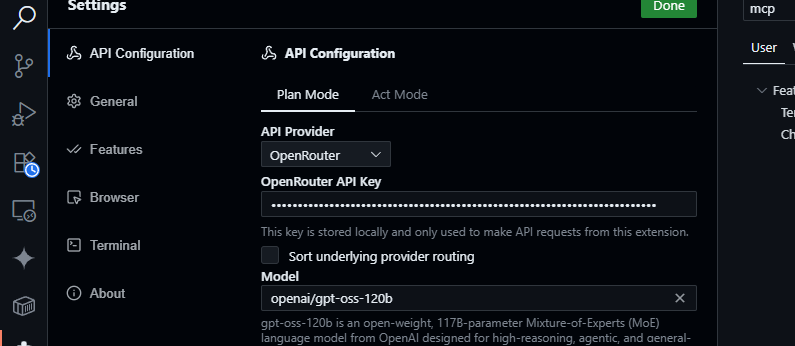

2. OpenRouterを設定:

- Clineパネルを開きます(アクティビティバーのClineアイコンをクリック)。

- Clineパネルの歯車アイコンをクリックします。

- プロバイダーとしてOpenRouterを選択します。

- OpenRouter APIキーを貼り付けます。

- モデルとして

openai/gpt-oss-120bを選択します。

3. 保存とテスト:

- 設定を保存します。Clineチャットパネルで、次を試します。

JSONデータをパースするJavaScript関数を生成してください。

- 次のような応答が期待されます。

function parseJSON(data) {

try {

return JSON.parse(data);

} catch (e) {

console.error("Invalid JSON:", e.message);

return null;

}

}

- コードベースのクエリをテストします。

src/api/server.jsを要約してください

- Clineはプロジェクトを分析し、GPT-OSS-120Bの128Kコンテキストウィンドウを活用して要約を返します。

CursorやClaudeよりもClineを選ぶ理由

- Claudeとの統合なし: Claude DesktopとClaude CodeはAnthropicのモデル(例:Claude 3.5 Sonnet)にロックされており、エコシステムの制限によりGPT-OSS-120BのようなOpenAIモデルをサポートしていません。

- CursorのBYOK制限: Cursorが最近非Proユーザー向けのBYOKを禁止したことにより、有効なOpenRouter APIキーを持っていても、月額20ドルのサブスクリプションなしではAgentまたはEditモードにアクセスできません。Clineにはそのような制限はなく、APIキーがあれば無料で全機能にアクセスできます。

- プライバシーと制御: ClineはOpenRouterに直接リクエストを送信し、サードパーティのサーバー(CursorのAWSルーティングとは異なり)をバイパスするため、プライバシーが強化されます。

トラブルシューティングのヒント

- APIキーが無効ですか? OpenRouterのダッシュボードでキーを確認し、アクティブであることを確認してください。

- モデルが利用できませんか? OpenRouterのモデルリストでopenai/gpt-oss-120bを確認してください。見つからない場合は、Fireworks AIのようなプロバイダーを試すか、OpenRouterのサポートに連絡してください。

- 応答が遅いですか? インターネット接続が安定していることを確認してください。より高速なパフォーマンスが必要な場合は、GPT-OSS-20Bのような軽量モデルを検討してください。

- Clineのエラーですか? 拡張機能パネルからClineを更新し、VS Codeの出力パネルでログを確認してください。

GPT-OSS-120Bを使用する理由

GPT-OSS-120Bモデルは、開発者や企業にとって画期的な存在であり、パフォーマンス、柔軟性、費用対効果の魅力的な組み合わせを提供します。際立つ理由は以下の通りです。

- オープンソースの自由: Apache 2.0ライセンスの下で、GPT-OSS-120Bを制限なくファインチューニング、デプロイ、または商用利用でき、AIワークフローを完全に制御できます。

- コスト削減: 単一のH100 GPUまたは消費者向けハードウェア(80GB VRAM)でローカルに実行すれば、APIコストはゼロです。OpenRouter経由では、入力トークン約$0.50/M、出力トークン約$2.00/Mと非常に競争力のある価格設定で、GPT-4の約$20.00/Mトークンのごく一部であり、ヘビーユーザーには最大90%の節約を提供します。Groq(入力$0.15/M、出力$0.75/M)やCerebras(入力$0.25/M、出力$0.69/M)のような他のプロバイダーもコストを低く抑えています。

- パフォーマンス: OpenAIのo4-miniとほぼ同等の性能を達成し、MMLUで94.2%、AIME数学で96.6%、コーディングのHumanEvalで87.3%を記録しています。128Kトークンのコンテキストウィンドウ(300〜400ページ)は、大規模なコードベースやドキュメントを容易に処理します。

- 思考の連鎖(CoT)推論: モデルの完全なCoT透過性により、その段階的な推論を見ることができ、出力のデバッグやバイアス、エラーの検出が容易になります。複雑な数学やコーディングのようなタスクでは、システムプロンプト(例:「Reasoning: high」)を介して推論の労力(低、中、高)を調整でき、速度と深さのバランスを取ることができます。この教師なしCoT設計は、研究者が直接的な監視なしにモデルの動作を監視するのに役立ち、信頼性と安全性を高めます。

- エージェント機能: ウェブブラウジングやPythonコード実行のようなツール使用のネイティブサポートにより、エージェントワークフローに最適です。データ集約や自動化のような複雑なタスクのために、複数のツール呼び出し(例:デモで28回の連続したウェブ検索)を連鎖させることができます。

- プライバシー: オンプレミス(例:Dell Enterprise Hub経由)でホストすれば、データの完全な制御が可能であり、企業やプライバシーを重視するユーザーに最適です。

- 柔軟性: OpenRouter、Fireworks AI、Cerebras、そしてOllamaやLM Studioのようなローカルセットアップと互換性があり、RTX GPUからApple Siliconまで多様なハードウェアで動作します。

Xでのコミュニティの話題では、その速度(Cerebrasで最大1,515トークン/秒)とコーディング能力が強調されており、開発者はマルチファイルプロジェクトを処理する能力と、カスタマイズ可能なオープンウェイトの性質を高く評価しています。AIエージェントを構築する場合でも、ニッチなタスクのためにファインチューニングする場合でも、GPT-OSS-120Bは比類のない価値を提供します。

結論

Open AIのGPT-OSS-120Bは、トップティアのパフォーマンスと費用対効果の高いデプロイメントを融合させた、革新的なオープンウェイトモデルです。そのベンチマークはプロプライエタリモデルに匹敵し、価格は手頃で、OpenRouterのAPIを介してCursorやClineと簡単に統合できます。コーディング、デバッグ、複雑な問題の推論など、どのような場合でもこのモデルは役立ちます。ぜひ試して、128Kのコンテキストウィンドウを実験し、コメントであなたの素晴らしいユースケースを教えてください—楽しみにしています!

詳細については、github.com/openai/gpt-ossのリポジトリまたはOpen AIの発表(openai.com)をご確認ください。

最高の生産性で開発チームが協力できる統合されたオールインワンプラットフォームをお探しですか?

Apidogはあなたのすべての要求に応え、Postmanをはるかに手頃な価格で置き換えます!

button