開発者は常に、コーディングタスクを効率化する高度なツールを求めており、OpenAIはGPT-5-Codex-Miniでそれに応えます。このモデルは、GPT-5-Codexシリーズのコンパクトな進化版であり、エージェント型コーディングワークフロー向けに費用対効果の高いパフォーマンスを提供します。エンジニアは、コード生成、デバッグ、リポジトリ管理といったタスクを、重要な機能を犠牲にすることなく処理するためにこれを統合します。ただし、そのAPIにアクセスするには特定の手順が必要であり、このガイドで詳細に説明します。

button

従来のコーディングアシスタントからAI駆動型への移行は大きな変化を意味しますが、セットアップのわずかな調整が生産性に大きな改善をもたらします。したがって、モデルの基盤を理解することが極めて重要です。

GPT-5-Codex-Miniの理解:機能とアーキテクチャ

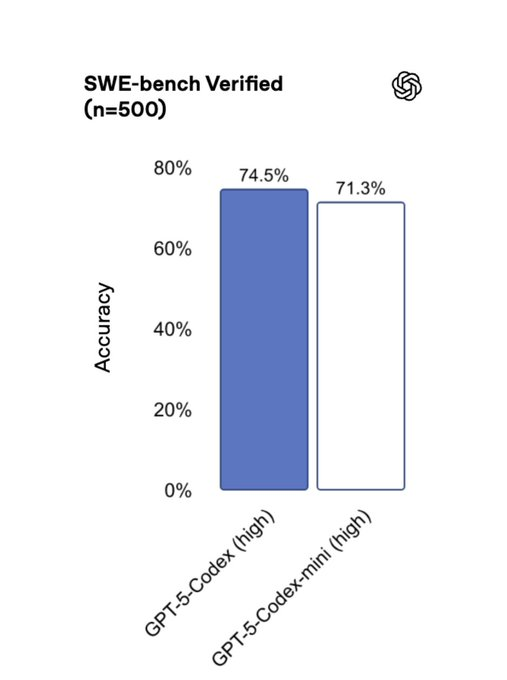

OpenAIのエンジニアは、明確に定義されたコーディングシナリオにおいて効率性を優先し、GPT-5-Codexの軽量版としてGPT-5-Codex-Miniを設計しました。このモデルは、フロントエンドコードの生成、大規模リポジトリのデバッグ、Python、JavaScript、Goなどの言語でのリファクタリングに優れています。より大規模なモデルとは異なり、GPT-5-Codex-Miniは消費リソースが少なく、クレジット割り当てあたりの使用量を約4倍に増やすことができます。

技術的には、このアーキテクチャはトランスフォーマーベースのニューラルネットワーク上に構築されており、トークン効率のために最適化されています。シンプルなクエリには迅速に、しかし複数の反復を伴う複雑なタスクには時間をかけて、動的な推論時間で入力を処理します。例えば、3,000行のコードベースをリファクタリングする場合、モデルは実装を繰り返し、テストを実行し、依存関係を自律的に検証します。

GPT-5-Codex-Miniは、Codex CLIやIDE拡張機能などのツールとシームレスに統合されます。開発者はVS CodeやCursorでこれをアクティブ化し、ローカルで変更をプレビューしたり、選択したコードスニペットを活用してコンテキストに応じた提案を得ることができます。このアプローチにより、プロンプトの長さが短縮され、応答時間が加速されるため、チームはワークフローの継続性を維持できます。

ただし、ユーザーはわずかな機能のトレードオフに注意する必要があります。ほとんどのエージェント型タスクを効果的に処理できますが、複雑な多言語統合には完全なGPT-5-Codexへの切り替えが必要になる場合があります。したがって、プロジェクトのニーズを事前に評価することで、最適なモデル選択が保証されます。

GPT-5-Codex-Mini APIへのアクセス要件

GPT-5-Codex-Mini APIにアクセスするには、慎重な準備が必要です。まず、開発者はOpenAIアカウントのステータスを確認します。OpenAIは、利用ティア(1から5まで)を通じてアクセスを構成しており、GPT-5-Codex-Miniのようなモデルはすべてのレベルで利用可能ですが、高度な機能には組織の検証が必要です。

OpenAIアカウントをお持ちでない場合は、まずアカウントを作成します。OpenAIプラットフォームにアクセスし、有効なメールアドレスを使用してサインアップしてください。次に、ビジネス詳細または身分証明書を提出する組織検証プロセスを完了します。この手順により、Responses APIでのストリーミング機能を含む、検証済みモデルへのアクセスが解除されます。

さらに、ダッシュボードからAPIキーを取得します。ログインし、APIキーセクションにアクセスして新しいキーを生成してください。すべてのリクエストを認証するために、これを安全に保管してください。このキーがないと、エンドポイントにアクセスできません。

さらに、開発環境が必要なライブラリをサポートしていることを確認してください。pipを介してOpenAI Python SDKをインストールします: pip install openai。このパッケージは、認証とペイロードのフォーマットを自動的に処理し、API呼び出しを容易にします。

ハードウェア要件に移行すると、特にバッチ処理の場合、安定したインターネット接続と十分な計算リソースが不可欠であることがわかります。GPT-5-Codex-Miniは効率のために最適化されていますが、大量の使用にはクラウドベースのセットアップが有利です。

OpenAIプランへのサインアップとAPIアクセスの有効化

OpenAIは、GPT-5-Codex-Miniの利用可能性に影響を与えるティア制のプランを提供しています。ChatGPT Plusの加入者は基本的なアクセス権を得ており、時折のコーディングセッションに適しています。しかし、広範な使用のためには、Pro、Business、またはEnterpriseプランにアップグレードしてください。これらは、最近50%増加した高いレート制限と優先処理を提供します。

APIアクセスを有効にするには、ChatGPTアカウントを開発者プラットフォームにリンクします。資格情報でサインインすると、システムが自動的に権限を同期します。APIのみのユーザーは、含まれる制限を超過した場合、直接クレジットを購入してください。

さらに、ベータプログラムのアナウンスを監視してください。GPT-5-Codex-MiniのAPIサポートは最近展開されたため、OpenAIコミュニティフォーラムを通じてウェイティングリストに参加してください。開発者プレビューに参加して早期アクセスを獲得し、将来のイテレーションを形作るフィードバックを提供しましょう。

有効化されたら、接続性をテストします。/modelsエンドポイントに簡単なリクエストを送信して利用可能なモデルをリストアップし、GPT-5-Codex-Miniが表示されることを確認します。この検証ステップは、後の統合問題を防止します。

したがって、プロジェクトの規模に合わせてプランを調整することで、価値が最大化されます。上位ティアではクレジットが拡大され、レイテンシが削減されるためです。

OpenAI APIキーの生成と管理

セキュリティはAPIインタラクションの基礎を形成するため、責任を持ってキーを生成してください。OpenAIダッシュボードから「API keys」を選択し、「Create new secret key」をクリックします。管理しやすいように、「GPT-5-Codex-Mini-Project」のように説明的な名前を付けましょう。

キーはハードコーディングするのではなく、環境変数に保存してください。Pythonでは、os.environ['OPENAI_API_KEY']を使用して動的にロードします。この方法は、露出のリスクを軽減します。

さらに、キーを定期的にローテーションしてください。OpenAIは、アクティブなセッションを中断することなく古いキーを取り消すことを許可しており、セキュリティプロトコルへの準拠を保証します。

さらに、アプリケーションにレート制限を実装してください。ダッシュボードを通じて使用状況を監視し、ティアを超過して一時的な制限がトリガーされるのを避けてください。

ツールに移行すると、Apidogはキー管理を簡素化します。その安全なボールトは資格情報を保存し、テスト環境での認証を自動化します。これにより、開発者は管理タスクではなくコーディングに集中できます。

GPT-5-Codex-Miniを開発ワークフローに統合する

統合は、適切なエンドポイントの選択から始まります。一般的なクエリにはChat Completions APIを、エージェント型タスクにはResponses APIを使用します。リクエストボディのモデルパラメータとして「gpt-5-codex-mini」を指定します。

import openai

openai.api_key = os.getenv('OPENAI_API_KEY')

response = openai.ChatCompletion.create(

model="gpt-5-codex-mini",

messages=[

{"role": "system", "content": "You are a helpful coding assistant."},

{"role": "user", "content": "Write a Python function to sort a list using quicksort."}

]

)

print(response.choices[0].message['content'])

この呼び出しは、モデルの効率性を活用して最適化されたコードを返します。

さらに、ファイルからのコンテキストを取り込みます。コードスニペットや図をプロンプトに添付することで、デバッグシナリオの精度を高めます。

ただし、プロンプトは簡潔に最適化してください。GPT-5-Codex-Miniは簡潔な指示で最高のパフォーマンスを発揮し、トークン消費量を削減します。

さらに、リアルタイムアプリケーション向けに非同期でレスポンスを処理します。ストリーミングモードを使用して部分的な出力を受信することで、IDE統合におけるユーザーエクスペリエンスを向上させます。

結果として、反復的なテストによって統合が洗練され、ユースケースに固有のパフォーマンスのニュアンスが明らかになります。

Apidogを使用してGPT-5-Codex-Mini API呼び出しをテストおよび最適化する

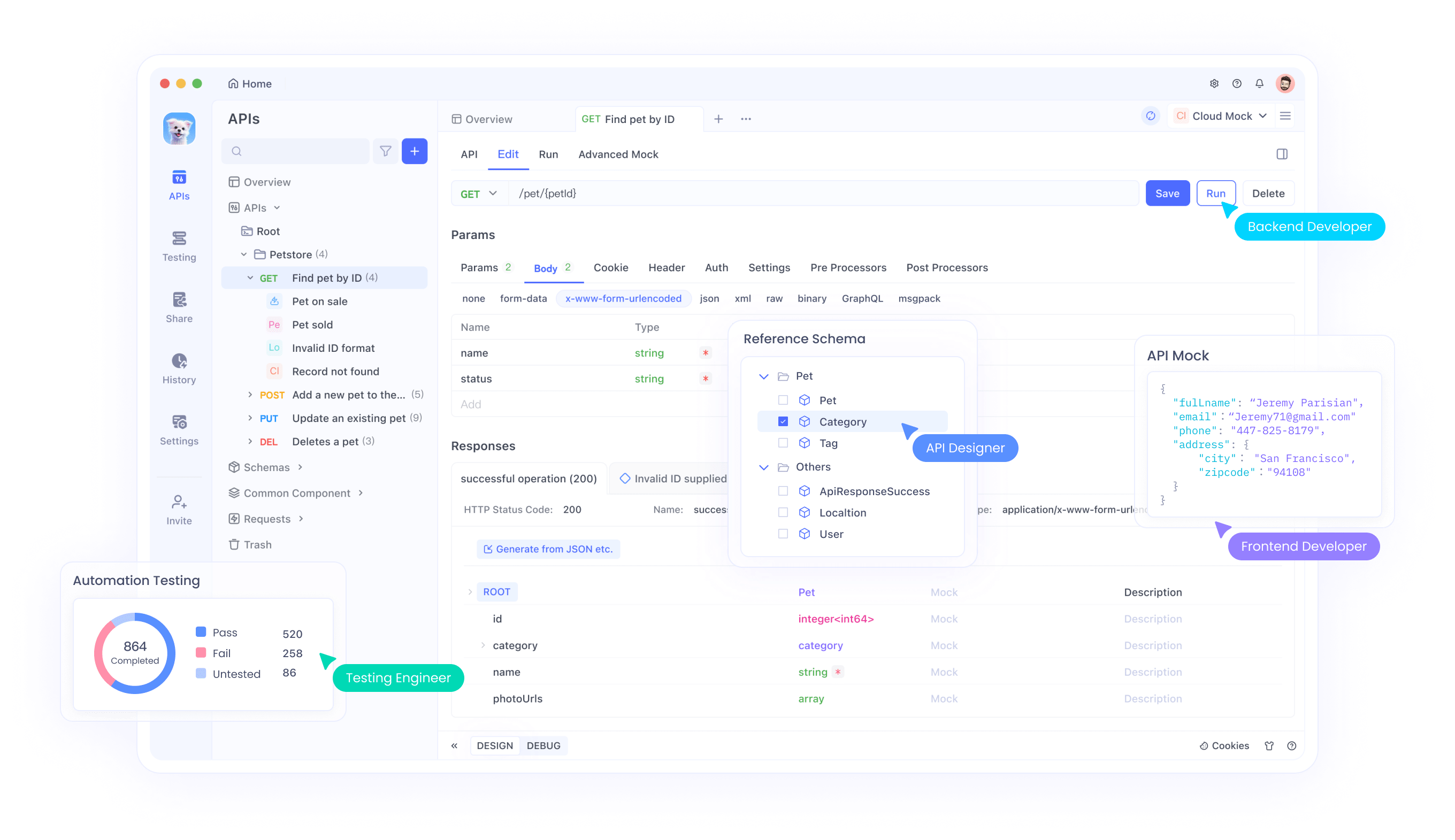

ApidogはAPIテストの強力な味方として登場します。無料でダウンロードし、OpenAIのAPI仕様をインポートしてください。GPT-5-Codex-Miniエンドポイントのコレクションを作成し、動的パラメータ用の変数を含むリクエストを定義します。

エンジニアは、モックリクエストを送信してシナリオをシミュレートします。例えば、呼び出しをバッチ処理することでレート制限をテストし、応答時間とエラー率を分析します。

さらに、Apidogのコラボレーション機能により、チームはテストスイートを共有でき、プロジェクト全体で一貫した統合を保証します。

最適化に移行すると、その分析機能を使用してボトルネックを特定します。トークン使用量を監視し、それに応じてプロンプトを調整することで、クレジットの寿命を延ばします。

さらに、ApidogをCI/CDパイプラインと統合します。API変更のテストを自動化し、非推奨化を早期に検出します。

このように、Apidogは生のAPIアクセスを効率的なワークフローに変え、GPT-5-Codex-Miniの利点を増幅させます。

GPT-5-Codex-Miniを用いたプロンプトエンジニアリングのベストプラクティス

効果的なプロンプトは優れた出力を引き出します。ガイドラインにはシステム、タスクにはユーザーといった明確な役割で構造化してください。「PEP 8標準に従う」のように、スタイルを導く例を含めます。

さらに、複雑なタスクを段階に分割します。モデルに順次推論するよう指示することで、リファクタリングの精度を向上させます。

ただし、プロンプトを過負荷にしないようにしてください。GPT-5-Codex-Miniは焦点を絞った入力で最高のパフォーマンスを発揮するため、大きなリクエストは分割します。

さらに、ツール統合を活用します。動的な応答のために、プロンプト内でウェブ検索やコード実行を有効にします。

結果として、定期的な実験が技術を洗練させ、モデルの強みに適応させます。

レート制限の処理と使用量のスケーリング

OpenAIは、公正なアクセスを確保するためにレート制限を設けています。Plusユーザーはベースラインのクォータを利用でき、Proティアは優先キューを提供します。

残りのリクエスト数を報告するAPIヘッダーを介して使用状況を監視します。再試行には指数関数的バックオフを実装し、BANのリスクを防ぎます。

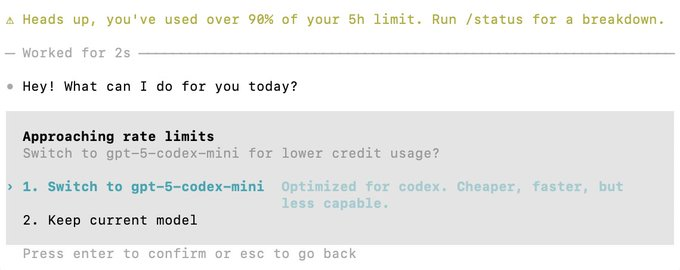

さらに、制限に近づいたらGPT-5-Codex-Miniに切り替えることで、中断なくセッションを延長できます。

スケーリングに移行すると、大量のアプリでは複数のキーに呼び出しを分散させます。エンタープライズプランはこれをネイティブにサポートしています。

このように、積極的な管理がパフォーマンスを維持し、成長をサポートします。

結論:GPT-5-Codex-Miniから最大の価値を引き出す

GPT-5-Codex-Miniにアクセスし統合することで、コーディングワークフローが変革されます。その力を効率的に活用するために、これらの手順に従ってください。

Apidogのようなツールは体験を向上させます。今すぐ無料でダウンロードしてください。

最終的に、一貫した適用が深い生産性向上をもたらします。

button