長年にわたり、高品質な動画コンテンツの作成は、撮影、編集、サウンドデザイン、アニメーションといった専門スキルを必要とする、複雑で時間のかかり、しばしば高価な作業でした。生成AI、特に動画分野の生成AIは、これらの障壁を大幅に下げるでしょう。説得力のあるBロール映像を生成したり、ダイナミックなソーシャルメディア向けアニメーションを作成したり、あるいは短い映画のようなシーケンスでさえ、テキスト記述や静止画からすべて生成できることを想像してみてください。これがVeo 3のようなモデルが約束するものです。

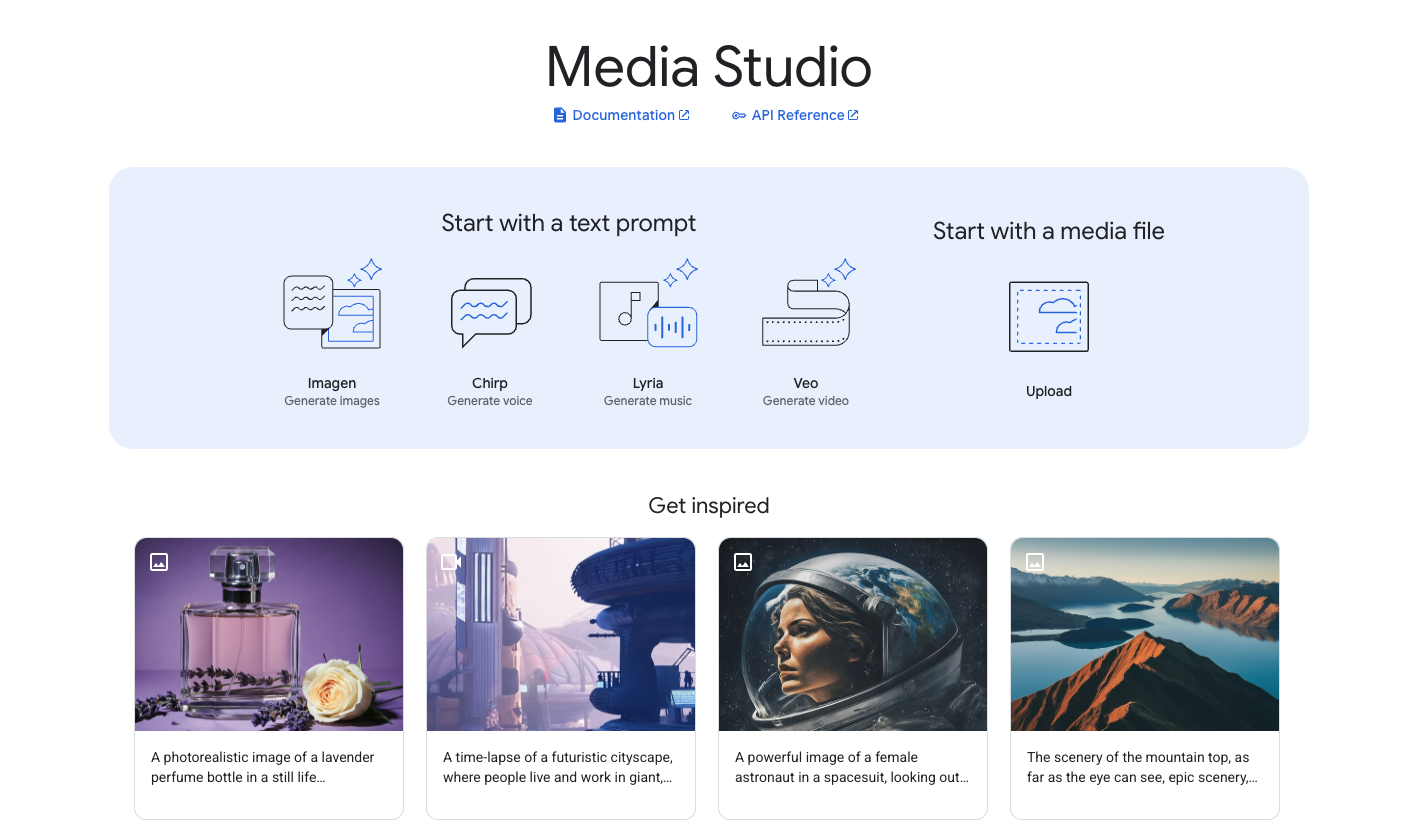

GoogleはAIの研究開発に大きく貢献しており、Vertex AIを通じて利用可能なモデルの継続的な進化に、生成メディアへのコミットメントが明確に表れています。Vertex AIは統合された機械学習プラットフォームとして機能し、DeepMindを含むGoogleの最先端AIモデルへのアクセスを提供し、ユーザーがMLアプリケーションを簡単に構築、デプロイ、スケーリングできるようにします。Veo 3、Imagen 4、Lyria 2の導入は、Vertex AIがクリエイティブAIの強力な基盤であることをさらに強固にしています。

最大限の生産性で開発チームが共同作業できる統合されたオールインワンプラットフォームをお探しですか?

Apidogはあなたのすべての要求に応え、Postmanをはるかに手頃な価格で置き換えます!

Veo 3の紹介:AI動画生成における次の飛躍

Google DeepMindによって開発されたVeo 3は、Googleの動画生成技術における最新の進歩を表しています。これは、視覚的に印象的なだけでなく、聴覚的な詳細も豊かな高品質動画をユーザーが生成できるようにすることを目指しています。Veo 3で発表された主な機能強化と機能は以下の通りです。

- 動画品質の向上:Veo 3は、テキストおよび画像プロンプトの両方から生成される際に、優れた品質の動画を生成するように設計されています。これは、よりリアルなテクスチャ、より優れたモーションの一貫性、複雑なプロンプトの詳細へのより忠実な順守を意味します。このモデルは、複雑なプロンプトの詳細を処理し、微妙なテキスト記述を説得力のある視覚的な物語に変換することができます。

- 音声生成の統合:大きな前進は、Veo 3が対話やナレーションなどの音声を生成された動画に直接組み込む能力です。この機能は、ストーリーテリング、マーケティングコンテンツ、教育資料に広大な可能性を開き、基本的な音声のために別途オーディオ制作ワークフローを必要とすることなく、作成者が物語の深さをさらに加えることを可能にします。

Google Veo 3のリアリズムが昨日インターネットを席巻しました。

— Min Choi (@minchoi) May 22, 2025

これは100% AIです。

驚くべき10の例:

1. 実際には行われなかった街頭インタビュー pic.twitter.com/qdxZVhOO3G

これらの機能の潜在的な影響は、早期導入者によって既に認識されています。デジタル決済のリーダーであるKlarnaは、Vertex AI上のVeo(およびImagen)を活用して、コンテンツ作成の効率を向上させています。彼らは、BロールからYouTubeバンパーに至るアセットの制作タイムラインが大幅に短縮されたことに注目しています。Klarnaのデジタルエクスペリエンス&成長責任者であるジャスティン・トーマス氏は、この変革について次のように述べています。「VeoとImagenを使用することで、かつて時間のかかっていた制作プロセスを、コンテンツ作成を迅速にスケールできる、迅速で効率的なタスクに変えました…かつて8週間かかっていたものが、今ではわずか8時間で済み、大幅なコスト削減につながっています。」

Vertex AIでGoogle Veo APIを使用する方法

GoogleのVeoモデルはVertex AIでアクセス可能であり、テキストまたは画像プロンプトから動画を生成できます。Google CloudコンソールまたはVertex AI APIへのリクエストを通じてVeoとやり取りできます。このガイドでは、主にPython用のGen AI SDKとREST呼び出しを使用したAPIの使用に焦点を当てます。

方法1:Google FlowでGoogle Veo 3を使用する

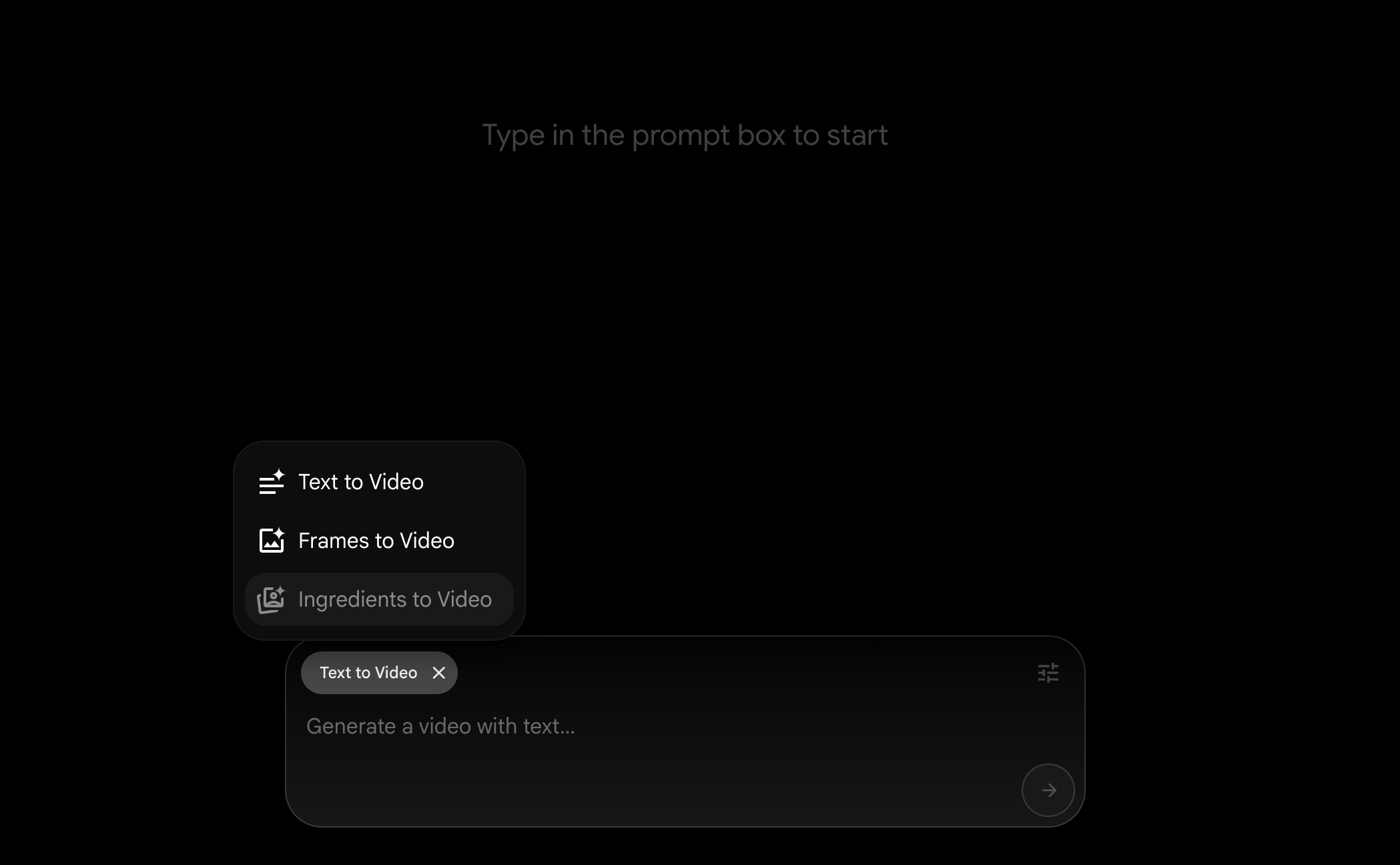

Googleは、Googleの最も高度なモデルであるVeo、Imagen、Geminiのためにカスタム設計された革新的なAI映画制作ツール、Flowを導入しました。FlowはVideoFXの進化形であり、クリエイターによって、そしてクリエイターのために特別に構築されています。

Flowが提供するもの:

- 直感的なインターフェース:Gemini搭載のプロンプトで日常的な言葉でビジョンを記述

- カメラコントロール:カメラの動き、アングル、パースペクティブを直接制御

- シーンビルダー:連続的な動きと一貫したキャラクターで既存のショットをシームレスに編集・拡張

- アセット管理:素材とプロンプトを効率的に整理

- Flow TV:プロンプトとテクニックが見える、増え続けるクリップのショーケースを閲覧

価格とアクセス:

- Google AI Proプラン:主要なFlow機能と月100回の生成を提供

- Google AI Ultraプラン:最高の使用制限と、環境音やキャラクターの対話を含むネイティブオーディオ生成を備えたVeo 3への早期アクセスを提供

Flowは現在、米国の加入者が利用可能で、他の国もまもなく対応予定です。この方法は、複雑なAPI呼び出しや技術的なセットアップを気にせず、使いやすいインターフェースを求めるクリエイターに最適です。

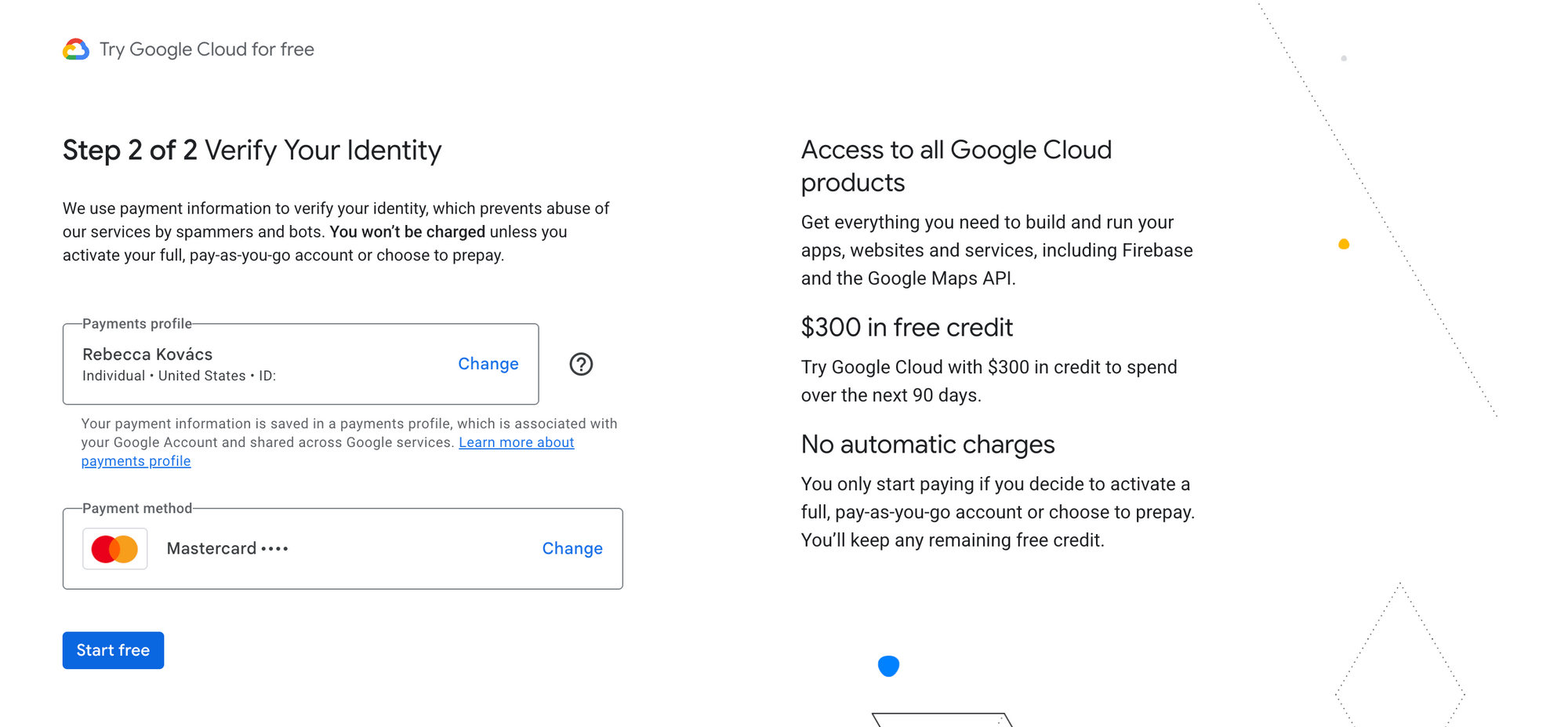

方法2:Google Cloudのサインアップ時の300ドルの無料クレジットを使用する

例えば、Google Cloudのウェブサイトで強調されているように、新規ユーザーは300ドルの無料クレジットと20以上の製品の無料使用を受け取ることができます。これらのクレジットは、Google Veo 3モデルの実験を含むVertex AI上のサービスに適用できます。

サインアッププロセスを進める必要があります。これには認証が必要です。

これにより、クレジットまたはプラットフォームの無料ティアの許容範囲内で、Veo 3を実質的に無料で試すことができます。開始するには、Google Cloudアカウントを作成し、プロジェクトを設定し、Vertex AI APIが有効になっていることを確認する必要があります。

API経由でVeo 3にアクセスする

現在、Veo 3(veo-3.0-generate-preview)はVertex AI APIを通じて利用可能ですが、許可リストへのアクセスが必要です。公式ドキュメントによると、このモデルは制御されたアクセスによるプレビュー状態です。

Googleの公式ドキュメントはこちらでご確認ください。

APIアクセス要件:

- veo-3.0-generate-previewアクセス用の待機リストに参加する

- このモデルはテキストから動画、画像から動画の生成をサポートします

- 現在の制限:アスペクト比16:9、解像度720p、24 FPS、最大長8秒

- プロジェクトあたり毎分最大10件のAPIリクエスト。

方法3:Google AI Proの学生割引

Googleは、学生や教育関係者がVeo 3にアクセスしやすくするための教育割引やプログラムを提供しています。

仕組み:

- 学生はGoogle AI Proの割引または無料アクセス対象となる可能性があります

- 教育機関はしばしば特別な価格設定契約を結んでいます

- 一部の地域では、強化されたクレジット付きの特定の学生プログラムを提供しています

学生アクセスを取得するには、以下の手順が必要です。

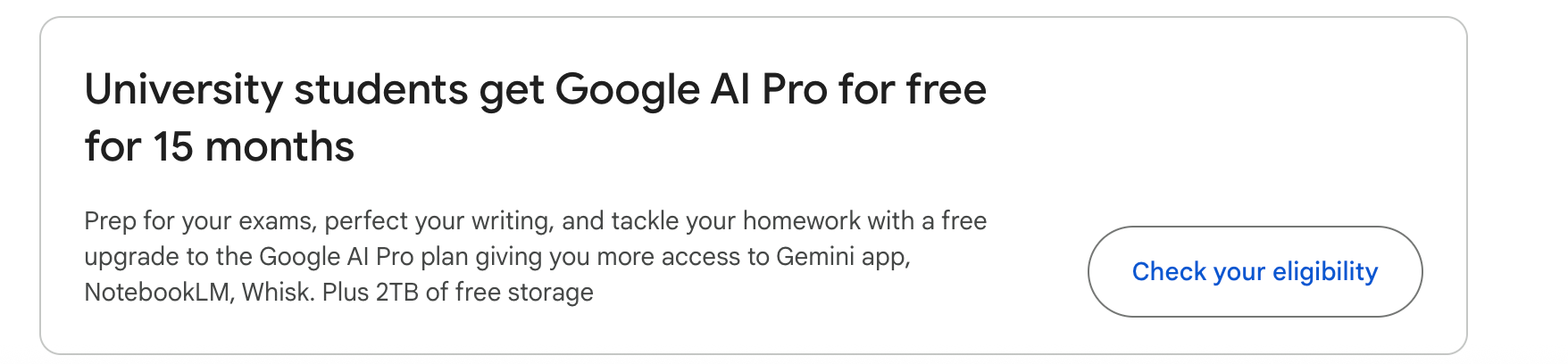

ステップ1. Google Oneでプランにサインアップする

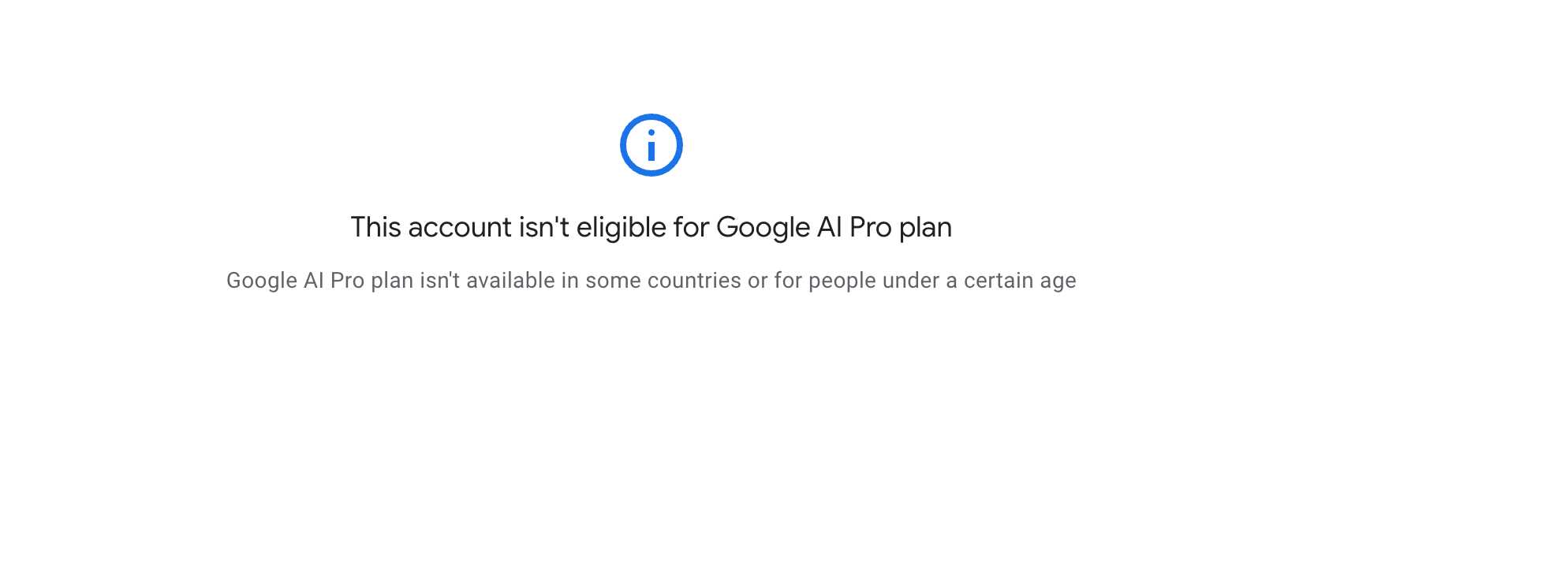

一部のユーザーは、このエラーに遭遇する可能性があることに注意してください。

ステップ2. スクロールダウンして、大学生向けの15ヶ月無料オプションを選択する

ステップ3. 学生ステータスを確認する

- 教育機関のメールアドレス(.eduドメイン)を使用する

- 学生証または在学証明を提供する

- 所属機関が既存のGoogle for Educationパートナーシップを結んでいるか確認する

重要な注意事項:

- 資格は地域や機関によって異なります

- 現在の基準を満たしていない場合、一部のアカウントでは「このアカウントはGoogle AI Proプランの対象ではありません」と表示されることがあります

- 教育機関向けの価格設定と提供状況は頻繁に変更されるため、最新の提供情報はGoogleの公式教育関連ページでご確認ください

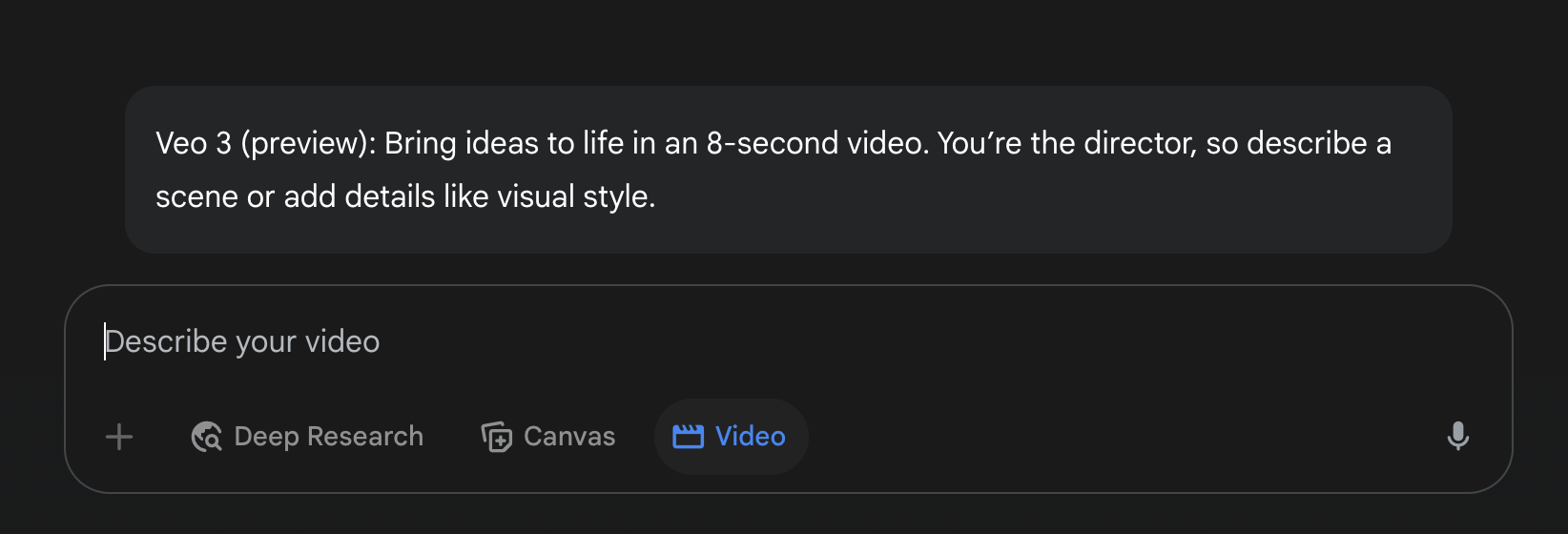

ステップ4. リクエストが承認されたら、Google Geminiにアクセスし、動画オプションを選択して、Veo 3を今すぐ試すことができます!(もちろん、いくつかの制限はあります)

Veo 3のためのより良いプロンプトの書き方

Google Veoモデルは、テキスト記述に基づいて動画を生成します。より詳細なプロンプトを使用すると、一般的に高品質で関連性の高い動画が得られます。以下を記述することを検討してください。

- 被写体とアクション。

- 設定と環境。

- シネマティックなスタイル、カメラの動き。

- ムードとトーン。

音声をサポートするモデル(veo-3.0-generate-previewなど)の場合、トランスクリプション(対話)や効果音の記述を含めることができます。

- プロンプトリライター(プロンプト強化):

VeoにはLLMベースのプロンプト強化ツールが含まれています。この機能は、より記述的な詳細、カメラの動き、トランスクリプション、効果音を追加するためにプロンプトを書き換えることができ、より高品質な動画出力を目指します。 - デフォルトで有効:この機能は、

veo-2.0-generate-001やveo-3.0-generate-previewのようなモデルでデフォルトで有効になっています。 - 無効化:REST API呼び出しで

enhancePromptパラメーターをFalseに設定することで、プロンプト強化をオフにできます(またはSDKで利用可能な同様のパラメーターを使用)。 veo-3.0-generate-previewに関する重要事項:veo-3.0-generate-previewモデルを使用する場合、プロンプトリライターを無効にすることはできません。- レスポンスでの書き換えられたプロンプト:元のプロンプトが30語未満の場合、モデルによって使用された書き換えられたプロンプトがAPIレスポンスで提供されます。

最大限の生産性で開発チームが共同作業できる統合されたオールインワンプラットフォームをお探しですか?

Apidogはあなたのすべての要求に応え、Postmanをはるかに手頃な価格で置き換えます!

結論

Vertex AI上のGoogleのVeoモデルは、特に動画作成における生成AIの重要な進歩を表しています。Gen AI SDK for Pythonと直接的なRESTエンドポイントの両方を通じて直感的なAPIアクセスを提供することで、Googleは開発者やクリエイターが強力なテキストから動画、画像から動画への機能をワークフローやアプリケーションに統合することを可能にします。