モバイルデバイスで大規模言語モデル(LLM)を実行することは、AIを活用したアプリケーションを構築する開発者にとってますます重要になっています。GoogleのGemma 3nモデルは、AI Edge Galleryと組み合わせることで、Androidプラットフォーム上でのオンデバイス推論のための強力なソリューションを提供します。この包括的なガイドでは、Googleの最新のエッジコンピューティングツールを使用して、AndroidデバイスにGemma 3nを実装するプロセス全体を詳しく説明します。

Gemma 3nとGoogle AI Edge Galleryについて理解する

Gemma 3nは、Googleがエッジコンピューティングシナリオ向けに特別に設計した、効率的な言語モデルにおける最新の進歩を表しています。従来のクラウドベースのモデルとは異なり、Gemma 3nはデバイスハードウェア上で直接動作するため、ネットワーク遅延がなくなり、ユーザープライバシーが確保されます。

Google AI Edge Galleryは、エッジデバイスにAIモデルをデプロイするためのツール、サンプル、ドキュメントの包括的なリポジトリとして機能します。このギャラリーには、Gemma 3nのようなモデルをリソースに制約のある環境で実行するための、事前に構築されたソリューション、最適化手法、ベストプラクティスが含まれています。

Google AI Edge Gallery: オンデバイスAIへのゲートウェイ

Google AI Edge Galleryは、最先端のGenerative AIモデルの力をAndroidデバイス上で完全に実行できる実験的なアプリです。このアプリケーションは、さまざまなAIモデルをローカルでテストするためのデモンストレーションプラットフォームと開発環境の両方として機能します。

Edge Galleryのアーキテクチャは、シームレスなモデル実行を提供するために連携するいくつかのコアコンポーネントで構成されています。ランタイム環境には、モデルの読み込み、メモリ管理、実行スケジューリングを処理する最適化された推論エンジンが含まれています。さらに、このアプリケーションは、開発者がテキストチャット、画像分析、マルチモーダル会話など、さまざまなモダリティを通じてモデルと対話できるユーザーインターフェイスレイヤーを提供します。

前提条件とシステム要件

AI Edge Galleryを通じてGemma 3nをインストールする前に、開発者はAndroidデバイスが特定の技術要件を満たしていることを確認する必要があります。最小システム仕様には、Android 8.0(APIレベル26)以上、4GB以上のRAM、およびモデルファイル用の約2GBの空きストレージ容量が含まれます。

さらに、最適なパフォーマンスを得るには、デバイスはARM64アーキテクチャプロセッサを搭載している必要がありますが、システムは古いARMアーキテクチャのフォールバックサポートを提供します。このアプリケーションは、推論操作を高速化できる専用のニューラルプロセッシングユニット(NPU)またはグラフィックスプロセッシングユニット(GPU)を備えたデバイスからも恩恵を受けます。

ステップバイステップのインストールプロセス

Google AI Edge Galleryのインストールプロセスは、アプリケーションが現在Google PlayストアではなくGitHubを通じて配布されているため、手動でのAPKインストールが必要です。GitHubにアクセスし、リリースのセクションから最新のリリースを入手してください。

まず、開発者はAndroidデバイスで未知のソースからのインストールを有効にする必要があります。このセキュリティ設定により、Google Playストア以外のソースからのアプリケーションのインストールが可能になります。設定 > セキュリティ > 未知のソースに移動し、オプションを有効にしてください。新しいAndroidバージョンでは、この権限はインストールプロセス中にアプリケーションごとに付与される場合があります。

その後、GitHubのリリースページから最新のAPKファイルをダウンロードします。ファイルサイズは通常、特定のリリースバージョンによって50〜100MBの範囲です。USB接続、クラウドストレージ、またはデバイスのウェブブラウザからの直接ダウンロードを使用して、APKファイルをAndroidデバイスに転送します。

次に、ファイルマネージャーアプリケーションを使用してダウンロードしたAPKファイルを見つけ、タップしてインストールを開始します。Androidシステムはセキュリティ警告を表示し、続行する前に確認を求めます。ストレージアクセスやネットワーク権限など、プロンプトが表示されたら必要な権限を付与してください。

最後に、インストールが成功したらAI Edge Galleryアプリケーションを起動します。アプリケーションがランタイム環境を構成し、必須のモデルコンポーネントをダウンロードするため、最初の起動プロセスには数分かかる場合があります。

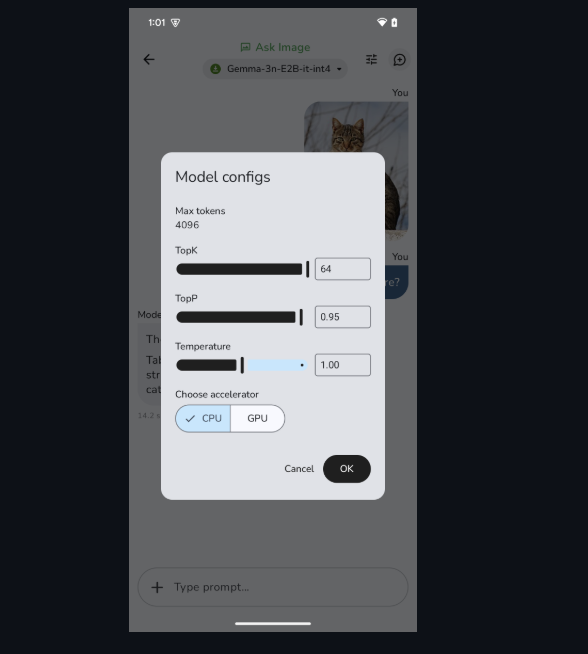

Gemma 3nモデルの構成

AI Edge Galleryアプリケーションが動作可能になったら、次の重要なステップはGemma 3nモデルのダウンロードと構成です。アプリケーションは、モデルの選択と管理のための直感的なインターフェイスを提供します。モバイルデプロイメント用に最適化された事前構成済みのGemma 3nモデルにアクセスするには、huggingfaceから.taskファイルのいずれかをダウンロードします。

モデル選択プロセスでは、デバイスの機能と意図された使用例を慎重に考慮する必要があります。より小さなモデルバリアントは、より少ないメモリを消費し、より高速な推論時間を提供しますが、より大きなバリアントと比較して機能が低下する可能性があります。逆に、より大きなモデルはパフォーマンスが向上しますが、より多くのシステムリソースを必要とします。

最初のモデルダウンロード中、アプリケーションは進行状況インジケーターと推定完了時間を表示します。

テストと検証の手順

適切なテストにより、Gemma 3nのインストールと構成が正しく機能していることが保証されます。AI Edge Galleryは、開発者がさまざまなインタラクションモードでモデルのパフォーマンスを検証できる、いくつかの組み込みテストインターフェイスを提供します。

基本的な機能を検証するために、簡単なテキストベースの会話からテストを開始します。チャットインターフェイスは、クエリの複雑さとデバイスのパフォーマンスに応じて、通常1〜5秒の妥当な時間枠でクエリに応答する必要があります。これらの初期テスト中にシステムリソースの使用状況を監視し、アプリケーションが許容範囲内で動作していることを確認します。

その後、画像をアップロードして分析または説明を要求することにより、マルチモーダル機能をテストします。このアプリは、Ask Image(画像からテキストへ)、Prompt Lab(単一ターンタスク)、AI Chat(複数ターン会話)など、さまざまなAI機能を紹介しています。これらの機能は、Edge Galleryプラットフォームを通じて利用可能な包括的な機能を示しています。

本番デプロイメントのための最適化戦略

AndroidデバイスでGemma 3nのパフォーマンスを最適化するには、いくつかの技術的な要因に注意を払う必要があります。メモリ管理は最も重要な最適化領域であり、非効率なメモリ使用はアプリケーションのクラッシュやシステムの不安定性につながる可能性があります。

利用可能なシステムリソースに基づいてメモリ割り当てを動的に管理するインテリジェントなモデル読み込み戦略を実装します。許容可能な精度レベルを維持しながら精度を低下させるモデル量子化手法の実装を検討します。これらのアプローチは、メモリ要件を大幅に削減し、推論速度を向上させることができます。

さらに、他のシステムプロセスとの競合を最小限に抑えるために、推論スケジューリングを最適化します。重要な操作がバックグラウンド処理タスクよりも優先されるようにする優先度ベースの実行キューを実装します。このアプローチにより、集中的なAI処理操作中でも応答性の高いユーザーインタラクションが保証されます。

さらに、長時間のAI処理セッション中にデバイスの過熱を防ぐ熱管理ポリシーを構成します。CPUおよびGPUの温度を監視し、熱制限に近づいたときに処理強度を下げるスロットリングメカニズムを実装します。

開発ワークフローとの統合

Gemma 3nの機能を既存のAndroid開発ワークフローに統合するには、慎重な計画とツール選択が必要です。最新の開発環境は、AIコンポーネントとアプリケーションロジック間のシームレスな統合を保証する包括的なAPIテストおよび検証ツールから恩恵を受けます。

Apidogは、Gemma 3nのようなAIモデルと統合するアプリケーションを構築する開発者にとって不可欠な機能を提供します。このプラットフォームの包括的なテストスイートは、AIを活用したアプリケーションで一般的に発生するAPIエンドポイント、応答フォーマット、およびエラー処理シナリオの検証を可能にします。

さらに、ローカルAI処理とクラウドベースのサービスを組み合わせたアプリケーションを開発する場合、信頼性とパフォーマンスを確保するために適切なAPIテストが不可欠になります。Apidogのモックサーバー機能を使用すると、開発者はさまざまなサービス条件をシミュレートし、さまざまなシナリオでのアプリケーションの動作をテストできます。

今後の開発ロードマップ

Gemma 3nとAI Edge Galleryのエコシステムは急速に進化し続けており、今後のリリースで大幅な機能強化が計画されています。Googleはまた、iOSデバイス向けにも間もなく登場し、モバイルエコシステム全体でプラットフォームのリーチを拡大すると述べています。

予想される改善には、パフォーマンス品質を維持しながらリソース要件をさらに削減する強化されたモデル圧縮技術が含まれます。さらに、拡張されたマルチモーダル機能により、テキスト、画像、音声、ビデオコンテンツの複雑な組み合わせを処理する、より洗練されたアプリケーションが可能になります。統合機能も拡張され、カスタムモデルのファインチューニングとデプロイメントワークフローのサポートが向上します。これらの機能強化により、開発者は特定のユースケースや業界に合わせた高度に専門化されたAIアプリケーションを作成できるようになります。

結論

Google AI Edge Galleryを通じてAndroidでGemma 3nを実行することは、モバイルAI機能における重要な進歩を表しています。この組み合わせは、開発者に完全にオンデバイスで動作する洗練されたAIアプリケーションを作成するための強力なツールを提供し、プライバシーを確保し、クラウドサービスへの依存を減らします。

成功した実装には、システム要件、適切なインストール手順、および徹底的なテストプロトコルに注意を払う必要があります。このガイドに概説されている技術ガイドラインに従うことで、開発者は最適なパフォーマンスとセキュリティ標準を維持しながら、本番環境にGemma 3nを効果的にデプロイできます。