Gemini 3 ProがOllamaの無料枠で利用可能になり、開発者たちはすぐに注目しました。最も高性能なマルチモーダルモデルの一つを試すために、有料のCloud MaxやProサブスクリプションはもう必要ありません。さらに、この統合により、Gemini 3 Proの最先端の推論機能が、何百万人ものユーザーがローカルモデルで既に利用しているおなじみのOllamaワークフローに直接もたらされます。

次に、何が変更されたのか、設定方法、そしてコンシューマーハードウェアでパフォーマンスを最大化する方法について見ていきます。

OllamaにおけるGemini 3 Proの変更点

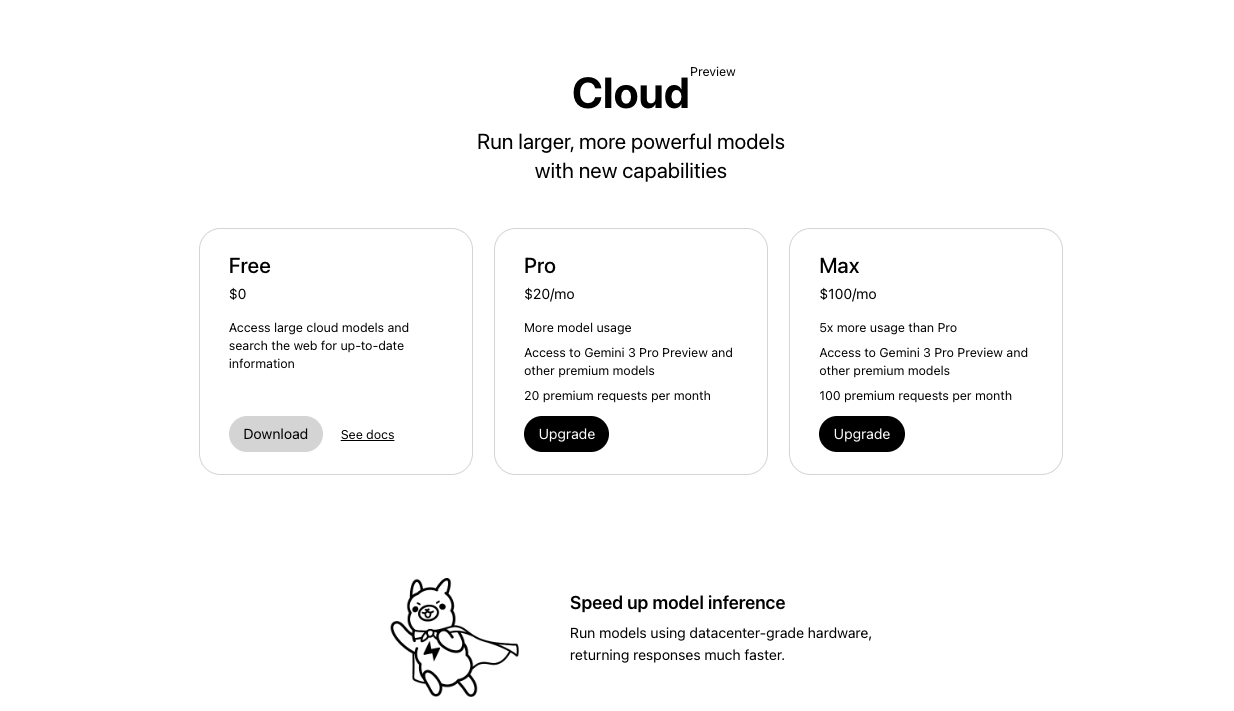

Ollamaは当初、Gemini 3 ProをOllamaの有料Cloudプランに限定していました。しかし、2025年11月18日、Ollamaの公式アカウントは、このモデルがProおよびMaxティアに加え、無料枠でも利用可能になったと発表しました。

今では、たった一つのコマンドを実行するだけです。

ollama run gemini-3-pro-preview

このコマンドは、追加の課金なしでモデルをプルして実行します。さらに、このモデルは1Mトークンのコンテキストウィンドウ、ネイティブなマルチモーダル入力(テキスト、画像、音声、動画)、および高度なエージェント機能をサポートしています。

| ティア | Gemini 3 Proアクセス | レート制限(概算) | 費用 |

|---|---|---|---|

| 無料 | はい(プレビュー) | 中程度 | 0ドル |

| Pro | はい | 高め | 有料 |

| Max | はい | 最高 | 高額有料 |

この変化は、アクセスを民主化します。その結果、独立開発者、研究者、そして趣味でAIに取り組む人々は、これまでエンタープライズ向けのサブスクリプションが必要だった最先端の推論能力を、同じように手に入れることができるようになります。

開始前の前提条件

最新の**Ollamaをインストール**する必要があります — バージョン0.3.12以降は、クラウドホスト型モデルをシームレスに処理します。[https://ollama.com/download](https://ollama.com/download)からダウンロードしてください。

ステップバイステップ:無料枠でGemini 3 Proプレビューを実行する

モデルを起動するには、以下の手順に正確に従ってください。

まず、ターミナルを開き、Ollamaが動作していることを確認します。

ollama --version

バージョン0.3.12以上が表示されるはずです。

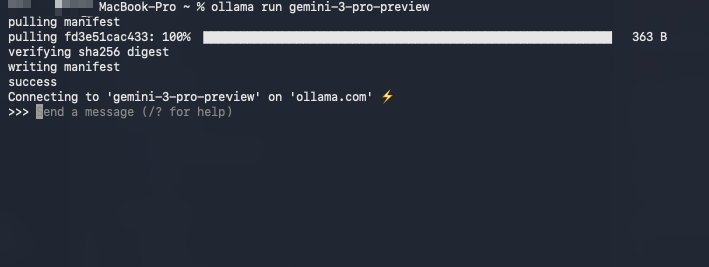

次に、モデルを直接プルして実行します。

ollama run gemini-3-pro-preview

Ollamaは、無料枠の資格を自動的に検出し、APIキー(初回実行後に安全に保存されます)を介してGoogleのバックエンドに接続します。さらに、APIキーが不足している場合は、初回実行時にキーの入力を求められます。

第三に、基本的なやり取りをテストします。

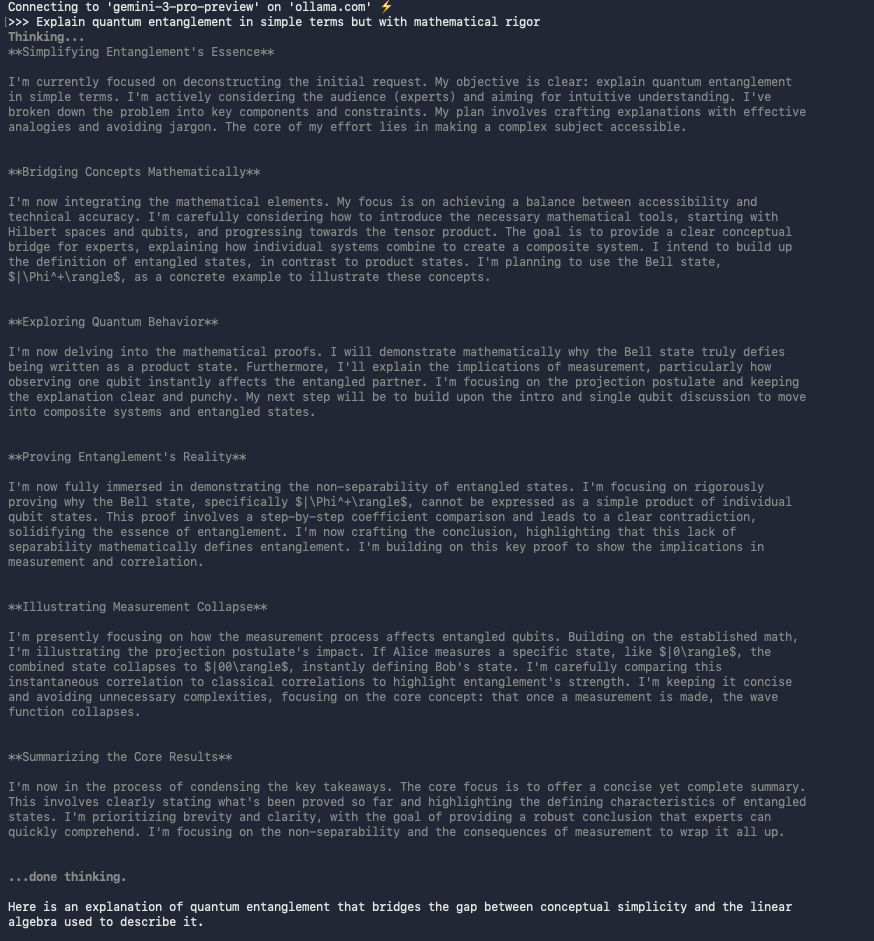

>>> Explain quantum entanglement in simple terms but with mathematical rigor.

モデルは、多くの場合LaTeX形式の数式を含む明確な説明で応答します。

さらに、Open WebUIのようなツールで画像やドキュメントを直接アップロードすることもできます。

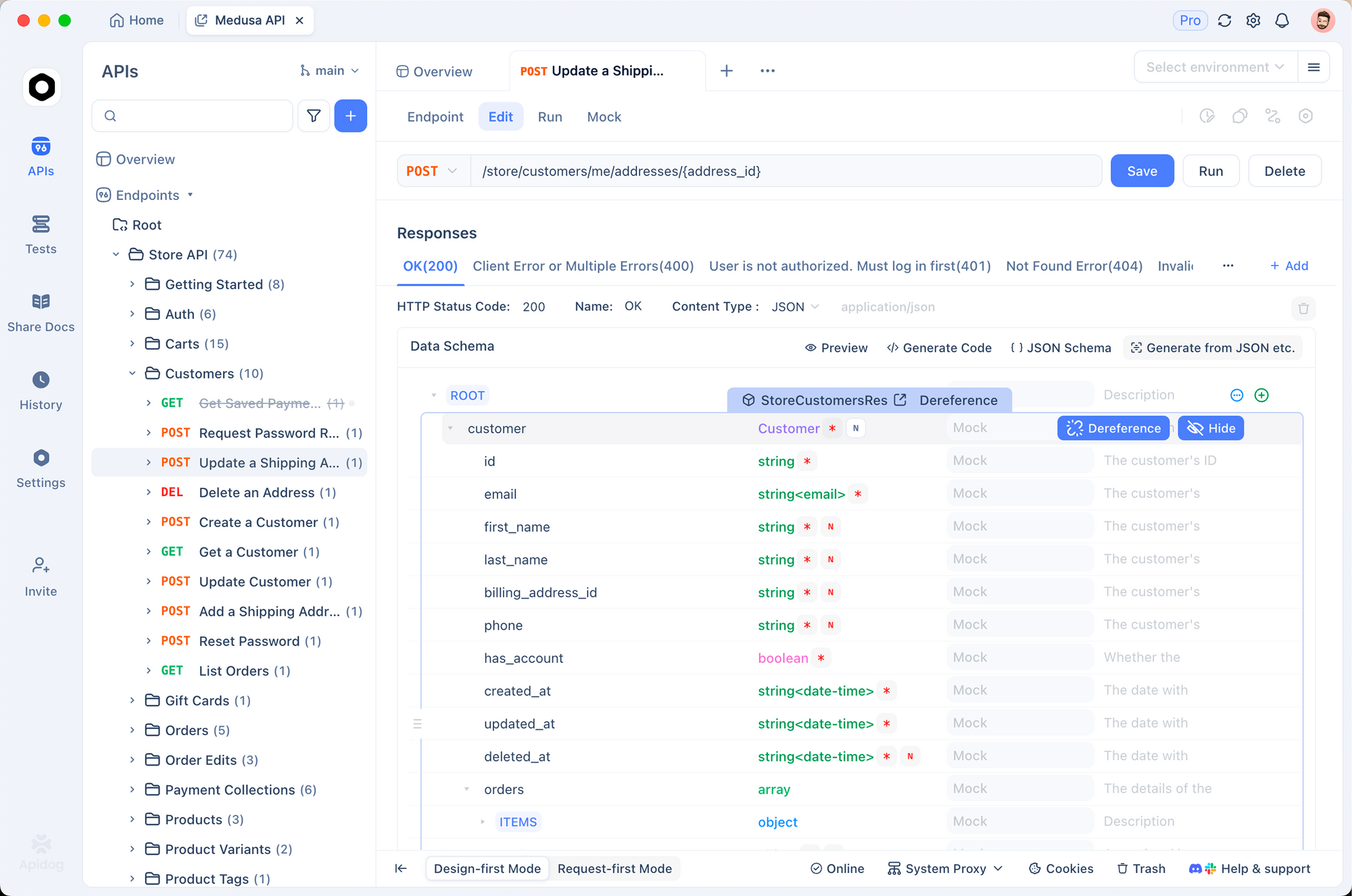

ApidogでGemini APIを直接テストする

スクリプト作成や統合のために、Geminiエンドポイントへの生アクセスが必要になることがあります。Apidogは、自動リクエスト生成、環境変数、応答検証をサポートしているため、この点で優れています。

公式エンドポイントを介して同じモデルをテストする方法は次のとおりです。

Apidogを開き、新しいリクエストを作成します。

メソッドをPOSTに、URLを以下に設定します。

https://generativelanguage.googleapis.com/v1/models/gemini-3-pro-preview:generateContent

クエリパラメータを追加します: key=YOUR_API_KEY

ボディ(JSON)には、以下を使用します。

{

"contents": [{

"parts": [{

"text": "Compare Gemini 3 Pro to GPT-4o on reasoning benchmarks."

}]

}]

}

リクエストを送信します。

Apidogは、応答を自動的に整形し、トークン使用量をハイライト表示し、リクエストをコレクションとして保存できます。このアプローチは、連続した呼び出しを行ったり、エージェントを構築したりする場合に非常に貴重です。

マルチモーダル機能:ビジョン、オーディオ、ビデオ

Gemini 3 Proは、ネイティブなマルチモーダル処理で際立っています。例えば、画像URLやローカルファイルを読み込ませることができます。

ollama run gemini-3-pro-preview

>>> (回路図の画像をアップロード)

この回路図を説明し、効率向上のための改善策を提案してください。

モデルは図を分析し、コンポーネントを特定し、最適化を提案します。同様に、同じセッションでビデオフレームや音声トランスクリプトを処理することもできます。

実際には、開発者たちは、以前のGemini 1.5 Proと比較して、ドキュメント理解タスク、特にテキストと画像が混在するPDFにおいて優れたパフォーマンスを報告しています。

パフォーマンスベンチマークと実世界でのテスト

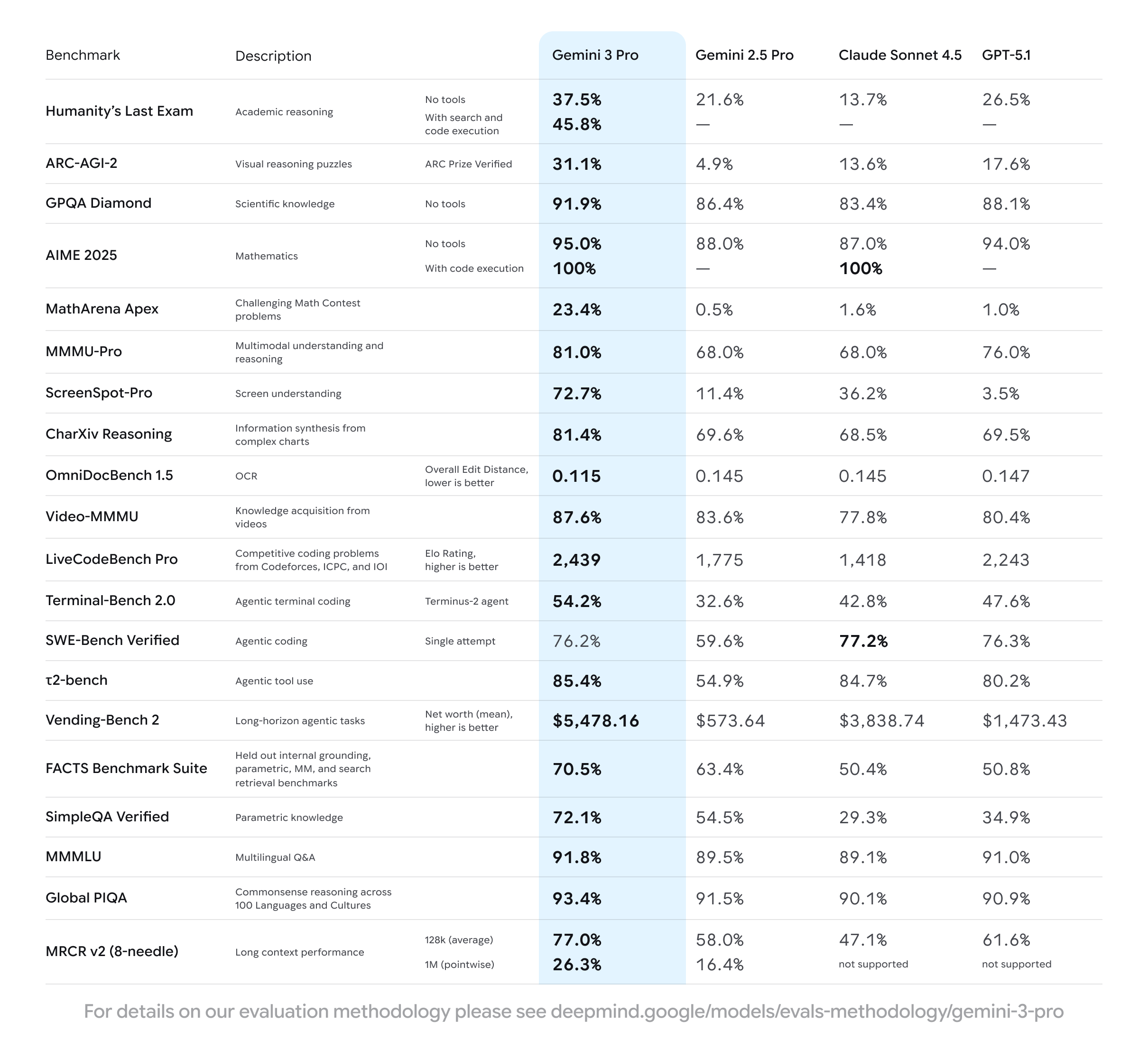

2025年11月18日に実施された独立したテストでは、Gemini 3 Proは以下の結果を達成しました。

- MMLU-Pro: 88.2%

- GPQA Diamond: 82.7%

- LiveCodeBench: 74.1%

- MMMU(マルチモーダル): 78.5%

さらに、無料枠での出力速度は、テキストのみのプロンプトで平均45~60トークン/秒であり、競合モデルの有料枠に匹敵します。

Open WebUIフロントエンドを使用するか、Ollamaが公開しているOpenAI互換のエンドポイントを介して統合することで、さらに高速な応答を実現できます。

Gemini 3 Proをアプリケーションに統合する

Ollamaは`http://localhost:11434/v1`でOpenAI互換APIを公開しています。したがって、LangChain、LlamaIndex、またはHaystackのどのプロジェクトでも、これを参照できます。

from openai import OpenAI

client = OpenAI(

base_url="http://localhost:11434/v1",

api_key="ollama", # ダミーキー

)

response = client.chat.completions.create(

model="gemini-3-pro-preview",

messages=[{"role": "user", "content": "Write a FastAPI endpoint for user auth."}]

)

print(response.choices[0].message.content)

この互換性により、GPTモデル用に構築されたコードベースを書き直すことなく、Gemini 3 Proを組み込むことができます。

知っておくべき無料枠の制限

無料アクセスには、寛大ながらも有限なレート制限が含まれます。ヘビーユーザーは、地域や負荷に応じて、1分あたり約50~100リクエストの制限に達します。また、モデルはクラウドホスト型であるため、レイテンシは接続環境に依存します(通常、TTFは800~1500ミリ秒)。

無制限に使用するには、Ollama ProまたはMaxにアップグレードしてください。しかし、ほとんどの開発者は、プロトタイプ作成や日常業務には無料枠で十分だと感じています。

高度な使用法:関数呼び出しとツール利用

Gemini 3 Proはネイティブな関数呼び出しをサポートしています。Modelfile内またはAPI経由でツールを定義します。

{

"tools": [{

"type": "function",

"function": {

"name": "get_weather",

"description": "Get current weather",

"parameters": { ... }

}

}]

}

モデルは、いつ関数を呼び出すかを決定し、Webブラウジングやデータベースクエリのようなエージェントワークフローを可能にします。

一般的な問題のトラブルシューティング

- **エラー 401/403**: Gemini APIキーを再生成し、

ollama runを再度実行して再認証してください。 - **モデルが見つからない**: Ollamaを更新し(

ollama update)、再試行してください。 - **応答が遅い**: 有線接続に切り替えるか、オフピーク時に使用してください。

- **マルチモーダル機能が失敗する**: 最新のOllamaバージョンを使用していることを確認し、サポートされているクライアント(Open WebUIが最適)を介してファイルをアップロードしてください。

2025年の開発者にとってこれが重要な理由

今や、インフラコストゼロで最先端の知能にアクセスできます。これにより、競争環境は劇的に平準化されます。小規模チームは高度なエージェントを構築し、研究者は最新のSOTAモデルとベンチマークを行い、愛好家はマルチモーダルAIを探索できます — これらすべてが予算の承認なしに可能です。

さらに、これをAPI管理のためのApidogのようなツールと組み合わせることで、開発サイクルを数日から数時間へと短縮できます。

結論:今すぐGemini 3 Proを使い始めましょう

今すぐollama run gemini-3-pro-previewを実行して、その違いを体験してください。GoogleとOllamaは、高度なAI実験における最大の障壁を取り除きました。

今すぐApidogを無料でダウンロードして、APIテストワークフローを強化しましょう — Geminiリクエストのデバッグでも、Ollamaを中心としたフルスタックアプリケーションの構築でも。

オープンでアクセス可能なAIの未来が到来しました。それに参加するために必要なコマンドは一つだけです。