FLUX 2は、特に高忠実度な画像生成と編集を必要とするアプリケーションを構築する開発者にとって、生成AIにおける大きな進歩を意味します。チームが複雑な視覚タスクを処理するためにスケーラブルなAPIにますます依存するようになる中、fal.aiのFLUX 2 APIは堅牢なソリューションとして登場します。プロフェッショナルグレードの出力を実現するFLUX 2 Proや、カスタマイズ可能な制御を可能にするFLUX 2 Flexのようなバリアントをサポートしており、ローカルインフラのオーバーヘッドなしに、正確なテキストから画像への変換と編集を可能にします。

このガイドは、FLUX 2 APIを効果的に活用するための技術的知識を提供します。セットアップ、主要なエンドポイント、パラメータ調整、エラー処理と最適化のベストプラクティスについて学びます。さらに、Apidogのようなツールが開発サイクルをどのように強化し、デバッグ時間を短縮し、コラボレーションを改善するかを強調します。

FLUX 2 APIアーキテクチャの理解

開発者は、Black Forest Labsのフローマッチング技術に基づいたモジュラー設計のため、FLUX 2 APIを高く評価しています。画像を繰り返しノイズ除去する従来の拡散モデルとは異なり、FLUX 2は120億のパラメータを持つトランスフォーマーベースのアーキテクチャを採用しており、より少ないステップで出力を生成しながら、優れたプロンプトへの忠実性とリアリズムを維持します。この効率性により、APIコールでのレイテンシとコストが低減され、コンテンツ作成ツールやEコマースビジュアライザーなどのリアルタイムアプリケーションに最適です。

このAPIは、fal.aiのサーバーレスインフラストラクチャを通じて動作し、NVIDIA H100およびH200 GPUを使用してグローバルな地域にワークロードを分散します。特定のFLUX 2バリアントに合わせたHTTP POSTリクエストを介して操作します。認証は、AuthorizationヘッダーにKey {your_fal_key}として渡されるシンプルなAPIキーに依存します。この設定により、サーバー管理なしで安全かつスケーラブルなアクセスが保証されます。

さらに、このAPIはストリーミング応答をサポートしており、ユーザー向けのアプリでプログレッシブな画像レンダリングを可能にします。コストはペイパーメガピクセルモデルに従い、出力あたり通常0.003ドルから0.012ドルで、丸められた解像度に基づいて請求されます。たとえば、1024x1024の画像は約1 MPとカウントされ、大量使用時の費用を予測可能にします。

始めるには、fal.aiにサインアップし、ダッシュボードからAPIキーを生成します。クライアントサイドコードで公開すると不正アクセスのリスクがあるため、環境変数に安全に保管してください。これらの基盤が整ったら、コアエンドポイントの探索に進むことができます。

認証と環境のセットアップ

安全な認証は、あらゆるAPI統合の礎石であり、FLUX 2 APIはこれをシンプルかつ堅牢に保ちます。まず、HTTPの複雑さを言語固有のラッパーに抽象化する公式のfal.aiクライアントSDKをインストールすることから始めます。Pythonの場合、pip install fal-clientを実行します。JavaScriptの場合、npm install @fal-ai/clientを使用します。

インストールしたら、キーを使用してクライアントを初期化します。

import fal_client as fal

fal.config(api_key="your_fal_key_here")

JavaScriptの場合:

import { fal } from "@fal-ai/client";

const falClient = new fal.Client({ apiKey: "your_fal_key_here" });

この設定は、リトライ、タイムアウト、レート制限を自動的に処理します。基本的なプロンプトのためにモデルを購読するなど、FLUX 2エンドポイントへの簡単なpingで接続性をテストします。応答が200ステータスを返した場合、セットアップは成功です。

次に、開発環境を準備します。Pythonでは仮想環境(python -m venv flux_env)を使用して依存関係を分離し、JavaScriptプロジェクトではNode.js v18以降を確保します。python-dotenvや.envファイルなどのツールを使用して環境変数管理を統合し、シークレットのハードコーディングを避けます。

構築を進める上で、Apidogはここで非常に貴重であることが証明されます。FLUX 2 OpenAPI仕様(fal.aiドキュメントで入手可能)をインポートし、モックデータでリクエストをシミュレートできます。このステップにより、プロトタイピング中の高額なライブAPIコールを防ぎます。結果として、開発者はこのようなプラットフォームを使用すると、最大40%速いイテレーションサイクルを報告しています。

認証が確保されたら、高リスクなアプリケーション向けのプロバリアントから始めて、特定のFLUX 2エンドポイントに注目しましょう。

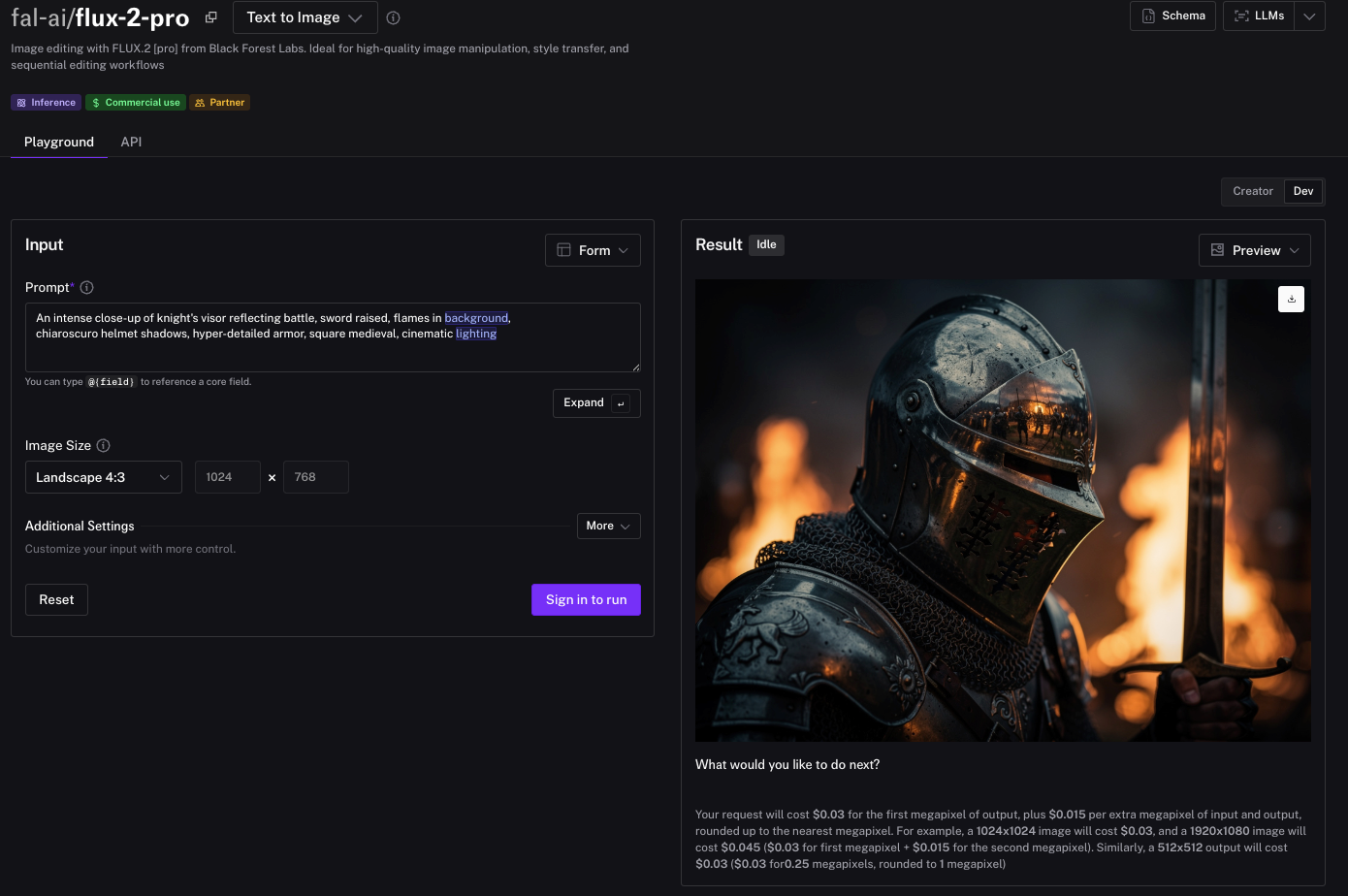

プロフェッショナルなテキストから画像への生成のためのFLUX 2 Proの活用

FLUX 2 Proは、最先端の画像品質を求める開発者にとっての主力エンドポイントとして際立っています。fal-ai/flux-2-proでホストされており、プロンプトへの忠実性に優れ、複雑なシーンをフォトリアリスティックな詳細と正確なタイポグラフィでレンダリングします。広告や製品モックアップなど、アプリケーションがクローズドソースモデルに匹敵する出力を要求する場合に使用します。

このエンドポイントは、プロンプトと生成パラメータを定義するJSONペイロードを含むPOSTリクエストを受け入れます。主な入力は以下の通りです。

prompt: 出力をガイドする説明的な文字列(例:「夜明けの穏やかな山岳風景、高山の峰々に霧が立ち込める、アンセル・アダムスのスタイルで」)。image_size:landscape_16_9などのオプション、またはカスタム寸法(幅/高さはピクセル単位、最大2048x2048)。num_inference_steps: 品質と速度のバランスのためにデフォルトは28。より細かい詳細のためには50に増やします。guidance_scale: プロンプトの忠実度を制御(デフォルトは7.5。高い値ほど厳密な忠実度を強制します)。

Pythonでの画像生成リクエストの例:

result = fal.subscribe("fal-ai/flux-2-pro", {

"input": {

"prompt": "A futuristic cityscape at night, neon lights reflecting on wet streets, cyberpunk aesthetic",

"image_size": "square_hd",

"num_inference_steps": 30,

"guidance_scale": 8.0

}

})

print(result["images"][0]["url"]) # 生成された画像URLにアクセス

JavaScriptでの同等の記述:

const result = await fal.subscribe("fal-ai/flux-2-pro", {

input: {

prompt: "A futuristic cityscape at night, neon lights reflecting on wet streets, cyberpunk aesthetic",

image_size: "square_hd",

num_inference_steps: 30,

guidance_scale: 8.0

}

});

console.log(result.images[0].url);

応答は、base64エンコードされた画像、またはfal.aiがホストするファイルへのURLを含むJSONオブジェクトを返します。本番環境では、クライアント設定でstream: trueを設定することでストリーミングを有効にし、リアルタイムプレビュー用の部分的な出力を得ることができます。

ただし、オーバーヘッドを削減するために、リクエストをバッチ処理(1回のコールで最大10個のプロンプト)することでコストを最適化します。fal.aiのダッシュボードを通じて使用状況を監視し、1分あたり100リクエストでのスロットリングを避けてください。

生成からカスタマイズへと移行し、FLUX 2 Flexエンドポイントは、カスタマイズされたワークフローのためのきめ細かい制御を提供します。

FLUX 2 Flexエンドポイントで出力をカスタマイズする

調整可能なパラメータが必要なシナリオでは、fal-ai/flux-2-flexのFLUX 2 Flexが開発者に推論の微調整を可能にします。このバリアントは、速度と詳細のバランスを取る反復設計ツールのようなアプリケーションで威力を発揮します。可変ステップ(4-50)とガイダンススケール(0-20)をサポートし、再現可能な結果のためのシード制御などの高度な機能も備えています。

主要なパラメータはProを超えて拡張されます。

num_inference_steps: 4(超高速)から50(高忠実度)まで微調整可能。guidance_scale: 0(創造的自由)から20(厳密なプロンプト追従)まで調整可能。seed: 決定論的な出力のための整数(例:42)。safety_tolerance: コンテンツモデレーションの閾値(0-5; デフォルト3)。

PythonでFlexコールを実装します。

flex_result = fal.subscribe("fal-ai/flux-2-flex", {

"input": {

"prompt": "An abstract watercolor of ocean waves crashing on rocks, vibrant blues and greens",

"num_inference_steps": 20,

"guidance_scale": 5.0,

"seed": 12345

}

})

JavaScriptの場合:

const flexResult = await fal.subscribe("fal-ai/flux-2-flex", {

input: {

prompt: "An abstract watercolor of ocean waves crashing on rocks, vibrant blues and greens",

num_inference_steps: 20,

guidance_scale: 5.0,

seed: 12345

}

});

出力はProに似ていますが、スタイル転送のためのLoRAウェイトでの実験が可能です。URL経由でカスタムのsafetensorsをアップロードし、lora_scale: 0.8を設定します。この柔軟性は、UI/UXデザインにおけるA/Bテストに適しています。

しかし、大きな制御には検証の必要性が伴います。Apidogを使用してFlexエンドポイントをモックし、さまざまなパラメータを注入して高ステップ生成などのエッジケースをシミュレートします。このアプローチにより、パフォーマンスのボトルネックを早期に検出できます。

生成を基盤として、FLUX 2 Editによる画像編集は変革的な機能をもたらします。

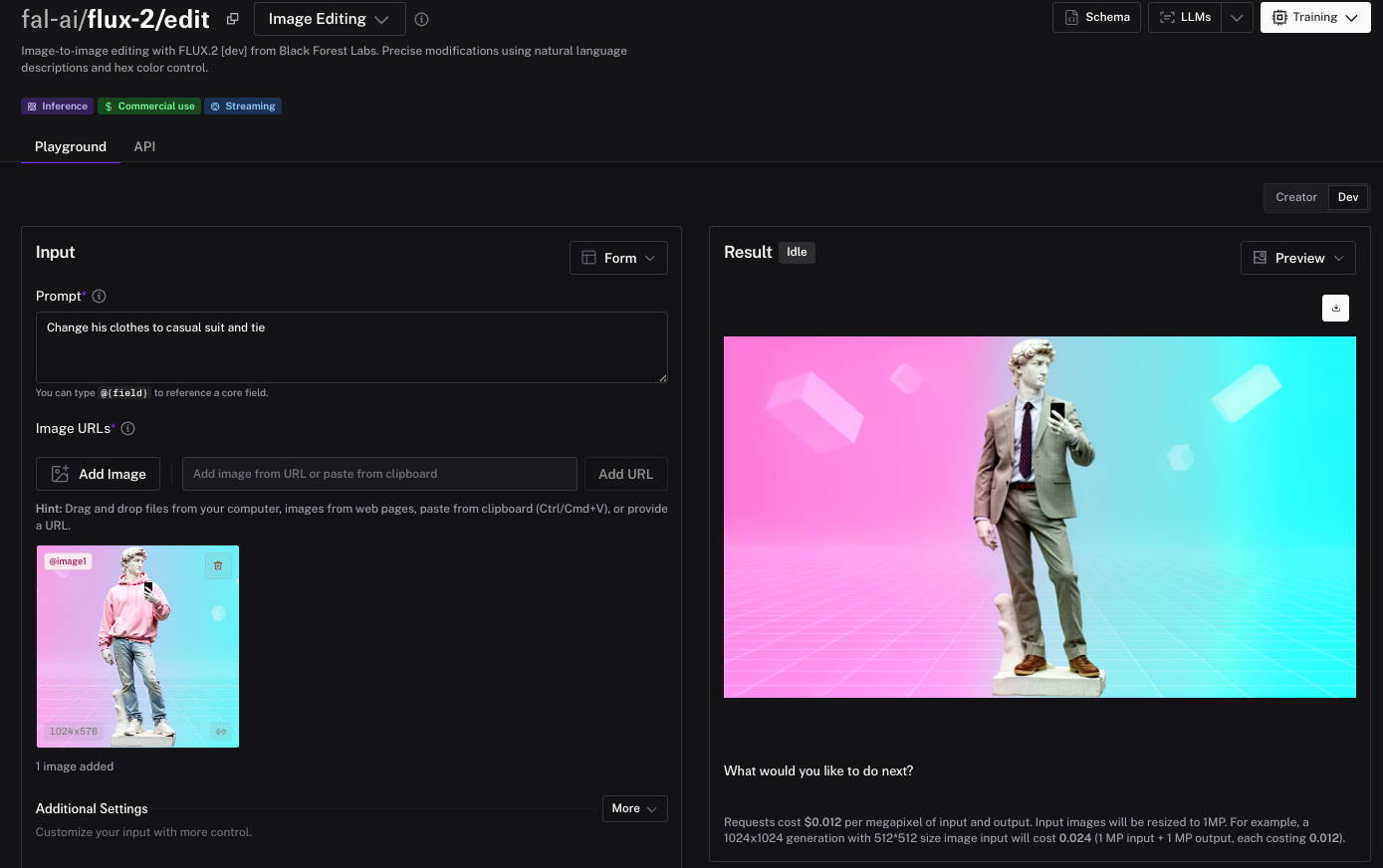

FLUX 2 Editによる高度な画像編集

FLUX 2 Editエンドポイント(fal-ai/flux-2/edit)は、画像から画像へのワークフローに革命をもたらし、マスクやセグメンテーションなしで自然言語による修正を可能にします。開発者はこれを使用して要素を交換したり、スタイルを適用したり、シーンを合成したりでき、写真レタッチアプリやARフィルターに最適です。

入力は画像と説明的なプロンプトを組み合わせます。

@image1: ベース画像のURLまたはbase64。prompt: 編集指示(例:「空を星空に置き換え、満月を追加する」)。- 複数画像参照: スタイル転送用の

@image2。 - 構造のためのJSONプロンプト: シーン、被写体、カメラアングルを定義します。

Pythonコードの例:

edit_result = fal.subscribe("fal-ai/flux-2/edit", {

"input": {

"image": "https://example.com/base.jpg", # またはbase64 URI

"prompt": "@image wearing a red dress from @image2, sunset background",

"num_inference_steps": 25

}

})

JavaScriptの場合:

const editResult = await fal.subscribe("fal-ai/flux-2/edit", {

input: {

image: "https://example.com/base.jpg",

prompt: "@image wearing a red dress from @image2, sunset background",

num_inference_steps: 25

}

});

HEXカラーで精度を高めます:「車を#FF0000でペイントする」。入出力MPのコストは2倍になるため、クライアント側で画像をリサイズしてください。

Apidogは、リクエストでのファイルアップロードをサポートすることでシームレスに統合され、複数画像の編集を視覚的にテストできます。

エラー処理と最適化戦略

堅牢なアプリケーションは障害を予測し、FLUX 2 APIコールも例外ではありません。一般的なエラーには、429(レート制限)、401(認証失敗)、422(無効なプロンプト)があります。クライアントで指数関数的バックオフを実装します。

import time

from fal_client import FalError

try:

result = fal.subscribe("fal-ai/flux-2-pro", {...})

except FalError as e:

if e.status_code == 429:

time.sleep(2 ** e.retry_after) # バックオフ

# ここでリトライロジック

バリエーションのためにシードをキャッシュしたり、再利用可能なアセットのためにfal.aiのファイルストレージを使用したりすることで、さらに最適化します。Apidogのアナリティクスでリクエストをプロファイリングし、遅いパラメータを特定します。

スケーリングのため、バッチエンドポイントはプロンプトの配列を処理し、レイテンシを70%削減します。非同期ジョブについては、Webhookを介して監視します。

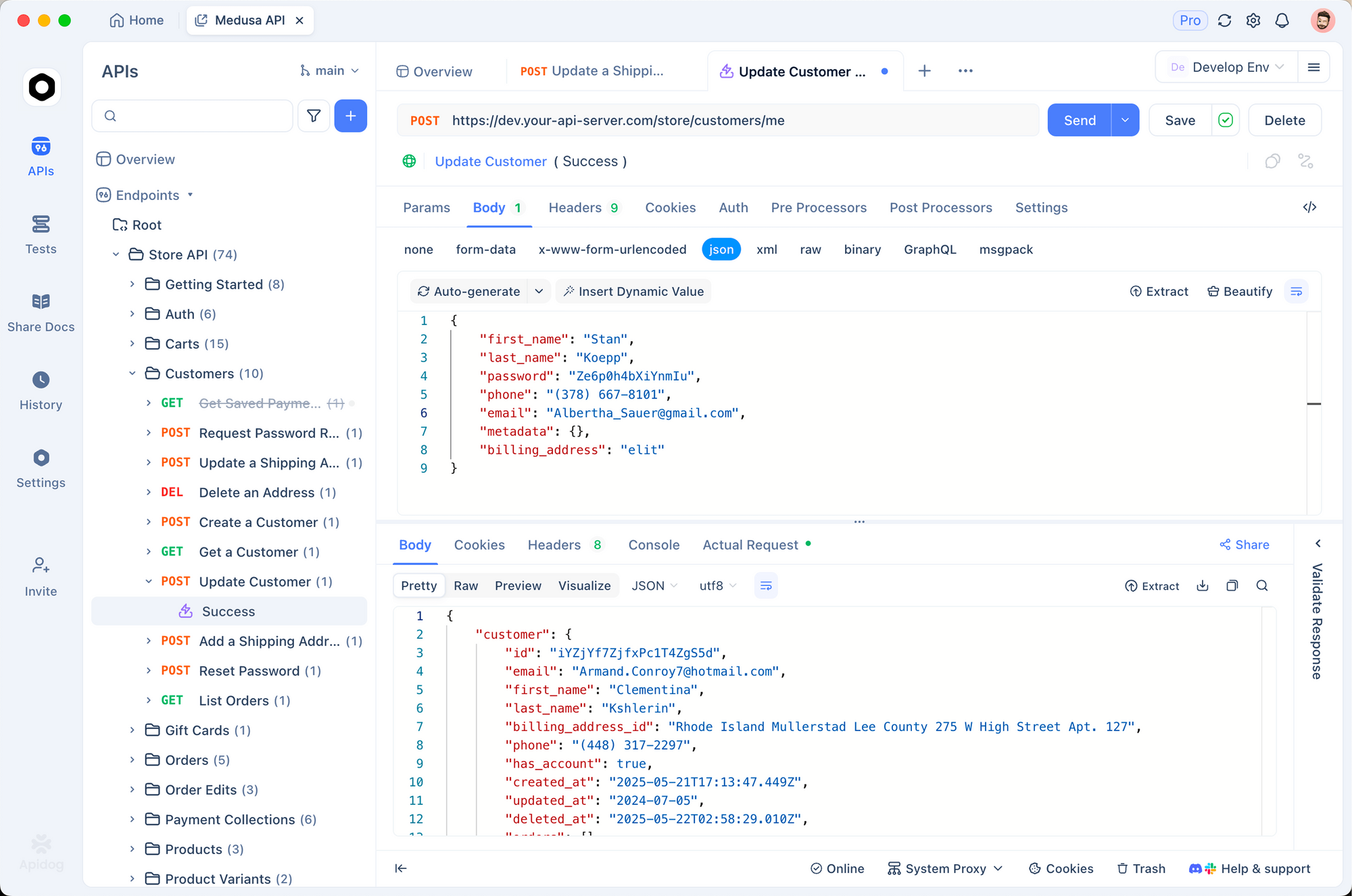

FLUX 2 APIとApidogを統合してテストを効率化する

Apidogはテストを集中管理することで、FLUX 2の開発を向上させます。fal.aiスキーマをインポートし、認証ヘッダーを追加し、エンドポイントカバレッジのためにコレクションを実行します。モック応答はGPUの遅延をシミュレートし、チーム共有はコラボレーションを促進します。

セットアップは数分で完了します。プロジェクトを作成し、エンドポイントドキュメントを貼り付け、実行します。プロンプトを繰り返しデバッグし、出力が期待通りであることを確認します。

この統合は、同様のAIパイプラインにおけるバグ率の低下によって証明されているように、デプロイメントのリスクを削減します。結論:FLUX 2でプロジェクトを向上させる

FLUX 2 APIは、画像中心のアプリケーションに比類のない汎用性を提供します。Apidogによって強化された認証、エンドポイント、最適化を習得することで、チームをイノベーションへと導くことができます。今すぐ実装を始めましょう。その結果はあなたのワークフローを変革するでしょう。さらに詳しく知るには、fal.aiのドキュメントとApidogの無料ティアをご覧ください。