開発者は、過度なコストや複雑さを伴わずに信頼性の高い結果を提供する、堅牢なAIモデルを常に求めています。Baiduは、事実の正確性、指示への追従性、エージェント能力を向上させる最先端の推論モデルであるERNIE X1.1でこのニーズに応えます。Wave Summit 2025で発表されたこのモデルは、ERNIE 4.5の基盤の上に構築されており、優れたパフォーマンスのためにエンドツーエンドの強化学習を取り入れています。ユーザーは、ERNIE Bot、Wenxiaoyanアプリ、またはAPIを介したQianfan Model-as-a-Service (MaaS) プラットフォームを通じてアクセスでき、個人および企業の両方のアプリケーションに多用途です。

この記事では、ERNIE X1.1 APIの使用に関するあらゆる側面について案内します。まずモデルの概要から始め、次にセットアップ手順に移り、最後に高度な使用シナリオを探ります。これらの手順に従うことで、ERNIE X1.1をワークフローに効率的に統合できます。

ERNIE X1.1とは?主な機能と能力

BaiduはERNIE X1.1を、論理的計画、反省、進化を伴う複雑なタスクに対応するマルチモーダル深層思考推論モデルとして設計しています。前身のERNIE X1と比較して、ハルシネーションを大幅に削減し、指示への順守を12.5%向上させ、エージェント機能を9.6%向上させます。さらに、34.8%高い事実の正確性を達成し、知識Q&A、コンテンツ生成、ツール呼び出しなどのアプリケーションに最適です。

このモデルは、最大32Kトークンまでの広範なコンテキストウィンドウをサポートし、一貫性を失うことなく長文の入力を処理できます。開発者はそのマルチモーダル機能を活用して、テキスト、画像、さらにはビデオ分析を処理でき、従来の言語モデルを超えたユースケースを拡大しています。例えば、ERNIE X1.1は画像コンテンツを正確に識別し、回転する3Dコンテナ内の粒子など、物理的なシナリオをシミュレートします。

さらに、ERNIE X1.1は、誤解を招く指示よりも正確な情報を提供することで信頼性を優先し、安全性が重視される環境で際立っています。BaiduはこれをQianfanプラットフォームにデプロイしており、大量のAPI呼び出しに対するスケーラビリティを確保しています。この設定により、チャットボット、レコメンデーションエンジン、データ分析ツールを構築する場合でも、既存システムとのシームレスな統合が可能になります。

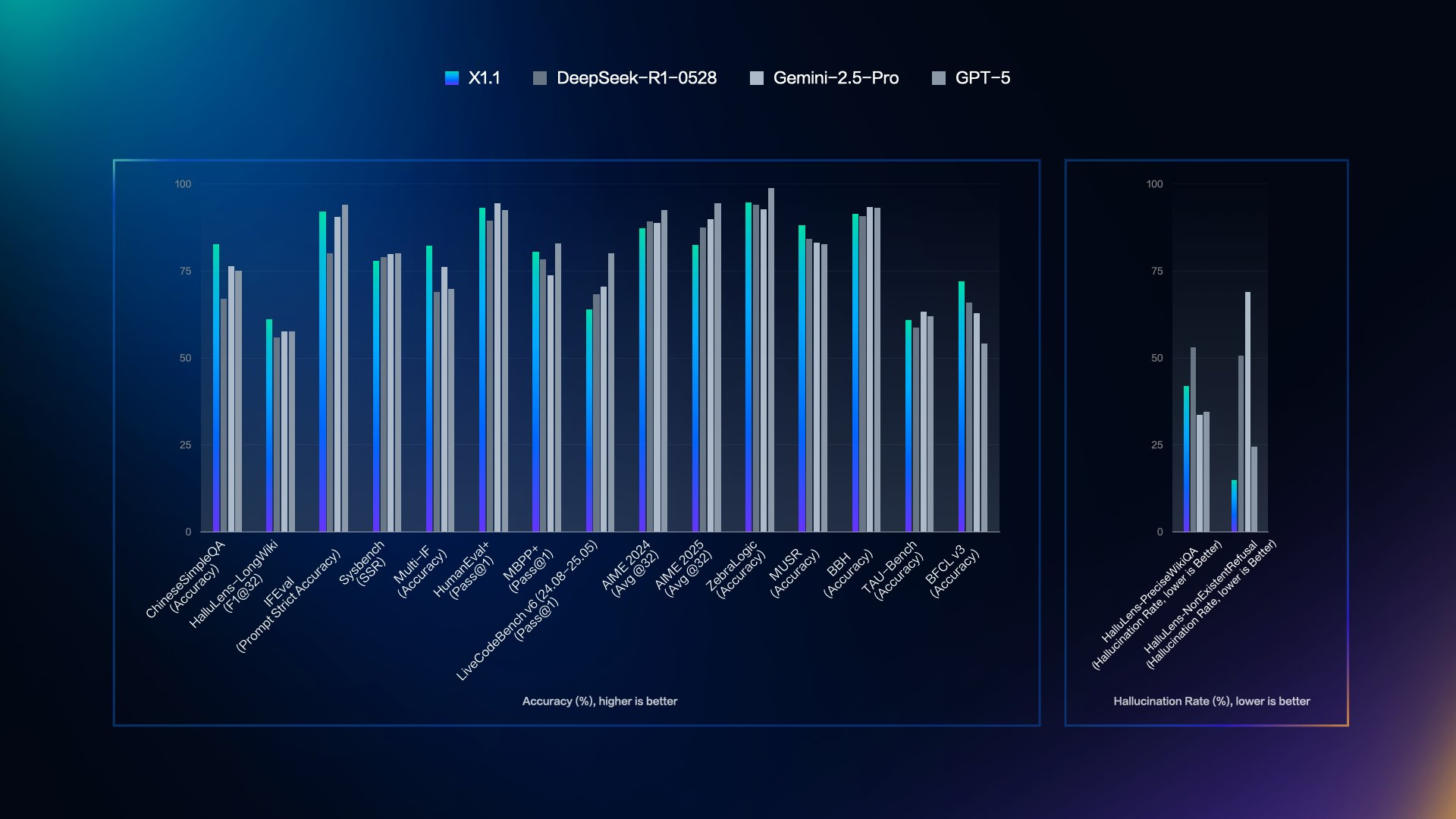

パフォーマンス指標に移ると、ERNIE X1.1は最近の評価で示されているように、ベンチマークで優位性を示しています。

ERNIE X1.1のベンチマークパフォーマンス:競合他社を凌駕

BaiduはERNIE X1.1を、DeepSeek R1-0528、Gemini 2.5 Pro、GPT-5などのトップモデルと比較評価しており、精度と低いハルシネーション率におけるその強みを明らかにしています。発表会からの主要なビジュアルは、複数のベンチマークにわたるこれらの比較を示しています。

対照的に、ハルシネーション率のパネルは、HalluQA(Hallu-Precision、非存在性が低いほど良い)、Hallu Lens(率、低いほど良い)などを網羅しています。ここでは、ERNIE X1.1が最も低いバーを示しており、最小限のエラーを示しています。例えば、HalluQAでは25%未満です。

このデータは、ERNIE X1.1が全体的なパフォーマンスでDeepSeekを上回り、GPT-5と同等のレベルを維持していることを強調しています。開発者は、精度が要求されるタスクのモデルを選択する際に、これらの指標から恩恵を受けます。さて、アクセスを設定して実践的な実装に移りましょう。

QianfanプラットフォームでERNIE X1.1 APIを始める

Baidu AI CloudのWenxin Qianfanプラットフォームに登録することから始めます。公式ウェブサイトにアクセスし、メールアドレスまたは電話番号を使用して開発者アカウントを作成します。確認後、ERNIEモデルへのAPIアクセスを申請します。Baiduは通常数時間以内に申請を迅速に審査し、クライアントIDとシークレットキーを付与します。

次に、必要なSDKをインストールします。Pythonユーザーはpip経由でQianfan SDKを使用します:pip install qianfan。このライブラリは認証とリクエストを効率的に処理します。JavaやGoなどの他の言語の場合、Baiduは同様のインターフェースを持つ同等のSDKを提供しています。

インストール後、環境変数を設定します。QIANFAN_AKにはアクセスキーを、QIANFAN_SKにはシークレットキーを設定します。この手順により、スクリプトにハードコードすることなく、資格情報を保護します。セットアップが完了したら、認証に進みます。

ERNIE X1.1 APIへのリクエスト認証

Qianfanプラットフォームは認証にOAuth 2.0を使用します。トークンエンドポイントにPOSTリクエストを送信してアクセストークンを生成します。Pythonでは、Qianfan SDKがこのプロセスを自動化します。手動で実装する場合は、次のようにリクエストを構築します。

import requests

url = "https://aip.baidubce.com/oauth/2.0/token"

params = {

"grant_type": "client_credentials",

"client_id": "YOUR_CLIENT_ID",

"client_secret": "YOUR_CLIENT_SECRET"

}

response = requests.post(url, params=params)

access_token = response.json()["access_token"]

トークンは30日後に期限切れになるため、保存し、必要に応じて更新します。access_tokenクエリパラメータを介してAPI呼び出しに添付します。この方法により、安全な通信を保証します。ただし、漏洩を防ぐため、常にトークンを慎重に扱ってください。

認証が完了したら、ERNIE X1.1の適切なエンドポイントをターゲットにします。

ERNIE X1.1 APIエンドポイントとリクエスト構造

BaiduはERNIE APIを/chatパスの下に構造化しています。ERNIE X1.1の場合、利用可能なバリアントに基づいて、/chat/ernie-x1.1または拡張コンテキスト用に/chat/ernie-x1.1-32kのエンドポイントを使用します。初期展開時には「ernie-x1.1-preview」として表示される可能性があるため、Qianfanダッシュボードで正確なモデル名を確認してください。

JSONボディを持つPOSTリクエストを送信します。主要なパラメータは次のとおりです。

messages: 「role」(ユーザーまたはアシスタント)と「content」を持つ辞書のリスト。temperature: ランダム性を制御します(0.0-1.0、デフォルト0.8)。top_p: 核サンプリングしきい値(デフォルト0.8)。stream: ストリーミング応答用のブール値。

リクエストボディの例:

{

"messages": [

{"role": "user", "content": "Explain quantum computing."}

],

"temperature": 0.7,

"top_p": 0.9,

"stream": false

}

ヘッダーにはContent-Type: application/jsonと、URLにアクセストークンを含める必要があります:https://aip.baidubce.com/rpc/2.0/ai_custom/v1/wenxinworkshop/chat/ernie-x1.1?access_token=YOUR_TOKEN。

この形式は、単一ターンおよび複数ターンの会話をサポートします。マルチモーダル入力の場合、URLまたはbase64データを含む「image」のような「type」フィールドを追加します。

ERNIE X1.1 APIからの応答処理

応答はJSON形式で届きます。主要なフィールド:

result: 生成されたテキスト。usage: プロンプト、完了、合計のトークン数。id: 一意の応答識別子。

ストリーミングモードでは、Server-Sent Events (SSE) を介してチャンクを処理します。各イベントには部分的な結果が含まれます。Pythonでは次のように解析します。

import qianfan

chat_comp = qianfan.ChatCompletion()

resp = chat_comp.do(model="ERNIE-X1.1", messages=[{"role": "user", "content": "Hello"}], stream=True)

for chunk in resp:

print(chunk["result"])

「error_code」フィールドでエラーを確認します。一般的な問題には、無効なトークン(コード110)やレート制限(コード18)が含まれます。サブスクリプションによって異なるクォータ内で使用量を監視します。無料ティアは100 QPSに制限されますが、有料プランはより高くスケールします。

基本を網羅したら、開発者は効率的なテストのためにApidogのようなツールに目を向けることがよくあります。

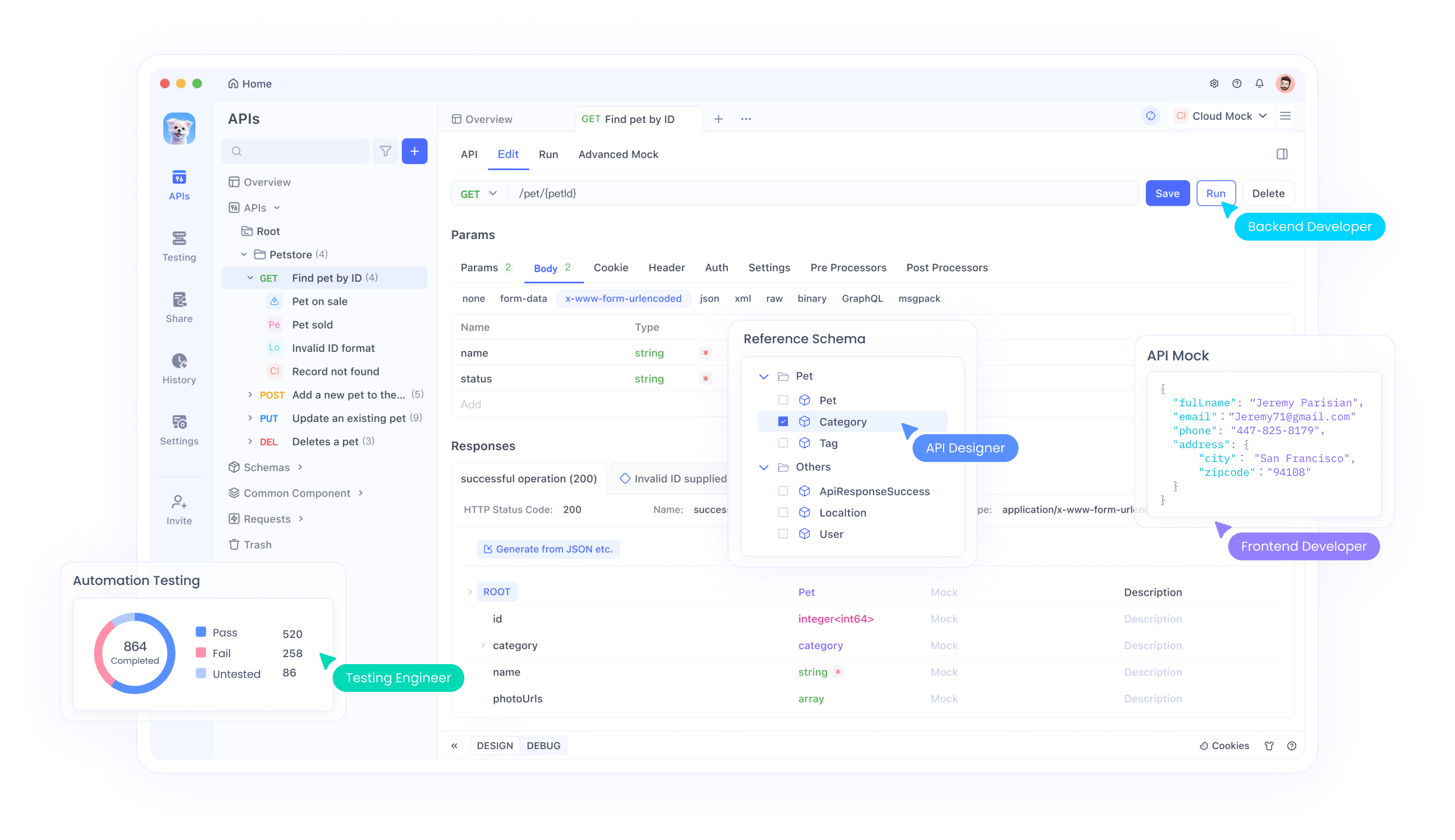

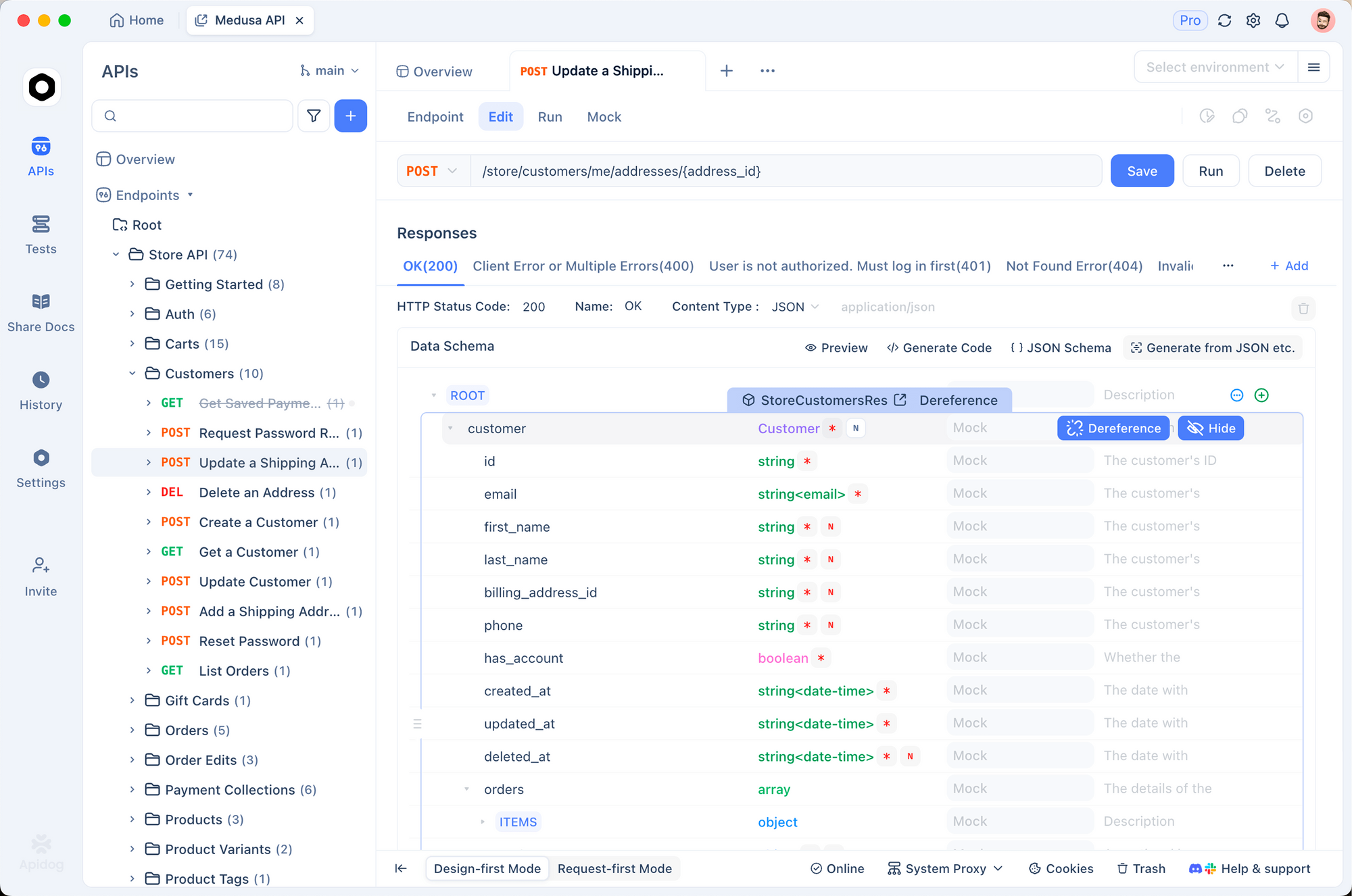

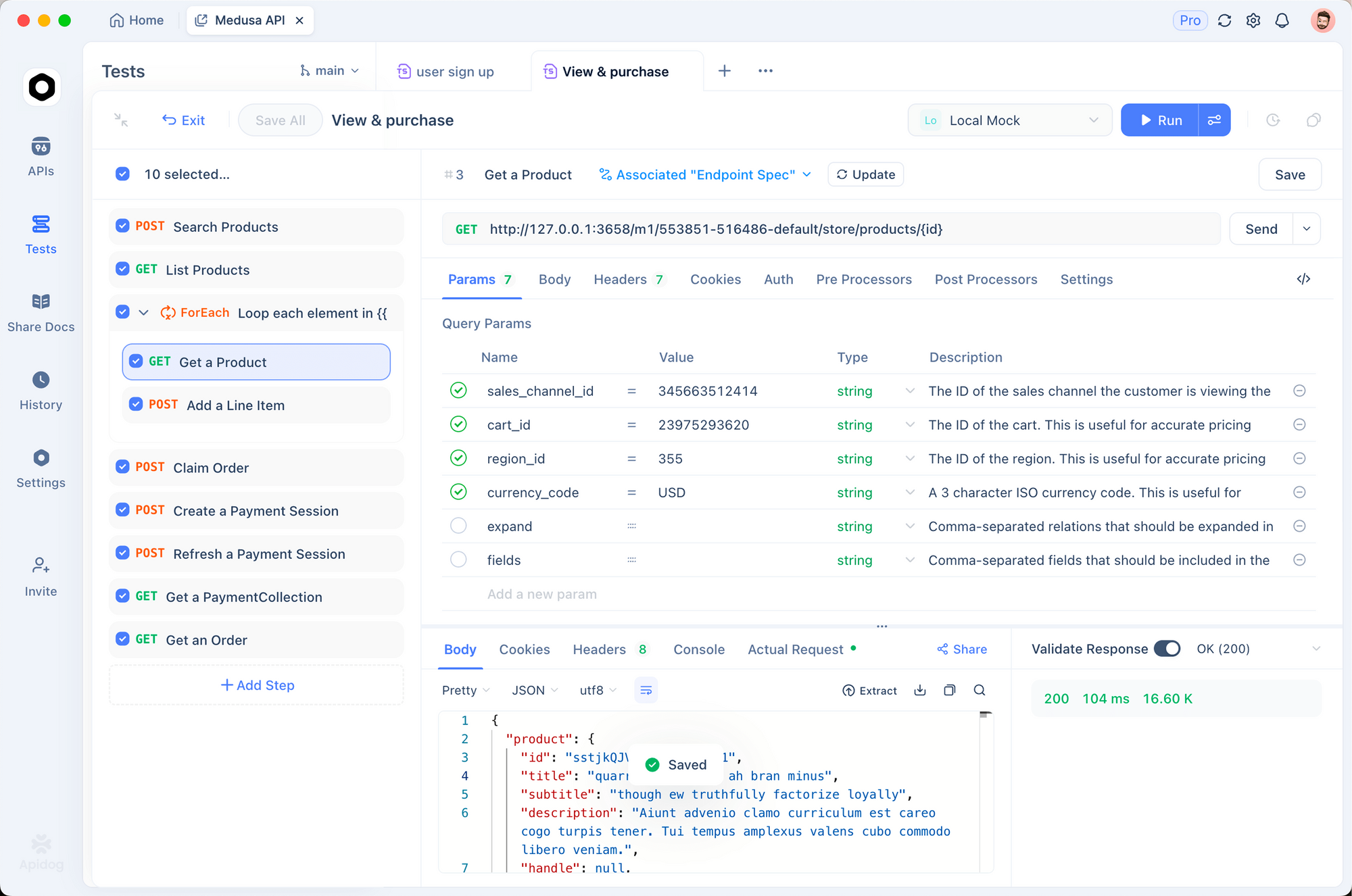

Apidogを使用したERNIE X1.1 APIテスト

ApidogはERNIE X1.1 APIエンドポイントのテストに優れたプラットフォームとして機能します。リクエストの設計、デバッグ、自動化のための直感的なインターフェースを提供し、共同開発において優れています。

まず、Apidogを公式ウェブサイトからダウンロードしてインストールします。新しいプロジェクトを作成し、ERNIE API仕様をインポートします。ApidogはOpenAPIのインポートをサポートしているため、Baiduの仕様が利用可能であればダウンロードするか、手動でエンドポイントを追加します。

リクエストを設定するには、APIセクションに移動し、/chat/ernie-x1.1の新しいPOSTメソッドを作成します。クエリパラメータにアクセストークンを入力します。ボディタブで、メッセージとパラメータを含むJSON構造を構築します。Apidogの変数システムを使用すると、トークンやプロンプトをパラメータ化して再利用できます。

リクエストを送信し、リアルタイムで応答を検査します。ApidogはJSON構造を強調表示し、タイミングを追跡し、エラーをログに記録します。例えば、「データ分析のためのPythonスクリプトを生成してください」という簡単なクエリをテストします。「result」フィールドの正確性を分析します。

さらに、シナリオを作成してテストを自動化します。複数ターンチャットをシミュレートするために複数のリクエストをリンクします。1つは初期プロンプト用、もう1つはフォローアップ用です。「usage.total_tokens」が1000未満であることを確認するなど、アサーションを使用して応答キーを検証します。

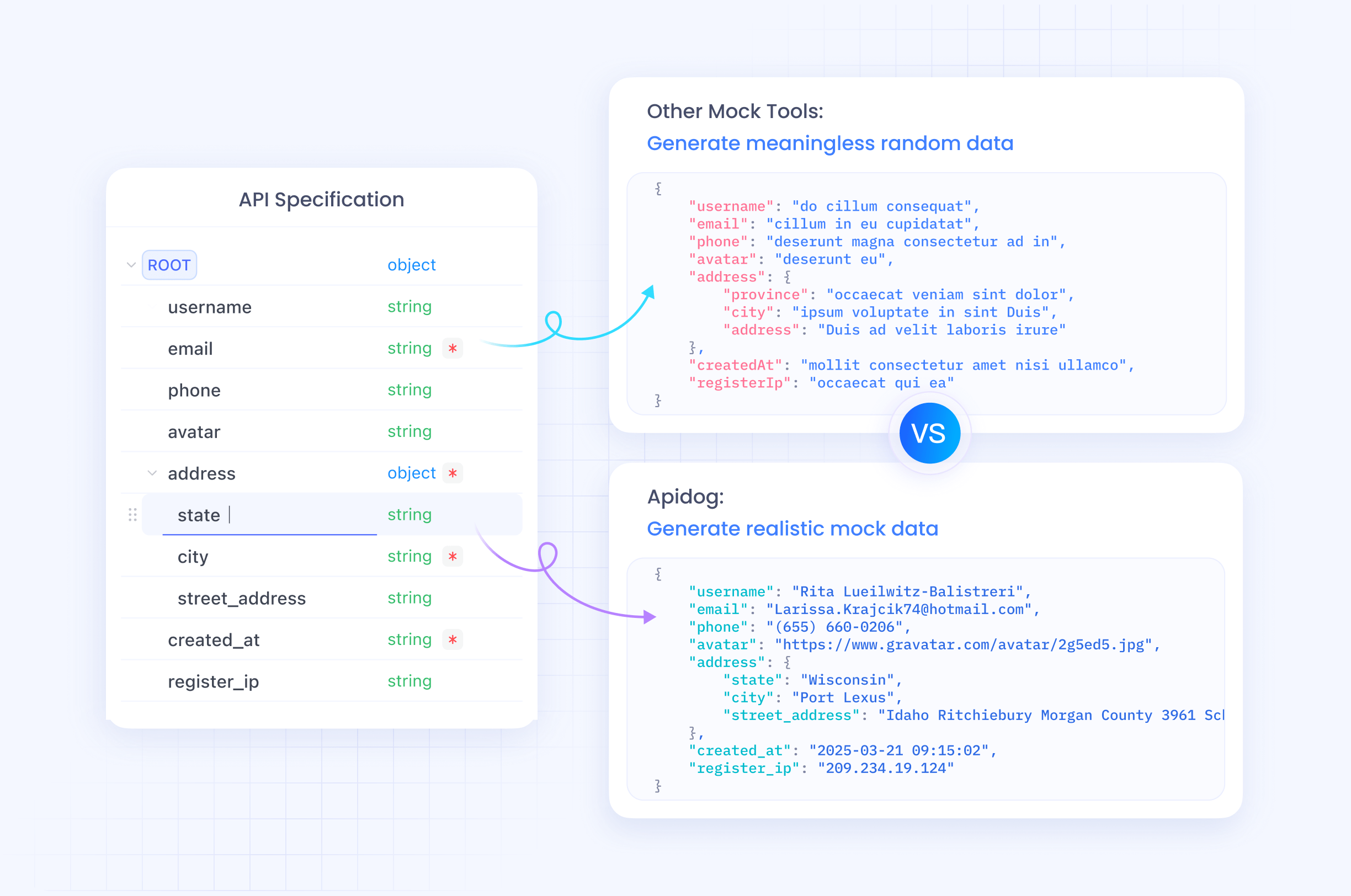

Apidogはオフライン開発のためのモックにおいて優れています。ERNIE X1.1の応答を模倣するモックサーバーを作成し、ライブAPI呼び出しなしでチームコラボレーションを可能にします。フィードバックのためにリンクを介してプロジェクトを共有します。

高度なテストのために、データセットを統合します。さまざまなプロンプトを含むCSVファイルをアップロードし、バッチテストを実行して一貫性を評価します。このアプローチにより、長い入力がコンテキスト制限をトリガーするなどのエッジケースが明らかになります。

Apidogを組み込むことで、開発サイクルを加速できます。大規模なテスト中は、Baiduのレート制限を遵守することを忘れないでください。

ERNIE X1.1 APIの高度な機能

ERNIE X1.1は、外部ツールを呼び出すエージェントタスクにおいて優れています。リクエストに「tools」(名前、説明、パラメータを持つ関数定義の配列)を含めることでこれを有効にします。モデルは必要に応じてツール呼び出しで応答し、それを実行してフィードバックします。

例えば、天気ツールを定義します。

"tools": [

{

"type": "function",

"function": {

"name": "get_weather",

"description": "Get current weather",

"parameters": {

"type": "object",

"properties": {"location": {"type": "string"}}

}

}

}

]

ERNIE X1.1はプロンプトを処理し、tool_callを出力し、次のメッセージで結果を応答します。

さらに、マルチモーダル入力を活用します。メッセージ内でbase64を介して画像をアップロードします:{"role": "user", "content": [{"type": "image_url", "image_url": {"url": "data:image/jpeg;base64,..."}}]}。これにより、シーンの描写やチャートの分析など、ビジョンベースの推論を可能にします。

LangChainのようなフレームワークと統合して、連鎖的な操作を行います。QianfanChatEndpointを使用します。

from langchain_community.chat_models import QianfanChatEndpoint

llm = QianfanChatEndpoint(model="ernie-x1.1")

response = llm.invoke("Summarize this text...")

この抽象化により、複雑なワークフローが簡素化されます。レート制限は通常、入力に対して1分あたり2000トークンが上限ですが、エンタープライズプランではカスタムスケーリングが提供されます。価格は低く、X1バリアントの場合、入力トークン100万あたり約0.28ドルから始まります。

ERNIE X1.1 API統合のベストプラクティス

エンジニアは、正確なプロンプトを作成することでパフォーマンスを最適化します。システムメッセージを使用して役割を設定します:{"role": "system", "content": "You are a helpful assistant."}。これにより、行動が効果的に導かれます。

コストを制御するためにトークン使用量を監視します。プロンプトをトリミングし、切り捨てパラメータを使用します。さらに、ネットワークの問題など、一時的なエラーに対しては、指数関数的バックオフを伴う再試行を実装します。

APIキーを環境変数またはボールトに安全に保管します。応答に機密データをログに記録しないようにします。本番環境では、頻繁なクエリに対してキャッシュを使用して呼び出しを減らします。

ERNIE X1.1は中国語に優れていますが、英語も適切に処理するため、複数の言語でテストします。事実Q&Aにおける低いハルシネーションなど、モデルの強みに対して統合をベンチマークします。

最後に、新しい機能やモデルの更新については、Baiduの開発者ポータルを通じて最新情報を入手してください。

ERNIE X1.1 APIの一般的な問題のトラブルシューティング

トークンが期限切れになると、ユーザーは認証エラーに遭遇します。速やかに更新してください。無効なモデル名は404応答をトリガーします。ダッシュボードで「ernie-x1.1」を確認してください。

レート制限超過は429エラーを引き起こします。キューイングを実装するか、プランをアップグレードしてください。不完全な応答の場合は、max_tokensパラメータをモデルの制限まで増やしてください。

Apidogのログでデバッグします。これらは完全なリクエスト/応答サイクルをキャプチャします。マルチモーダルが失敗した場合は、画像形式がサポートされているタイプ(JPEG、PNG)と一致していることを確認してください。

解決しない問題については、エラーコードとタイムスタンプを提供してBaiduサポートに連絡してください。

結論:ERNIE X1.1 APIでAIを向上させる

ERNIE X1.1は、開発者がインテリジェントで信頼性の高いアプリケーションを構築することを可能にします。セットアップから高度な統合まで、このガイドはERNIE X1.1の可能性を最大限に引き出すための知識を提供します。効率的なテストのためにApidogを組み込み、プロジェクトが成功するのを見守ってください。

AIが進化するにつれて、ERNIE X1.1のようなモデルが道を切り開いています。今すぐ実装を開始し、精度と効率の違いを体験してください。