エンジニアや開発者は、パフォーマンス、効率性、アクセシビリティのバランスが取れた強力な言語モデルを常に求めています。DeepSeek-V3.2-Expは、この分野における重要な進歩として登場し、複雑なAIタスクを処理するための堅牢なソリューションを提供します。DeepSeek-AIによって開発されたこの実験的なモデルは、DeepSeek-V3.1-Terminusの基盤を直接引き継いでいます。大規模な言語処理、特に長文コンテキストのシナリオにおける主要な課題に対処する革新的な機能を組み込んでいます。

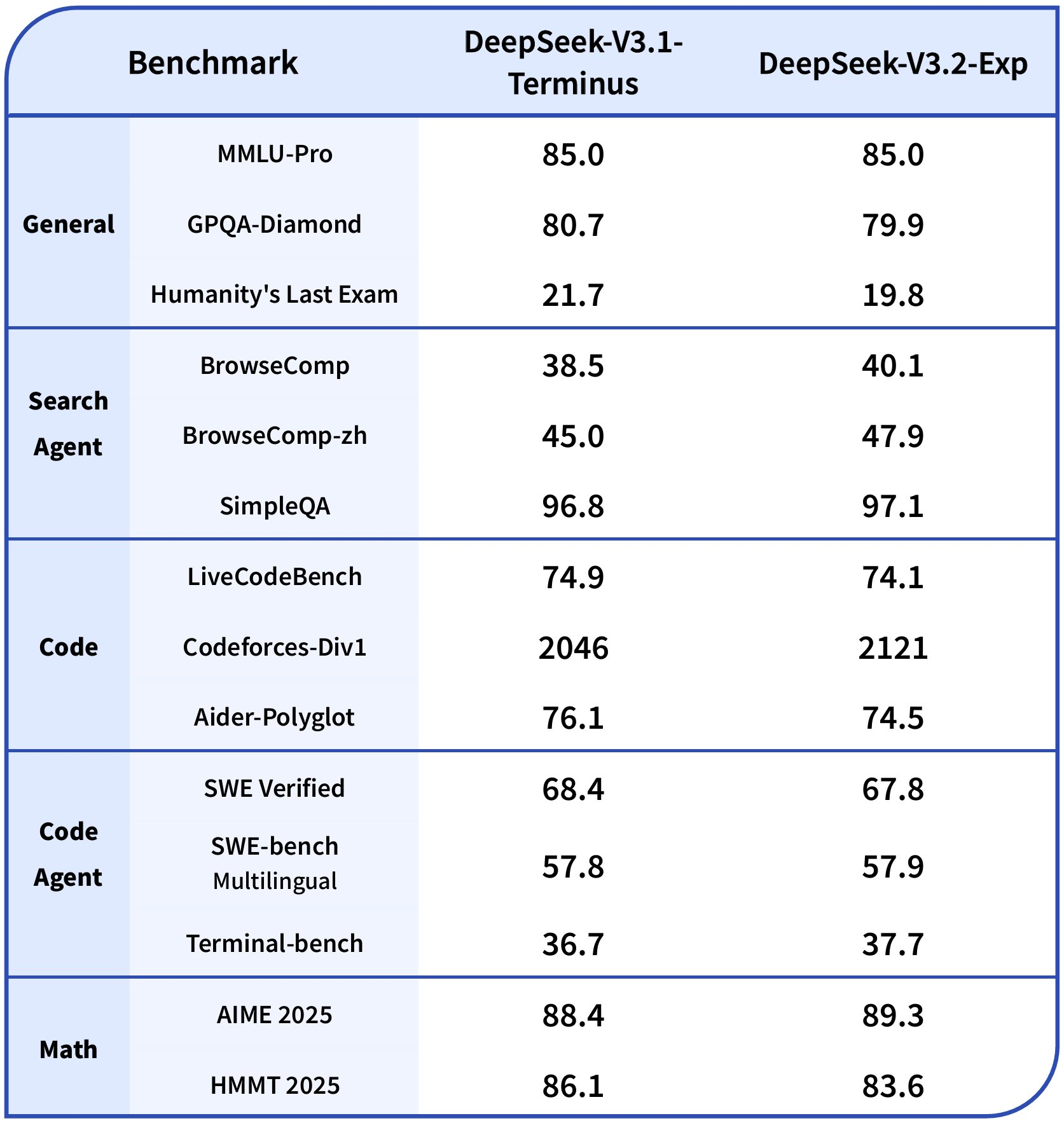

DeepSeek-V3.2-Expは6,850億のパラメーターを誇り、今日利用可能なオープンソースモデルの中で最も高性能なものの1つです。その核となるのは、きめ細かなスパースアテンション計算を可能にするDeepSeek Sparse Attention (DSA) メカニズムです。この革新により、計算オーバーヘッドを削減しつつ出力品質を維持し、モデルが先行モデルよりも効率的に拡張されたコンテキストを処理できるようになります。ベンチマークでは、DeepSeek-V3.2-Expが推論、コーディング、エージェントツール使用など、多様なタスクにおいてDeepSeek-V3.1-Terminusと同等の性能を発揮することが示されています。

例えば、ツールを使用しない推論ベンチマークでは、DeepSeek-V3.2-ExpはMMLU-Proで85.0、AIME 2025で89.3といったスコアを達成しています。エージェントシナリオでは、BrowseCompで40.1、SWE Verifiedで67.8と優れた成績を収めています。これらの結果は、スパースアテンションの影響を厳密に評価する整合性の取れたトレーニング設定に由来します。さらに、Hugging Faceでホストされているモデルのオープンソース性は、コミュニティからの貢献やローカル展開を促進します。

モデルの概要から実用的な実装へ移行する次のステップは、DeepSeek-V3.2-Exp API自体にアクセスすることです。

DeepSeek-V3.2-Exp APIへのアクセス

DeepSeek-V3.2-Expの機能を理解したら、実際のアプリケーション向けにそのAPIにアクセスします。DeepSeekは業界標準に準拠したシンプルなAPIを提供しており、既存システムへの迅速な統合を容易にします。

まず、DeepSeekプラットフォームに登録して認証情報を取得します。

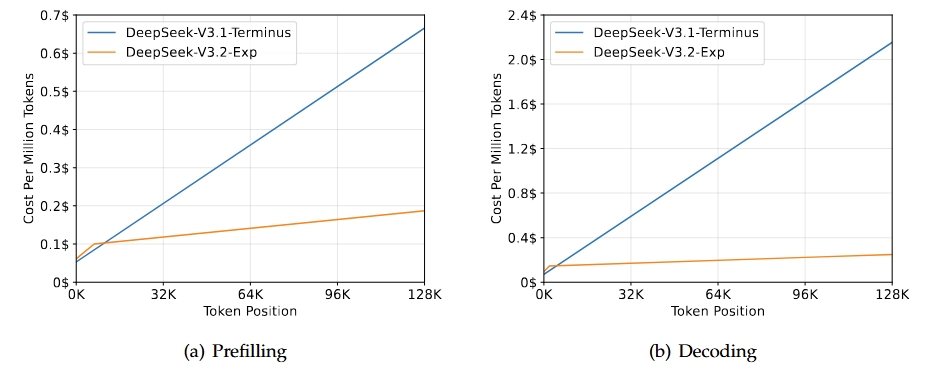

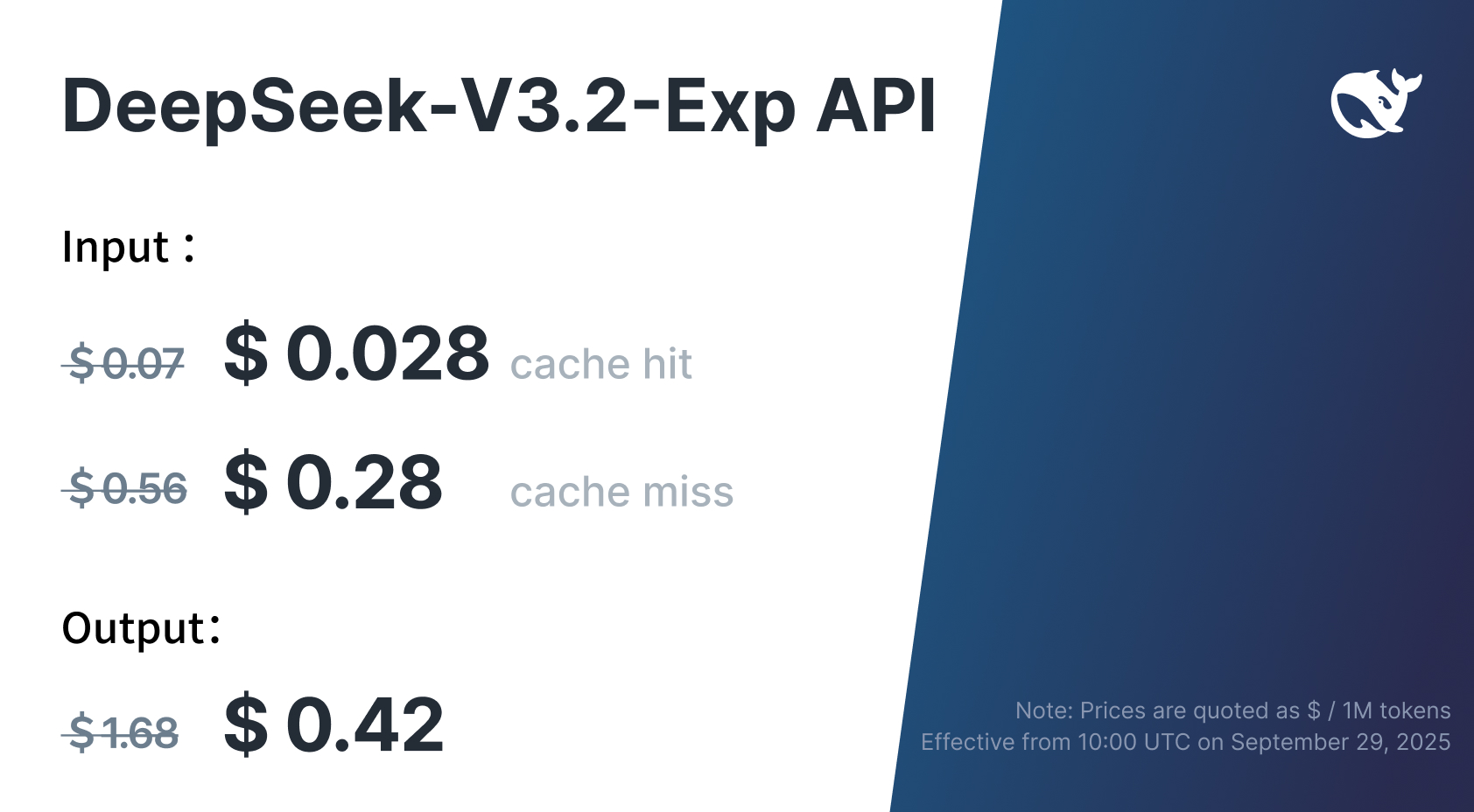

このAPIは、OpenAIのSDKのような人気のあるフレームワークとの互換性をサポートしており、同様のインターフェースに慣れているチームにとって導入が容易になります。標準アクセスの場合、ベースURLをhttps://api.deepseek.comに設定します。これはデフォルトでDeepSeek-V3.2-Expに設定されます。この設定により、リリースと同時に発表されたAPI料金の50%以上の削減を含む、モデルの強化された効率性を活用できます。

比較目的のため、DeepSeekは一時的にDeepSeek-V3.1-Terminusへのアクセスを特別なエンドポイント経由で維持しています: https://api.deepseek.com/v3.1_terminus_expires_on_20251015。これにより、エンジニアはDSAによる推論速度の向上など、パフォーマンスの違いをベンチマークできます。ただし、このエンドポイントは2025年10月15日15:59 UTCに期限切れとなるため、テスト計画はそれに応じて立ててください。

さらに、このAPIはAnthropicのエコシステムとの互換性も拡張しています。ClaudeのようなインタラクションにはベースURLをhttps://api.deepseek.com/anthropicに、以前のバージョンにはhttps://api.deepseek.com/v3.1_terminus_expires_on_20251015/anthropicに調整してください。この柔軟性により、ウェブアプリからコマンドラインツールまで、多様な開発環境がサポートされます。

アクセスが確立されたら、認証がインタラクションを保護するための次の重要な層となります。

認証とAPIキー管理

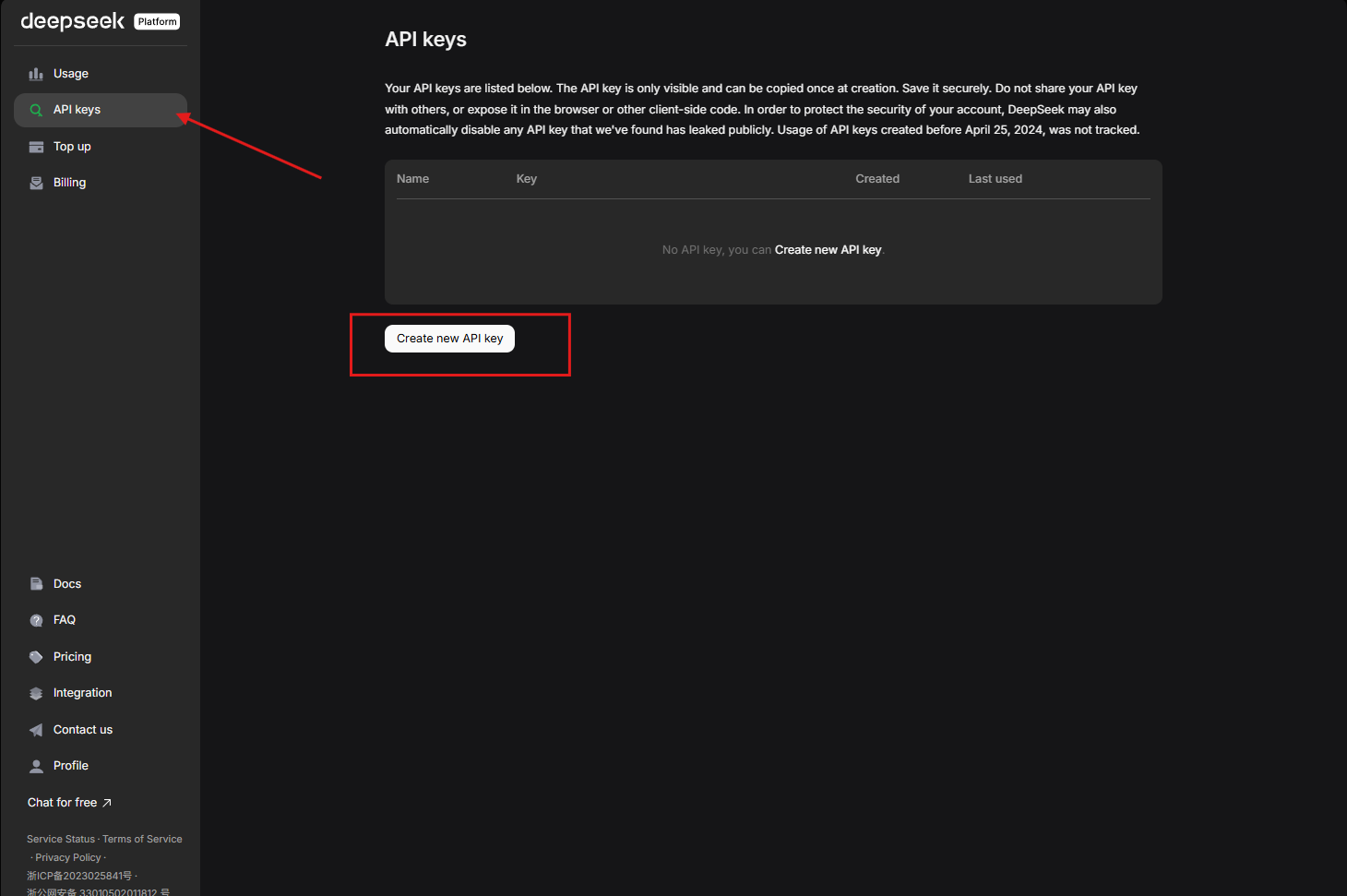

セキュリティは信頼性の高いAPI利用の基盤であるため、APIキーを使用してリクエストを認証します。DeepSeekでは、プラットフォームダッシュボードからキーを生成する必要があります。このキーは一意の識別子として機能し、DeepSeek-V3.2-Expのようなモデルへのアクセスを許可します。

各リクエストのAuthorizationヘッダーにキーを含めます: Bearer ${DEEPSEEK_API_KEY}。この方法はRESTfulのベストプラクティスに準拠しており、HTTPSを介した暗号化された送信を保証します。キーは常に安全に保管してください。コード内の環境変数やAWS Secrets Managerのようなシークレット管理サービスを使用して、露出を避けるようにしてください。

さらに、プラットフォームのダッシュボードを通じて使用状況を監視し、トークン消費量と請求を追跡します。価格引き下げにより、DeepSeek-V3.2-Expは費用対効果の高いスケーリングを提供しますが、予期せぬ料金を防ぐためにアプリケーションでレート制限を実装してください。チームの場合、キーを定期的にローテーションし、侵害されたキーは直ちに失効させてください。

認証に基づいて、DeepSeek-V3.2-Expとのインタラクションを可能にするコアエンドポイントについて説明します。

DeepSeek-V3.2-Exp APIの主要エンドポイントとリクエスト形式

DeepSeek-V3.2-Exp APIは、チャット補完、推論、関数呼び出しを処理する主要なエンドポイントを中心に展開しています。主に、会話型入力を処理する/chat/completionsエンドポイントを介してインタラクションを行います。

JSONボディを使用してhttps://api.deepseek.com/chat/completionsにPOSTリクエストを構築します。標準モードではモデルを「deepseek-chat」として、強化された思考能力には「deepseek-reasoner」として指定します。messages配列には会話履歴が保持されます。システムプロンプトは動作を定義し、ユーザーロールはクエリを入力します。

{

"model": "deepseek-chat",

"messages": [

{

"role": "system",

"content": "You are a technical expert."

},

{

"role": "user",

"content": "Explain sparse attention."

}

],

"stream": false

}

リアルタイム応答には「stream」をtrueに設定します。これはインタラクティブなアプリケーションに最適です。ヘッダーにはContent-Type: application/jsonとAuthorizationベアラートークンを含める必要があります。

さらに、このAPIは、後続の呼び出しのためにアシスタントの応答をメッセージ配列に追加することで、複数回の会話をサポートします。これにより、インタラクション全体でコンテキストが維持され、DeepSeek-V3.2-Expの長文コンテキストの強みが活用されます。

さらに、ツール統合のために関数呼び出しを組み込みます。リクエストでツールを定義すると、モデルはクエリに基づいて適切なツールを選択します。このエンドポイントは、データ取得やコード実行などのエージェントワークフローを強化します。

出力を中心に考えると、応答構造を理解することがコードでの効果的なパースを保証します。

DeepSeek-V3.2-Exp APIにおける応答構造と処理

DeepSeek-V3.2-Exp APIからの応答は予測可能なJSON形式に従っており、簡単な統合を可能にします。非ストリーム応答には、id、object、created、model、choices、usageなどのフィールドが含まれます。

choices配列には生成されたコンテンツが含まれます。各選択肢には、ロールが「assistant」のメッセージと応答テキストが含まれます。使用状況の詳細では、prompt_tokens、completion_tokens、total_tokensが追跡され、コスト監視に役立ちます。

ストリーム応答の場合、APIはServer-Sent Events (SSE) を送信します。各チャンクはデータイベントとして到着し、コンテンツへのデルタ更新を含むJSONオブジェクトが含まれます。これらを増分的にパースして完全な応答を構築します。これはライブチャットインターフェースに適しています。

エラーは適切に処理してください。一般的なコードには、認証失敗の401とレート制限の429があります。信頼性を維持するために、指数バックオフ再試行を実装してください。

リクエストと応答について説明したので、実際のコード例で実装を示します。

DeepSeek-V3.2-Exp APIを統合するためのPythonコード例

開発者は、そのシンプルさと豊富なライブラリのため、Pythonから始めることが多いです。互換性のためにOpenAI SDKを活用してください。

import openai

openai.api_base = "https://api.deepseek.com"

openai.api_key = "your_api_key_here"

response = openai.ChatCompletion.create(

model="deepseek-chat",

messages=[

{"role": "system", "content": "You are a coding assistant."},

{"role": "user", "content": "Write a Python function to calculate Fibonacci numbers."}

],

stream=False

)

print(response.choices[0].message.content)

# This code generates a complete response. For streaming:

def stream_response():

stream = openai.ChatCompletion.create(

model="deepseek-chat",

messages=[...],

stream=True

)

for chunk in stream:

if chunk.choices[0].delta.content is not None:

print(chunk.choices[0].delta.content, end="")

# Extend this to multi-turn chats by storing and appending messages. For function calling:

tools = [

{

"type": "function",

"function": {

"name": "get_weather",

"description": "Get current weather",

"parameters": {

"type": "object",

"properties": {

"location": {"type": "string"}

},

"required": ["location"]

}

}

}

]

create呼び出しにツールを含め、応答に基づいて選択された関数を実行します。

基本的な例を超えて、高度なユースケースでは、構造化された出力のためにJSONモードが関与します。データ抽出タスクに役立つJSON応答を強制するには、response_formatを{"type": "json_object"}に設定します。

コードからさらに進んで、Apidogのような専門ツールとの統合は、開発プロセスを向上させます。

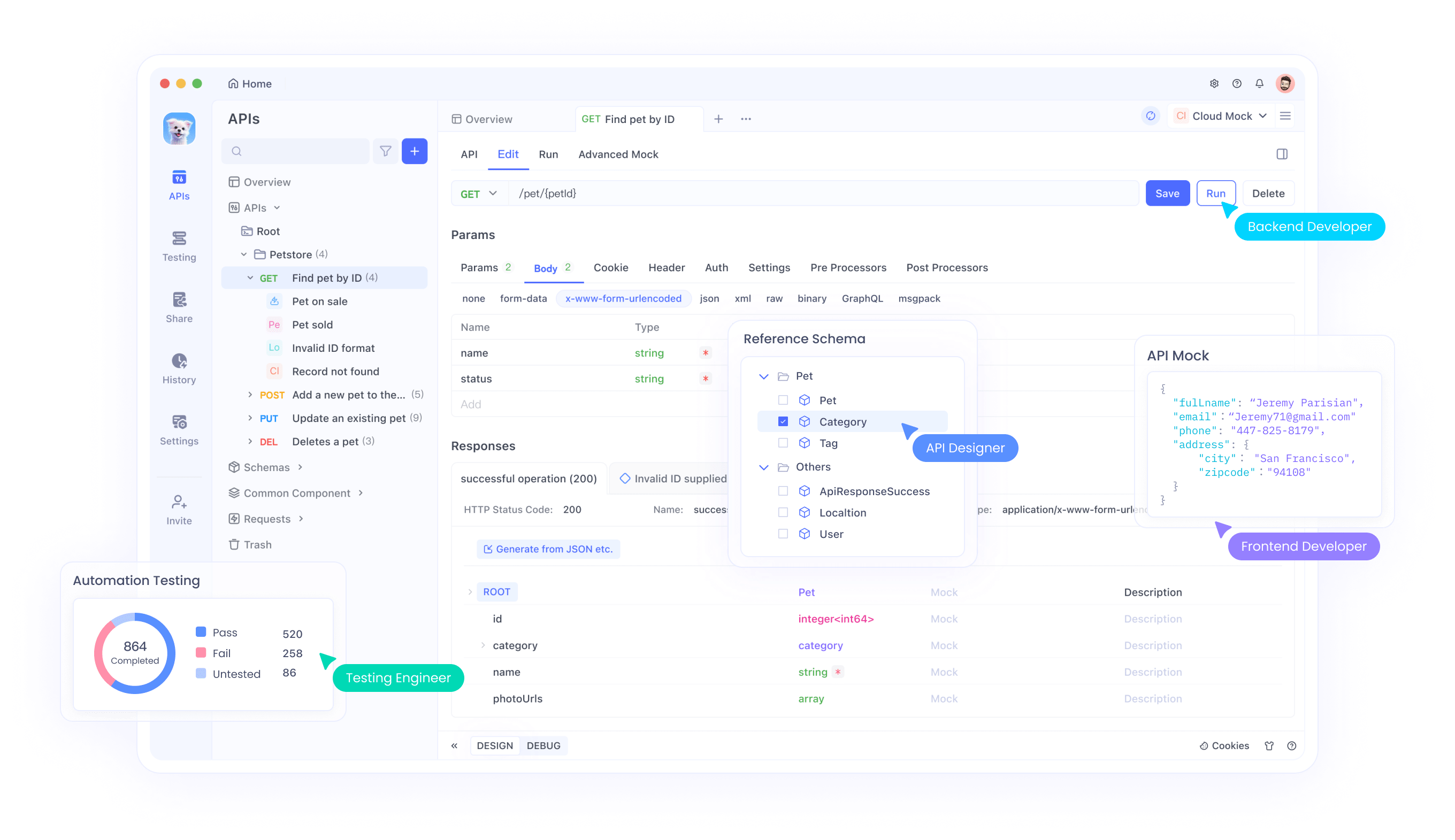

DeepSeek-V3.2-Exp APIとApidogの統合

Apidogは、テストと統合を加速する多機能なAPI管理ツールとして際立っています。DeepSeek-V3.2-Exp API仕様をApidogに直接インポートし、チャット補完のようなエンドポイントのコレクションを作成できます。

まずDeepSeekでAPIキーを生成し、Apidogの環境変数を設定して安全に保存します。Apidogのリクエストビルダーを使用してPOST呼び出しを作成します。URL、ヘッダー、ボディを設定し、送信して即座に応答を受け取ります。

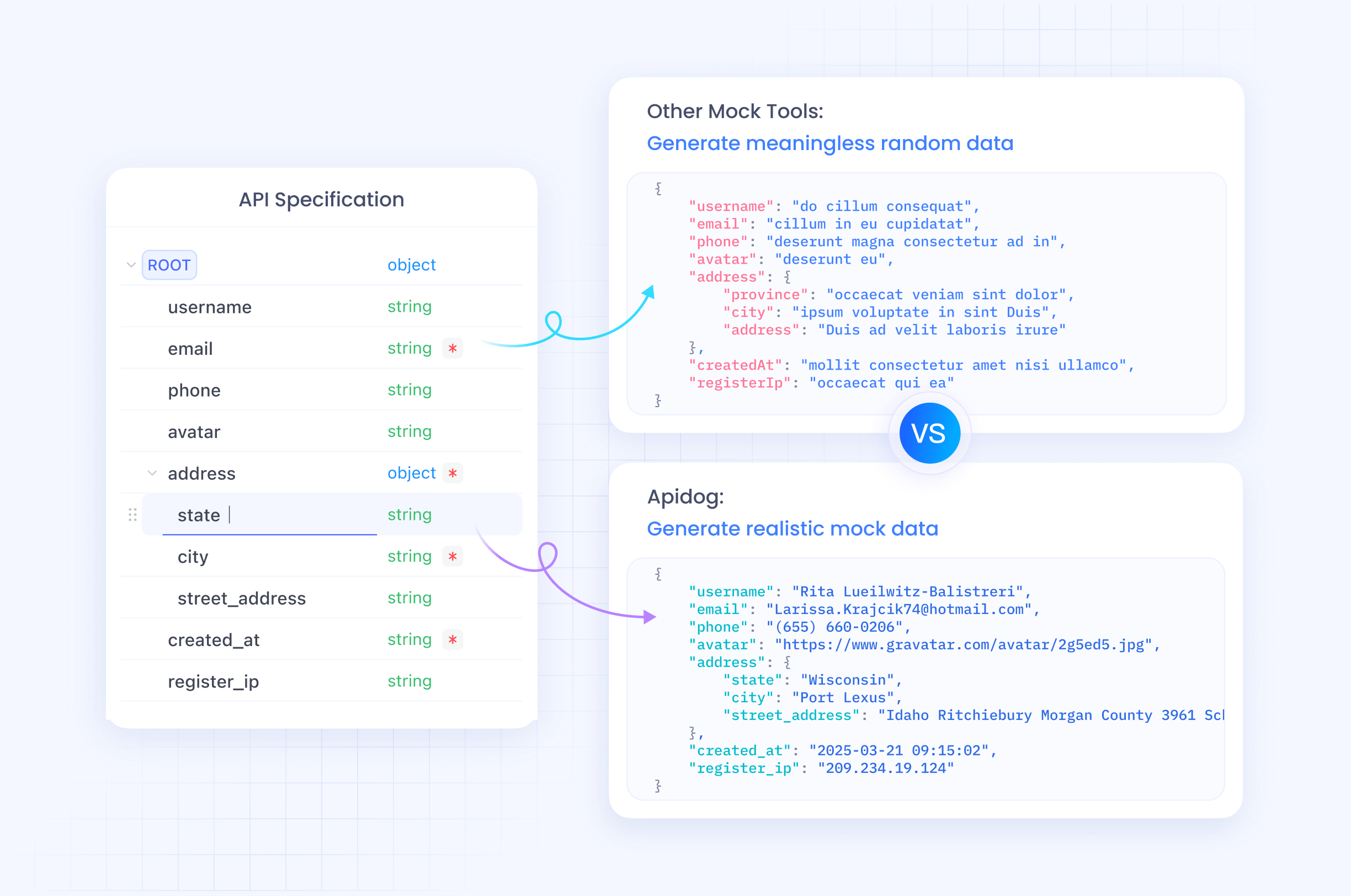

Apidogはオフライン開発のためのモック応答に優れており、APIコストを発生させることなくDeepSeek-V3.2-Expの出力をシミュレートしてエッジケースをテストできます。さらに、成功したリクエストからPythonやJavaScriptなどの言語でコードスニペットを生成し、実装を加速できます。

デバッグには、Apidogのタイムラインビューがリクエスト履歴を追跡し、認証やパラメータの問題を特定します。DeepSeek-V3.2-Expは長文コンテキストをサポートしているため、Apidogで拡張されたプロンプトをテストしてパフォーマンスを確認します。

さらに、Apidogプロジェクトを共有することでチームと共同作業を行い、開発者全体で一貫したAPI使用を保証します。この統合は時間を節約するだけでなく、AI機能をデプロイする際の信頼性も向上させます。

スケールするにつれて、ベストプラクティスはDeepSeek-V3.2-Exp APIから最適な結果を保証します。

DeepSeek-V3.2-Exp APIを使用するためのベストプラクティス

DeepSeek-V3.2-Expの強みを最大限に引き出すために、プロンプトを最適化します。明確で簡潔なシステムプロンプトを使用して動作を誘導し、複雑な問題には推論モードで思考連鎖手法を使用します。

トークン使用量を監視してください。DeepSeek-V3.2-Expは最大128Kのコンテキストを処理できますが、長さが過度になると効率が低下します。履歴をインテリジェントに切り捨てて制限内に収めるようにしてください。

頻繁なクエリにはキャッシュを実装して呼び出しを減らし、高スループットのシナリオでは可能な限りリクエストをバッチ処理します。

セキュリティ面では、プロンプトインジェクションを防ぐためにユーザー入力をサニタイズし、監査のためにインタラクションをログに記録します。

パフォーマンスチューニングのためには、temperatureとtop_pパラメータを試してください。低い値は決定論的な出力を生成し、高い値は創造性を促進します。

さらに、deepseek-chatモードとdeepseek-reasonerモードの間でA/Bテストを実施し、アプリケーションに最適なものを選択します。

比較に移行し、DeepSeek-V3.2-Expを先行モデルと比較評価します。

DeepSeek-V3.2-Expと以前のモデルの比較

DeepSeek-V3.2-Expは、主にDSAを通じてDeepSeek-V3.1-Terminusを超えて進化しており、ベンチマークの同等性を維持しながら、場合によっては推論速度を3倍に向上させます。

コーディングタスクでは、Codeforcesで2046に対して2121を記録し、わずかな改善を示しています。しかし、人文科学系の試験では、Humanity's Last Examで21.7に対して19.8といったわずかな低下が見られ、改善の余地があることを示しています。

直接比較のために以前のモデルに一時的にアクセスし、記載されているようにベースURLを調整します。これにより、文書要約のようなアプリケーションにとって重要な、長文コンテキスト処理におけるDSAの効率向上が明らかになります。

Apidogのようなツールを使用して並行テストを実行し、情報に基づいた意思決定のためにメトリクスを記録します。

さらに拡張して、DeepSeek-V3.2-Expが輝くユースケースを探ります。

DeepSeek-V3.2-Exp APIの一般的な問題のトラブルシューティング

401エラーが発生しましたか?APIキーとヘッダー形式を確認してください。

レート制限に達しましたか?バックオフロジックを実装してください: 再試行の間に徐々に長く待機します。

予期せぬ出力ですか?プロンプトを改善するか、max_tokensのようなパラメータを調整してください。

ストリームの問題については、クライアントがSSEを正しく処理し、バッファリングの遅延なしにチャンクをパースすることを確認してください。

コンテキストが制限を超えた場合は、追加する前に以前のメッセージを要約してください。

DeepSeekのフィードバックフォームを通じて永続的な問題を報告し、モデルの改善に貢献してください。

最後に、より高度な制御のためにローカル展開を検討してください。

ローカル展開と高度な設定

APIだけでなく、Hugging Faceの重みを使用してDeepSeek-V3.2-Expをローカルで実行することもできます。提供されたスクリプトでチェックポイントを変換し、エキスパート数(256)とGPUに基づいたモデル並列処理を指定します。

インタラクティブなテストのために推論デモを起動し、最適化されたパフォーマンスのためにTileLangまたはCUDAカーネルを利用します。

この設定は、プライバシーに敏感なアプリケーションやオフライン環境に適しています。

要約すると、DeepSeek-V3.2-Exp APIは、最先端のAI機能を開発者に提供します。

結論: DeepSeek-V3.2-Expを活用した未来のイノベーション

DeepSeek-V3.2-Expは、効率的なAIモデリングにおける飛躍を意味し、そのAPIはアクセスしやすいエントリーポイントを提供します。認証から高度な統合まで、このガイドは堅牢なアプリケーションを構築するための準備を整えます。実験し、反復し、限界を押し広げてください。プロンプトや設定の小さな改良が、しばしば大きな成果をもたらします。