世界中の開発者は、ワークフローを効率化し、複雑なプログラミングタスクに取り組むために、OpenAIの強力なAI駆動型コーディングアシスタントであるCodeXに依存しています。しかし、Xのようなプラットフォームでの最近の議論では、懸念が高まっていることが明らかになっています。多くのユーザーは、CodeXが初期のパフォーマンスと比較して最適ではない結果を提供していると認識しています。イライラするバグ、応答の遅延、不完全なコード提案に遭遇し、このツールが実際に劣化しているのではないかと疑問に思うかもしれません。この認識は、OpenAIが継続的な改善と使用量の増加を示す指標を主張しているにもかかわらず、根強く残っています。

エンジニアは、CodeXがパッチの適用や長時間の会話の処理など、複雑なタスクで苦戦する事例を報告しており、これが性能低下の憶測につながっています。しかし、OpenAIのチームは、厳格な調査を通じてこれらの問題に積極的に対処し、透明性へのコミットメントを示しています。例えば、彼らは最近、ユーザーフィードバックと内部評価からの調査結果をまとめた詳細なレポートを公開しました。

CodeXの理解:その中核機能と進化

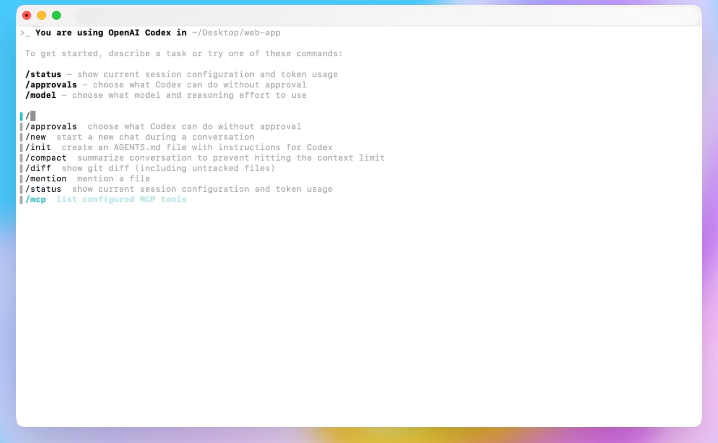

CodeXは、OpenAIの大規模言語モデルの基盤の上に構築された、AIアシストプログラミングにおける重要な進歩を象徴しています。エンジニアはCodeXを、自然言語のプロンプトを解釈し、コードスニペットを生成し、問題をデバッグし、さらにはリポジトリ全体を管理するように設計しています。従来のIDEプラグインとは異なり、CodeXはコマンドラインインターフェースやエディターと深く統合されており、シームレスな対話を可能にします。

OpenAIは、Codexのような初期のモデルの進化形としてCodeXをリリースし、GPT-5アーキテクチャからの強化を取り入れました。このイテレーションは永続性に焦点を当てており、AIがタスクを再試行し、セッション内でユーザーフィードバックに適応できるようにします。その結果、開発者はCodeXを、簡単なスクリプト作成から複雑なシステム統合まで、多様なアプリケーションに使用しています。

しかし、採用が進むにつれて、ユーザーはCodeXの限界を押し広げています。例えば、初期のタスクは基本的な機能を含むかもしれませんが、上級ユーザーは複数ファイルの編集やAPIオーケストレーションを試みます。この変化は限界を露呈し、パフォーマンスの一貫性に関する疑問を提起しています。

さらに、CodeXはファイル変更のための`apply_patch`やコンテキスト管理のための`compaction`のようなツールを採用しています。これらの機能は使いやすさを向上させますが、結果に影響を与える変数を導入します。プロンプトを入力すると、CodeXはそれをレスポンスAPIを通じて処理し、トークンをストリーミングして結果を解析します。このパイプラインにおける不一致は、認識される性能低下として現れる可能性があります。

ユーザーレポート:CodeXが性能低下している可能性を示す兆候

ユーザーはソーシャルプラットフォームで積極的に経験を共有し、CodeXが期待に応えられない事例を強調しています。例えば、Xのある開発者は、CodeXが初期のタスクでは優れているものの、複雑さが増すにつれて苦戦し、モデルの性能低下の憶測につながっていると指摘しました。

具体的には、パッチ適用中にCodeXが誤った差分を生成し、ファイルの削除や再作成を引き起こすという報告があります。この挙動は、特に中断されたセッションでワークフローを妨害します。もう一つの一般的な苦情はレイテンシーに関するもので、かつては迅速に完了したタスクが、タイムアウトの延長を伴う再試行のために時間がかかるようになっています。

さらに、ユーザーは応答の途中で言語が切り替わる現象(英語から韓国語への切り替えなど)を観察しており、これは制約付きサンプリングのバグに起因するとされています。これらの異常はセッションの0.25%未満に影響しますが、遭遇すると不満を増幅させます。

加えて、コンテキストを管理するために会話を要約する機能である`compaction`が批判を受けています。セッションが長くなるにつれて、複数回のコンパクションが精度を低下させるため、OpenAIは「特定の対話には新しい会話を開始してください」という警告を追加するよう促されています。

さらに、ハードウェアのバリエーションも影響しています。古いセットアップではわずかなパフォーマンス低下が生じ、維持率に影響を与えます。プレミアムプランの開発者も一貫性のない動作を報告していますが、全体的な成長を示す指標もあります。

これらの報告から、定量的な証拠を分析することで、これらの問題が真の性能低下を示すのか、それとも使用法の進化を示すのかについて明確な見解が得られます。

証拠の分析:指標、フィードバック、および使用パターン

OpenAIは、CLIバージョンやハードウェア全体にわたる評価を含む、CodeXのパフォーマンスに関する広範なデータを収集しています。評価では、CLI 0.45アップデート後のトークン使用量の10%削減など、中核タスクにおける退行なしの改善が確認されています。

しかし、`/feedback`コマンドを介したユーザーフィードバックは傾向を明らかにしています。エンジニアは毎日100以上の問題をトリアージし、それらを特定のハードウェアや機能に紐付けています。予測モデルは、OSやプランの種類などの要因と維持率を関連付け、ハードウェアが軽微な原因であることを特定しています。

さらに、セッション分析では、時間の経過とともに`compaction`の使用量が増加し、パフォーマンスの低下と相関していることが示されています。評価ではこれを定量化しており、繰り返し`compaction`を行うと精度が低下します。

さらに、Web検索統合(`--search`)と2ヶ月間のプロンプト変更は、負の影響を示していません。しかし、認証キャッシュの非効率性がリクエストごとに50ミリ秒のレイテンシーを追加し、ユーザーの認識を悪化させています。

さらに、使用法も進化しています。より多くの開発者がMCPツールを使用するようになり、セットアップの複雑さが増します。OpenAIは、最適な結果を得るためにミニマリストな構成を推奨しています。

したがって、証拠は、認識がCodeX本来の性能低下ではなく、より困難なタスクにCodeXを押し付けることから生じていることを示唆しています。あるXユーザーが要約したように、「codexは非常に優れているため、人々はより難しいタスクにそれを使用し続けましたが、それらのタスクではうまく機能せず、人々はモデルが悪化したと単純に思い込んだのです。」

この分析は、OpenAIの調査対応の舞台を設定し、これらの点に直接対処します。

OpenAIの対応:CodeXパフォーマンスに関する透明な調査

OpenAIは透明性に取り組んでおり、性能低下の報告を真剣に調査することを約束しています。CodexチームのメンバーであるTiboは、Xで調査を発表し、フィードバックメカニズムのアップグレード、内部使用の標準化、追加評価の実施計画を概説しました。

エンジニアは迅速に実行し、強化された`/feedback`機能を備えたCLI 0.50をリリースし、問題をクラスターとハードウェアに紐付けました。彼らは60以上の機能フラグを削除し、スタックを簡素化しました。

さらに、専任のチームが毎日問題を仮説検証し、テストしました。このアプローチにより、古いハードウェアの廃止から`compaction`の改良まで、修正が発見されました。

加えて、OpenAIは「Ghosts in the Codex Machine」と題する包括的なレポートを共有し、主要な退行はないものの、複合的な要因を認めつつ調査結果を詳述しました。

さらに、彼らは課金バグのためにレート制限をリセットし、クレジットを返金することで、ユーザー中心の行動を示しました。

具体的に言えば、レポートの主要な調査結果は、ユーザーの懸念の背後にある技術的なニュアンスを明らかにしています。

OpenAIのCodeX性能低下レポートからの主要な調査結果

レポートは、単一の大きな問題は存在せず、行動の変化と小さな問題が蓄積していると結論付けています。ハードウェアに関しては、評価とモデルが古いユニットを特定し、それらの削除とロードバランシングの最適化につながりました。

`compaction`に関しては、時間の経過とともに頻度が高まることでセッションが劣化します。OpenAIは再帰的な要約を避けるための実装を改善し、ユーザーへの注意喚起を追加しました。

`apply_patch`については、まれな失敗が危険な削除を引き起こすことがあります。緩和策として、そのようなシーケンスを制限し、モデルの強化が計画されています。

タイムアウトについては、広範な退行は見られず、レイテンシーは改善されていますが、非効率な再試行が残っています。より良い長時間処理のハンドリングを目標とした投資が行われています。

制約付きサンプリングのバグにより、分布外のトークンが発生していましたが、これは間もなく修正されます。

レスポンスAPIの監査では、パフォーマンスへの影響がない軽微なエンコーディングの変更が明らかになりました。

CLIバージョンやプロンプトに関する評価など、他の調査でも安定性が確認されています。

さらに、より多くのツールを伴う進化するセットアップでは、シンプルさが推奨されます。

これらの調査結果は、全体的な性能低下がないことを裏付けつつ、ユーザー体験を検証するものです。

実施された改善とCodeXの今後の方向性

OpenAIは調査結果に基づいて行動し、`compaction`の警告やサンプリングの修正などの対策を展開しています。ハードウェアの整理とレイテンシーの削減により、信頼性が向上しています。

さらに、彼らは実世界のパフォーマンスを監視する常設チームを結成し、継続的な最適化のために人材を募集しています。

加えて、フィードバックの共有が促進され、継続的なインプットが保証されています。

今後の作業には、モデルの永続性の改善とツールの適応性が含まれます。

その結果、CodeXは進化し、データ駆動型の強化を通じて認識に対処しています。

しかし、これらを待つ間、開発者はApidogのような補完ツールを求めています。

補完ツール:ApidogがCodeXのワークフローを強化する方法

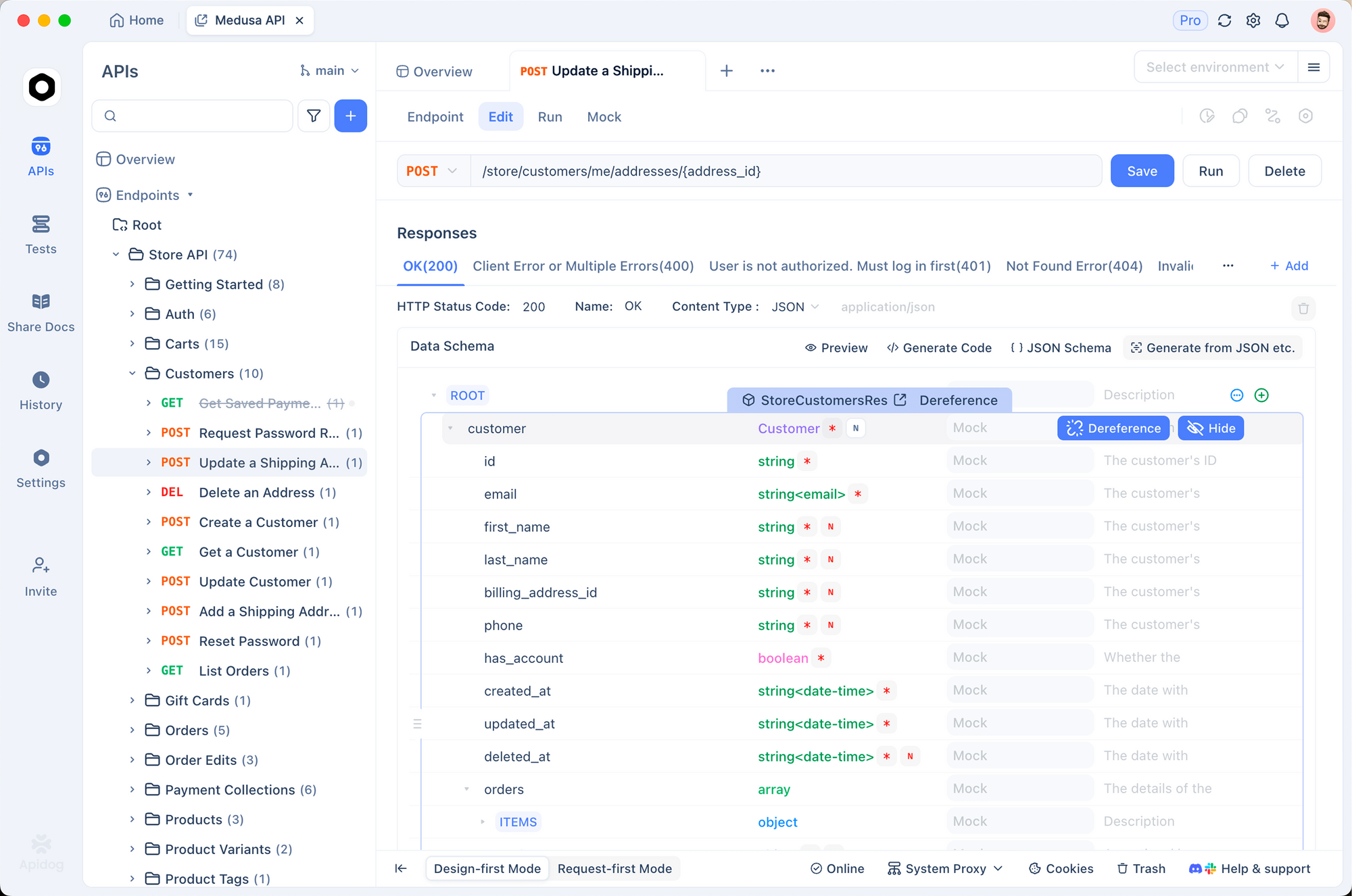

CodeXがAPIタスクを処理する際、特に統合において一貫性のない動作が生じることがあります。堅牢なAPIプラットフォームであるApidogがこのギャップを埋めます。

開発者はApidogを使用してAPIを設計、テスト、ドキュメント化し、CodeXが生成したコードが正しく機能することを確認します。

例えば、CodeXを実装する前にApidogでエンドポイントをシミュレーションすることで、エラーを減らすことができます。

さらに、Apidogの無料ダウンロード版は、コラボレーション機能、バージョン管理、自動化を提供しており、CodeXの制限に直面しているチームにとって理想的です。

スムーズに移行するため、Apidogはコーディング環境と統合し、AIの出力を検証します。

したがって、CodeXとApidogを組み合わせることで開発が最適化され、認識されている性能低下が軽減されます。

ケーススタディ:Xでの議論からの実例

Xのスレッドは鮮明な例を提供しています。あるユーザーは、CodeXの成功が過度な野心を生み出し、レポートの使用法の進化を反映していると強調しました。

別のユーザーはCLIの速度について議論し、迅速なタスクのために代替手段に切り替えることで、レイテンシーの懸念を浮き彫りにしました。

さらに、課金のリセットは過剰請求に対処し、信頼を回復させました。

これらの逸話は、レポートデータと組み合わされて、多面的な問題を説明しています。

CodeXのパフォーマンスを最大化するためのベストプラクティス

認識に対抗するために、セッションを短く保ち、ツールを最小限にし、`/feedback`を使用するといった実践を採用してください。

さらに、アップデートを監視してください。CLIの改善は結果に直接影響します。

加えて、精度を高めるためにプロンプトを試行錯誤してください。

その結果、これらの手順は体験を向上させます。

結論:CodeXとその先における変化を受け入れる

ユーザーは、複雑なタスクや軽微な問題のためにCodeXが性能低下したと認識していますが、証拠は低下ではなく進化を示しています。OpenAIの調査と修正は、コミットメントを裏付けています。

さらに、Apidogを統合することで、回復力のあるワークフローが保証されます。

最終的に、戦略を適応させ、ツールを活用し、フィードバックに貢献してください。小さな調整が生産性に大きな利益をもたらします。