開発者は、コーディング効率の向上、複雑なワークフローの自動化、インテリジェントなアプリケーションの構築のために、高度なAIモデルへの依存度を高めています。AnthropicのClaude Opus 4.5は、この分野の主要なソリューションとして登場し、ソフトウェアエンジニアリング、エージェントタスク、多段階推論において優れたパフォーマンスを提供します。このモデルは、実際のコーディングとコンピューター利用において新たなベンチマークを確立し、本番レベルのプロジェクトに取り組む技術チームにとって不可欠な存在となっています。

このガイドは、Claude Opus 4.5を効果的に活用するための技術的知識を提供します。セットアップ、コアAPIメカニクス、高度な構成、最適化戦略について説明します。これらの手順に従うことで、モデルの200Kトークンコンテキストウィンドウ、強化されたツール利用、効率的なトークン管理をアプリケーションが活用できるようになります。これにより、開発サイクルが短縮され、AI駆動の機能がより信頼性の高いものになります。

Claude Opus 4.5とは?

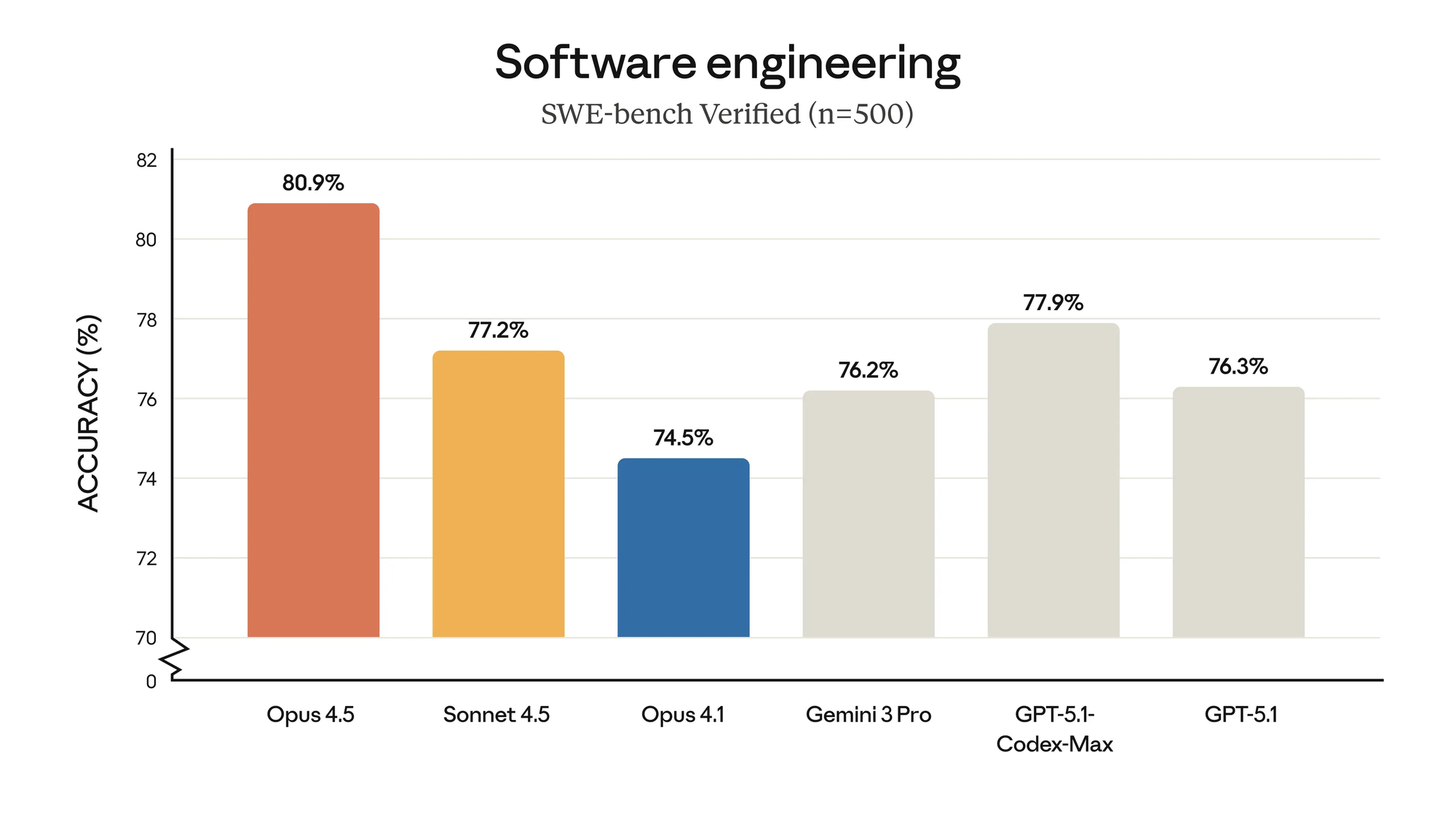

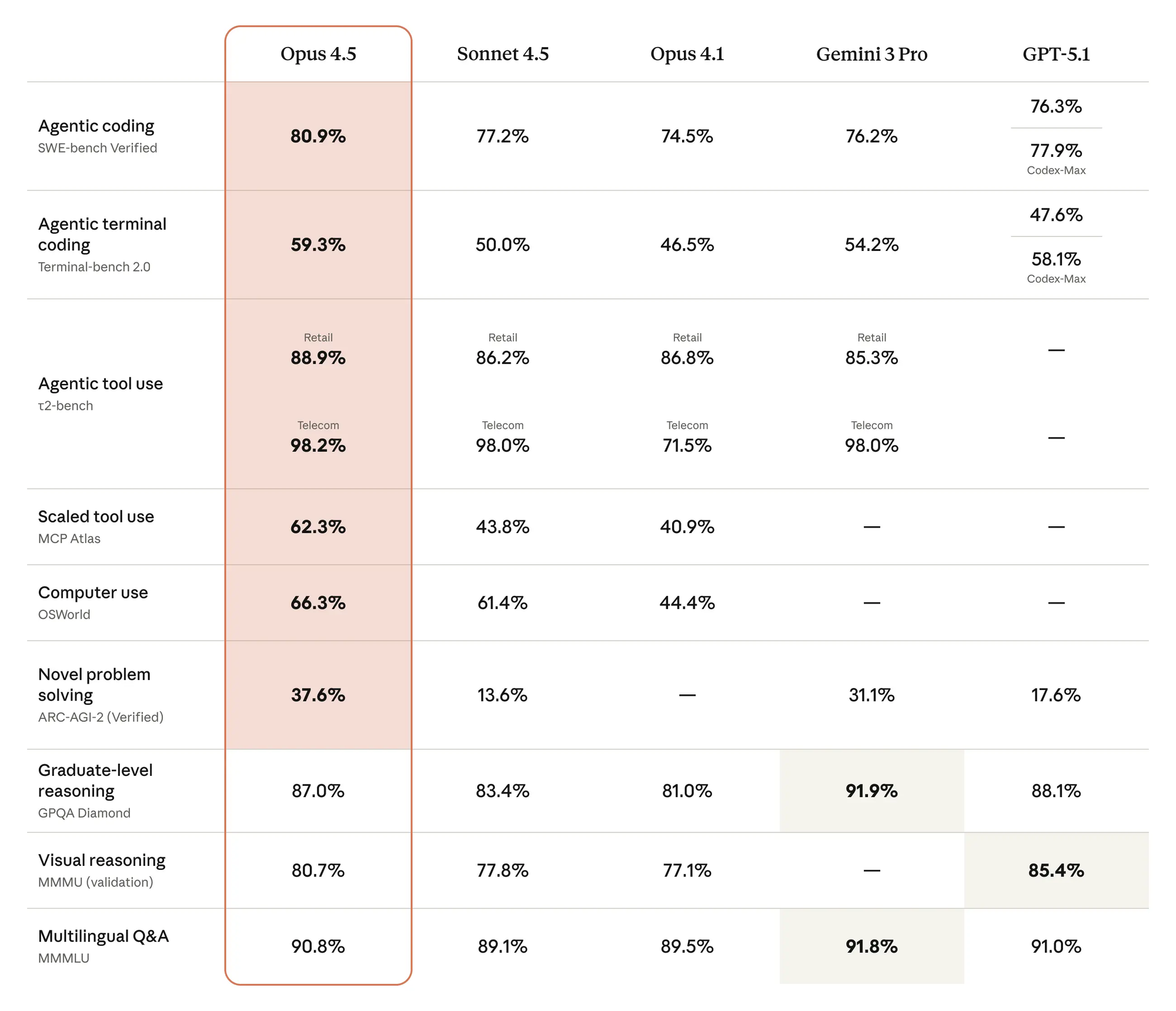

Anthropicのエンジニアは、推論の深さ、コーディングの精度、エージェントの自律性を優先して、Claude Opus 4.5をフラッグシップモデルとして設計しました。このバージョンは、ビジョン処理、数学的精度、曖昧さの解消におけるブレークスルーを取り入れることで、以前のバージョンに基づいて構築されています。例えば、エンタープライズシミュレーションでフライトの旅程を変更したり、明示的な指示なしに広範なコードベースをデバッグしたりするなど、複雑なシナリオにおけるトレードオフの処理に優れています。

主な機能には、SWE-bench Verifiedでの最先端の結果が含まれます。ここでは、最大努力で48%少ない出力トークンを使用しながら、以前のモデルを最大4.3パーセンテージポイント上回っています。

開発者は、Claude APIを通じてこれらの強みにアクセスできます。Claude APIは、長文分析や複数ファイルのコードレビューに最適な200Kトークンコンテキストウィンドウをサポートしています。さらに、このモデルはAmazon Bedrock、Google Vertex AI、Microsoft Foundryなどのクラウドプラットフォームとシームレスに統合され、スケーラブルなデプロイメントを可能にします。

価格設定は、そのプレミアムな位置付けを反映しています。入力トークンあたり5ドル、出力トークンあたり25ドルで、プロンプトキャッシュ(最大90%削減)とバッチ処理(50%削減)によってコストを節約できます。ただし、これらのコストは、後述する正確な使用パターンが必要であることを強調しています。要するに、Claude Opus 4.5は、開発者が最小限の人的監視で、最初の計画から実行まで、エンドツーエンドのプロジェクトを管理するエージェントを構築する力を与えます。

開発環境のセットアップ

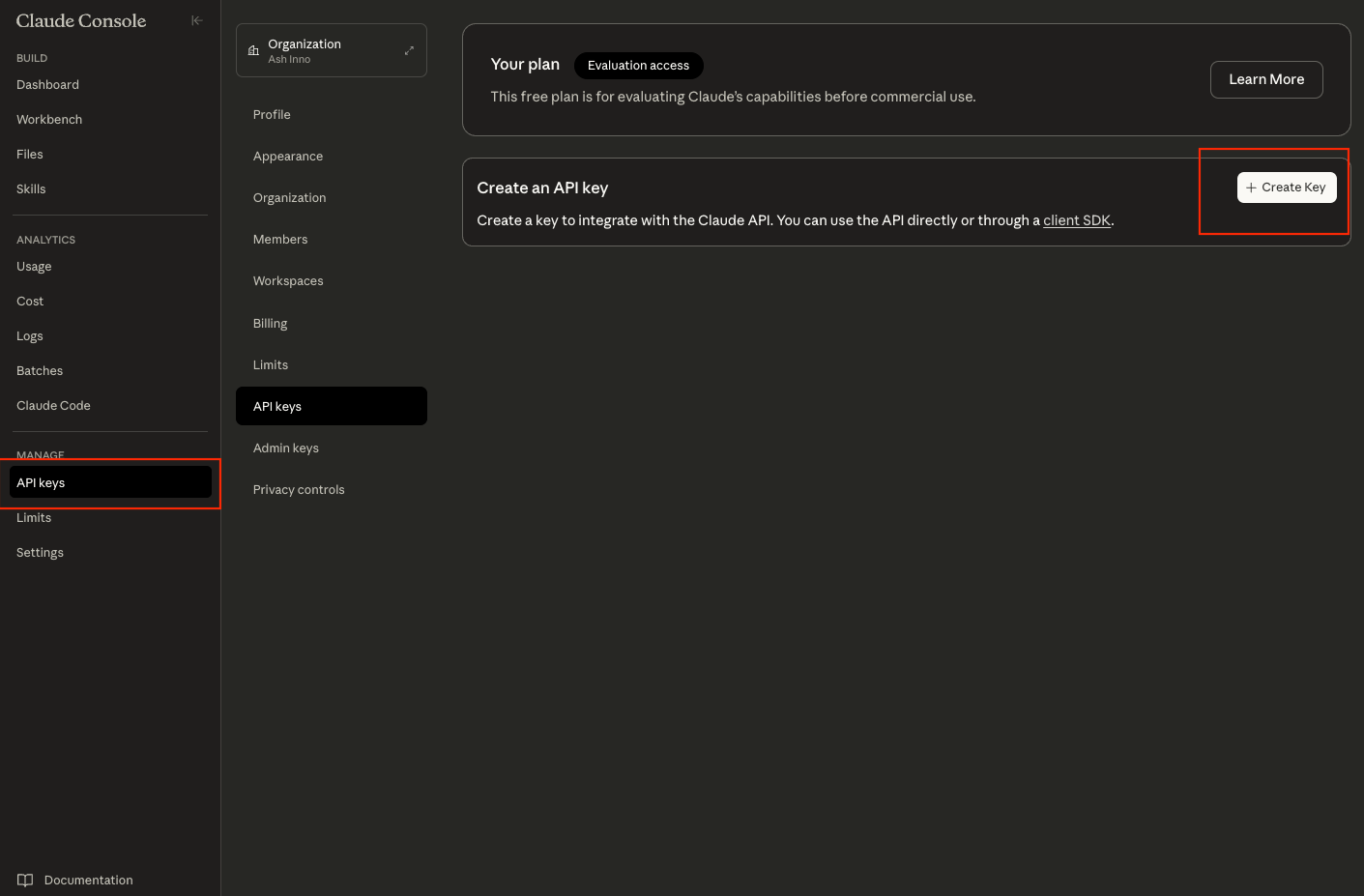

まず、Claude APIと対話するための堅牢な環境を準備します。最初に、Anthropic Console (console.anthropic.com) でAPIキーを取得します。サインアップまたはログインし、「API Keys」セクションに移動して新しいキーを生成します。このキーは安全に保管してください。ターミナルでは export ANTHROPIC_API_KEY='your-key-here' のように環境変数を使用するか、プロジェクトルートの .env ファイルに保存してください。

次に、HTTPの複雑さを抽象化し、リトライを処理する公式のAnthropic SDKをインストールします。Pythonの場合は pip install anthropic を実行します。このライブラリは、高スループットアプリケーションに不可欠な同期および非同期呼び出しをサポートします。同様に、Node.js開発者は npm install @anthropic-ai/sdk を実行します。モジュールをインポートしてインストールを確認します。Pythonでは import anthropic; client = anthropic.Anthropic(api_key=os.getenv('ANTHROPIC_API_KEY')) となります。

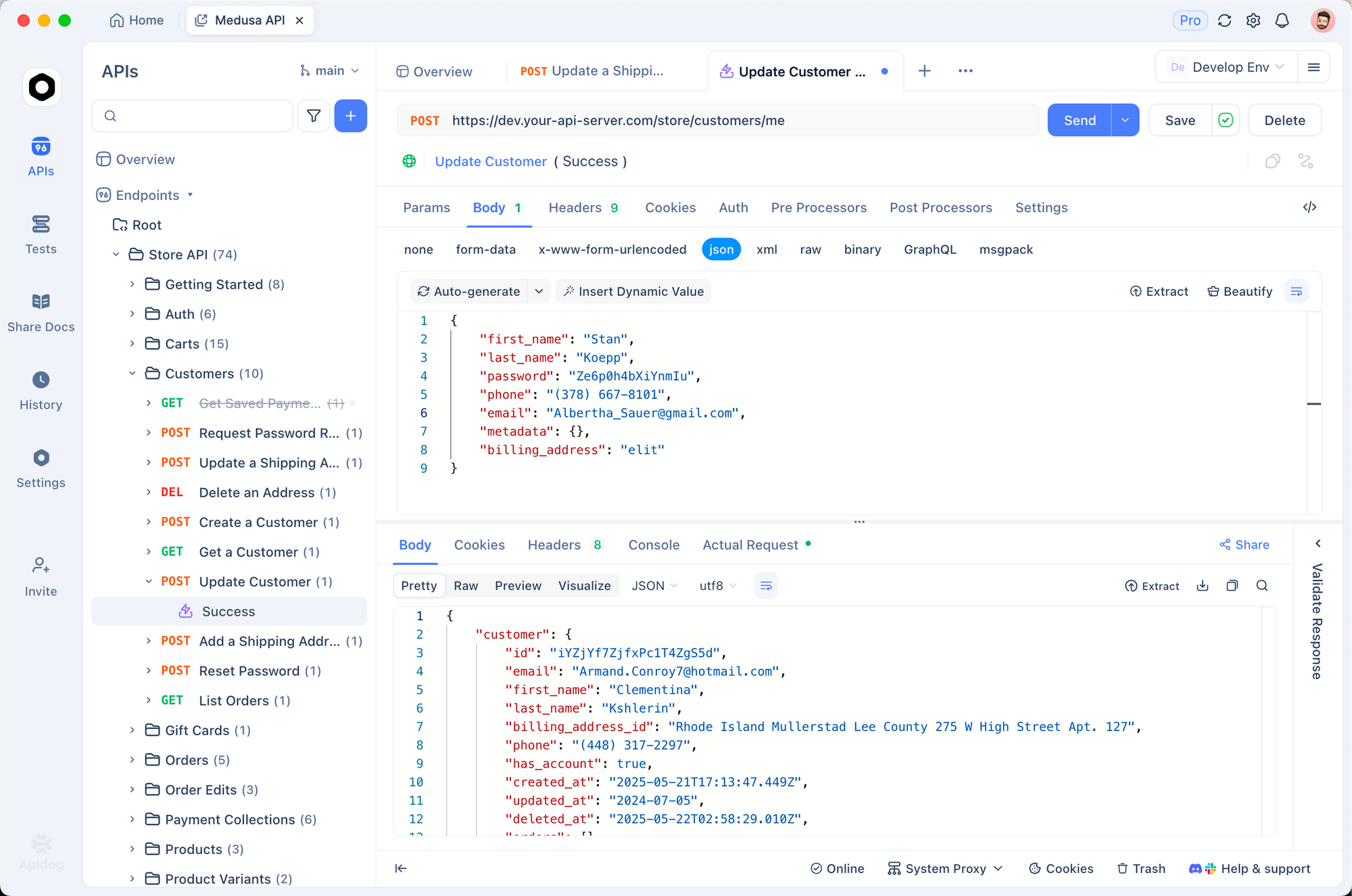

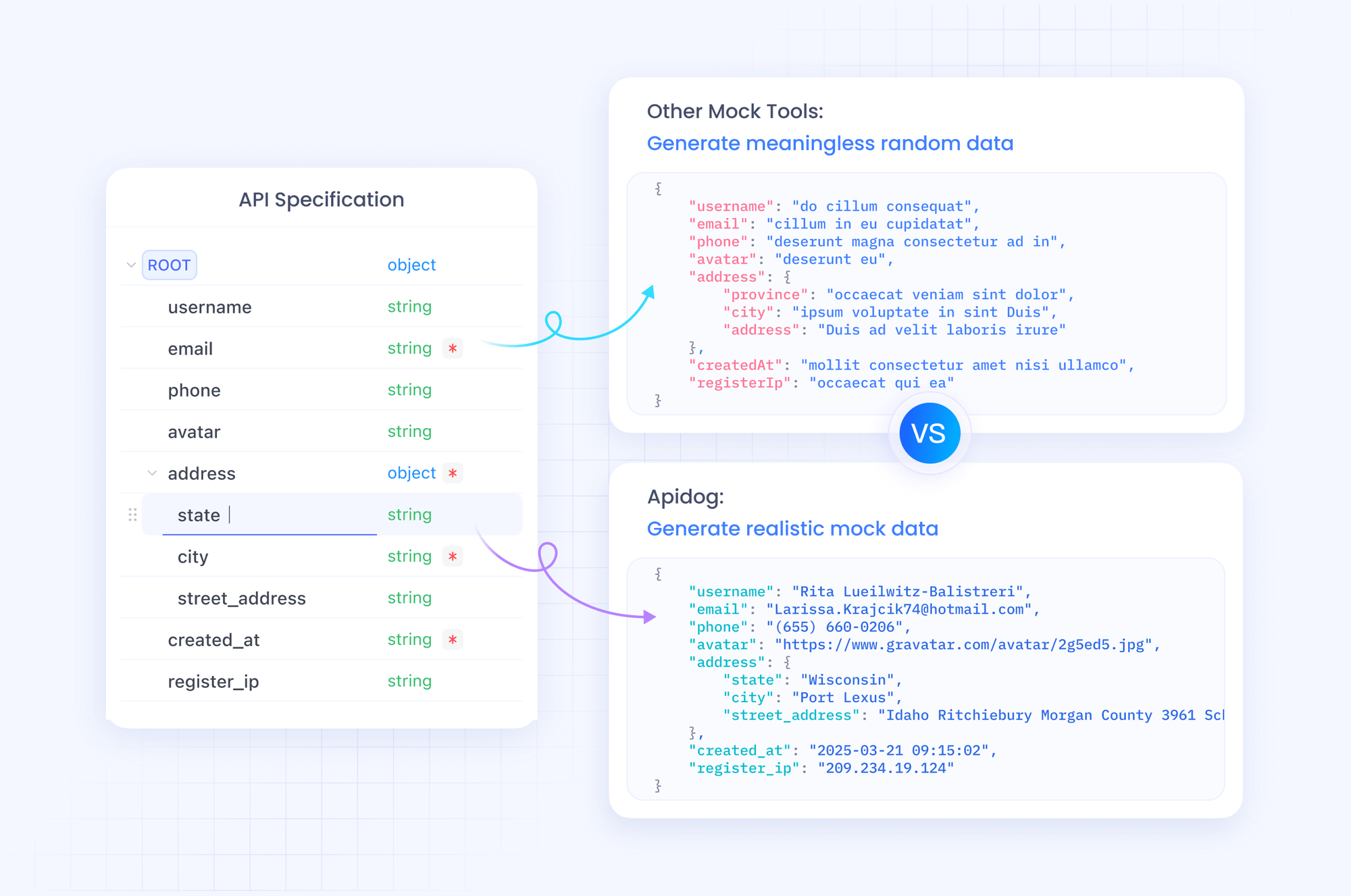

テストのために、Apidogを早期に統合します。このツールは、SDKの実験からcURLコマンドやPostmanコレクションを生成し、チーム間の整合性を確保します。APIキーをApidogの環境変数にインポートし、/v1/messages エンドポイントへの新しいリクエストを作成します。このような準備により、認証エラーなどの一般的な落とし穴を防ぎ、プロンプトエンジニアリングに集中できます。

セットアップが完了したら、簡単なヘルスチェックで接続を確認します。基本的なリクエストを送信して、キーとネットワークを検証します。このステップにより、APIのレート制限(Opusモデルでは最初は1分あたり50リクエスト、使用量に応じてスケーリング可能)を環境が処理できることを確認します。

認証とAPIの基本

Anthropicは、標準的なOAuth2ベースのメカニズムであるBearerトークンによる認証を強制しています。すべてのリクエストに Authorization ヘッダーに Bearer ${ANTHROPIC_API_KEY} としてAPIキーを含めます。ベースURLは https://api.anthropic.com/v1 で、チャット完了の主要エンドポイントは /messages です。

リクエストはJSONペイロード構造に従います。model フィールドには、このリリース用の正確な識別子である claude-opus-4-5-20251101 を指定します。messages 配列には、ロールとコンテンツのペアを含めます。システムプロンプトは行動ガイドラインを設定し、ユーザーメッセージは応答をトリガーします。例:

{

"model": "claude-opus-4-5-20251101",

"max_tokens": 1024,

"messages": [

{"role": "user", "content": "Explain quantum entanglement in simple terms."}

]

}

SDKはこれを簡素化します。Pythonでは client.messages.create(model="claude-opus-4-5-20251101", max_tokens=1024, messages=[{"role": "user", "content": "Your prompt here"}]) です。応答は、ストリーミング用のテキストデルタ、またはバッチモード用の完全なブロックを含む content 配列を返します。

レート制限は組織ごとに適用されます。Opus 4.5は、最初は1分あたり10,000トークンに制限され、最大50,000トークンまでバーストできます。x-ratelimit-remaining のような応答ヘッダーを介して監視します。超過した場合は、コードに指数バックオフを実装します。SDKは retry_on=anthropic.RetryStatus.SERVER_ERROR でこれをネイティブに処理します。

セキュリティのベストプラクティスには、キーを四半期ごとにローテーションし、コンソールで特定のIP範囲に制限することが含まれます。これにより、API呼び出しをスケーリングしながら、エンタープライズ設定でのコンプライアンスを維持できます。

最初のAPIリクエストの作成

APIのリズムを把握するために、最初のリクエストを実行してみましょう。モデルの推論能力をテストする簡単なクエリから始めます。Pythonでは次のようになります。

import anthropic

import os

client = anthropic.Anthropic(api_key=os.getenv("ANTHROPIC_API_KEY"))

response = client.messages.create(

model="claude-opus-4-5-20251101",

max_tokens=500,

messages=[

{"role": "user", "content": "Write a Python function to compute Fibonacci numbers up to n=20."}

]

)

print(response.content[0].text)

このコードはモデルを呼び出し、メモ化を利用した効率的なコードを生成します。これはモデルのコーディング能力を示しています。デフォルトの努力レベルでは2秒以内に応答が返され、簡潔な結果の場合、出力トークンは約150です。

ストリーミングの場合、呼び出しに stream=True を追加します。これにより、リアルタイムUIに最適な増分デルタが生成されます。ジェネレーターループを介してそれらを解析します。

stream = client.messages.stream(

model="claude-opus-4-5-20251101",

max_tokens=500,

messages=[{"role": "user", "content": "Your streaming prompt"}]

)

for text in stream:

print(text.content[0].text, end="", flush=True)

Apidogは、応答ビューアでストリームを視覚化し、トークン消費量を強調表示することでこれを補完します。本番環境に移行する前に、ここで実験してプロンプトを洗練させましょう。

エラーに積極的に対処してください。429ステータスはスロットリングを示します。try-exceptブロックでキャッチします。同様に、400は不正なJSONを示します。Apidogのスキーマチェッカーを使用してペイロードを検証します。これらの基本を通じて、より複雑な統合のための基盤を構築します。

高度な機能:努力レベルの制御とコンテキスト管理

Claude Opus 4.5は、速度と深さのバランスを取るための画期的な effort パラメータを導入しました。リクエストで「low」、「medium」、「high」に設定します。lowは迅速な応答(サブ秒のレイテンシ)を優先し、highはニュアンスのある出力のために拡張された計算リソースを割り当て、SWE-benchなどのベンチマークを15ポイント向上させます。

次のように組み込みます。

response = client.messages.create(

model="claude-opus-4-5-20251101",

effort="high",

max_tokens=2000,

messages=[{"role": "user", "content": "Analyze tradeoffs in microservices vs. monoliths for a fintech app."}]

)

高努力では、モデルはインターリーブされたスクラッチパッドと64Kの思考バジェットを使用し、詳細な賛否両論の表を生成します。ただし、これによりコストが増加します。中程度の努力は、Sonnet 4.5の効率を76%少ないトークンで実現し、80%のタスクで十分であることがよくあります。

コンテキスト管理も同様です。200Kのウィンドウは、リポジトリ全体を収容できます。クライアント側の圧縮SDKを使用して、以前のやり取りを要約します。pip install anthropic-compaction でインストールし、次に:

from anthropic.compaction import compact_context

compacted = compact_context(previous_messages)

# Append to new messages array

この機能は、エージェントがセッション間で記憶を維持するエージェントループで輝きます。マルチエージェントシステムの場合、ツール呼び出しを介してサブエージェントを定義し、Opus 4.5がチーム(例:研究用、検証用)を調整できるようにします。

ツールへの移行により、Opus 4.5は高度な定義をサポートします。データベースクエリなどの関数にJSONスキーマを宣言します。

{

"name": "get_user_data",

"description": "Fetch user profile",

"input_schema": {"type": "object", "properties": {"user_id": {"type": "string"}}}

}

モデルはツールを自律的に呼び出し、引数を解析し、結果をフォローアップに注入します。これにより、サイバーセキュリティスキャン用のAPIチェーン型エージェントなどのハイブリッドワークフローが可能になります。

ツールの統合とエージェントの構築

ツール利用により、Claude Opus 4.5はエージェント機能の頂点に到達します。リクエストの tools 配列でツールを定義します。モデルはコンテキストに基づいて呼び出しを決定し、XML形式の呼び出しを生成して精度を高めます。

例:天気APIツールを統合する。

tools = [

{

"name": "get_weather",

"description": "Retrieve current weather for a city",

"input_schema": {

"type": "object",

"properties": {"city": {"type": "string"}},

"required": ["city"]

}

}

]

response = client.messages.create(

model="claude-opus-4-5-20251101",

max_tokens=1000,

tools=tools,

messages=[{"role": "user", "content": "Plan a trip to Paris; check weather."}]

)

モデルがツールを呼び出した場合、response.stop_reason == "tool_use" から抽出し、外部で実行し、出力をツール結果メッセージとして追加します。完全なエージェント実行のために完了するまでループします。

コンピュータ利用の場合、ヘッダーを介してベータ機能を有効にします。これにより、画面検査と自動化が可能になり、ピクセルレベルの分析のためのZoom Toolが提供されます。これはUIデバッグに不可欠です。

Apidogはツールテストを効率化します。シミュレータでエンドポイントをモックし、SDKコードにエクスポートします。この反復的なアプローチにより、エージェントの信頼性が向上し、幻覚的な呼び出しが減少します。

マルチエージェント設定では、状態永続性のためにメモリツールを活用します。主要な事実を memory ツールに保存し、サブエージェント間でクエリを実行します。その結果、システムは、あるエージェントが計画し、他のエージェントが実行するソフトウェア監査のような広範なタスクを処理できます。

エラー処理とベストプラクティス

堅牢なアプリケーションは障害を予測します。APIの癖に対応するための包括的なエラー処理を実装します。4xxエラーの場合、error.type(例:「invalid_request」)をログに記録し、修正されたペイロードで再試行します。デコレータには tenacity ライブラリを使用します。

from tenacity import retry, stop_after_attempt, wait_exponential

@retry(stop=stop_after_attempt(3), wait=wait_exponential(multiplier=1, min=4, max=10))

def safe_api_call(prompt):

return client.messages.create(model="claude-opus-4-5-20251101", messages=[{"role": "user", "content": prompt}])

応答の usage を介してトークン使用量を監視します。入力、出力、およびキャッシュヒットを追跡します。予算を動的に設定します。出力が max_tokens の80%を超えた場合、切り詰めて要約します。

ベストプラクティスには、構造化のためにXMLタグを使用したプロンプトエンジニアリングが含まれます。例:<thinking>Reason step-by-step</thinking><output>Final answer</output>。これにより、特に低い努力レベルでもモデルをガイドできます。さらに、倫理ガイドラインを強制する system プロンプトを介して安全性を有効にします。

本番環境では、コスト削減のためにリクエストをバッチ処理します。緊急性のないクエリをキューに入れ、100単位で処理します。頻繁なプロンプトをキャッシュして、90%の節約を実現します。出力の整合性を定期的に監査します。Opus 4.5はインジェクションに耐性がありますが、機密データを検証してください。

パフォーマンスとコストの最適化

最適化は持続可能な利用を確実にします。Apidogの分析を使用してリクエストをプロファイリングします。レイテンシ、トークン消費量、成功率を追跡します。冗長なプロンプトなどのボトルネックを特定し、圧縮を使用してそれらを短縮します。

プロンプトキャッシュを活用します。再利用可能なプレフィックスには cache_control: {"type": "ephemeral"} をタグ付けします。ヒットした場合、入力に対しては25%のみ支払います。エージェントの場合、キャッシュを呼び出し間で永続化して、手頃な価格でコンテキストを維持します。

非同期パターンでスケールします。Node.jsの場合:

const { Anthropic } = require('@anthropic-ai/sdk');

const anthropic = new Anthropic({ apiKey: process.env.ANTHROPIC_API_KEY });

async function parallelRequests(prompts) {

const promises = prompts.map(p =>

anthropic.messages.create({ model: 'claude-opus-4-5-20251101', messages: [{role: 'user', content: p}] })

);

return Promise.all(promises);

}

これにより、同時エージェントフォークが効率的に処理されます。高い努力レベルでは、品質を犠牲にすることなくコストを制御するために、思考バジェットを32Kに制限します。

ベンチマークに対してセットアップを評価します。Opus 4.5はSWE-benchで72.5%を達成しているため、カスタム評価をテストします。タスクごとに努力レベルを調整します。アイデア出しには低、検証には高を使用します。

結論

これで、Claude Opus 4.5 APIを効果的にスタックに統合するためのツールが揃いました。初期設定からエージェントのオーケストレーションまで、このガイドはコーディングと推論におけるその強みを活用するための道筋を示しています。キャッシュや努力レベルの調整のような小さな改良が、パフォーマンスと経済性の両方で大きな利益をもたらすことを忘れないでください。

Apidogを使用して各層を検証しながら、反復的に実験してください。開発を進めるにつれて、Anthropicの更新情報に注目し、機能強化を把握してください。最終的に、Claude Opus 4.5は、開発を手作業の苦労から、調整された知能へと変革します。今日から実装を開始し、プロジェクトが精度を伴ってスケールアップするのを目の当たりにしてください。