開発者は、パフォーマンスとコスト、速度のバランスが取れた効率的なAIモデルをますます求めています。Claude Haiku 4.5は、この状況において強力な選択肢として登場し、様々なアプリケーションに高度な機能を提供します。この記事では、エンジニアやプログラマーがプロジェクトでClaude Haiku 4.5 APIを実装する方法について詳しく解説します。初期設定から高度な統合まで、その可能性を最大限に引き出すための洞察を得られるでしょう。

このガイドを進めるにつれて、互いに積み重なるステップバイステップの指示に遭遇するでしょう。まず、Claude Haiku 4.5の核となる属性を理解し、次に実践的な実装へと進みます。

Claude Haiku 4.5を理解する:主要な機能と改善点

Anthropicは、速度と効率を最優先するコンパクトでありながらインテリジェントなモデルとしてClaude Haiku 4.5を設計しました。エンジニアは、大規模なモデルのオーバーヘッドなしに、フロンティアに近いパフォーマンスを提供する点を高く評価しています。具体的には、Claude Haiku 4.5はClaude Sonnet 4に匹敵するコーディング能力を達成しながら、コストは3分の1、速度は2倍以上で動作します。この最適化は、高い精度を維持しつつ計算要件を削減する洗練されたアルゴリズムに由来しています。

前身であるClaude Haiku 3.5から移行したこのバージョンは、安全性評価においてアライメントが強化され、誤った動作の発生率が低減されています。例えば、自動評価では懸念される出力の発生が統計的に低く、本番環境にとってより安全な選択肢となっています。さらに、Claude Haiku 4.5はAI安全レベル2(ASL-2)に分類されており、化学、生物、放射線、核(CBRN)などの分野におけるリスクが最小限であることを示しています。この分類により、Claude Sonnet 4.5のようなASL-3モデルと比較して、より広範な展開が可能になります。

主要な機能には、低遅延タスク向けのリアルタイム処理が含まれます。開発者は、チャットアシスタント、カスタマーサービスエージェント、ペアプログラミングのシナリオでこれを使用します。コーディングタスクでは、複雑な問題を分解し、最適化を提案し、リアルタイムでコードをデバッグすることで優れた能力を発揮します。さらに、Claude Sonnet 4.5のような調整モデルが複数のClaude Haiku 4.5インスタンスにサブタスクを委任して並行実行するマルチエージェントシステムもサポートしています。このアプローチにより、ソフトウェアのプロトタイピング、データ分析、インタラクティブなアプリケーションにおけるワークフローが加速されます。

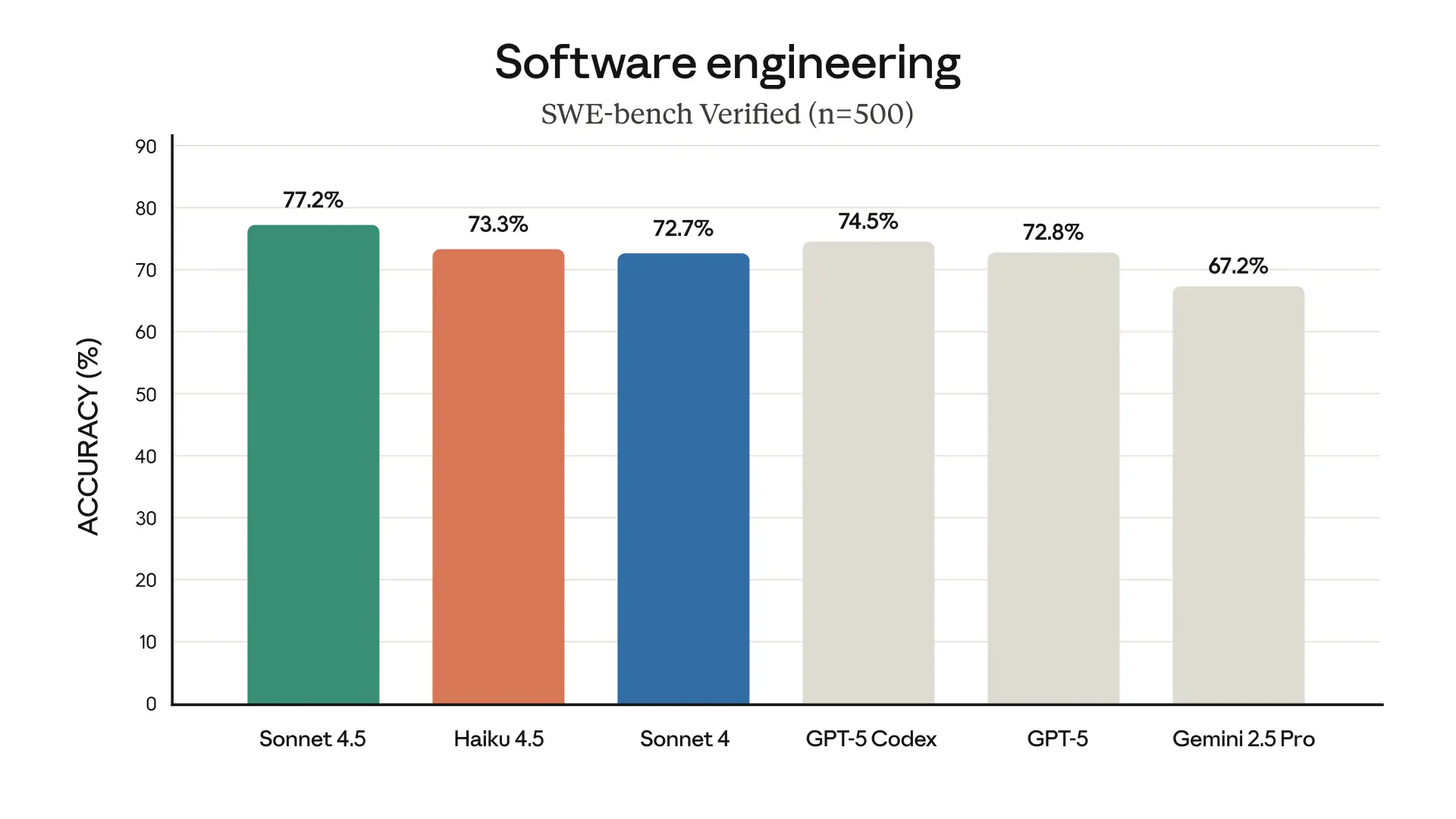

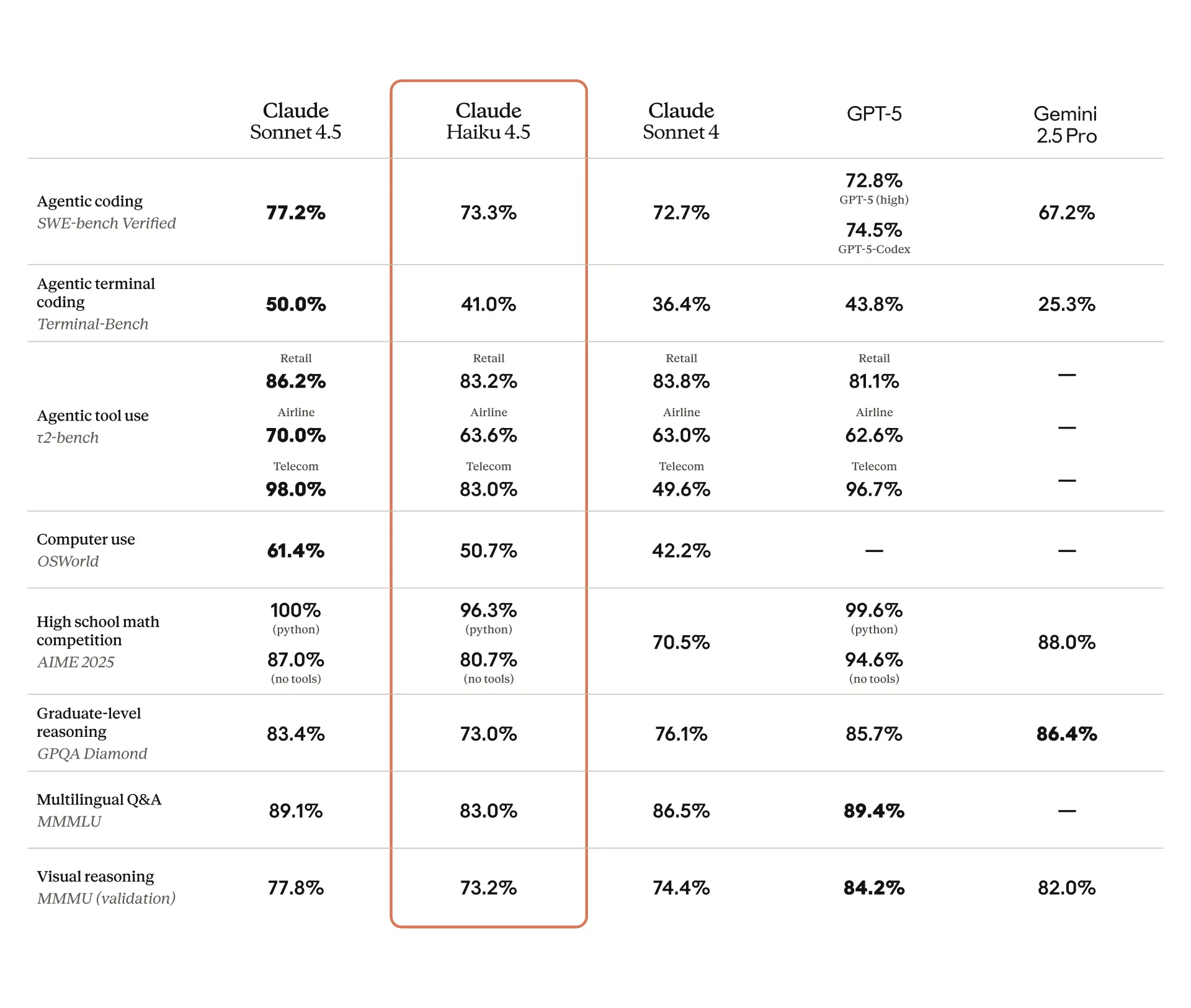

ベンチマークは、その強みをさらに裏付けています。SWE-bench Verifiedでは、Claude Haiku 4.5は、128Kの思考予算を持つDocker化された環境で50回の試行を平均して73.3%のスコアを記録しました。bashやファイル編集ツールを含むシンプルな足場を採用しており、タスクあたり100回を超える広範なツール使用を奨励しています。OpenAIのGPT-5のような競合他社と比較して、デバッグと機能実装において優れたパフォーマンスを発揮します。Terminal-Bench(思考なしで平均40.21%、32Kの予算で41.75%)やOSWorld(4回の実行で最大100ステップ)などの他の評価も、エージェントベースおよびオペレーティングシステムとのインタラクションにおける信頼性を強調しています。

さらに、Claude Haiku 4.5はAmazon BedrockやGoogle CloudのVertex AIなどのプラットフォームとシームレスに統合します。開発者は、Haiku 3.5やSonnet 4のような古いモデルを直接置き換えることができ、その経済的な価格設定構造から恩恵を受けます。これらの機能を検討する際には、セットアップ手順に進む前に、それらがプロジェクトの要件とどのように合致するかを考慮してください。

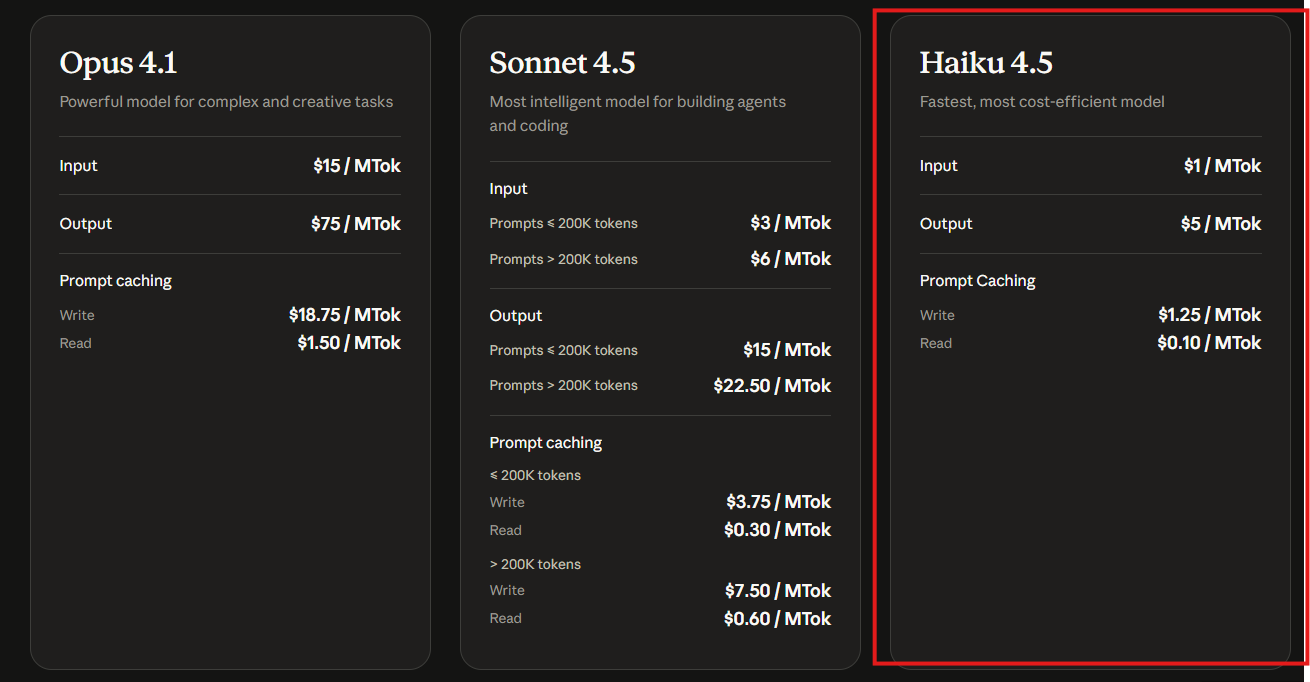

Claude Haiku 4.5 APIの料金詳細

コスト効率は、AIモデルを導入する上で重要な側面を形成します。AnthropicはClaude Haiku 4.5の価格を、入力トークン100万あたり1ドル、出力トークン100万あたり5ドルと設定しています。この構造により、Claudeファミリーの中で最も手頃な選択肢となり、過剰な費用なしに大量の利用が可能になります。比較として、Claude Haiku 3.5は入力トークン100万あたり0.80ドル、出力トークン100万あたり1.60ドルですが、新しいバージョンは競争力のある価格で優れたパフォーマンスを提供します。

プロンプトキャッシュのような追加機能には、書き込みトークン100万あたり1.25ドル、読み取りトークン100万あたり0.10ドルがかかり、アプリケーションでの繰り返しのクエリを最適化します。Amazon BedrockやGoogle Vertex AIなどのサードパーティプラットフォームを通じてモデルにアクセスする開発者は、プロバイダーの手数料に基づいて請求に若干の変動がある場合がありますが、基本料金は一貫しています。

AI統合をスケールアップする組織は、この価格設定がプロトタイプや本番環境にとって有利であると感じるでしょう。例えば、毎日何千ものインタラクションを処理するカスタマーサービスボットでは、入力コストの低減により全体的な運用費用が削減されます。ただし、広範な思考予算を伴う複雑なタスクでは料金が蓄積される可能性があるため、トークン使用量を注意深く監視してください。Apidogのようなツールは、テスト段階でのコストシミュレーションと見積もりを支援し、予算遵守を確実にします。

価格設定を念頭に置き、Claude Haiku 4.5 APIを使用するためのアクセス取得と環境設定に焦点を移しましょう。

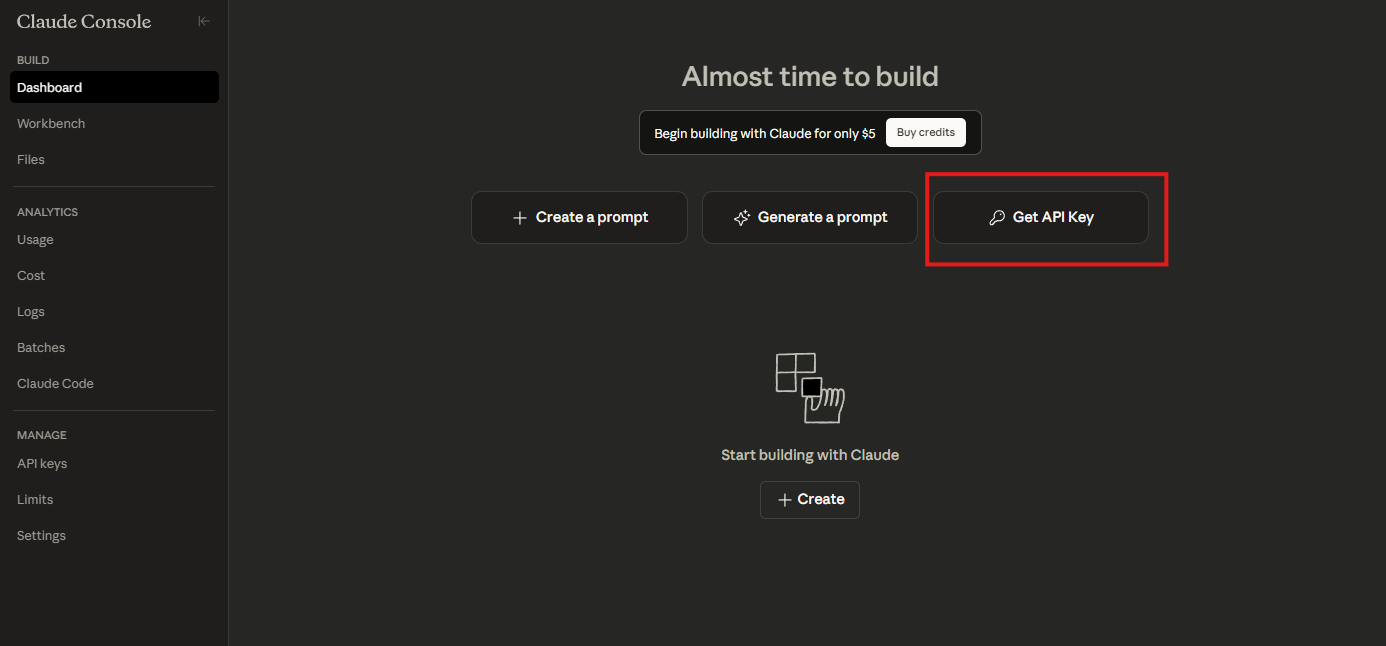

Claude Haiku 4.5 APIへのアクセスを設定する

Claude Haiku 4.5の利用を開始するには、AnthropicからAPIキーを取得します。Anthropic開発者コンソールにアクセスし、アカウントをお持ちでない場合は作成してください。ログイン後、APIセクションで新しいAPIキーを生成します。このキーはすべてのリクエストを認証するため、安全に保管してください。

次に、必要なライブラリをインストールします。Python開発者の場合、公式のAnthropic SDKを使用します。ターミナルでpip install anthropicを実行してください。このパッケージは、認証、リクエストのフォーマット、レスポンスの解析を処理することで、インタラクションを簡素化します。

APIキーを環境変数として設定して環境を構成します: export ANTHROPIC_API_KEY='your-api-key-here'。または、テスト目的でコードに直接渡すこともできますが、本番環境での情報漏洩を防ぐため、この方法は避けてください。

Amazon Bedrockを使用している場合は、AWSコンソールに移動し、Anthropicモデルを有効にしてClaude Haiku 4.5を選択します。Bedrockはマネージドサービスを提供し、インフラ管理を抽象化します。同様に、Google Vertex AIユーザーはModel Gardenを通じてアクセスし、そこでモデルを選択し、REST APIまたはSDKを介して統合します。

簡単なテストリクエストでセットアップを確認します。Pythonでクライアントをインポートし、基本的なメッセージを送信します。

import anthropic

client = anthropic.Anthropic()

message = client.messages.create(

model="claude-haiku-4-5",

max_tokens=1000,

temperature=0.7,

messages=[

{"role": "user", "content": "Hello, Claude Haiku 4.5!"}

]

)

print(message.content)

このコードは、クライアントを初期化し、モデルを指定し、ユーザーメッセージを処理します。モデルの動作を確認するレスポンスが期待されます。エラーが発生した場合は、キーの有効性またはネットワーク接続を確認してください。

Apidogは、Claude APIのOpenAPI仕様をインポートできるようにすることで、このセットアップを強化します。Apidogをダウンロードし、新しいプロジェクトを作成して、Anthropicエンドポイントを追加します。これにより、オフライン開発のためのレスポンスのモックが可能になり、統合がスムーズに進むことが保証されます。

設定が完了したら、基本的なAPI呼び出しとそのパラメータを探索に進みます。

Claude Haiku 4.5 APIの基本的な使用法

Claude Haiku 4.5 APIは、会話型インタラクションを処理するメッセージエンドポイントを中心に展開します。開発者は、役割(ユーザーまたはアシスタント)とコンテンツを含むメッセージのリストでリクエストを構築します。モデルはこのコンテキストに基づいて補完を生成します。

max_tokensのようなパラメータで出力を制御し、過剰な生成を防ぐためにレスポンスの長さを制限します。temperatureを0から1の間で設定してランダム性を調整します。低い値は技術的なタスクに適した決定論的な出力を生成します。さらに、top_pは上位の確率質量からサンプリングすることで多様性に影響を与えます。

コーディング例として、Python関数についてモデルにクエリを実行します。

message = client.messages.create(

model="claude-haiku-4-5",

max_tokens=500,

messages=[

{"role": "user", "content": "Write a Python function to calculate Fibonacci numbers recursively."}

]

)

print(message.content[0].text)

レスポンスは、多くの場合説明付きで関数コードを提供します。Claude Haiku 4.5の速度は迅速なイテレーションを保証し、デバッグセッションに最適です。

エラーを適切に処理します。一般的な問題には、レート制限や無効なパラメータがあります。指数関数的バックオフによる再試行を実装します。

import time

def send_message_with_retry(client, params, max_retries=3):

for attempt in range(max_retries):

try:

return client.messages.create(**params)

except anthropic.APIError as e:

if attempt < max_retries - 1:

time.sleep(2 ** attempt)

else:

raise e

この関数は、待機時間を増やしながらリクエストを複数回試行します。このような手法は、本番環境での信頼性を維持します。

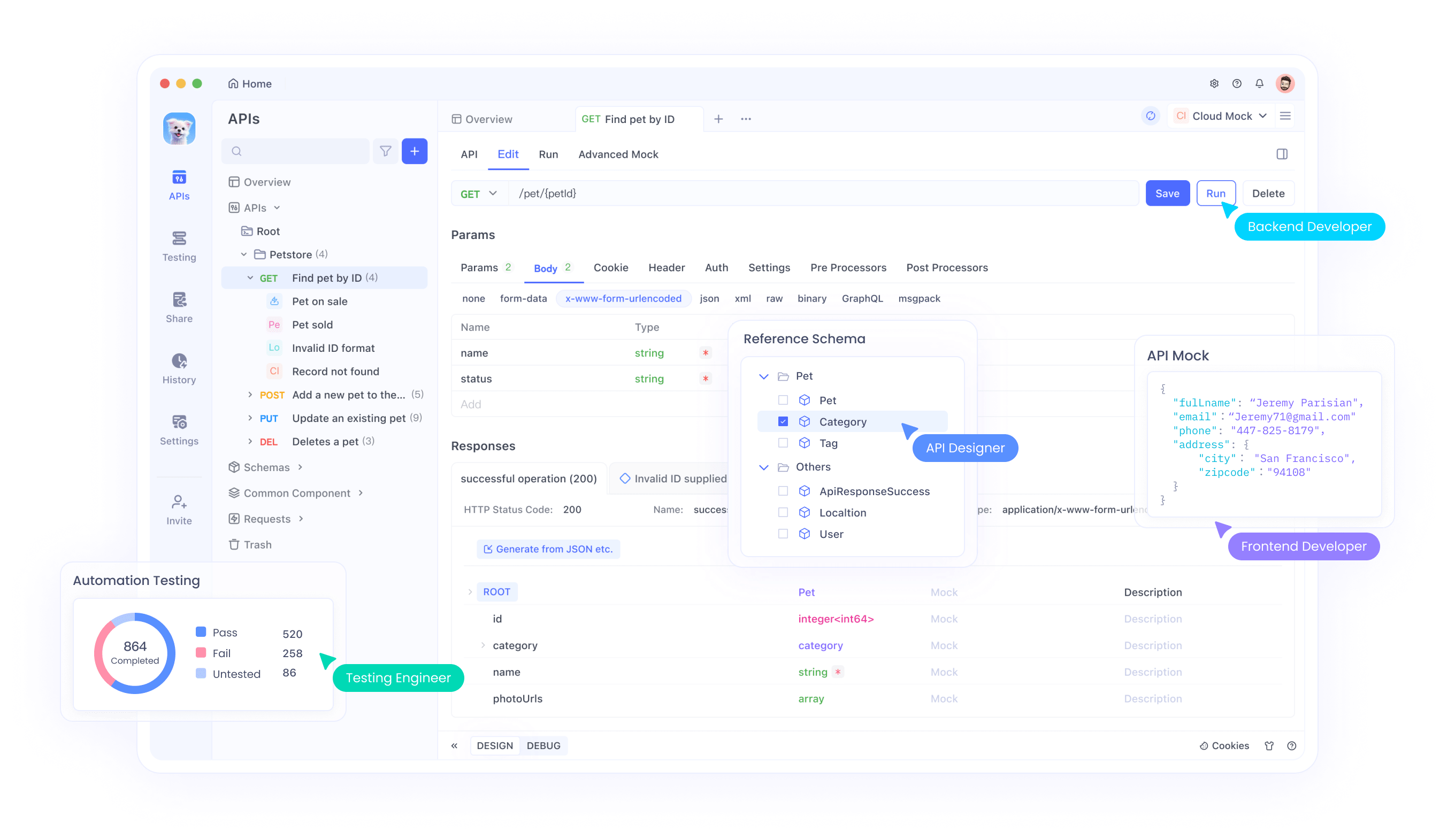

基本に基づいて、これらの呼び出しをテストするためにApidogを統合します。Apidogで新しいAPIリクエストを作成し、URLをhttps://api.anthropic.com/v1/messagesに設定し、x-api-keyのようなヘッダーにキーを追加し、JSONボディを定義します。リクエストを送信し、Apidogが分析しやすいようにフォーマットされたレスポンスを検査します。

簡単なインタラクションを習得したら、ツールやエージェントを含むより複雑なシナリオに進みましょう。

高度な使用法:ツール統合とマルチエージェントシステム

Claude Haiku 4.5はツール呼び出しをサポートしており、モデルが外部関数と対話できるようにします。リクエストでツールを定義すると、モデルはいつそれらを使用するかを決定します。例えば、数学的計算のためのツールを作成します。

tools = [

{

"name": "calculator",

"description": "Perform arithmetic operations",

"input_schema": {

"type": "object",

"properties": {

"expression": {"type": "string"}

},

"required": ["expression"]

}

}

]

message = client.messages.create(

model="claude-haiku-4-5",

max_tokens=1000,

tools=tools,

messages=[

{"role": "user", "content": "What is 15 * 23?"}

]

)

モデルがツールを呼び出した場合、入力を処理し、後続のメッセージで結果を提供します。これにより、テキスト生成を超えた機能が拡張されます。

マルチエージェントのセットアップでは、計画にClaude Sonnet 4.5を、実行にClaude Haiku 4.5を使用します。コーディネーターはタスクをサブタスクに分割し、それらをHaikuインスタンスにディスパッチします。ソフトウェア開発の場合、あるエージェントがデータ取得を処理し、別のエージェントがUI設計を処理するなど、すべて並行して行われます。

これを非同期呼び出しで実装します。

import asyncio

async def execute_subtask(client, subtask):

return await asyncio.to_thread(client.messages.create,

model="claude-haiku-4-5",

max_tokens=500,

messages=[{"role": "user", "content": subtask}]

)

async def main():

subtasks = ["Fetch user data", "Design login page"]

results = await asyncio.gather(*(execute_subtask(client, task) for task in subtasks))

# Aggregate results

このコードは、Haikuの速度を活用してサブタスクを並行して実行します。

このようなシステムをテストする場合、Apidogのモックサーバーはツールの応答をシミュレートし、オフラインでの検証を可能にします。モックを構成して期待される出力を返し、ライブデプロイメントの前にエージェントを洗練させます。

さらに、最大128Kトークンの予算を割り当てることで、拡張された思考に最適化します。ベンチマークでは、これによりAIME(10回の実行で平均)やMMMLUのような複雑な問題におけるパフォーマンスが向上します。

実用的なアプリケーションに移行し、これらの機能が輝く現実世界のユースケースを検討しましょう。

Claude Haiku 4.5 APIのユースケース

組織は、Claude Haiku 4.5を多様なシナリオで適用しています。カスタマーサービスでは、問い合わせに即座に応答し、待ち時間を短縮するボットを強化します。例えば、メッセージングプラットフォームと統合します。

# Pseudocode for bot integration

def handle_message(user_input):

response = client.messages.create(

model="claude-haiku-4-5",

messages=[{"role": "user", "content": user_input}]

)

return response.content[0].text

このセットアップは、高いトラフィックを効率的に処理するようにスケールします。

GitHub CopilotやCursorのようなコーディング環境では、Claude Haiku 4.5はAPIを介して提案を提供します。開発者はパブリックプレビューでそれを有効にし、アクセス用のキーを入力します。

ブラウザ自動化の場合、そのコンピュータ使用能力は前身モデルを上回ります。モデルがページをナビゲートしたり、データを抽出したり、フォームを自動化したりする拡張機能を構築します。

教育プラットフォームは、インタラクティブな個別指導にこれを使用し、オンデマンドで説明やクイズを生成します。データアナリストは、自然言語とSQLツールを組み合わせて、データベースに対するクエリ生成にこれを利用します。

いずれの場合も、Apidogはシナリオを自動化することでテストを容易にし、堅牢性を確保します。例えば、負荷時の応答時間を検証するテストスイートを作成します。

これらを実装する際には、効率を最大化するためにベストプラクティスを遵守してください。

ベストプラクティスと最適化手法

メッセージ履歴を効果的に管理することで、コンテキストの一貫性を維持します。トークンの無駄を避けるため、会話を必要不可欠なやり取りに限定してください。

Anthropicダッシュボードを通じて使用状況メトリクスを監視し、コストと品質のバランスを取るためにパラメータを調整します。高スループットのアプリケーションでは、可能な限りリクエストをバッチ処理してください。

APIキーを定期的にローテーションし、最小特権の原則を使用することで、統合を保護します。異常を追跡するためにロギングを実装してください。

頻繁なプロンプトにはキャッシュを活用し、冗長な計算を削減します。コードでは次のようになります。

cache = {} # Simple in-memory cache

def cached_message(client, prompt):

if prompt in cache:

return cache[prompt]

response = client.messages.create(

model="claude-haiku-4-5",

messages=[{"role": "user", "content": prompt}]

)

cache[prompt] = response

return response

これは結果を再利用のために保存します。

Apidogでテストする際には、特定のキーワードやステータスコードの確認など、レスポンスに対するアサーションを定義します。

さらに、サンプリングパラメータを試してください。デフォルト設定はうまく機能しますが、クリエイティブなタスクにはtemperatureを、焦点を絞った出力にはtop_pを微調整します。

ツールへの過度な依存など、潜在的な落とし穴に対処するには、モデルに段階的に思考するように促します。

これらに従うことで、信頼性の高い、スケーラブルなデプロイメントを確実にします。

APIテストを強化するためのApidogの統合

Apidogは、API開発とテストのための包括的なプラットフォームとして際立っており、特にClaude Haiku 4.5で有用です。仕様のインポート、テストケースの生成、エンドポイントのモックをサポートしています。

統合するには、Apidogをインストールしてプロジェクトを作成します。Claude APIエンドポイントを追加し、キーで認証し、リクエストを定義します。ApidogのAI機能は、仕様からテストケースを生成することもできます。

Claude Haiku 4.5の場合、リアルタイム応答をシミュレートすることで、レイテンシに敏感なアプリケーションをテストします。そのデバッグツールを使用して、JSONペイロードを検査し、問題を特定します。

マルチエージェントのシナリオでは、Apidogはリクエストを連鎖させ、オーケストレーションを模倣します。

この統合は、開発を加速するだけでなく、ベストプラクティスへの準拠も保証します。

セキュリティと倫理的考慮事項

AnthropicはClaude Haiku 4.5の安全性を重視しており、誤った動作の発生率が低いことを特徴としています。開発者は、ユーザー入力に対するコンテンツフィルターのような保護策を依然として実装する必要があります。

データプライバシー規制を遵守し、プロンプトに機密情報を含めないようにしてください。

倫理的には、AIの関与をユーザーに知らせ、モデルを透明性をもって使用してください。

これらの措置は、責任ある導入を促進します。

一般的な問題のトラブルシューティング

レート制限に遭遇しましたか?前述のようにバックオフを実装してください。

無効な応答ですか?max_tokensを調整するか、プロンプトを洗練させてください。

認証失敗ですか?キーの形式と権限を確認してください。

Apidogは、分析のために完全なインタラクションをログに記録することで役立ちます。

将来の開発とアップデート

AnthropicはClaudeラインアップの進化を続けています。Haiku 4.5のマルチモーダルサポートなどの機能強化に関する発表を監視してください。

APIは後方互換性を維持しているため、アップデートをシームレスに統合してください。

結論

Claude Haiku 4.5 APIは、開発者にとってインテリジェントで効率的なアプリケーションを構築するための多用途なツールを提供します。このガイドに従うことで、基本的なセットアップから高度な統合まで、その可能性を最大限に活用する準備が整います。Apidogのようなツールは、テストと洗練のための無料リソースを提供し、あなたの努力を増幅させることを忘れないでください。

テクノロジーが進歩するにつれて、小さな効率性が積み重なって大きな利点となります。これらの洞察をプロジェクトに適用し、その影響を観察してください。