はじめに

AIアシスタントがますます強力になる一方で、多くの場合クラウド接続が必要であり、プライバシーに関する懸念が生じる時代において、AgenticSeekは、Manus AIのような高度なAIツールの機能を活用しつつ、自身のデータを完全に制御したいユーザーにとって魅力的なソリューションとして登場しました。この包括的なチュートリアルでは、AgenticSeekの効果的なセットアップ、構成、および使用方法について知っておくべきすべてを解説します。

AgenticSeekは、音声対話、自律的なウェブブラウジング、コード生成、タスク計画機能を組み合わせた、100%ローカルなAIアシスタントです。クラウドベースの代替手段とは異なり、完全にあなたのハードウェア上で実行されるため、会話、ファイル、検索はプライベートに保たれます。コーディングアシスタントを探している開発者、ウェブ自動化が必要な研究者、あるいは単にプライバシーを重視する人であろうと、このガイドはAgenticSeekの可能性を最大限に引き出すのに役立ちます。

最大限の生産性で開発チームが協力できる統合されたオールインワンプラットフォームをお探しですか?

Apidogはあなたのすべての要求に応え、Postmanをはるかに手頃な価格で置き換えます!

AgenticSeekの特別な点

完全なプライバシーとローカルでの動作

AgenticSeekの最も重要な利点は、プライバシーへのコミットメントです。言語モデルから音声認識、テキスト読み上げまで、すべてのコンポーネントがマシン上でローカルに実行されます。これは以下を意味します:

- データがデバイスから外部に出ることはありません

- コア機能にクラウドへの依存やインターネット接続は不要です

- AIとの対話を完全に制御できます

- ローカルでの動作にサブスクリプション料金やAPIコストはかかりません

マルチモーダルAI機能

AgenticSeekは単なるチャットボットではありません。以下のような機能を備えた包括的なAIシステムです:

- ウェブを自律的にブラウジング: 検索、記事の読解、情報抽出、さらにはウェブフォームへの入力も可能

- コードの記述と実行: Python、Go、Java、C、その他の言語でプログラムを生成

- 複雑なタスクの計画と実行: 複数の専門エージェントを使用して、大規模なプロジェクトを管理可能なステップに分解

- 音声対話: 自然な音声認識(speech-to-text)およびテキスト読み上げ(text-to-speech)機能

- ファイル管理: ローカルのファイルやディレクトリを操作

インテリジェントなエージェントルーティング

AgenticSeekの際立った機能の1つは、各タスクに最適なエージェントを自動的に選択する能力です。リクエストを行うと、システムはクエリを分析し、それがウェブブラウジングエージェントであろうと、コーディングエージェントであろうと、タスク計画エージェントであろうと、最も適切な専門エージェントにルーティングします。

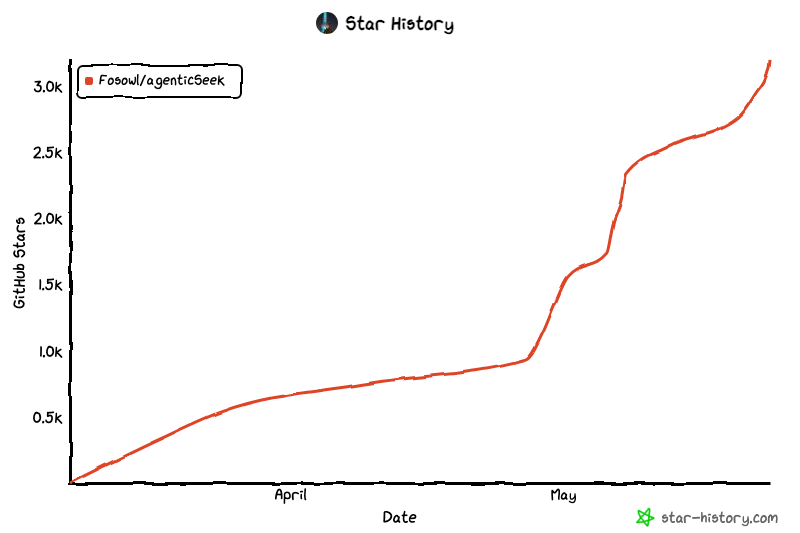

AgenticseekのGithubリポジトリ:

前提条件とハードウェア要件

インストールに進む前に、AgenticSeekを効果的に実行するためのハードウェア要件を理解することが重要です。

最小システム要件

- オペレーティングシステム: Linux、macOS、またはWindows

- Python: バージョン 3.10 (特に推奨)

- Chromeブラウザ: 最新バージョン

- Docker: サポートサービスを実行するため

- メモリ: 少なくとも16GB RAMを推奨

LLMハードウェア要件

AgenticSeekのパフォーマンスは、ローカルで実行することを選択した言語モデルに大きく依存します:

| モデルサイズ | GPU要件 | パフォーマンスに関する注意点 |

|---|---|---|

| 7B | 8GB VRAM | 非推奨 - パフォーマンスが悪く、エラーが頻繁に発生します |

| 14B | 12GB VRAM (RTX 3060または同等) | 単純なタスクには使用可能ですが、複雑な操作では苦労する場合があります |

| 32B | 24GB VRAM (RTX 4090または同等) | ほとんどのタスクで良好なパフォーマンス |

| 70B+ | 48GB+ VRAM (Mac Studio M2 Ultraまたは同等) | 優れたパフォーマンス、パワーユーザーに推奨 |

推奨モデル

AgenticSeekは、以下のような推論に重点を置いたモデルで最もよく動作します:

- Deepseek R1: 推論とツール使用に優れています

- Qwen: 様々なタスクで強力なパフォーマンスを発揮します

- Llamaモデル: 汎用的なパフォーマンスが良好です

インストールプロセス

ステップ1: クローンと初期セットアップ

まず、AgenticSeekリポジトリをクローンし、基本的な構成をセットアップします:

git clone https://github.com/Fosowl/agenticSeek.git

cd agenticSeek

mv .env.example .env

ステップ2: 仮想環境の作成

依存関係の競合を避けるために、特にPython 3.10を使用することが重要です:

python3 -m venv agentic_seek_env

source agentic_seek_env/bin/activate

# Windowsの場合: agentic_seek_env\Scripts\activate

ステップ3: 依存関係のインストール

Linux/macOSの場合 (自動インストール):

./install.sh

Windowsの場合:

./install.bat

手動インストール (自動インストールが失敗した場合):

Linux:

sudo apt update

sudo apt install -y alsa-utils portaudio19-dev python3-pyaudio libgtk-3-dev libnotify-dev libgconf-2-4 libnss3 libxss1

sudo apt install -y chromium-chromedriver

pip3 install -r requirements.txt

macOS:

brew update

brew install --cask chromedriver

brew install portaudio

python3 -m pip install --upgrade pip

pip3 install --upgrade setuptools wheel

pip3 install -r requirements.txt

Windows:

pip install pyreadline3

pip install pyaudio

pip3 install -r requirements.txt

注意: Windowsの場合、公式のChromeウェブサイトからChromeDriverを手動でダウンロードし、PATHに追加する必要があります。

ステップ4: ローカルLLMプロバイダーのセットアップ

最も人気のある選択肢は、その使いやすさからOllamaです:

# Ollamaをインストールして起動

ollama serve

# 推奨モデルをプル

ollama pull deepseek-r1:14b # ハードウェアに基づいてサイズを調整してください

構成のセットアップ

config.iniの理解

AgenticSeekの構成の中心は、config.iniファイルにあります。各設定の詳細な内訳は以下の通りです:

[MAIN]

is_local = True

provider_name = ollama

provider_model = deepseek-r1:14b

provider_server_address = 127.0.0.1:11434

agent_name = Jarvis

recover_last_session = True

save_session = True

speak = True

listen = False

work_dir = /Users/yourname/Documents/ai_workspace

jarvis_personality = False

languages = en zh

[BROWSER]

headless_browser = True

stealth_mode = True

主な構成オプションの説明

コア設定:

is_local: ローカル動作の場合はTrue、APIプロバイダーの場合はFalseに設定provider_name:ollama、lm-studio、openaiなどから選択provider_model: 使用する特定のモデル (例:deepseek-r1:14b)work_dir: AgenticSeekがファイルを読み書きできるディレクトリ

パーソナリティと対話:

agent_name: AIアシスタントの名前 (音声でのウェイクワードとして使用)speak: テキスト読み上げ出力を有効にするlisten: 音声認識入力を有効にする (CLIのみ)jarvis_personality: より会話的な、Jarvisのようなパーソナリティを使用する

ブラウザ設定:

headless_browser: ウィンドウを表示せずにブラウザを実行 (ウェブインターフェースに推奨)stealth_mode: ボット検出を回避するためにundetected Seleniumを使用

ワークスペースのセットアップ

AgenticSeekが作業するための専用ディレクトリを選択してください。これは、AIがファイルを生成、変更、整理しても問題ない場所である必要があります:

mkdir ~/Documents/agentic_workspace

config.iniをこのパスで更新します:

work_dir = /Users/yourname/Documents/agentic_workspace

はじめに: 初回実行

サービスの開始

AgenticSeekを実行する前に、サポートサービスを開始する必要があります:

# 仮想環境をアクティベート

source agentic_seek_env/bin/activate

# サービスを開始 (ウェブ検索用のSearxNG、Redis、フロントエンド)

sudo ./start_services.sh # Linux/macOS

# または

start_services.cmd # Windows

オプション1: コマンドラインインターフェース (CLI)

CLIインターフェースは、ターミナルベースの操作を好むユーザーに最適です:

python3 cli.py

推奨CLI設定:

- ブラウザの動作を確認するためにconfig.iniで

headless_browser = Falseに設定 - 音声応答のために

speak = Trueに設定 - 音声入力を希望する場合は

listen = Trueに設定

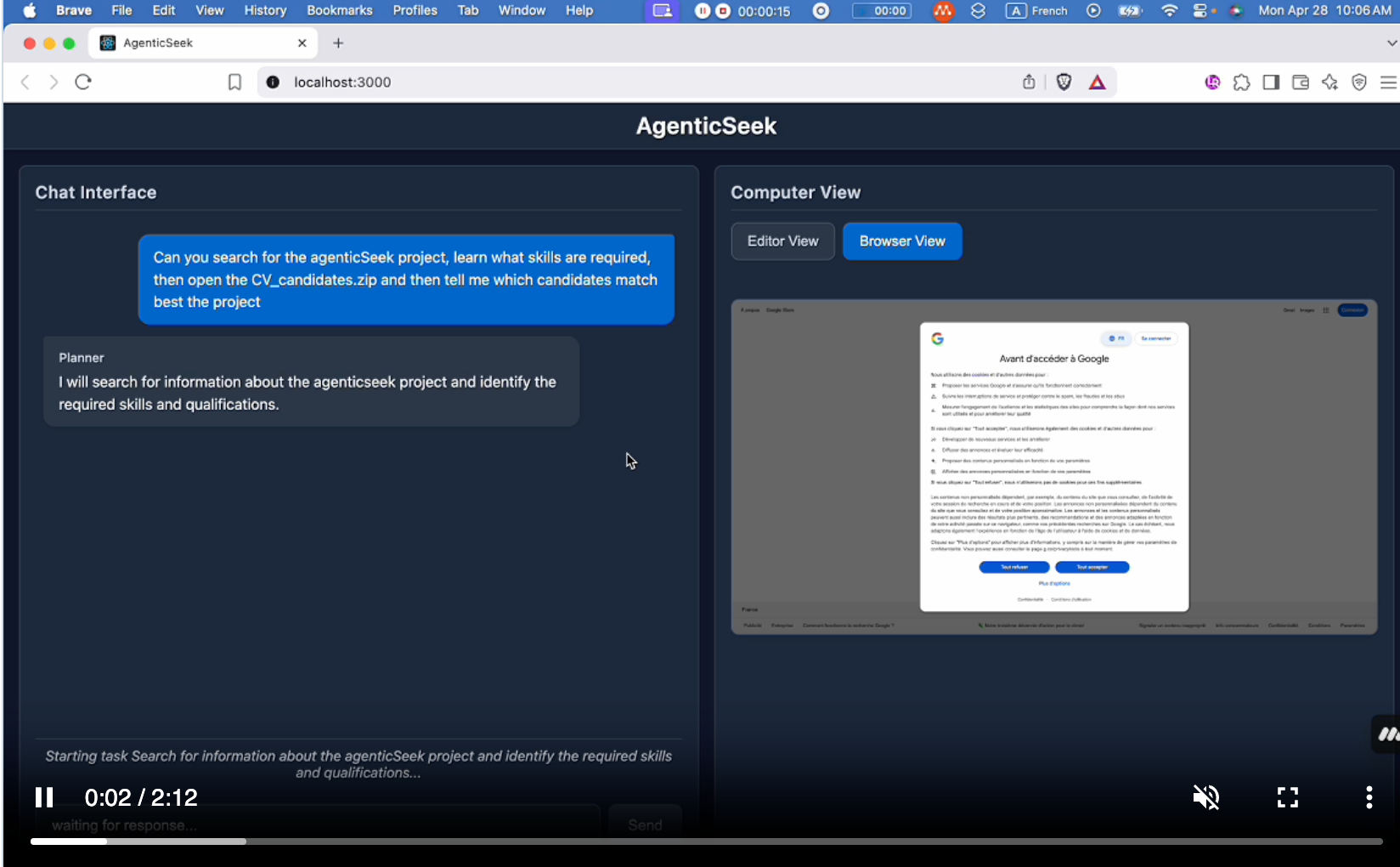

オプション2: ウェブインターフェース

より視覚的な体験のために、ウェブインターフェースを使用します:

# バックエンドを開始

python3 api.py

次にブラウザを開き、http://localhost:3000/にアクセスします。

推奨ウェブインターフェース設定:

- パフォーマンス向上のために

headless_browser = Trueに設定 - ブラウザで音声を希望しない限り、

speak = Falseのままにする

AgenticSeekの機能の理解

ウェブブラウジングと調査

AgenticSeekはインターネットを自律的にブラウジングして情報を収集できます。効果的なクエリの例を以下に示します:

良いクエリ: 「2024年のプログラミング言語トップ10をウェブで検索し、要約をprogramming_trends.txtに保存して」

避けるべきクエリ: 「人気のあるプログラミング言語は何?」 (曖昧すぎる、ウェブ検索が必要であることを示していない)

AIは以下を行うことができます:

- SearxNG (プライバシー重視の検索エンジン) を使用して検索

- ウェブサイトをナビゲートし、情報を抽出

- ウェブフォームへの入力 (実験的機能)

- コンテンツのダウンロードと保存

コード生成と実行

AgenticSeekは複数の言語でのコード記述と実行に優れています:

リクエスト例:

- 「CSVデータを分析し、可視化を作成するPythonスクリプトを書いて」

- 「REST APIサーバーを実装するGoプログラムを作成して」

- 「クイックソートアルゴリズムを使用して配列をソートするCプログラムを書いて」

AIは以下を行います:

- 完全で実行可能なコードを生成

- 必要なインポートと依存関係を追加

- コードをテストし、基本的なエラーを修正

- 指定されたワークスペースにファイルを保存

タスク計画と実行

複雑なタスクの場合、AgenticSeekはそれらを管理可能なステップに分解できます:

例: 「パリへの週末旅行を計画して、フライト、ホテル、アクティビティを含めて。オプションを調査し、推奨事項をparis_trip.txtに保存して」

AIは以下を行います:

- フライトオプションを調査

- ホテルを推奨

- 人気のアクティビティやレストランを発見

- すべてを整理されたドキュメントにまとめる

ファイル管理

AgenticSeekはローカルファイルを操作できます:

- ドキュメントを読み込み、分析

- ファイルを整理し、名前を変更

- 新しいファイルとディレクトリを作成

- 既存のファイルからデータを処理

高度な機能

音声対話

音声機能を有効にするには、これらの設定を構成します:

speak = True # テキスト読み上げを有効にする

listen = True # 音声認識を有効にする (CLIのみ)

agent_name = Friday # 音声アクティベーションのウェイクワード

音声コマンドの使用:

- エージェントの名前を言います (例: 「フライデー」)

- 文字起こしが表示されるのを待ちます

- リクエストを明確に話します

- 「do it」、「go ahead」、「execute」のような確認フレーズで終了します

サポートされている確認フレーズ:

- "do it"

- "go ahead"

- "execute"

- "run"

- "start"

- "thanks"

- "please"

- "proceed"

多言語サポート

AgenticSeekはテキスト読み上げのために複数の言語をサポートしています:

languages = en zh fr es # 英語、中国語、フランス語、スペイン語

リストの最初の言語が、テキスト読み上げのデフォルトになります。

セッション管理

AgenticSeekが会話履歴をどのように処理するかを制御します:

recover_last_session = True # 前回の会話を再開

save_session = True # 現在の会話を記憶

これは、長期にわたるプロジェクトや、複数のセッションにわたって作業を継続する必要がある場合に特に役立ちます。

効果的な使用パターン

クエリのベストプラクティス

アクションを具体的に指定する:

- 代わりに: 「Pythonについて教えて」

- 使用: 「Pythonチュートリアルをウェブで検索し、上位5つのリンクをpython_resources.txtに保存して」

ファイル操作を指定する:

- 「結果をfilename.txtに保存して」

- 「project_nameという新しいディレクトリを作成して」

- 「既存のfile.csvからデータを読み込み、分析して」

ウェブ検索の指示:

- オンライン調査が必要な場合は、常に「ウェブで検索して」または「インターネットをブラウジングして」と言及する

- 探している情報を具体的に指定する

最適なワークフロー例

調査プロジェクト:

- 「2024年の最近のAI開発についてウェブで検索して」

- 「調査結果を要約し、ai_developments_2024.txtに保存して」

- 「要約で言及されたトレンドを可視化するPythonスクリプトを作成して」

開発タスク:

- 「ウェブスクレーパーの新しいPythonプロジェクト構造を作成して」

- 「BeautifulSoupを使用して主要なスクレイピングモジュールを記述して」

- 「スクレーパーにエラー処理とロギングを追加して」

- 「スクレイピング関数の単体テストを記述して」

データ分析:

- 「ワークスペースにあるsales_data.csvファイルを読み込んで」

- 「トレンドとパターンについてデータを分析して」

- 「月間売上トレンドを示す可視化を作成して」

- 「洞察を含むレポートを生成し、sales_analysis.txtとして保存して」

一般的な問題のトラブルシューティング

ChromeDriverの問題

エラー: ChromeとChromeDriverのバージョン不一致

解決策:

- Chromeのバージョンを確認します:

google-chrome --version - 一致するChromeDriverをhttps://developer.chrome.com/docs/chromedriver/downloadsからダウンロードします

- 既存のChromeDriverを新しいバージョンに置き換えます

接続の問題

エラー: 「接続アダプターが見つかりませんでした」

解決策: プロバイダーアドレスにプロトコルが含まれていることを確認してください:

provider_server_address = http://127.0.0.1:11434

SearxNGベースURLエラー

解決策: .env.exampleを.envに名前変更したか、または環境変数をエクスポートしたことを確認してください:

export SEARXNG_BASE_URL="http://127.0.0.1:8080"

パフォーマンスの問題

AIパフォーマンスの低下:

- より大きなモデルを使用する (可能であれば32B以上)

- 十分なVRAM/RAMを確保する

- LLMプロバイダーが適切に実行されていることを確認する

ウェブブラウジングの遅延:

- 互換性向上のためにstealth_modeを有効にする

- 高速化のためにheadless_browser = Trueに設定する

- インターネット接続を確認する

高度な構成オプション

異なるLLMプロバイダーの使用

Ollamaのセットアップ:

provider_name = ollama

provider_model = deepseek-r1:32b

provider_server_address = 127.0.0.1:11434

LM Studioのセットアップ:

provider_name = lm-studio

provider_model = your-model-name

provider_server_address = http://127.0.0.1:1234

リモートサーバーのセットアップ:

LLMを実行している強力なサーバーがある場合:

provider_name = server

provider_model = deepseek-r1:70b

provider_server_address = your-server-ip:3333

APIプロバイダーオプション

十分なハードウェアがないユーザー向けに、APIプロバイダーが利用可能です:

is_local = False

provider_name = deepseek

provider_model = deepseek-chat

APIキーをエクスポートします:

export DEEPSEEK_API_KEY="your-api-key-here"

最適な使用のためのヒント

ハードウェアの最適化

- GPUメモリ管理: 不要なアプリケーションを閉じてVRAMを解放する

- モデル選択: より小さなモデルから始め、必要に応じてアップグレードする

- RAM使用量: 特に大きなモデルを使用している場合、システムメモリを監視する

クエリの最適化

- 明確にする: ウェブ検索、ファイル操作、コード生成が必要な場合は常に指定する

- 複雑なタスクを分解する: 複数ステップのプロセスでは、明確なステップバイステップの指示を提供する

- 具体的なファイル名を使用する: 常に正確なファイル名と場所を指定する

ワークフローの効率化

- ワークスペースを整理する: work_dirを明確なフォルダ構造で整理しておく

- セッション管理を使用する: 長期プロジェクトのためにセッション保存を有効にする

- 音声コマンドをテストする: より良い認識のために静かな環境で音声コマンドを練習する

結論

AgenticSeekは、プライバシーに配慮したAIアシスタンスにおいて重要な一歩を進めました。この包括的なガイドに従うことで、ウェブブラウジング、コード生成、タスク計画、音声対話が可能な完全に機能するローカルAIアシスタントを手に入れることができ、同時にデータを完全にプライベートに保つことができます。

AgenticSeekは進化するプロジェクトであることを忘れないでください。使用するにつれて、新しい機能や最適な使用パターンを発見するでしょう。成功の鍵は、リクエストを具体的にすること、システムの強みを理解すること、そしてそのマルチエージェントアーキテクチャを活用することです。

AgenticSeekを調査、開発、または一般的な生産性タスクに使用する場合でも、そのプライバシー、機能、およびローカル動作の組み合わせは、クラウドベースのAIアシスタントに代わる強力な選択肢となります。簡単なタスクから始めてシステムに慣れ、その機能に慣れてきたら、徐々により複雑なワークフローを探求してください。

AIアシスタンスの未来は、ローカルでプライベートであり、あなたの完全な制御下にあります—そしてAgenticSeekは、その未来をすべての人にアクセス可能にする道をリードしています。