Bayangkan memiliki superkomputer di saku Anda, yang mampu memahami dan menghasilkan teks seperti manusia tentang topik apa pun. Kedengarannya seperti fiksi ilmiah, bukan? Nah, berkat terobosan baru-baru ini dalam kecerdasan buatan, impian ini sekarang menjadi kenyataan – dan itu disebut Ollama.

Ollama seperti pisau Swiss Army untuk LLM Lokal. Ini adalah alat sumber terbuka yang memungkinkan Anda menjalankan model bahasa yang kuat langsung di komputer Anda sendiri. Tidak perlu layanan cloud mewah atau gelar di bidang ilmu komputer. Tapi inilah yang membuatnya semakin menarik: Ollama memiliki kekuatan super tersembunyi yang disebut API. Anggap saja itu sebagai bahasa rahasia yang memungkinkan program Anda berbicara langsung dengan otak AI ini.

Sekarang, saya tahu apa yang Anda pikirkan. "API? Kedengarannya rumit!"

Jangan khawatir – di situlah Apidog berperan. Ini seperti penerjemah ramah yang membantu Anda berkomunikasi dengan API Ollama tanpa berkeringat. Dalam artikel ini, kita akan memulai perjalanan bersama. Saya akan menjadi pemandu Anda saat kita menjelajahi cara melepaskan potensi penuh Ollama menggunakan Apidog. Pada akhirnya, Anda akan membuat aplikasi bertenaga AI seperti seorang profesional, semuanya dari kenyamanan mesin Anda sendiri. Jadi, bersiaplah – saatnya menyelami dunia AI lokal yang menarik dan menemukan betapa mudahnya itu!

Apa itu Ollama dan Bagaimana Cara Menggunakan Ollama untuk Menjalankan LLM Secara Lokal?

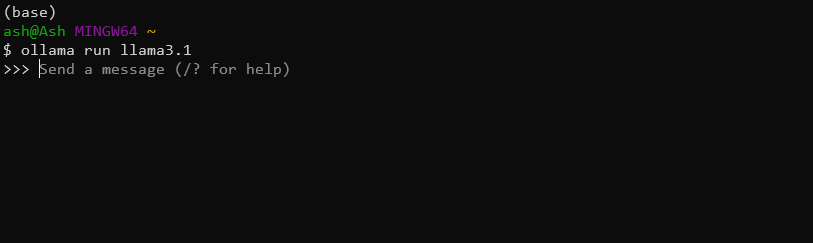

Ollama adalah alat yang nyaman yang memungkinkan pengguna untuk menjalankan model bahasa besar di mesin lokal mereka. Ini menyederhanakan proses mengunduh, menjalankan, dan menyempurnakan berbagai LLM, membuat kemampuan AI tingkat lanjut dapat diakses oleh audiens yang lebih luas. Misalnya, Anda dapat dengan mudah mengunduh dan menginstal model Llama 3.1 8B terbaru hanya dengan perintah ini:

ollama run llama3.1

Apakah Ollama memiliki API?

Ya, Anda dapat menggunakan API Ollama untuk mengintegrasikan LLM Lokal yang kuat ini ke dalam aplikasi mereka dengan mulus.

Fitur utama API Ollama meliputi:

- Manajemen model (menarik, membuat daftar, dan menghapus model)

- Pembuatan teks (penyelesaian dan interaksi obrolan)

- Pembuatan penyematan

- Kemampuan penyempurnaan

Dengan menggunakan API Ollama, Anda dapat dengan mudah memanfaatkan kekuatan LLM dalam aplikasi mereka tanpa memerlukan infrastruktur yang kompleks atau ketergantungan cloud.

Menggunakan Apidog untuk Menguji API Ollama

Apidog adalah platform pengembangan dan dokumentasi API serbaguna yang dirancang untuk menyederhanakan seluruh siklus hidup API. Ia menawarkan antarmuka yang mudah digunakan untuk merancang, menguji, dan mendokumentasikan API, menjadikannya alat yang ideal untuk bekerja dengan API Ollama.

Beberapa fitur unggulan APIDog meliputi:

- Antarmuka desain API yang intuitif

- Pembuatan dokumentasi otomatis

- Alat pengujian dan debugging API

- Fitur kolaborasi untuk proyek tim

- Dukungan untuk berbagai protokol dan format API

Dengan Apidog, pengembang dapat dengan mudah membuat, mengelola, dan berbagi dokumentasi API, memastikan bahwa integrasi API Ollama mereka terdokumentasi dengan baik dan dapat dipelihara.

Prasyarat

Sebelum menyelami pembuatan panggilan API Ollama dengan Apidog, pastikan Anda memiliki prasyarat berikut:

Instalasi Ollama: Unduh dan instal Ollama di mesin lokal Anda. Ikuti dokumentasi resmi Ollama untuk instruksi instalasi khusus untuk sistem operasi Anda.

Akun APIDog: Daftar untuk akun Apidog jika Anda belum melakukannya. Anda dapat menggunakan versi berbasis web atau mengunduh aplikasi desktop, tergantung pada preferensi Anda.

Model Ollama: Tarik model menggunakan antarmuka baris perintah Ollama. Misalnya, untuk mengunduh model "llama2", Anda akan menjalankan:

ollama pull llama3.1

Alat Pengujian API: Meskipun Apidog menyediakan kemampuan pengujian bawaan, Anda mungkin juga ingin memiliki alat seperti cURL atau Postman untuk pengujian dan verifikasi tambahan.

Dengan elemen-elemen ini, Anda siap untuk mulai menjelajahi API Ollama menggunakan Apidog.

Membuat Proyek API Ollama di Apidog

Untuk mulai bekerja dengan API Ollama di Apidog, ikuti langkah-langkah berikut:

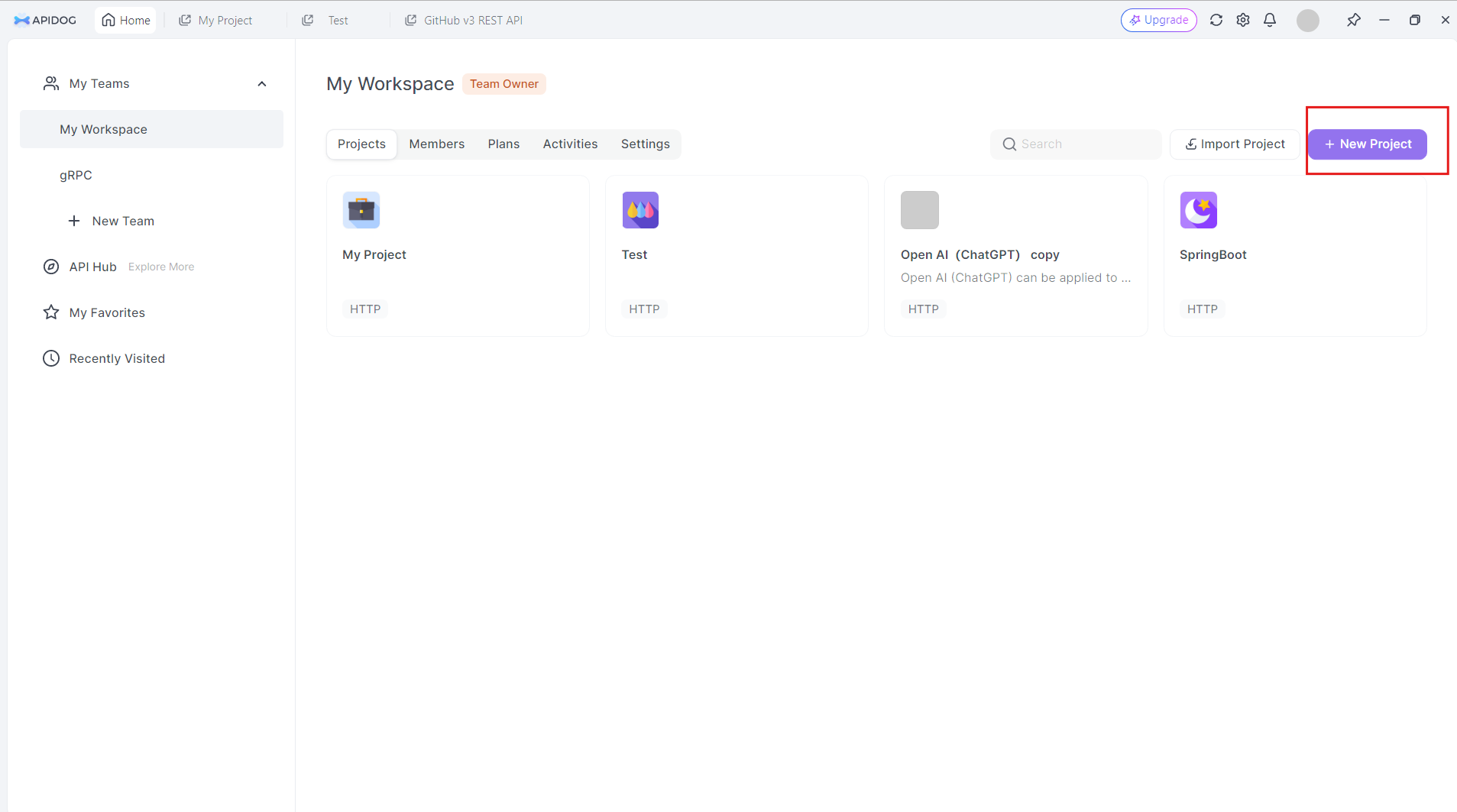

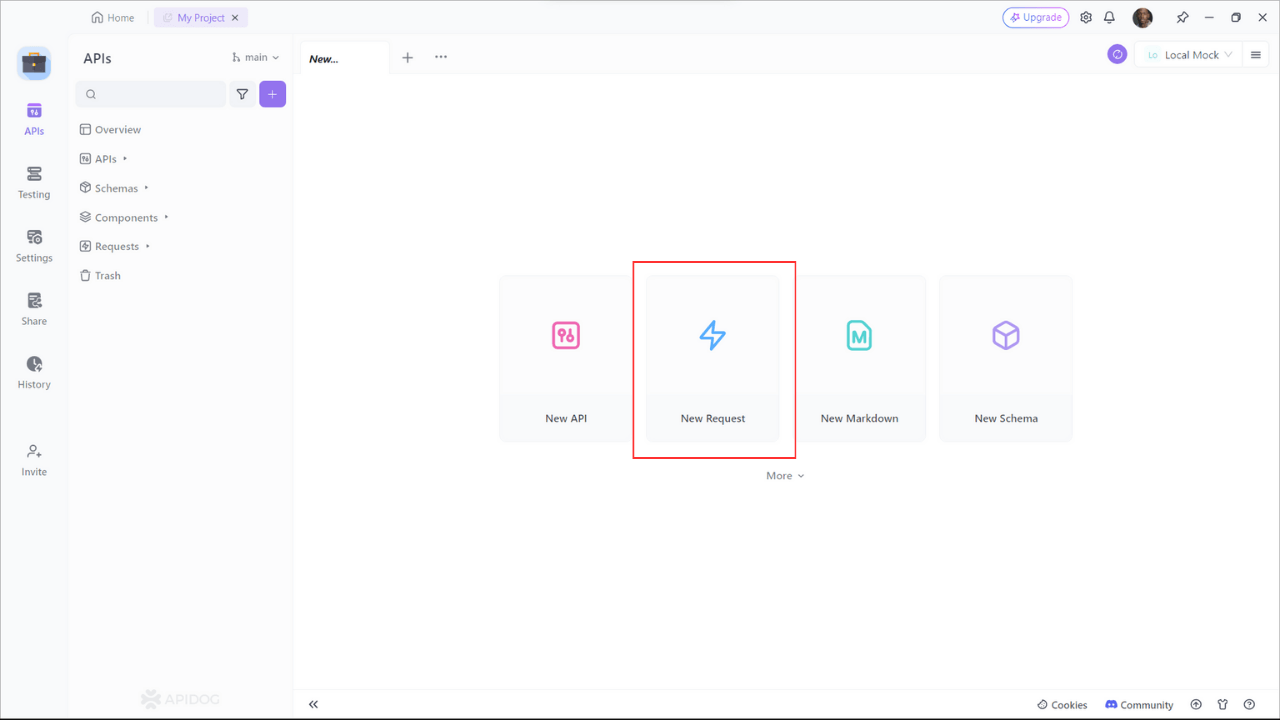

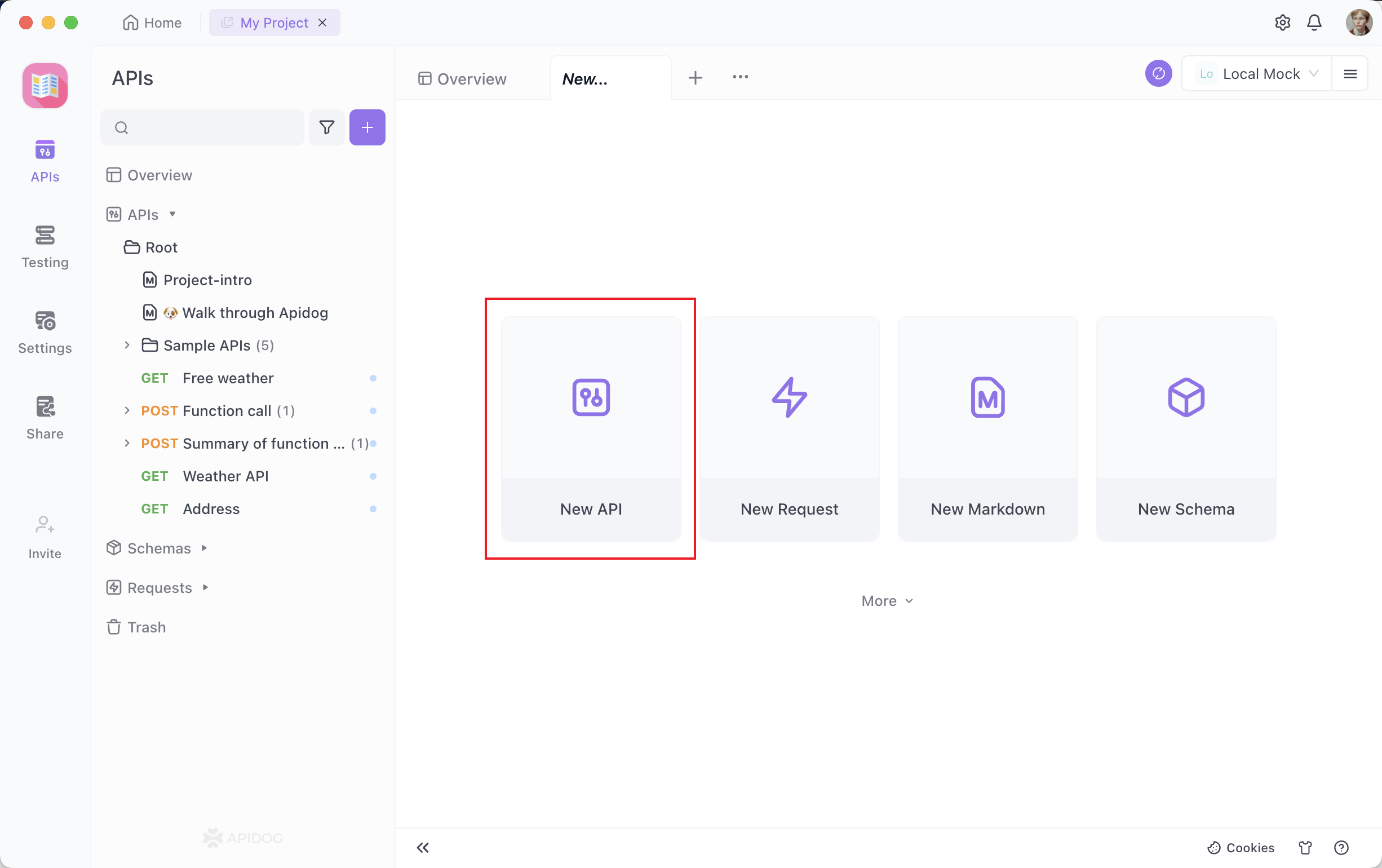

Buat Proyek Baru: Masuk ke Apidog dan buat proyek baru khusus untuk pekerjaan API Ollama Anda. Klik Tombol Proyek Baru di sudut kanan atas

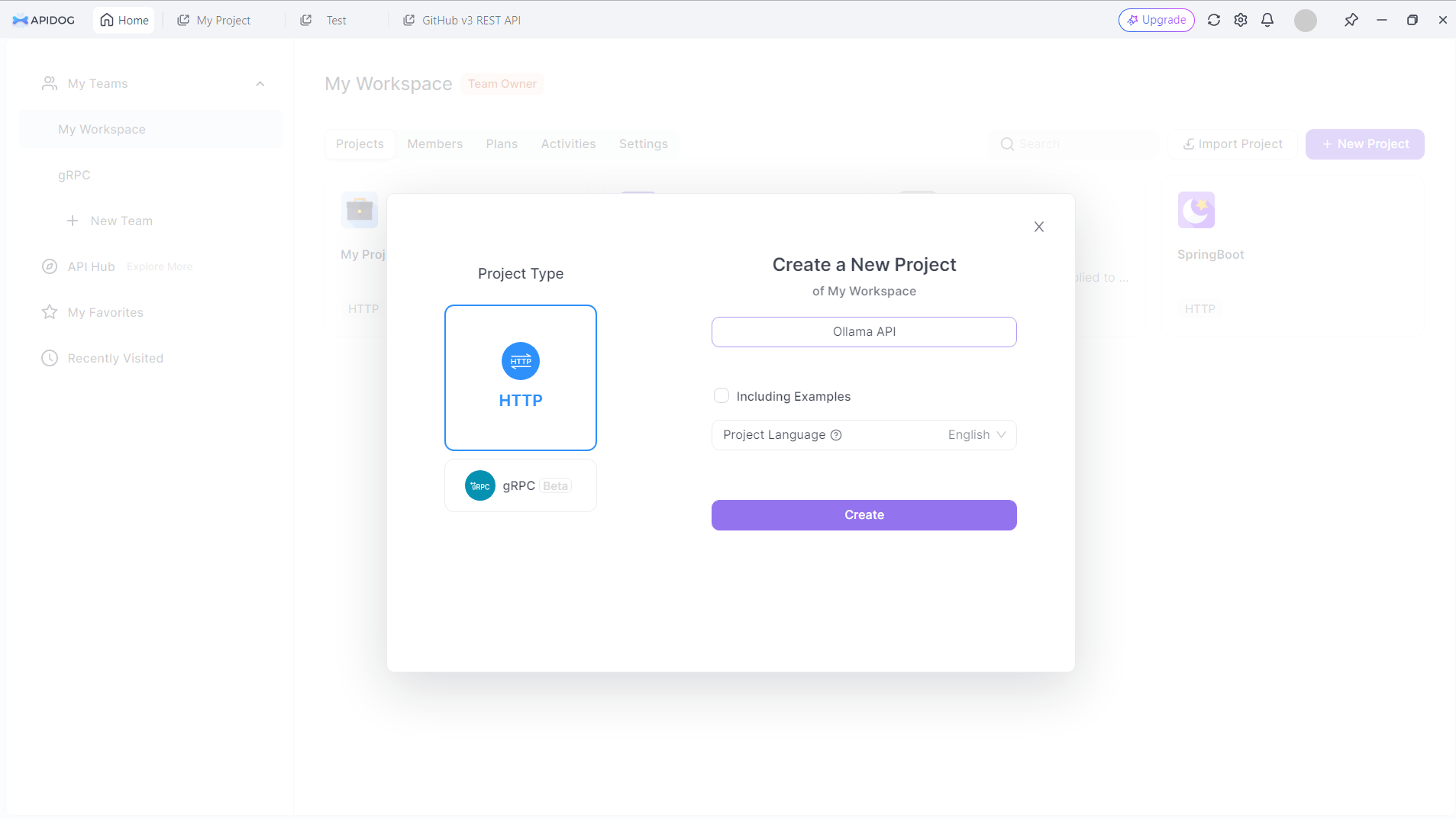

Beri nama proyek baru Anda. Katakanlah: API Ollama:

Klik tombol Buat untuk melanjutkan.

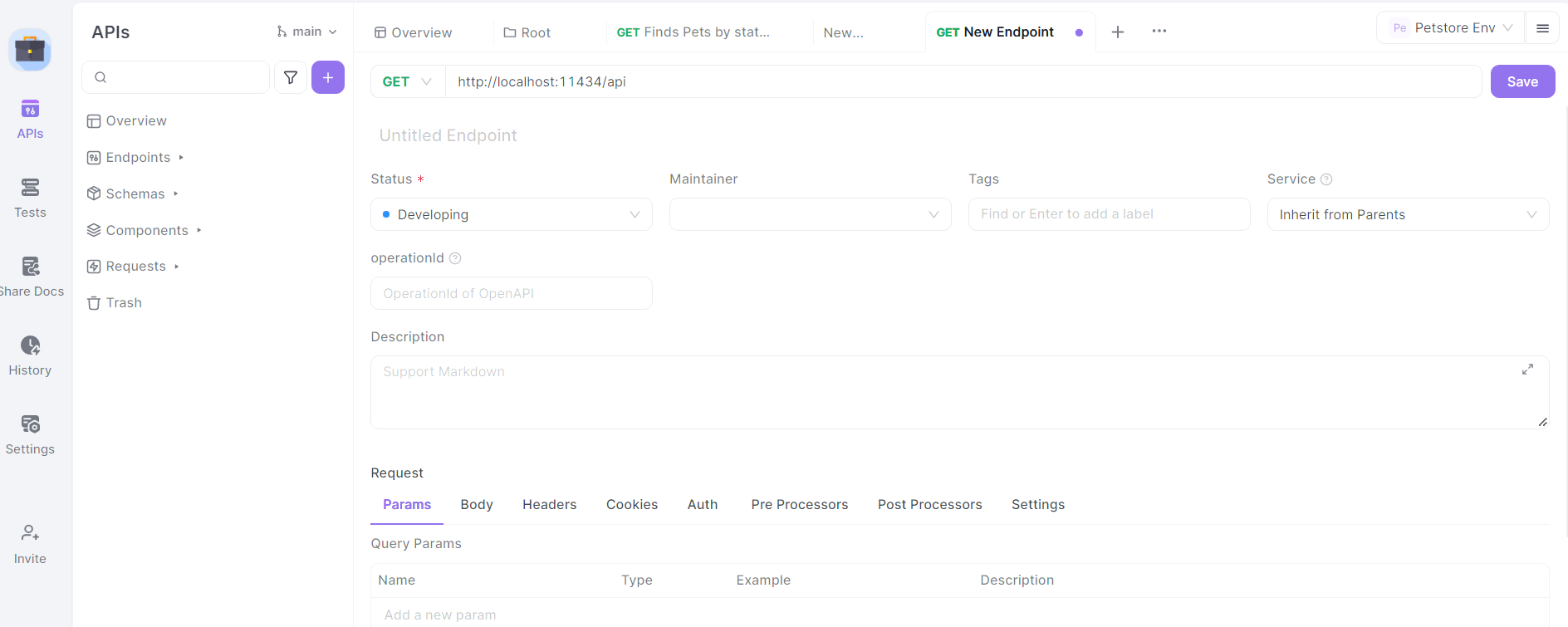

Siapkan URL Dasar: Di pengaturan proyek Anda, atur URL dasar ke http://localhost:11434/api. Ini adalah alamat default tempat Ollama mengekspos titik akhir API-nya.

Impor Spesifikasi API Ollama: Meskipun Ollama tidak menyediakan spesifikasi OpenAPI resmi, Anda dapat membuat struktur dasar untuk titik akhir API secara manual di APIDog.

Tentukan Titik Akhir: Mulailah dengan menentukan titik akhir API Ollama utama di APIDog. Beberapa titik akhir utama yang perlu disertakan adalah:

/generate(POST): Untuk pembuatan teks/chat(POST): Untuk interaksi berbasis obrolan/embeddings(POST): Untuk menghasilkan penyematan/pull(POST): Untuk menarik model baru/list(GET): Untuk membuat daftar model yang tersedia

Untuk setiap titik akhir, tentukan metode HTTP, parameter permintaan, dan format respons yang diharapkan berdasarkan dokumentasi API Ollama.

Merancang Panggilan API Ollama di Apidog

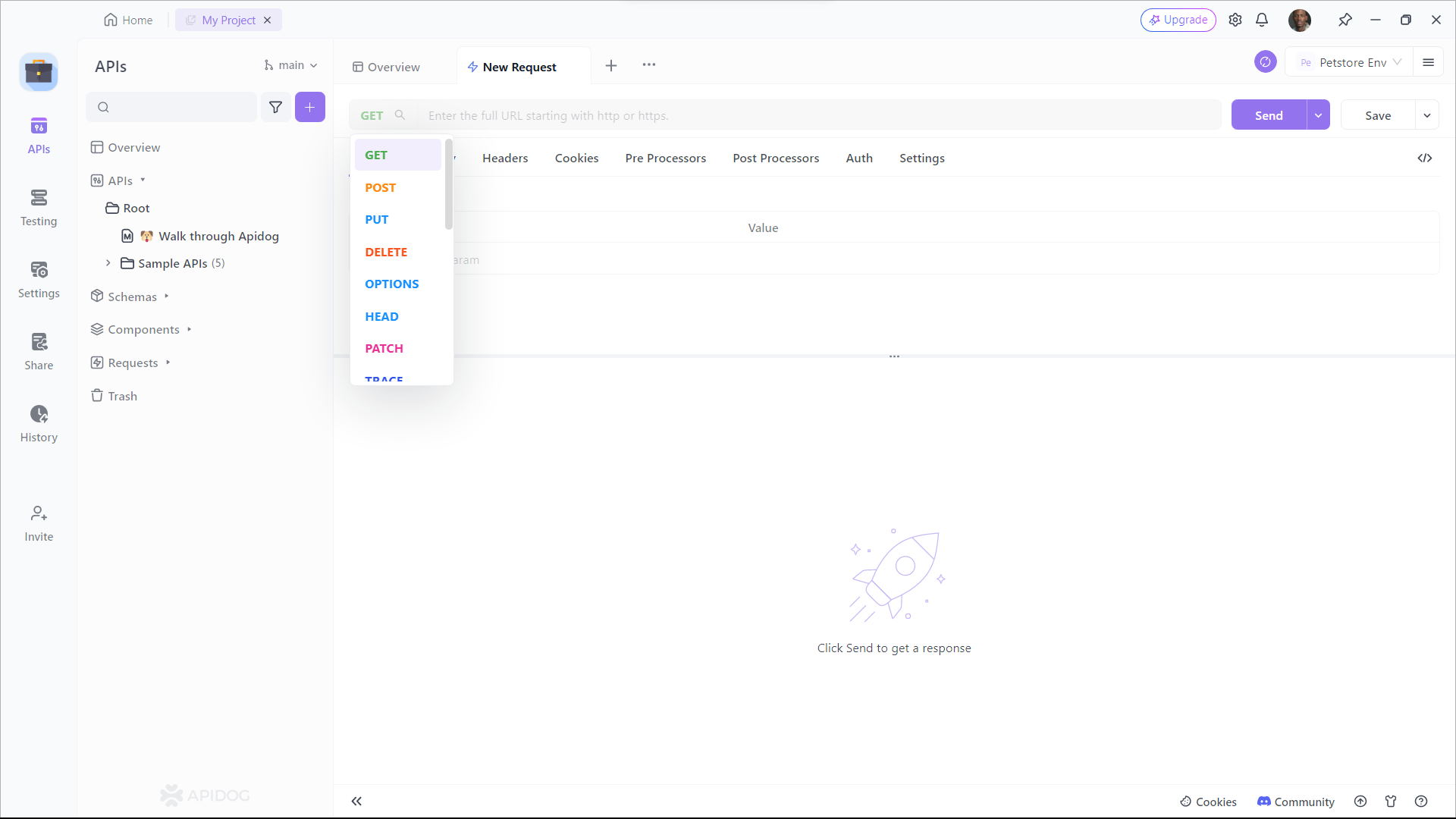

Mari kita telusuri proses perancangan panggilan API untuk beberapa titik akhir Ollama yang paling umum digunakan menggunakan Apidog:

Titik Akhir Pembuatan Teks (/generate)

Di Apidog, buat titik akhir API baru dengan jalur /generate dan atur metode HTTP ke POST.

Tentukan skema badan permintaan:

{

"model": "string",

"prompt": "string",

"system": "string",

"template": "string",

"context": "array",

"options": {

"temperature": "number",

"top_k": "integer",

"top_p": "number",

"num_predict": "integer",

"stop": "array"

}

}

Berikan deskripsi untuk setiap parameter, menjelaskan tujuannya dan batasan apa pun.

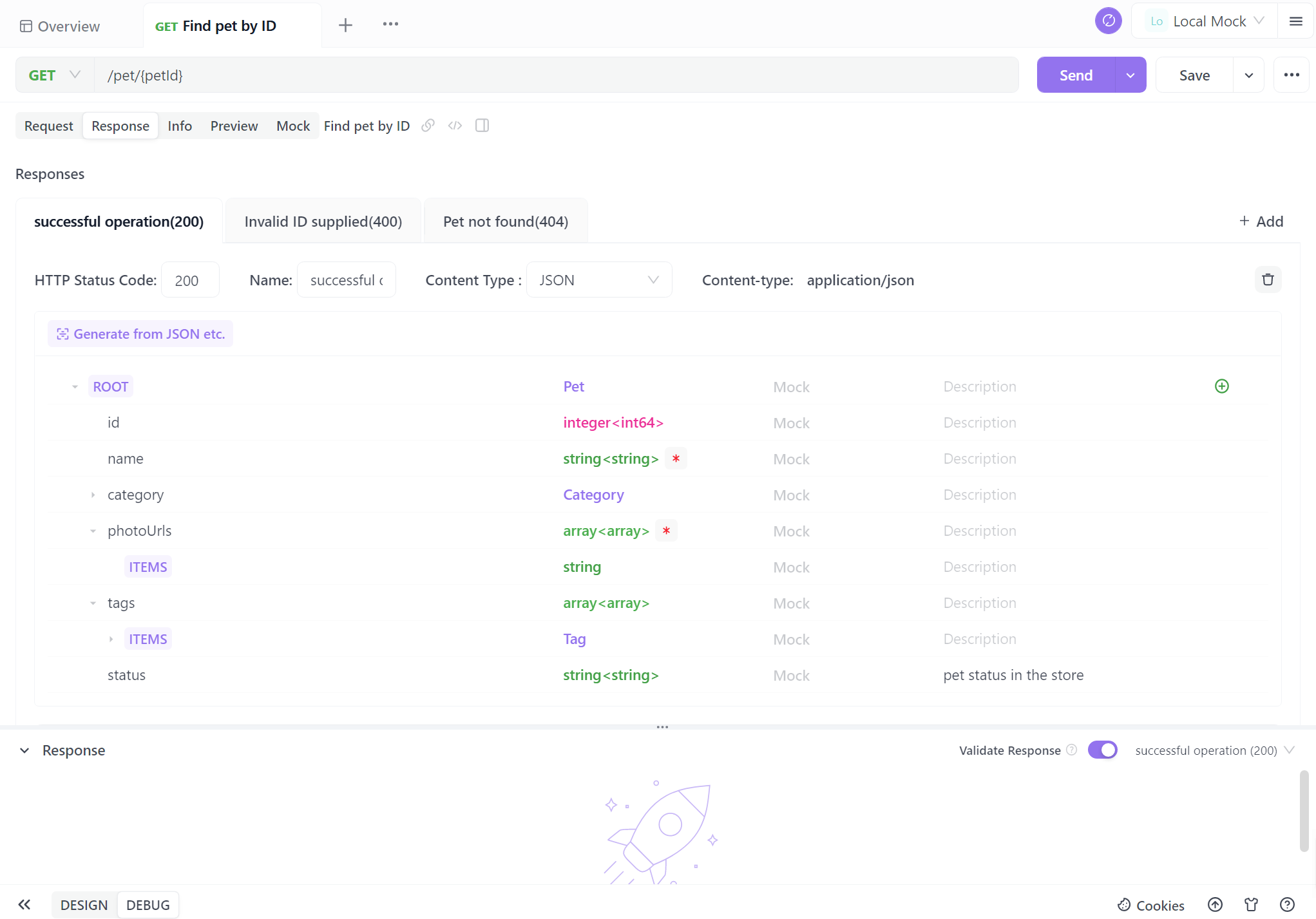

Tentukan skema respons berdasarkan dokumentasi API Ollama, termasuk bidang seperti response, context, dan total_duration.

Titik Akhir Obrolan (/chat)

Buat titik akhir baru dengan jalur /chat dan atur metode HTTP ke POST.

Tentukan skema badan permintaan:

{

"model": "string",

"messages": [

{

"role": "string",

"content": "string"

}

],

"format": "string",

"options": {

"temperature": "number",

"top_k": "integer",

"top_p": "number",

"num_predict": "integer",

"stop": "array"

}

}

Berikan deskripsi terperinci untuk larik messages, menjelaskan struktur pesan obrolan dengan peran (sistem, pengguna, asisten) dan konten.

Tentukan skema respons, termasuk objek message dengan bidang role dan content.

Titik Akhir Manajemen Model

Buat titik akhir untuk operasi manajemen model:

- Tarik Model (

/pull): Permintaan POST dengan parameternameuntuk model yang akan diunduh. - Daftar Model (

/list): Permintaan GET untuk mengambil model yang tersedia. - Hapus Model (

/delete): Permintaan DELETE dengan parameternameuntuk model yang akan dihapus.

Untuk setiap titik akhir ini, tentukan skema permintaan dan respons yang sesuai berdasarkan dokumentasi API Ollama.

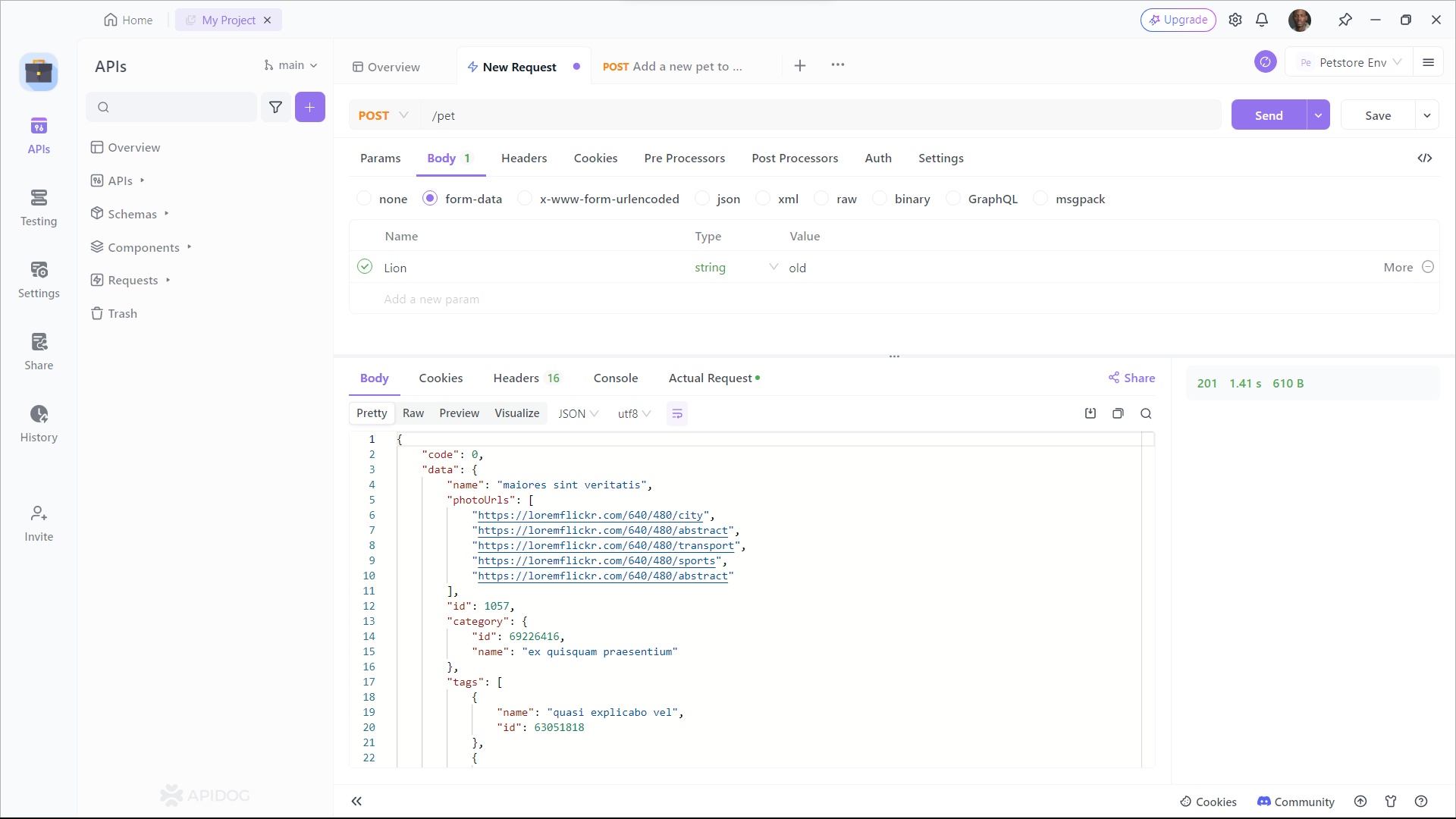

Menguji Panggilan API Ollama di Apidog

Apidog menyediakan lingkungan pengujian bawaan yang memungkinkan Anda mengirim permintaan ke API Ollama Anda dan memverifikasi respons. Berikut cara menggunakannya:

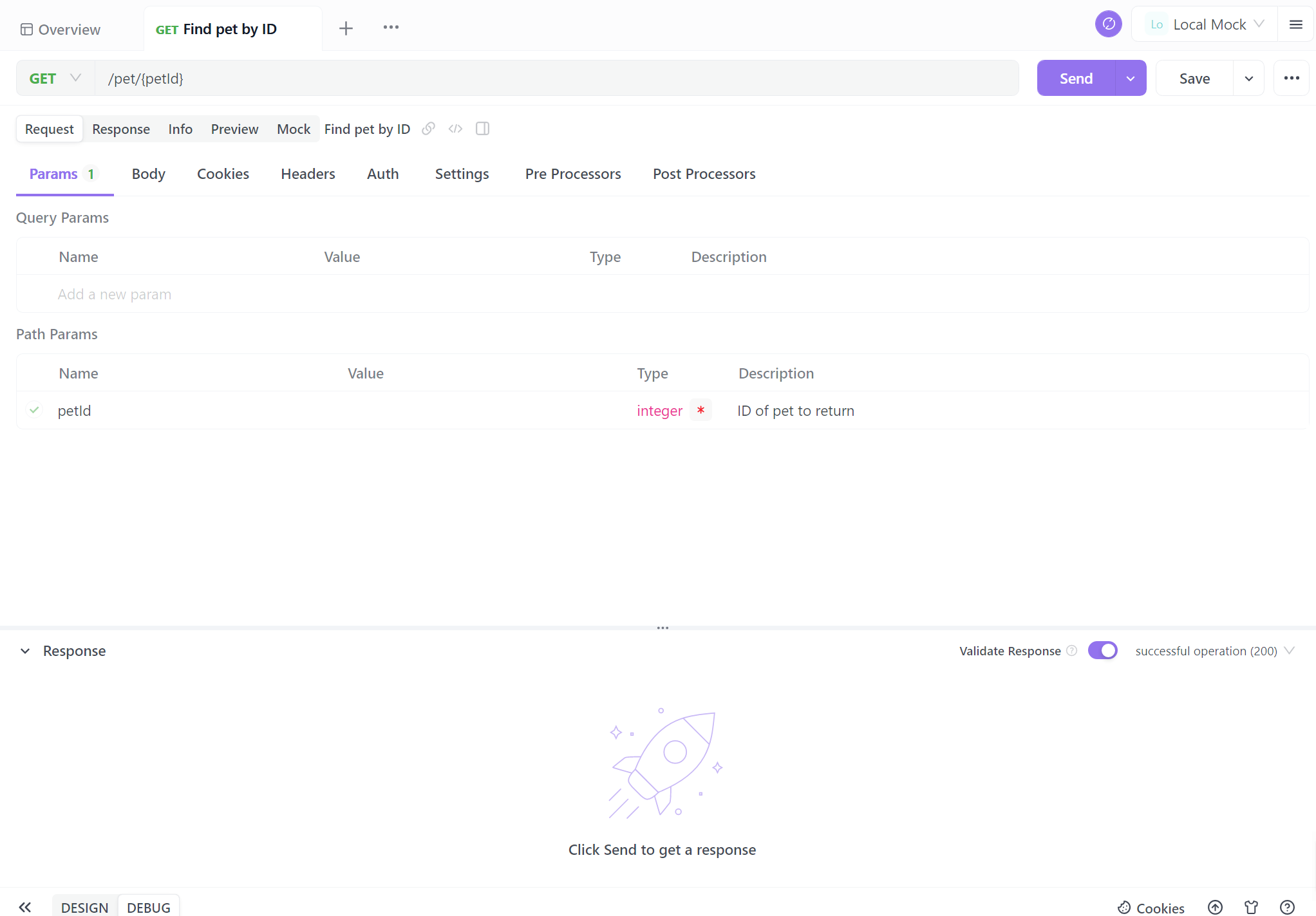

Pilih Titik Akhir: Pilih salah satu titik akhir API Ollama yang telah Anda tentukan di Apidog.

Konfigurasikan Parameter Permintaan: Isi parameter yang diperlukan untuk titik akhir yang dipilih. Misalnya, untuk titik akhir /generate, Anda dapat mengatur:

{

"model": "llama2",

"prompt": "Jelaskan konsep kecerdasan buatan dalam istilah sederhana."

}

Kirim Permintaan: Gunakan tombol "Kirim" Apidog untuk mengeksekusi panggilan API ke instance Ollama lokal Anda.

Periksa respons dari Ollama, verifikasi bahwa itu sesuai dengan format yang diharapkan dan berisi teks yang dihasilkan atau informasi relevan lainnya. Jika Anda mengalami masalah, gunakan alat debugging Apidog untuk memeriksa header permintaan dan respons, badan, dan pesan kesalahan apa pun.

Menghasilkan Dokumentasi API

Salah satu fitur Apidog yang paling kuat adalah kemampuannya untuk secara otomatis menghasilkan dokumentasi API yang komprehensif. Untuk membuat dokumentasi untuk proyek API Ollama Anda:

Langkah 1: Daftar ke Apidog

Untuk mulai menggunakan Apidog untuk pembuatan dokumentasi API, Anda harus mendaftar untuk akun jika Anda belum melakukannya. Setelah Anda masuk, Anda akan disambut oleh antarmuka Apidog yang mudah digunakan.

Langkah 2: Membuat Permintaan API Anda

Proyek dokumentasi API terdiri dari berbagai titik akhir, yang masing-masing mewakili rute atau fungsionalitas API tertentu. Untuk menambahkan titik akhir, klik tombol "+" atau "API Baru" di dalam proyek Anda.

Langkah 3: Siapkan Parameter Permintaan

Anda harus memberikan detail seperti URL titik akhir, deskripsi, dan detail permintaan/respons. Sekarang tibalah bagian penting – mendokumentasikan titik akhir Anda. Apidog membuat proses ini sangat mudah. Untuk setiap titik akhir, Anda dapat:

- Tentukan metode HTTP (GET, POST, PUT, DELETE, dll.).

- Tentukan parameter permintaan, termasuk nama, jenis, dan deskripsinya.

- Jelaskan respons yang diharapkan, termasuk kode status, format respons (JSON, XML, dll.), dan contoh respons.

Banyak pengembang yang tidak suka menulis dokumentasi API, seringkali menganggapnya rumit. Namun, pada kenyataannya, dengan Apidog, Anda dapat menyelesaikannya hanya dengan beberapa klik mouse. Antarmuka visual Apidog ramah pemula, membuatnya jauh lebih sederhana daripada menghasilkan dokumentasi API dari kode.

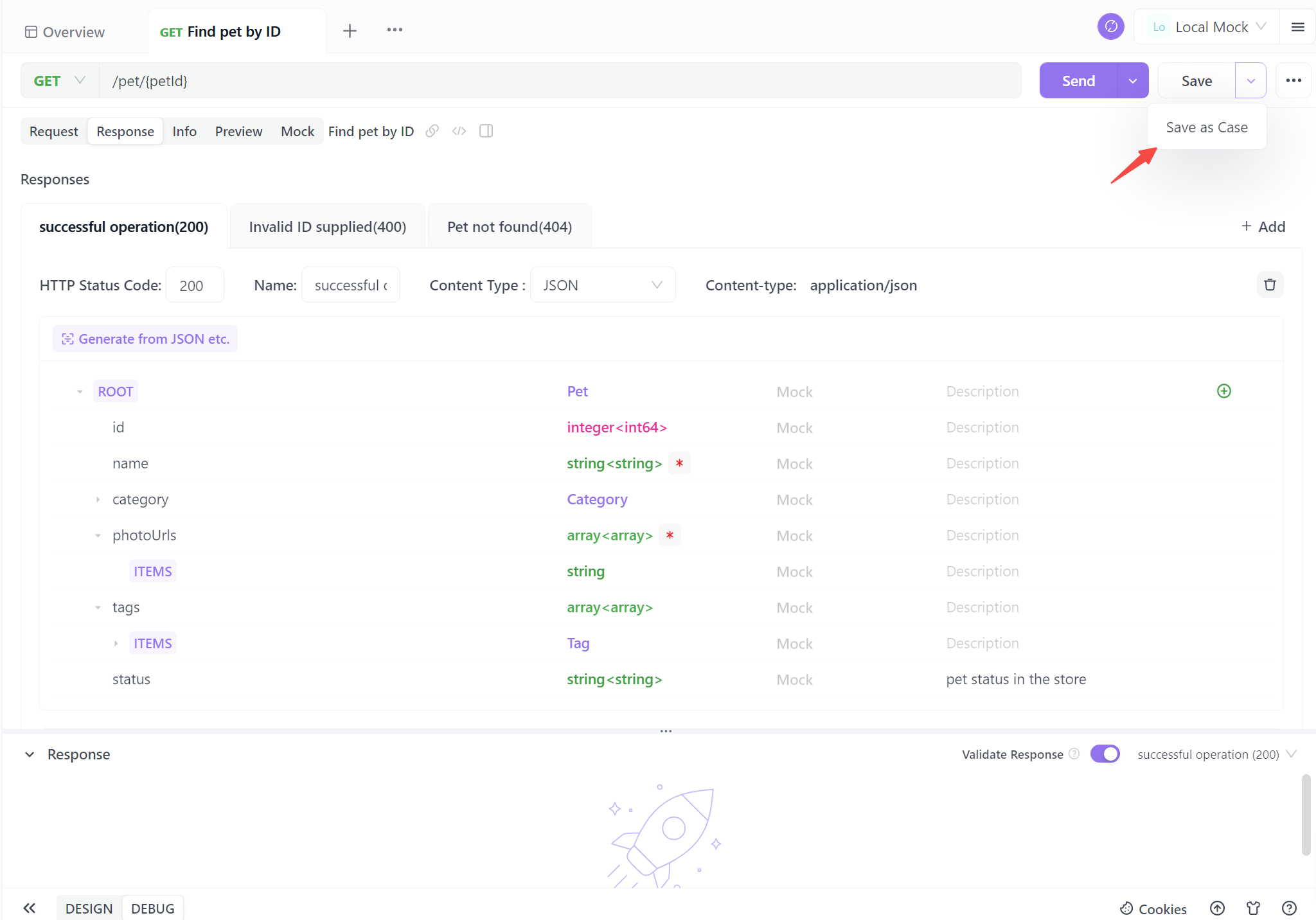

Langkah 4. Hasilkan API Anda

Saat Anda menyelesaikan informasi API dasar, cukup satu klik untuk menyimpan sebagai kasus. Anda juga dapat menyimpannya secara langsung, tetapi disarankan untuk menyimpannya sebagai kasus pengujian untuk referensi di masa mendatang yang lebih mudah.

Mengikuti keempat langkah ini memberdayakan Anda untuk dengan mudah menghasilkan dokumentasi API standar. Proses yang disederhanakan ini tidak hanya memastikan kejelasan dan konsistensi tetapi juga menghemat waktu yang berharga. Dengan dokumentasi otomatis, Anda diperlengkapi dengan baik untuk meningkatkan kolaborasi, menyederhanakan interaksi pengguna, dan mendorong proyek Anda maju dengan percaya diri.

Praktik Terbaik untuk Integrasi API Ollama

Saat Anda bekerja dengan API Ollama melalui APIDog, ingatlah praktik terbaik ini:

- Kontrol Versi: Gunakan fitur kontrol versi APIDog untuk melacak perubahan pada definisi API Anda dari waktu ke waktu.

- Penanganan Kesalahan: Dokumentasikan respons kesalahan umum dan sertakan contoh cara menanganinya dalam dokumentasi API Anda.

- Pembatasan Laju: Waspadai pembatasan laju apa pun yang diterapkan oleh Ollama, terutama saat berjalan pada sistem dengan sumber daya terbatas, dan dokumentasikan batasan ini.

- Pertimbangan Keamanan: Meskipun Ollama biasanya berjalan secara lokal, pertimbangkan untuk menerapkan autentikasi jika mengekspos API melalui jaringan.

- Optimasi Kinerja: Dokumentasikan praktik terbaik untuk mengoptimalkan permintaan, seperti menggunakan kembali konteks untuk kueri terkait untuk meningkatkan waktu respons.

Kesimpulan

Mengintegrasikan API Ollama ke dalam proyek Anda membuka dunia kemungkinan untuk memanfaatkan model bahasa yang kuat dalam aplikasi Anda. Dengan menggunakan APIDog untuk merancang, menguji, dan mendokumentasikan panggilan API Ollama Anda, Anda membuat integrasi yang kuat dan dapat dipelihara yang dapat berkembang seiring dengan kebutuhan proyek Anda.

Kombinasi kemampuan LLM lokal Ollama dan fitur manajemen API komprehensif APIDog memberi pengembang toolkit yang kuat untuk membangun aplikasi yang ditingkatkan AI. Saat Anda terus menjelajahi potensi Ollama dan menyempurnakan integrasi API Anda, ingatlah bahwa dokumentasi yang jelas dan pengujian menyeluruh adalah kunci keberhasilan implementasi.

Dengan mengikuti langkah-langkah dan praktik terbaik yang diuraikan dalam artikel ini, Anda akan diperlengkapi dengan baik untuk memanfaatkan potensi penuh API Ollama, membuat aplikasi bertenaga AI yang canggih dengan percaya diri dan mudah. Perjalanan integrasi AI adalah perjalanan yang menarik, dan dengan alat seperti Ollama dan APIDog yang Anda miliki, kemungkinannya benar-benar tidak terbatas.