Imaginez avoir un superordinateur dans votre poche, capable de comprendre et de générer du texte semblable à celui d'un humain sur n'importe quel sujet. Cela ressemble à de la science-fiction, n'est-ce pas ? Eh bien, grâce aux récentes percées dans l'intelligence artificielle, ce rêve est désormais une réalité – et il s'appelle Ollama.

Ollama est comme un couteau suisse pour les LLM locaux. C'est un outil open-source qui vous permet d'exécuter des modèles de langage puissants directement sur votre propre ordinateur. Pas besoin de services cloud sophistiqués ni de diplôme en informatique. Mais c'est là que cela devient vraiment passionnant : Ollama possède un superpouvoir caché appelé une API. Considérez-la comme un langage secret qui permet à vos programmes de parler directement à ces cerveaux d'IA.

Maintenant, je sais ce que vous pensez. "API ? Ça a l'air compliqué !"

Ne vous inquiétez pas – c'est là qu'Apidog entre en jeu. C'est comme un traducteur amical qui vous aide à communiquer avec l'API d'Ollama sans transpirer. Dans cet article, nous allons nous lancer ensemble dans un voyage. Je serai votre guide alors que nous explorerons comment libérer tout le potentiel d'Ollama en utilisant Apidog. À la fin, vous créerez des applications alimentées par l'IA comme un pro, le tout depuis le confort de votre propre machine. Alors, attachez votre ceinture – il est temps de plonger dans le monde fascinant de l'IA locale et de découvrir à quel point cela peut être facile !

Qu'est-ce qu'Ollama et comment utiliser Ollama pour exécuter des LLM localement ?

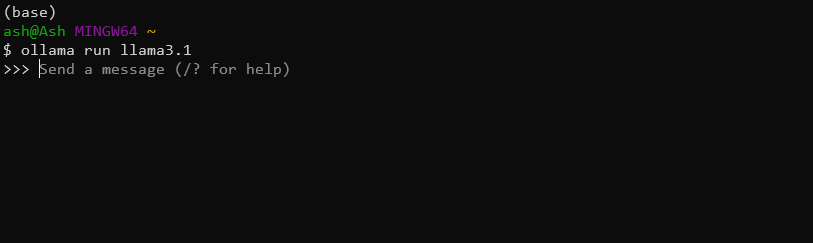

Ollama est un outil pratique qui permet aux utilisateurs d'exécuter des modèles de langage volumineux sur leurs machines locales. Il simplifie le processus de téléchargement, d'exécution et d'affinage de divers LLM, rendant les capacités d'IA avancées accessibles à un public plus large. Par exemple, vous pouvez simplement télécharger et installer le dernier modèle Llama 3.1 8B avec cette seule commande :

ollama run llama3.1

Ollama a-t-il une API ?

Oui, vous pouvez utiliser l'API Ollama pour intégrer ces puissants LLM locaux dans leurs applications de manière transparente.

Les principales fonctionnalités de l'API Ollama incluent :

- Gestion des modèles (extraction, liste et suppression des modèles)

- Génération de texte (complétions et interactions de chat)

- Génération d'intégrations

- Capacités d'affinage

En utilisant l'API Ollama, vous pouvez facilement exploiter la puissance des LLM dans leurs applications sans avoir besoin d'une infrastructure complexe ou de dépendances cloud.

Utilisation d'Apidog pour tester les API Ollama

Apidog est une plateforme polyvalente de développement et de documentation d'API conçue pour rationaliser l'ensemble du cycle de vie des API. Il offre une interface conviviale pour la conception, le test et la documentation des API, ce qui en fait un outil idéal pour travailler avec l'API Ollama.

Certaines des fonctionnalités exceptionnelles d'APIDog incluent :

- Interface de conception d'API intuitive

- Génération automatique de documentation

- Outils de test et de débogage d'API

- Fonctionnalités de collaboration pour les projets d'équipe

- Prise en charge de divers protocoles et formats d'API

Avec Apidog, les développeurs peuvent facilement créer, gérer et partager la documentation de l'API, garantissant ainsi que leurs intégrations d'API Ollama sont bien documentées et maintenables.

Prérequis

Avant de vous lancer dans les appels d'API Ollama avec Apidog, assurez-vous d'avoir les prérequis suivants en place :

Installation d'Ollama : Téléchargez et installez Ollama sur votre machine locale. Suivez la documentation officielle d'Ollama pour les instructions d'installation spécifiques à votre système d'exploitation.

Compte APIDog : Inscrivez-vous pour un compte Apidog si vous ne l'avez pas déjà fait. Vous pouvez utiliser la version Web ou télécharger l'application de bureau, selon vos préférences.

Modèle Ollama : Extrayez un modèle à l'aide de l'interface de ligne de commande d'Ollama. Par exemple, pour télécharger le modèle "llama2", vous exécuteriez :

ollama pull llama3.1

Outil de test d'API : Bien qu'Apidog fournisse des capacités de test intégrées, vous souhaiterez peut-être également avoir un outil comme cURL ou Postman à portée de main pour des tests et une vérification supplémentaires.

Avec ces éléments en place, vous êtes prêt à commencer à explorer l'API Ollama en utilisant Apidog.

Création d'un projet d'API Ollama dans Apidog

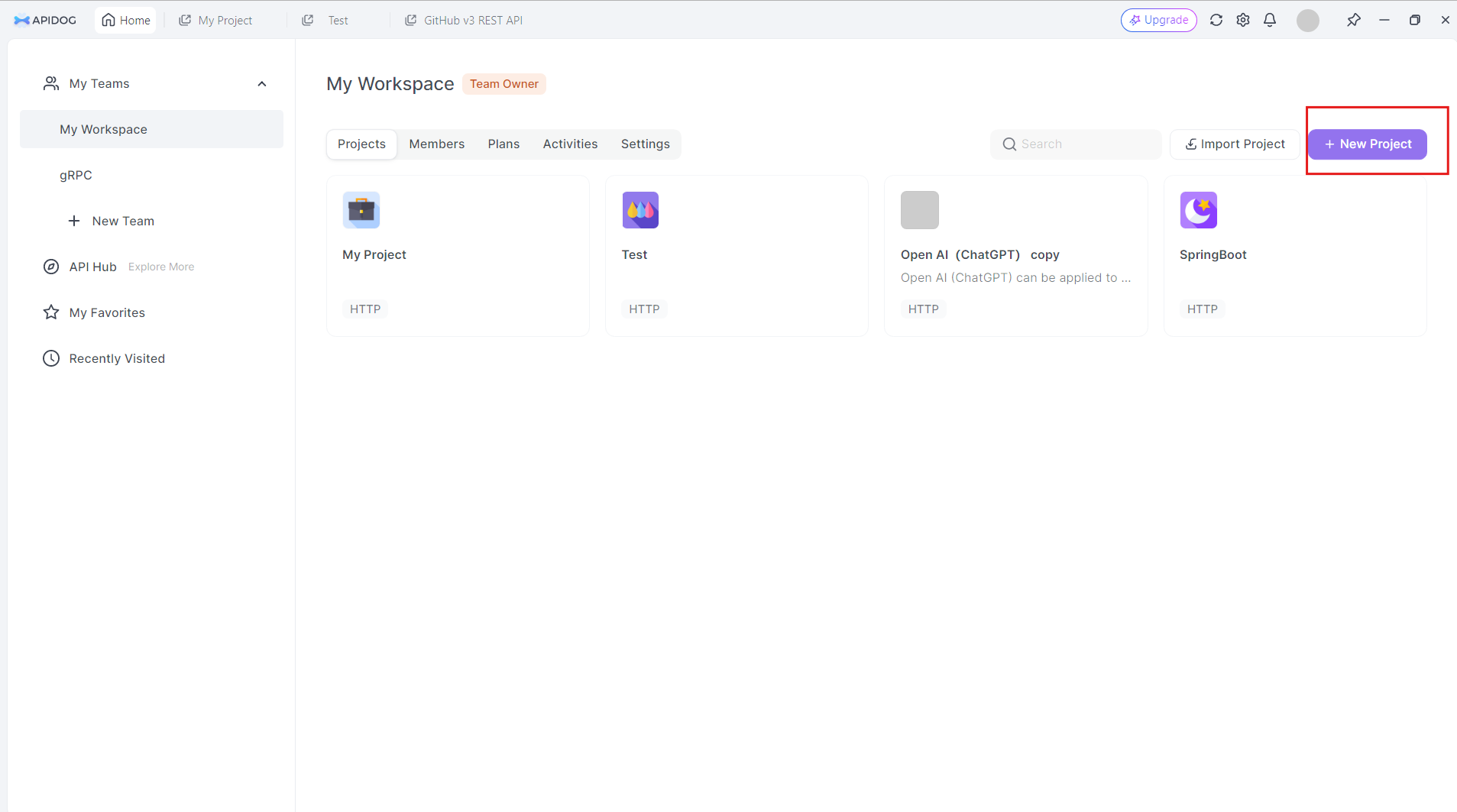

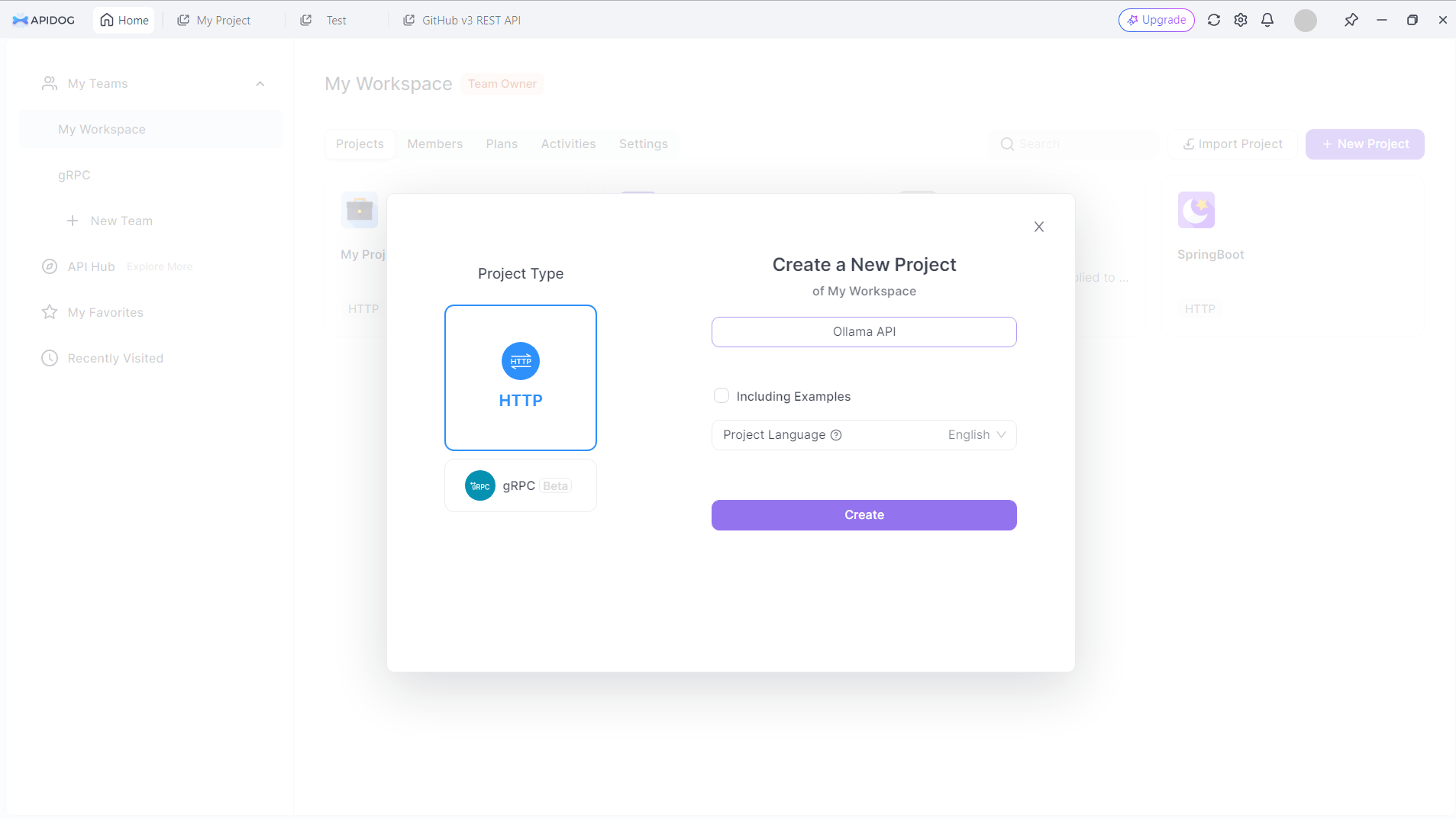

Pour commencer à travailler avec l'API Ollama dans Apidog, suivez ces étapes :

Créer un nouveau projet : Connectez-vous à Apidog et créez un nouveau projet spécifiquement pour votre travail d'API Ollama. Cliquez sur le bouton Nouveau projet dans le coin supérieur droit

Donnez un nom à votre nouveau projet. Disons : API Ollama :

Cliquez sur le bouton Créer pour continuer.

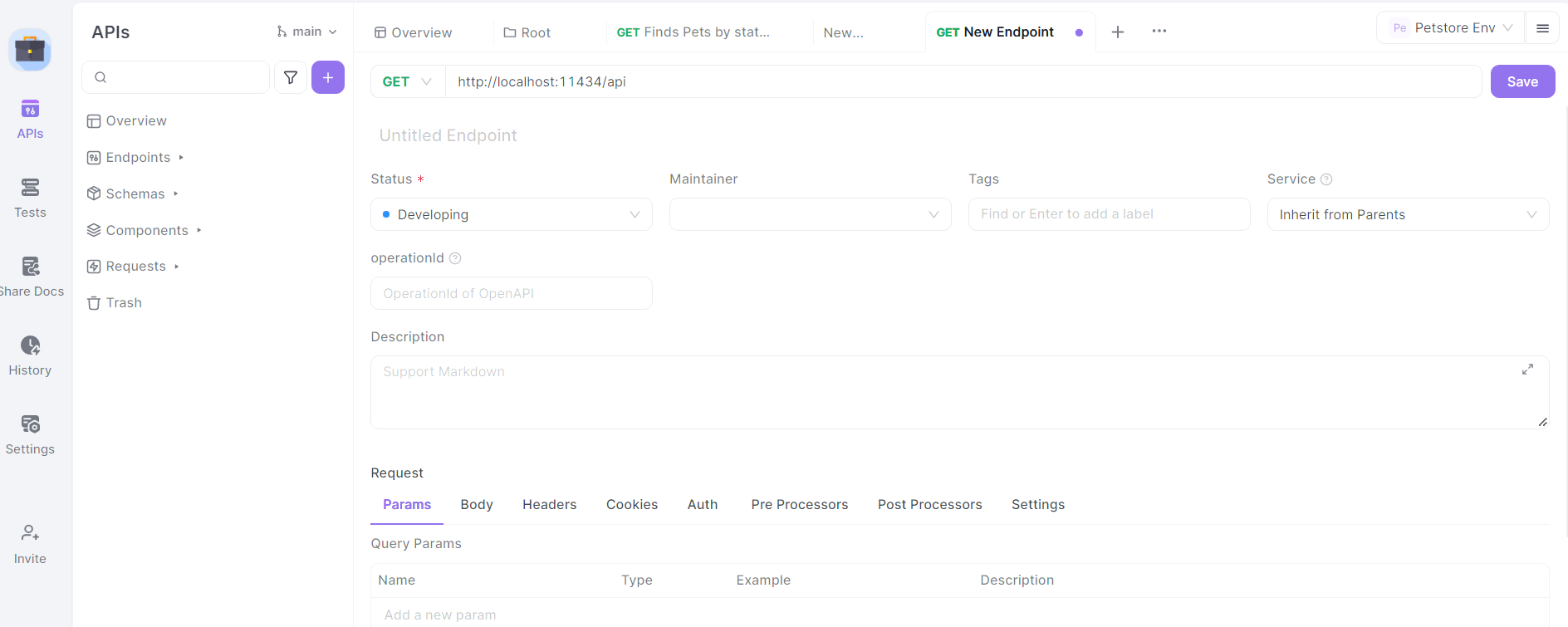

Configurer l'URL de base : Dans les paramètres de votre projet, définissez l'URL de base sur http://localhost:11434/api. Il s'agit de l'adresse par défaut où Ollama expose ses points de terminaison d'API.

Importer la spécification de l'API Ollama : Bien qu'Ollama ne fournisse pas de spécification OpenAPI officielle, vous pouvez créer une structure de base pour les points de terminaison de l'API manuellement dans APIDog.

Définir les points de terminaison : Commencez par définir les principaux points de terminaison de l'API Ollama dans APIDog. Certains points de terminaison clés à inclure sont :

/generate(POST) : Pour la génération de texte/chat(POST) : Pour les interactions basées sur le chat/embeddings(POST) : Pour la génération d'intégrations/pull(POST) : Pour l'extraction de nouveaux modèles/list(GET) : Pour lister les modèles disponibles

Pour chaque point de terminaison, spécifiez la méthode HTTP, les paramètres de requête et le format de réponse attendu en fonction de la documentation de l'API Ollama.

Conception d'appels d'API Ollama dans Apidog

Passons en revue le processus de conception d'appels d'API pour certains des points de terminaison Ollama les plus couramment utilisés à l'aide d'Apidog :

Point de terminaison de génération de texte (/generate)

Dans Apidog, créez un nouveau point de terminaison d'API avec le chemin /generate et définissez la méthode HTTP sur POST.

Définir le schéma du corps de la requête :

{

"model": "string",

"prompt": "string",

"system": "string",

"template": "string",

"context": "array",

"options": {

"temperature": "number",

"top_k": "integer",

"top_p": "number",

"num_predict": "integer",

"stop": "array"

}

}

Fournissez une description pour chaque paramètre, expliquant son objectif et toute contrainte.

Définissez le schéma de réponse en fonction de la documentation de l'API Ollama, y compris des champs tels que response, context et total_duration.

Point de terminaison de chat (/chat)

Créez un nouveau point de terminaison avec le chemin /chat et définissez la méthode HTTP sur POST.

Définir le schéma du corps de la requête :

{

"model": "string",

"messages": [

{

"role": "string",

"content": "string"

}

],

"format": "string",

"options": {

"temperature": "number",

"top_k": "integer",

"top_p": "number",

"num_predict": "integer",

"stop": "array"

}

}

Fournissez des descriptions détaillées pour le tableau messages, expliquant la structure des messages de chat avec des rôles (système, utilisateur, assistant) et du contenu.

Définissez le schéma de réponse, y compris l'objet message avec les champs role et content.

Points de terminaison de gestion des modèles

Créez des points de terminaison pour les opérations de gestion des modèles :

- Extraire le modèle (

/pull) : Requête POST avec le paramètrenamepour le modèle à télécharger. - Lister les modèles (

/list) : Requête GET pour récupérer les modèles disponibles. - Supprimer le modèle (

/delete) : Requête DELETE avec le paramètrenamepour le modèle à supprimer.

Pour chacun de ces points de terminaison, définissez les schémas de requête et de réponse appropriés en fonction de la documentation de l'API Ollama.

Test des appels d'API Ollama dans Apidog

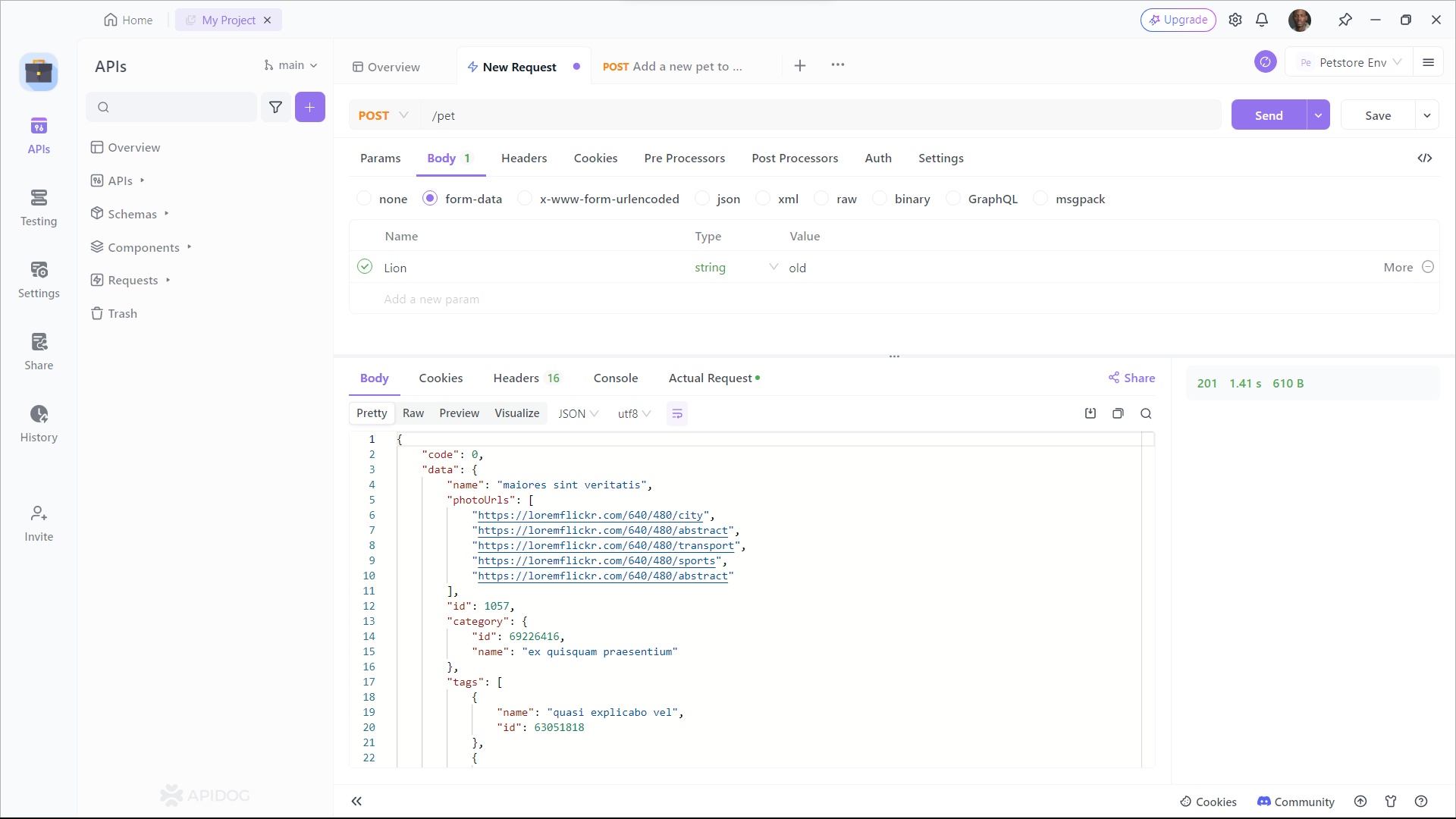

Apidog fournit un environnement de test intégré qui vous permet d'envoyer des requêtes à votre API Ollama et de vérifier les réponses. Voici comment l'utiliser :

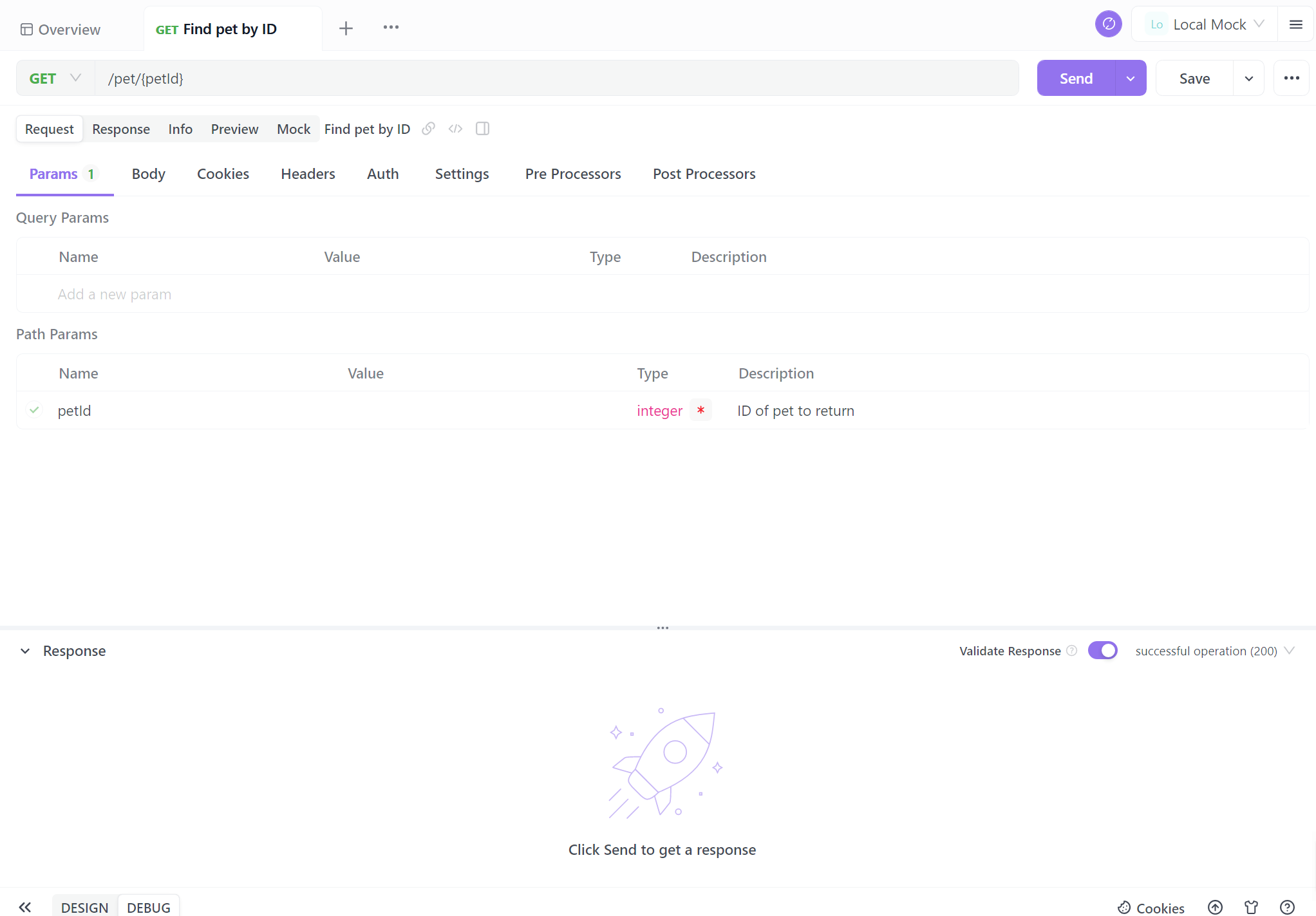

Sélectionnez un point de terminaison : Choisissez l'un des points de terminaison de l'API Ollama que vous avez définis dans Apidog.

Configurer les paramètres de requête : Remplissez les paramètres requis pour le point de terminaison sélectionné. Par exemple, pour le point de terminaison /generate, vous pouvez définir :

{

"model": "llama2",

"prompt": "Explain the concept of artificial intelligence in simple terms."

}

Envoyer la requête : Utilisez le bouton "Envoyer" d'Apidog pour exécuter l'appel d'API vers votre instance Ollama locale.

Examinez la réponse d'Ollama, en vérifiant qu'elle correspond au format attendu et contient le texte généré ou d'autres informations pertinentes. Si vous rencontrez des problèmes, utilisez les outils de débogage d'Apidog pour inspecter les en-têtes de requête et de réponse, le corps et tous les messages d'erreur.

Génération de documentation d'API

L'une des fonctionnalités les plus puissantes d'Apidog est sa capacité à générer automatiquement une documentation d'API complète. Pour créer une documentation pour votre projet d'API Ollama :

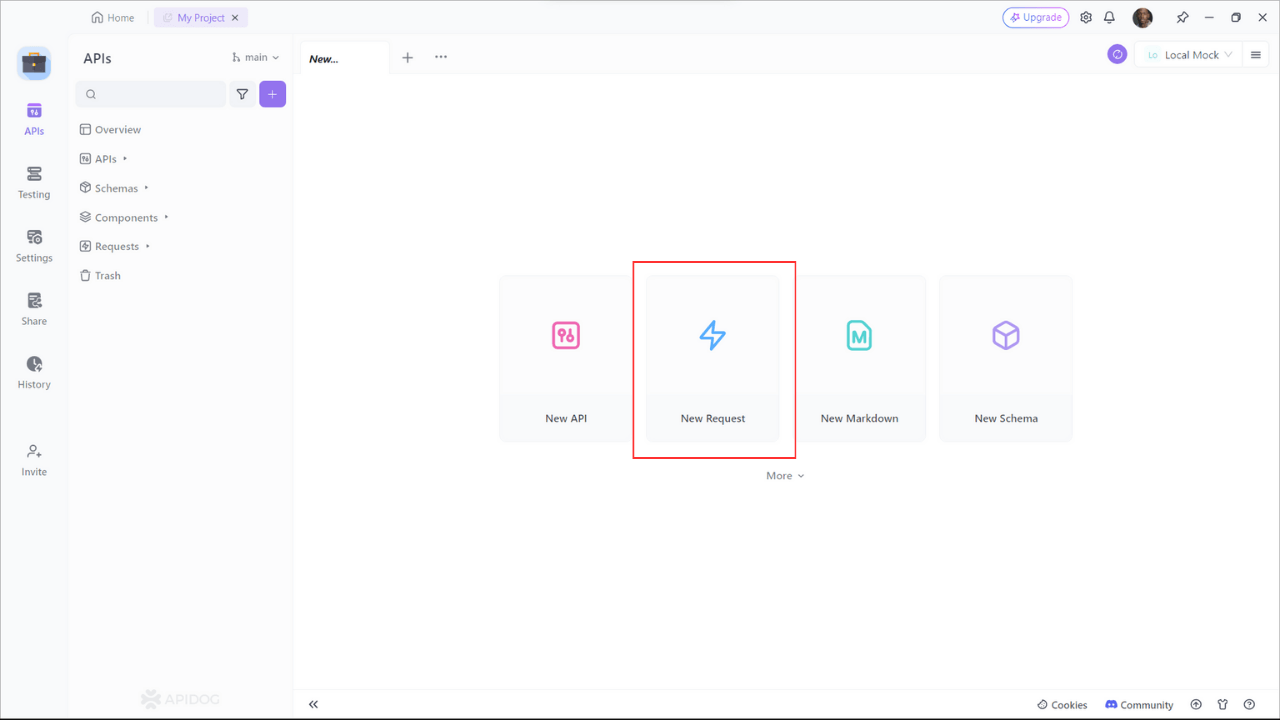

Étape 1 : Inscrivez-vous à Apidog

Pour commencer à utiliser Apidog pour la génération de documentation d'API, vous devrez vous inscrire pour un compte si vous ne l'avez pas déjà fait. Une fois connecté, vous serez accueilli par l'interface conviviale d'Apidog.

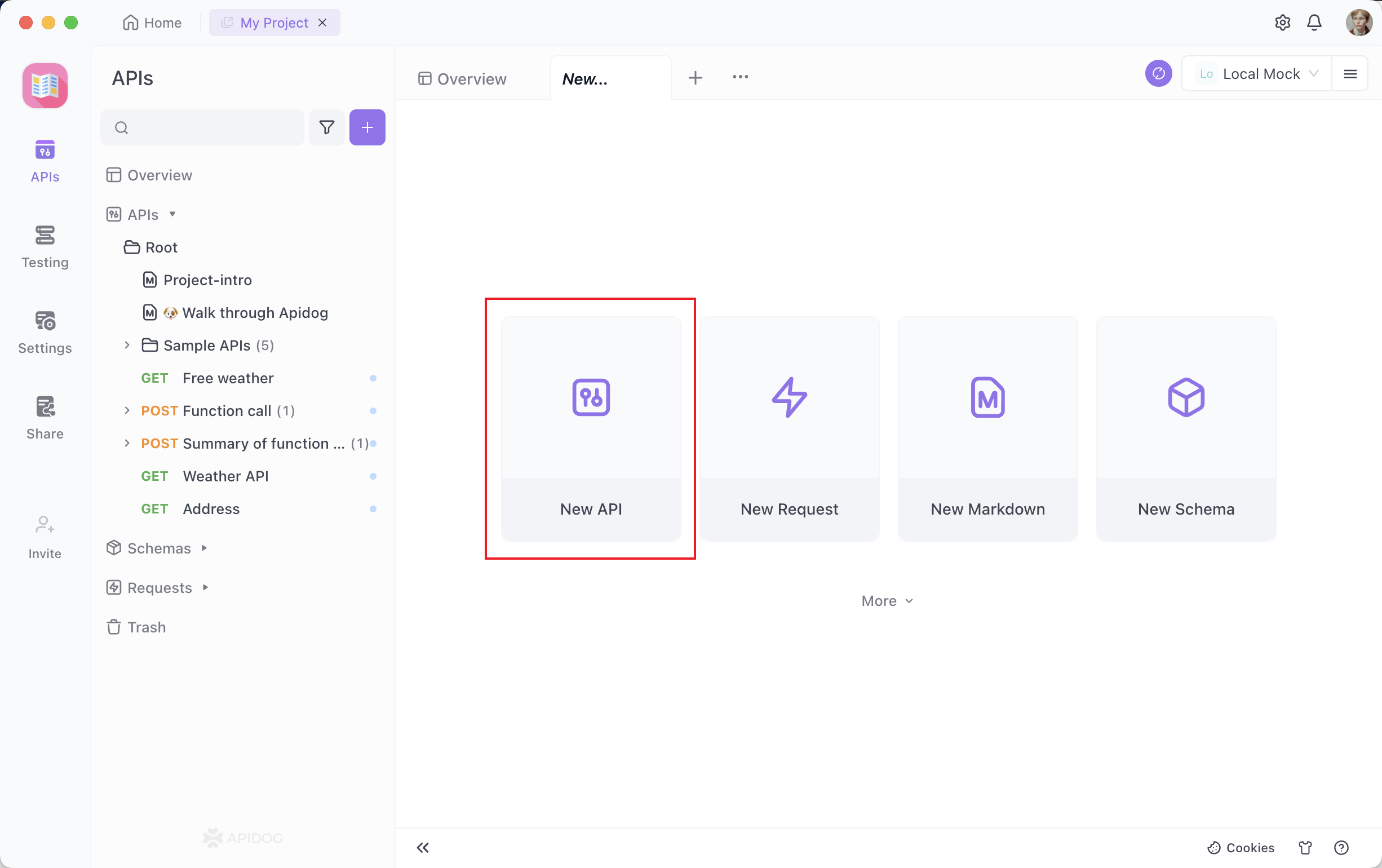

Étape 2 : Création de votre requête d'API

Un projet de documentation d'API est composé de divers points de terminaison, chacun représentant un itinéraire ou une fonctionnalité d'API spécifique. Pour ajouter un point de terminaison, cliquez sur le bouton "+" ou "Nouvelle API" dans votre projet.

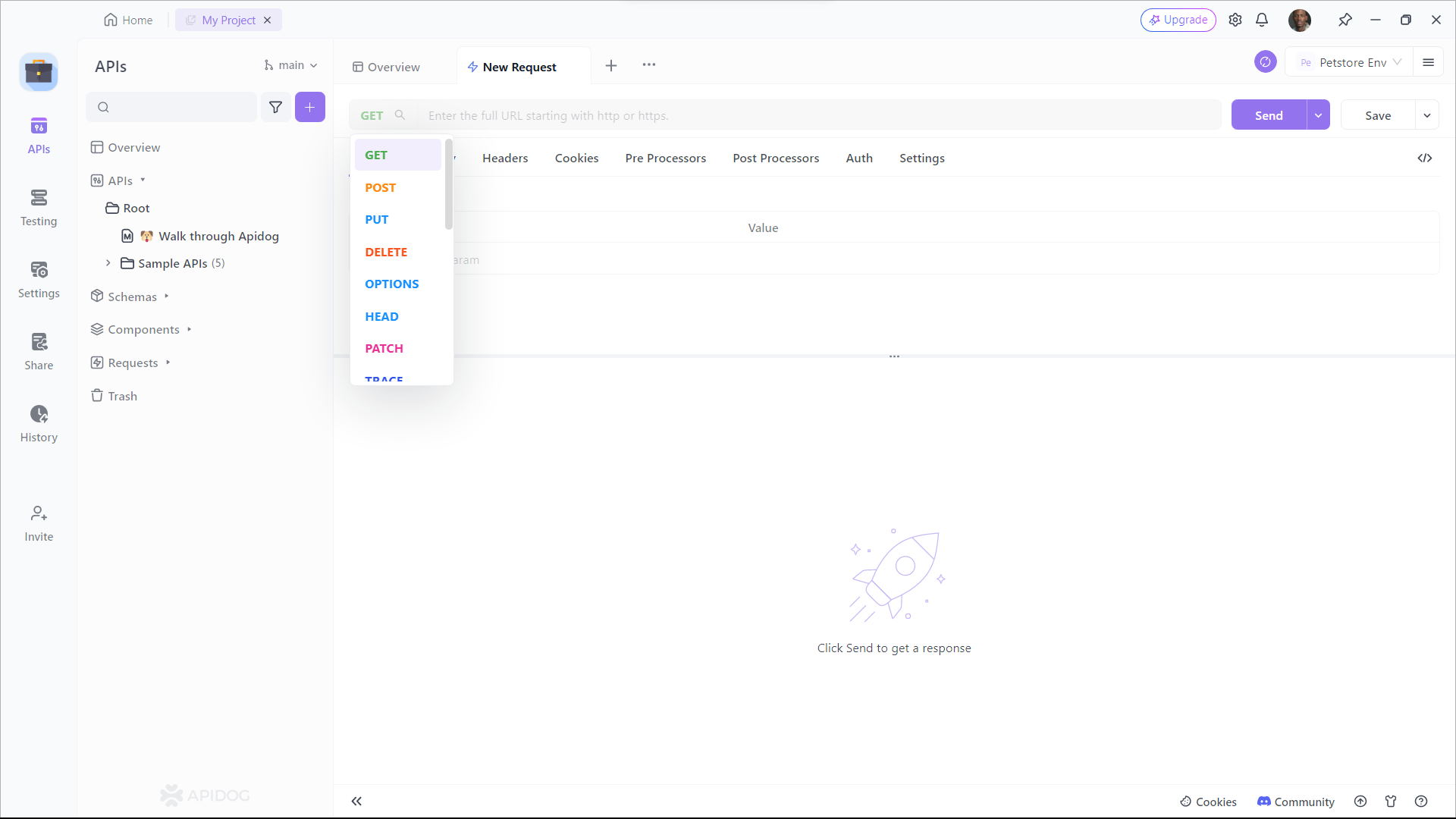

Étape 3 : Configurer les paramètres de la requête

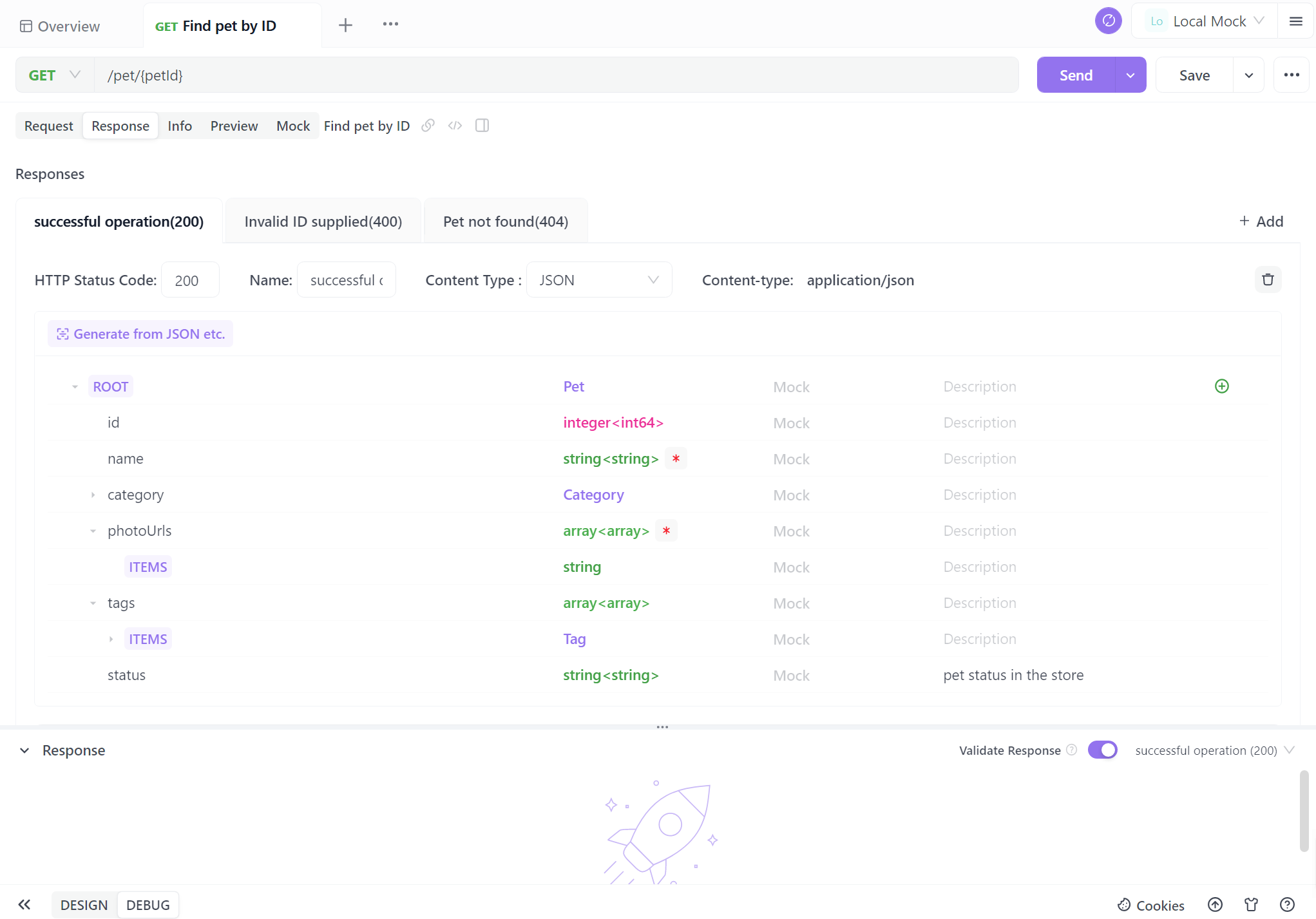

Vous devrez fournir des détails tels que l'URL du point de terminaison, la description et les détails de la requête/réponse. Vient maintenant la partie critique – documenter vos points de terminaison. Apidog rend ce processus incroyablement simple. Pour chaque point de terminaison, vous pouvez :

- Spécifier la méthode HTTP (GET, POST, PUT, DELETE, etc.).

- Définir les paramètres de requête, y compris leurs noms, types et descriptions.

- Décrire la réponse attendue, y compris les codes d'état, les formats de réponse (JSON, XML, etc.) et des exemples de réponses.

De nombreux développeurs ne sont pas friands d'écrire de la documentation d'API, la trouvant souvent complexe. Cependant, en réalité, avec Apidog, vous pouvez le faire en quelques clics de souris. L'interface visuelle d'Apidog est conviviale pour les débutants, ce qui la rend beaucoup plus simple que de générer de la documentation d'API à partir du code.

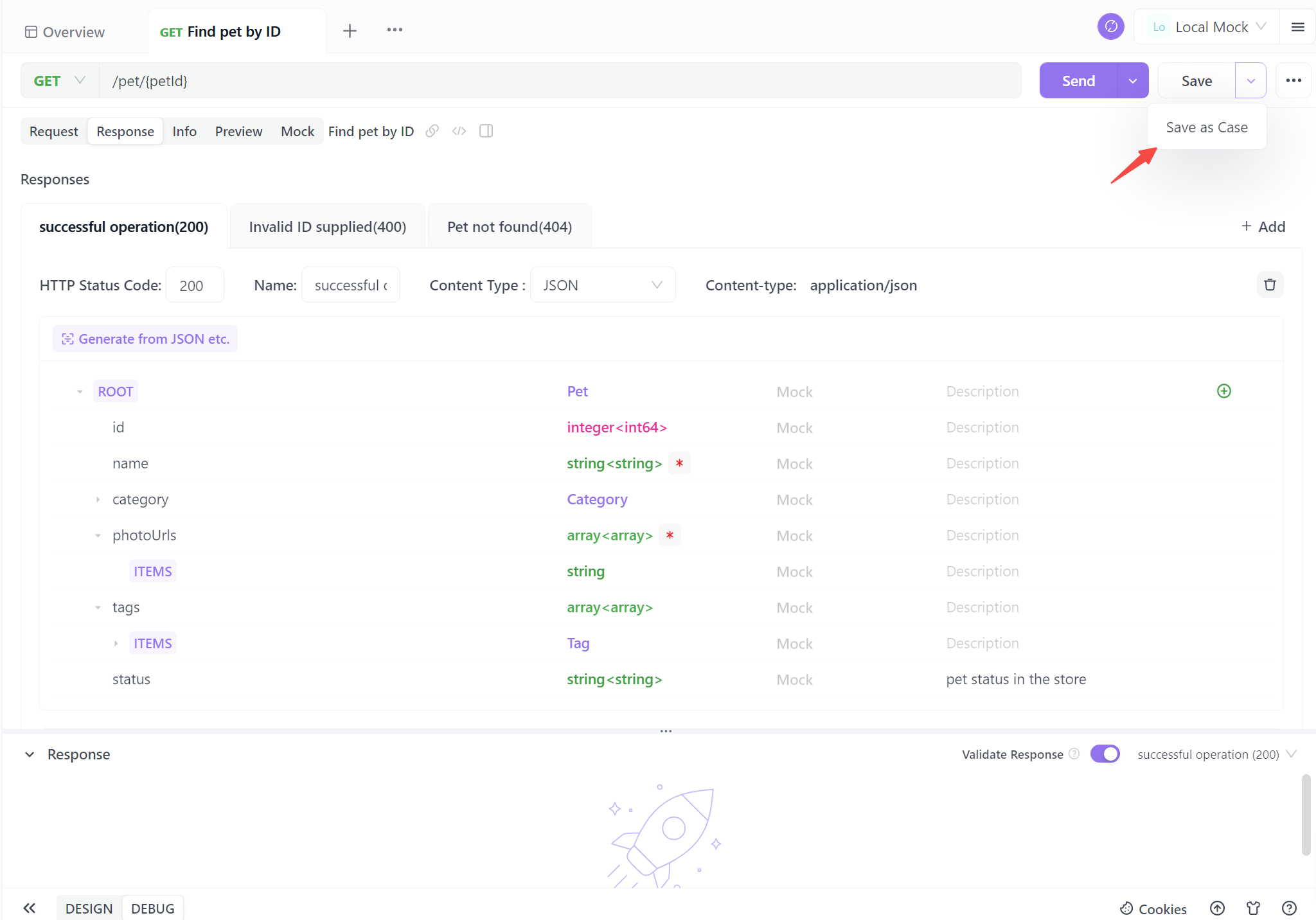

Étape 4. Générez votre API

Lorsque vous terminez les informations de base de l'API, un seul clic pour enregistrer en tant que cas. Vous pouvez également l'enregistrer directement, mais il est recommandé de l'enregistrer en tant que cas de test pour une référence future plus facile.

Suivre ces quatre étapes vous permet de générer sans effort une documentation d'API standardisée. Ce processus rationalisé garantit non seulement la clarté et la cohérence, mais permet également de gagner un temps précieux. Avec une documentation automatisée, vous êtes bien équipé pour améliorer la collaboration, simplifier l'interaction utilisateur et propulser vos projets en avant avec confiance.

Meilleures pratiques pour l'intégration de l'API Ollama

Lorsque vous travaillez avec l'API Ollama via APIDog, gardez ces bonnes pratiques à l'esprit :

- Contrôle de version : Utilisez les fonctionnalités de contrôle de version d'APIDog pour suivre les modifications de vos définitions d'API au fil du temps.

- Gestion des erreurs : Documentez les réponses d'erreur courantes et incluez des exemples de la façon de les gérer dans votre documentation d'API.

- Limitation du débit : Soyez conscient de toute limitation du débit mise en œuvre par Ollama, en particulier lors de l'exécution sur des systèmes aux ressources limitées, et documentez ces limitations.

- Considérations de sécurité : Bien qu'Ollama s'exécute généralement localement, envisagez de mettre en œuvre l'authentification si vous exposez l'API sur un réseau.

- Optimisation des performances : Documentez les meilleures pratiques pour optimiser les requêtes, telles que la réutilisation du contexte pour les requêtes associées afin d'améliorer les temps de réponse.

Conclusion

L'intégration de l'API Ollama dans vos projets ouvre un monde de possibilités pour exploiter des modèles de langage puissants dans vos applications. En utilisant APIDog pour concevoir, tester et documenter vos appels d'API Ollama, vous créez une intégration robuste et maintenable qui peut évoluer avec les besoins de votre projet.

La combinaison des capacités LLM locales d'Ollama et des fonctionnalités complètes de gestion d'API d'APIDog fournit aux développeurs une boîte à outils puissante pour la création d'applications améliorées par l'IA. Au fur et à mesure que vous continuez à explorer le potentiel d'Ollama et à affiner vos intégrations d'API, n'oubliez pas qu'une documentation claire et des tests approfondis sont essentiels à la réussite de la mise en œuvre.

En suivant les étapes et les meilleures pratiques décrites dans cet article, vous serez bien équipé pour exploiter tout le potentiel de l'API d'Ollama, en créant des applications sophistiquées basées sur l'IA avec confiance et facilité. Le voyage de l'intégration de l'IA est passionnant, et avec des outils comme Ollama et APIDog à votre disposition, les possibilités sont vraiment illimitées.