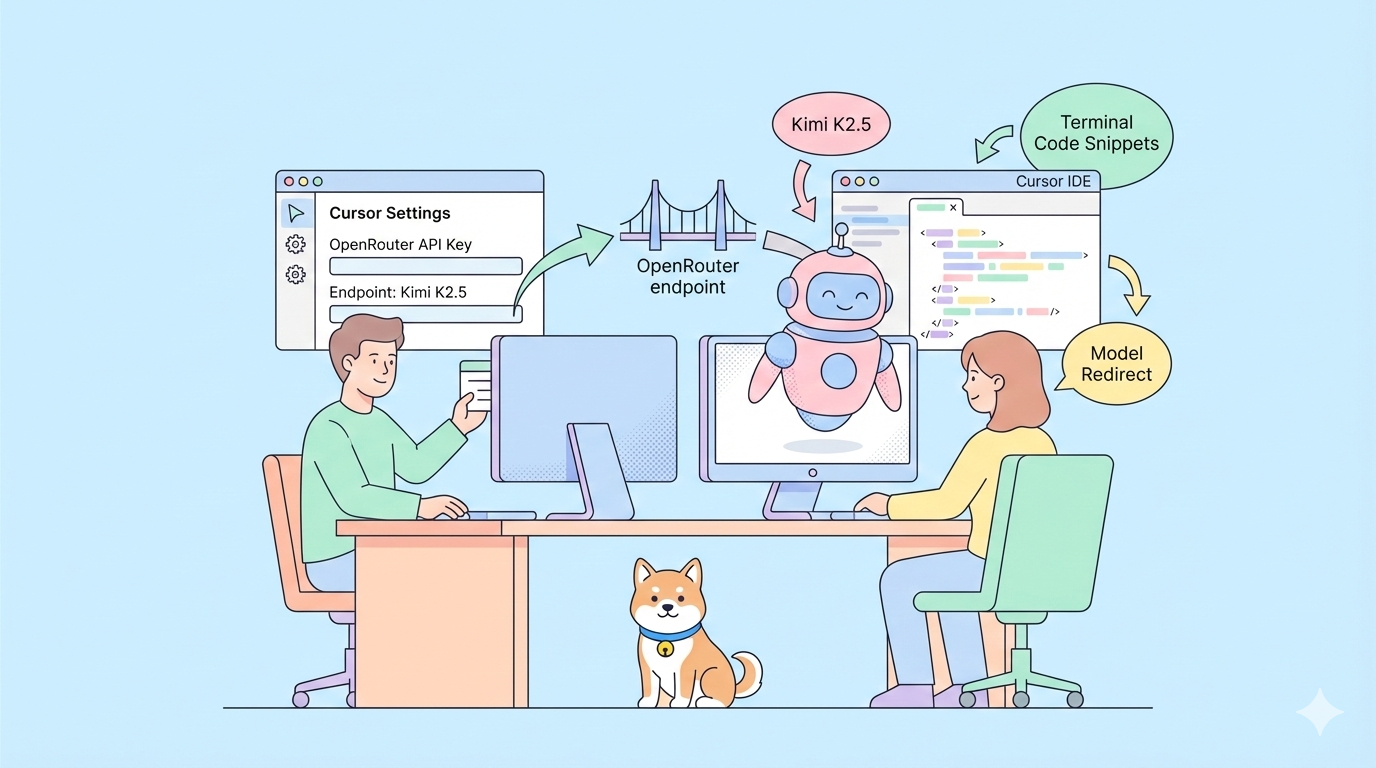

Avez-vous déjà voulu utiliser l'un des modèles d'IA open-source les plus avancés au sein de votre EDI de codage préféré, mais vous avez constaté qu'il était absent de la liste déroulante ? Avec Kimi K2.5, un puissant modèle multimodal et agent-capable de Moonshot AI, vous pouvez désormais l'intégrer à Cursor même s'il n'est pas nativement pris en charge. Au lieu d'attendre un support officiel, ce guide vous montre exactement comment connecter Kimi K2.5 à Cursor afin que vous puissiez l'utiliser pour le codage, le raisonnement et les flux de travail pilotés par des outils directement depuis votre éditeur.

Pourquoi ajouter Kimi K2.5 à Cursor ?

Cursor est un environnement de développement assisté par l'IA populaire qui vous permet d'interagir avec des modèles d'IA directement dans votre éditeur. Cependant, tous les modèles ne sont pas disponibles dans le sélecteur de modèles intégré, en particulier les modèles open-source récemment sortis ou émergents comme Kimi K2.5. Si vous souhaitez exploiter les puissantes capacités de codage et de raisonnement de K2.5 mais que vous ne le voyez pas dans la liste déroulante de Cursor, vous n'êtes pas seul. Heureusement, il existe une solution pratique qui consiste à ajouter Kimi K2.5 comme modèle personnalisé en utilisant des points d'accès de fournisseurs comme OpenRouter ou un accès direct à l'API Moonshot.

Ceci est important car les développeurs souhaitent de plus en plus de flexibilité — la capacité de choisir quel modèle alimente leurs flux de travail d'IA au lieu d'être contraints par ce qui est fourni avec l'EDI. Dans ce guide, nous allons détailler exactement comment établir cette connexion en utilisant les paramètres de configuration de Cursor, la prise en charge des modèles personnalisés et les clés API.

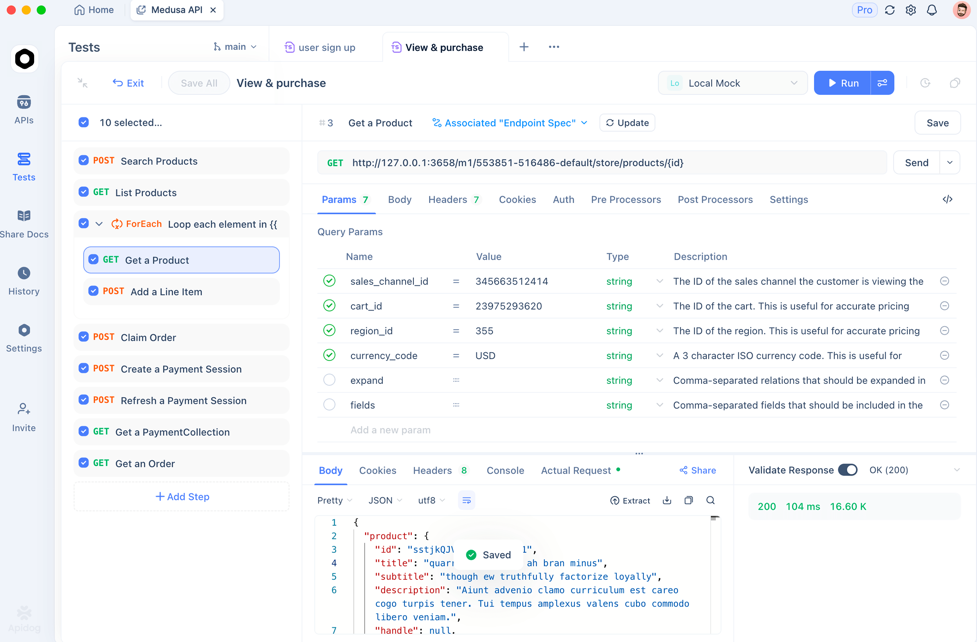

💡Conseil de pro : Testez vos points d d'accès API dans Apidog avant de configurer dans Cursor. Cela évite les erreurs d'authentification et garantit que votre intégration de modèle personnalisé fonctionne dès le départ.

Vous voulez une plateforme intégrée tout-en-un pour que votre équipe de développeurs travaille ensemble avec une productivité maximale ?

Apidog répond à toutes vos exigences et remplace Postman à un prix beaucoup plus abordable !

Comprendre les capacités de Kimi K2.5

Avant l'intégration, voici ce qui rend Kimi K2.5 précieux pour les flux de travail de Cursor :

- Capacité multimodale : Gère nativement le texte, le code et les données visuelles

- Conception agentique : Conçu pour le raisonnement, l'appel d'outils et les flux de travail en plusieurs étapes

- Accès API ouvert : Disponible via les points d'accès API de Moonshot et des fournisseurs tiers comme OpenRouter

- Grande fenêtre de contexte : Jusqu'à 256K tokens pour une compréhension de projets complexes

- Rentabilité : Plus abordable que les alternatives occidentales pour des performances équivalentes

Bien que Kimi K2.5 ne soit pas encore nativement pris en charge dans Cursor, son API compatible avec OpenAI signifie que vous pouvez le connecter manuellement et l'utiliser presque comme s'il était natif.

Choisissez votre fournisseur d'API Kimi K2.5

✅ Option A (via OpenRouter)

OpenRouter agit comme une passerelle API universelle qui vous donne accès à plusieurs modèles d'IA via une seule interface :

- Inscrivez-vous sur OpenRouter.ai

- Ajoutez des crédits pour l'utilisation de l'API

- Générez la clé API dans Paramètres → Clés

Cette clé authentifie vos requêtes auprès d'OpenRouter et prend en charge le routage vers Kimi K2.5.

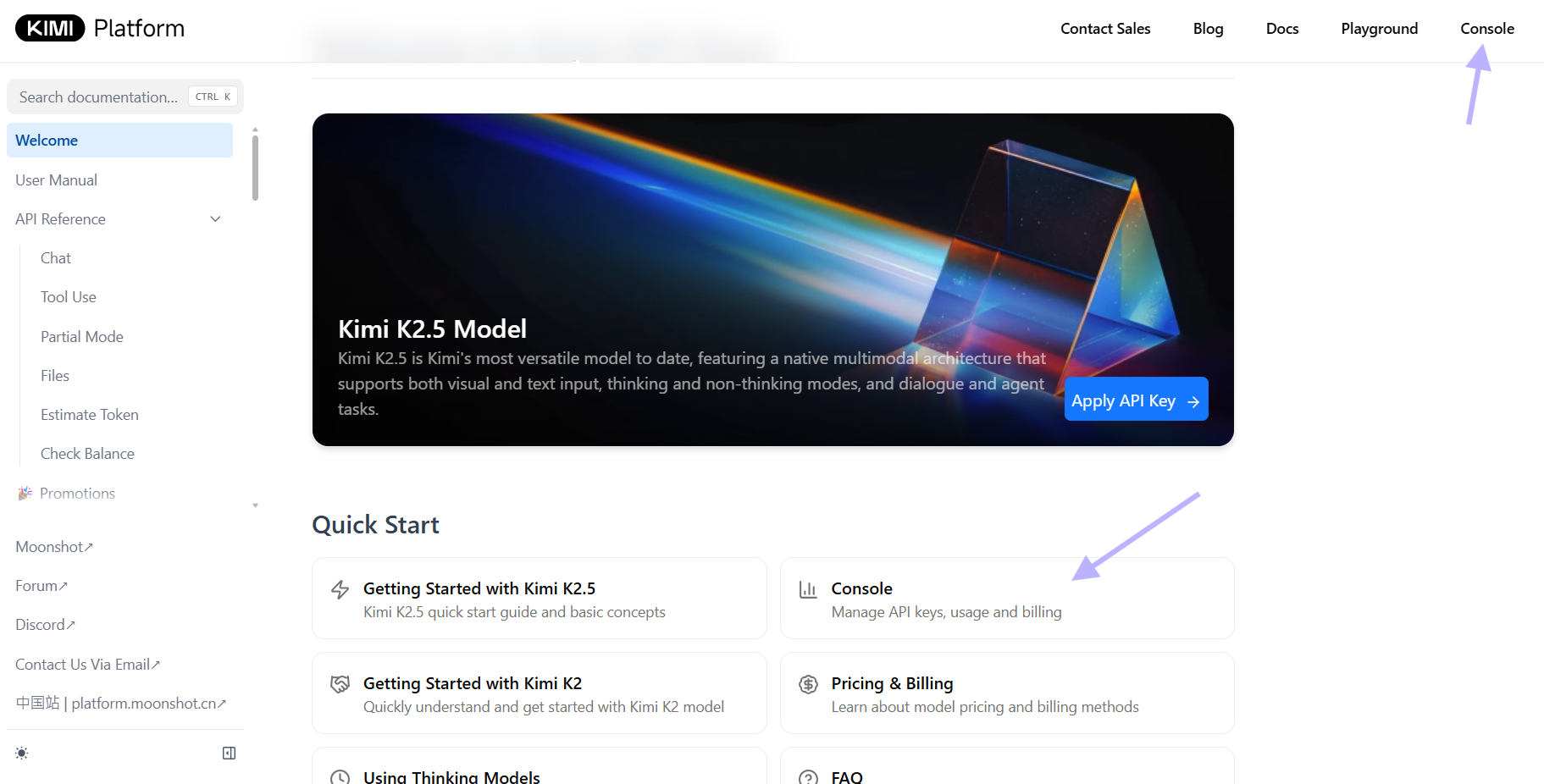

✅ Option B (via l'API Moonshot)

Si vous avez accès au portail développeur de Moonshot :

- Connectez-vous à la plateforme de Moonshot

- Créez ou récupérez votre clé API pour leurs points d'accès

- Utilisez le point d'accès compatible OpenAI - Moonshot prend en charge `moonshot/kimi-k2.5`

Le point d'accès de Moonshot fournit un contexte complet de 256K et une prise en charge multimodale avec la simplicité d'une connexion API directe.

💡Conseil de pro : Le point d'accès officiel de Moonshot utilise un format compatible OpenAI, ce qui le rend idéal pour la configuration de modèles personnalisés de Cursor.

Configurer Cursor pour les modèles personnalisés

Une fois votre fournisseur configuré, il est temps de pointer Cursor vers le bon point d'accès.

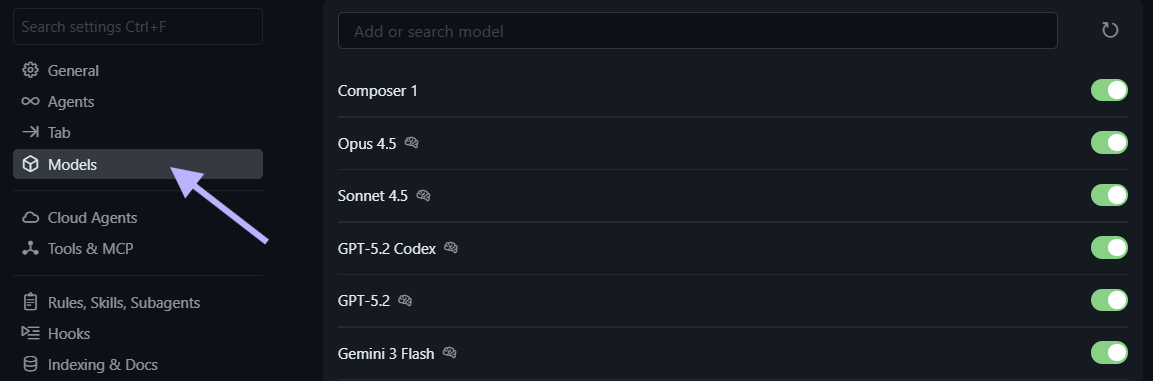

🧩 Ouvrir les paramètres de Cursor

- Ouvrez Cursor

- Accédez à Paramètres → Modèles.

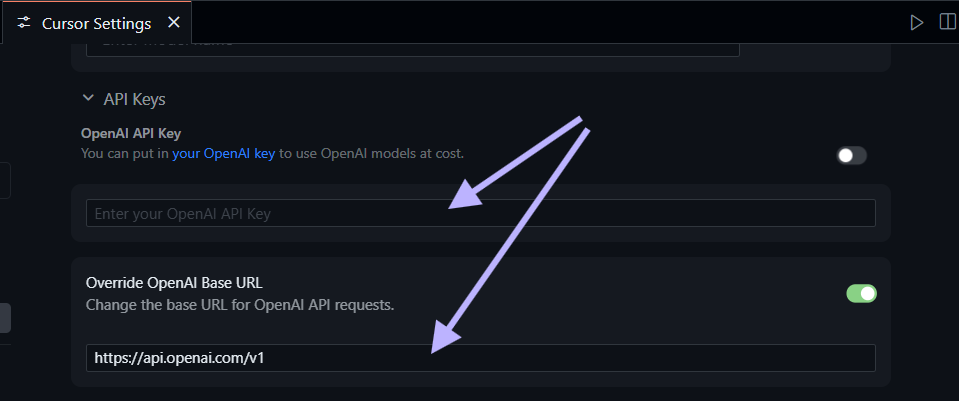

🔌 Mettre à jour l'URL de base de l'API

Selon votre fournisseur

Configuration OpenRouter :

URL de base : https://openrouter.ai/api/v1

Authentification : Votre clé API OpenRouterConfiguration Moonshot :

URL de base : https://api.moonshot.cn/v1

Authentification : Votre clé API Moonshot⚠️Important : Si vous rencontrez des erreurs "Fournisseur non pris en charge", assurez-vous que l'URL de base pointe vers un fournisseur qui prend explicitement en charge Kimi K2.5.

Ajouter Kimi K2.5 comme modèle personnalisé

L'interface utilisateur des modèles personnalisés de Cursor vous permet d'ajouter des modèles qui ne sont pas répertoriés nativement.

Ajouter le modèle Kimi K2.5

- Dans Paramètres → Modèles, sélectionnez Ajouter un modèle personnalisé

- Pour le slug du modèle (nom), entrez :

moonshot/kimi-k2.5

- Utilisez

moonshotai/kimi-k2.5si vous accédez via OpenRouter - Utilisez

moonshot/kimi-k2.5si vous accédez directement via Moonshot

3. Enregistrez la configuration du modèle

4. Actualisez les paramètres de Cursor si le modèle n'apparaît pas dans la liste

✅Gain rapide : Après avoir ajouté le modèle, il devrait apparaître dans votre liste déroulante aux côtés des modèles natifs.

Dépannage

- Modèle non affiché ? Vérifiez que l'URL de base est correcte et que votre clé API est valide.

- Erreurs d'authentification ? Vérifiez que votre clé API n'a pas expiré et qu'elle dispose de suffisamment de crédits.

- Limitation de débit ? Certains fournisseurs peuvent limiter les requêtes par minute.

Tester votre intégration Kimi K2.5

Maintenant que Cursor pointe vers Kimi K2.5, testez-le avec une simple requête pour vous assurer que tout fonctionne :

# Exemple de requête

Écrivez une fonction en Python qui intersecte efficacement deux grandes listes en utilisant des built-ins et des type hints.Cursor enverra cela à Kimi K2.5 via votre fournisseur configuré et affichera la réponse. Si rien n'apparaît ou si le modèle revient à un modèle par défaut, revérifiez les paramètres de votre modèle personnalisé et assurez-vous qu'il n'y a pas de fautes de frappe dans le slug du modèle ou le point d'accès de l'API.

💡Conseil de pro : Commencez par des tâches de codage simples avant de passer à des projets complexes multi-fichiers. Cela vous aide à vérifier que les capacités de raisonnement du modèle fonctionnent correctement.

Applications pratiques dans Cursor

Une fois Kimi K2.5 configuré, vous pouvez l'utiliser pour les tâches de développement typiques alimentées par l'IA :

💡Génération et refactorisation de code

- Générez des fonctions avec des docstrings et des annotations de type clairement définies.

- Refactorisez des modules complexes avec une organisation et une lisibilité améliorées.

- Suggérez des modèles et des idiomes alignés sur les meilleures pratiques Python modernes.

# Exemple de requête

Refactorisez cette classe en fonctions plus petites avec des responsabilités uniques claires.🧠Raisonnement et débogage

- Expliquez une logique dense ou des algorithmes avec des exemples clairs.

- Obtenez des suggestions d'optimisation pour les goulots d'étranglement de performance.

- Examinez les décisions architecturales et proposez des améliorations.

# Exemple de requête

Expliquez pourquoi cet algorithme récursif pourrait dépasser les limites de pile et proposez une version itérative.🔄Automatisation des flux de travail

- Générez du code boilerplate pour les structures de projet courantes.

- Créez des suites de tests automatiquement à partir des spécifications API.

- Mettez en place des pipelines CI/CD pour des tests automatisés.

💡Intégration Apidog : Lors du test des flux de travail API, utilisez l'interface visuelle d'Apidog pour déboguer les requêtes, valider les réponses et générer du code prêt pour la production.

Options de configuration avancées

🌐Gestion des variables d'environnement

Pour les configurations de production, utilisez des variables d'environnement au lieu de identifiants codés en dur :

# Ajoutez à votre profil shell (.zshrc, .bashrc)

export OPENROUTER_API_KEY="votre-clé-ici"

export MOONSHOT_API_KEY="votre-clé-ici"Référencez ensuite celles-ci dans la configuration de Cursor en utilisant le format standard ${ENV_VAR}.

🚀Optimisation des performances

- Réduisez la longueur du contexte pour des réponses plus rapides si nécessaire.

- Ajustez les paramètres de température (0.7 pour la créativité, 0.3 pour l'analyse).

- Utilisez des réponses en streaming pour un retour en temps réel lors de longues générations.

- Mettez en cache les requêtes courantes lorsque vous travaillez sur des tâches répétitives.

🔒Bonnes pratiques de sécurité

- Ne jamais commettre les clés API au contrôle de version.

- Utilisez uniquement les points d'accès HTTPS.

- Surveillez l'utilisation et définissez des limites de dépenses dans les tableaux de bord des fournisseurs.

- Faites pivoter les clés API régulièrement pour les environnements de production.

⚠️Note de sécurité : L'utilisation d'Apidog pour les tests d'API vous aide à valider les configurations de sécurité avant le déploiement en production.

Dépannage des problèmes courants

Problème : "Le modèle ne répond pas"

- Cause : Point d'accès API incorrect ou échec de l'authentification.

- Solution : Vérifiez votre URL de base et votre clé API, puis redémarrez Cursor.

Problème : "Limite de débit dépassée"

- Cause : Trop de requêtes envoyées au fournisseur en peu de temps.

- Solution : Attendez 60 secondes et réessayez, ou mettez à niveau votre plan de fournisseur.

Problème : "Fenêtre de contexte trop petite"

- Cause : Le fournisseur utilise par défaut un contexte de 4K au lieu des 256K de Kimi K2.5.

- Solution : Vérifiez les paramètres du fournisseur et assurez-vous que le contexte complet est activé.

Problème : "Jeton d'authentification expiré"

- Cause : La clé API a atteint sa date d'expiration.

- Solution : Générez une nouvelle clé API et mettez à jour votre configuration.

Conclusion

L'intégration de Kimi K2.5 avec Cursor débloque un modèle d'IA flexible et puissant dans votre environnement de développement préféré, même sans support natif. En configurant des points d'accès API personnalisés via OpenRouter ou Moonshot, vous accédez aux capacités multimodales de K2.5, à sa fenêtre de contexte de 256K et à ses comportements d'agent.

Cette approche vous donne un contrôle total sur votre flux de travail d'IA — la possibilité de choisir votre modèle en fonction des besoins du projet, du budget et des exigences de confidentialité. Configurez-le en quelques minutes, validez votre configuration et commencez à exploiter les capacités avancées de raisonnement et de codage de Kimi K2.5 directement là où vous écrivez du code.

Prochaines étapes :

- Choisissez votre fournisseur (OpenRouter pour la flexibilité, Moonshot pour l'accès direct)

- Configurez les identifiants API dans votre environnement ou les paramètres de Cursor

- Ajoutez Kimi K2.5 comme modèle personnalisé en utilisant le slug correct

- Testez l'intégration avec des tâches de codage simples avant de démarrer des projets importants

- Utilisez Apidog pour valider les flux de travail API et déboguer les problèmes efficacement

💡Conseil final : Rejoignez des communautés de développeurs utilisant des modèles d'IA personnalisés pour partager des flux de travail, des astuces de dépannage et des solutions créatives afin de maximiser le potentiel de Kimi K2.5 dans Cursor.