Imagina tener una supercomputadora en tu bolsillo, capaz de entender y generar texto similar al humano sobre cualquier tema. Suena a ciencia ficción, ¿verdad? Bueno, gracias a los recientes avances en inteligencia artificial, este sueño ahora es una realidad, y se llama Ollama.

Ollama es como una navaja suiza para LLM locales. Es una herramienta de código abierto que te permite ejecutar modelos de lenguaje potentes directamente en tu propia computadora. No necesitas servicios en la nube sofisticados ni un título en informática. Pero aquí es donde se pone realmente emocionante: Ollama tiene un superpoder oculto llamado API. Piensa en ello como un lenguaje secreto que permite que tus programas hablen directamente con estos cerebros de IA.

Ahora, sé lo que estás pensando. "¿APIs? ¡Eso suena complicado!"

No te preocupes, ahí es donde entra Apidog. Es como un traductor amigable que te ayuda a comunicarte con la API de Ollama sin sudar. En este artículo, vamos a embarcarnos juntos en un viaje. Seré tu guía mientras exploramos cómo liberar todo el potencial de Ollama usando Apidog. Al final, estarás creando aplicaciones impulsadas por IA como un profesional, todo desde la comodidad de tu propia máquina. Así que, abróchate el cinturón, ¡es hora de sumergirse en el fascinante mundo de la IA local y descubrir lo fácil que puede ser!

¿Qué es Ollama y cómo usar Ollama para ejecutar LLM localmente?

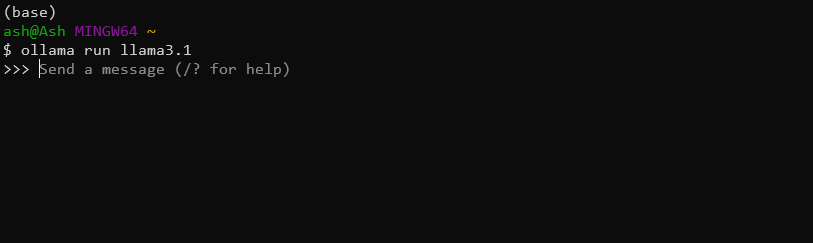

Ollama es una herramienta conveniente que permite a los usuarios ejecutar modelos de lenguaje grandes en sus máquinas locales. Simplifica el proceso de descarga, ejecución y ajuste fino de varios LLM, haciendo que las capacidades avanzadas de IA sean accesibles a un público más amplio. Por ejemplo, puedes simplemente descargar e instalar el último modelo Llama 3.1 8B con este comando solamente:

ollama run llama3.1

¿Ollama tiene una API?

Sí, puedes usar la API de Ollama para integrar estos potentes LLM locales en sus aplicaciones sin problemas.

Las características clave de la API de Ollama incluyen:

- Gestión de modelos (extracción, listado y eliminación de modelos)

- Generación de texto (finalizaciones e interacciones de chat)

- Generación de incrustaciones

- Capacidades de ajuste fino

Usando la API de Ollama, puedes aprovechar fácilmente el poder de los LLM en sus aplicaciones sin la necesidad de una infraestructura compleja o dependencias de la nube.

Usando Apidog para probar las APIs de Ollama

Apidog es una plataforma versátil de desarrollo y documentación de APIs diseñada para optimizar todo el ciclo de vida de la API. Ofrece una interfaz fácil de usar para diseñar, probar y documentar APIs, lo que la convierte en una herramienta ideal para trabajar con la API de Ollama.

Algunas de las características destacadas de APIDog incluyen:

- Interfaz intuitiva de diseño de API

- Generación automática de documentación

- Herramientas de prueba y depuración de API

- Características de colaboración para proyectos en equipo

- Soporte para varios protocolos y formatos de API

Con Apidog, los desarrolladores pueden crear, gestionar y compartir fácilmente la documentación de la API, asegurando que sus integraciones de la API de Ollama estén bien documentadas y sean mantenibles.

Prerrequisitos

Antes de sumergirte en hacer llamadas a la API de Ollama con Apidog, asegúrate de tener los siguientes prerrequisitos en su lugar:

Instalación de Ollama: Descarga e instala Ollama en tu máquina local. Sigue la documentación oficial de Ollama para obtener instrucciones de instalación específicas para tu sistema operativo.

Cuenta de APIDog: Regístrate para obtener una cuenta de Apidog si aún no lo has hecho. Puedes usar la versión basada en la web o descargar la aplicación de escritorio, dependiendo de tu preferencia.

Modelo de Ollama: Extrae un modelo usando la interfaz de línea de comandos de Ollama. Por ejemplo, para descargar el modelo "llama2", ejecutarías:

ollama pull llama3.1

Herramienta de prueba de API: Si bien Apidog proporciona capacidades de prueba integradas, también puedes tener a mano una herramienta como cURL o Postman para pruebas y verificaciones adicionales.

Con estos elementos en su lugar, estás listo para comenzar a explorar la API de Ollama usando Apidog.

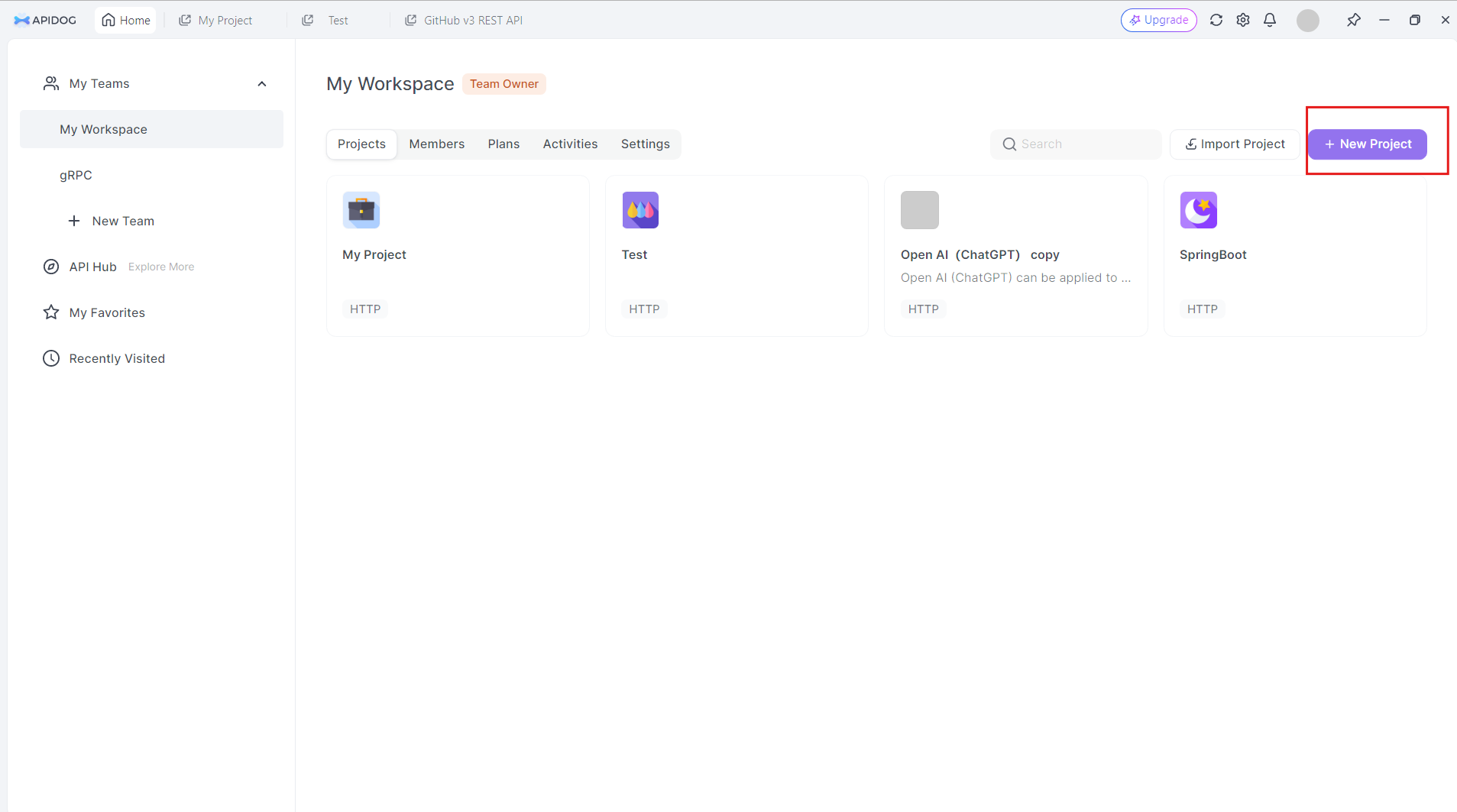

Creando un proyecto de API de Ollama en Apidog

Para comenzar a trabajar con la API de Ollama en Apidog, sigue estos pasos:

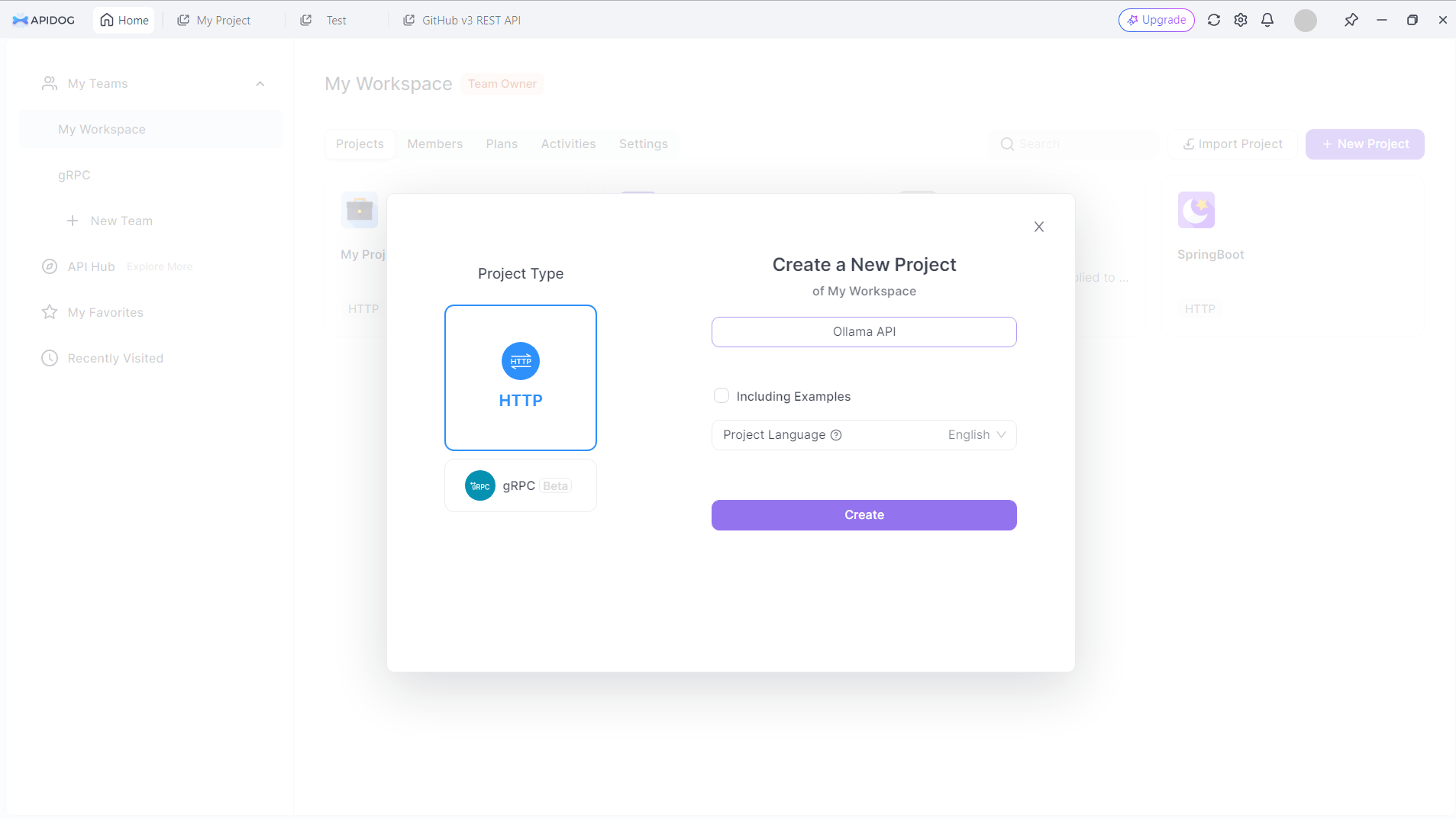

Crear un nuevo proyecto: Inicia sesión en Apidog y crea un nuevo proyecto específicamente para tu trabajo con la API de Ollama. Haz clic en el botón Nuevo proyecto en la esquina superior derecha

Dale un nombre a tu nuevo proyecto. Digamos: API de Ollama:

Haz clic en el botón Crear para continuar.

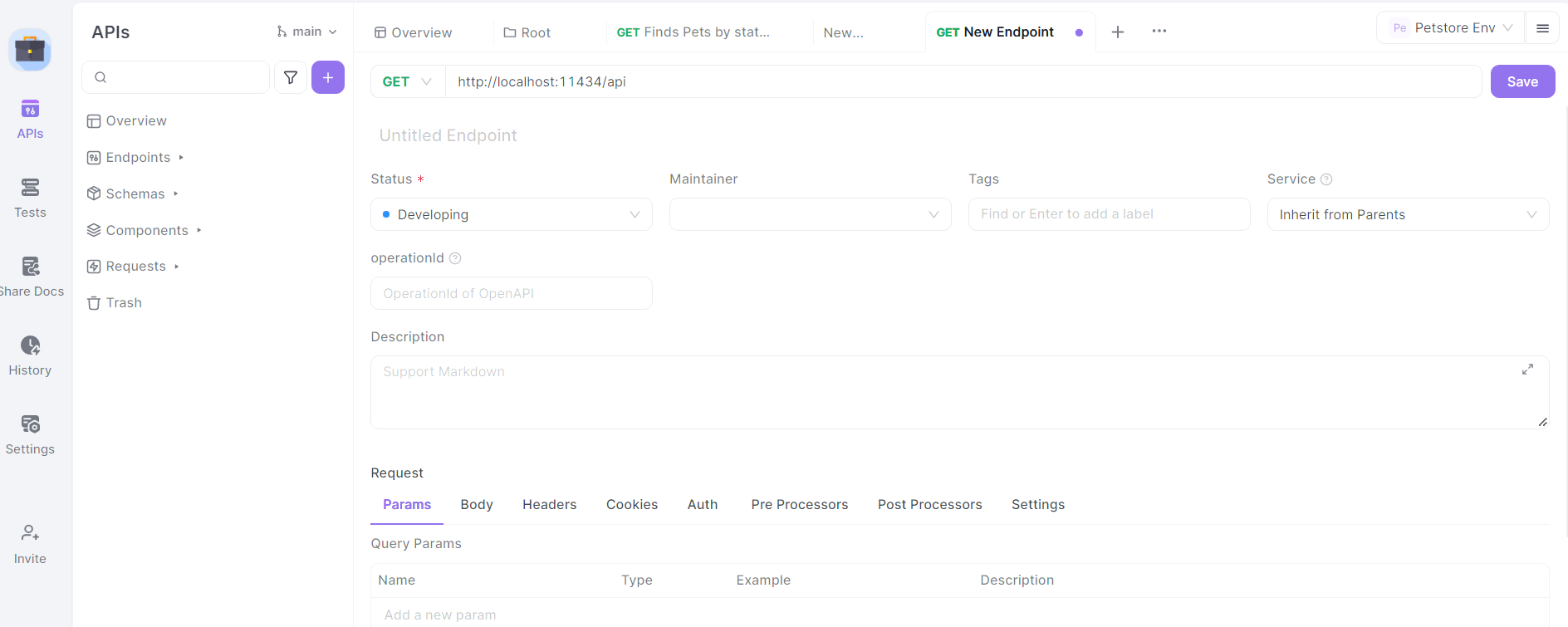

Configurar la URL base: En la configuración de tu proyecto, establece la URL base en http://localhost:11434/api. Esta es la dirección predeterminada donde Ollama expone sus puntos finales de API.

Importar la especificación de la API de Ollama: Si bien Ollama no proporciona una especificación oficial de OpenAPI, puedes crear una estructura básica para los puntos finales de la API manualmente en APIDog.

Definir puntos finales: Comienza definiendo los principales puntos finales de la API de Ollama en APIDog. Algunos puntos finales clave para incluir son:

/generate(POST): Para la generación de texto/chat(POST): Para interacciones basadas en chat/embeddings(POST): Para generar incrustaciones/pull(POST): Para extraer nuevos modelos/list(GET): Para listar los modelos disponibles

Para cada punto final, especifica el método HTTP, los parámetros de solicitud y el formato de respuesta esperado según la documentación de la API de Ollama.

Diseñando llamadas a la API de Ollama en Apidog

Repasemos el proceso de diseño de llamadas a la API para algunos de los puntos finales de Ollama más utilizados usando Apidog:

Punto final de generación de texto (/generate)

En Apidog, crea un nuevo punto final de API con la ruta /generate y establece el método HTTP en POST.

Define el esquema del cuerpo de la solicitud:

{

"model": "string",

"prompt": "string",

"system": "string",

"template": "string",

"context": "array",

"options": {

"temperature": "number",

"top_k": "integer",

"top_p": "number",

"num_predict": "integer",

"stop": "array"

}

}

Proporciona una descripción para cada parámetro, explicando su propósito y cualquier restricción.

Define el esquema de respuesta basado en la documentación de la API de Ollama, incluyendo campos como response, context y total_duration.

Punto final de chat (/chat)

Crea un nuevo punto final con la ruta /chat y establece el método HTTP en POST.

Define el esquema del cuerpo de la solicitud:

{

"model": "string",

"messages": [

{

"role": "string",

"content": "string"

}

],

"format": "string",

"options": {

"temperature": "number",

"top_k": "integer",

"top_p": "number",

"num_predict": "integer",

"stop": "array"

}

}

Proporciona descripciones detalladas para la matriz messages, explicando la estructura de los mensajes de chat con roles (sistema, usuario, asistente) y contenido.

Define el esquema de respuesta, incluyendo el objeto message con los campos role y content.

Puntos finales de gestión de modelos

Crea puntos finales para las operaciones de gestión de modelos:

- Extraer modelo (

/pull): Solicitud POST con el parámetronamepara el modelo a descargar. - Listar modelos (

/list): Solicitud GET para recuperar los modelos disponibles. - Eliminar modelo (

/delete): Solicitud DELETE con el parámetronamepara el modelo a eliminar.

Para cada uno de estos puntos finales, define los esquemas de solicitud y respuesta apropiados basados en la documentación de la API de Ollama.

Probando llamadas a la API de Ollama en Apidog

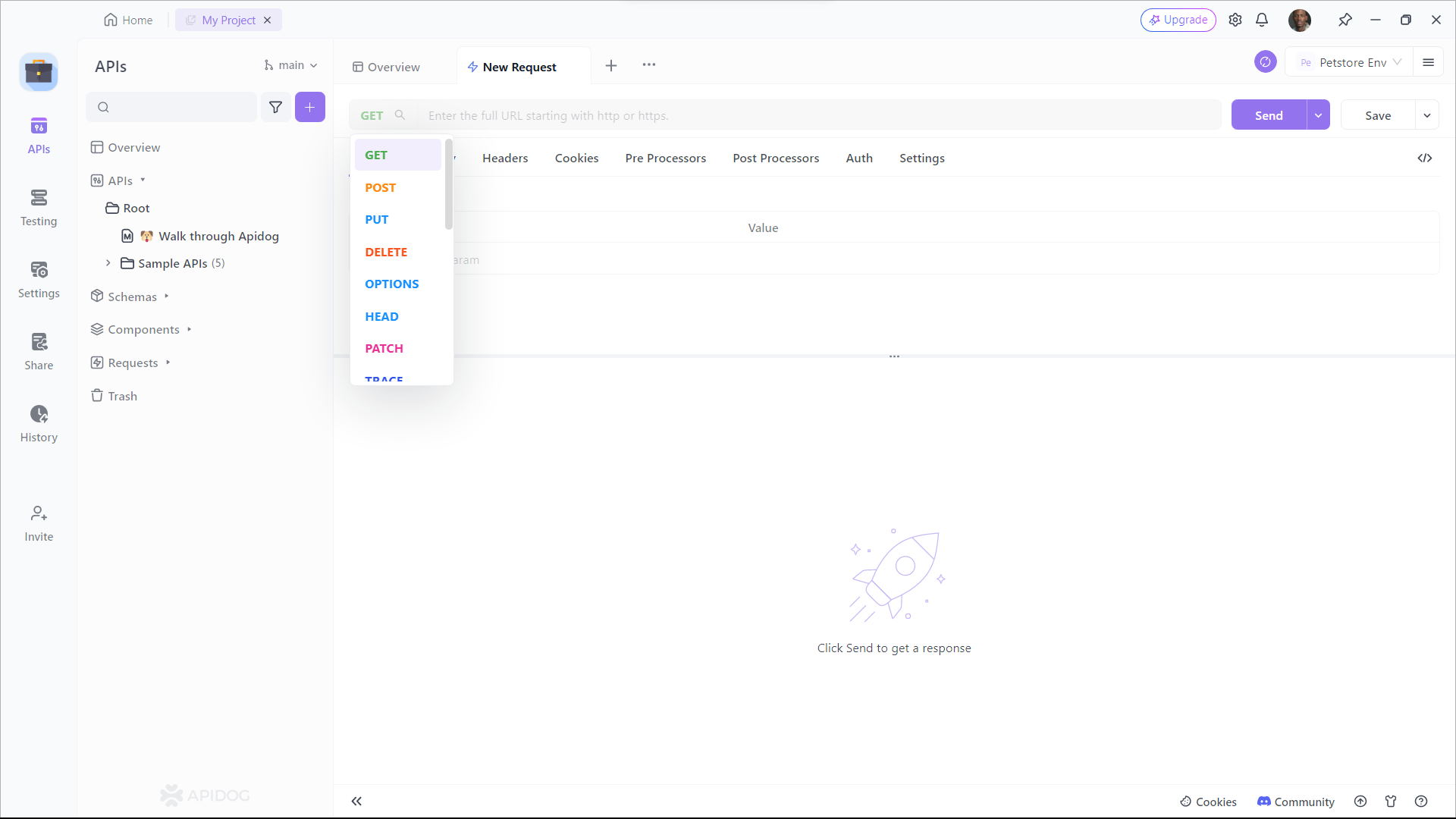

Apidog proporciona un entorno de prueba integrado que te permite enviar solicitudes a tu API de Ollama y verificar las respuestas. Aquí te mostramos cómo usarlo:

Selecciona un punto final: Elige uno de los puntos finales de la API de Ollama que hayas definido en Apidog.

Configura los parámetros de solicitud: Completa los parámetros requeridos para el punto final seleccionado. Por ejemplo, para el punto final /generate, podrías establecer:

{

"model": "llama2",

"prompt": "Explica el concepto de inteligencia artificial en términos sencillos."

}

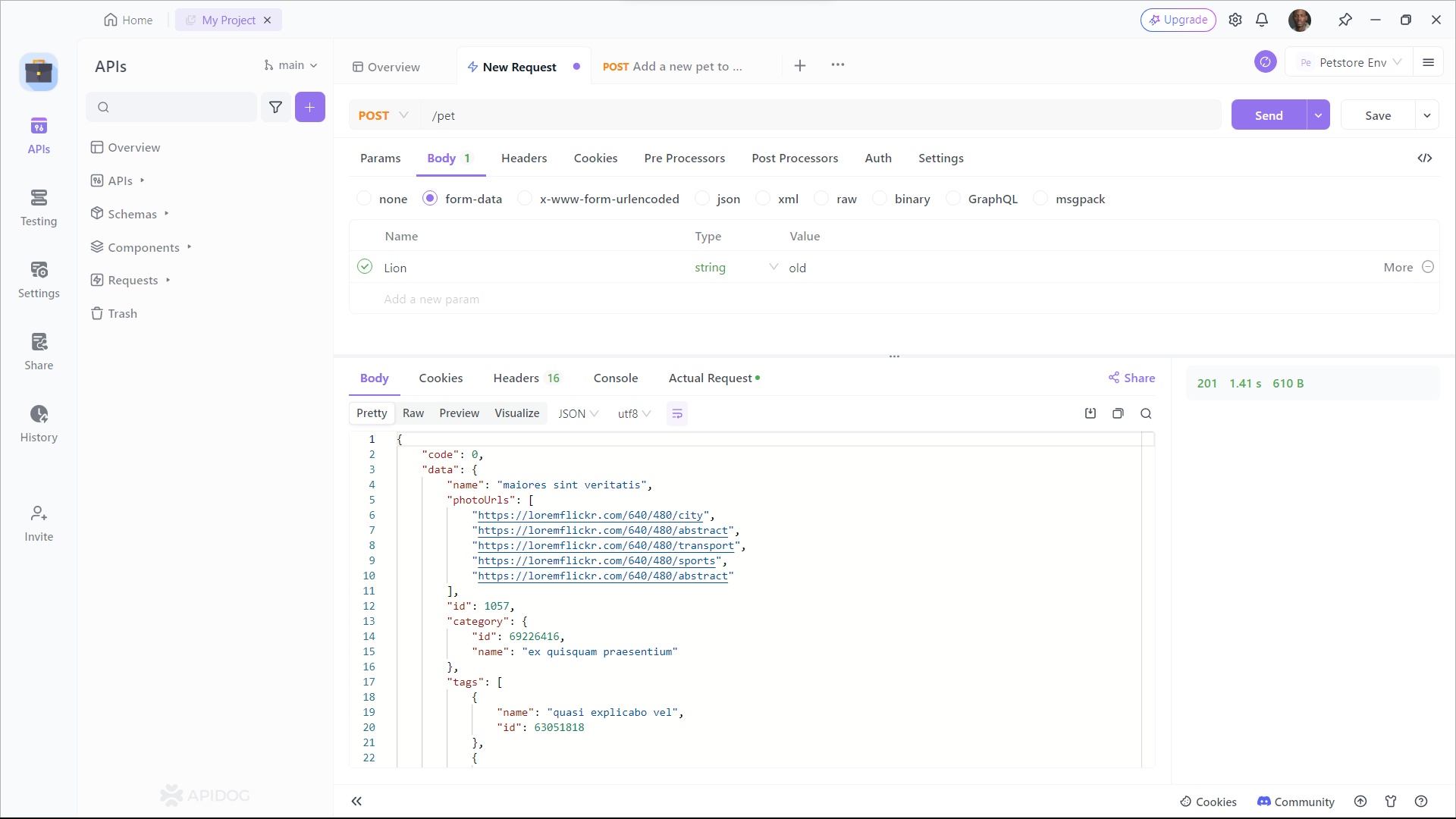

Envía la solicitud: Usa el botón "Enviar" de Apidog para ejecutar la llamada a la API a tu instancia local de Ollama.

Examina la respuesta de Ollama, verificando que coincida con el formato esperado y contenga el texto generado u otra información relevante. Si encuentras algún problema, usa las herramientas de depuración de Apidog para inspeccionar los encabezados de solicitud y respuesta, el cuerpo y cualquier mensaje de error.

Generando documentación de la API

Una de las características más poderosas de Apidog es su capacidad para generar automáticamente documentación completa de la API. Para crear documentación para tu proyecto de API de Ollama:

Paso 1: Regístrate en Apidog

Para comenzar a usar Apidog para la generación de documentación de la API, deberás registrarte para obtener una cuenta si aún no lo has hecho. Una vez que hayas iniciado sesión, serás recibido por la interfaz fácil de usar de Apidog.

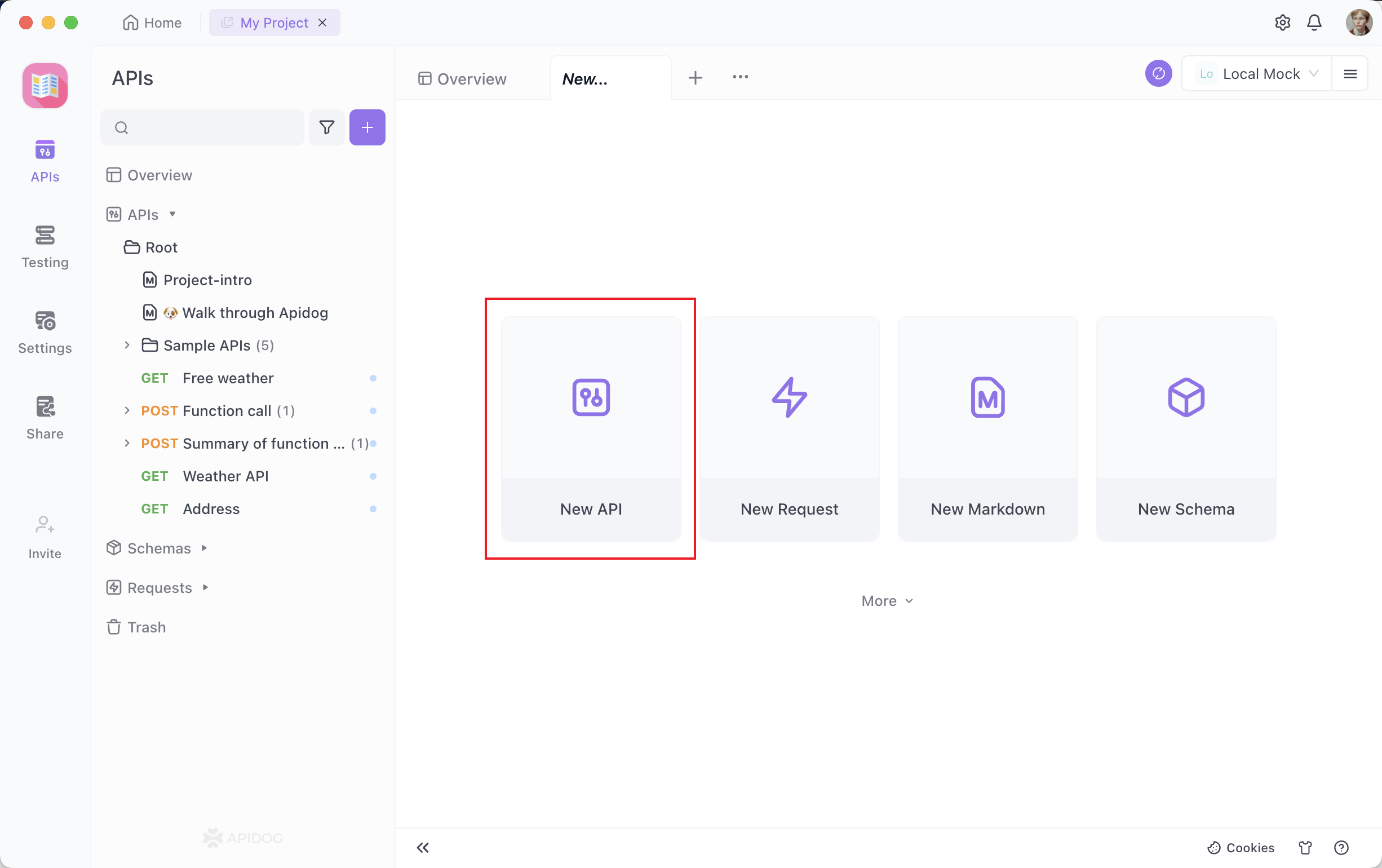

Paso 2: Creando tu solicitud de API

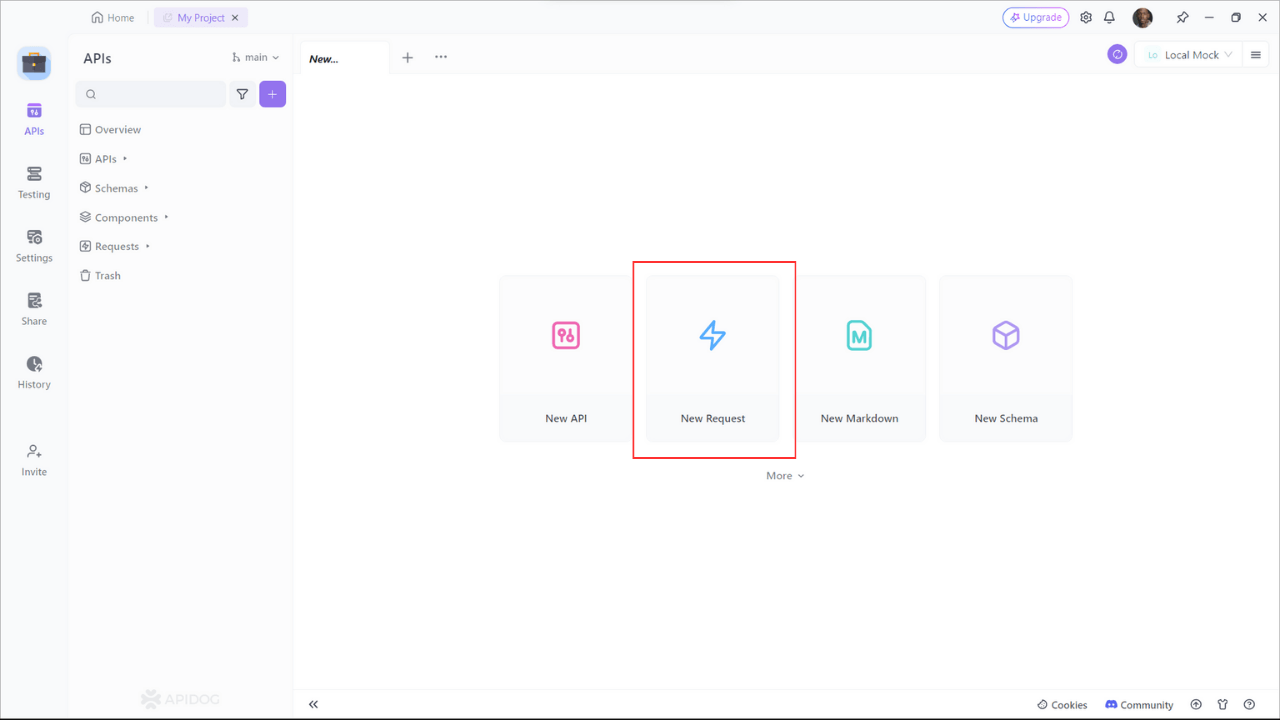

Un proyecto de documentación de API se compone de varios puntos finales, cada uno representando una ruta o funcionalidad de API específica. Para agregar un punto final, haz clic en el botón "+" o "Nueva API" dentro de tu proyecto.

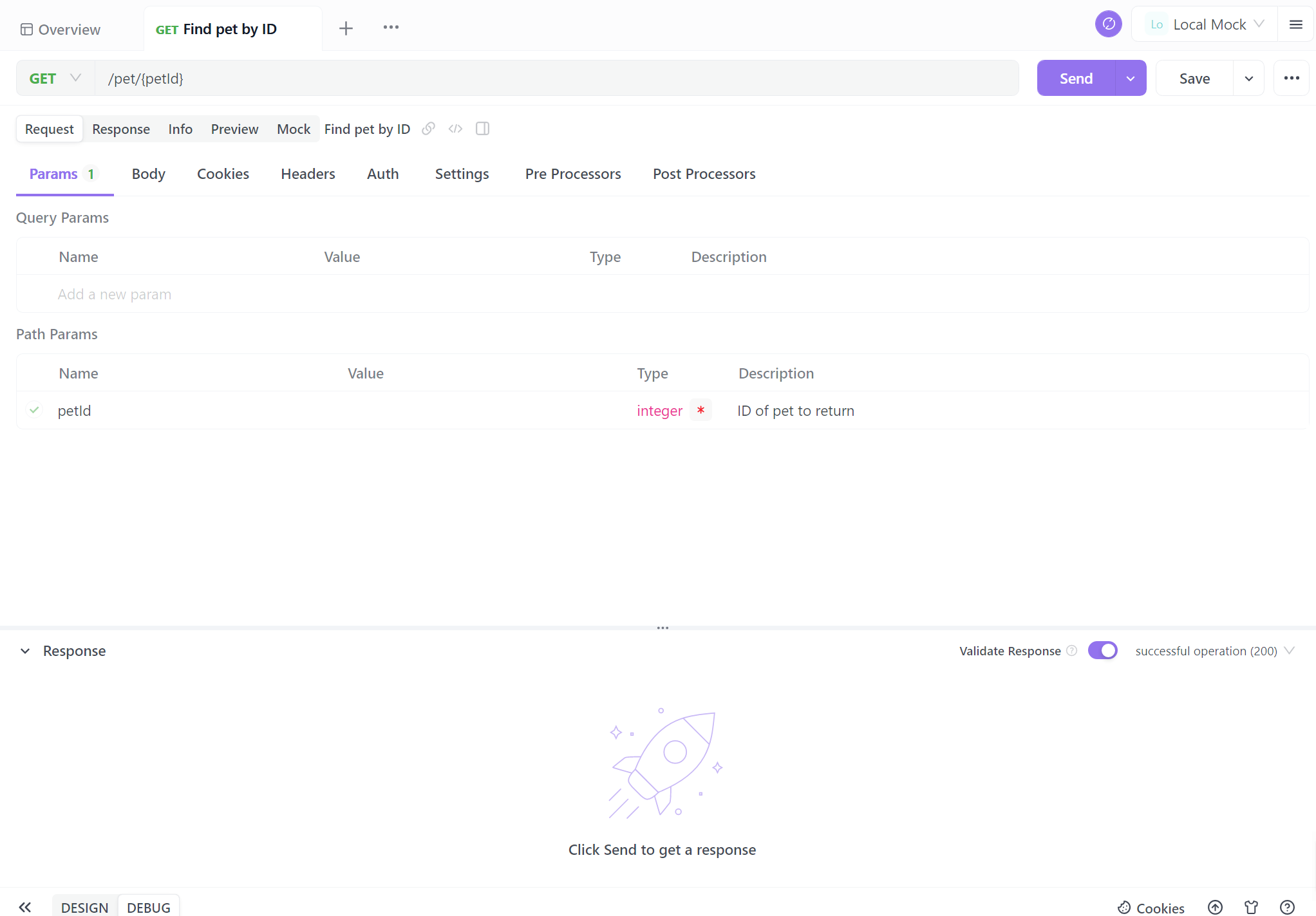

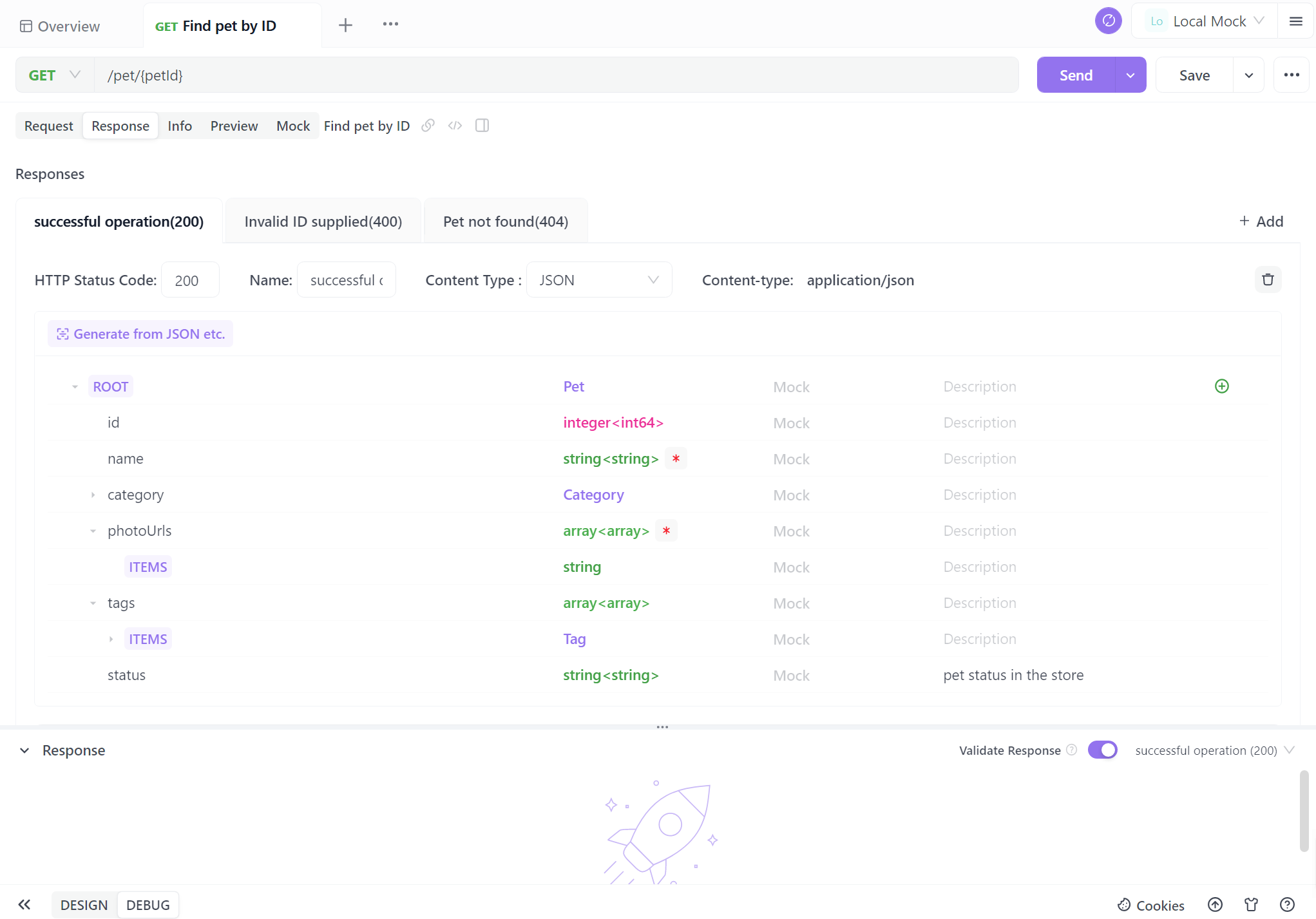

Paso 3: Configura los parámetros de solicitud

Deberás proporcionar detalles como la URL del punto final, la descripción y los detalles de solicitud/respuesta. Ahora viene la parte crítica: documentar tus puntos finales. Apidog hace que este proceso sea increíblemente sencillo. Para cada punto final, puedes:

- Especificar el método HTTP (GET, POST, PUT, DELETE, etc.).

- Definir los parámetros de solicitud, incluyendo sus nombres, tipos y descripciones.

- Describir la respuesta esperada, incluyendo los códigos de estado, los formatos de respuesta (JSON, XML, etc.) y los ejemplos de respuesta.

A muchos desarrolladores no les gusta escribir documentación de API, a menudo encontrándola compleja. Sin embargo, en realidad, con Apidog, puedes completarla con solo unos pocos clics del ratón. La interfaz visual de Apidog es amigable para principiantes, lo que la hace mucho más simple que generar documentación de API a partir del código.

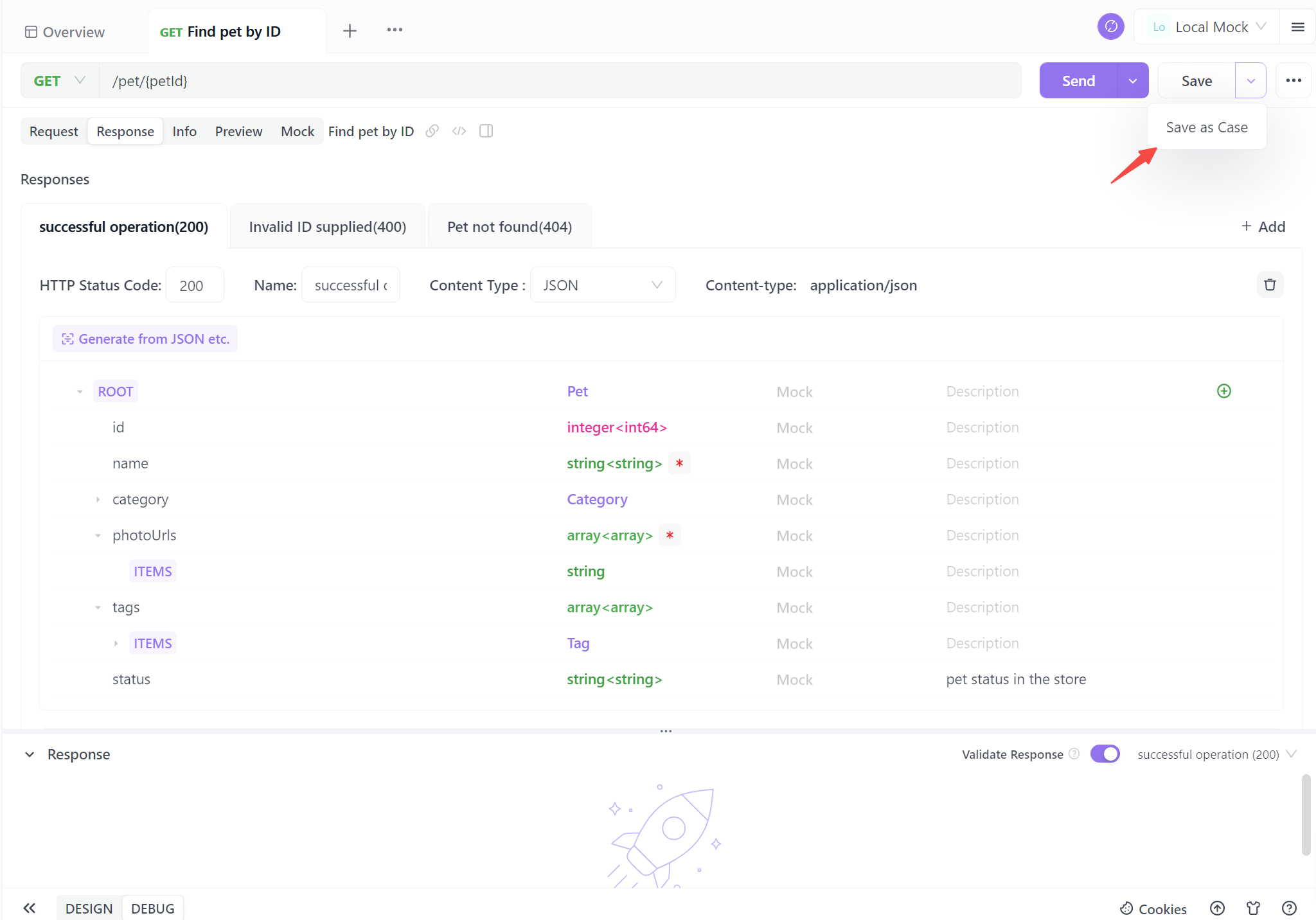

Paso 4. Genera tu API

Cuando completes la información básica de la API, solo un clic para guardar como un caso. También puedes guardarlo directamente, pero se recomienda guardarlo como un caso de prueba para una referencia futura más fácil.

Seguir estos cuatro pasos te permite generar sin esfuerzo documentación de API estandarizada. Este proceso optimizado no solo garantiza la claridad y la coherencia, sino que también ahorra un tiempo valioso. Con la documentación automatizada, estás bien equipado para mejorar la colaboración, simplificar la interacción del usuario e impulsar tus proyectos con confianza.

Mejores prácticas para la integración de la API de Ollama

A medida que trabajes con la API de Ollama a través de APIDog, ten en cuenta estas mejores prácticas:

- Control de versiones: Usa las características de control de versiones de APIDog para rastrear los cambios en tus definiciones de API a lo largo del tiempo.

- Manejo de errores: Documenta las respuestas de error comunes e incluye ejemplos de cómo manejarlas en tu documentación de API.

- Limitación de velocidad: Ten en cuenta cualquier limitación de velocidad implementada por Ollama, especialmente cuando se ejecuta en sistemas con recursos limitados, y documenta estas limitaciones.

- Consideraciones de seguridad: Si bien Ollama normalmente se ejecuta localmente, considera implementar la autenticación si expones la API a través de una red.

- Optimización del rendimiento: Documenta las mejores prácticas para optimizar las solicitudes, como reutilizar el contexto para consultas relacionadas para mejorar los tiempos de respuesta.

Conclusión

Integrar la API de Ollama en tus proyectos abre un mundo de posibilidades para aprovechar los potentes modelos de lenguaje en tus aplicaciones. Al usar APIDog para diseñar, probar y documentar tus llamadas a la API de Ollama, creas una integración robusta y mantenible que puede evolucionar con las necesidades de tu proyecto.

La combinación de las capacidades LLM locales de Ollama y las características integrales de gestión de API de APIDog proporciona a los desarrolladores un potente conjunto de herramientas para construir aplicaciones mejoradas con IA. A medida que continúes explorando el potencial de Ollama y refinando tus integraciones de API, recuerda que la documentación clara y las pruebas exhaustivas son clave para una implementación exitosa.

Siguiendo los pasos y las mejores prácticas descritas en este artículo, estarás bien equipado para aprovechar todo el potencial de la API de Ollama, creando aplicaciones sofisticadas impulsadas por IA con confianza y facilidad. El viaje de la integración de la IA es emocionante, y con herramientas como Ollama y APIDog a tu disposición, las posibilidades son realmente ilimitadas.