Der Benutzerakzeptanztest (UAT) stellt den letzten Prüfpunkt dar, bevor Software für reale Benutzer freigegeben wird. Nach Monaten der Entwicklung, unzähligen Komponententests und Systemintegrationsvalidierungen beantwortet der UAT (Benutzerakzeptanztest) die entscheidende Frage: Löst diese Lösung tatsächlich das Geschäftsproblem? Zu viele Teams behandeln den UAT als reine Formsache und stellen später fest, dass perfekt funktionierende Software die Benutzeranforderungen nicht erfüllt. Dieser Leitfaden bietet einen praktischen Rahmen für die Durchführung von Benutzerakzeptanztests, die den Geschäftswert tatsächlich validieren.

Was ist der Benutzerakzeptanztest (UAT)?

Der UAT (Benutzerakzeptanztest) ist ein formeller Test, der von Endbenutzern oder Geschäftsvertretern durchgeführt wird, um zu überprüfen, ob ein Softwaresystem die vereinbarten Anforderungen erfüllt und für die Produktivbereitstellung bereit ist. Im Gegensatz zu Funktionstests, die von QA-Ingenieuren durchgeführt werden, bewertet der Benutzerakzeptanztest die Software aus der Geschäftsprozessperspektive. Tester fragen: Kann ich meine täglichen Aufgaben erledigen? Passt dieser Workflow dazu, wie unser Team arbeitet? Wird dies unsere Arbeit tatsächlich erleichtern?

Der wesentliche Unterschied: Der UAT (Benutzerakzeptanztest) validiert, dass Sie das Richtige gebaut haben, während der Funktionstest bestätigt, dass Sie das Ding richtig gebaut haben. Eine Funktion kann jeden Funktionstest bestehen, aber im Benutzerakzeptanztest fehlschlagen, weil sie nicht mit den realen Geschäftsprozessen übereinstimmt.

Häufige UAT (Benutzerakzeptanztest)-Szenarien umfassen:

- Verarbeitung eines vollständigen Kundenauftrags von der Erstellung bis zur Ausführung

- Erstellung von Finanzberichten zum Monatsende

- Einarbeitung eines neuen Mitarbeiters über das HR-System

- Bearbeitung einer Produktrücksendung über das Kundendienstportal

Wann sollte der Benutzerakzeptanztest durchgeführt werden: Zeitpunkt im SDLC

Der UAT (Benutzerakzeptanztest) muss nach Abschluss des Systemtests, aber vor der Produktivbereitstellung erfolgen. Die Eintrittskriterien sind aus gutem Grund streng:

| Bedingung | Status |

|---|---|

| Alle kritischen funktionalen Fehler behoben | Muss abgeschlossen sein |

| Systemtest mit >95% Erfolgsquote bestanden | Muss abgeschlossen sein |

| Leistungsbenchmarks erfüllt | Muss abgeschlossen sein |

| Bekannte Fehler dokumentiert und akzeptiert | Muss abgeschlossen sein |

| UAT-Umgebung spiegelt Produktion wider | Muss abgeschlossen sein |

| Testdaten, die reale Szenarien repräsentieren | Muss abgeschlossen sein |

| UAT-Testfälle überprüft und genehmigt | Muss abgeschlossen sein |

| Geschäftstester in neuen Funktionen geschult | Muss abgeschlossen sein |

Der Versuch, Benutzerakzeptanztests durchzuführen, bevor diese Kriterien erfüllt sind, ist Zeitverschwendung. Benutzer werden auf grundlegende Fehler stoßen, das Vertrauen verlieren und in Frage stellen, ob das System bereit ist.

Der ideale Zeitpunkt ist 2-3 Wochen vor der geplanten Veröffentlichung. Dies bietet einen Puffer, um Probleme ohne Eile zu beheben. In agilen Umgebungen findet der UAT (Benutzerakzeptanztest) am Ende jedes Sprints für freizugebende Funktionen statt, wobei Sprint-Demos als Mikro-UAT-Sitzungen genutzt werden.

Wie man UAT durchführt: Ein Schritt-für-Schritt-Framework

Die Durchführung effektiver Benutzerakzeptanztests folgt einem strukturierten Prozess, der die Benutzerbeteiligung maximiert und Unterbrechungen minimiert.

Schritt 1: Planen und Vorbereiten

Definieren Sie den Umfang, indem Sie geschäftskritische Workflows auswählen. Erstellen Sie UAT (Benutzerakzeptanztest)-Testfälle, die:

- Vollständige Geschäftsprozesse abdecken, nicht isolierte Funktionen

- Realistische Testdaten enthalten, die die Produktion widerspiegeln

- Klare Bestanden-/Fehlerkriterien aus geschäftlicher Sicht definieren

Schritt 2: Tester auswählen und schulen

Wählen Sie 5-10 Geschäftsbenutzer aus, die:

- Verschiedene Rollen repräsentieren (Manager, Analyst, Bediener)

- Aktuelle Prozesse gründlich verstehen

- Engagierte Zeit aufwenden können

- Angesehene Multiplikatoren sind, die die Einführung fördern

Führen Sie eine 2-stündige Schulung durch, die Folgendes abdeckt:

- UAT (Benutzerakzeptanztest)-Ziele und -Bedeutung

- Wie Testfälle ausgeführt werden

- Wie Fehler klar gemeldet werden

- Was einen Blocker im Vergleich zu einem geringfügigen Problem darstellt

Schritt 3: Tests ausführen

Stellen Sie den Testern Folgendes zur Verfügung:

- UAT (Benutzerakzeptanztest)-Testfalldokument

- Zugangsdaten für die UAT-Umgebung

- Vorlage zur Fehlerberichterstattung

- Täglicher 30-minütiger Check-in-Zeitplan

Tester führen Szenarien in 2-4-Stunden-Blöcken aus und dokumentieren:

- Ob sie den Workflow abschließen konnten

- Jegliche Verwirrung oder Verzögerung

- Aufgetretene Fehler

- Fehlende Funktionalität

Schritt 4: Fehler verwalten

Verwenden Sie einen schnellen Triage-Prozess:

- Blocker: Verhindert eine Kernfunktion des Geschäfts (sofort beheben)

- Kritisch: Große Workflow-Störung (innerhalb von 48 Stunden beheben)

- Mittel: Workaround existiert (vor der Veröffentlichung beheben)

- Geringfügig: Kosmetisch oder mit geringem Einfluss (für die Zukunft dokumentieren)

Führen Sie tägliche Fehlerbesprechungen mit Produkt- und Entwicklungsteams durch, um die Fehlerbehebung zu priorisieren.

Schritt 5: Abnahme und Übergabe

Der Abschluss des UAT (Benutzerakzeptanztests) erfordert eine formelle Abnahme durch die Geschäftsinteressenten. Das Abnahmedokument sollte besagen:

"Wir haben das System anhand unserer Geschäftsanforderungen getestet und bestätigen, dass es unsere Anforderungen für die Produktivbereitstellung erfüllt. Wir übernehmen die Verantwortung für die Schulung unserer Teams und die Einführung der neuen Prozesse."

Dieses Dokument überträgt die Verantwortung von der IT an das Business, ein entscheidender psychologischer Meilenstein.

UAT vs. andere Testarten: Klare Abgrenzung

Das Verständnis des UAT (Benutzerakzeptanztests) erfordert die Unterscheidung von ähnlich klingenden Tests:

| Aspekt | Systemtest | Funktionstest | UAT (Benutzerakzeptanztest) |

|---|---|---|---|

| Zweck | Validiert das gesamte integrierte System | Überprüft, ob Funktionen gemäß Spezifikationen arbeiten | Bestätigt, dass Geschäftsanforderungen erfüllt sind |

| Durchgeführt von | QA-Ingenieure | QA/Tester | Endbenutzer, Business Analysts |

| Testgrundlage | Technische Anforderungen, Design-Dokumente | Funktionale Spezifikationen, User Stories | Geschäftsprozesse, Workflows |

| Umgebung | QA-Testumgebung | QA-Testumgebung | Produktionsähnliche UAT-Umgebung |

| Erfolgskriterien | Alle Tests bestanden, Fehler protokolliert | Anforderungsabdeckung erreicht | Geschäftsprozesse ausführbar |

| Gefundene Fehler | Technische Fehler, Integrationsprobleme | Funktionale Fehler, Logikfehler | Workflow-Lücken, fehlende Funktionen |

Der Systemtest beantwortet: "Funktioniert das System technisch?"

Der Funktionstest beantwortet: "Funktionieren die Funktionen wie entworfen?"

Der UAT (Benutzerakzeptanztest) beantwortet: "Können wir unser Geschäft damit betreiben?"

Häufige UAT-Herausforderungen und Lösungen

Selbst gut geplante UAT (Benutzerakzeptanztests) stehen vor Hindernissen. So gehen Sie damit um:

Herausforderung 1: Benutzer sind nicht verfügbar

Lösung: Planen Sie UAT (Benutzerakzeptanztests) im Voraus während der Sprintplanung. Kompensieren Sie Tester mit Freizeitausgleich oder Anerkennung. Erwägen Sie eine Rotation der UAT-Verantwortlichkeiten unter den Teammitgliedern.

Herausforderung 2: Testdaten sind unrealistisch

Lösung: Verwenden Sie Anonymisierungstools für Produktionsdaten, um realistische Datensätze zu erstellen. Befüllen Sie die UAT-Umgebung mit Daten, die tatsächliche Geschäftsszenarien widerspiegeln, nicht generische Beispiele.

Herausforderung 3: Fehler werden ignoriert

Lösung: Etablieren Sie einen klaren Triage-Prozess mit geschäftlicher Priorisierung. Kommunizieren Sie, dass UAT (Benutzerakzeptanztests) keine Qualitätssicherung ist – Geschäftsbenutzer entscheiden, was akzeptabel ist, nicht die technische Schwere.

Herausforderung 4: Umfangserweiterung (Scope Creep)

Lösung: Frieren Sie Funktionen ein, bevor der UAT (Benutzerakzeptanztest) beginnt. Dokumentieren Sie angeforderte Verbesserungen als zukünftige Stories, nicht als UAT-Blocker.

Herausforderung 5: Instabilität der Umgebung

Lösung: Behandeln Sie die UAT-Umgebung wie die Produktion – keine direkten Bereitstellungen, kontrollierte Updates und dedizierter Support.

Wie Apidog Entwicklungsteams während des UAT unterstützt

Wenn Geschäftsbenutzer während des UAT (Benutzerakzeptanztests) Probleme melden, müssen Entwickler diese schnell reproduzieren und beheben. Apidog beschleunigt diesen Zyklus dramatisch, insbesondere bei API-bezogenen Problemen.

Schnelle Problemreproduktion

Stellen Sie sich vor, ein UAT-Tester meldet: "Wenn ich die Bestellung abschicke, erhalte ich einen 'Validation Failed'-Fehler, aber ich weiß nicht warum."

Traditionelles Debugging umfasst:

- Den Tester nach genauen Schritten und Daten fragen

- Die Anfrage manuell in Postman neu erstellen

- Logs auf Validierungsfehler prüfen

- Raten, welches Feld das Problem verursacht hat

Mit Apidog wird der Prozess wie folgt:

- Der Tester exportiert die fehlgeschlagene Anfrage aus den Browser-Entwicklertools oder stellt den API-Endpunkt bereit

- Der Entwickler importiert sie in Apidog und führt sie sofort mit denselben Parametern aus

- Apidogs detailliertes Fehlerorakel zeigt genau, welches Feld die Validierung fehlgeschlagen hat und warum

- KI schlägt eine Lösung vor, basierend auf der API-Spezifikationsabweichung

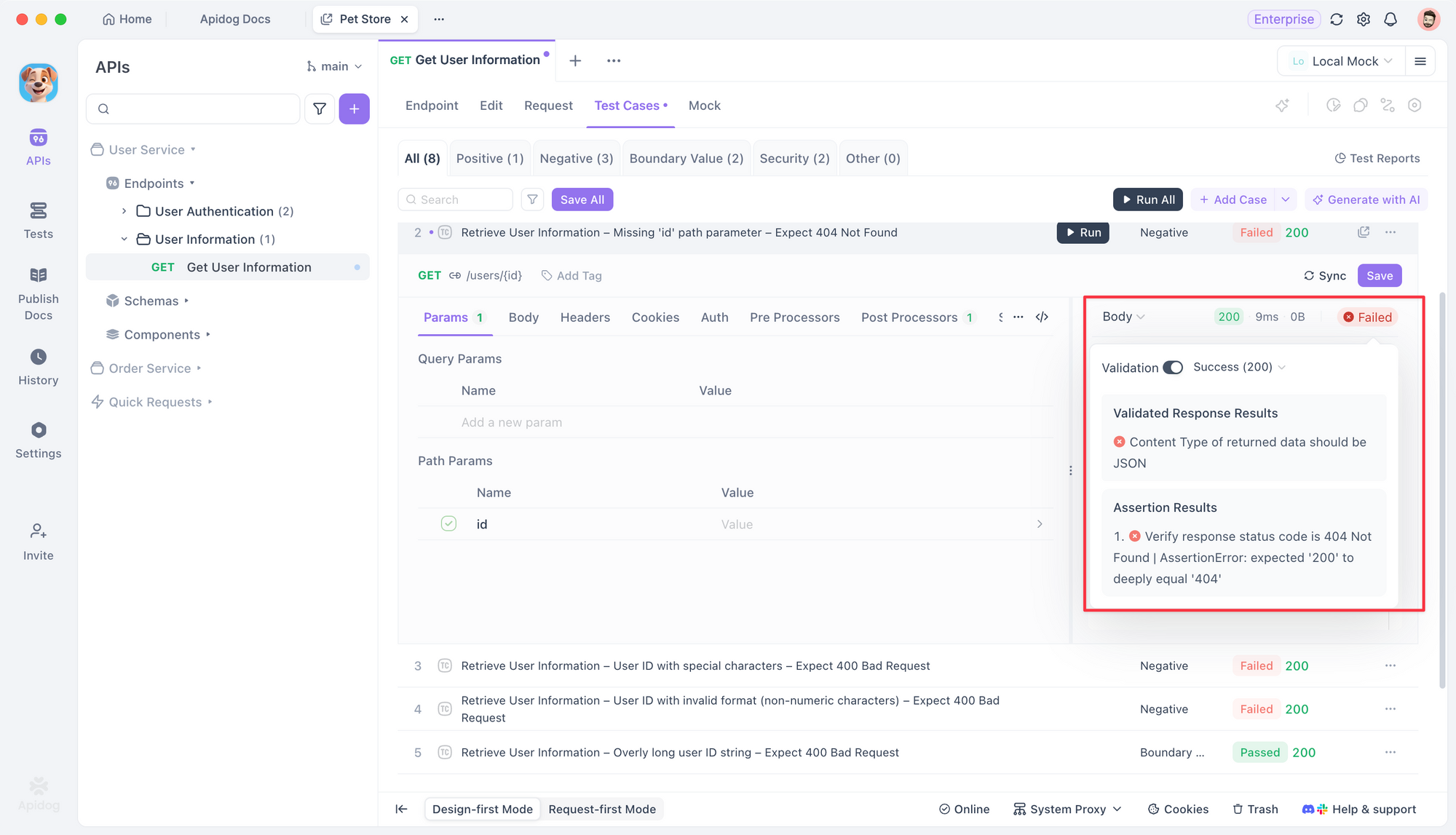

Automatisierte Regression während UAT-Fehlerbehebungen

Wenn Entwickler während des UAT (Benutzerakzeptanztests) Korrekturen einspielen, müssen sie sicherstellen, dass Änderungen keine anderen Funktionen beeinträchtigen. Apidogs Testsuite bietet:

// Apidog-generierter Regressionstest für die Bestellübermittlung

Test: POST /api/orders - Gültige Bestellung

Gegeben: Authentifizierter Benutzer, gültige Warenkorb-Artikel

Wenn: Bestellung mit vollständiger Lieferadresse abschicken

Oracle 1: Antwortstatus 201

Oracle 2: Bestell-ID zurückgegeben und entspricht dem UUID-Format

Oracle 3: Antwortzeit < 2 Sekunden

Oracle 4: Datenbank enthält Bestellung mit "ausstehendem" Status

Oracle 5: Bestand um bestellte Mengen reduziert

Entwickler führen diese Suite aus, bevor sie in die UAT-Umgebung pushen, um sicherzustellen, dass Korrekturen keine Regressionen einführen.

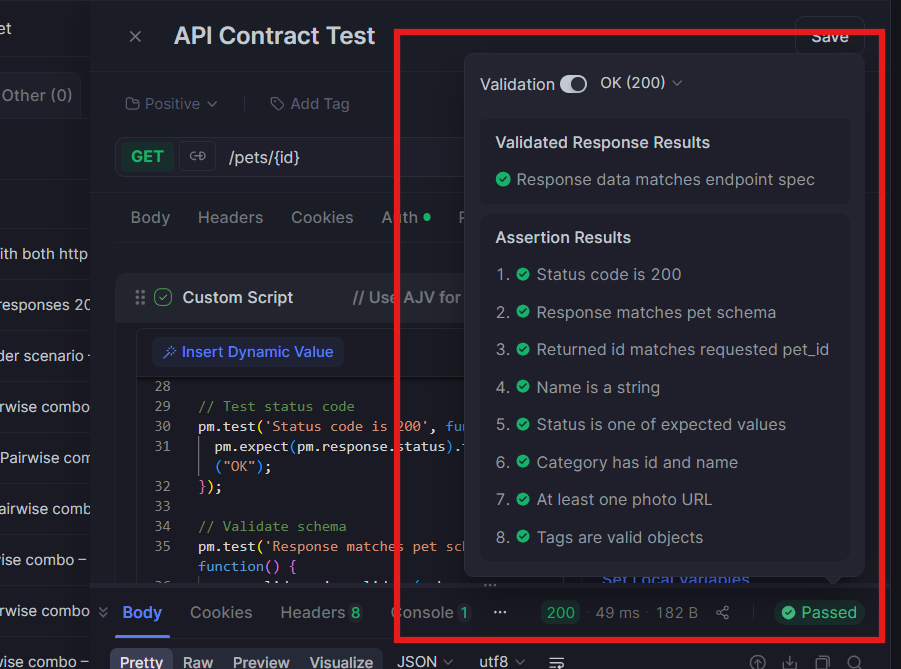

API-Vertragvalidierung im UAT

Der UAT (Benutzerakzeptanztest) zeigt oft, dass die API-Antwort nicht dem entspricht, was das Frontend erwartet. Apidog verhindert dies, indem es:

- Antwortschemata in Echtzeit gegen die OpenAPI-Spezifikation validiert

- Abweichungen zwischen Frontend-Erwartungen und API-Verhalten hervorhebt

- Mock-Server generiert, basierend auf der Spezifikation, damit der UAT fortgesetzt werden kann, während das Backend noch offene Probleme behebt

Optimierte Fehlerdokumentation

Wenn UAT-Tester API-Probleme melden, erfasst Apidog automatisch:

- Vollständige Anforderungs-/Antwortpaare

- Ausführungszeitstempel und Umgebungsdetails

- Leistungskennzahlen

- Unterschied zwischen erwarteten und tatsächlichen Antworten

Dies eliminiert das Hin und Her unvollständiger Fehlerberichte und ermöglicht es Entwicklern, Probleme in Stunden statt Tagen zu beheben.

Häufig gestellte Fragen

F1: Was ist, wenn UAT-Tester zu viele Fehler finden? Sollten wir die Veröffentlichung verzögern?

Antwort: Dies hängt von der Schwere der Fehler ab. Wenn Blocker Kernfunktionen des Geschäfts verhindern, ist eine Verzögerung zwingend erforderlich. Wenn die Probleme geringfügig sind und Workarounds existieren, dokumentieren Sie diese und veröffentlichen Sie mit einer Liste bekannter Probleme. Entscheidend ist die Einschätzung der Geschäftsinteressenten, nicht die technische Schwere.

F2: Wie lange sollte der UAT dauern?

Antwort: Für eine größere Veröffentlichung sind 2-3 Wochen typisch. Bei agilen Sprints sollte der UAT innerhalb des Sprint-Zeitrahmens liegen, oft 2-3 Tage am Sprintende. Die Dauer sollte der Funktionskomplexität und dem Geschäftsrisiko entsprechen.

F3: Kann UAT automatisiert werden?

Antwort: Teilweise. Sie können die Regression von Kern-Workflows automatisieren, aber UAT (Benutzerakzeptanztests) erfordert grundsätzlich menschliches Urteilsvermögen bezüglich der Geschäftstauglichkeit und Benutzerfreundlichkeit. Nutzen Sie Automatisierung zur Unterstützung des UAT, nicht zu dessen Ersatz. Tools wie Apidog automatisieren die API-Validierung, sodass Benutzer sich auf die Workflow-Bewertung konzentrieren können.

F4: Was ist der Unterschied zwischen UAT und Beta-Tests?

Antwort: UAT (Benutzerakzeptanztests) ist ein formeller, interner Test durch Geschäftsinteressenten vor der Veröffentlichung. Beta-Tests umfassen externe, reale Benutzer in produktionsähnlichen Umgebungen, nachdem der UAT abgeschlossen ist. UAT validiert Geschäftsanforderungen; Beta-Tests validieren die Marktreife.

F5: Wer sollte UAT-Testfälle schreiben?

Antwort: Business Analysts und Product Owner sollten diese entwerfen, mit Input von der QA. Tester sollten validieren, dass die Testfälle ausführbar sind und Feedback zur Klarheit geben. Ziel ist die geschäftliche Verantwortung für die Akzeptanzkriterien.

Fazit

Der UAT (Benutzerakzeptanztest) ist der Punkt, an dem Software von "es funktioniert" zu "es liefert Wert" übergeht. Diese abschließende Validierung durch Geschäftsinteressenten ist für erfolgreiche Veröffentlichungen unerlässlich. Der hier vorgestellte Rahmen – richtiges Timing, systematische Ausführung, klare Abgrenzung von anderen Testarten und moderne Tools wie Apidog – verwandelt den UAT von einer reinen Abhake-Aktivität in ein echtes Qualitätstor.

Die erfolgreichsten Teams behandeln den UAT (Benutzerakzeptanztest) nicht als eine Phase, die es schnell zu durchlaufen gilt, sondern als eine kritische Lerngelegenheit. Wenn Geschäftsbenutzer tief involviert sind, entdecken sie Workflow-Verbesserungen, identifizieren Schulungsbedarfe und werden zu Verfechtern der Akzeptanz. Die wenigen Wochen, die in rigorose UATs investiert werden, sparen Monate an nachträglichen Korrekturen und Kopfschmerzen beim Änderungsmanagement.

Beginnen Sie, diese Praktiken in Ihrer nächsten Veröffentlichung umzusetzen. Definieren Sie klare Eintrittskriterien, wählen Sie engagierte Tester aus, erstellen Sie realistische Szenarien und nutzen Sie Tools, die Reibungsverluste beseitigen.