Testen ist ein kritischer Bestandteil der Softwareentwicklung. Es spielt keine Rolle, ob Sie eine kleine Webanwendung oder ein großes verteiltes System entwickeln, das Verständnis der Testarten hilft sicherzustellen, dass Ihr Code zuverlässig, wartbar ist und sowohl funktionale als auch nicht-funktionale Anforderungen erfüllt. In diesem Artikel werden wir die wichtigsten Testarten untersuchen, wann sie eingesetzt werden sollten und wie Tools (wie Apidog) helfen können, insbesondere beim Testen von APIs.

Was ist Softwaretest und warum ist er wichtig?

Softwaretest ist die Praxis der Bewertung von Anwendungen, um Fehler zu identifizieren, korrektes Verhalten zu überprüfen und die Qualität sicherzustellen, bevor Benutzer mit der Software interagieren. Richtiges Testen kann Fehler frühzeitig erkennen, Risiken reduzieren, die Zuverlässigkeit verbessern und letztendlich Kosten und Zeit sparen. Da jedoch ein vollständiger Test praktisch unmöglich ist, ist es entscheidend, die richtige Teststrategie zu wählen und verschiedene Typen zu kombinieren, um Abdeckung und Ressourcen auszugleichen.

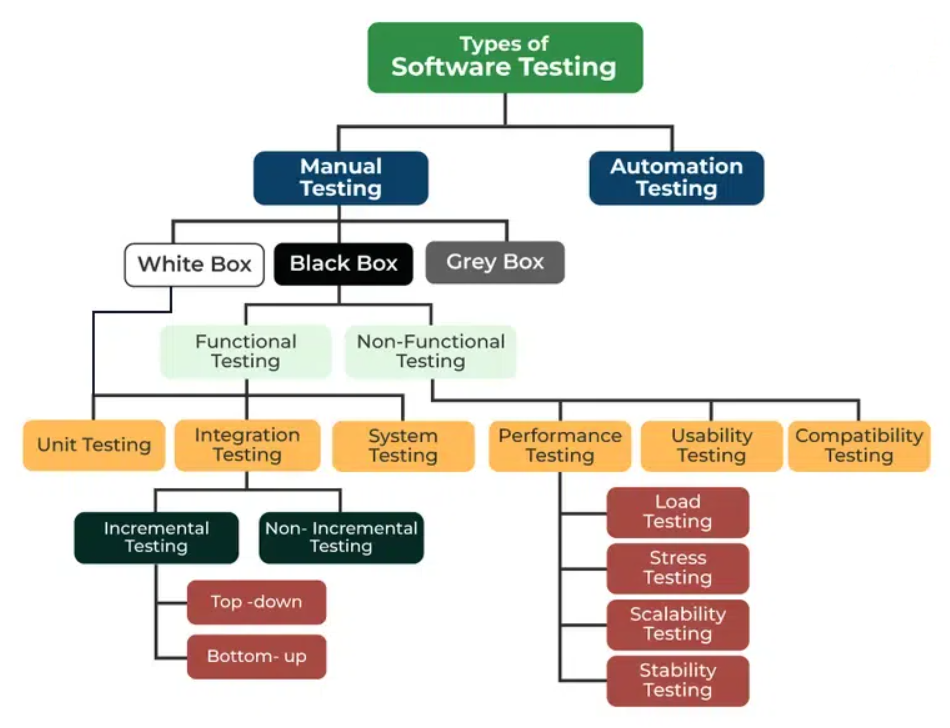

Auf einer hohen Ebene kann Testen in Funktionale Tests – die Überprüfung, ob das System tut, was es soll – und Nicht-funktionale Tests – die Bewertung, wie gut das System funktioniert (Geschwindigkeit, Sicherheit, Benutzerfreundlichkeit usw.) – unterteilt werden.

Innerhalb dieser Gruppen dienen viele spezifische Typen – vom „Komponententest“ bis zum „Leistungstest“ – je nach Entwicklungsphase und -umfang unterschiedlichen Zwecken.

Kernarten des Softwaretests

1. Komponententest (Unit Testing)

Komponententests sind die granularste Testebene: Sie testen einzelne Komponenten, Funktionen oder Methoden isoliert, ohne externe Abhängigkeiten.

- Zweck: Überprüfen, ob jede kleine „Einheit“ des Codes korrekt funktioniert.

- Wann: Üblicherweise während der Entwicklung, durch Entwickler.

- Vorteile: Schnell auszuführen, einfach zu automatisieren, erkennt Fehler frühzeitig – was den Code beim Refactoring oder Aufbau sicherer macht.

Komponententests sind typischerweise automatisiert, und Sie können (und sollten) sie während der Entwicklung viele Male ausführen, um schnelles Feedback zu erhalten.

2. Integrationstest (Integration Testing)

Sobald einzelne Einheiten korrekt funktionieren, überprüft der Integrationstest, ob sie richtig zusammenarbeiten. Er verifiziert Interaktionen zwischen Modulen, Komponenten, Datenbanken, APIs oder Diensten.

- Zweck: Schnittstellen-, Datenfluss- oder Interaktionsprobleme erkennen, die Komponententests möglicherweise übersehen.

- Wann: Nach den Komponententests – oft bevor das System vollständig zusammengebaut ist.

- Vorteile: Hilft sicherzustellen, dass Module korrekt kommunizieren, Daten wie erwartet fließen und das kombinierte Verhalten mit dem Design übereinstimmt.

Da Integrationstests mehr Teile des Systems umfassen, können sie in der Einrichtung oder Ausführung teurer sein als Komponententests – aber sie sind entscheidend, um größere Probleme frühzeitig zu erkennen.

3. Systemtest (System Testing)

Der Systemtest behandelt die Anwendung als Ganzes. Ziel ist es, ein vollständig integriertes System zu testen, um sicherzustellen, dass es sowohl funktionale als auch nicht-funktionale Anforderungen erfüllt.

- Zweck: Bestätigen, dass das gesamte System in einer produktionsähnlichen Umgebung wie erwartet funktioniert.

- Was es abdeckt: Funktionale Korrektheit, Geschäftslogik, grundlegende Leistung und manchmal nicht-funktionale Aspekte wie Benutzerfreundlichkeit oder Sicherheit (abhängig vom Umfang).

- Wann: Nach den Integrationstests, oft durch QA-Teams oder Tester, die den internen Code möglicherweise nicht kennen müssen.

Der Systemtest bietet eine abschließende Überprüfung vor dem Abnahmetest oder der Veröffentlichung.

4. Abnahmetest (Acceptance Testing)

Der Abnahmetest – oft als User Acceptance Testing (UAT) bezeichnet – überprüft, ob das System die Anforderungen und Erwartungen der Stakeholder oder Endbenutzer erfüllt. Dies geschieht normalerweise gegen Ende der Entwicklung, vor der Veröffentlichung.

- Zweck: Sicherstellen, dass die Anwendung die versprochene Funktionalität und das Verhalten aus Benutzer- oder Geschäftsperspektive liefert.

- Wer führt ihn durch: Endbenutzer, Stakeholder oder QA-Teams, die reale Benutzerszenarien simulieren.

- Ergebnis: Bestimmt, ob das Produkt für die Veröffentlichung akzeptabel ist oder Änderungen erfordert.

5. Regressionstest (Regression Testing)

Regressionstests umfassen das erneute Ausführen bestehender Tests nach Änderungen – wie Fehlerbehebungen oder Implementierungen neuer Funktionen – um sicherzustellen, dass die vorhandene Funktionalität nicht negativ beeinflusst wurde.

- Wann: Nach jeder Änderung (Code, Konfiguration, Abhängigkeiten), die das bestehende Verhalten beeinflussen könnte.

- Vorteil: Verhindert „Regressionen“ – unbeabsichtigte Fehler, die durch Updates eingeführt werden.

6. Leistungs- und Lasttest (Performance & Load Testing)

Unter dem Dach der nicht-funktionalen Tests misst der Leistungstest (manchmal aufgeteilt in Last-, Stress-, Volumen- und Dauertests), wie sich das System unter verschiedenen Arbeitslasten verhält. Dies umfasst Antwortzeiten, Parallelitätsverarbeitung, Skalierbarkeit und Stabilität über die Zeit.

- Zweck: Sicherstellen, dass das System die Leistungsanforderungen (Geschwindigkeit, Skalierbarkeit, Stressbewältigung) unter realistischen oder extremen Bedingungen erfüllt.

- Wann: Während der Qualitätssicherung oder vor der Veröffentlichung – insbesondere für Dienste, die viele Benutzer oder eine hohe Last bewältigen müssen.

7. Sicherheitstest (Security Testing)

Sicherheitstests zielen darauf ab, Schwachstellen, Mängel und potenzielle Angriffsvektoren zu identifizieren – und sicherzustellen, dass das System gegen unbefugten Zugriff, Datenlecks und bösartiges Verhalten widerstandsfähig ist. Obwohl nicht immer als eigenständige „Ebene“ kategorisiert, ist er für jedes System, das sensible Daten verarbeitet oder öffentlich zugänglich ist, von entscheidender Bedeutung. Sicherheitstests umfassen oft Penetrationstests, Zugriffskontrolltests und Schwachstellen-Scans.

8. Usability, Kompatibilität und weitere nicht-funktionale Tests

Über Leistung und Sicherheit hinaus kann Software auf Benutzerfreundlichkeit (Usability), Barrierefreiheit, Kompatibilität (über Browser/Geräte/Plattformen hinweg), Wiederherstellung (Fehlertoleranz) und Compliance getestet werden. Diese Testarten gewährleisten breitere Qualitätsaspekte jenseits der Frage „funktioniert es einfach?“.

Testmethoden: Manuell vs. Automatisiert — Black Box, White Box, Gray Box

Testen kann auch danach klassifiziert werden, wie es durchgeführt wird:

- White-Box-Tests: Tests basierend auf interner Programmlogik und -struktur – erfordert internes Codewissen. Oft bei Unit- oder Tests auf niedrigerer Ebene verwendet.

- Black-Box-Tests: Tests basierend auf Ein- / Ausgaben ohne Kenntnis des internen Codes – gut für funktionale, Abnahme- und Systemtests.

- Gray-Box-Tests: Kombiniert beides – Tester kennen einen Teil der internen Struktur, konzentrieren sich aber hauptsächlich auf das Eingabe-/Ausgabe-Verhalten. Nützlich, wenn Sie ein Gleichgewicht zwischen internem Einblick und externer Verhaltensvalidierung wünschen.

Die Automatisierung wird bei Unit-, Integrations-, Regressions- und Leistungstests stark bevorzugt – da sie wiederholt und konsistent ausgeführt werden können. Manuelle Tests spielen weiterhin eine Rolle bei explorativen Tests, Usability-Tests und Abnahmetests, insbesondere bei der Simulation realen Benutzerverhaltens.

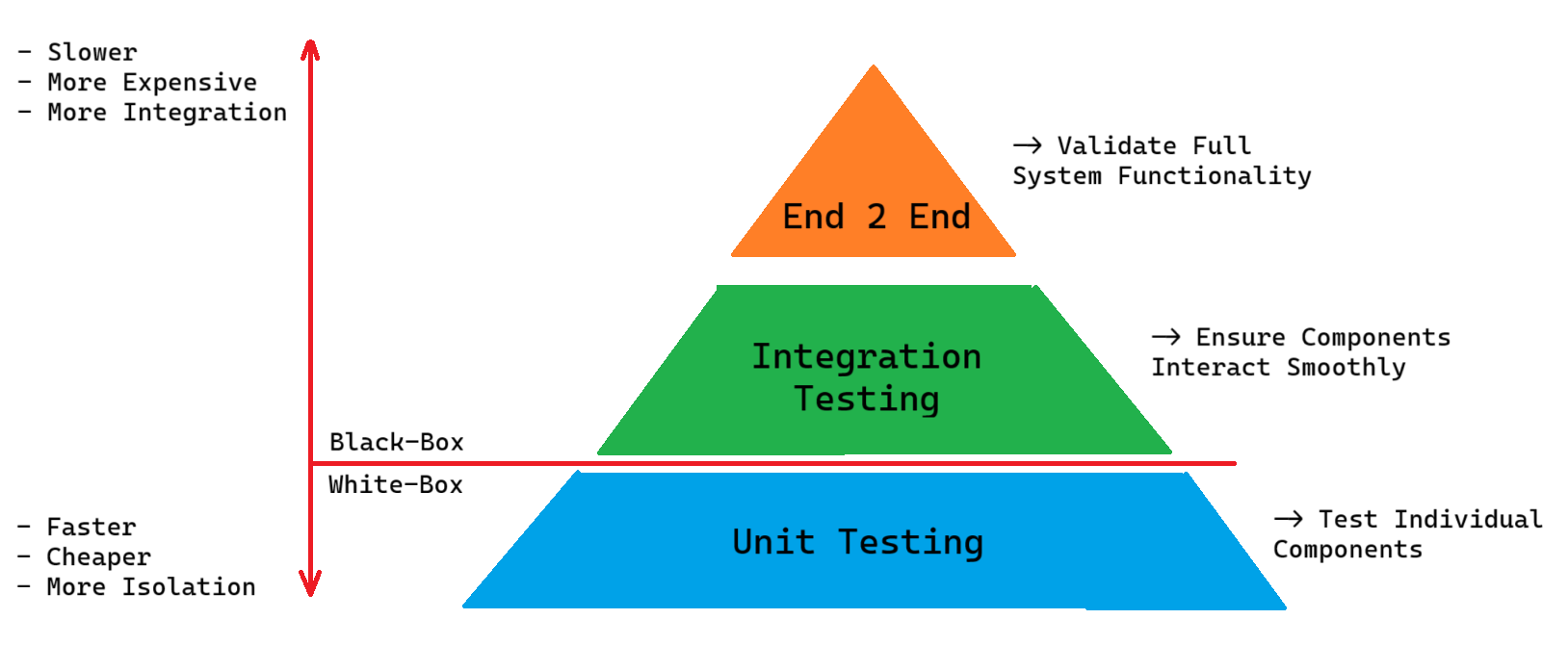

Die Testpyramide: Warum Sie Tests kombinieren sollten

Eine gängige Leitphilosophie ist die Testpyramide: Viele kleine, schnelle Komponententests an der Basis; weniger Integrationstests in der Mitte; und noch weniger vollständige System- oder End-to-End-Tests an der Spitze.

Die Idee: Sie erkennen grundlegende Fehler frühzeitig und kostengünstig (Komponententests), überprüfen Modulinteraktionen (Integration) und verlassen sich auf eine kleine Anzahl hochwertiger Tests mit breitem Umfang (System/E2E) – wodurch Abdeckung, Geschwindigkeit und Wartungsaufwand in Einklang gebracht werden.

Dies hilft, Regressionsrisiken zu reduzieren und die Zuverlässigkeit zu verbessern, während eine Explosion langsamer, anfälliger End-to-End-Tests vermieden wird.

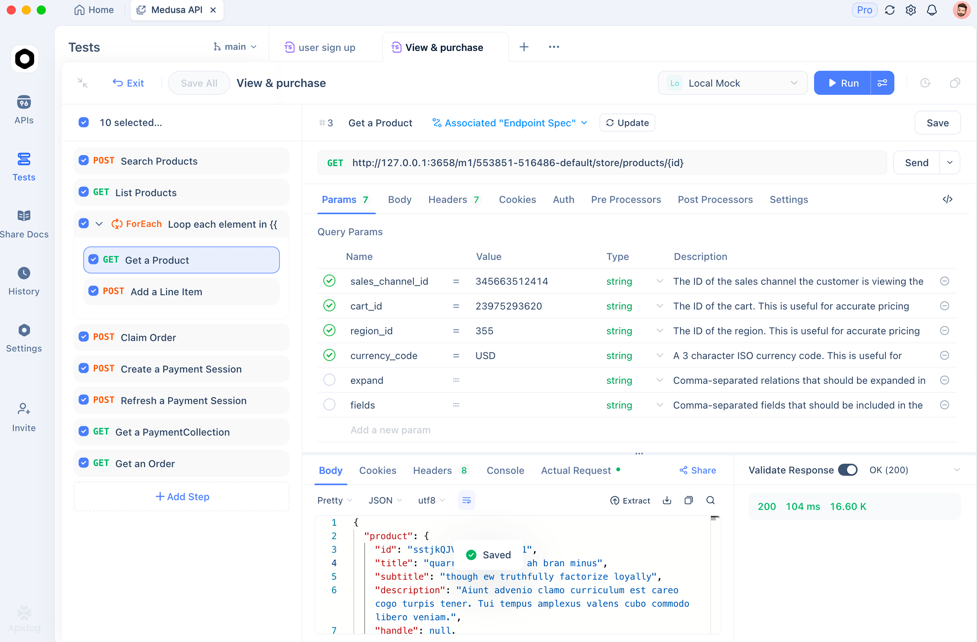

APIs testen – Tools und praktische Ratschläge

Wenn Ihr Projekt APIs (REST, GraphQL usw.) anbietet, wird das Testen besonders wichtig. Sie müssen sicherstellen, dass Endpunkte korrekt funktionieren, Antworten mit Verträgen übereinstimmen, die Fehlerbehandlung funktioniert und Änderungen keine Clients beeinträchtigen.

Hier kommen API-Testtools ins Spiel. Zum Beispiel hilft Apidog – ein API-Tool – Ihnen, Endpunkte zu definieren, Testanfragen zu senden (GET, POST usw.), Antworten zu überprüfen, die Fehlerbehandlung zu testen und die Logik zu validieren – ohne alle Tests manuell schreiben zu müssen. Mit einem solchen Tool können Sie Folgendes durchführen:

- Integrationstests (testen, wie Frontend oder Dienste über APIs interagieren)

- Regressionstests (erneutes Ausführen nach Änderungen, um Fehler zu erkennen)

- Vertrags- oder Schemavalidierung (sicherstellen, dass die API-Spezifikation konsistent bleibt)

Die Kombination traditioneller Testarten (Unit/Integration/System) mit API-spezifischen Tests verbessert das Vertrauen erheblich, insbesondere bei Backend-lastigen oder serviceorientierten Projekten.

Häufig gestellte Fragen

F1. Ist es zwingend erforderlich, alle Testarten für jedes Projekt zu verwenden?

Nicht immer. Die Teststrategie sollte zur Größe, dem Risiko und der Komplexität Ihres Projekts passen. Kleine oder kurzlebige Anwendungen kommen möglicherweise mit Unit- und grundlegenden Integrationstests aus, während große oder kritische Systeme von einer vollständigen Suite (Unit → Integration → System → Leistung/Sicherheit) profitieren.

F2. Was ist der Hauptunterschied zwischen Unit-Tests und Integrationstests?

Unit-Tests prüfen einzelne Komponenten isoliert, ohne externe Abhängigkeiten. Integrationstests verifizieren, dass mehrere Komponenten oder Module nach der Integration korrekt zusammenarbeiten (z.B. Frontend ↔ API ↔ Datenbank).

F3. Wann sollte ich Regressionstests durchführen?

Nach jeder Codeänderung – neuen Funktionen, Fehlerbehebungen, Refactoring. Regressionstests stellen sicher, dass die vorhandene Funktionalität weiterhin wie erwartet funktioniert und verhindern, dass „Fehler“ unbemerkt eingeschleppt werden.

F4. Was ist der Vorteil von automatisierten Tests gegenüber manuellen Tests?

Automatisierte Tests (Unit, Integration, Regression, Performance) sind wiederholbar, schnell und weniger fehleranfällig als manuelle Tests. Sie skalieren gut, wenn sich der Code weiterentwickelt. Manuelle Tests bleiben nützlich für Usability-, explorative und User-Experience-Aspekte.

F5. Können Black-Box-Tests alle Arten von Fehlern erkennen?

Nein – Black-Box-Tests konzentrieren sich ausschließlich auf Eingaben und Ausgaben, ohne interne Kenntnisse. Sie sind effektiv für funktionales oder systemweites Verhalten, können jedoch keine interne Abdeckung (wie Codezweige, Logikpfade oder interne Sicherheitsprobleme) garantieren – dafür können White-Box- oder hybride Tests erforderlich sein.

Fazit

Das Verständnis der Testarten ist entscheidend für den Aufbau zuverlässiger, wartbarer Software. Durch die Kombination verschiedener Testarten – Unit, Integration, System, Performance, Sicherheit, Regression – bauen Sie Sicherheitsebenen auf, erkennen Fehler frühzeitig und stellen sicher, dass das Softwareverhalten über die Zeit korrekt bleibt.

Für moderne Webanwendungen oder Dienste, insbesondere solche, die APIs exponieren, bietet die Kombination von Standard-Softwaretestpraktiken mit API-fokussierten Tools (wie Apidog) eine starke Grundlage für Qualität, Skalierbarkeit und reibungslose Veröffentlichungen.

Letztendlich gibt es keine „Einheitslösung“ für Teststrategien – aber die Kenntnis Ihrer Optionen, ihrer Kompromisse und deren Anwendung hilft Ihnen, einen Testansatz zu entwickeln, der zu Ihrem Projekt, Ihrem Team und Ihren Zielen passt.