Das Modellkontextprotokoll (MCP) ist ein offener Standard, der entwickelt wurde, um eine gemeinsame Sprache zwischen Anwendungen von Großen Sprachmodellen (LLM) und externen Diensten zu schaffen. Es etabliert eine standardisierte Methode, mit der ein KI-Modell Werkzeuge entdecken und mit ihnen interagieren, auf Daten zugreifen und vordefinierte Prompts verwenden kann, unabhängig davon, wie das Modell oder die externen Dienste aufgebaut sind.

Im Kern ermöglicht MCP einer Anwendung, bekannt als „MCP-Client“, die Verbindung zu einem oder mehreren „MCP-Servern“. Diese Server stellen Fähigkeiten bereit, die das LLM dann nutzen kann. Dies entkoppelt die Kernlogik der KI von den spezifischen Implementierungen der von ihr verwendeten Werkzeuge, wodurch KI-Systeme modularer, skalierbarer und interoperabler werden.

Das Protokoll definiert verschiedene Arten von Funktionen, die ein Server anbieten kann. Ein MCP-Client kann je nach seinem Zweck einige oder alle dieser Funktionen unterstützen. Das Verständnis dieser Funktionen ist entscheidend, um zu erfassen, was eine MCP-Integration ermöglicht.

| Funktion | Beschreibung |

|---|---|

| Tools | Ausführbare Funktionen, die ein LLM aufrufen kann, um Aktionen durchzuführen. |

| Prompts | Vordefinierte Vorlagen zur Strukturierung von Interaktionen mit dem LLM. |

| Resources | Vom Server bereitgestellte Daten und Inhalte, die ein LLM lesen kann. |

| Discovery | Die Möglichkeit, benachrichtigt zu werden, wenn sich die Fähigkeiten eines Servers ändern. |

| Instructions | Vom Server bereitgestellte Anleitung, wie sich das LLM verhalten soll. |

| Sampling | Vom Server initiierte LLM-Vervollständigungen und Parameter-Vorschläge. |

| Roots | Definitionen von Dateisystemgrenzen für die Operationen des LLM. |

| Elicitation | Ein Mechanismus für den Server, um Informationen vom Benutzer anzufordern. |

| Tasks | Eine Möglichkeit, den Status von langlaufenden Operationen zu verfolgen. |

| Apps | Interaktive HTML-Oberflächen, die vom Server bereitgestellt werden. |

Durch die Unterstützung dieser Funktionen können verschiedene Anwendungen dieselben externen Werkzeuge und Datenquellen konsistent nutzen und so ein reichhaltigeres Ökosystem miteinander verbundener KI-Dienste fördern.

Ein Leitfaden für MCP-Clients

Ein MCP-Client ist jede Anwendung, die sich mit einem MCP-Server verbinden kann, um die von ihm bereitgestellten Funktionen zu nutzen. Diese Clients fungieren als Brücke zwischen dem Benutzer, dem LLM und der weiten Welt externer Fähigkeiten. Sie können von entwicklerorientierten Werkzeugen wie Code-Editoren und Befehlszeilenschnittstellen bis hin zu benutzerfreundlichen Desktop-Anwendungen und No-Code-Plattformen reichen.

Die Hauptfunktion eines Clients besteht darin, die Verbindung zu einem oder mehreren MCP-Servern zu verwalten und die entdeckten Tools, Prompts und Resources in seine eigene Benutzererfahrung zu integrieren. Beispielsweise könnte ein Codierungsassistent MCP verwenden, um ein Tool zu finden und auszuführen, das Tests durchführt, während ein Chatbot es verwenden könnte, um Daten aus der internen Wissensdatenbank eines Unternehmens über eine Resource abzurufen.

Das Wachstum des MCP-Ökosystems hat zu einer vielfältigen Palette von Clients geführt, die jeweils auf unterschiedliche Workflows und Anwendungsfälle zugeschnitten sind. Die Untersuchung einiger der Top-Clients kann ein klareres Bild davon vermitteln, wie dieses Protokoll in der Praxis implementiert wird, um leistungsfähigere und kontextsensitivere KI-Anwendungen zu erstellen.

Top 10 MCP-Clients

Die folgenden Clients demonstrieren die Breite der MCP-Adoption, von weit verbreiteten kommerziellen Produkten bis hin zu innovativen Open-Source-Projekten. Jeder bietet eine einzigartige Möglichkeit, mit dem wachsenden Ökosystem der MCP-Server zu interagieren.

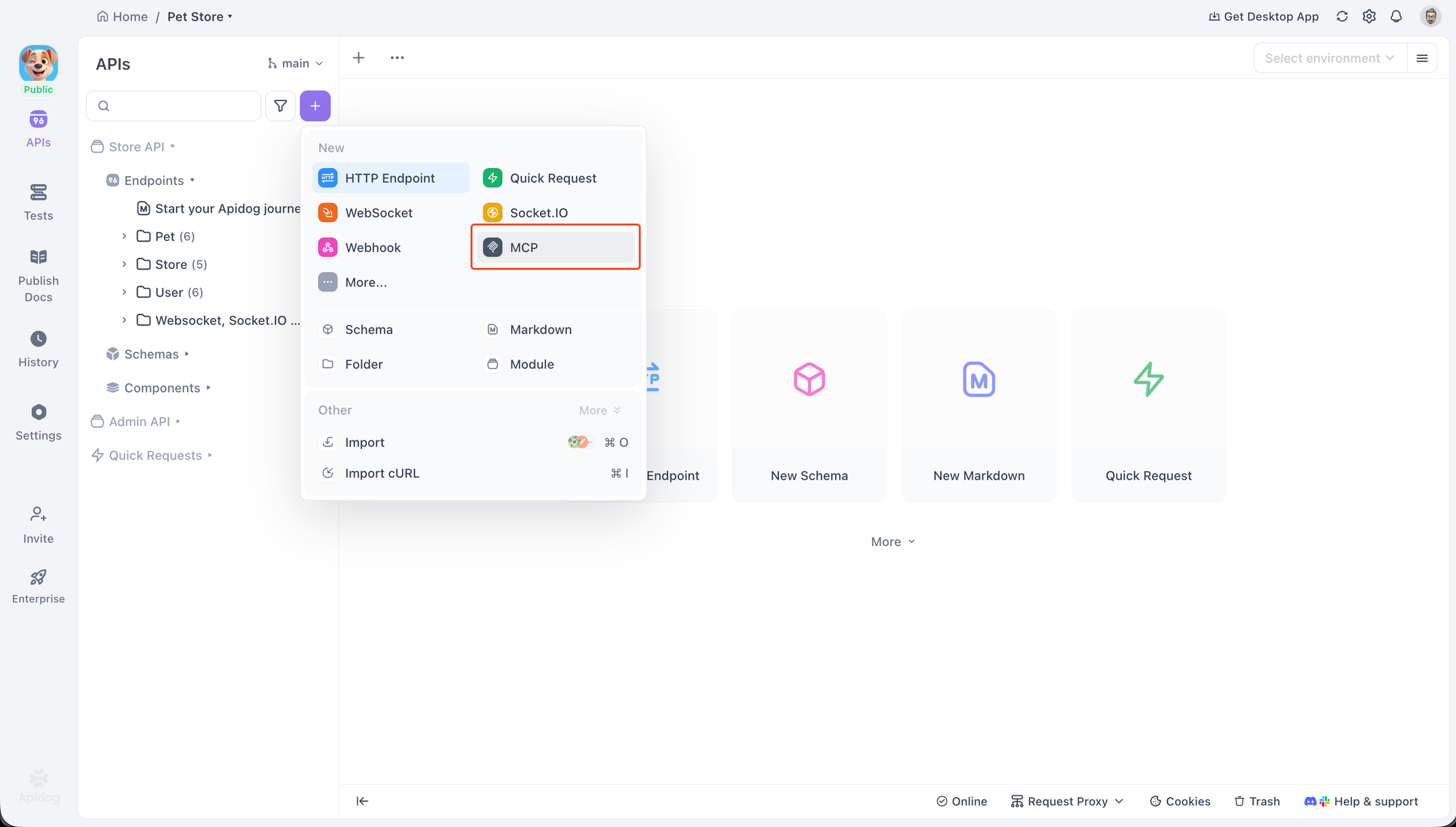

Apidog MCP-Client

Apidog ist eine umfassende API-Entwicklungsplattform, die einen integrierten MCP-Client zum Debuggen und Testen von MCP-Servern enthält. Dies macht es zu einem hervorragenden Werkzeug für Entwickler, die mit MCP arbeiten oder es integrieren, da es eine dedizierte Schnittstelle für die Interaktion mit allen wichtigen MCP-Funktionen bietet.

Der Client unterstützt zwei Haupttransportmethoden für die Verbindung zu Servern: STDIO für lokale Prozesse und HTTP für Remote-Server. Diese Flexibilität ermöglicht es Entwicklern, eine Vielzahl von Serverkonfigurationen zu testen.

Um zu beginnen, kann eine neue MCP-Anfrage innerhalb eines Apidog-Projekts erstellt werden. Die Verbindung zu einem Server ist unkompliziert. Man kann einfach einen Befehl einfügen, der zum Starten eines lokalen Servers verwendet wird. Um sich beispielsweise mit einem Beispielserver zu verbinden, könnten Sie einen Befehl wie diesen verwenden:

npx -y @modelcontextprotocol/server-everything

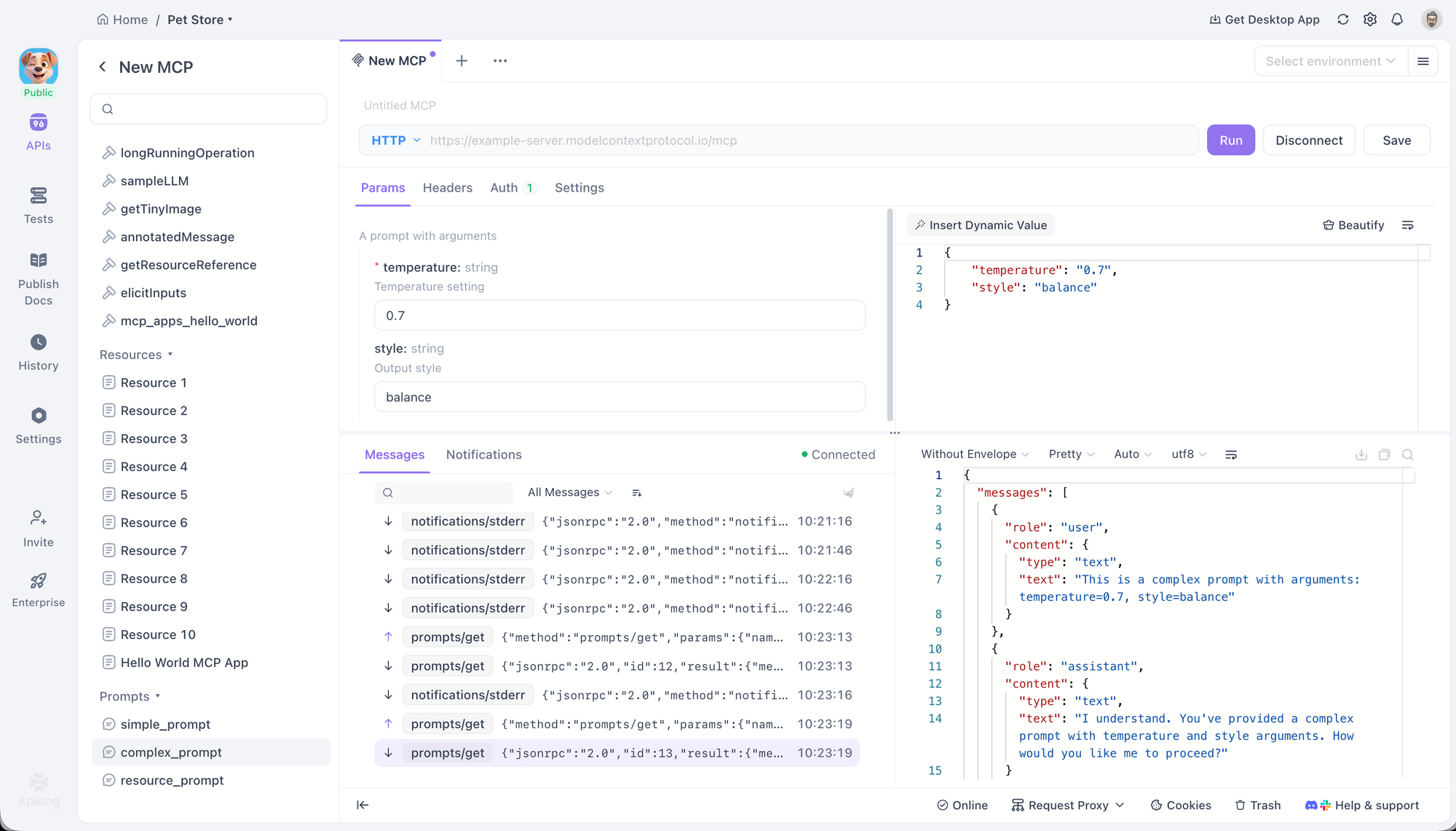

Apidog erkennt dies als Befehl, wählt automatisch das STDIO-Protokoll aus und fordert vor dem Starten des lokalen Prozesses eine Sicherheitsbestätigung an. Für Remote-Server wechselt das Einfügen einer URL das Protokoll auf HTTP.

Nach der Verbindung zeigt Apidog eine Verzeichnisstruktur aller vom Server bereitgestellten Tools, Prompts und Resources an. Dies ermöglicht eine direkte Interaktion und Fehlersuche. Benutzer können ein Tool auswählen, dessen Parameter über ein Formular oder einen JSON-Editor ausfüllen und es ausführen, um die Antwort zu sehen. Ebenso können Prompts ausgeführt werden, um die generierte Ausgabe anzuzeigen, und Resources können abgerufen werden, um deren Inhalt zu überprüfen.

Der Client bietet auch erweiterte Konfigurationsoptionen. Für HTTP-Verbindungen unterstützt er verschiedene Authentifizierungsmethoden, einschließlich OAuth 2.0, API-Schlüssel und Bearer-Token, und kann den OAuth 2.0-Fluss automatisch handhaben. Benutzerdefinierte Header und Umgebungsvariablen können ebenfalls festgelegt werden, mit vollständiger Unterstützung für Apidogs Variablesystem.

ChatGPT

Als OpenAIs Flaggschiff-KI-Assistent ist die Integration von MCP in ChatGPT ein bedeutender Indikator für die wachsende Bedeutung des Protokolls. Es unterstützt die Verbindung zu Remote-MCP-Servern, wodurch es externe Tools für die Durchführung fundierter Recherchen und den Zugriff auf spezialisierte Funktionen nutzen kann.

Die Integration wird über die Verbindungs-Benutzeroberfläche in den Einstellungen von ChatGPT verwaltet. Sobald ein Server konfiguriert ist, werden seine Tools dem Modell zur Verfügung gestellt. Dies ermöglicht es ChatGPT, über seine integrierten Funktionen hinauszugehen und Tools von konfigurierten Servern zu verwenden, um Aufgaben wie die Suche in proprietären Datenbanken oder die Interaktion mit APIs von Drittanbietern auf standardisierte Weise auszuführen. Diese Unterstützung ist besonders wertvoll in Unternehmensumgebungen, in denen Sicherheit und Compliance von größter Bedeutung sind.

Das Claude-Ökosystem

Anthropic hat MCP tief integriert in seine Produktsuite, einschließlich seines Web-Assistenten claude.ai, der Claude Desktop App und des agentenhaften Codierungs-Tools Claude Code. Diese vielfältige Unterstützung zeigt verschiedene Aspekte des MCP-Standards.

claude.ai unterstützt Remote-MCP-Server, wodurch Webbenutzer ihre Claude-Konversationen mit externen Tools, Prompts und Ressourcen verbinden können.

Die Claude Desktop App geht noch weiter, indem sie Verbindungen zu lokalen Servern ermöglicht, was die Privatsphäre und Sicherheit verbessert, indem Daten auf dem Rechner des Benutzers verbleiben. Sie bietet volle Unterstützung für Resources, Prompts, Tools und sogar interaktive Apps.

Claude Code ist ein leistungsstarkes Beispiel für eine bidirektionale Integration. Es fungiert als MCP-Client, der Tools, Prompts und Resources von anderen Servern nutzt, um seine Codierungsaufgaben zu unterstützen. Gleichzeitig fungiert es auch als MCP-Server, der seine eigenen Fähigkeiten anderen MCP-Clients zur Verfügung stellt.

GitHub Copilot Codierungsagent

GitHub Copilot, der am weitesten verbreitete KI-Codierungsassistent, nutzt MCP, um seinen Kontext und seine Fähigkeiten zu erweitern. Der Copilot Codierungsagent kann Aufgaben delegieren und mit lokalen sowie Remote-MCP-Servern interagieren, um externe Tools zu nutzen.

Diese Integration ermöglicht es Entwicklern, Copilot an ihre spezifischen Projektanforderungen anzupassen. Zum Beispiel kann ein Entwickler Copilot mit einem internen MCP-Server verbinden, der Tools für die Interaktion mit einem proprietären Build-System oder einer projektspezifischen Datenbank bereitstellt. Dies erweitert das Bewusstsein von Copilot über den Code selbst hinaus und ermöglicht es ihm, komplexere und kontextsensitivere Entwicklungsaufgaben auszuführen.

Cursor

Cursor ist ein KI-zentrierter Code-Editor, der von Grund auf für die KI-gestützte Entwicklung konzipiert wurde. Seine native Unterstützung für MCP ist ein Kernbestandteil seiner Architektur und ermöglicht eine tiefe Integration in den Workflow eines Entwicklers.

Der Editor unterstützt MCP-Tools über seine Composer-Funktion, wodurch Benutzer externe Funktionen direkt beim Codieren aufrufen können. Er unterstützt auch Prompts, Roots und Elicitation, was komplexere, interaktive Sitzungen mit Servern ermöglicht. Cursor kann sich über STDIO und SSE mit Servern verbinden und bietet so Flexibilität für lokale und Remote-Toolsets.

LM Studio

LM Studio ist eine beliebte Desktop-Anwendung, die es einfach macht, Open-Source-LLMs lokal zu entdecken, herunterzuladen und auszuführen. Ihr wesentlicher Beitrag zum MCP-Ökosystem ist ihre Fähigkeit, diese lokalen Modelle mit MCP-Servern zu verbinden.

Dies überbrückt die Lücke zwischen der Welt der Open-Source-Modelle und der standardisierten Tool-Nutzung durch MCP. Benutzer können Serverkonfigurationen zu einer lokalen mcp.json-Datei hinzufügen, um loszulegen. Ein herausragendes Merkmal ist die Benutzeroberfläche zur Tool-Bestätigung, die den Benutzer um Genehmigung bittet, bevor ein lokales Modell einen Tool-Aufruf ausführen darf, was eine wichtige Ebene der Sicherheit und Kontrolle bietet.

Amazon Q

Amazons KI-gestützter Assistent, Amazon Q, hat MCP sowohl in seinen Kommandozeilen- (Amazon Q CLI) als auch in seinen IDE-Versionen (Amazon Q IDE) übernommen. Dies zeigt den Nutzen des Protokolls in professionellen Entwicklungsumgebungen zur Verwaltung von Cloud-Infrastrukturen und zur Rationalisierung von Codierungsaufgaben.

Die Amazon Q CLI ist ein agentenhafter Codierungsassistent für das Terminal, der volle Unterstützung für MCP-Server bietet. Sie ermöglicht Benutzern den direkten Zugriff auf Tools und gespeicherte Prompts über ihre Kommandozeile.

Die Amazon Q IDE, verfügbar für große IDEs wie VS Code und JetBrains, bringt ähnliche Funktionen in eine grafische Oberfläche. Sie ermöglicht Benutzern die Kontrolle und Organisation von AWS-Ressourcen sowie die Verwaltung von Berechtigungen für jedes MCP-Tool über die Benutzeroberfläche der IDE, wodurch eine granulare Kontrolle über die Fähigkeiten des Assistenten geboten wird.

AIQL TUUI

AIQL TUUI ist eine kostenlose und quelloffene Desktop-KI-Chat-Anwendung, die sich durch ihre umfassende Unterstützung des MCP-Standards und ihre plattformübergreifende Natur auszeichnet. Sie funktioniert auf macOS, Windows und Linux und unterstützt eine breite Palette von KI-Anbietern und lokalen Modellen.

Seine MCP-Integration ist umfassend und deckt Resources, Prompts, Tools, Discovery, Sampling und Elicitation ab. Dies ermöglicht eine reichhaltige, interaktive Erfahrung, bei der Benutzer nahtlos zwischen verschiedenen LLMs und Agenten wechseln können. Die Anwendung bietet erweiterte Kontrolle über Sampling-Parameter und ermöglicht die Anpassung von Tools, was sie zu einer leistungsstarken Wahl für fortgeschrittene Benutzer und Entwickler macht, die einen hochgradig konfigurierbaren Client wünschen.

Langflow

Langflow ist ein quelloffener visueller Builder zur Erstellung von KI-Anwendungen. Seine einzigartige Position im MCP-Ökosystem ist seine Doppelrolle als Client und Server, die durch eine grafische, flussbasierte Oberfläche ermöglicht wird.

Als MCP-Client kann Langflow Tools von jedem MCP-Server verwenden, um Agenten und Workflows zu erstellen. Dies ermöglicht es Benutzern, Knoten, die MCP-Tools darstellen, per Drag-and-Drop in ihre Abläufe zu ziehen, wodurch komplexe Integrationen leichter zugänglich werden.

Umgekehrt können Benutzer ihre erstellten Agenten und Flows auch als vollständigen MCP-Server exportieren. Diese leistungsstarke Funktion ermöglicht es Entwicklern, einen Satz von Tools visuell zu prototypisieren und diese dann anderen MCP-Clients zur Verfügung zu stellen, wodurch die Hürde für die Erstellung und gemeinsame Nutzung benutzerdefinierter KI-Funktionen erheblich gesenkt wird.

AgenticFlow

AgenticFlow richtet sich an ein anderes Publikum, indem es eine No-Code-KI-Plattform zum Erstellen von Agenten bereitstellt, die Vertriebs-, Marketing- und kreative Aufgaben übernehmen. Es verwendet MCP als zugrunde liegendes Protokoll, um sich sicher mit einer riesigen Bibliothek von über 10.000 Tools und 2.500 APIs zu verbinden.

Die Plattform vereinfacht den Prozess der Verbindung zu einem MCP-Server auf wenige Schritte und abstrahiert die technischen Details. Dies ermöglicht es Nicht-Entwicklern, leistungsstarke KI-Agenten zu erstellen, die mit einer Vielzahl externer Dienste interagieren können. Benutzer können ihre Verbindungen sicher verwalten und den Zugriff jederzeit widerrufen, was es zu einem sicheren und zugänglichen Einstiegspunkt in die Welt der KI-Tool-Nutzung macht.

Fazit

Das Modellkontextprotokoll entwickelt sich schnell zu einer grundlegenden Schicht dafür, wie KI-Systeme mit der Außenwelt interagieren. Indem es die Art und Weise standardisiert, wie LLMs Tools, Prompts und Datenquellen entdecken und nutzen, eliminiert MCP die enge Kopplung zwischen Modellen und Diensten und ersetzt sie durch eine saubere, modulare und interoperable Architektur. Diese Verschiebung macht KI-Anwendungen einfacher erweiterbar, sicherer im Betrieb und wesentlich anpassungsfähiger an reale Workflows.

Wie die wachsende Liste der MCP-Clients zeigt, wird das Protokoll bereits in einem breiten Spektrum von Anwendungsfällen eingesetzt – von Entwickler-Tools wie Apidog, Cursor und GitHub Copilot über Unternehmensassistenten wie ChatGPT und Amazon Q bis hin zu No-Code-Plattformen wie Langflow und AgenticFlow. Jeder Client wendet MCP anders an, aber alle profitieren vom selben Kernversprechen: Wiederverwendbarkeit, Flexibilität und konsistente Tool-Integration.

Mit Blick auf die Zukunft liegt der wahre Wert von MCP in dem Ökosystem, das es ermöglicht. Da immer mehr Server hochwertige Tools bereitstellen und mehr Clients das Protokoll übernehmen, gewinnen Entwickler und Benutzer gleichermaßen die Freiheit, Modelle, Tools und Workflows zu mischen, ohne Integrationen von Grund auf neu aufbauen zu müssen. Ob Sie einen MCP-Server debuggen, einen agentenhaften Codierungsassistenten erstellen oder KI-Workflows visuell entwerfen – MCP bietet eine gemeinsame Basis, die Innovation skalieren lässt.