Stellen Sie sich vor: Sie stecken knietief in einem Coding-Marathon, füttern Ihren KI-Kumpel mit einer riesigen Codebasis zur Refaktorierung, und plötzlich – bumm – verschluckt er sich an „Token-Limit überschritten“. Kommt Ihnen das bekannt vor? Wenn Sie **Codex**, OpenAIs elegantes Coding-Tool, nutzen, können sich diese **Codex-Token-Limits** wie ein Stimmungskiller mitten im Arbeitsfluss anfühlen. Aber fürchten Sie sich nicht, lieber Entwickler – das ist kein harter Stopp; es ist eine Einladung, intelligenter mit Ihren Prompts umzugehen. Ab September 2025 bietet **Codex** (angetrieben von Modellen wie GPT-5-Codex) großzügige Token-Fenster, die alles von schnellen Korrekturen bis hin zu Mono-Repo-Überarbeitungen bewältigen. In dieser lockeren Aufschlüsselung werden wir erläutern, was diese **Codex-Token-Limits** wirklich bedeuten, wie Sie das Maximum aus ihnen herausholen und Tipps zur Steigerung Ihrer Nutzung geben. Egal, ob Sie ein Einzelkämpfer oder Teamleiter sind, die Beherrschung dessen hält Ihre KI-Sitzungen am Laufen. Lassen Sie uns die Tokens entschlüsseln und Ihr **Codex**-Spiel auf die nächste Stufe heben!

Möchten Sie eine integrierte All-in-One-Plattform, damit Ihr Entwicklerteam mit maximaler Produktivität zusammenarbeiten kann?

Apidog erfüllt all Ihre Anforderungen und ersetzt Postman zu einem viel günstigeren Preis!

Codex-Token-Limits entmystifizieren: Das Zahlenspiel

Im Kern drehen sich die **Codex-Token-Limits** um das Kontextfenster – den gesamten „Denkraum“, den Ihre Anfrage einnehmen kann. Im Gegensatz zu älteren Modellen, die auf 4K oder 8K Tokens begrenzt waren, bietet **Codex** – im Mai 2025 eingeführt und mit codex-1 aufgerüstet – eine enorme Kontextlänge von 192.000 Tokens. Das reicht aus, um ein mittelgroßes Repository (denken Sie an etwa 50.000 Zeilen Code) zu verarbeiten und gleichzeitig Platz für Ihren Prompt, die Historie und die Ausgabe zu lassen. Eingabe-Tokens (Ihr Code + Anweisungen) erreichen maximal etwa 150K, wobei die Ausgabe auf 42K begrenzt ist, um Antworten schnell zu halten – was insgesamt diesen 192K „Sweet Spot“ ergibt.

Warum so geräumig? **Codex** ist für die reale Technik gemacht: Eine alte Anwendung debuggen? Werfen Sie das gesamte Modul hinein. Eine Funktion entwickeln? Fügen Sie Spezifikationen, Abhängigkeiten und Tests ohne Kürzungen hinzu. Die Variante codex-mini-latest reduziert dies auf 128K für leichtere Aufgaben (Code-Q&A, schnelle Bearbeitungen), aber der volle codex-1 glänzt bei schweren Aufgaben. Pro-Nachricht-Limits sind an Ihren Plan gebunden – Plus-Benutzer erhalten 30-150 Nachrichten/5 Stunden, aber jede kann bei Komplexität bis zu 192K verbrauchen. Es gibt keine harte Obergrenze pro Anfrage über das Fenster hinaus; es geht mehr um die Gesamtnutzung, um Serverausfälle zu verhindern.

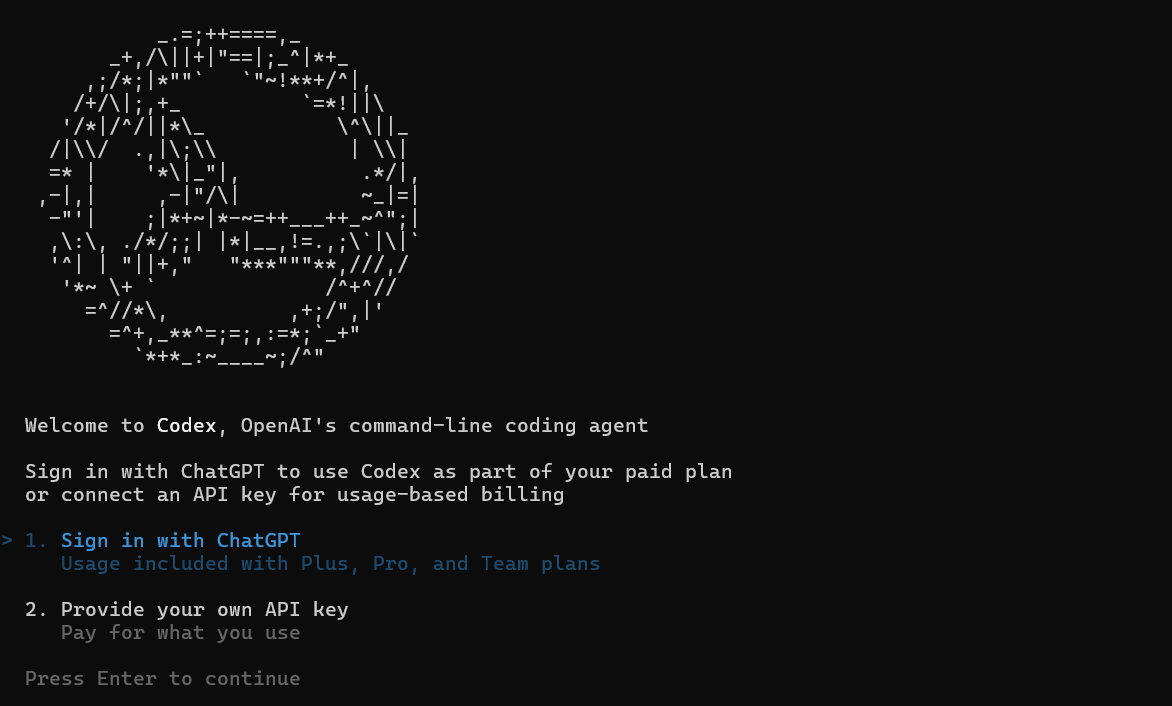

Diese Limits sind nicht statisch – OpenAI iteriert basierend auf Feedback. Frühe Vorschauen von 2025 waren zum Testen „unbegrenzt“, aber jetzt sind sie für Nachhaltigkeit gestaffelt. Für API-Benutzer gilt die Bezahlung pro Token: 1,50 $ / 1 Mio. Eingabe, 6 $ / 1 Mio. Ausgabe bei codex-mini, mit 75 % Caching-Rabatten für Wiederholungen. Fazit: **Codex-Token-Limits** sind für die meisten Entwickler großzügig, aber geschicktes Prompting verwandelt sie in Superkräfte.

So nutzen Sie die Codex-Token-Limits optimal: Maximieren Sie Ihr Fenster

Diese 192K-Grenze erreichen? Nein, mit cleveren Strategien werden Sie sie selten berühren – und wenn doch, werden Sie es lieben. Der Schlüssel zur Beherrschung der **Codex-Token-Limits** ist, sie wie RAM zu behandeln: Laden Sie das Wichtige, entfernen Sie unnötigen Ballast und iterieren Sie effizient.

Zuerst, klug chunking: Bei großen Codebasen fassen Sie nicht-essentielle Dateien zusammen („Hier ist utils.py; konzentrieren Sie sich auf die Authentifizierungslogik“), um Tokens für kritische Pfade freizugeben. Tools wie Git-Diff oder selektive Uploads reduzieren die Eingaben um 50 %, ohne den Kontext zu verlieren. In der CLI verwenden Sie --context-file, um Zusammenfassungen vorzuladen und Ihren Prompt schlank zu halten.

Caching nutzen: Wiederkehrende Muster? OpenAIs 75% Rabatt auf gecachte Prompts bedeutet, dass die Neuerstellung einer Boilerplate-Testsuite fast nichts kostet. Prompen Sie einmal mit vollem Kontext und verweisen Sie dann darauf: „Bauen Sie auf dem vorherigen Auth-Refactoring auf.“ Dies verbindet Sitzungen, ohne alles neu zu laden, und dehnt Ihr Fenster über Marathons hinweg.

Multimodal vorgehen: GPT-5-Codex verarbeitet Bilder (Screenshots von Fehlern) ohne Token-Verbrauch – beschreiben Sie einen UI-Bug visuell und sparen Sie so Textballast. Für Ausgaben setzen Sie --max-output 10K, um sich auf Korrekturen zu konzentrieren, nicht auf Aufsätze.

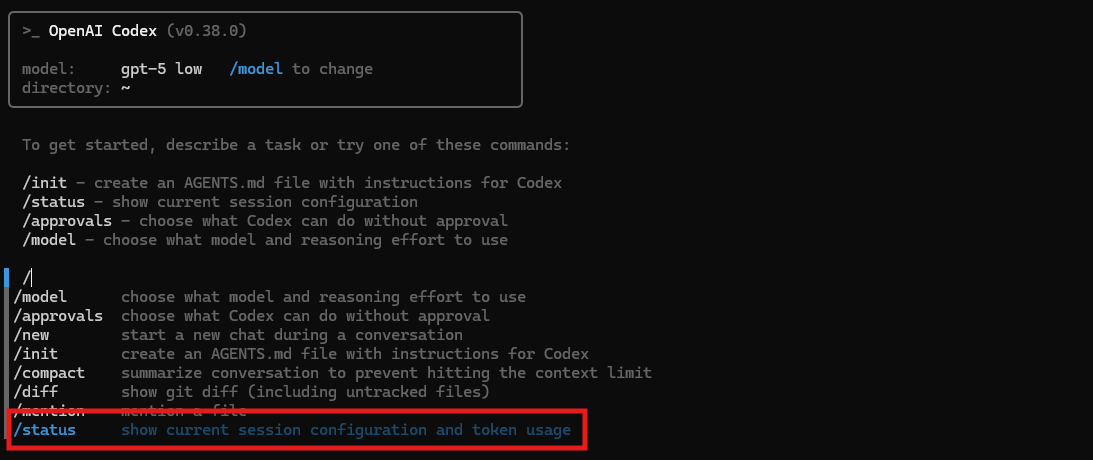

Überwachen Sie wie ein Falke: Das CLI-Dashboard zeigt den Echtzeitverbrauch an (z.B. 486K verbraucht, 32% Kontext übrig). Stellen Sie Warnungen für 80% ein – pausieren Sie, fassen Sie den Fortschritt in AGENTS.md zusammen und fahren Sie fort. Pro-Benutzer erhalten eine feinere Granularität und erkennen Token-Fresser wie ausführliche Begründungen.

Sonderfälle? Monorepos: Verwenden Sie Vektorsuche, um relevante Chunks dynamisch abzurufen und jeweils nur 20K zu speisen. Dieses dynamische Laden umgeht statische Limits, ideal für die Ausbreitung in Unternehmen. Das Ergebnis? Aufgaben, die ältere Modelle überfordern würden, laufen reibungslos, wobei Entwickler einen 3-fachen Durchsatz melden.

Die besten Wege, Codex zu nutzen: Jenseits der Limits

**Codex-Token-Limits** sind nur die Leinwand – wahre Meisterschaft entsteht, wenn man sie wie ein Schweizer Taschenmesser für das Entwicklerleben einsetzt. Beginnen Sie mit der CLI für Terminal-Krieger: `codex debug app.py --context 50K` nimmt die Hälfte Ihres Limits für gezielte Korrekturen auf und gibt PR-Diffs aus. Kombinieren Sie dies mit der VS Code-Erweiterung für Inline-Vorschläge – fahren Sie über eine Funktion, klicken Sie auf „Test with Codex“, und es generiert Testsuiten innerhalb von 10K Tokens.

Für Teams delegieren: Weisen Sie Agenten über den Cloud-Modus (nahezu unbegrenzt für Bursts) für parallele Aufgaben zu – einer debuggt das Frontend (20K Tokens), ein anderer das Backend (separates Fenster). Integrieren Sie MCP für den Kontextübergabe: Übergeben Sie einen zusammengefassten Zustand zwischen Agenten, um Neuladungen zu minimieren.

Prompt Engineering steigert die Nutzung: „Priorisieren Sie Effizienz: Erklären Sie die Korrektur in 500 Tokens, Code in 2K.“ Dies holt den Wert aus den Ausgaben heraus. Verketten Sie mit Tools – verwenden Sie die Dateisuche, um Snippets (5K Tokens) abzurufen, speisen Sie diese in den Interpreter zur Ausführung (keine zusätzlichen Kosten) und verfeinern Sie dann.

Unternehmen? Benutzerdefinierte Limits über Credits ermöglichen Bursts von über 500K pro Aufgabe, perfekt für Migrationen. Kostenlose Stufe? Bleiben Sie beim Mini-Modell für 128K-Grundlagen und rüsten Sie auf, wenn Sie begeistert sind.

Fallstricke? Überladene Prompts blähen die Eingaben auf – halten Sie sie modular. Überprüfen Sie immer die Ausgaben; gesparte Tokens bei Halluzinationen sind besser als verschwendete Wiederholungen.

Fazit: Tokens sind Ihr Verbündeter, nicht Ihr Feind

**Codex-Token-Limits** – dieses 192K-Kraftpaket – sind keine Barrieren; sie sind Blaupausen für effizientes Genie. Durch Chunking, Caching und Chaining verwandeln Sie Einschränkungen in Kreativität und machen **Codex** zu Ihrem ultimativen Co-Piloten. Egal ob CLI-Sprints oder IDE-Marathons, optimieren Sie rücksichtslos und beobachten Sie, wie die Produktivität steigt. Haben Sie einen Token-Spar-Trick? Teilen Sie ihn auf jeder Entwicklerplattform – lassen Sie uns die Limits gemeinsam knacken!