Haben Sie sich jemals gefragt, wie moderne Apps mühelos skalieren, ohne dass Sie einen einzigen Server verwalten müssen? Das ist die Magie von **serverlosen APIs** – ein Wendepunkt im Cloud Computing, der die Art und Weise, wie wir Backend-Dienste erstellen und bereitstellen, neu gestaltet. Wenn Sie ein Entwickler sind, der das Server-Provisioning satt hat, oder ein Geschäftsinhaber, der kosteneffizientes Skalieren sucht, könnten **serverlose APIs** Ihr neuer bester Freund sein. In diesem ausführlichen Artikel werden wir die Infrastruktur hinter **serverlosen APIs** beleuchten, ihre Vor- und Nachteile abwägen, beliebte Tools vorstellen, sie mit traditionellen serverbasierten Backends vergleichen, das Testen mit Apidog erkunden und die große Frage beantworten: Wann sollten Sie serverlos werden? Basierend auf Expertenwissen werden wir es technisch aufschlüsseln und sehen, warum **serverlose APIs** im Jahr 2025 explosionsartig an Popularität gewinnen.

Möchten Sie eine integrierte All-in-One-Plattform, damit Ihr Entwicklerteam mit maximaler Produktivität zusammenarbeiten kann?

Apidog erfüllt alle Ihre Anforderungen und ersetzt Postman zu einem wesentlich günstigeren Preis!

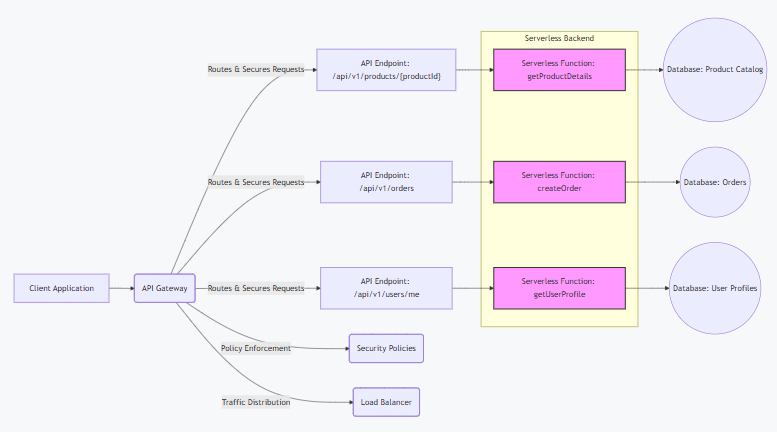

Die Infrastruktur und Architektur serverloser APIs verstehen

Im Kern ist eine **serverlose API** eine API, die auf serverlosem Computing basiert, bei dem Cloud-Anbieter die Backend-Infrastruktur übernehmen, sodass sich Entwickler ausschließlich auf den Code konzentrieren können. Im Gegensatz zu traditionellen Setups laufen **serverlose APIs** auf Function-as-a-Service-Plattformen (FaaS) und führen Code in zustandslosen Containern aus, die durch Ereignisse wie HTTP-Anfragen ausgelöst werden.

Technisch gesehen dreht sich die Architektur um ereignisgesteuertes Computing. Wenn eine Anfrage Ihren **serverlosen API**-Endpunkt erreicht, startet der Anbieter (z.B. AWS Lambda) einen Container, führt Ihre Funktion aus und skaliert diese automatisch je nach Bedarf. Dies nutzt ein Pay-per-Use-Modell – keine untätigen Server bedeuten keine verschwendeten Kosten. Zu den Schlüsselelementen gehören:

- API Gateway: Fungiert als Einstiegspunkt und übernimmt Routing, Authentifizierung (z.B. JWT oder OAuth), Ratenbegrenzung und Anfragenumwandlung. Zum Beispiel integriert AWS API Gateway mit Lambda und cacht Antworten für geringe Latenz.

- FaaS-Schicht: Ihr Code lebt hier als Funktionen. Jede Funktion ist isoliert, mit begrenzten Ausführungszeiten (z.B. 15 Minuten auf Lambda), um das Microservices-Design zu fördern.

- Backend-Dienste: **Serverlose APIs** verbinden sich mit verwalteten Datenbanken wie DynamoDB (NoSQL) oder Aurora Serverless (SQL), Speicher wie S3 und Warteschlangen wie SQS für die asynchrone Verarbeitung.

- Skalierungsmechanismen: Anbieter verwenden unter der Haube Auto-Scaling-Gruppen und Load Balancer. Bei hohem Datenverkehr replizieren sich Container über Verfügbarkeitszonen hinweg, um eine 99%ige Verfügbarkeit durch Redundanz zu gewährleisten.

Im Vergleich zu monolithischen Architekturen zerlegen sich **serverlose APIs** in granulare Funktionen, was eine unabhängige Skalierung ermöglicht. Dies führt jedoch zu Kaltstarts – anfängliche Latenz (50-500 ms), wenn Funktionen aus dem Ruhezustand hochfahren. Zu den Minderungsstrategien gehören die bereitgestellte Parallelität (Vorwärmen von Funktionen) oder die Verwendung von Warmer-Tools wie AWS Lambda Warmer.

Im Wesentlichen abstrahiert die Architektur von **serverlosen APIs** Betriebssystem, Netzwerk und Bereitstellung, sodass Sie Code als Funktionen bereitstellen können, die auf Auslöser reagieren. Sie ist ereignisgesteuert, zustandslos und hochresilient, erfordert aber ein sorgfältiges Design, um eine Anbieterbindung zu vermeiden.

Vorteile und Nachteile serverloser APIs

Serverlose APIs sind kein Allheilmittel, aber ihre Vorteile überwiegen oft die Nachteile für viele Anwendungsfälle. Lassen Sie es uns technisch aufschlüsseln.

Vorteile

- Kosteneffizienz: Zahlen Sie nur für die Ausführungszeit (z.B. berechnet Lambda 0,20 $ pro Million Anfragen + 0,0000166667 $/GB-Sekunde). Keine Kosten für Leerlaufzeiten, ideal für variablen Datenverkehr – sparen Sie bis zu 90 % im Vergleich zu ständig laufenden EC2-Instanzen.

- Automatische Skalierung: Bewältigt Spitzenlasten nahtlos; Lambda skaliert standardmäßig auf 1.000 gleichzeitige Ausführungen pro Region, mit Burst-Limits von bis zu 3.000. Keine manuelle Bereitstellung erforderlich.

- Schnellere Markteinführung: Konzentrieren Sie sich auf Code, nicht auf Infrastruktur. Stellen Sie Funktionen in Sekundenschnelle über die CLI bereit (z.B.

aws lambda update-function-code), was CI/CD-Pipelines beschleunigt. - Integrierte Resilienz: Anbieter bieten Multi-AZ-Bereitstellung, automatische Wiederholungen und Dead-Letter-Queues für fehlgeschlagene Ereignisse.

- Integrationsökosystem: Einfache Anbindung an Dienste wie S3 (für Dateiauslöser) oder DynamoDB (für Datenströme), was ereignisgesteuerte Architekturen ermöglicht.

Nachteile

- Kaltstarts: Latenzspitzen (bis zu 10 Sekunden für komplexe Funktionen) beim Skalieren von Null. Workarounds wie bereitgestellte Parallelität verursachen zusätzliche Kosten (0,035 $/GB-Stunde).

- Anbieterbindung (Vendor Lock-In): Proprietäre Funktionen (z.B. Lambda Layers) erschweren die Migration. Verwenden Sie Standards wie OpenFaaS für Portabilität.

- Ausführungslimits: Timeouts (max. 15 Min.), Speicher (10 GB) und Nutzlastgrößen (6 MB synchron) schränken lang laufende Aufgaben ein – verwenden Sie Step Functions zur Orchestrierung.

- Debugging-Herausforderungen: Die verteilte Natur erschwert das Tracing; Tools wie X-Ray (0,0001 $/Trace) helfen, erhöhen aber die Komplexität.

- Zustandsverwaltung: Zustandlose Funktionen erfordern externen Speicher (z.B. Redis), was die Latenz und Kosten für zustandsbehaftete Anwendungen erhöht.

Insgesamt eignen sich **serverlose APIs** hervorragend für stoßartige, ereignisgesteuerte Workloads, sind aber möglicherweise nicht für Anwendungen mit konstant hohem Durchsatz geeignet.

Beliebte Tools und Plattformen für serverlose APIs

Der Aufbau von **serverlosen APIs** wird mit diesen Plattformen und Tools einfacher, da jedes einzigartige Funktionen für unterschiedliche Anforderungen bietet.

- AWS Lambda + API Gateway: Der Urvater des Serverless. Lambda führt Code in über 15 Sprachen aus, wobei das Gateway das Routing übernimmt. Preise: 0,20 $/Mio. Anfragen. Vorteile: Tiefe AWS-Integration. Nachteile: Kaltstarts.

- Google Cloud Functions + API Gateway: Ereignisgesteuert, unterstützt Node.js/Python/Go. Preise: 0,40 $/Mio. Aufrufe. Vorteile: Schnelle Kaltstarts (über Firestore). Nachteile: Beschränkt auf das Google-Ökosystem.

- Azure Functions + API Management: Timer-gesteuerte Funktionen in C#/Java/JS. Preise: 0,20 $/Mio. Ausführungen. Vorteile: Hybrid-Cloud-Unterstützung. Nachteile: Steilere Lernkurve.

- Vercel Serverless Functions: Edge-Funktionen für Next.js-Apps. Preise: Kostenlose Stufe (100 GB-Stunden/Monat). Vorteile: Globales Edge-Netzwerk. Nachteile: An Vercel-Hosting gebunden.

- Cloudflare Workers: KV-Speicher für den Zustand. Preise: 0,30 $/Mio. Anfragen. Vorteile: Keine Kaltstarts. Nachteile: 10ms CPU-Limit.

Tools wie Serverless Framework (für Multi-Cloud-Bereitstellungen) oder SAM (AWS-spezifisch) vereinfachen die Orchestrierung. Für GraphQL ist Apollo Server auf Lambda beliebt.

Serverless vs. Serverful Backends: Ein technischer Vergleich

Serverless (FaaS) und serverbasiert (traditionelle VMs/Container) unterscheiden sich in Verwaltung, Skalierung und Kosten. Hier ist eine Aufschlüsselung:

- Verwaltung: Serverless abstrahiert die Infrastruktur – kein OS-Patching oder Lastenausgleich. Serverbasiert erfordert volle Kontrolle (z.B. Kubernetes-Orchestrierung).

- Skalierung: Serverless skaliert automatisch pro Anfrage (von Null auf Tausende in Sekunden). Serverbasiert benötigt manuelle/automatische Skalierungsgruppen, mit Bereitstellungsverzögerung.

- Kostenmodell: Serverless: Pay-per-Use (z.B. Lambdas GB-Sekunden). Serverbasiert: Fixkosten für ständig laufende Instanzen (z.B. EC2s 0,10 $/Stunde).

- Leistung: Serverless birgt das Risiko von Kaltstarts; serverbasiert bietet konsistente Latenz, verschwendet aber Ressourcen bei geringem Datenverkehr.

- Zustandsbehandlung: Serverless ist zustandslos (verwendet externe Datenbanken); serverbasiert unterstützt zustandsbehaftete Anwendungen nativ.

- Anwendungsfälle: Serverless für Microservices/APIs; serverbasiert für monolithische oder rechenintensive Anwendungen.

In Benchmarks kann Serverless bei intermittierenden Lasten 50 % günstiger, aber aufgrund von Startvorgängen 20 % langsamer sein. Wählen Sie basierend auf den Datenverkehrsmustern – hybride Ansätze mischen beides.

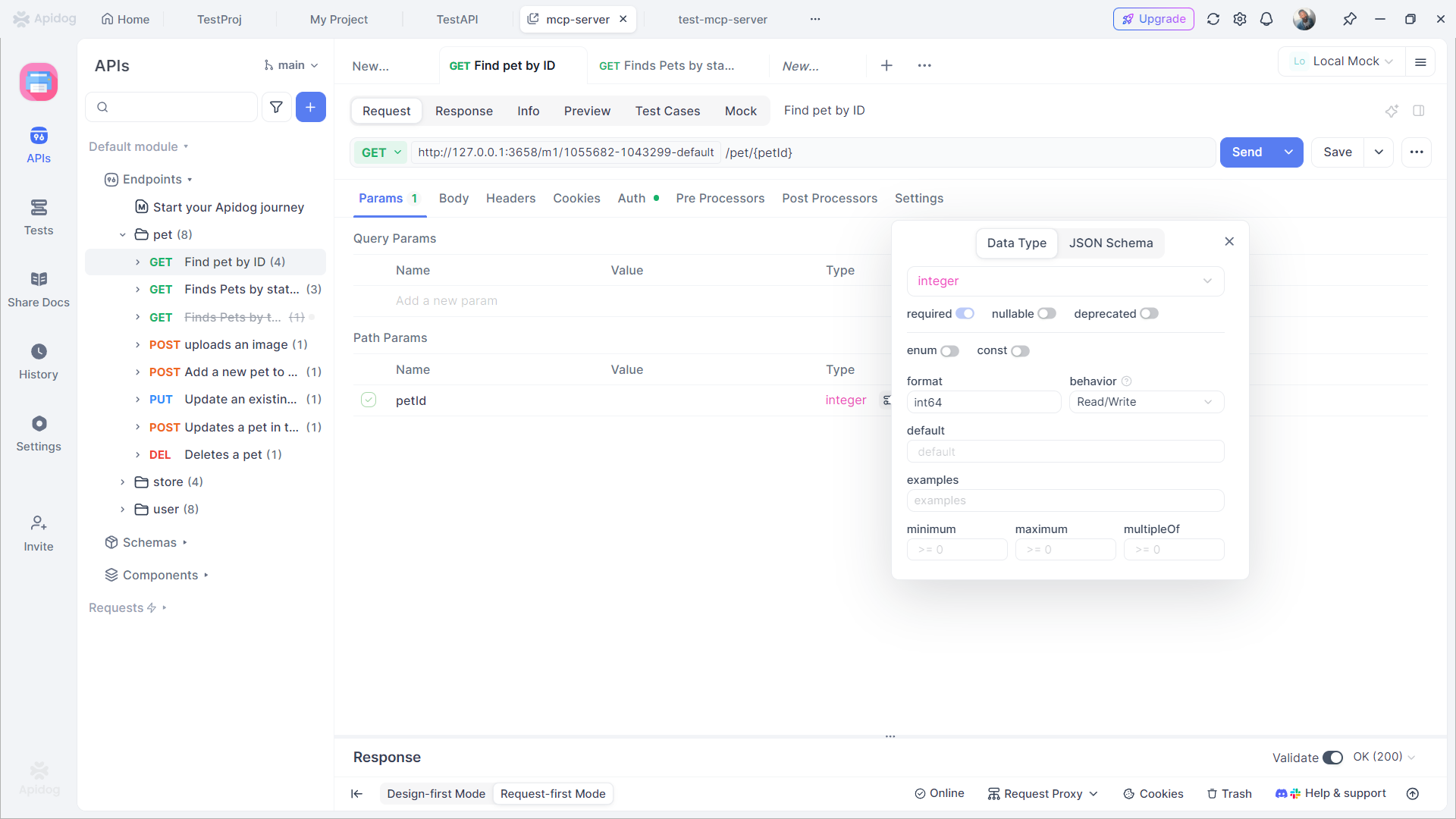

Testen serverloser APIs mit Apidog

Das Testen von **serverlosen APIs** ist entscheidend, um die Zuverlässigkeit zu gewährleisten, und Apidog ist ein Top-Tool dafür. Diese All-in-One-Plattform unterstützt visuelles Design, automatisiertes Testen und Mock-Server.

Wie Apidog beim Testen serverloser APIs hilft

- Visuelle Assertions: Legen Sie Enums fest und validieren Sie Antworten visuell – kein Code erforderlich.

- Unbegrenzte Ausführungen: Kostenlose unbegrenzte Sammlungsdurchläufe, im Gegensatz zu Postmans Limit von 25/Monat.

- CI/CD-Integration: Integrieren Sie sich in Pipelines wie Jenkins für automatisches Testen bei Bereitstellungen.

- Mocking: Generieren Sie enum-konforme Daten für Offline-Tests.

- KI-Unterstützung: Automatische Generierung von Tests aus Prompts, z.B. "Test enum for user_status."

Vorteile: Apidogs Echtzeit-Synchronisierung erkennt Probleme frühzeitig, und seine Datenbankverbindungen testen zustandsbehaftete Abläufe. Die Preise beginnen kostenlos, mit Pro für 9 $/Monat – günstiger als Postman.

Wann sollten Sie serverlose APIs verwenden?

Serverlose APIs bieten einen modernen Ansatz zum Erstellen und Bereitstellen von Anwendungen, sind aber keine Einheitslösung. Das Verständnis ihrer Stärken und Einschränkungen ist entscheidend, um sie effektiv zu nutzen. Hier ist eine Aufschlüsselung, wann serverlose APIs in Betracht gezogen werden sollten, mit detaillierten Erklärungen:

- Variabler Datenverkehr: Serverless ist ideal für Anwendungen mit unvorhersehbaren oder stoßartigen Datenverkehrsmustern. Zum Beispiel E-Commerce-Plattformen während Flash-Sales oder Event-Registrierungsseiten, die plötzliche Anstiege erleben. Serverlose Funktionen skalieren automatisch hoch, um die Nachfrage zu bewältigen, und skalieren auf Null herunter, wenn sie im Leerlauf sind, wodurch Sie nur für die tatsächliche Nutzung bezahlen, anstatt teure, ständig aktive Infrastruktur bereitzustellen.

- Schnelles Prototyping und MVPs: Wenn Sie schnell eine Idee validieren oder ein Minimum Viable Product (MVP) erstellen müssen, ermöglicht Serverless das Bereitstellen von Funktionen in Sekundenschnelle. Diese Agilität beschleunigt Experimente, verkürzt die Markteinführungszeit und ermöglicht es Teams, basierend auf echtem Benutzerfeedback zu iterieren, ohne sich auf komplexe Infrastruktur-Setups festlegen zu müssen.

- Ereignisgesteuerte Anwendungen: Serverless glänzt in ereignisgesteuerten Architekturen. Anwendungsfälle umfassen die IoT-Datenverarbeitung (z.B. die Handhabung von Sensor-Triggern), die Verwaltung von Webhooks (z.B. die Reaktion auf GitHub- oder Stripe-Ereignisse) und die Orchestrierung von Microservices. Funktionen werden genau dann ausgelöst, wenn Ereignisse auftreten, was eine effiziente Ressourcennutzung gewährleistet und ereignisbasierte Workflows vereinfacht.

- Kostenoptimierung für intermittierende Workloads: Wenn Ihre Anwendung viel Zeit im Leerlauf verbringt (z.B. 80 % oder mehr), kann Serverless die Kosten drastisch senken. Traditionelle Server verursachen auch im Ruhezustand Kosten, aber Serverless folgt einem Pay-per-Execution-Modell. Dies macht es wirtschaftlich für Anwendungen mit geringem Datenverkehr, Batch-Jobs oder Hintergrundaufgaben, die intermittierend ausgeführt werden.

- DevOps-Light-Teams: Organisationen mit begrenzten DevOps-Ressourcen profitieren von der verwalteten Infrastruktur von Serverless. Cloud-Anbieter kümmern sich um Skalierung, Patching und Wartung, sodass sich Entwickler ausschließlich auf den Code konzentrieren können. Dies reduziert den Betriebsaufwand und beschleunigt die Entwicklungszyklen, wodurch es für kleine Teams einfacher wird, Funktionen schneller bereitzustellen.

Wann serverlose APIs zu vermeiden sind:

- Lang laufende Prozesse: Funktionen haben typischerweise Zeitlimits (z.B. 15 Minuten bei AWS Lambda), was sie für Aufgaben wie Videokodierung oder große Datenexporte ungeeignet macht.

- Zustandsbehaftete Anwendungen: Serverless ist von Natur aus zustandslos; vermeiden Sie es für Anwendungen, die persistente Verbindungen oder In-Memory-Zustände erfordern (z.B. WebSocket-Server).

- Anforderungen an extrem geringe Latenz: Kaltstarts (Verzögerungen beim Initialisieren von Funktionen) können Latenz einführen, daher sollten Sie Serverless für Echtzeitsysteme vermeiden, die konsistente Antwortzeiten unter 50 ms erfordern.

Endgültiges Fazit

Beginnen Sie klein, indem Sie einen einzelnen Microservice oder API-Endpunkt als Prototyp erstellen. Messen Sie Leistung, Kosten und Skalierbarkeit in Ihrem spezifischen Kontext. Serverless ist ein leistungsstarkes Tool für die richtigen Anwendungsfälle – nutzen Sie es für agile Entwicklung, variable Workloads und ereignisgesteuerte Anforderungen, aber kombinieren Sie es mit traditioneller Infrastruktur für zustandsbehaftete oder Hochleistungsanforderungen. Indem Sie Serverless an Ihren Architekturzielen ausrichten und Ihre APIs mit Apidog testen, können Sie Effizienz und Innovation maximieren.