Entwickler suchen nach Tools, die die Produktivität steigern und gleichzeitig die Kontrolle über ihre Arbeitsabläufe behalten. Devstral, ein Open-Source-KI-Modell von Mistral AI, erweist sich als leistungsstarke Lösung für Programmieraufgaben. Entwickelt, um Code zu generieren, zu debuggen und zu erklären, zeichnet sich Devstral durch seine Fähigkeit aus, lokal über Ollama ausgeführt zu werden, einer Plattform, die KI-Modelle auf Ihrer Hardware bereitstellt. Dieser Ansatz bietet Datenschutz, reduziert die Latenz und eliminiert Cloud-Kosten; wichtige Vorteile für technische Anwender. Darüber hinaus unterstützt es die Offline-Nutzung und gewährleistet so ununterbrochene Programmiersitzungen.

Warum lokale Bereitstellung wählen? Erstens schützt es sensible Codebasen, was in regulierten Sektoren wie Finanzen oder dem Gesundheitswesen von entscheidender Bedeutung ist. Zweitens verkürzt es die Reaktionszeiten, indem es Internetverzögerungen umgeht, ideal für Echtzeit-Unterstützung. Drittens spart es Geld, indem es Abonnementgebühren vermeidet, was den Zugang für Solo-Entwickler erweitert. Bereit, Devstral zu nutzen?

Einrichten von Ollama: Schritt-für-Schritt-Installation

Um Devstral lokal auszuführen, installieren Sie zuerst Ollama. Diese Plattform vereinfacht die Bereitstellung von KI-Modellen und macht sie auch auf bescheidener Hardware zugänglich. Befolgen Sie diese Schritte, um zu beginnen:

Systemanforderungen

Stellen Sie sicher, dass Ihr Gerät diese Spezifikationen erfüllt:

- OS: Windows, macOS oder Linux

- RAM: Mindestens 16 GB (32 GB bevorzugt für größere Modelle)

- CPU: Moderner Multi-Core-Prozessor

- GPU: Optional, aber empfohlen (NVIDIA mit CUDA-Unterstützung)

- Storage: Mindestens 20 GB frei für Modelldateien

Installationsprozess

- Download Ollama: Besuchen Sie ollama.com und holen Sie sich das Installationsprogramm für Ihr Betriebssystem.

- Führen Sie das Installationsprogramm aus:

- Führen Sie unter Windows die

.exeaus und befolgen Sie die Anweisungen. - Öffnen Sie unter macOS die

.dmgund ziehen Sie Ollama in die Anwendungen. - Verwenden Sie unter Linux

curl -fsSL https://ollama.com/install.sh | shfür eine schnelle Einrichtung.

- Installation überprüfen: Öffnen Sie ein Terminal und geben Sie

ollama --versionein. Sie sollten die Versionsnummer sehen (z. B. 0.1.x). Wenn nicht, überprüfen Sie Ihre PATH-Variable.

Devstral abrufen

Ziehen Sie nach der Installation von Ollama Devstral aus seiner Bibliothek:

- Führen Sie

ollama pull devstralaus. Dadurch wird das Modell heruntergeladen, was je nach Bandbreite einige Zeit dauern kann (erwarten Sie 10-15 GB). - Bestätigen Sie die Verfügbarkeit mit

ollama list. Devstral sollte in der Ausgabe erscheinen.

Devstral starten

Führen Sie ollama run devstral aus. Das Terminal zeigt eine Lademeldung an, gefolgt von einer Eingabeaufforderung, die die Bereitschaft anzeigt. Wenn Fehler auftreten (z. B. unzureichender Speicher), überprüfen Sie Ihre Hardware oder konsultieren Sie die Fehlerbehebungsdokumente von Ollama.

Durch Ausführen dieser Schritte richten Sie eine lokale Devstral-Instanz ein, die für Programmieraufgaben vorbereitet ist.

Verwendung von Devstral für das Programmieren: Praktische Anwendungen

Devstral zeichnet sich durch das Programmieren aus und nutzt sein Training mit riesigen Code-Datensätzen. So verwenden Sie es aktiv:

Code-Generierung

Benötigen Sie schnell eine Funktion? Geben Sie eine klare Eingabeaufforderung ein:

- Eingabe: „Generieren Sie eine Python-Funktion, um eine Zeichenkette umzukehren.“

- Ausgabe:

def reverse_string(text):

return text[::-1]

Dies verwendet das Slicing von Python und zeigt die Effizienz von Devstral.

Debugging-Unterstützung

Stecken Sie bei einem Fehler fest? Geben Sie Ihren Code und das Problem an:

- Eingabe: „Warum gibt dieser JavaScript-Fetch undefined zurück?

fetch('https://api.example.com').then(data => console.log(data));“ - Ausgabe: „Ihnen fehlt

.json(), um die Antwort zu parsen. Versuchen Sie:fetch('https://api.example.com').then(res => res.json()).then(data => console.log(data));“

Devstral lokalisiert die Korrektur und spart Debugging-Zeit.

Code-Vervollständigung

Starten Sie eine Funktion und lassen Sie Devstral sie beenden:

- Eingabe: „Vervollständigen Sie diese Python-Funktion:

def factorial(n):“ - Ausgabe:

def factorial(n):

if n == 0 or n == 1:

return 1

return n * factorial(n - 1)

Diese rekursive Lösung demonstriert Devstrals Verständnis von Algorithmen.

Neue Konzepte lernen

Erforschen Sie eine Sprache? Bitten Sie um Erklärungen:

- Eingabe: „Zeigen Sie mir, wie man eine Klasse in C++ erstellt.“

- Ausgabe:

class MyClass {

public:

int value;

MyClass(int v) : value(v) {}

void print() { std::cout << value << std::endl; }

};

Devstral kombiniert Code mit implizitem Kontext und unterstützt das Verständnis.

Interagieren Sie über das Terminal nach dem Start von ollama run devstral. Für die erweiterte Verwendung erkunden Sie die API-Integration, falls unterstützt – überprüfen Sie die Dokumente von Ollama auf Endpunkte.

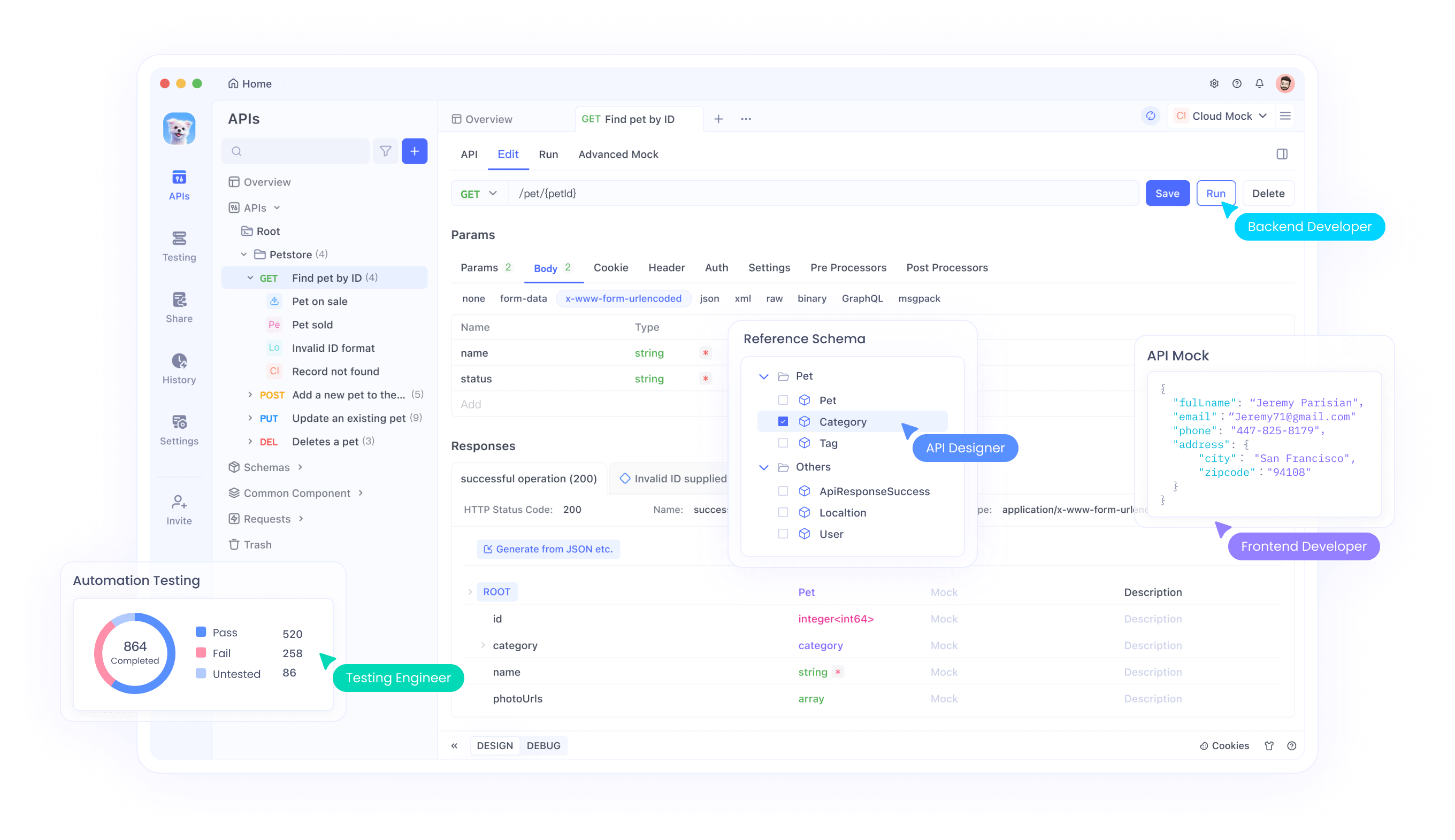

Verbesserung des Workflows mit Apidog: API-Testintegration

Während Devstral das Programmieren übernimmt, stellt Apidog sicher, dass Ihre APIs zuverlässig funktionieren. Dieses Tool rationalisiert die API-Entwicklung und ergänzt die Fähigkeiten von Devstral.

APIs testen

Validieren Sie Endpunkte mit Apidog:

- Starten Sie Apidog und erstellen Sie ein Projekt.

- Definieren Sie einen Endpunkt (z. B.

GET /users). - Legen Sie Parameter fest und führen Sie Tests aus. Überprüfen Sie den Status 200 und gültiges JSON.

Mock-Server

Simulieren Sie APIs während der Entwicklung:

- Greifen Sie in Apidog auf die Mock-Server-Registerkarte zu.

- Geben Sie Antworten an (z. B.

{ "id": 1, "name": "Test" }). - Verwenden Sie die generierte URL in Ihrem Code und testen Sie ohne Live-Server.

API-Dokumentation

Generieren Sie Dokumente automatisch:

- Erstellen Sie Testfälle in Apidog.

- Exportieren Sie die Dokumentation als HTML oder Markdown für die Teamfreigabe.

Die Integration von Apidog stellt sicher, dass Ihre APIs mit dem von Devstral generierten Code übereinstimmen, wodurch eine robuste Pipeline entsteht.

Erweiterte Verwendung: Anpassen von Devstral

Maximieren Sie das Potenzial von Devstral mit diesen Techniken:

Parameter-Tuning

Passen Sie Einstellungen wie temperature (Zufälligkeit) oder top-p (Ausgabevielfalt) über die Konfigurationsoptionen von Ollama an. Testen Sie Werte, um Kreativität und Präzision auszugleichen.

IDE-Integration

Suchen Sie nach Ollama-kompatiblen Plugins für VS Code oder JetBrains IDEs. Dadurch wird Devstral direkt in Ihren Editor eingebettet, wodurch der Workflow verbessert wird.

API-Nutzung

Wenn Ollama eine API verfügbar macht, erstellen Sie Skripte, um Aufgaben zu automatisieren. Beispiel: ein Python-Skript, das Eingabeaufforderungen über HTTP-Anforderungen an Devstral sendet.

Community-Engagement

Verfolgen Sie Updates auf mistral.ai oder in den Foren von Ollama. Tragen Sie zu Korrekturen bei oder teilen Sie Anwendungsfälle, um die Entwicklung zu gestalten.

Diese Schritte passen Devstral an Ihre Bedürfnisse an und steigern die Effizienz.

Technischer Hintergrund: Unter der Haube

Devstral und Ollama kombinieren modernste Technologie:

Devstral-Architektur

Mistral AI hat Devstral als Transformer-basiertes LLM entwickelt, das auf Code und Text trainiert wurde. Seine Mehrsprachigkeit resultiert aus umfangreichen Datensätzen, die eine präzise Code-Generierung ermöglichen.

Ollama-Framework

Ollama optimiert Modelle für die lokale Ausführung und unterstützt die CPU- und GPU-Beschleunigung. Es verarbeitet das Laden von Modellen, die Speicherverwaltung und die Inferenz und abstrahiert die Komplexität für Benutzer.

Diese Synergie liefert KI mit hoher Leistung ohne Cloud-Abhängigkeit.

Fazit

Das lokale Ausführen von Devstral mit Ollama ermöglicht Entwicklern ein privates, kostengünstiges und offline-fähiges Programmiertool. Sie richten es einfach ein, verwenden es für verschiedene Programmieraufgaben und erweitern es mit den API-Tests von Apidog. Diese Kombination steigert die Produktivität und Qualität. Treten Sie der Devstral-Community bei, experimentieren Sie mit Anpassungen und verbessern Sie Ihre Fähigkeiten. Laden Sie Apidog noch heute kostenlos herunter, um Ihr Toolkit zu vervollständigen.