OpenAI ist seit Langem führend auf dem Gebiet der künstlichen Intelligenz und treibt die Fähigkeiten von Machine-Learning-Modellen kontinuierlich voran. Ihr neuestes Angebot, das Modell o3-pro, markiert einen weiteren bedeutenden Meilenstein auf diesem Weg. Das Anfang 2025 vorgestellte o3-pro zeichnet sich durch seine außergewöhnliche Leistung und Anpassungsfähigkeit aus und wird damit zu einem Wendepunkt in der KI-Landschaft. Dieser Artikel untersucht die Benchmarks, die Preisgestaltung und die API-Preise von OpenAIs o3-pro und bietet einen detaillierten Einblick in das, was dieses Modell zu einer herausragenden Innovation macht.

Möchten Sie eine integrierte All-in-One-Plattform für Ihr Entwicklerteam, um mit maximaler Produktivität zusammenzuarbeiten?

Apidog erfüllt all Ihre Anforderungen und ersetzt Postman zu einem viel günstigeren Preis!

Was ist OpenAI o3-pro?

Das o3-pro-Modell von OpenAI ist ein hochmodernes Sprachmodell, das entwickelt wurde, um eine Vielzahl von Aufgaben mit beeindruckender Präzision und Geschwindigkeit zu bewältigen. Es baut auf dem Erbe früherer Modelle wie GPT-4 und o1 auf und integriert die neuesten Fortschritte in den Bereichen Verarbeitung natürlicher Sprache, maschinelles Lernen und Deep Learning. Seine Architektur ist darauf ausgelegt, sowohl schnelle Verarbeitung als auch hohe Genauigkeit zu liefern und eine breite Palette von Anwendungen zu unterstützen, von einfacher Textgenerierung bis hin zu komplexer Problemlösung.

I’ve been secretly testing o3-pro for a while now 👀

— Flavio Adamo (@flavioAd) June 10, 2025

Extremely cheaper, faster, and way more precise than o1-pro (and coding with o3 vs o3-pro is night and day)

Got some cool tests coming, starting with (of course) a tougher version of the Hexagon Bauncing ball

o3-pro is the… https://t.co/BDUyA7TXms pic.twitter.com/fG5l7LlGp4

Ein herausragendes Merkmal von o3-pro ist seine Fähigkeit, Text zu produzieren und zu verstehen, der der menschlichen Kommunikation sehr nahekommt, wobei Kohärenz und Relevanz auch in komplexen Szenarien erhalten bleiben. Dies wird durch riesige Trainingsdatensätze, fortschrittliche Algorithmen und innovative Trainingstechniken ermöglicht. Über Text hinaus unterstützt o3-pro multimodale Eingaben und verarbeitet nahtlos Datentypen wie Bilder neben Text, was seine Vielseitigkeit erweitert.

Dieses Modell glänzt bei Aufgaben, die ein tiefes kontextuelles Verständnis erfordern, wie z. B. das Zusammenfassen langer Dokumente, das Übersetzen von Sprachen oder das Beantworten nuancierter Fragen. Es zeichnet sich auch bei kreativen Unternehmungen aus, darunter das Schreiben von Erzählungen, das Programmieren und sogar das Generieren musikalischer Kompositionen. Mit solch vielseitigen Fähigkeiten wird o3-pro Industrien wie Bildung, Gesundheitswesen, Unterhaltung und Finanzen transformieren und leistungsstarke Werkzeuge für Einzelpersonen und Organisationen bieten.

OpenAI o3-pro Benchmarks

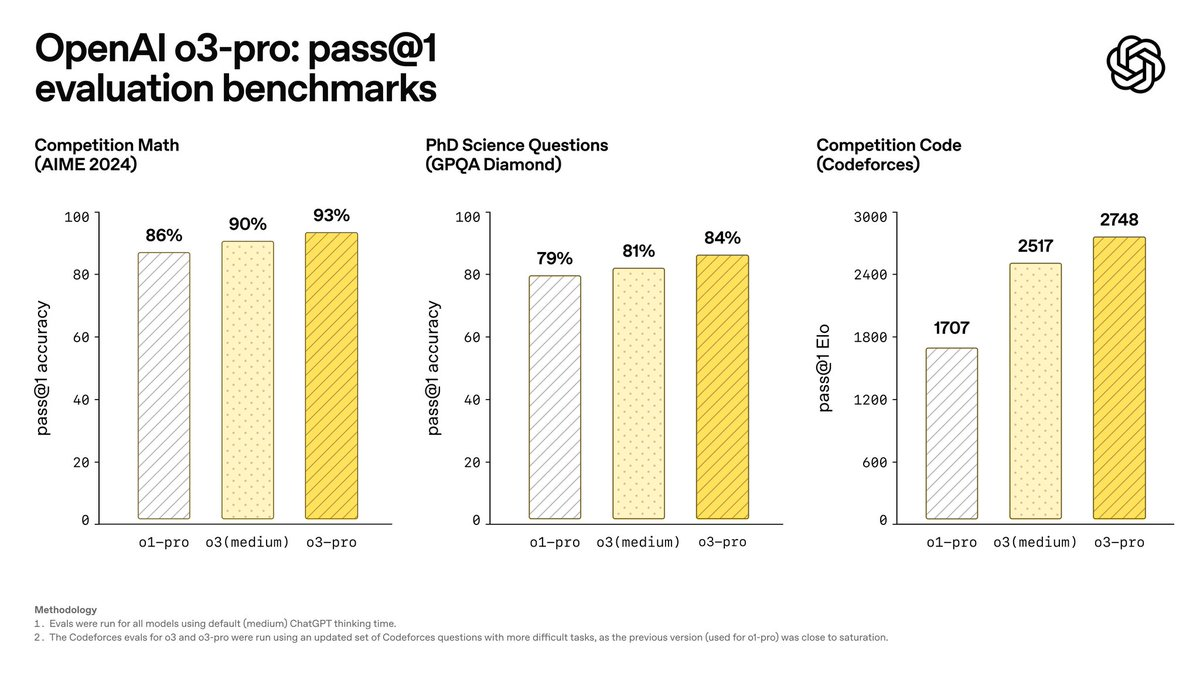

Benchmarks sind unerlässlich, um die Leistung eines KI-Modells zu beurteilen, und o3-pro hat die Messlatte in mehreren Metriken höher gelegt. Interne Evaluierungen von OpenAI zeigen, dass o3-pro bei wichtigen KI-Benchmarks hervorragend abschneidet und seine Überlegenheit in Bereichen wie Mathematik und wissenschaftlichem Wissen demonstriert.

Beim AIME 2024-Benchmark, der mathematische Fähigkeiten testet, übertrifft o3-pro das führende Modell von Google, Gemini 2.5 Pro. Diese Leistung unterstreicht seine außergewöhnliche Fähigkeit, komplexe Gleichungen zu lösen und logisches Denken anzuwenden, was es zu einem wertvollen Asset für technische und akademische Anwendungen macht.

Ähnlich übertrifft o3-pro beim GPQA Diamond-Benchmark – einer strengen Bewertung des wissenschaftlichen Verständnisses auf PhD-Niveau – Anthropic's Claude 4 Opus. Dies zeigt sein tiefes und genaues Verständnis fortgeschrittener wissenschaftlicher Konzepte und positioniert es als erste Wahl für Forschung und professionelle Nutzung.

Über diese spezifischen Tests hinaus zeigt o3-pro bemerkenswerte Stärken im Verständnis natürlicher Sprache, in der Geschwindigkeit der Textgenerierung und in der Leistung bei multimodalen Aufgaben. Seine Fähigkeit, Genauigkeit bei schneller Datenverarbeitung beizubehalten, hebt es von Konkurrenten ab. OpenAI hat o3-pro auch rigoros auf Zuverlässigkeit getestet und es Stresstests und adversariellen Herausforderungen unterzogen, um sicherzustellen, dass es unter anspruchsvollen Bedingungen stabil und sicher bleibt. Diese Ergebnisse bestätigen o3-pro als ein leistungsstarkes, zuverlässiges Modell, das für den Einsatz in der Praxis bereit ist.

OpenAI o3-pro Preisgestaltung

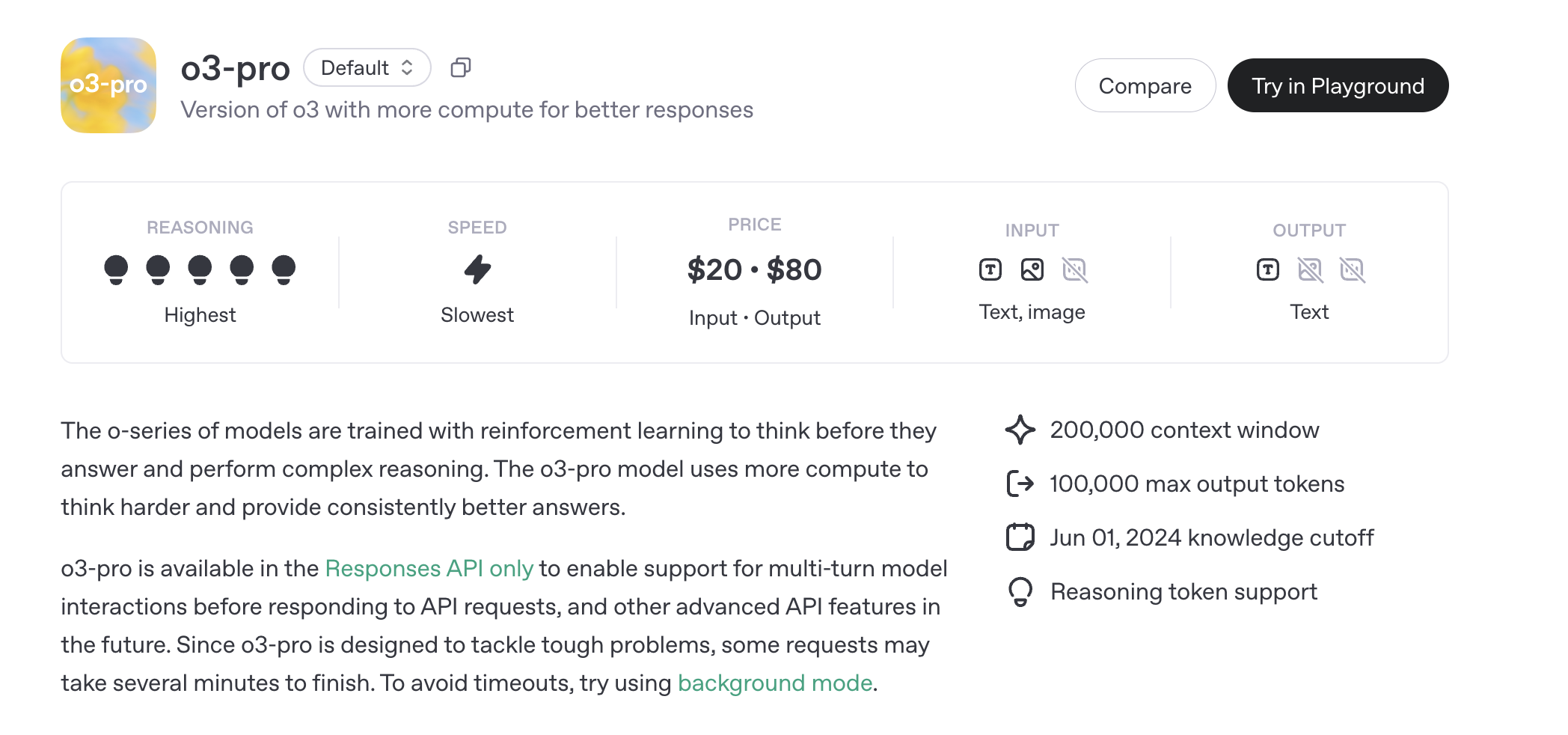

Die Preisgestaltung von OpenAI für o3-pro basiert auf der API-Nutzung, ohne eigenständige Abonnementpläne für Einzelpersonen oder Unternehmen. Stattdessen sind die Kosten an den Token-Verbrauch gebunden, was die rechenintensive Natur des Modells widerspiegelt. Unten finden Sie eine detaillierte Aufschlüsselung der Preisstruktur.

o3-pro API-Preise

Das o3-pro-Modell ist nur über die Responses API zugänglich, wobei die Preise auf der Anzahl der verarbeiteten Tokens basieren. Tokens repräsentieren Textabschnitte, wobei etwa 1 Million Tokens 750.000 Wörtern entsprechen – ungefähr die Länge eines Romans wie Krieg und Frieden.

- Input Tokens: 20,00 $ pro 1 Million Tokens

- Output Tokens: 80,00 $ pro 1 Million Tokens

Output Tokens sind aufgrund des höheren Rechenaufwands bei der Generierung von Antworten teurer. Zum Vergleich: Das Standardmodell o3 kostet 2,00 $ pro Million Input Tokens und 8,00 $ pro Million Output Tokens, während o3-mini mit 1,10 $ bzw. 4,40 $ noch günstiger ist. Die erhöhten Kosten von o3-pro spiegeln seine verbesserten Denk- und Rechenanforderungen wider.

Zusätzliche Kosten können für werkzeugspezifische Funktionen anfallen, wie z. B. Dateisuche oder Bildgenerierung, die Gebühren pro Aufruf verursachen. Zum Beispiel wird die Nutzung des Dateisuchwerkzeugs oder die Integration der Bildgenerierung über die API die Gesamtkosten basierend auf der Nutzung erhöhen.

o3-pro Batch API-Preise

Für Nutzer mit hohem Volumen bietet OpenAI eine Batch API-Option an, die Anfragen asynchron verarbeitet, um die Kosteneffizienz zu erhöhen. Die Batch API-Preise für o3-pro spiegeln die Standardtarife wider: 20,00 $ pro Million Input Tokens und 80,00 $ pro Million Output Tokens. Dies ist ideal für Anwendungen, die eine großvolumige Verarbeitung erfordern, wie z. B. Datenanalyse oder Massen-Content-Generierung.

Enterprise- und benutzerdefinierte Preisgestaltung

Unternehmen mit umfangreicher API-Nutzung können benutzerdefinierte Preispläne verhandeln, die Mengenrabatte und erweiterten Support beinhalten können. Diese Pläne sind auf den Umfang des Projekts zugeschnitten und gewährleisten Kosteneffizienz für große Implementierungen. OpenAI bietet auch Fine-Tuning-Funktionen an, die es Entwicklern ermöglichen, o3-pro für spezifische Aufgaben anzupassen, obwohl dies zusätzliche Kosten basierend auf den Rechenressourcen verursacht.

Rabatte und Zugänglichkeit

Um die Zugänglichkeit zu fördern, bietet OpenAI reduzierte Tarife für Bildungseinrichtungen und gemeinnützige Organisationen an. Berechtigte Organisationen können Rabatte beantragen, wodurch o3-pro für akademische Forschung oder soziale Projekte erschwinglicher wird. Periodische Werbeaktionen können auch die Kosten für neue Nutzer oder Nutzer mit hohem Volumen senken.

o3-pro Ratenbegrenzungen

Ratenbegrenzungen sind entscheidend, um einen fairen und zuverlässigen API-Zugriff zu gewährleisten, indem die Anzahl der Anfragen oder Tokens begrenzt wird, die innerhalb eines bestimmten Zeitraums verarbeitet werden. Die Ratenbegrenzungen von OpenAI für o3-pro variieren je nach Nutzungsebene und skalieren automatisch, wenn Benutzer ihre API-Aktivität und Ausgaben erhöhen.

Unten finden Sie eine Aufschlüsselung der Ebenen und ihrer jeweiligen Grenzen:

- Kostenlose Ebene: Wird für o3-pro nicht unterstützt.

- Ebene 1: 500 Anfragen pro Minute (RPM), 30.000 Tokens pro Minute (TPM), 90.000 Batch-Warteschlangenlimit.

- Ebene 2: 5.000 RPM, 450.000 TPM, 1.350.000 Batch-Warteschlangenlimit.

- Ebene 3: 5.000 RPM, 800.000 TPM, 50.000.000 Batch-Warteschlangenlimit.

- Ebene 4: 10.000 RPM, 2.000.000 TPM, 200.000.000 Batch-Warteschlangenlimit.

- Ebene 5: 10.000 RPM, 30.000.000 TPM, 5.000.000.000 Batch-Warteschlangenlimit.

Höhere Ebenen schalten größere Kapazitäten frei, sodass Entwickler größere Workloads bewältigen können. Das Batch-Warteschlangenlimit regelt die Anzahl der Tokens, die für die asynchrone Verarbeitung in die Warteschlange gestellt werden können, was für Batch API-Nutzer entscheidend ist. Diese Grenzen gewährleisten einen gerechten Zugang und berücksichtigen gleichzeitig verschiedene Anwendungsfälle, von kleinen Apps bis hin zu Unternehmenslösungen.

o3-pro API-Funktionen und Einschränkungen

Das o3-pro-Modell unterstützt eine Reihe von API-Endpunkten und Funktionen, obwohl einige aufgrund seines rechenintensiven Designs nicht verfügbar sind:

- Unterstützte Endpunkte: Chat Completions, Responses, Assistants, Batch, Fine-tuning, Embeddings, Image Generation, Image Edit, Speech Generation, Transcription, Translation, Moderation.

- Nicht unterstützte Endpunkte: Realtime, Completions (veraltet).

- Funktionen:

- Function Calling: Unterstützt, ermöglicht die Integration mit externen Werkzeugen.

- Structured Outputs: Unterstützt, gewährleistet konsistente Antwortformate.

- Werkzeuge: Dateisuche, Bildgenerierung und MCP (Model Control Protocol) werden über die Responses API unterstützt. Websuche, Code-Interpreter und Computernutzung werden nicht unterstützt.

- Einschränkungen:

- Streaming wird nicht unterstützt, was die langsamere, bewusste Verarbeitung des Modells widerspiegelt.

- Fine-Tuning ist verfügbar, aber keine Destillation oder vorhergesagte Ausgaben.

- Audioeingaben werden nicht unterstützt; es werden nur Text- und Bildeingaben akzeptiert.

Snapshots, wie z. B. o3-pro-2025-06-10, ermöglichen es Benutzern, eine bestimmte Modellversion für konsistente Leistung festzulegen und so Stabilität für Produktionsumgebungen zu gewährleisten.

Fazit

OpenAIs o3-pro ist ein leistungsstarkes KI-Modell, das sich durch komplexe Denkprozesse auszeichnet und bei Benchmarks wie AIME 2024 und GPQA Diamond Spitzenleistungen liefert. Seine Preisgestaltung – 20 $ pro Million Input Tokens und 80 $ pro Million Output Tokens – spiegelt seine rechenintensive Natur wider, wobei Batch API- und Unternehmensoptionen Flexibilität für Nutzer mit hohem Volumen bieten. Ratenbegrenzungen, die von Ebene 1 bis Ebene 5 skalieren, gewährleisten einen fairen Zugang und unterstützen gleichzeitig verschiedene Workloads.

Ausschließlich über die Responses API verfügbar, machen das 200.000-Token-Kontextfenster von o3-pro und die Unterstützung für Werkzeuge wie Dateisuche und Bildgenerierung es zu einer vielseitigen Wahl für Entwickler. Trotz seiner langsameren Geschwindigkeit und höheren Kosten im Vergleich zu o3 und o3-mini positionieren seine unübertroffenen Denkfähigkeiten es als führende Lösung zur Bewältigung der anspruchsvollsten KI-Aufgaben. Während OpenAI weiterhin innoviert, ist o3-pro ein Beweis für das transformative Potenzial fortschrittlicher KI und treibt den Fortschritt in allen Branchen und Anwendungen voran.

Möchten Sie eine integrierte All-in-One-Plattform für Ihr Entwicklerteam, um mit maximaler Produktivität zusammenzuarbeiten?

Apidog erfüllt all Ihre Anforderungen und ersetzt Postman zu einem viel günstigeren Preis!