OpenAI hat seine Palette leistungsstarker KI-Modelle um o1-pro erweitert, ein neues Angebot, das für fortgeschrittene Denk- und Problemlösungsaufgaben konzipiert wurde. Als Teil der Entwicklung von OpenAI über die GPT-Serie hinaus, stellen die "o"-Modelle spezialisierte KI-Systeme dar, die für bestimmte Anwendungsfälle optimiert sind. In diesem umfassenden Leitfaden werden wir alles erkunden, was Sie über o1-pro wissen müssen, einschließlich seiner Fähigkeiten, der Preisstruktur und wie Sie es in Ihren Anwendungen durch verschiedene Methoden implementieren können, einschließlich mit API-Testtools wie Apidog.

Was ist o1-pro? Und wie gut ist es?

o1-pro ist OpenAIs spezialisiertes Modell für komplexe Denkaufgaben. Es ist Teil der "o1"-Modellfamilie, die sich durch schrittweises Denken und Problemlösen auszeichnet. Die "pro"-Variante bietet erweiterte Fähigkeiten gegenüber dem Basismodell und eignet sich daher für anspruchsvolle Anwendungen, die ausgefeiltes Denken erfordern.

Im Gegensatz zu allgemeineren Modellen wie GPT-4o wurde o1-pro speziell für Aufgaben optimiert, die logische Abfolgen, mathematisches Denken und strukturierte Analysen erfordern. Dieser spezialisierte Fokus ermöglicht es, in Bereichen, in denen methodisches Denken und Problemzerlegung entscheidend sind, außergewöhnlich gut zu arbeiten.

o1-pro ist mit folgenden Stärken ausgestattet:

- Fortgeschrittenes Denken: Übertrifft sich beim Aufschlüsseln komplexer Probleme in logische Schritte und ist somit ideal für Aufgaben, die strukturiertes Denken und Analyse erfordern. Es kann durch komplexe Entscheidungsbäume navigieren und explizite Denkpfade bereitstellen.

- Mathematische Problemlösung: Behandelt mathematisches Denken, Beweise und Berechnungen mit verbesserter Genauigkeit. Das Modell zeigt besondere Stärken in Algebra, Analysis, Statistik und formaler Logik.

- Code-Analyse: Fähig, Code mit detailliertem Verständnis zu analysieren, zu debuggen und zu erklären. Es kann in mehreren Programmiersprachen arbeiten und logische Fehler oder Optimierungsmöglichkeiten identifizieren.

- Strukturiertes Denken: Erzeugt klarere, strukturiertere Antworten auf komplexe Fragen, mit natürlichen Aufschlüsselungen von mehrstufigen Problemen und klar abgegrenzten Denkweisen.

- Forschung und Analyse: Führt eingehende Analysen von Themen mit logischer Organisation durch, vergleicht verschiedene Perspektiven und bewertet methodisch Beweise.

- Chain-of-Thought-Verarbeitung: Zeigt explizit seinen Denkprozess, wodurch es einfacher wird, komplexen Gedankengängen zu folgen und Schlussfolgerungen zu überprüfen.

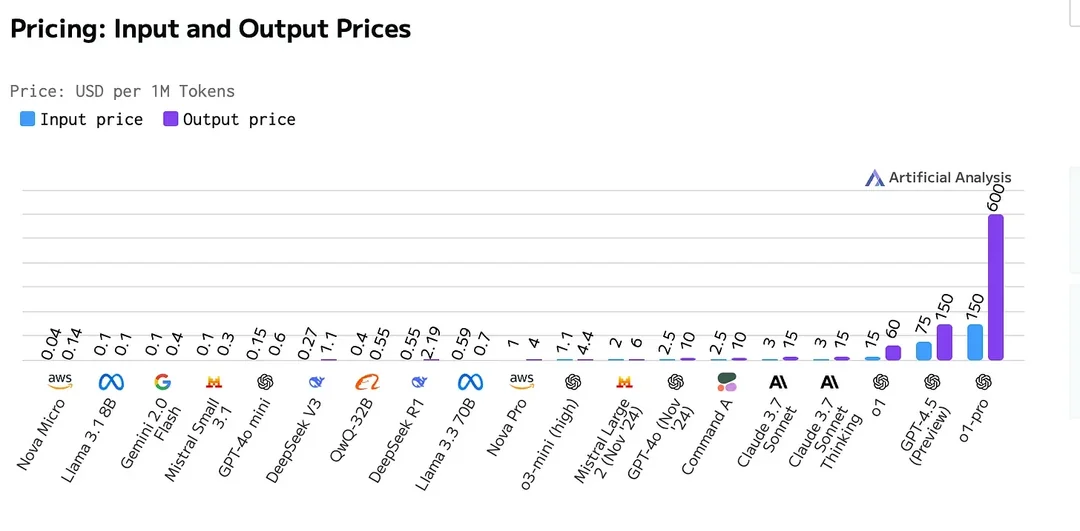

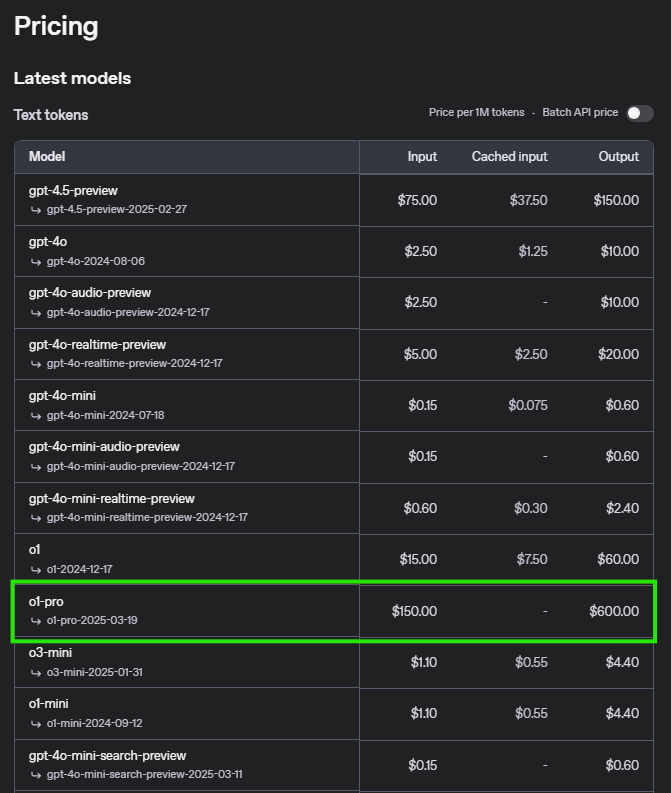

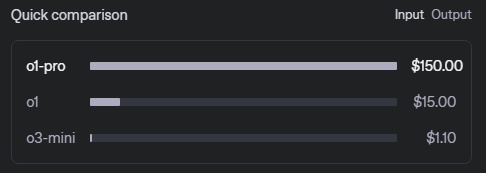

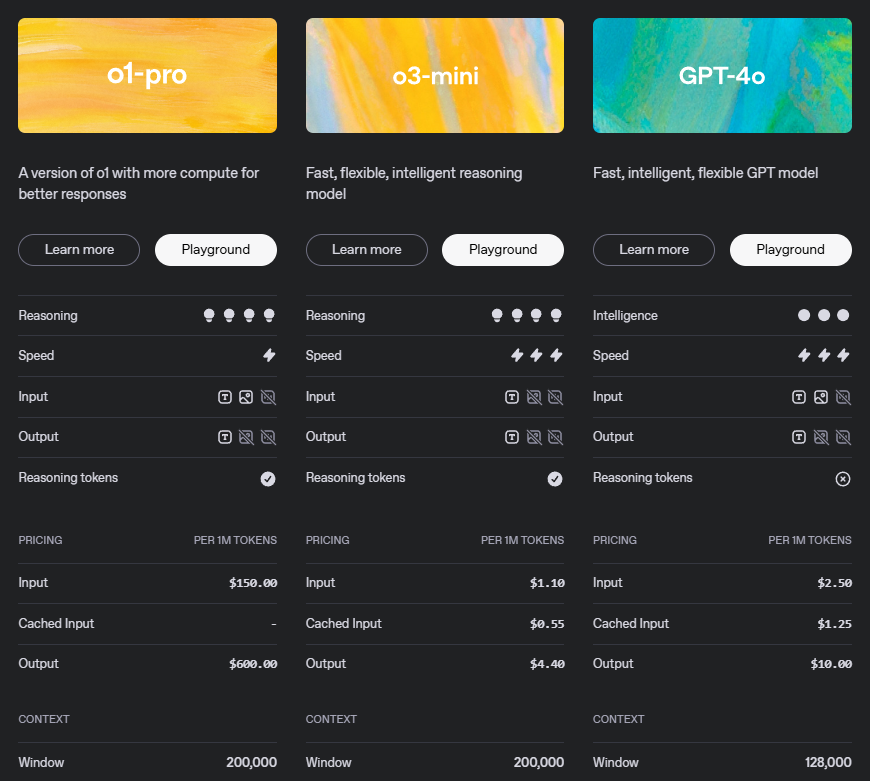

o1-pro API Preisgestaltung

Das Verständnis der Preisstruktur ist für die Planung Ihrer API-Nutzung unerlässlich. Hier ist die detaillierte Aufschlüsselung für o1-pro:

Dieses Preismodell spiegelt die anspruchsvollen Fähigkeiten von o1-pro wider, insbesondere sein fortgeschrittenes Denken und die Ausgabequalität. Die höheren Kosten für Ausgabetoken erkennen den Wert der strukturierten, gut begründeten Antworten an, die das Modell generiert.

Preisbeispiel-Szenarien

| Operation | Preis |

|---|---|

| Eingabe (Prompt) | $5 pro Million Token |

| Ausgabe (Fertigstellung) | $15 pro Million Token |

Szenario 1: Geringfügige Nutzung

Für ein Szenario mit 500.000 Eingabe-Token und 200.000 Ausgabe-Token:

- Eingabekosten: 500.000 Token × 5/Million Token = 2,50

- Ausgabekosten: 200.000 Token × 15/Million Token = 3,00

- Gesamtkosten: $5,50

Szenario 2: Mittlere Nutzung

Für ein Szenario mit 5 Millionen Eingabe-Token und 2 Millionen Ausgabe-Token:

- Eingabekosten: 5.000.000 Token × 5/Million Token = 25,00

- Ausgabekosten: 2.000.000 Token × 15/Million Token = 30,00

- Gesamtkosten: $55,00

Szenario 3: Umfangreiche Nutzung

Für ein Szenario mit 50 Millionen Eingabe-Token und 20 Millionen Ausgabe-Token:

- Eingabekosten: 50.000.000 Token × 5/Million Token = 250,00

- Ausgabekosten: 20.000.000 Token × 15/Million Token = 300,00

- Gesamtkosten: $550,00

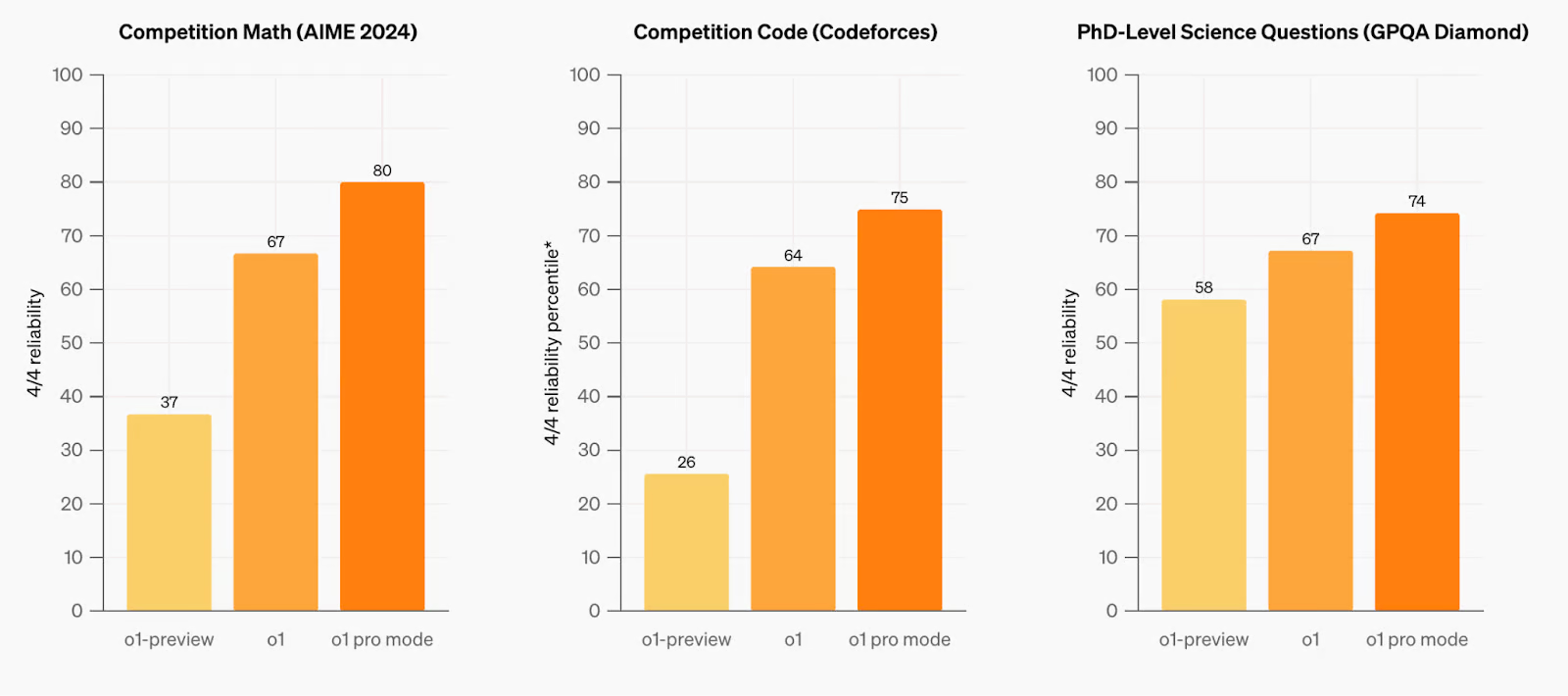

Vergleich mit früheren Modellen

o1-pro zeigt bemerkenswerte Fortschritte in Bezug auf Denken, Problemlösung und das Verständnis langer Kontexte. Das Modell wurde anhand verschiedener Benchmarks rigoros getestet und zeigt Verbesserungen gegenüber seinen Vorgängern bei der Bearbeitung komplexer Abfragen und mehrstufiger Denkaufgaben. In Schlüsselbereichen wie Mathematik, Programmierung und strukturierter Planung zeigt o1-pro eine verbesserte Genauigkeit und Zuverlässigkeit und übertrifft frühere Modelle sowohl in Bezug auf Leistung als auch Effizienz. Seine optimierte Architektur ermöglicht ein besseres Verständnis komplizierter Prompts, was es zu einem starken Kandidaten für erweiterte Anwendungen macht, die Denken auf hohem Niveau und erweiterte Kontextfähigkeiten erfordern.

Sie finden den vollständigen Vergleich der OpenAI-Modelle, einschließlich detaillierter Spezifikationen und Benchmarks, auf der offiziellen OpenAI-Dokumentationsseite.

OpenAI O1 Pro API Anforderungen und Ratenlimits

| Stufe | Qualifikation | Nutzungslimits |

|---|---|---|

| Kostenlos | Der Benutzer muss sich in einer zulässigen Geografie befinden | $100/Monat |

| Stufe 1 | $5 bezahlt | $100/Monat |

| Stufe 2 | $50 bezahlt und 7+ Tage seit der ersten erfolgreichen Zahlung | $500/Monat |

| Stufe 3 | $100 bezahlt und 7+ Tage seit der ersten erfolgreichen Zahlung | $1.000/Monat |

| Stufe 4 | $250 bezahlt und 14+ Tage seit der ersten erfolgreichen Zahlung | $5.000/Monat |

| Stufe 5 | $1.000 bezahlt und 30+ Tage seit der ersten erfolgreichen Zahlung | $50.000/Monat |

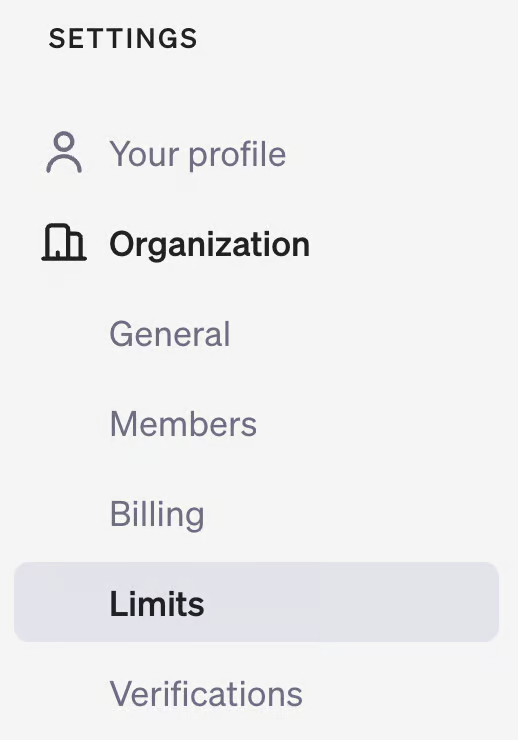

Um Ihre Nutzungsebene zu überprüfen, besuchen Sie Ihre Kontoseite auf der OpenAI-Entwicklerplattform und überprüfen Sie den Abschnitt "Limits" unter "Organisation".

Wie man 01 API verwendet

Die Implementierung von o1-pro in Ihren Anwendungen ist unkompliziert. Befolgen Sie diese Schritte, um zu beginnen:

1. Voraussetzungen

- Ein OpenAI-API-Schlüssel (erhalten Sie ihn von Ihrem OpenAI-Dashboard)

- Eine kompatible Entwicklungsumgebung mit geeigneten Bibliotheken

- Ausreichend API-Guthaben oder eine mit Ihrem OpenAI-Konto verknüpfte Zahlungsmethode

2. Installation

Installieren Sie die OpenAI-Bibliothek für Ihre bevorzugte Programmiersprache:

Für Python:

pip install openai

Für JavaScript:

npm install openai

Für andere Sprachen lesen Sie bitte die offizielle Dokumentation von OpenAI für Client-Bibliotheken.

3. Python-Implementierungsbeispiel

So verwenden Sie o1-pro in Python mit detaillierten Parametern:

from openai import OpenAI

client = OpenAI(api_key="your-api-key")

response = client.chat.completions.create(

model="o1-pro",

messages=[

{"role": "system", "content": "Sie sind ein KI-Assistent, der sich auf mathematisches Denken spezialisiert hat. Stellen Sie klare, schrittweise Lösungen mit Erklärungen für jeden Schritt bereit."},

{"role": "user", "content": "Lösen Sie dieses Kalkülproblem Schritt für Schritt: Finden Sie die Ableitung von f(x) = x^3*ln(x)."}

],

temperature=0.1, # Niedrigere Temperatur für präziseres Denken

max_tokens=1024, # Anpassen basierend auf der erwarteten Antwortlänge

top_p=0.95,

frequency_penalty=0,

presence_penalty=0

)

print(response.choices[0].message.content)

4. JavaScript-Implementierungsbeispiel

Für Node.js-Anwendungen mit detaillierterer Konfiguration:

import OpenAI from 'openai';

const openai = new OpenAI({

apiKey: 'your-api-key',

});

async function askO1Pro() {

try {

const response = await openai.chat.completions.create({

model: 'o1-pro',

messages: [

{role: 'system', content: 'Sie sind ein KI-Assistent, der sich auf mathematisches Denken spezialisiert hat. Stellen Sie klare, schrittweise Lösungen mit Erklärungen für jeden Schritt bereit.'},

{role: 'user', content: 'Lösen Sie dieses Kalkülproblem Schritt für Schritt: Finden Sie die Ableitung von f(x) = x^3*ln(x).'}

],

temperature: 0.1,

max_tokens: 1024,

top_p: 0.95,

frequency_penalty: 0,

presence_penalty: 0

});

console.log(response.choices[0].message.content);

// Optional: Token-Nutzung verfolgen

console.log("Prompt-Token:", response.usage.prompt_tokens);

console.log("Completion-Token:", response.usage.completion_tokens);

console.log("Gesamt-Token:", response.usage.total_tokens);

} catch (error) {

console.error('Fehler:', error);

}

}

askO1Pro();

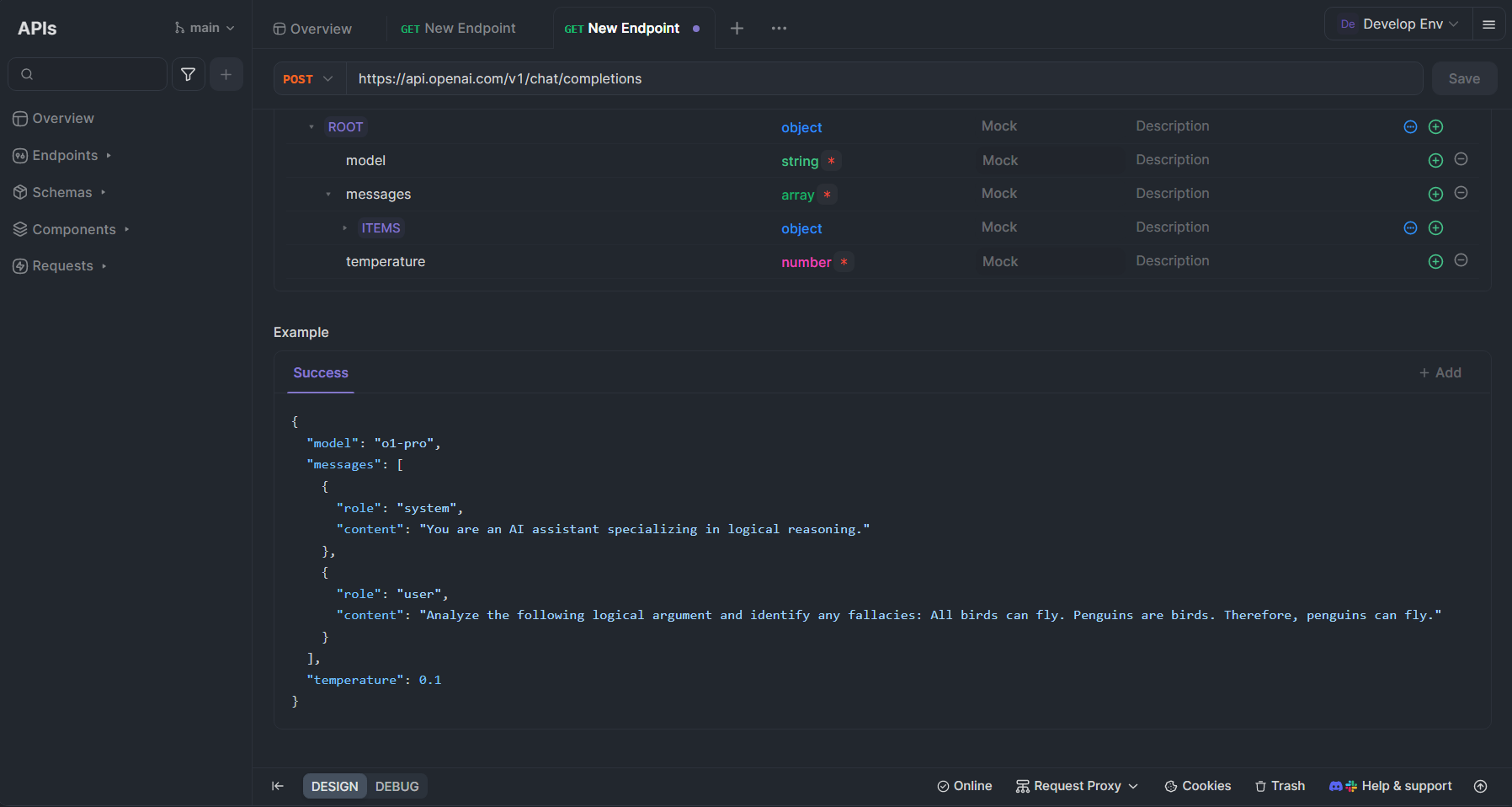

Testen der o1-pro API mit Apidog

Apidog ist eine umfassende API-Entwicklungsplattform, die Ihre Arbeit mit o1-pro und anderen OpenAI-APIs erheblich rationalisieren kann. So können Sie Apidog für das Testen und die Integration von o1-pro in Ihren Workflow nutzen:

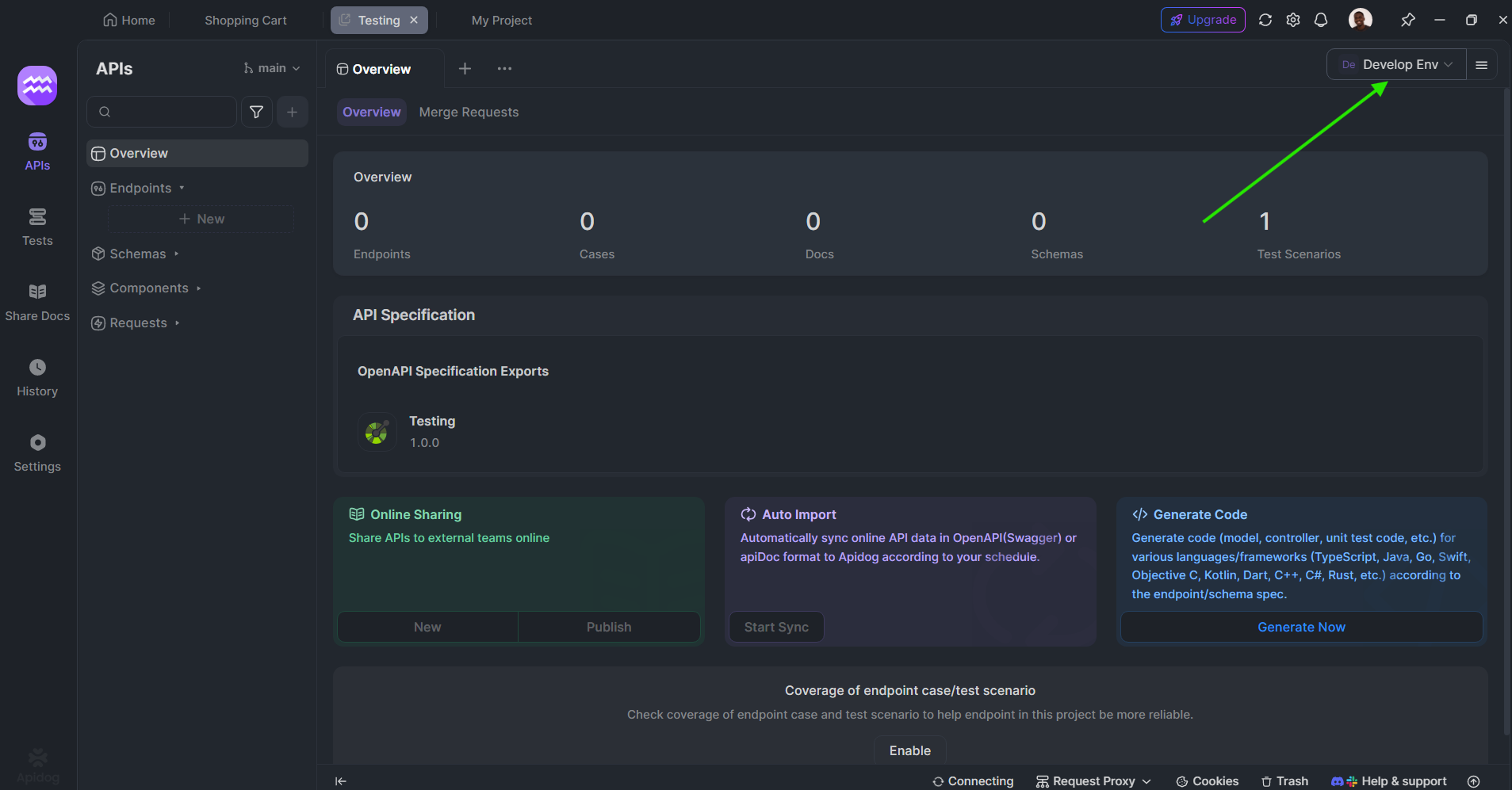

Einrichten von o1-pro in Apidog

- Erstellen Sie ein Konto: Melden Sie sich für Apidog unter apidog.com an, falls Sie noch kein Konto haben.

- Erstellen Sie eine neue API-Sammlung: Erstellen Sie in Ihrem Apidog-Dashboard eine neue Sammlung speziell für OpenAI-APIs.

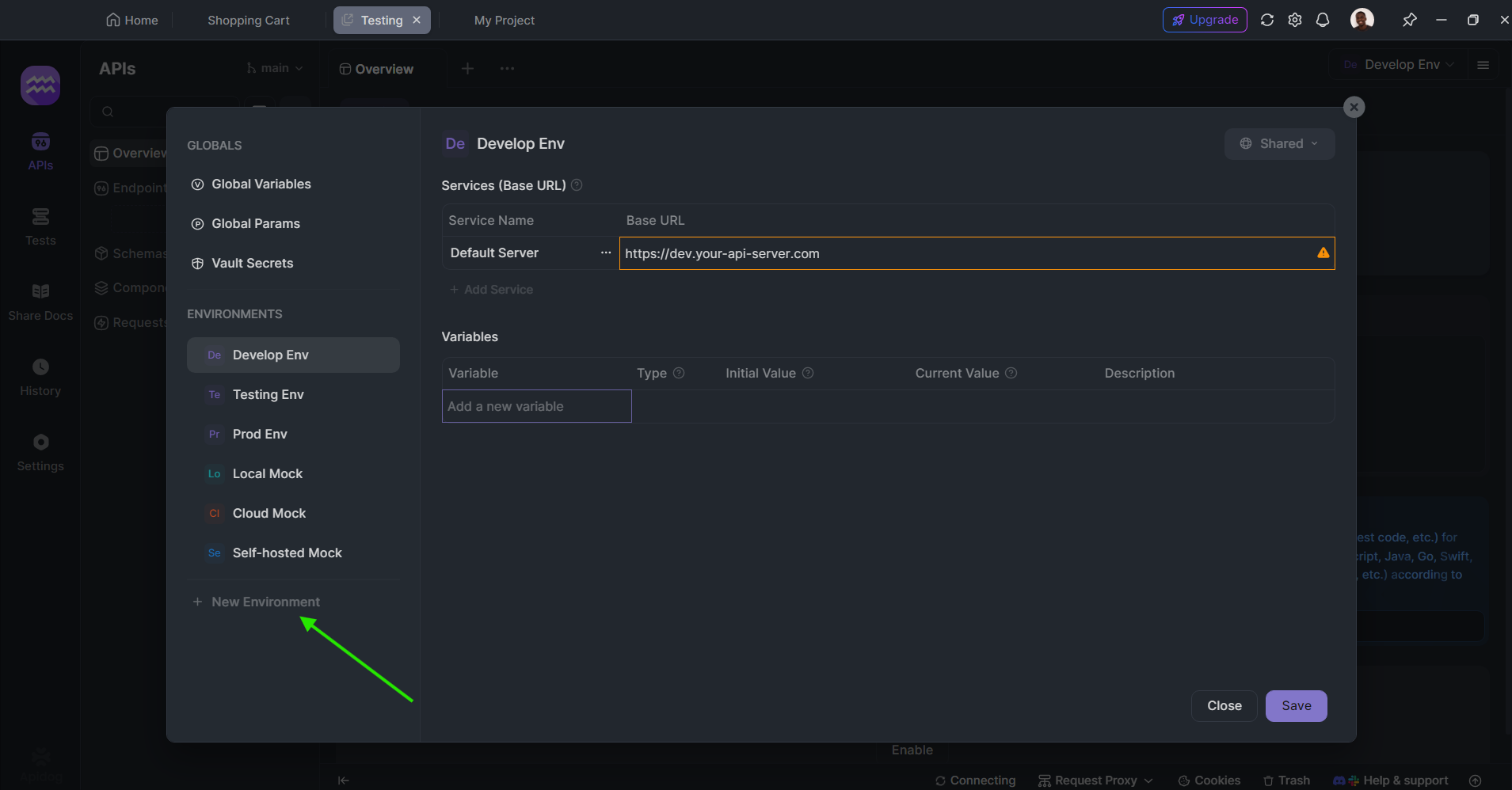

Umgebungsvariablen festlegen: Konfigurieren Sie Ihren OpenAI-API-Schlüssel als Umgebungsvariable für einen sicheren und bequemen Zugriff:

- Gehen Sie in die obere rechte Ecke zu Umgebungen

- Erstellen Sie eine neue Umgebung namens "OpenAI"

- Fügen Sie eine Variable namens "OPENAI_API_KEY" mit Ihrem tatsächlichen API-Schlüssel als Wert hinzu

Erstellen Sie eine Anfrage für o1-pro:

- Erstellen Sie eine neue POST-Anfrage

- Setzen Sie die URL auf

https://api.openai.com/v1/chat/completions - Fügen Sie einen Authorization-Header mit dem Wert

Bearer {{OPENAI_API_KEY}}hinzu - Verwenden Sie im Anfragetext (JSON):

{

"model": "o1-pro",

"messages": [

{

"role": "system",

"content": "Sie sind ein KI-Assistent, der sich auf logisches Denken spezialisiert hat."

},

{

"role": "user",

"content": "Analysieren Sie das folgende logische Argument und identifizieren Sie etwaige Fehlschlüsse: Alle Vögel können fliegen. Pinguine sind Vögel. Daher können Pinguine fliegen."

}

],

"temperature": 0.1

}

Vorteile der Verwendung von Apidog mit o1-pro

Apidog bietet mehrere Vorteile für die Arbeit mit o1-pro:

- Interaktives Testen: Testen Sie API-Aufrufe in Echtzeit und sehen Sie formatierte Antworten, wodurch das Iterieren über Prompts erleichtert wird.

- Automatische Dokumentation: Dokumentieren Sie Ihre API-Implementierungen automatisch, wodurch die Zusammenarbeit im Team erleichtert wird.

- API-Mocking: Erstellen Sie Mock-Antworten für o1-pro-API-Aufrufe während der Entwicklung.

- Zusammenarbeitsfunktionen: Teilen Sie API-Sammlungen mit Teammitgliedern für die gemeinsame Entwicklung.

- Umgebungsverwaltung: Wechseln Sie einfach zwischen Entwicklungs-, Staging- und Produktionsumgebungen mit verschiedenen API-Schlüsseln.

- Antwortvisualisierung: Erhalten Sie eine klare visuelle Darstellung der Token-Nutzung und -Kosten für ein besseres Budgetmanagement.

- Anfrageverlauf: Behalten Sie den Überblick über frühere API-Aufrufe zur Referenz und Optimierung.

Best Practices für die Verwendung von o1-pro-APIs

Um die Effektivität von o1-pro zu maximieren und Ihre Kosten zu optimieren:

- Strukturieren Sie Ihre Prompts klar: Strukturieren Sie für komplexe Denkaufgaben Ihre Prompts mit klaren Anweisungen und erwarteten Ergebnissen. Erwägen Sie die Verwendung von Aufzählungspunkten oder nummerierten Anweisungen für mehrteilige Probleme.

- Verwenden Sie Systemnachrichten effektiv: Legen Sie den Kontext mit Systemnachrichten fest, um o1-pro auf den gewünschten Denkansatz zu lenken. Seien Sie spezifisch in Bezug auf die Art des Denkens (deduktiv, induktiv usw.), die Sie erwarten.

Passen Sie die Temperaturparameter an:

- Niedrigere Temperatur (0,1-0,3) für präziseres, deterministisches Denken und mathematische Probleme

- Moderate Temperatur (0,3-0,7) für ausgewogenes Denken mit etwas Flexibilität

- Höhere Temperatur für kreativere Problemlösungsansätze

- Fordern Sie schrittweises Denken an: Bitten Sie explizit um detaillierte Denkschritte, wenn Sie komplexe Probleme lösen. Formulierungen wie "Denken Sie dies Schritt für Schritt durch" oder "Zeigen Sie Ihre Denkweise" helfen, die Stärken von o1-pro zu aktivieren.

- Überwachen Sie die Token-Nutzung: Behalten Sie die Eingabe- und Ausgabetoken im Auge, um die Kosten effektiv zu verwalten. Erwägen Sie die Implementierung einer Token-Schätzfunktion in Ihrer Anwendung.

- Stapeln Sie verwandte Abfragen: Kombinieren Sie nach Möglichkeit verwandte Fragen in einem einzigen API-Aufruf, anstatt mehrere separate Aufrufe zu tätigen.

- Implementieren Sie Caching: Zwischenspeichern Sie häufige Antworten, um redundante API-Aufrufe für häufig angeforderte Informationen zu vermeiden.

- Verwenden Sie Chain-of-Thought-Techniken: Implementieren Sie bei komplexen Problemen Chain-of-Thought-Prompts, indem Sie das Modell bitten, "Schritt für Schritt über dieses Problem nachzudenken, bevor Sie die endgültige Antwort geben".

Fazit

o1-pro stellt einen bedeutenden Fortschritt in den KI-Denkfähigkeiten dar und bietet leistungsstarke Werkzeuge für Aufgaben, die strukturiertes Denken und komplexe Problemlösung erfordern. Mit seiner wettbewerbsfähigen Preisstruktur und der unkomplizierten Implementierung ist es für Entwickler zugänglich, die ihre Anwendungen mit erweiterten Denkfähigkeiten verbessern möchten.

Indem Sie die in diesem Artikel beschriebenen Implementierungsrichtlinien und Best Practices befolgen, können Sie o1-pro effektiv in Ihre Workflows integrieren und seine ausgefeilten Denkfähigkeiten nutzen und gleichzeitig Ihre API-Kosten effizient verwalten. Tools wie Apidog rationalisieren den Entwicklungs- und Testprozess weiter und erleichtern es, das volle Potenzial von o1-pro für Ihre spezifischen Anwendungsfälle auszuschöpfen.

Da sich die KI-Denkfähigkeiten ständig weiterentwickeln, werden Modelle wie o1-pro zunehmend zu wesentlichen Bestandteilen von Anwendungen, die nicht nur Intelligenz, sondern auch strukturiertes, logisches Denken erfordern, dem Benutzer folgen und verstehen können.