Möchten Sie mit leistungsstarken Sprachmodellen wie Llama 3.1 oder Mistral chatten, ohne in einer Terminalumgebung festzustecken? Open WebUI ist Ihr Ticket zu einer eleganten, ChatGPT-ähnlichen Oberfläche, die die Interaktion mit Ollamas LLMs unterhaltsam und intuitiv macht. Es ermöglicht Ihnen, Chat-Verläufe zu speichern, Prompts zu speichern und sogar Dokumente hochzuladen, um intelligentere Antworten zu erhalten – alles in Ihrem Browser. In diesem anfängerfreundlichen Leitfaden führe ich Sie durch die Installation von Ollama, das Testen eines Modells im Terminal und dann das Aufleveln mit Open WebUI für eine benutzerfreundlichere Erfahrung. Wir verwenden Docker für ein schnelles Setup und testen es mit einem unterhaltsamen Prompt. Bereit, KI-Chats zum Kinderspiel zu machen? Legen wir los!

Was ist Open WebUI? Ihr LLM-Kommandozentrum

Open WebUI ist eine Open-Source-, selbst gehostete Weboberfläche, die sich mit Ollama verbindet und es Ihnen ermöglicht, mit großen Sprachmodellen (LLMs) wie Llama 3.1 oder Mistral in einem browserbasierten Dashboard zu interagieren. Im Gegensatz zur Befehlszeilenschnittstelle von Ollama fühlt sich Open WebUI wie ChatGPT an und bietet:

- Chat-Verlauf: Speichern und wiederaufrufen Ihrer Unterhaltungen.

- Prompt-Speicherung: Speichern und Wiederverwenden Ihrer bevorzugten Prompts.

- Dokument-Uploads: Fügen Sie Dateien für kontextbezogene Antworten hinzu (Retrieval-Augmented Generation oder RAG).

- Modellwechsel: Einfaches Wechseln zwischen Modellen mit einem Klick.

Mit über 50.000 GitHub-Sternen ist Open WebUI ein Hit für Entwickler und KI-Enthusiasten, die eine kollaborative, grafische Möglichkeit suchen, lokal mit LLMs zu arbeiten. Lassen Sie uns zunächst Ollama zum Laufen bringen, um zu sehen, warum Open WebUI das Hinzufügen wert ist!

Installieren und Testen von Ollama

Bevor wir uns in Open WebUI stürzen, richten wir Ollama ein und testen ein Modell wie Llama 3.1 oder Mistral im Terminal. Dies gibt Ihnen eine Grundlage, um die intuitive Benutzeroberfläche von Open WebUI zu schätzen.

1. Systemanforderungen prüfen:

- OS: Windows, macOS oder Linux (Ubuntu 24.04 oder ähnlich).

- Hardware: Mindestens 16 GB RAM und 10 GB freier Speicher für Modelle (Llama 3.1 8B benötigt ~5 GB). Eine GPU (z. B. NVIDIA 1060 4GB) ist optional für eine schnellere Leistung.

- Software: Ollama, herunterladbar von ollama.com.

2. Ollama installieren: Laden Sie Ollama von ollama.com für Ihr Betriebssystem herunter und installieren Sie es. Befolgen Sie die Installationsaufforderungen – es ist ein schnelles Setup. Überprüfen Sie die Installation mit:

ollama --version

Erwarten Sie eine Version wie 0.1.44 (April 2025). Wenn es fehlschlägt, stellen Sie sicher, dass Ollama in Ihrem PATH ist.

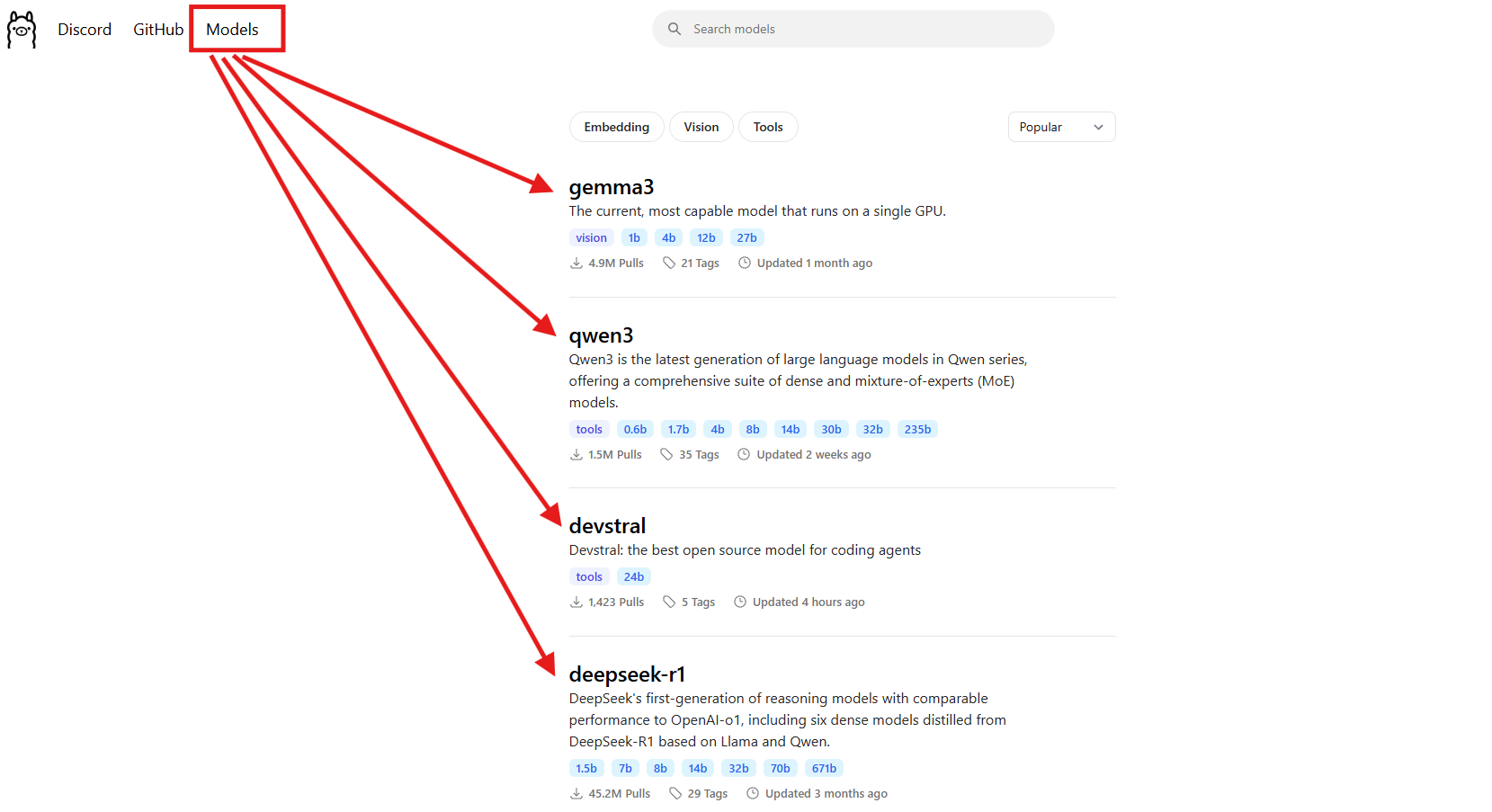

3. Ein Modell herunterladen: Wählen Sie ein Modell wie Llama 3.1 (8B) oder Mistral (7B). Für diesen Leitfaden verwenden wir Llama 3.1:

ollama pull llama3.1

Dies lädt ~5 GB herunter, also holen Sie sich einen Kaffee, wenn Ihr Internet langsam ist. Überprüfen Sie, ob es installiert ist:

ollama list

Suchen Sie nach llama3.1:latest. Mistral (ollama pull mistral) ist eine weitere großartige Option, wenn Sie ein leichteres Modell (~4 GB) wünschen.

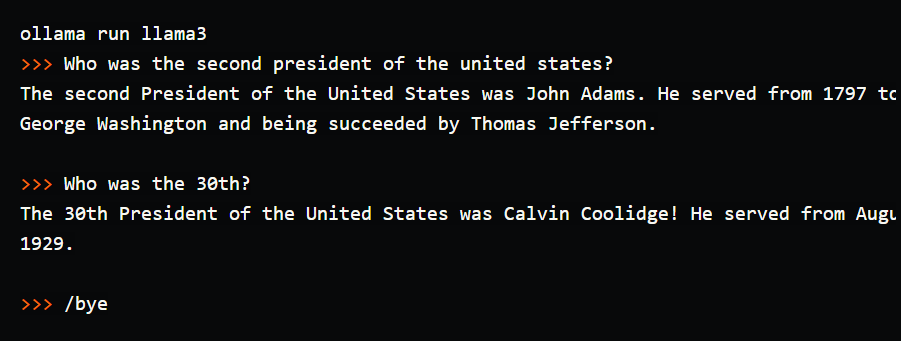

4. Testen Sie das Modell im Terminal: Probieren Sie einen einfachen Prompt aus, um Ollama in Aktion zu sehen:

ollama run llama3.1

Geben Sie am Prompt (>>>) Folgendes ein: „Erzähl mir einen Papa-Witz über Computer.“ Drücken Sie die Eingabetaste. Möglicherweise erhalten Sie: „Warum ging der Computer zum Arzt? Er hatte einen Virus!“ Beenden Sie mit /bye. Ich habe dies ausgeführt und einen zum Schmunzeln anregenden Witz erhalten, aber das Tippen im Terminal fühlte sich umständlich an – kein Chat-Verlauf, keine gespeicherten Prompts. Hier glänzt Open WebUI und bietet eine visuelle Oberfläche, um Unterhaltungen zu speichern, Prompts wiederzuverwenden und Dokumente hochzuladen, um reichhaltigere Antworten zu erhalten. Richten wir es ein!

Einrichten Ihrer Umgebung für Open WebUI

Nachdem Sie die Terminaloberfläche von Ollama gesehen haben, bereiten wir uns auf Open WebUI vor, um Ihre LLM-Erfahrung intuitiver zu gestalten. Wir gehen davon aus, dass Sie Docker installiert haben, da dies für die Einrichtung von Open WebUI erforderlich ist.

1. Docker überprüfen: Stellen Sie sicher, dass Docker installiert ist und ausgeführt wird:

docker --version

Erwarten Sie so etwas wie Docker 27.4.0. Wenn Sie Docker nicht haben, laden Sie Docker Desktop von der offiziellen Website herunter und installieren Sie es – es ist ein schnelles Setup für Windows, macOS oder Linux.

2. Erstellen Sie einen Projektordner: Halten Sie die Dinge organisiert:

mkdir ollama-webui

cd ollama-webui

Dieser Ordner ist Ihre Basis für die Ausführung von Open WebUI.

3. Stellen Sie sicher, dass Ollama ausgeführt wird: Starten Sie Ollama in einem separaten Terminal:

ollama serve

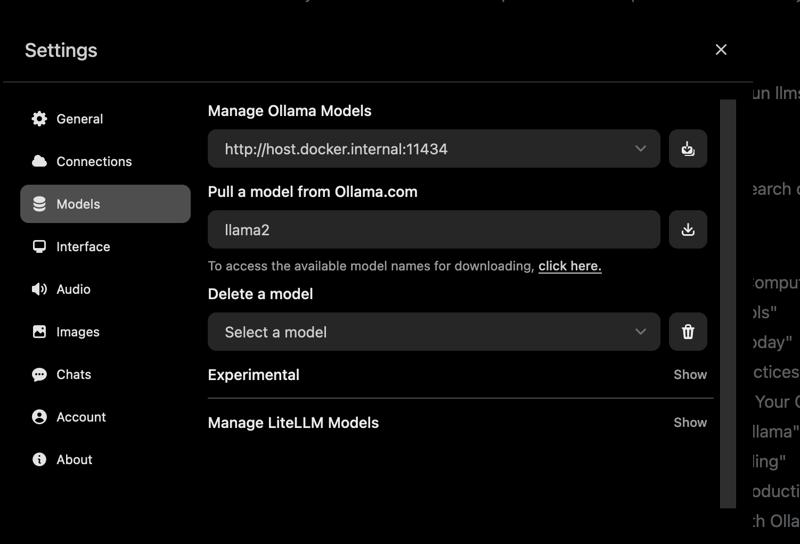

Dies führt die API von Ollama unter http://localhost:11434 aus. Lassen Sie dieses Terminal geöffnet, da Open WebUI es benötigt, um sich mit Ihren Modellen zu verbinden.

Installieren von Open WebUI mit Docker

Mit Ollama und Llama 3.1 bereit, installieren wir Open WebUI mit einem einzigen Docker-Befehl für ein schnelles, zuverlässiges Setup.

1. Open WebUI ausführen: Führen Sie in Ihrem Ordner ollama-webui Folgendes aus:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

Dieser Befehl:

- Ruft das Open WebUI-Image ab (

ghcr.io/open-webui/open-webui:main, ~3,77 GB). - Ordnet Port 3000 (lokal) Port 8080 (Container) für den Browserzugriff zu.

- Fügt

host.docker.internalhinzu, um sich mit der API von Ollama unterlocalhost:11434zu verbinden. - Verwendet ein Volume (

open-webui), um den Chat-Verlauf und die Einstellungen beizubehalten. - Benennt den Container

open-webuiund stellt ihn so ein, dass er automatisch neu gestartet wird.

Das Herunterladen dauert eine Minute. Überprüfen Sie mit docker ps, ob es ausgeführt wird – suchen Sie nach dem Container open-webui.

2. Auf Open WebUI zugreifen: Öffnen Sie Ihren Browser und gehen Sie zu http://localhost:3000. Sie sehen die Willkommensseite von Open WebUI. Klicken Sie auf „Anmelden“, um ein Konto zu erstellen (der erste Benutzer erhält Administratorrechte). Verwenden Sie ein sicheres Passwort und speichern Sie es sicher. Sie sind jetzt bereit zum Chatten! Wenn die Seite nicht geladen wird, stellen Sie sicher, dass der Container ausgeführt wird (docker logs open-webui) und Port 3000 frei ist.

Verwenden von Open WebUI: Chatten und Erkunden von Funktionen

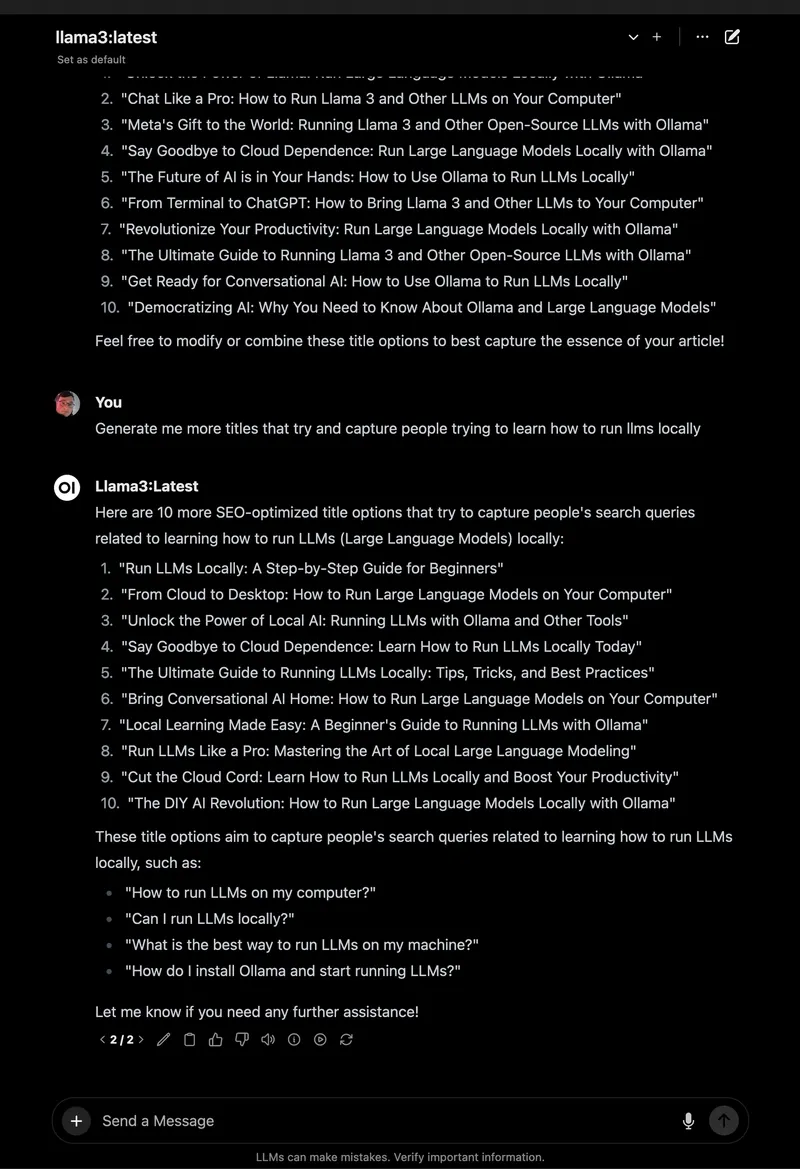

Wenn Open WebUI ausgeführt wird, tauchen wir in das Chatten mit Llama 3.1 ein und erkunden seine großartigen Funktionen, die es zu einem großen Upgrade gegenüber dem Terminal machen.

1. Mit dem Chatten beginnen:

- Wählen Sie in Open WebUI

llama3.1:8baus der Modellauswahl oben links aus (es sollte angezeigt werden, da Sie es abgerufen haben). - Klicken Sie in der Seitenleiste auf „Neuer Chat“.

- Geben Sie denselben Prompt ein: „Erzähl mir einen Papa-Witz über Computer.“

- Drücken Sie die Eingabetaste. Sie erhalten eine Antwort wie: „Warum ging der Computer zur Kunstschule? Weil er lernen wollte, ein besseres Byte zu zeichnen!“

Die Benutzeroberfläche ist sauber, wobei Ihr Prompt und Ihre Antwort automatisch im Chat-Verlauf gespeichert werden.

2. Chats speichern und organisieren: Klicken Sie in der linken Seitenleiste auf das Pinsymbol, um den Chat zu speichern. Benennen Sie ihn um (z. B. „Papa-Witze“), um einen einfachen Zugriff zu ermöglichen. Sie können Chats über die Seitenleiste archivieren oder löschen und so Ihre Experimente organisiert halten – viel besser als das Scrollen im Terminal!

3. Prompts speichern: Speichern Sie den Papa-Witz-Prompt zur Wiederverwendung:

- Gehen Sie zu Einstellungen > Prompts.

- Klicken Sie auf „Neuer Prompt“, benennen Sie ihn „Papa-Witz“ und fügen Sie Folgendes ein: „Erzähl mir einen Papa-Witz über Computer.“

- Speichern. Jetzt können Sie ihn mit einem Klick in jedem Chat anwenden.

4. Ein Dokument für RAG hochladen: Fügen Sie Ihren Chats Kontext hinzu:

- Klicken Sie auf das „#“-Symbol in der Chateingabe, um die Dokumentbibliothek zu öffnen.

- Laden Sie eine Textdatei hoch (z. B. einen Spring Boot 3.2-Leitfaden).

- Fragen Sie: „Wie verwende ich den REST Client in Spring Boot 3.2?“ Llama 3.1 verweist auf das Dokument und gibt ein Code-Snippet wie

RestClient.create().get().uri("/users").retrieve()aus.

Ich habe dies mit einem Python-Tutorial-PDF getestet, und Open WebUI hat kontextbezogene Antworten perfekt getroffen, im Gegensatz zu den grundlegenden Antworten des Terminals.

5. Weitere Funktionen erkunden:

- Modelle wechseln: Verwenden Sie die Modellauswahl, um Mistral oder andere Modelle auszuprobieren, die Sie abgerufen haben (

ollama pull mistral). - Antworten anpassen: Klicken Sie auf „Chat-Steuerung“, um den Ton (z. B. „lustig“) oder die Länge anzupassen.

- Admin-Tools: Verwalten Sie in Einstellungen > Admin Benutzer oder schränken Sie den Modellzugriff ein (ideal für Teams).

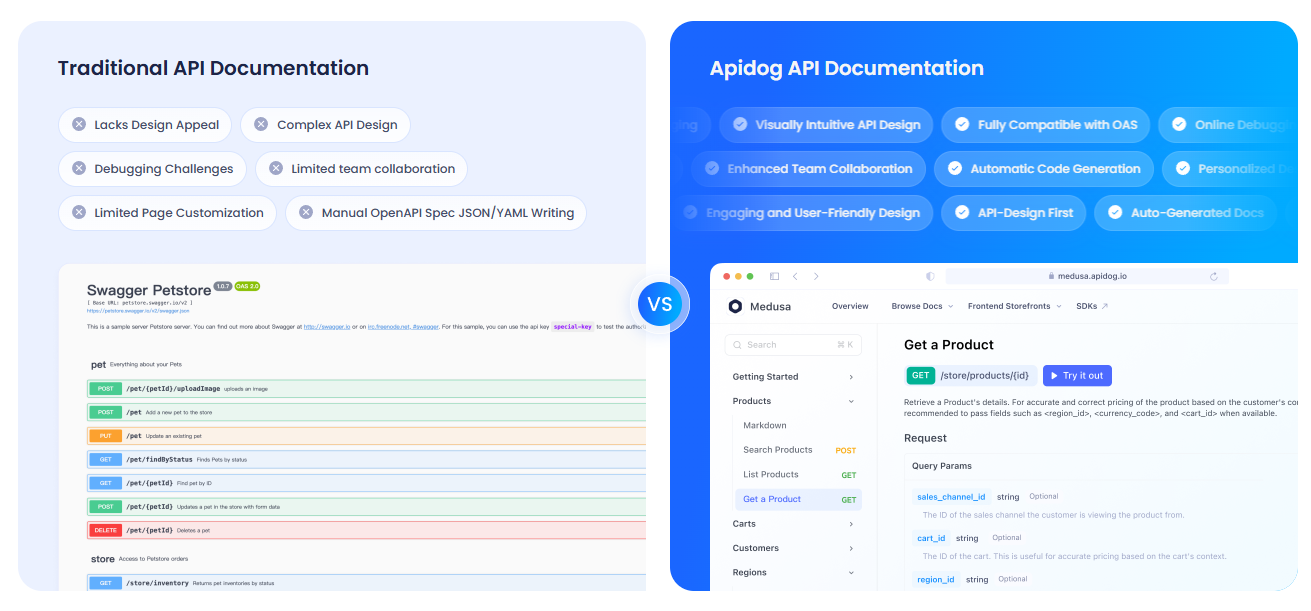

Dokumentieren Ihrer APIs mit APIdog

Verwenden Sie Open WebUI, um mit der API von Ollama zu interagieren, und möchten Sie Ihr Setup dokumentieren? APIdog ist ein fantastisches Tool zum Erstellen interaktiver API-Dokumentation. Die elegante Benutzeroberfläche und die Self-Hosting-Optionen machen es ideal für das Teilen Ihrer KI-Projekte – probieren Sie es aus!

Fehlerbehebung und Tipps

- Verbindungsprobleme: Wenn Open WebUI Ollama nicht finden kann, stellen Sie sicher, dass

ollama serveausgeführt wird und Port 11434 geöffnet ist. Überprüfen Sie die Docker-Protokolle:docker logs open-webui. - Portkonflikte: Wenn Port 3000 belegt ist, stoppen Sie den Container (

docker stop open-webui), entfernen Sie ihn (docker rm open-webui) und führen Sie den Befehldocker runmit einem neuen Port erneut aus (z. B.-p 3001:8080). - Langsame Antworten: Verwenden Sie eine GPU mit den

:cuda-Tags von Ollama oder kleinere Modelle wie Mistral für Geschwindigkeit. - Community: Treten Sie den GitHub-Diskussionen oder Discord von Open WebUI bei, um Unterstützung und Ideen zu erhalten.

Warum Open WebUI wählen?

Open WebUI verwandelt Ollama von einem umständlichen Terminal-Tool in eine leistungsstarke, benutzerfreundliche Plattform:

- Intuitive Benutzeroberfläche: Das browserbasierte Dashboard ist perfekt für Anfänger und Profis.

- Organisation: Gespeicherte Chats und Prompts halten Ihre Arbeit ordentlich, im Gegensatz zu Terminalprotokollen.

- Kontextbewusstsein: Dokument-Uploads ermöglichen RAG für intelligentere Antworten.

- Datenschutz: Wird lokal ausgeführt und schützt Ihre Daten.

Nachdem ich sowohl das Terminal als auch Open WebUI getestet habe, bin ich von der Benutzerfreundlichkeit und den Funktionen der GUI überzeugt. Es ist wie ein Upgrade von einem Klapphandy auf ein Smartphone!

Zusammenfassung: Ihr Open WebUI-Abenteuer erwartet Sie

Sie sind von Terminal-Chats zu einem vollständigen Open WebUI-Setup mit Ollama übergegangen und machen LLM-Interaktionen reibungslos und unterhaltsam! Mit Llama 3.1, gespeicherten Chats und Dokument-Uploads sind Sie bereit, KI wie nie zuvor zu erkunden. Probieren Sie neue Modelle aus, speichern Sie mehr Prompts oder dokumentieren Sie Ihre APIs mit APIdog. Teilen Sie Ihre Open WebUI-Erfolge auf dem Open WebUI GitHub – ich bin gespannt, was Sie erstellen! Viel Spaß beim KI-Tüfteln!