Wenn Sie Ihrem Kleinkind jemals Ihr Smartphone in die Hand gegeben und beobachtet haben, wie es jede Taste antippt, willkürlich wischt und es irgendwie schafft, Ihre App innerhalb von 30 Sekunden zum Absturz zu bringen, dann haben Sie gerade Monkey Testing in seiner reinsten Form erlebt. Es mag chaotisch, ja fast unverantwortlich wirken, doch gerade dieses Chaos deckt Fehler auf, die bei strukturierten Tests übersehen werden. Die Zufälligkeit, die Monkey Testing undiszipliniert erscheinen lässt, ist genau das, was es so wertvoll macht.

Professionelle Qualitätssicherungsteams setzen Monkey Testing strategisch und nicht sorglos ein. Sie nutzen es, um Speicherlecks, unbehandelte Ausnahmen und Systemabstürze zu entdecken, die nur auftreten, wenn die Software unvorhersehbaren Eingabesequenzen ausgesetzt ist. Dieser Leitfaden zeigt Ihnen, wie Sie Monkey Testing richtig nutzen, seine Typen verstehen und es sinnvoll in Ihre QA-Strategie integrieren.

Was genau ist Monkey Testing?

Monkey Testing ist eine Softwaretesttechnik, bei der Sie einer Anwendung zufällige, unerwartete oder ungültige Eingaben geben und beobachten, wie sie sich verhält. Der Name leitet sich vom unendlichen Affentheorem ab: Wenn ein Affe lange genug zufällig auf einer Tastatur tippt, wird er irgendwann einen sinnvollen Text produzieren. Beim Testen ist der „Affe“ ein Programm oder menschlicher Tester, der die Anwendung ohne vorgegebene Testfälle ausführt.

Im Gegensatz zu strukturierten Tests validiert Monkey Testing keine Anforderungen. Es stellt eine einfachere, aber entscheidende Frage: Kann die Anwendung Chaos bewältigen, ohne abzustürzen? Dieser Ansatz ist hervorragend geeignet, um Folgendes zu finden:

- Speicherlecks durch wiederholte Operationen

- Unbehandelte Ausnahmen durch ungültige Datenkombinationen

- Race Conditions in asynchronen Prozessen

- UI-Einfrierungen durch schnelle Benutzerinteraktionen

- Sicherheitslücken durch fehlerhafte Eingaben

Die Technik ist besonders wertvoll für mobile Apps, Webanwendungen und APIs, die im Produktivbetrieb unvorhersehbarem Benutzerverhalten ausgesetzt sind.

Die drei Typen des Monkey Testing: Dummes, Intelligentes und Brillantes

Nicht jedes Monkey Testing ist gleich. Die Technik existiert auf einem Spektrum von völlig zufällig bis intelligent geführt.

1. Dummes Monkey Testing

Dummes Monkey Testing ist reine Zufälligkeit. Das Testwerkzeug weiß nichts über die Anwendung. Es klickt auf zufällige Koordinaten, gibt Kauderwelsch ein und sendet fehlerhafte Daten. Es kann Fehler nicht erkennen, nicht absichtlich navigieren oder sein Verhalten anpassen.

Vorteile: Minimaler Einrichtungsaufwand, findet unerwartete Abstürze, geringer Wartungsaufwand

Nachteile: Verpasst kritische Pfade, erzeugt viele irrelevante Tests, kann Korrektheit nicht überprüfen

Am besten geeignet für: Stresstests der UI-Robustheit, frühe explorative Tests

Ein dummer Affe könnte den „Senden“-Button 1.000 Mal klicken, ohne Felder auszufüllen, und dabei einen Formularvalidierungsfehler aufdecken, der den Server zum Absturz bringt.

2. Intelligentes Monkey Testing

Intelligentes Monkey Testing kennt die Struktur der Anwendung. Es versteht gültige Eingabeformate, Navigationsbeschränkungen und erwartete Zustandsübergänge. Es agiert immer noch zufällig innerhalb dieser Grenzen, vermeidet aber offensichtlich ungültige Aktionen.

Vorteile: Relevantere Testszenarien, höhere Fehlererkennungsrate, berücksichtigt Geschäftsregeln

Nachteile: Erfordert anfängliche Konfiguration, benötigt aktualisierte Mappings bei UI-Änderungen

Am besten geeignet für: Regressionstests, Validierung der Workflow-Robustheit

Ein intelligenter Affe weiß, dass ein Kreditkartenfeld 16 Ziffern akzeptiert. Er gibt zufällige 16-stellige Zahlen ein (einige gültig, andere nicht), tippt aber keine Buchstaben oder Sonderzeichen.

3. Brillantes Monkey Testing

Brillantes Monkey Testing kombiniert Zufälligkeit mit Lernen. Es beobachtet das Anwendungsverhalten, merkt sich, welche Aktionen in der Vergangenheit zu Abstürzen geführt haben, und gewichtet zukünftige Tests zugunsten dieser anfälligen Bereiche. Es ist die ausgeklügeltste Form des Monkey Testing, die oft KI oder genetische Algorithmen verwendet.

Vorteile: Hoch effizient, passt sich an Anwendungsänderungen an, findet tiefsitzende Fehler

Nachteile: Komplexer Einrichtungsaufwand, erfordert spezielle Tools, höherer Ressourcenverbrauch

Am besten geeignet für: Reife Produkte, die tiefe Stabilitätstests benötigen, Sicherheits-Fuzzing

Ein brillanter Affe könnte entdecken, dass das Öffnen eines Modals, das Schließen und anschließende schnelle Drehen des Geräts ein Speicherleck verursacht. Er wiederholt dieses Muster dann mit Variationen, um die Schwachstelle zu bestätigen.

| Typ | Wissen über die Anwendung | Einrichtungsaufwand | Fehlererkennungsrate | Bester Anwendungsfall |

|---|---|---|---|---|

| Dumm | Keines | Sehr gering | Gering | Absturztests |

| Intelligent | Struktur & Regeln | Mittel | Mittel | Workflow-Tests |

| Brillant | Selbstlernend | Hoch | Hoch | Tiefe Stabilitätstests |

Vor- und Nachteile des Monkey Testing

Wie jede andere Technik hat auch das Monkey Testing seine Kompromisse.

Vorteile:

- Findet Grenzfälle, die Menschen übersehen: Zufälligkeit erforscht Kombinationen, an die Tester nicht denken würden

- Decktt Robustheitsprobleme auf: Zeigt Speicherlecks, Abstürze und Hänger unter Belastung

- Geringe Anfangskosten für dummes Testen: Kann mit minimaler Konfiguration gestartet werden

- Skalierbar: Automatisierte Affen laufen 24/7 ohne Ermüdung

- Gut für die Sicherheit: Fuzzing mit fehlerhaften Daten findet Injektionsschwachstellen

Nachteile:

- Unvorhersehbare Abdeckung: Kann nicht garantieren, dass alle Funktionen getestet werden

- Viele Fehlalarme: Zufällige Fehler stellen möglicherweise keine echten Benutzerprobleme dar

- Keine Anforderungsvalidierung: Bestätigt nicht, dass die Software den Geschäftsanforderungen entspricht

- Schwer zu reproduzieren: Zufällige Testfehler können schwer zu reproduzieren und zu debuggen sein

- Begrenzte Dokumentation: Schwer nachweisbar, was den Auditoren getestet wurde

Hinweis: Monkey Testing sollte niemals Ihre einzige Teststrategie sein. Es ist eine leistungsstarke Ergänzung zu strukturierten Tests, kein Ersatz!

Wo Monkey Testing glänzt: Praxisanwendungen

Monkey Testing ist in diesen Szenarien am wertvollsten:

- Mobile App-Tests: Benutzer tippen zufällig, drehen Geräte, wechseln Apps und unterbrechen Netzwerkverbindungen. Affen simulieren dieses Chaos effektiv und finden Abstürze, die strukturierte Tests übersehen.

- API-Resilienztests: APIs erhalten fehlerhafte Anfragen, unvollständige Payloads und unerwartete Header. Monkey Testing mit zufälligen Datenstrukturen deckt unbehandelte Ausnahmen und Sicherheitslücken auf.

- UI-Stresstests: Schnelles Klicken, Fenstergrößenänderungen und Menünavigation können Threading-Probleme und UI-Einfrierungen aufdecken.

- Spieltests: Spieler führen unerwartete Sequenzen aus. Ein Affe könnte gleichzeitig springen, schießen und pausieren und dabei einen Rendering-Fehler aufdecken.

- IoT-Gerätetests: Geräte sind unvorhersehbaren Netzwerkbedingungen und Benutzerinteraktionen ausgesetzt. Affen simulieren Verbindungsabbrüche und schnelles Tastendrücken.

Monkey Testing vs. Guerrilla Testing vs. Ad-hoc-Testing

Diese Begriffe werden oft verwechselt. Hier sind ihre Unterschiede:

- Monkey Testing: Systematische Zufälligkeit, oft automatisiert, konzentriert sich auf Robustheit.

- Guerrilla Testing: Schnelle, informelle Tests mit echten Benutzern in ihrer natürlichen Umgebung (z. B. Testen einer Café-App in einem echten Café).

- Ad-hoc-Testing: Unstrukturierte, explorative Tests, die von der Intuition des Testers und nicht von Skripten geleitet werden.

| Aspekt | Monkey Testing | Guerrilla Testing | Ad-hoc-Testing |

|---|---|---|---|

| Ansatz | Zufällig, automatisiert | Beobachtung in der realen Welt | Intuitive Erkundung |

| Ziel | Abstürze/Hänger finden | Echte Nutzung validieren | Unerwartete Probleme entdecken |

| Umgebung | Labor/CI/CD | Produktionsähnlich | Beliebig |

| Wer führt durch | Automatisierte Tools oder Tester | Endbenutzer | Erfahrene Tester |

| Dokumentation | Minimal | Beobachtungsnotizen | Sitzungsnotizen |

Alle drei sind explorativ, aber Monkey Testing ist die einzige Methode, die bewusste Zufälligkeit als Kernstrategie verwendet.

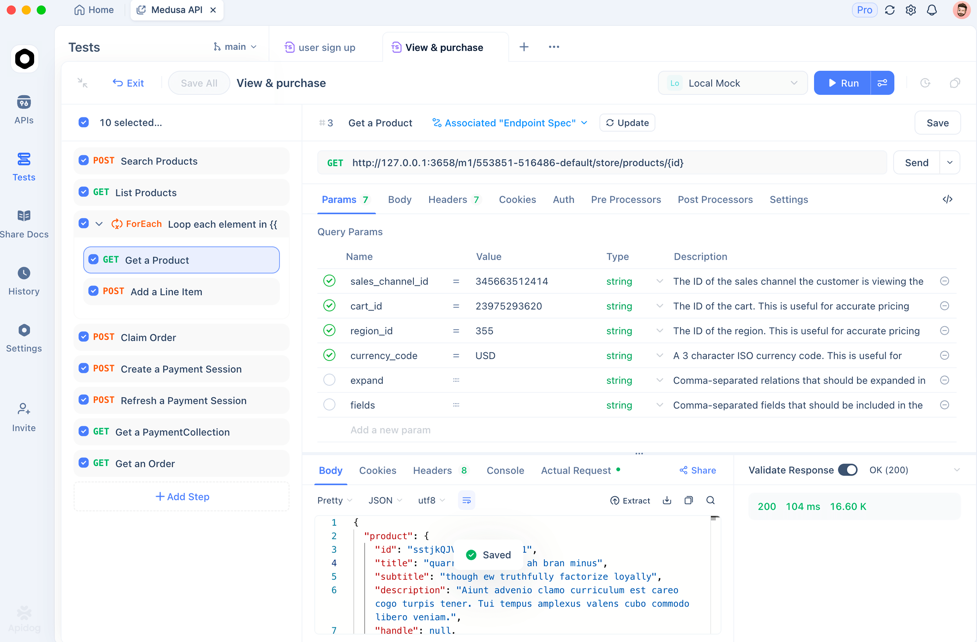

Wie Apidog beim Monkey Testing für APIs hilft

Während sich Monkey Testing traditionell auf die Benutzeroberfläche konzentriert, benötigen auch APIs Monkey Testing! Zufällige Anfragen mit unerwarteten Parametern, Headern und Payloads können Ihr Backend zum Absturz bringen. Apidog wendet die Prinzipien des Monkey Testing auf API-Tests auf kontrollierte, reproduzierbare Weise an.

Während der Phase der Testfallentwicklung Ihres Software Testing Life Cycle kann Apidog „intelligente Affen“-Testszenarien für Ihre API-Endpunkte generieren. Anstatt reiner Zufälligkeit versteht es Ihre API-Spezifikation und erstellt Variationen, die die Robustheit testen:

// Apidog generiert diese Monkey Testing-Szenarien automatisch:

1. POST /api/users mit gültigem JSON → Erwartet 201

2. POST /api/users mit fehlendem Pflichtfeld → Erwartet 400

3. POST /api/users mit zusätzlichem unbekanntem Feld → Erwartet 200 (sollte ignoriert werden)

4. POST /api/users mit SQL-Injection in E-Mail → Erwartet 400/500 (sollte nicht abstürzen)

5. POST /api/users mit 10MB JSON-Payload → Erwartet 413

6. POST /api/users mit fehlerhaftem JSON → Erwartet 400

7. Schnellfeuer 100 Anfragen mit zufälligen Daten → System sollte nicht abstürzen

Die KI von Apidog versteht Datentypen und Einschränkungen und generiert zufällige, aber plausible Werte. Sie erstellt Grenzwerttests, Injektionsversuche und Payload-Mutationen, die einen „intelligenten Affen“ nach Schwachstellen in Ihrer API suchen lassen.

Während der Testausführung können Sie diese Monkey-Tests automatisch als Teil Ihrer CI/CD-Pipeline ausführen. Apidog bietet:

- Fuzzing-Fähigkeiten: Senden Sie Tausende von zufälligen Anfragen, um Bruchstellen zu finden

- Lastsimulation: Kombinieren Sie zufällige Anfragen mit gleichzeitiger Ausführung, um sowohl Robustheit als auch Leistung zu testen

- Detaillierte Protokollierung: Erfassen Sie genaue Anfrage-/Antwortpaare für reproduzierbares Debugging

- Sicherheits-Scanning: Identifizieren Sie, welche zufälligen Eingaben Schwachstellen erzeugen

Dieser Ansatz bietet Ihnen die Vorteile des Monkey Testing (Finden unerwarteter Fehler) ohne die Nachteile (nicht reproduzierbare Ergebnisse und keine Abdeckungsverfolgung).

Best Practices für die Implementierung von Monkey Testing

Um Monkey Testing effektiv und ohne Zeitverschwendung einzusetzen, befolgen Sie diese Richtlinien:

- Beginnen Sie mit intelligenten Affen: Dumme Affen erzeugen zu viel Lärm. Beginnen Sie mit einem Tool wie Apidog, das Ihre Anwendungsstruktur versteht und relevante zufällige Variationen generiert.

- Setzen Sie Zeitgrenzen: Führen Sie Monkey-Tests für festgelegte Zeiträume (z. B. 2 Stunden über Nacht) aus, um den Umfang zu begrenzen und dennoch Fehler zu finden.

- Überwachen Sie die Systemintegrität: Verwenden Sie Tools zur Anwendungsleistungsüberwachung (APM) zusammen mit Monkey Testing, um Speicherlecks und CPU-Spitzen zu erkennen, die auf zugrunde liegende Probleme hinweisen.

- Protokollieren Sie alles: Zeichnen Sie alle zufälligen Aktionen auf, damit Sie Fehler reproduzieren können. Apidogs detaillierte Anforderungsprotokolle machen dies automatisch.

- In CI/CD integrieren: Führen Sie Monkey-Tests bei nächtlichen Builds aus, um Stabilitätsregressionen abzufangen, ohne die Entwicklung zu verlangsamen.

- Verlassen Sie sich nicht nur auf Affen: Verwenden Sie Monkey Testing als 20 % Ihrer Strategie, ergänzend zu strukturierten funktionalen und Regressionstests.

Häufig gestellte Fragen

F1: Ist Monkey Testing dasselbe wie Fuzzing?

Antwort: Fuzzing ist eine spezifische Art des Monkey Testing, die sich auf die Sicherheit konzentriert. Es sendet absichtlich fehlerhafte, unerwartete oder zufällige Daten, um Schwachstellen wie Pufferüberläufe oder Injektionsfehler zu finden. Jedes Fuzzing ist Monkey Testing, aber nicht jedes Monkey Testing ist Fuzzing.

F2: Kann Monkey Testing manuelle Tests vollständig ersetzen?

Antwort: Nein. Monkey Testing findet Abstürze und Robustheitsprobleme, kann aber nicht validieren, ob die Software die Geschäftsanforderungen erfüllt oder eine gute Benutzererfahrung bietet. Es ergänzt manuelle Tests, insbesondere bei der Entdeckung von Randfällen, ersetzt aber niemals die strukturierte Testfallausführung.

F3: Wie lange sollte ich Monkey Tests laufen lassen?

Antwort: Für UI-Tests offenbaren 30-60 Minuten zufälliger Interaktion oft große Stabilitätsprobleme. Für API-Tests mit Apidog führen Sie Fuzzing-Tests 2-4 Stunden oder 10.000 Anfragen lang aus, je nachdem, was zuerst eintritt. Das Ziel ist statistische Sicherheit, nicht unendliches Testen.

F4: Welches ist das beste Tool für Monkey Testing mobiler Apps?

Antwort: Für Android ist der UI/Application Exerciser Monkey in das SDK integriert. Für iOS bieten Tools wie FastMonkey ähnliche Funktionen. Für Cross-Plattform-Lösungen sollten Sie Appium mit benutzerdefinierten zufälligen Skriptgeneratoren in Betracht ziehen. Für API-Monkey-Tests ist Apidog die effizienteste Option.

F5: Wie messe ich die Effektivität von Monkey Testing?

Antwort: Verfolgen Sie diese Metriken: Anzahl der Abstürze pro 1.000 Aktionen, Anzahl der gefundenen einzigartigen Fehler, Codeabdeckung, die während der Monkey-Läufe erreicht wurde, und die Zeit bis zum ersten Fehler. Wenn Ihre Monkey-Tests innerhalb der ersten Stunde kritische Fehler finden, liefern sie einen Wert.

Fazit

Monkey Testing verdient einen Platz in Ihrer Qualitätsstrategie – nicht als chaotischer letzter Ausweg, sondern als disziplinierte Technik, um Fehler zu finden, die bei strukturierten Tests übersehen werden. Indem Sie die Unterschiede zwischen dummen, intelligenten und brillanten Affen verstehen und Best Practices für die Implementierung befolgen, können Sie Zufälligkeit nutzen, um die Robustheit der Software zu verbessern.

Für API-Tests integrieren moderne Tools wie Apidog die Prinzipien des Monkey Testing in ein kontrolliertes, automatisiertes Framework. Sie erhalten die chaosfindende Kraft ohne den Albtraum der Reproduzierbarkeit. Das Tool generiert intelligente Variationen, führt sie in großem Maßstab aus und liefert die Protokolle, die Sie zur Behebung von Fehlern benötigen.

Fangen Sie klein an. Fügen Sie einen 30-minütigen Monkey-Test zu Ihrem nächtlichen Build hinzu. Verfolgen Sie, was er findet. Sie werden wahrscheinlich Abstürze, Speicherlecks oder Sicherheitsprobleme entdecken, die Ihnen im Produktionsbetrieb peinlich gewesen wären. Beim Monkey Testing geht es nicht um Rücksichtslosigkeit – es geht darum, auf eine Weise gründlich zu sein, die methodische Testfälle nicht erreichen können. Nehmen Sie das Chaos an, und Ihre Software wird dadurch stärker werden.