Mistral AI hat sich mit seinen leistungsstarken Sprachmodellen schnell einen Namen gemacht. Egal, ob Sie einen Chatbot erstellen, kreative Texte generieren, Daten analysieren, Code schreiben oder Text für die semantische Suche einbetten möchten, die Mistral API bietet die benötigten Tools. Aber wie jedes leistungsstarke Werkzeug gibt es einen Zugang: den API-Schlüssel.

Stellen Sie sich einen API-Schlüssel als Ihr geheimes Passwort oder Ihren eindeutigen Identifikator vor. Er sagt Mistral: "Hey, ich bin's! Ich habe die Erlaubnis, Ihre Dienste zu nutzen." Ohne ihn wüssten die API-Server nicht, wer die Anfrage stellt oder ob sie autorisiert sind.

Dieser Leitfaden ist Ihr Schritt-für-Schritt-Begleiter, um die Ersteinrichtung zu navigieren, die Landschaft der Mistral-Modelle zu verstehen, Ihre ersten API-Aufrufe zu tätigen und sogar Tools wie APidog zu verwenden, um mit der API zu interagieren. Wir werden alles gesprächsorientiert aufschlüsseln, um Sie von Null zu erfolgreichen API-Aufrufen zu bringen.

Geschätzte Zeit: Lesen und Mitmachen könnte 30-45 Minuten dauern.

Voraussetzungen: Ein grundlegendes Verständnis davon, was eine API ist, ist hilfreich, aber nicht zwingend erforderlich. Wir werden Konzepte erklären, während wir vorgehen. Sie benötigen außerdem eine Internetverbindung und einen Webbrowser.

Bereit? Holen wir uns diesen API-Schlüssel!

Benötigen Sie eine integrierte All-in-One-Plattform für Ihr Entwicklerteam, um mit maximaler Produktivität zusammenzuarbeiten?

Apidog liefert alle Ihre Anforderungen und ersetzt Postman zu einem viel günstigeren Preis!

Schritt 1: Einrichten Ihres Mistral AI-Kontos

Zuerst einmal benötigen Sie ein Konto auf der Plattform von Mistral, bekannt als "La Plateforme".

- Navigieren Sie zur Konsole: Öffnen Sie Ihren Webbrowser und gehen Sie zu console.mistral.ai.

- Registrieren oder Anmelden:

- Wenn Sie neu sind, klicken Sie auf die Registrierungsoption. Sie müssen wahrscheinlich eine E-Mail-Adresse angeben und ein Passwort erstellen, oder Sie können sich möglicherweise mit einem bestehenden Google- oder GitHub-Konto anmelden. Befolgen Sie die Anweisungen auf dem Bildschirm, die möglicherweise die Überprüfung Ihrer E-Mail-Adresse umfassen.

- Wenn Sie bereits ein Konto haben, melden Sie sich einfach mit Ihren Anmeldeinformationen an.

3. Rechnungsinformationen (Wichtig!): Dies ist ein entscheidender Schritt, der die Leute oft stolpern lässt. Um die API tatsächlich zu nutzen (auch wenn Sie zunächst Modelle der kostenlosen Stufe verwenden möchten, erfordert die Plattform oft Rechnungsdetails, um Schlüssel zu aktivieren), müssen Sie die Abrechnung einrichten.

- Suchen Sie nach der Anmeldung nach einem Abschnitt, der normalerweise mit "Workspace" oder Ihrem Kontonamen in der Seitenleiste oder im Navigationsmenü bezeichnet ist.

- Suchen Sie in diesem Abschnitt nach "Billing".

- Klicken Sie darauf und befolgen Sie die Anweisungen, um Ihre Zahlungsinformationen (normalerweise eine Kreditkarte) hinzuzufügen. Keine Sorge, Sie werden in der Regel nur für das belastet, was Sie verwenden, und viele Modelle haben möglicherweise kostenlose Stufen oder anfängliche Gutschriften, aber die Aktivierung von Zahlungen ist oft erforderlich, um Ihre API-Schlüssel für die allgemeine Verwendung zu aktivieren. Die Preisseite von Mistral (weiter unten verlinkt) enthält die Einzelheiten.

- Stellen Sie sicher, dass Ihre Zahlungen als "aktiv" oder "aktiviert" gekennzeichnet sind. Es kann einige Momente dauern, bis sich der Status nach dem Hinzufügen von Details aktualisiert.

Sie haben jetzt ein Mistral AI-Konto, das einsatzbereit ist! Der nächste Schritt ist die Generierung dieses überaus wichtigen Schlüssels.

Schritt 2: Generieren Ihres geheimen API-Schlüssels

Lassen Sie uns, nachdem Sie Ihr Konto eingerichtet und die Abrechnung aktiviert haben, den Schlüssel selbst erstellen.

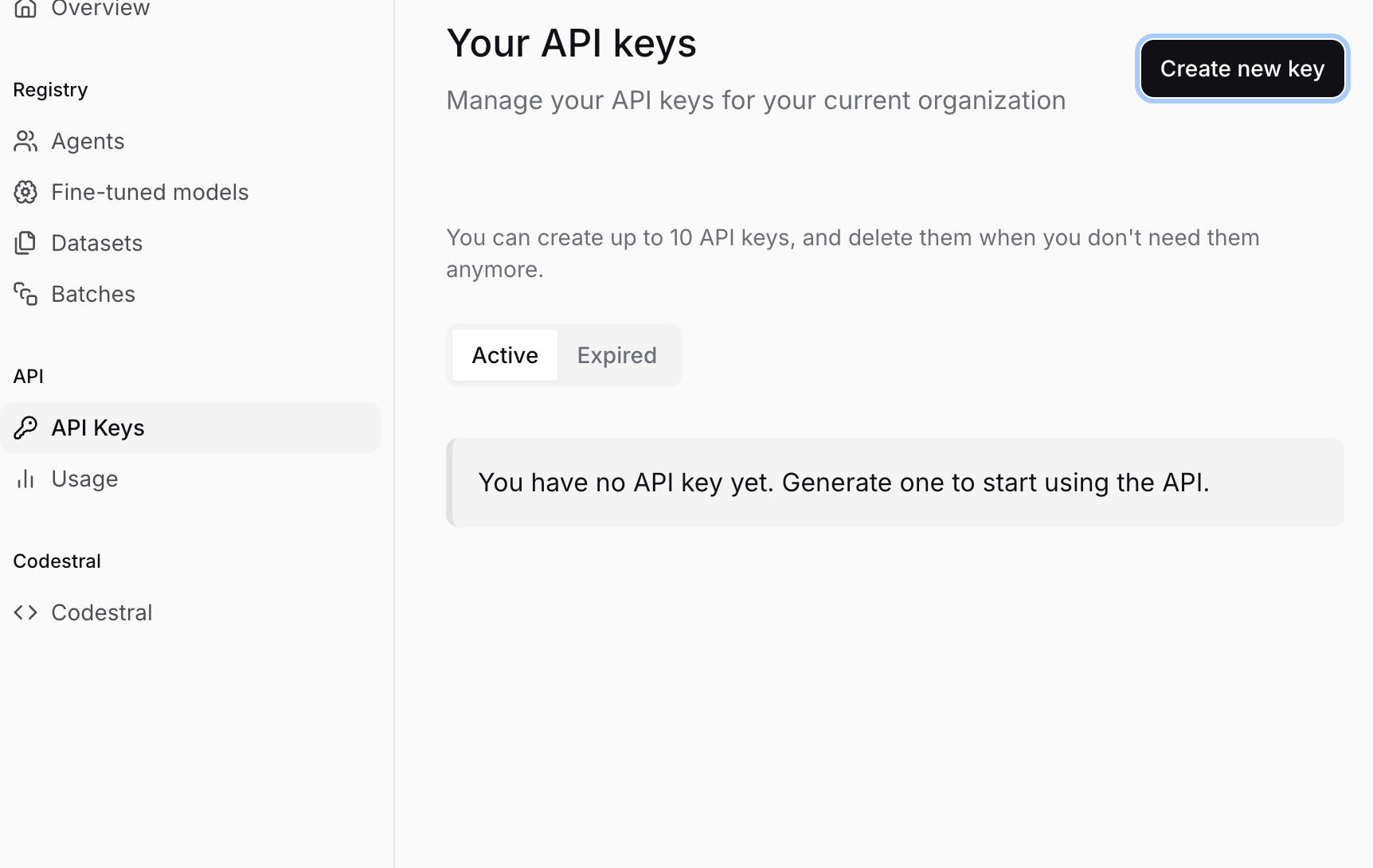

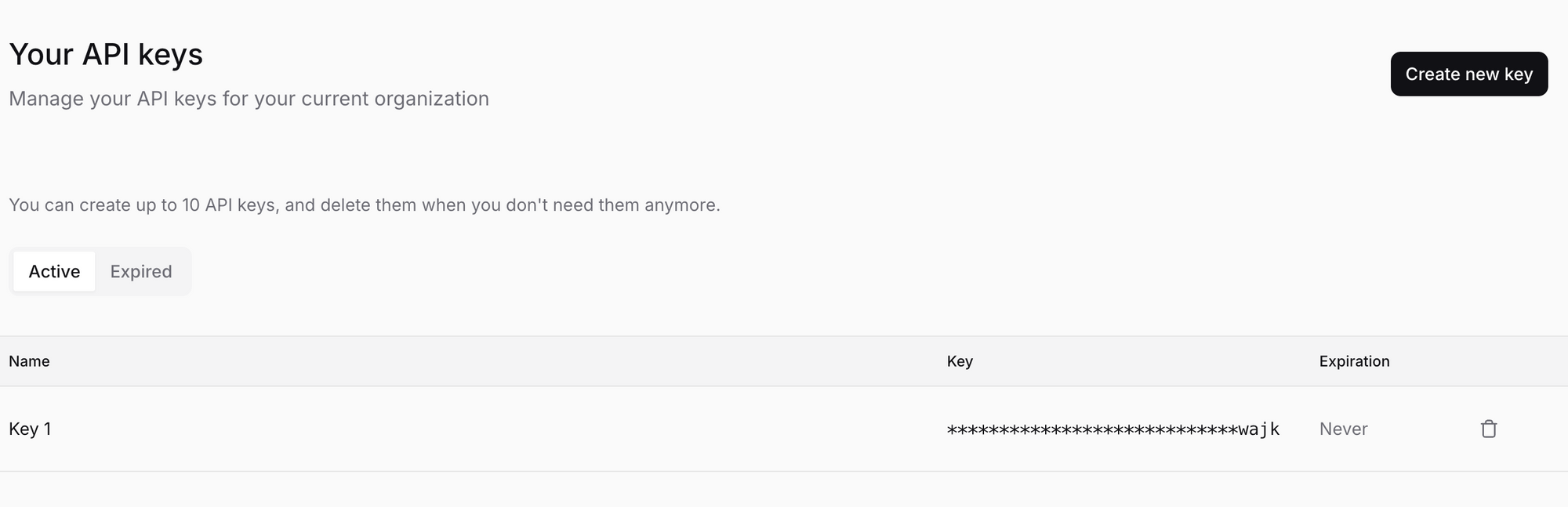

- Navigieren Sie zu API-Schlüsseln: Suchen Sie im Mistral-Konsolenfenster (console.mistral.ai) nach einem Abschnitt namens "API-Schlüssel" in der Seitenleiste oder im Navigationsmenü. Klicken Sie darauf.

- Erstellen Sie einen neuen Schlüssel: Sie sollten eine Schaltfläche wie "Neuen Schlüssel erstellen" oder "+ Neuer Schlüssel" sehen. Klicken Sie darauf.

- Benennen Sie Ihren Schlüssel (optional, aber empfohlen): Möglicherweise werden Sie aufgefordert, Ihrem Schlüssel einen Namen zu geben. Dies ist sehr hilfreich für die Organisation, insbesondere wenn Sie später mehrere Schlüssel erstellen möchten (z. B. einen für "Mein Chatbot-Projekt", einen anderen für "Datenanalyse-Skript"). Wählen Sie einen beschreibenden Namen.

- Generieren und KOPIEREN Sie Ihren Schlüssel: Klicken Sie auf die endgültige Bestätigungsschaltfläche (z. B. "Erstellen", "Generieren"). Mistral generiert nun einen eindeutigen API-Schlüssel für Sie. Er sieht aus wie eine lange Zeichenfolge aus zufälligen Zeichen, etwa

sk-aBcDeFgHiJkLmNoPqRsTuVwXyZ1234567890....... - !!! KRITISCHER SCHRITT: SPEICHERN SIE IHREN SCHLÜSSEL SICHER !!!

- Mistral zeigt Ihnen diesen Schlüssel NUR EINMAL. Wenn Sie das Fenster schließen oder wegnavigieren, ohne es zu kopieren, werden Sie es nie wieder sehen. Sie müssten einen neuen Schlüssel generieren.

- Kopieren Sie den Schlüssel sofort. Klicken Sie auf das Kopiersymbol oder wählen Sie die gesamte Zeichenfolge manuell aus und kopieren Sie sie.

- Speichern Sie ihn sicher. Verwenden Sie einen Passwort-Manager (wie 1Password, Bitwarden, Dashlane) oder eine sichere Notiz-App. SPEICHERN SIE IHN NICHT in einer Nur-Text-Datei auf Ihrem Desktop, senden Sie ihn ungesichert per E-Mail an sich selbst oder betten Sie ihn direkt in Ihren Code ein (mehr dazu später). Behandeln Sie diesen Schlüssel wie ein Passwort für Ihr Bankkonto – jeder, der ihn hat, kann API-Aufrufe tätigen, die auf Ihr Konto abgerechnet werden.

- Teilen Sie ihn nicht. Ernsthaft.

Sie haben es geschafft! Sie besitzen jetzt einen Mistral AI API-Schlüssel. Bewahren Sie ihn sicher auf und finden wir heraus, wie man ihn verwendet.

Schritt 3: Verstehen der Mistral-Modelllandschaft

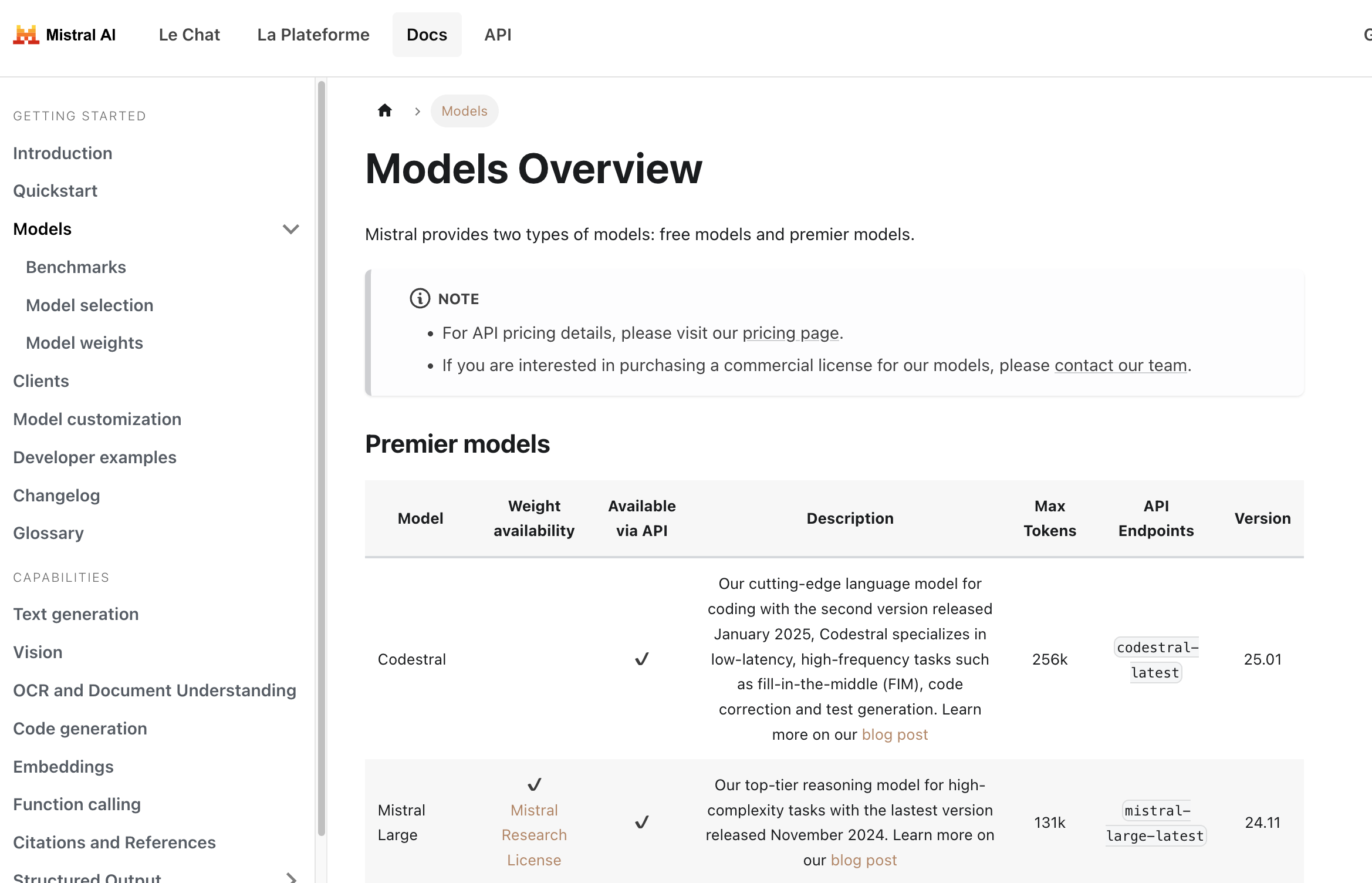

Bevor Sie einen API-Aufruf tätigen, müssen Sie Mistral mitteilen, welches Modell Sie verwenden möchten. Mistral bietet eine Vielzahl von Modellen, die auf verschiedene Aufgaben zugeschnitten sind und Leistung, Kosten und Fähigkeiten ausgleichen. Die Wahl des richtigen Modells ist entscheidend.

Hier finden Sie einen detaillierten Überblick über die Modelle: Mistral Models Overview

Hier ist eine kurze Aufschlüsselung der Arten von Modellen, denen Sie begegnen werden:

Premier Models: Dies sind die leistungsstärksten Modelle von Mistral, die oft eine Zahlung erfordern.

Mistral Large: Ihr Flaggschiff-Modell, das für komplexe Denkaufgaben entwickelt wurde. Es hat ein großes Kontextfenster (kann viel Text verarbeiten) und eine starke Leistung über verschiedene Benchmarks hinweg.Codestral: Spezialisierte Modelle, die für Code-Generierung, -Vervollständigung und -Erklärung optimiert sind. Ausgezeichnet für Entwickler.Pixtral Large: Ein leistungsstarkes multimodales Modell, das in der Lage ist, sowohl Text als auch Bilder zu verstehen.Mistral Embed: Ein hocheffizientes Modell, das speziell für die Erstellung numerischer Darstellungen (Einbettungen) von Text für Aufgaben wie semantische Suche, Clustering und Klassifizierung entwickelt wurde.Mistral Moderation: Ein Tool zur Erkennung schädlicher oder unerwünschter Inhalte in Texten.Mistral OCR: Dienst zum Extrahieren von Text, der mit Bildern aus Dokumenten verschachtelt ist.- Spezialisierte Modelle wie

Mistral Saba(für Sprachen des Nahen Ostens/Südasien) oderMinistral(effiziente Edge-Modelle).

Kostenlose Modelle (oft mit offenen Gewichten): Diese Modelle haben möglicherweise Gewichte, die unter permissiven Lizenzen (wie Apache 2.0) verfügbar sind, was bedeutet, dass die KI-Community sie studieren und darauf aufbauen kann. Sie sind oft auch über die API verfügbar, manchmal mit großzügigeren kostenlosen Stufen oder niedrigeren Kosten.

Mistral Small: Ein sehr leistungsfähiges kleineres Modell, das Leistung und Effizienz ausgleicht. Oft ein großartiger Ausgangspunkt.- Ältere Modelle wie

Mistral 7BoderMixtral 8x7Bkönnen noch aufgelistet sein, könnten aber in den Legacy-Status übergehen (siehe unten).

Modellversionierung und latest-Tags:

Sie werden feststellen, dass Modelle oft Namen wie mistral-large-latest oder mistral-large-2411 haben.

*-latest: Dieses Tag verweist immer auf die aktuellste stabile Version dieses Modells (z. B. verweistmistral-large-latestderzeit aufmistral-large-2411). Die Verwendung vonlatestist praktisch, um immer die neuesten Funktionen zu haben, aber beachten Sie, dass sich das zugrunde liegende Modell ändern kann, was das Verhalten oder die Ausgaben im Laufe der Zeit geringfügig verändern kann.*-YYYYMM(z. B.mistral-large-2411): Dies bezieht sich auf eine bestimmte, datierte Version des Modells (in diesem Beispiel im November 2024 veröffentlicht). Die Verwendung einer datierten Version gewährleistet Konsistenz. Ihre Anwendung wird immer genau dieselbe Modellversion treffen, was für Produktionsumgebungen, in denen vorhersagbares Verhalten von größter Bedeutung ist, von entscheidender Bedeutung ist.

Empfehlung: Für Entwicklung und Erkundung ist latest in Ordnung. Für Produktionsanwendungen sollten Sie dringend die Verwendung einer datierten Version in Betracht ziehen, um die Stabilität zu gewährleisten.

Modell-Deprecation:

KI bewegt sich schnell! Mistral veröffentlicht kontinuierlich neuere, bessere Modelle. Im Rahmen dieses Zyklus werden ältere Modelle schließlich veraltet und ausgemustert. Die Seite Models Overview enthält einen Abschnitt zu Legacy-Modellen, der deren Veralterungs- und Ausmusterungsdaten zeigt. Überprüfen Sie dies immer, wenn Sie sich auf ein älteres Modell verlassen, und planen Sie Ihre Migration zu neueren Alternativen rechtzeitig.

Auswahl eines Modells:

- Aufgabe: Was müssen Sie tun? (Chat, Code, Einbettungen, Bildanalyse?)

- Komplexität: Wie schwierig ist die Aufgabe? (Einfache Fragen und Antworten vs. differenzierte Argumentation?)

- Kosten: Überprüfen Sie die Preisseite! Größere Modelle kosten in der Regel mehr.

- Geschwindigkeit: Kleinere Modelle sind in der Regel schneller.

Beginnen Sie mit einem kleineren, günstigeren Modell (wie mistral-small-latest) und sehen Sie, ob es Ihren Anforderungen entspricht. Wenn nicht, skalieren Sie auf größere oder spezialisiertere Modelle.

Schritt 4: Tätigen Ihres ersten API-Aufrufs (Chat-Vervollständigung) mit Python

Lassen Sie uns etwas geschehen lassen! Der häufigste Anwendungsfall ist die Chat-Vervollständigung – dem Modell eine Eingabeaufforderung oder einen Konversationsverlauf geben und eine Antwort erhalten. Der primäre Endpunkt von Mistral hierfür ist /v1/chat/completions.

Wir verwenden für dieses Beispiel das Modell mistral-large-latest, aber Sie können jeden geeigneten Chat-Modellnamen einsetzen.

Wichtiger Sicherheitshinweis: In den folgenden Beispielen verwenden wir oft os.environ["MISTRAL_API_KEY"] (Python) oder process.env.MISTRAL_API_KEY (TypeScript). Dies setzt voraus, dass Sie Ihren API-Schlüssel als Umgebungsvariable mit dem Namen MISTRAL_API_KEY festgelegt haben. Dies ist dringend empfohlen, anstatt den Schlüssel direkt in Ihren Code einzufügen.

- So legen Sie eine Umgebungsvariable fest (vorübergehend für die Terminalsitzung):

- Mac/Linux:

export MISTRAL_API_KEY='your_actual_api_key_here' - Windows (Eingabeaufforderung):

set MISTRAL_API_KEY=your_actual_api_key_here - Windows (PowerShell):

$env:MISTRAL_API_KEY='your_actual_api_key_here' - Ersetzen Sie

your_actual_api_key_heredurch den von Ihnen gespeicherten Schlüssel. Denken Sie daran, die Anführungszeichen wegzulassen, wenn Sie die Windows-Eingabeaufforderung verwenden. Suchen Sie für eine dauerhaftere Einrichtung nach der Festlegung von Umgebungsvariablen dauerhaft auf Ihrem Betriebssystem.

Installieren Sie die Bibliothek:

pip install mistralai

Erstellen Sie eine Python-Datei (z. B. mistral_test.py):

import os

from mistralai.client import MistralClient

from mistralai.models.chat_completion import ChatMessage

# Laden Sie den API-Schlüssel aus Umgebungsvariablen

api_key = os.environ.get("MISTRAL_API_KEY")

if not api_key:

raise ValueError("MISTRAL_API_KEY environment variable not set!")

# Definieren Sie das Modell, das Sie verwenden möchten

model_name = "mistral-large-latest" # Oder wählen Sie ein anderes Modell

# Initialisieren Sie den Mistral-Client

client = MistralClient(api_key=api_key)

print(f"Sending request to model: {model_name}")

# Definieren Sie die Konversationsnachrichten

# Die Liste 'messages' enthält den Chatverlauf oder eine einzelne Benutzereingabeaufforderung

messages = [

ChatMessage(role="user", content="What is the best French cheese?")

# Sie können weitere Nachrichten für den Konversationsverlauf hinzufügen:

# ChatMessage(role="assistant", content="There are many wonderful French cheeses! It depends on your taste. Do you prefer soft, hard, or blue cheese?"),

# ChatMessage(role="user", content="I prefer soft cheese.")

]

try:

# Tätigen Sie den API-Aufruf an den Chat-Vervollständigungs-Endpunkt

chat_response = client.chat(

model=model_name,

messages=messages,

# Optionale Parameter:

# temperature=0.7, # Steuert die Zufälligkeit (0.0 = deterministisch, 1.0 = zufälliger)

# max_tokens=150 # Begrenzt die Länge der Antwort

)

# Drucken Sie die Antwort vom Modell

if chat_response.choices:

print("Model Response:")

print(chat_response.choices[0].message.content)

else:

print("No response received.")

# Sie können auch das vollständige Antwortobjekt drucken, um Nutzungsdetails usw. anzuzeigen.

# print("\nFull Response Object:")

# print(chat_response)

except Exception as e:

print(f"An error occurred: {e}")

Führen Sie das Skript aus:

python mistral_test.py

Sie sollten die Antwort des Modells in Ihrem Terminal sehen!

Schritt 5: Testen von Mistral AI-Einbettungen mit API

Bei Mistral geht es nicht nur um Chat! Schauen wir uns eine weitere Schlüsselfunktion an: Einbettungen. Einbettungen wandeln Text in numerische Vektoren um, die die semantische Bedeutung erfassen. Texte mit ähnlichen Bedeutungen haben Vektoren, die im Vektorraum nahe beieinander liegen. Dies ist grundlegend für RAG (Retrieval-Augmented Generation), semantische Suche, Empfehlungssysteme usw.

Auf das Einbettungsmodell von Mistral wird über den Endpunkt /v1/embeddings zugegriffen, in der Regel mit dem Modellbezeichner mistral-embed.

Sehen wir uns an, wie man Einbettungen für ein paar Sätze mit Python erhält:

import os

from mistralai.client import MistralClient

api_key = os.environ.get("MISTRAL_API_KEY")

if not api_key:

raise ValueError("MISTRAL_API_KEY environment variable not set!")

model_name = "mistral-embed"

client = MistralClient(api_key=api_key)

print(f"Requesting embeddings using model: {model_name}")

texts_to_embed = [

"Mistral AI provides powerful language models.",

"Embeddings are numerical representations of text.",

"What is the weather like today?"

]

try:

embeddings_response = client.embeddings(

model=model_name,

input=texts_to_embed

)

# Die Antwort enthält eine Liste von Einbettungsobjekten, jedes mit dem Vektor

print(f"Received {len(embeddings_response.data)} embeddings.")

# Drucken Sie die ersten paar Dimensionen der ersten Einbettung als Beispiel

if embeddings_response.data:

first_embedding_vector = embeddings_response.data[0].embedding

print(f"Dimensions of each embedding: {len(first_embedding_vector)}")

print(f"First 5 dimensions of the first embedding: {first_embedding_vector[:5]}")

# Sie würden diese Vektoren typischerweise zur späteren Verwendung speichern

# print("\nFull Embeddings Response:")

# print(embeddings_response)

except Exception as e:

print(f"An error occurred: {e}")

Führen Sie dieses Python-Skript aus, und Sie sehen die Dimensionen der Einbettungen und einen Ausschnitt der ersten.

Weitere Funktionen:

Mistral bietet noch mehr! Obwohl wir den Code hier nicht detailliert beschreiben, sollten Sie unbedingt die offizielle Dokumentation für Folgendes erkunden:

- Vervollständigung (Legacy): Obwohl Chat oft bevorzugt wird, gibt es möglicherweise einfachere Vervollständigungs-Endpunkte, die hier besprochen werden: Mistral Completion Capabilities

- Dokumentenverständnis (OCR): Extrahieren von Text aus Dokumenten, möglicherweise unter Berücksichtigung von Layouts und Bildern: Mistral Document Capabilities

- Funktionsaufruf: Ermöglichen von Modellen, mit externen Tools und APIs zu interagieren.

- Feinabstimmung: Anpassen von Modellen an Ihre eigenen Daten (oft eine Unternehmensfunktion).

Beziehen Sie sich immer auf die offizielle Mistral AI-Dokumentation, um die aktuellsten Informationen zu Endpunkten, Parametern und Funktionen zu erhalten.

Schritt 6: Verstehen der Preisgestaltung und Überwachung der Nutzung

Die Verwendung leistungsstarker KI-Modelle ist oft mit Kosten verbunden. Es ist entscheidend zu verstehen, wie Mistral seine API-Nutzung bepreist.

- Die Preisgestaltung variiert je nach Modell: Größere, leistungsfähigere Modelle kosten in der Regel mehr pro Token (Eingabe und Ausgabe) als kleinere Modelle. Einbettungsmodelle haben ihre eigene Preisgestaltung, die sich in der Regel nach der Anzahl der verarbeiteten Token richtet.

- Token: KI-Modelle verarbeiten Text in Blöcken, die als Token bezeichnet werden. Ein Token ist nicht genau ein Wort; es kann ein Wort, ein Teil eines Wortes oder eine Interpunktion sein. Ungefähr 1000 Token sind etwa 750 Wörter, aber dies variiert. Die Preisgestaltung wird typischerweise als "Kosten pro 1 Million Eingabe-Token" und "Kosten pro 1 Million Ausgabe-Token" angegeben.

- Überprüfen Sie die offizielle Preisseite: Die Preise können sich ändern. Beziehen Sie sich immer auf die offizielle Mistral AI-Preisseite, um die neuesten Details zu erhalten. Sie finden in der Regel einen Link dazu auf der Hauptwebsite oder in der Dokumentation Models Overview.

- Überwachen Sie Ihre Nutzung: Die Mistral AI-Konsole (console.mistral.ai) hat in der Regel einen Abschnitt (oft unter "Billing" oder "Usage"), in dem Sie Ihre API-Aufrufe und die damit verbundenen Kosten verfolgen können. Überprüfen Sie dies regelmäßig, um Überraschungen zu vermeiden.

- Budgets/Benachrichtigungen festlegen: Wenn die Plattform dies zulässt, legen Sie Ausgabenlimits oder Benachrichtigungen fest, um Sie zu benachrichtigen, wenn Ihre Nutzung bestimmte Schwellenwerte überschreitet.

Achten Sie auf Ihre Nutzung, insbesondere bei der Entwicklung von Anwendungen, die möglicherweise viele Aufrufe tätigen. Optimieren Sie Ihre Eingabeaufforderungen und wählen Sie das kostengünstigste Modell, das Ihren Anforderungen entspricht.

Schritt 7: Tätigen von API-Aufrufen mit APidog

Während das Codieren üblich ist, möchten Sie manchmal eine grafische Oberfläche, um API-Endpunkte schnell zu testen. Tools wie Postman, Insomnia oder APidog sind dafür hervorragend geeignet. Gehen wir durch die Verwendung von APidog, um denselben Chat-Vervollständigungsaufruf wie zuvor zu tätigen.

Laden Sie APidog herunter und installieren Sie es: Wenn Sie dies noch nicht getan haben, laden Sie APidog von der offiziellen Website herunter und installieren Sie es auf Ihrem Computer.

Starten Sie APidog: Öffnen Sie die Anwendung.

Erstellen Sie eine neue Anfrage: Sie sehen wahrscheinlich eine "+" -Schaltfläche oder eine Option zum Erstellen einer "Neuen Anfrage". Klicken Sie darauf.

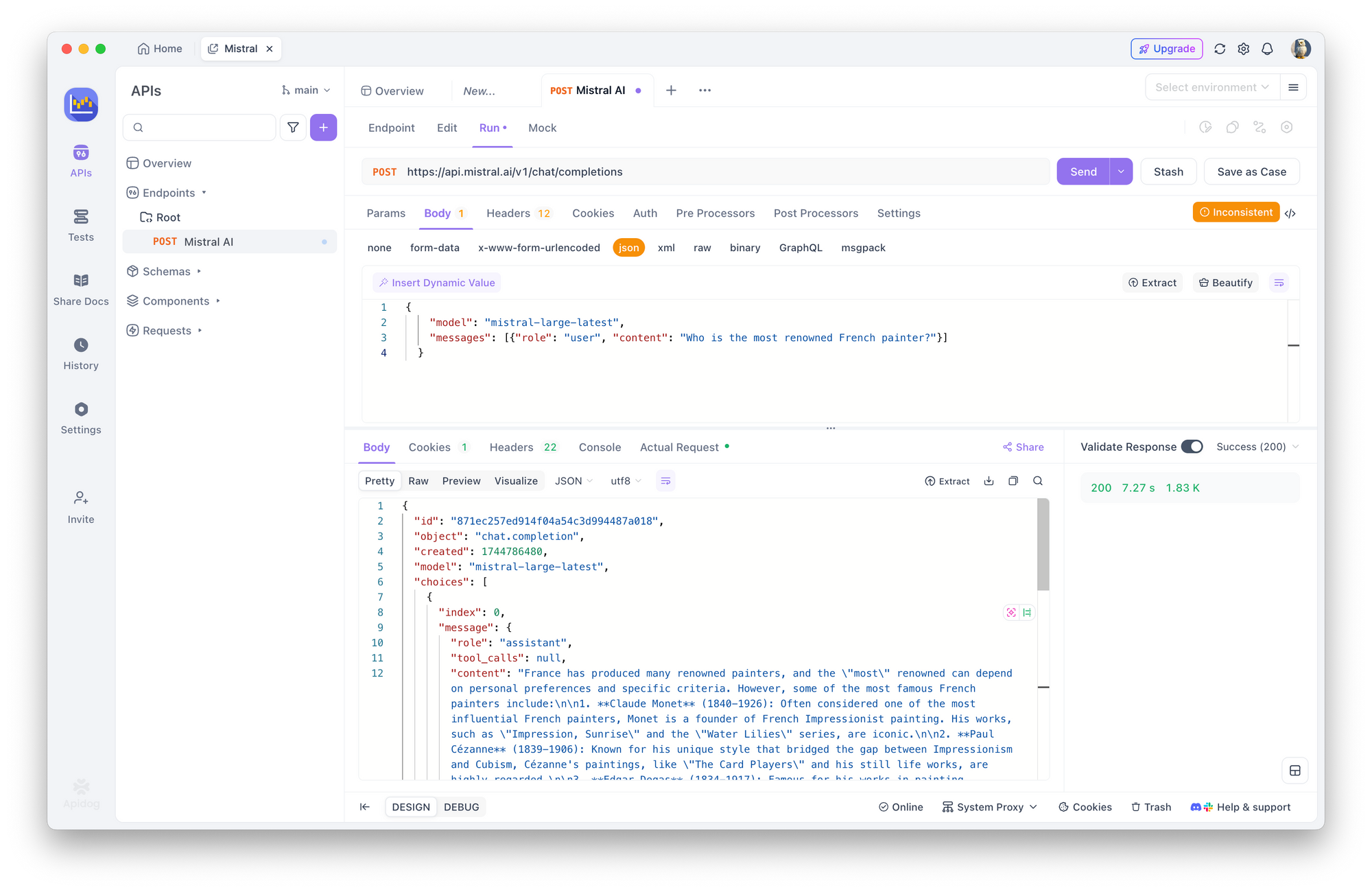

Legen Sie die HTTP-Methode und die URL fest:

- Suchen Sie im Anforderungsbereich das Dropdown-Menü für die HTTP-Methode (es ist normalerweise standardmäßig auf

GETeingestellt). Ändern Sie es inPOST. - Geben Sie im URL-Eingabefeld daneben den Mistral-Chat-Vervollständigungs-Endpunkt ein:

https://api.mistral.ai/v1/chat/completions

Autorisierung konfigurieren:

- Suchen Sie nach Registerkarten unterhalb der URL-Leiste wie "Params", "Authorization", "Headers", "Body". Klicken Sie auf die Registerkarte "Authorization".

- Wählen Sie im Dropdown-Menü "Type" in dieser Registerkarte "Bearer Token" aus.

- Ein Feld mit der Bezeichnung "Token" wird rechts angezeigt. Fügen Sie Ihren gespeicherten Mistral API-Schlüssel in dieses Feld ein.

Anforderungsheader festlegen:

- Klicken Sie auf die Registerkarte "Headers".

- Sie müssen zwei Header hinzufügen:

- Geben Sie in der ersten leeren Zeile unter "Key"

Content-Typeein. Geben Sie in der Spalte "Value" danebenapplication/jsonein. - Geben Sie in der nächsten leeren Zeile

Acceptfür den "Key" undapplication/jsonfür den "Value" ein. - Setzen Sie auch

Authorization:Bearer $MISTRAL_API_KEY

Geben Sie den Anforderungstext an:

- Klicken Sie auf die Registerkarte "Body".

- Wählen Sie das Optionsfeld "raw" aus.

- Direkt rechts neben "raw" gibt es oft ein Dropdown-Menü, das das Format anzeigt (z. B. "Text"). Ändern Sie dieses Dropdown-Menü in "JSON".

- Fügen Sie im großen Textbereich darunter die JSON-Nutzlast für Ihre Anfrage ein:

{

"model": "mistral-large-latest",

"messages": [{"role": "user", "content": "Who is the most renowned French painter?"}]

}

Senden Sie die Anfrage: Suchen Sie die Schaltfläche "Senden" (normalerweise prominent in der Nähe der URL-Leiste angezeigt) und klicken Sie darauf.

Zeigen Sie die Antwort an: APidog tätigt den Aufruf an die Mistral-API. Die Antwort vom Server wird im unteren Bereich des APidog-Fensters angezeigt, normalerweise unter einer Registerkarte "Response" oder "Body". Sie sollten die JSON-Antwort sehen, einschließlich der Antwort des Modells in choices[0].message.content. Sie können auch Antwortheader und Statuscodes untersuchen (hoffentlich 200 OK!).

Die Verwendung eines Tools wie APidog ist fantastisch, um mit verschiedenen Modellen, Eingabeaufforderungen und Parametern zu experimentieren, ohne Code zu schreiben.

Schritt 8: Best Practices & Sicherheit (Eine kurze Zusammenfassung)

Die Arbeit mit API-Schlüsseln erfordert Verantwortung. Lassen Sie uns einige wichtige Punkte wiederholen:

- NIEMALS Schlüssel fest codieren: Fügen Sie Ihren API-Schlüssel nicht direkt in Ihren Quellcode ein (

my_key = "sk-..."). Wenn Sie diesen Code in ein öffentliches Repository (wie GitHub) committen, wird Ihr Schlüssel offengelegt, und andere könnten ihn verwenden, wodurch Gebühren für Ihr Konto anfallen. - Verwenden Sie Umgebungsvariablen: Wie in den Codebeispielen gezeigt, ist das Laden von Schlüsseln aus Umgebungsvariablen (

os.environ,process.env) eine viel sicherere Standardpraxis. - Geheimnisverwaltungstools: Verwenden Sie für robustere Anwendungen, insbesondere in Teamumgebungen oder Cloud-Bereitstellungen, dedizierte Geheimnisverwaltungsdienste (wie AWS Secrets Manager, Google Secret Manager, HashiCorp Vault).

- Geringste Berechtigung: Wenn Mistral das Erstellen von Schlüsseln mit bestimmten Berechtigungen zulässt (dies ist nicht immer verfügbar), erstellen Sie Schlüssel, die nur die Berechtigungen haben, die für eine bestimmte Anwendung benötigt werden.

- Schlüsselrotation: Erwägen Sie für erhöhte Sicherheit, regelmäßig neue Schlüssel zu generieren und alte zu deaktivieren (z. B. alle paar Monate), obwohl dies eine Aktualisierung Ihrer Anwendungen erfordert.

- Regelmäßig überwachen: Behalten Sie Ihr Nutzungs-Dashboard in der Mistral-Konsole im Auge. Ungewöhnliche Aktivitäten könnten auf einen kompromittierten Schlüssel hindeuten.

Fazit: Gehen Sie voran und bauen Sie!

Sie haben den Prozess des Erhaltens und Verwendens eines Mistral AI API-Schlüssels erfolgreich durchlaufen! Wir haben Folgendes behandelt:

- Einrichten Ihres Mistral-Kontos und Aktivieren der Abrechnung.

- Generieren und sicheres Speichern Ihres eindeutigen API-Schlüssels.

- Verstehen der verschiedenen Mistral-Modelle und wie man eines auswählt.

- Tätigen von API-Aufrufen mit Python, TypeScript und cURL für Chat-Vervollständigungen und Einbettungen.

- Überprüfen der Preise und Überwachen Ihrer Nutzung.

- Verwenden eines GUI-Tools wie APidog für einfaches API-Testen.

- Verstärkung wesentlicher Sicherheitsbest Practices.

Die Mistral-API ist ein Tor zu unglaublich leistungsstarken KI-Funktionen. Ihr API-Schlüssel ist der buchstäbliche Schlüssel zum Freischalten dieses Potenzials. Indem Sie die hier beschriebenen Schritte und Best Practices befolgen, sind Sie auf dem besten Weg, modernste KI in Ihre eigenen Projekte zu integrieren.

Zögern Sie nicht, die offizielle Mistral-Dokumentation weiter zu erkunden – sie ist die ultimative Informationsquelle für alle verfügbaren Parameter, Modelle und erweiterten Funktionen.

Viel Spaß beim Bauen!

Benötigen Sie eine integrierte All-in-One-Plattform für Ihr Entwicklerteam, um mit maximaler Produktivität zusammenzuarbeiten?

Apidog liefert alle Ihre Anforderungen und ersetzt Postman zu einem viel günstigeren Preis!