Stellen Sie sich eine Entwicklungsumgebung vor, in der Ihr Code von einem Team spezialisierter KI-Agenten erstellt wird. Claude entwirft die Architektur, Gemini schreibt die Tests und DeepSeek implementiert fehlerfrei Funktionen – alles in perfekter Harmonie. Dies ist keine futuristische Fantasie; es ist die Leistung von MCP Sequential Thinking in Kombination mit OpenRouter. In diesem Leitfaden zeigen wir Ihnen, wie Sie es zu Ihrer Geheimwaffe für die Bewältigung komplexer Projekte machen können.

Was ist MCP Sequential Thinking?

MCP (Model Context Protocol) Sequential Thinking ist ein revolutionärer Ansatz zur Problemlösung, der komplexe Coding-Herausforderungen angeht, indem er sie in eine Reihe klarer, logischer und miteinander verbundener Schritte aufteilt. Es geht um mehr als nur das Codieren; es geht darum, Ihre Gedanken zu strukturieren und die Stärken verschiedener KI-Modelle in jeder Phase des Entwicklungsprozesses zu nutzen. Anstatt sich kopfüber in die Implementierung zu stürzen, betont MCP Sequential Thinking:

1. Präzise Problemdefinition: Das klare Formulieren des Problems, das Sie lösen möchten, ohne Raum für Mehrdeutigkeiten.

2. Atomare Sub-Task-Zerlegung: Aufteilen des Problems in kleinere, überschaubare und unabhängige Teilaufgaben.

3. Abhängigkeitssequenzierung: Identifizieren und Organisieren der Abhängigkeiten zwischen diesen Teilaufgaben, um einen logischen Ausführungsablauf sicherzustellen.

4. Optimierter Ausführungsablauf: Optimierung der Ausführung dieser Teilaufgaben für maximale Effizienz und Effektivität.

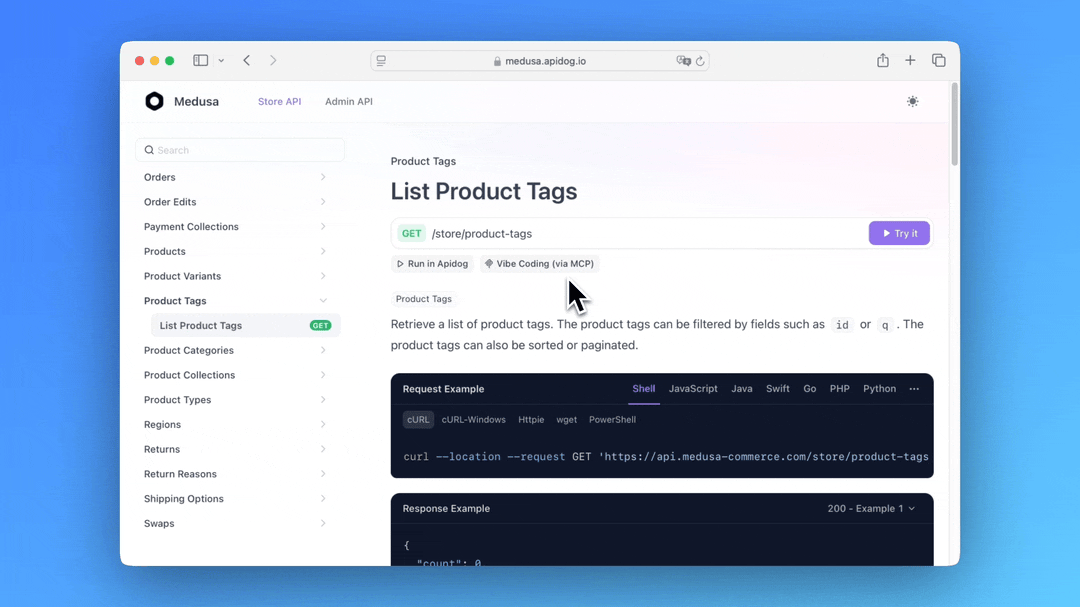

Hier ist eine kurze Zusammenfassung der Angebote des Apidog MCP Servers:

- Generiert oder modifiziert Code basierend auf Ihren API-Spezifikationen

- Durchsucht API-Spezifikationsinhalte

- Erstellt Datenmodelle und DTOs, die sich nahtlos an Ihr API-Design anpassen

- Fügt relevante Kommentare und Dokumentation basierend auf API-Spezifikationen hinzu

Durch die Funktion als Brücke zwischen Ihren Apidog-Projekten und Cursor stellt der Apidog MCP Server sicher, dass Ihr KI-Assistent Zugriff auf die aktuellsten API-Designs hat. Diese Integration verbessert die Memory Bank-Funktion, indem sie strukturierte API-Informationen bereitstellt, auf die Cursor während der Entwicklung verweisen kann.

Um mehr zu erfahren, lesen Sie die Dokumentation oder besuchen Sie die NPM-Seite.

Erwägen Sie auch, Apidog auszuprobieren – eine integrierte, leistungsstarke und kostengünstige Alternative zu Postman!

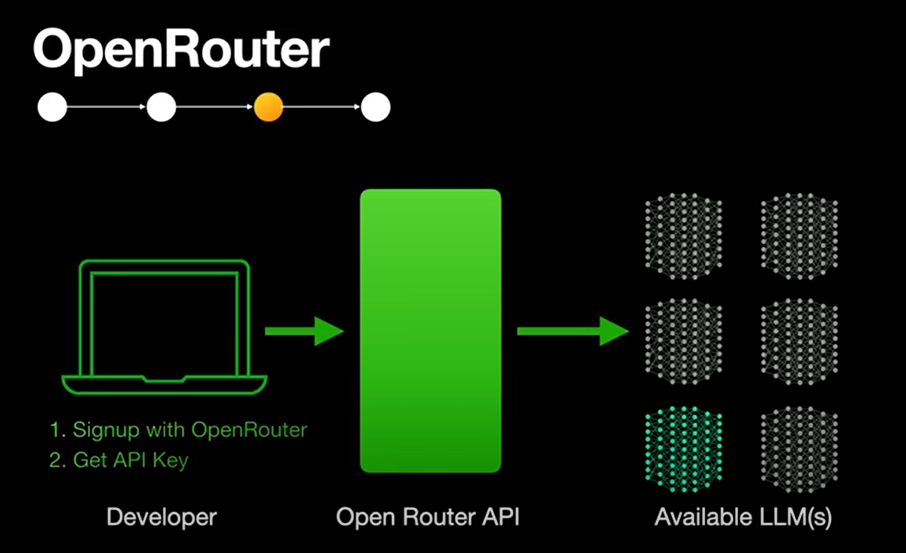

Wie OpenRouter AI diesen Prozess verbessert

OpenRouter AI spielt eine entscheidende Rolle bei der Verbesserung von MCP Sequential Thinking. Es fungiert als einheitliches API-Gateway und bietet Zugriff auf eine Vielzahl von KI-Modellen (GPT-4, Claude, Mistral und mehr). Dies ermöglicht es Ihnen, die einzigartigen Stärken verschiedener Modelle für jeden Schritt der Sequenz zu nutzen. OpenRouter AI verbessert den Prozess durch:

- Automatisierung sich wiederholender Codierungsschritte: Befreit Sie von mühsamen Aufgaben, indem es automatisch Boilerplate-Code generiert, Projektstrukturen einrichtet und Entwicklungsumgebungen konfiguriert.

- Generierung von Boilerplate-Code: Reduziert die Entwicklungszeit drastisch, indem automatisch die grundlegende Codestruktur und die anfänglichen Komponenten für jede Aufgabe erstellt werden.

- Vorschlagen von Optimierungen: Bietet intelligente Vorschläge zur Verbesserung der Codeeffizienz, -leistung und -sicherheit.

- Debugging in Echtzeit: Hilft, Fehler schnell zu identifizieren und zu beheben, mit Echtzeit-Codeanalyse und intelligenten Debugging-Vorschlägen.

MCP Sequential Thinking 101

Was macht das anders?

Traditionelles KI-Codieren beinhaltet oft Einzelmodell-Konversationen, bei denen eine einzelne KI für die gesamte Aufgabe verantwortlich ist. Im Gegensatz dazu ist Sequential Thinking wie ein KI-Fließband:

Task --> [Planner] --> [Researcher] --> [Coder] --> [Reviewer]Real-World-Beispiel aus dem Forum-Thread:

User: "Build a React dashboard showing real-time crypto prices"

1. Claude-3.5-Sonnet: Creates architecture plan

2. Gemini-2.0-Flash-Thinking: Researches best WebSocket APIs

3. DeepSeek-R1: Implements React components

4. GPT-4-Omni: Reviews code for security flawsKey Components

1. MCP Server Network: Verwaltet die Übergabe von Aufgaben zwischen verschiedenen KI-Modellen.

2. OpenRouter Gateway: Leitet Aufgaben an das kostengünstigste und am besten geeignete KI-Modell weiter.

3. Cursor IDE Integration: Bietet native Workflow-Steuerung direkt in Ihrer Entwicklungsumgebung.

Richten Sie MCP Sequential Thinking und OpenRouter wie ein Profi ein

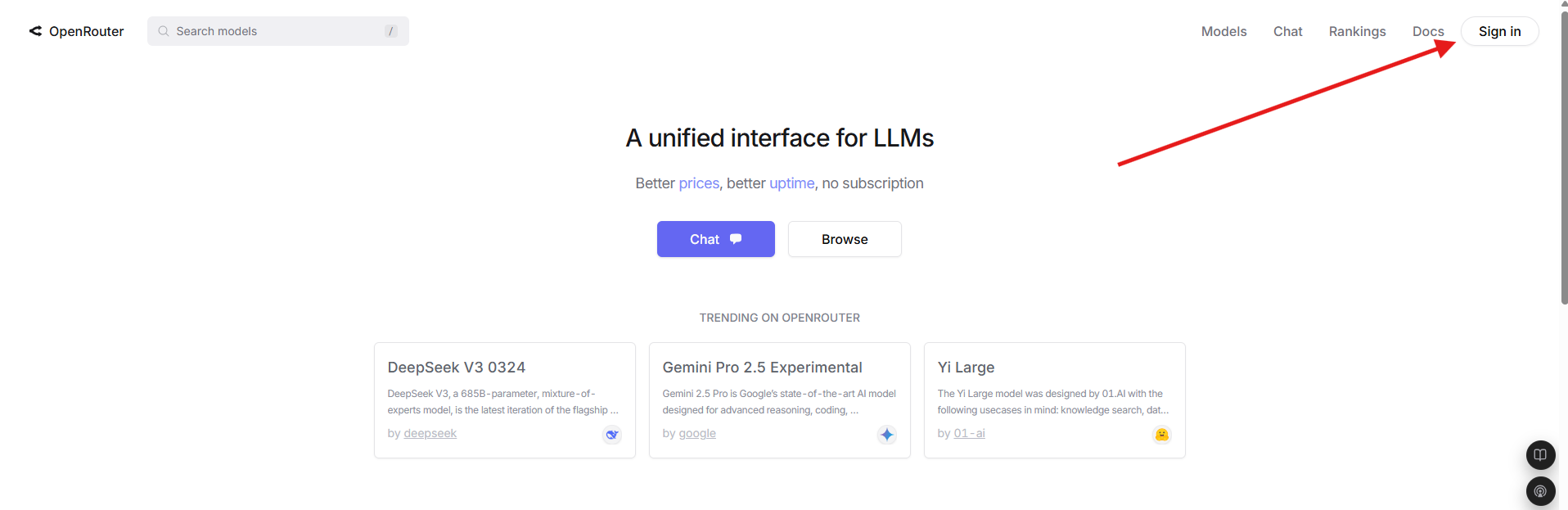

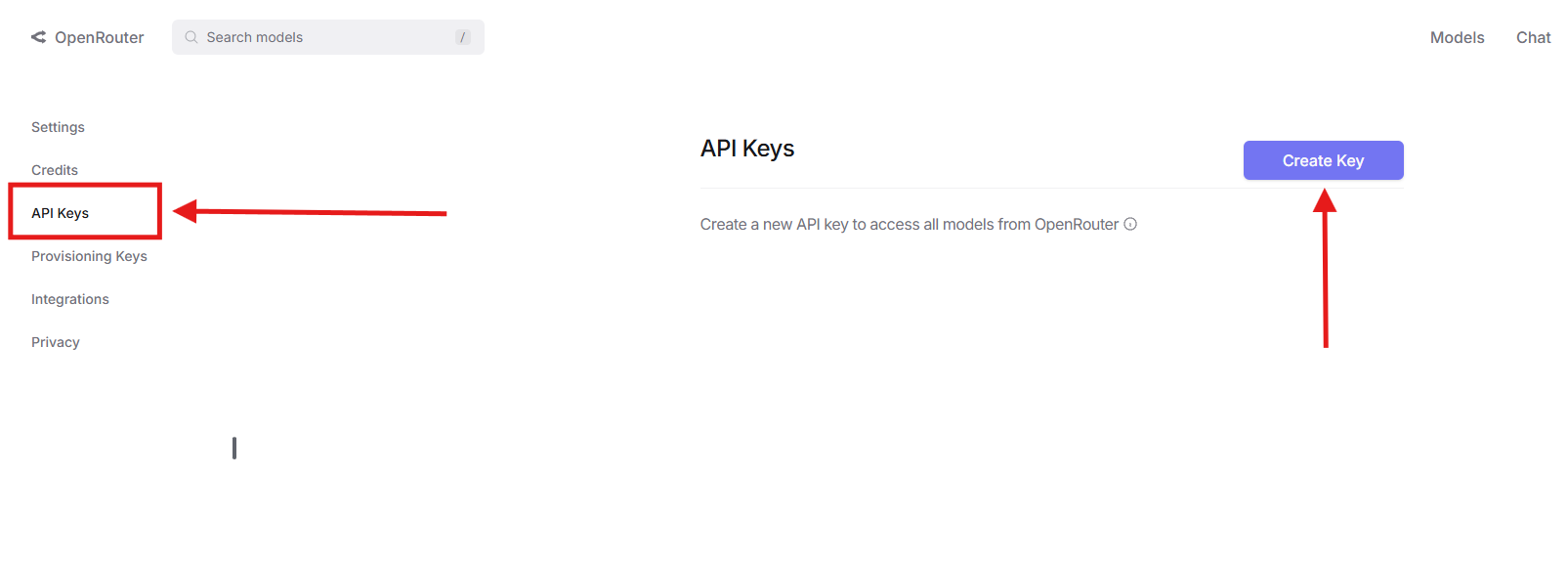

Schritt 1: Holen Sie sich Ihren OpenRouter API-Schlüssel

- Besuchen Sie OpenRouter.ai

2. Melden Sie sich an → Gehen Sie zu Account Settings → API Keys

3. Klicken Sie auf Create Key → Kopieren Sie in die Zwischenablage

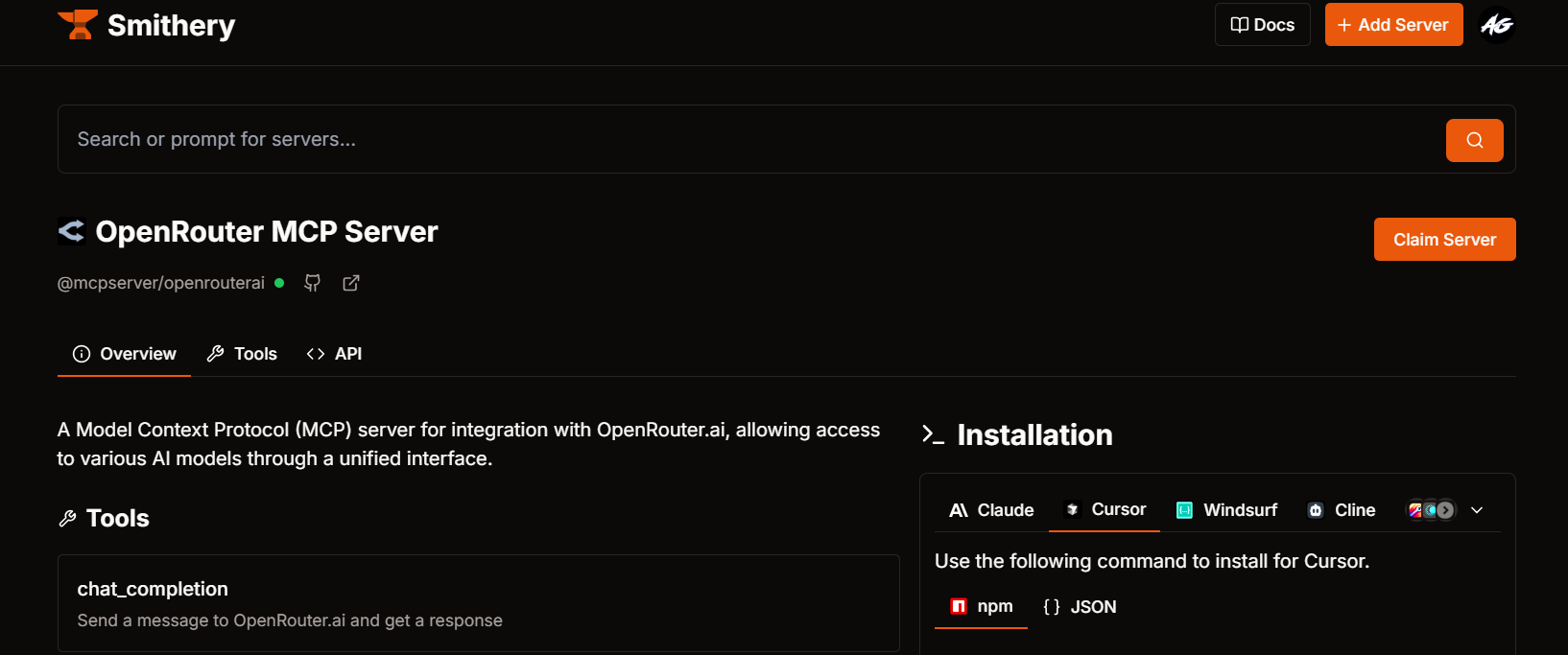

Schritt 2: Konfigurieren Sie OpenRouter in Smithery AI

- Öffnen Sie Smithery AI

- Suchen Sie nach "OpenRouter MCP"

- Fügen Sie im Konfigurationsfenster ein:

{

"api_key": "your_copied_key",

"default_model": "google/gemini-pro" // Free tier recommended

}

4. Kopieren Sie entweder:

- NPM Command:

npx -y @smithery/cli@latest install @mcpserver/openrouterai --client cursor --config "{\"openrouterApiKey\":\"YOUR_API_KEY\",\"openrouterDefaultModel\":\"deepseek/deepseek-chat-v3-0324:free\"}"- oder JSON Config (für manuelle Einrichtung):

{

"mcpServers": {

"openrouterai": {

"command": "npx",

"args": [

"-y",

"@smithery/cli@latest",

"run",

"@mcpserver/openrouterai",

"--config",

"{\"openrouterApiKey\":\"YOUR_API_KEY\",\"openrouterDefaultModel\":\"deepseek/deepseek-chat-v3-0324:free\"}"

]

}

}

}

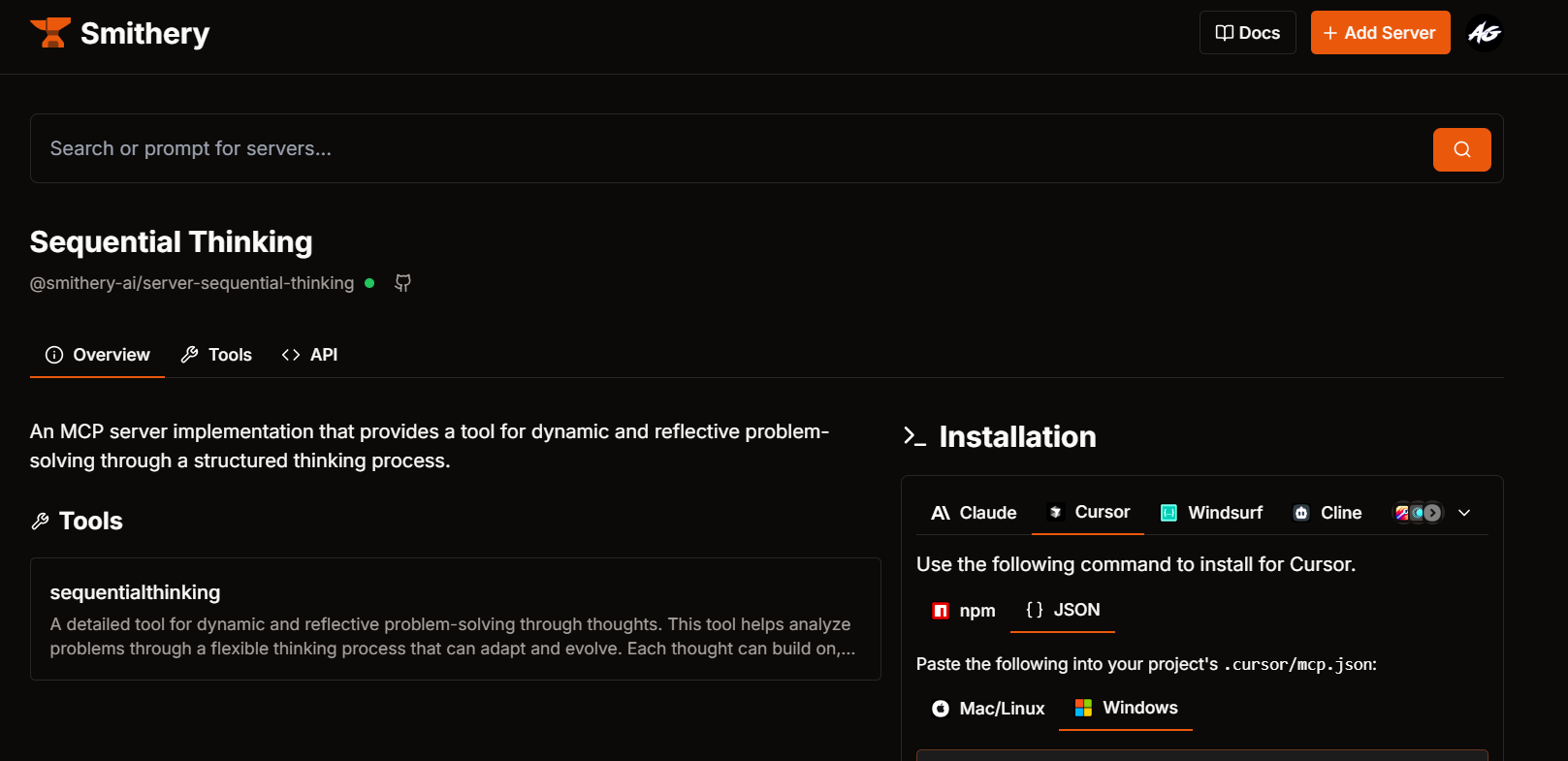

Schritt 3: Fügen Sie Sequential Thinking MCP hinzu

- Suchen Sie in Smithery AI nach "Sequential Thinking MCP Server"

- Wählen Sie Ihr bevorzugtes Format:

- NPM Quick Install:

npx -y @smithery/cli@latest install @smithery-ai/server-sequential-thinking --client cursor --key YOUR_API_KEY- oder JSON Config (Erweitert):

{

"mcpServers": {

"server-sequential-thinking": {

"command": "cmd",

"args": [

"/c",

"npx",

"-y",

"@smithery/cli@latest",

"run",

"@smithery-ai/server-sequential-thinking",

"--key",

"YOUR_API_KEY"

]

}

}

}

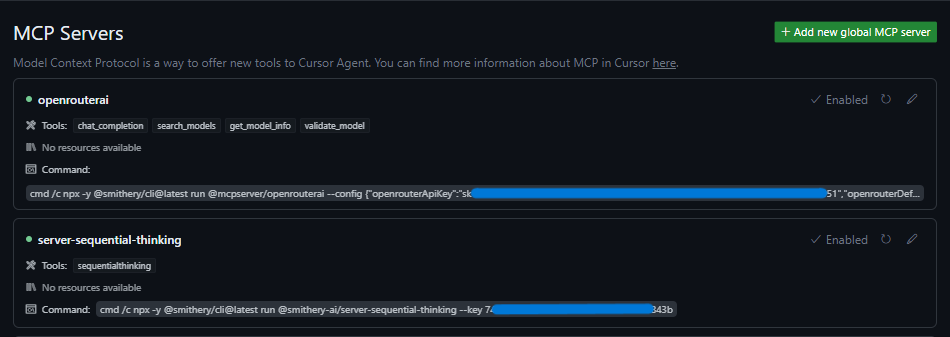

Schritt 4: Aktivieren Sie in Cursor IDE

Für NPM-Benutzer:

- Öffnen Sie Cursor → Terminal (

Ctrl + j) - Fügen Sie die Befehle einen nach dem anderen ein

- Warten Sie auf ✅ Erfolgsbestätigung

Für JSON-Konfigurationsbenutzer:

- Öffnen Sie die Cursor-Einstellungen (

Ctrl + shift + j) - Navigieren Sie zu MCP → Server

- Klicken Sie auf Server hinzufügen → Fügen Sie JSON ein

- Speichern → Suchen Sie nach dem grünen ● Verbunden-Status

Überprüfen Sie die Installation:

Suchen Sie nach dem Hinzufügen des Servers nach einem grünen Punkt neben "Sequential Thinking" in der MCP-Serverliste, der eine erfolgreiche Verbindung anzeigt.

Wenn Sie diese Schritte befolgen, integrieren Sie OpenRouter und Sequential Thinking MCP-Server effektiv in Cursor und erweitern so Ihre Entwicklungsumgebung mit fortschrittlichen KI-gesteuerten Tools.

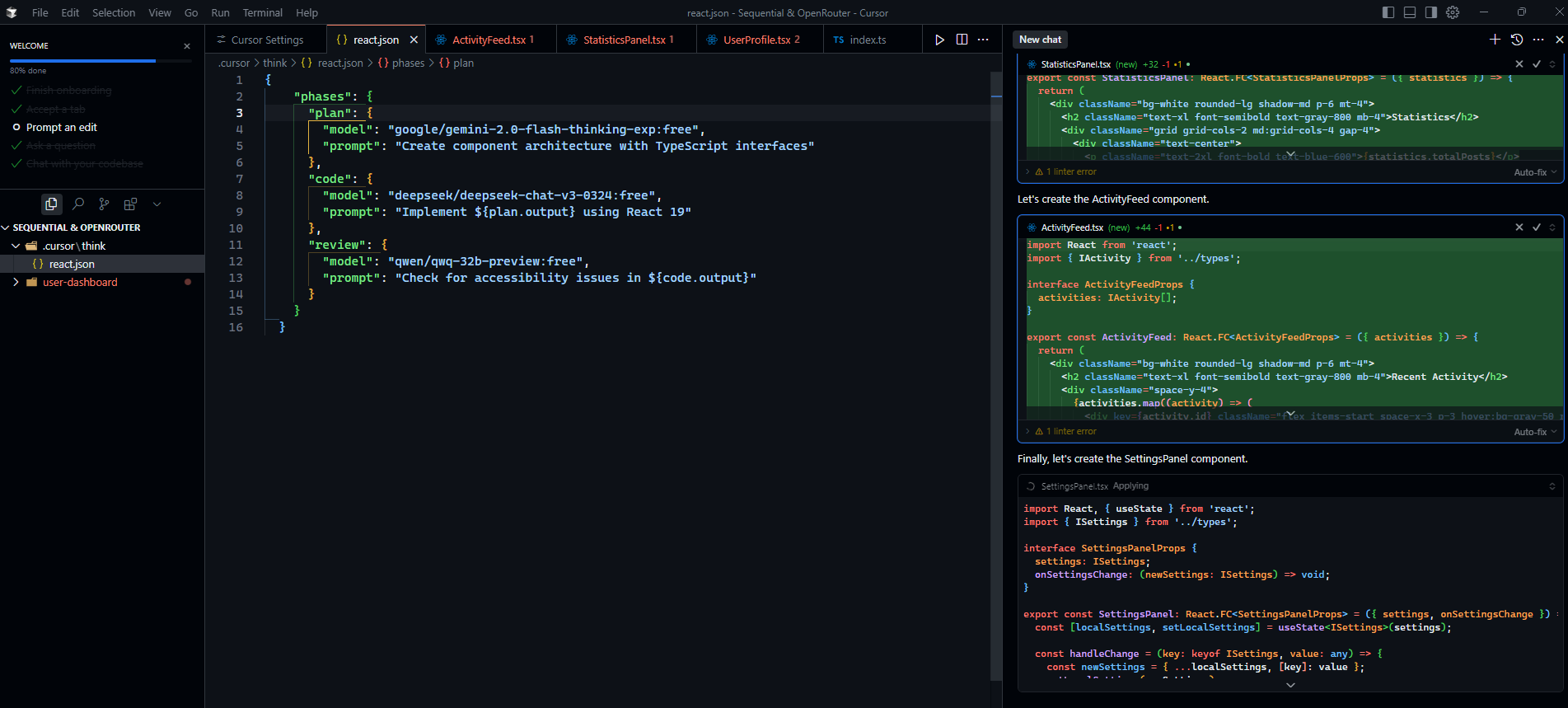

Erstellen Sie Ihren ersten OpenRouter- und MCP-Sequential-Thinking-Workflow

Entwicklung einer Vorlage für React-Projekte:

Öffnen Sie ein neues Projekt mit Cursor und erstellen Sie eine Datei mit dem Namen .cursor/think/react.json mit folgendem Inhalt:

{

"phases": {

"plan": {

"model": "google/gemini-2.0-flash-thinking-exp:free",

"prompt": "Create component architecture with TypeScript interfaces"

},

"code": {

"model": "deepseek/deepseek-chat-v3-0324:free",

"prompt": "Implement ${plan.output} using React 19"

},

"review": {

"model": "qwen/qwq-32b-preview:free",

"prompt": "Check for accessibility issues in ${code.output}"

}

}

}Verwendung: Um diesen Workflow auszuführen, führen Sie den folgenden Befehl aus:

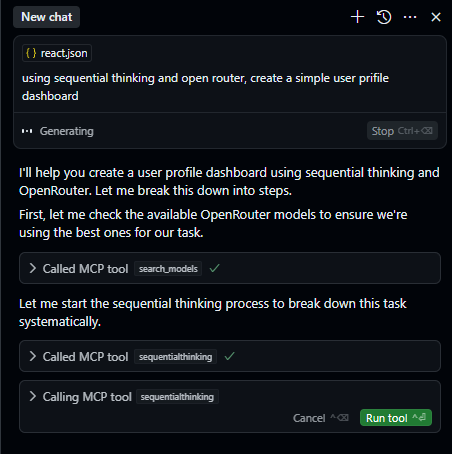

/think react "Simple User profile dashboard"Workflow-Aufschlüsselung:

- Planungsphase mit Gemini 2.0 Flash Thinking: Verwenden Sie das Gemini 2.0 Flash Thinking-Modell, um eine detaillierte Komponentenarchitektur mit TypeScript-Schnittstellen zu erstellen. Dieser Schritt stellt eine gut strukturierte Grundlage für Ihr React-Projekt sicher.

- Codierungsphase mit DeepSeek Chat V3: Implementieren Sie die geplante Architektur mit React 19, indem Sie das DeepSeek Chat V3-Modell nutzen. Diese Phase konzentriert sich auf die Übersetzung des Designs in funktionale Codekomponenten.

- Überprüfungsphase mit Qwen 32B Preview: Führen Sie eine gründliche Überprüfung des implementierten Codes durch, um etwaige Barrierefreiheitsprobleme zu identifizieren und zu beheben, um sicherzustellen, dass die Anwendung benutzerfreundlich ist und den Barrierefreiheitsstandards entspricht.

Codeausführung: Bei der Ausführung des definierten Workflows greift Cursor sequenziell auf die angegebenen MCP (Model Context Protocol)-Tools – Sequential Thinking und OpenRouter AI – zu, um die zugewiesenen Aufgaben auszuführen.

Während dieses Prozesses fordert Cursor Ihre ausdrückliche Erlaubnis an, bevor jeder MCP-Server verwendet wird, um sicherzustellen, dass Sie die Kontrolle über die Integration dieser Tools in Ihren Entwicklungsworkflow behalten.

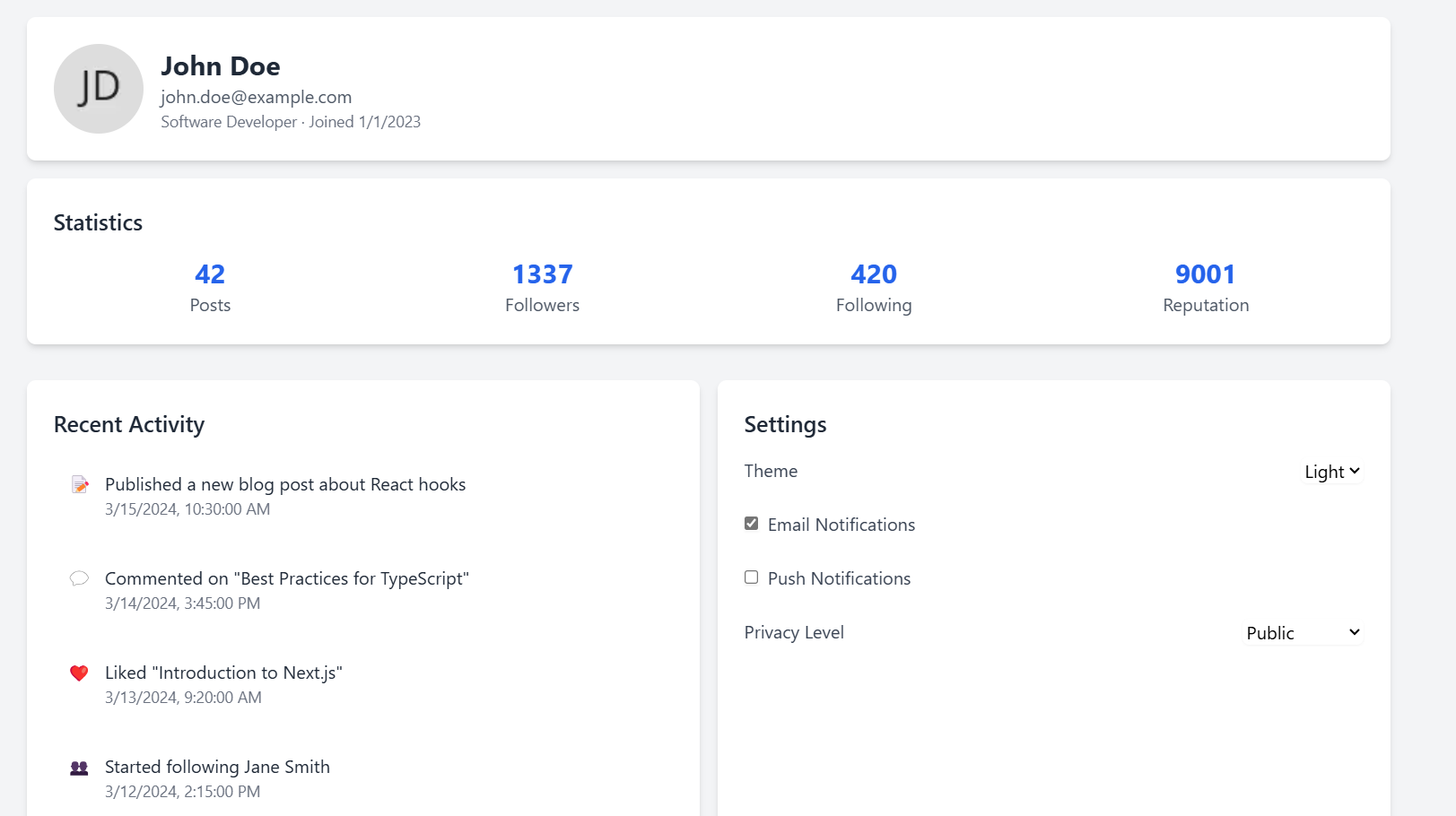

Ergebnis: Ein produktionsbereites User-Profile-Dashboard in wenigen Minuten im Vergleich zu Stunden oder Tagen, die Sie manuell aufwenden müssten.

Abschließende Gedanken: Die Zukunft des Codierens ist da

MCP Sequential Thinking ist nicht nur ein Trend; es ist eine grundlegende Veränderung in unserer Herangehensweise an die Softwareentwicklung. Durch die Nutzung der Leistung mehrerer KI-Modelle auf strukturierte und effiziente Weise können Sie ein beispielloses Maß an Produktivität, Codequalität und Innovation erreichen. Ihr Code wird nie wieder derselbe sein. Nutzen Sie die Zukunft der KI-gestützten Entwicklung mit MCP Sequential Thinking und entfalten Sie das volle Potenzial Ihres Teams. Die wichtigsten Erkenntnisse sind die Fähigkeit, komplexe Projekte in kleinere, überschaubare Aufgaben zu zerlegen, diese Aufgaben KI-Modellen zuzuweisen, die auf diesen speziellen Bereich spezialisiert sind, und den gesamten Entwicklungslebenszyklus zu optimieren. Mit dem kontinuierlichen Fortschritt von KI und Tools wie OpenRouter und Cursor ist die Zukunft der Softwareentwicklung zweifellos mit MCP Sequential Thinking verknüpft, was es zu einer wesentlichen Fähigkeit für jeden zukunftsorientierten Entwickler macht. 🚀