In der sich schnell entwickelnden Welt der KI-gestützten Entwicklung hat sich Cursor für viele Ingenieure zu einer beliebten IDE entwickelt. Doch mit der Verschiebung der KI-Landschaft ändern sich auch die Erwartungen der Entwickler. Die Community wünscht sich dringend die native Unterstützung von Kimi K2 – Moonshot AIs offenem agentischem Intelligenzmodell – in Cursor. Warum? Weil Kimi K2 ein Game-Changer für Codierung, Argumentation und Werkzeugnutzung ist und seine Kosteneffizienz kaum zu übertreffen ist.

Dieser Artikel beleuchtet, warum Entwickler Kimi K2 in Cursor fordern, wie Sie es schon heute nutzen können (auch ohne native Unterstützung) und wie der Apidog MCP Server Ihren Workflow auf die nächste Stufe heben kann.

Profi-Tipp:

Apidog MCP ServerStarten Sie mit Apidog MCP Server und erleben Sie eine nahtlose KI-API-Integration.

Kimi K2: Offene agentische Intelligenz für Entwickler

Kimi K2 ist nicht nur ein weiteres großes Sprachmodell. Es wurde für agentische Aufgaben entwickelt – das heißt, es beantwortet nicht nur Fragen, es handelt. Mit 32 Milliarden aktivierten Parametern (von insgesamt 1 Billion) erreicht Kimi K2 eine hochmoderne Leistung in den Bereichen Codierung, Mathematik und Werkzeugnutzung.

Hauptmerkmale:

- Agentisches Codieren: Automatisieren Sie komplexe Workflows, von der Datenanalyse bis zur Codegenerierung.

- Werkzeugnutzung: Kimi K2 kann Werkzeuge verstehen und nutzen, was es ideal für den Aufbau agentischer Anwendungen macht.

- Open Source: Sowohl die Basis- als auch die Instruktionsmodelle stehen zum Download und zur Anpassung bereit.

Anwendungsfälle:

- Gehaltsdatenanalyse mit mehrstufigen statistischen Workflows.

- Automatisches Code-Refactoring und Debugging.

- Erstellung benutzerdefinierter Agenten, die mit APIs, Dateien und externen Tools interagieren.

Benchmarks:

Kimi K2 erreicht oder übertrifft führende Open-Source- und proprietäre Modelle in einer Reihe von Aufgaben, einschließlich LiveCodeBench, SWE-bench und mehr.

Warum Entwickler Kimi K2 in Cursor wollen

Die Nachfrage nach Kimi K2 in Cursor ist in der Community laut und deutlich zu hören:

- „Das Modell Kimi K2 ist ein Biest, und so günstig, das brauchen wir in Cursor, es wird helfen, viel mit dem Pro-Preismodell zu erledigen.“

- „+1 dazu, einige Open-Source-Modelle haben wirklich die Grenzen verschoben, das Team sollte sich allmählich von Anthropic entwöhnen und eine engere Zusammenarbeit mit Open-Source-Modellen in Betracht ziehen.“

- „Absolut, genau danach bin ich hierher gekommen, um zu fragen.“

Warum die Begeisterung?

- Leistung: Kimi K2 ist ein Mixture-of-Experts (MoE)-Modell mit 1 Billion Parametern, optimiert für agentische Aufgaben, Codierung und Argumentation.

- Kosten: Mit nur 60 Cent pro Million Eingabetokens (Cache-Fehler) und 2,5 $ pro Million Ausgabetokens ist es eines der günstigsten Hochleistungsmodelle auf dem Markt.

- Open Source: Kimi K2 ist wirklich offen, mit Gewichten und APIs, die für jedermann zur Nutzung, zum Testen und zur Integration verfügbar sind.

Was fehlt?

Trotz seiner Leistung ist Kimi K2 noch kein integriertes Modell in Cursor. Aber die Nachfrage der Community drängt auf Veränderung – und in der Zwischenzeit gibt es Workarounds.

So verwenden Sie Kimi K2 in Cursor (Schritt-für-Schritt-Anleitung)

Obwohl Cursor Kimi K2 noch nicht nativ unterstützt, können Sie es heute über OpenRouter verwenden. So geht’s:

1. OpenRouter-Konto erstellen

- Gehen Sie zu https://openrouter.ai/ und melden Sie sich an.

2. Guthaben hinzufügen

- Besuchen Sie https://openrouter.ai/settings/credits, um Ihrem Konto Guthaben hinzuzufügen.

3. API-Schlüssel generieren

- Gehen Sie zu https://openrouter.ai/settings/keys und erstellen Sie einen neuen API-Schlüssel.

4. Cursor konfigurieren

In Cursor navigieren Sie zu Einstellungen > Modelle.

Ersetzen Sie die Modell-URL durch https://openrouter.ai/api/v1 und fügen Sie Ihren API-Schlüssel ein.

5. Kimi K2 als benutzerdefiniertes Modell hinzufügen

Klicken Sie auf Benutzerdefiniertes Modell hinzufügen und geben Sie moonshotai/kimi-k2 ein.

6. Kimi K2 in Cursor verwenden

Sie können Kimi K2 nun direkt in Cursor für Codierung, Argumentation und mehr verwenden.

Hinweis:

Der Agentenmodus funktioniert möglicherweise nicht wie gewohnt, da dies keine native Cursor-Integration ist. Aber für die meisten Aufgaben liefert Kimi K2 hervorragende Ergebnisse.

Optimieren Sie Ihren Workflow: Verbinden Sie Kimi K2 mit Ihren API-Spezifikationen über den Apidog MCP Server

Die Verwendung von Kimi K2 in Cursor ist leistungsstark, aber Sie können noch mehr Wert freisetzen, indem Sie Ihre API-Spezifikationen mit dem Apidog MCP Server direkt mit Ihren KI-Tools verbinden.

Was ist der Apidog MCP Server?

Apidog MCP Server ermöglicht es Ihnen, Ihre API-Spezifikation als Datenquelle für KI-gestützte IDEs wie Cursor zu verwenden. Das bedeutet, Sie können:

- Code generieren oder ändern basierend auf Ihrer API-Spezifikation.

- Ihre API-Dokumentation mit KI suchen und analysieren.

- Code-Updates, DTO-Generierung und Dokumentationsaufgaben automatisieren.

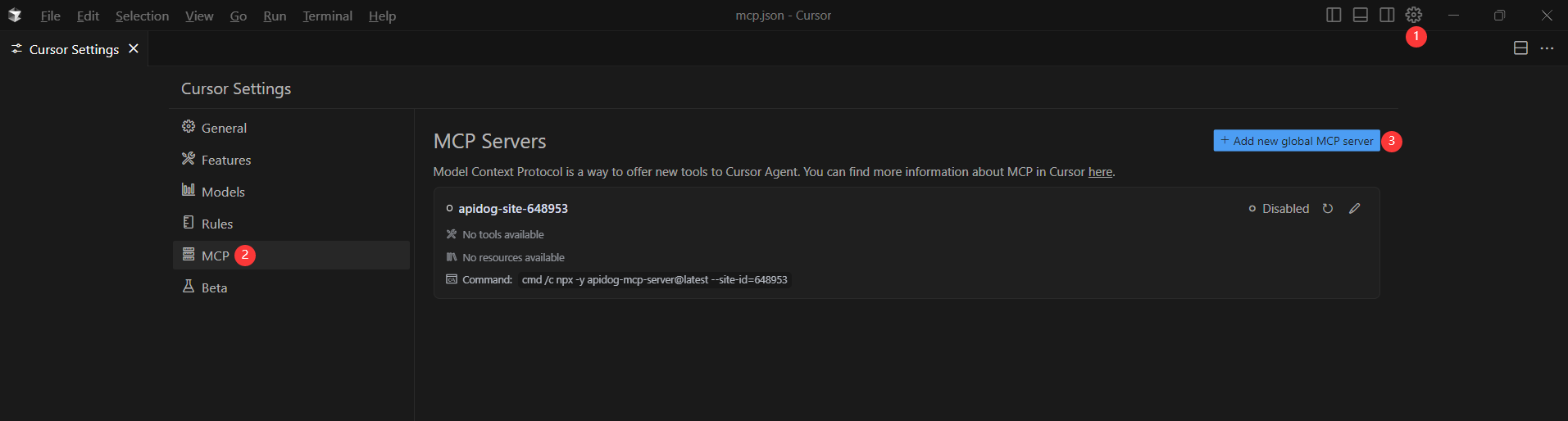

So richten Sie den Apidog MCP Server mit Cursor ein

Voraussetzungen:

Bevor Sie beginnen, stellen Sie Folgendes sicher:

✅ Node.js ist installiert (Version 18+; neueste LTS empfohlen)

✅ Sie verwenden eine IDE, die MCP unterstützt, wie z.B.: Cursor

Schritt 1: OpenAPI-Datei vorbereiten

Sie benötigen Zugriff auf Ihre API-Definition:

- Eine URL (z.B.

https://petstore.swagger.io/v2/swagger.json) - Oder ein lokaler Dateipfad (z.B.

~/projects/api-docs/openapi.yaml) - Unterstützte Formate:

.jsonoder.yaml(OpenAPI 3.x empfohlen)

Schritt 2: MCP-Konfiguration zu Cursor hinzufügen

Sie werden nun die Konfiguration zur mcp.json-Datei von Cursor hinzufügen.

Denken Sie daran, <oas-url-or-path> durch Ihre tatsächliche OpenAPI-URL oder Ihren lokalen Pfad zu ersetzen.

- Für MacOS/Linux:

{

"mcpServers": {

"API specification": {

"command": "npx",

"args": [

"-y",

"apidog-mcp-server@latest",

"--oas=https://petstore.swagger.io/v2/swagger.json"

]

}

}

}Für Windows:

{

"mcpServers": {

"API specification": {

"command": "cmd",

"args": [

"/c",

"npx",

"-y",

"apidog-mcp-server@latest",

"--oas=https://petstore.swagger.io/v2/swagger.json"

]

}

}

}Schritt 3: Verbindung überprüfen

Nach dem Speichern der Konfiguration testen Sie diese in der IDE, indem Sie Kimi K2 (oder einen beliebigen KI-Agenten) bitten:

Please fetch API documentation via MCP and tell me how many endpoints exist in the project.Wenn es funktioniert, sehen Sie eine strukturierte Antwort, die Endpunkte und deren Details auflistet. Wenn nicht, überprüfen Sie den Pfad zu Ihrer OpenAPI-Datei und stellen Sie sicher, dass Node.js ordnungsgemäß installiert ist.

Beispiel-Anwendungsfälle:

- „Verwenden Sie MCP, um die API-Spezifikation abzurufen und Java-Datensätze für das ‚Produkt‘-Schema zu generieren.“

- „Basierend auf der API-Spezifikation neue Felder zum ‚Benutzer‘-DTO hinzufügen.“

- „Kommentare für jedes Feld in der ‚Order‘-Klasse basierend auf der API-Dokumentation hinzufügen.“

Warum Apidog MCP Server?

- Nahtlose Integration zwischen Ihren API-Dokumenten und KI-Tools.

- Automatisieren Sie wiederkehrende Codierungs- und Dokumentationsaufgaben.

- Halten Sie Ihre API und Ihren Code synchron – keine manuellen Updates mehr.

Fazit: Die Zukunft der KI-gesteuerten Entwicklung ist offen, flexibel und automatisiert

Die Nachfrage nach Kimi K2 in Cursor ist ein klares Signal: Entwickler wünschen sich mehr Auswahl, mehr Leistung und mehr Flexibilität bei ihren KI-Tools. Während die native Unterstützung noch in den Sternen steht, können Sie Kimi K2 heute mit OpenRouter in Cursor verwenden – und Ihren Workflow noch weiter optimieren, indem Sie Ihre API-Dokumentation mit dem Apidog MCP Server verbinden.

Bereit, die nächste Stufe der intelligenten, automatisierten API-Entwicklung zu erleben?

- Richten Sie Kimi K2 in Cursor gemäß den obigen Schritten ein.

- Verbinden Sie Ihre API-Dokumente mit Apidog MCP Server mit Cursor.

- Genießen Sie einen nahtlosen, agentischen Entwicklungs-Workflow, der Zeit spart, Fehler reduziert und Ihr Team stärkt.