Hallo, liebe Entwicklerkollegen und KI-Enthusiasten! Habt ihr euch jemals vor einem leeren Code-Editor wiedergefunden, die Idee im Kopf scheinbar unerreichbar? Oder habt ihr vielleicht mit einem KI-Modell herumexperimentiert und euch gefragt, ob ihr dessen Stärken mit einem anderen kombinieren könntet, um etwas wirklich Mächtiges zu schaffen. Nun, dann seid ihr hier genau richtig.

Heute tauchen wir tief in einen der spannendsten Entwickler-Workflows ein: die Verwendung von Minimax M2 zusammen mit Claude, um Code zu schreiben, zu verfeinern und zu verstehen. Stellt es euch vor, als würdet ihr euer eigenes KI-Dreamteam zusammenstellen. Claude, mit seiner messerscharfen Argumentation und seinem riesigen Kontextfenster, kann euer strategischer Architekt sein. Währenddessen kann Minimax M2, ein Kraftpaket für sich, als spezialisierter Ingenieur agieren, der Code mit beeindruckender Präzision generiert und ausführt.

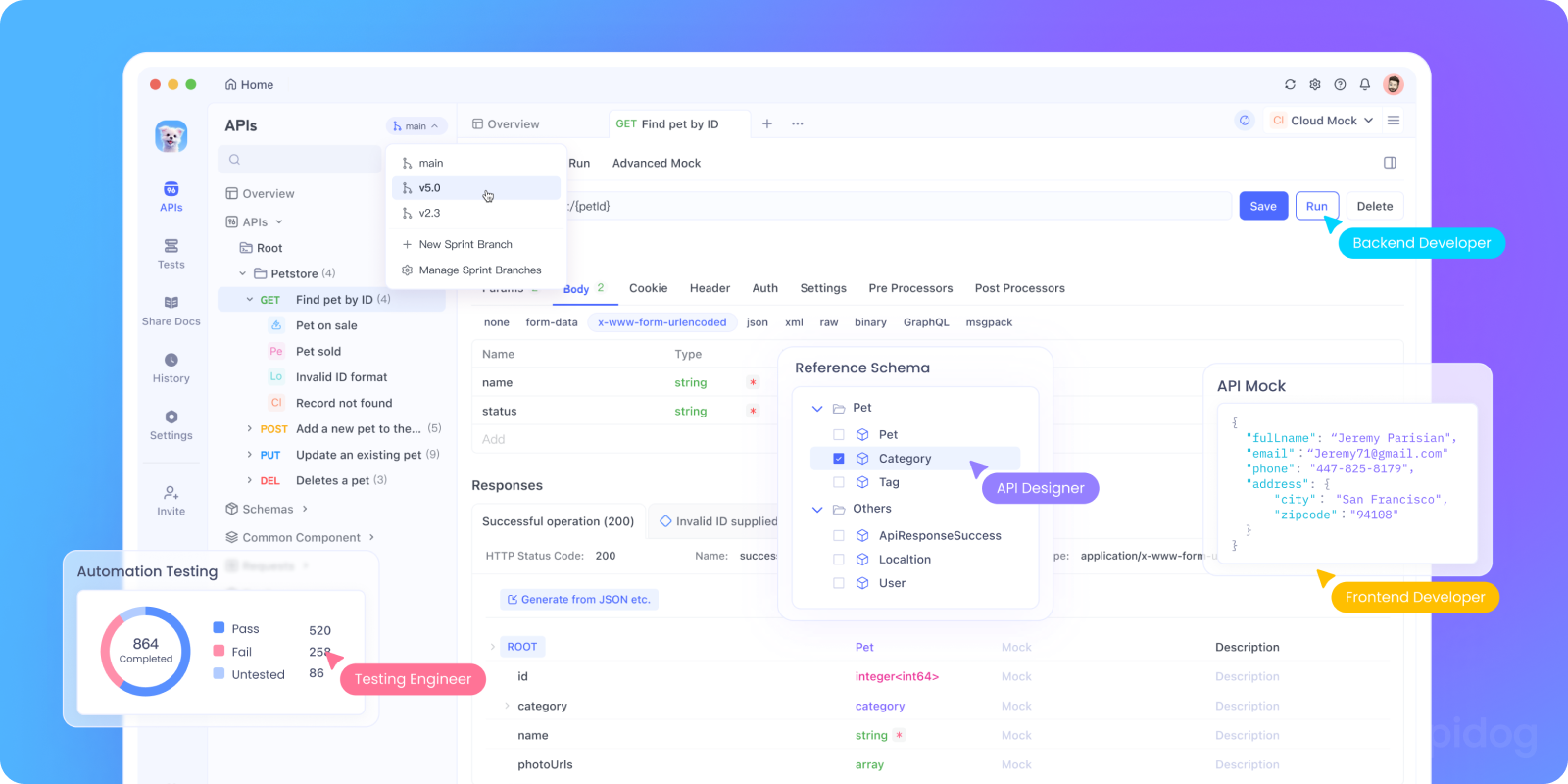

Möchtet ihr eine integrierte All-in-One-Plattform, damit euer Entwicklerteam mit maximaler Produktivität zusammenarbeiten kann?

Apidog erfüllt all eure Anforderungen und ersetzt Postman zu einem viel günstigeren Preis!

Also, schnappt euch euer Lieblingsgetränk und lasst uns diese Reise antreten, um euren Codierungsprozess zu beschleunigen!

Die Bühne bereiten: Warum Minimax M2 und Claude kombinieren?

Zunächst fragt ihr euch vielleicht: "Warum der Aufwand, zwei KI-Modelle zu verwenden? Reicht nicht eines aus?" Das ist eine berechtigte Frage! Die Antwort liegt im Konzept der Spezialisierung und Zusammenarbeit.

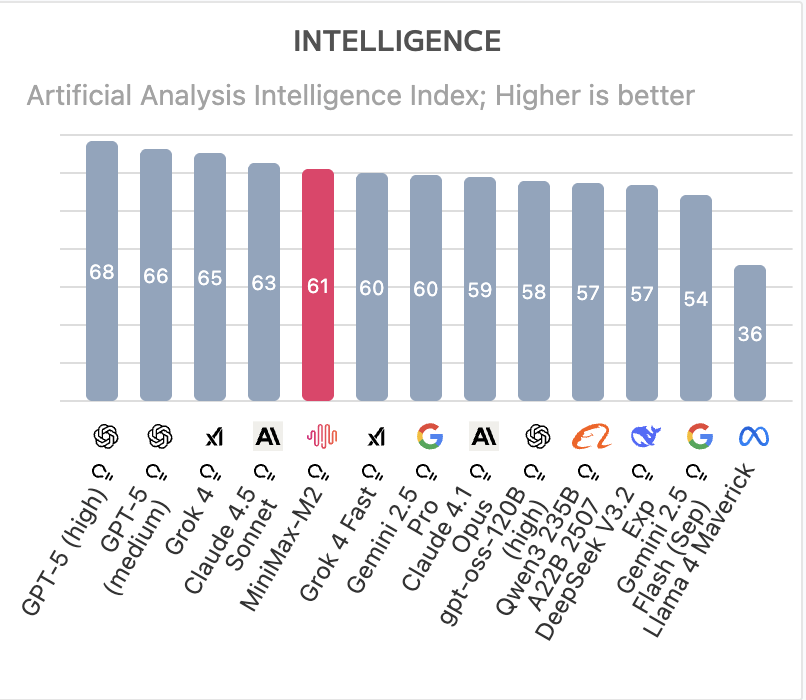

Unser KI-Power-Duo verstehen

Claude (von Anthropic) wird oft für seine tiefgreifenden Denkfähigkeiten, seine Fähigkeit, komplexe, nuancierte Anweisungen zu erfassen, und sein massives Kontextfenster gelobt. Man kann ihm eine ausgedehnte, mehrteilige Codebasis geben und um eine detaillierte Umgestaltung bitten, und es wird ein kohärentes Verständnis des gesamten Projekts beibehalten. Es ist ein brillanter Stratege und Architekt.

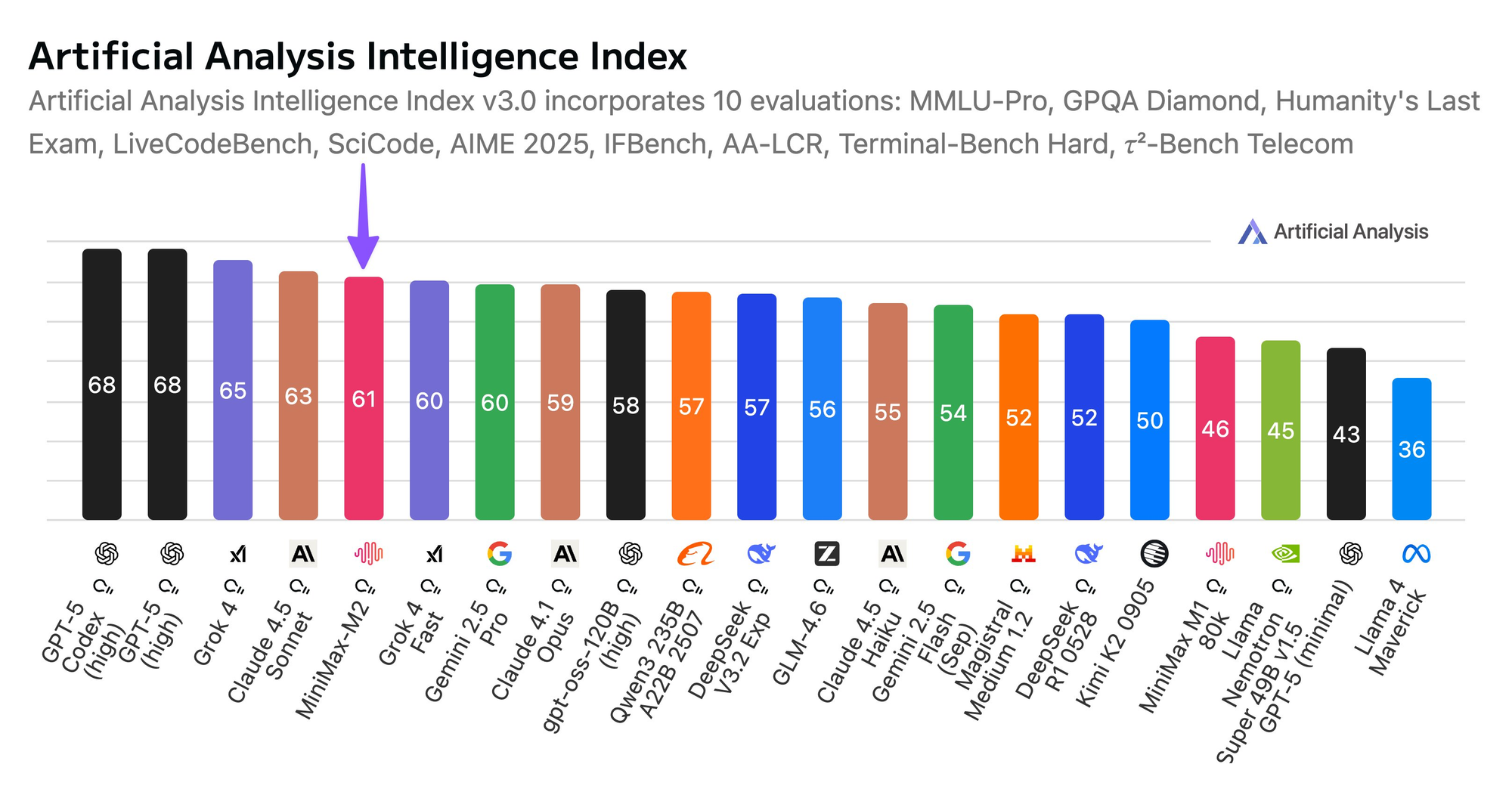

Minimax M2 hingegen ist ein multimodales LLM von einem führenden chinesischen KI-Unternehmen. Es ist außergewöhnlich stark in der Codegenerierung und beim Befolgen spezifischer, strukturierter Prompts. Es kann eine klar definierte Aufgabe übernehmen und sauberen, funktionalen und effizienten Code produzieren.

Der synergetische Workflow

Wie arbeiten sie also zusammen? Stellt euch diesen Ablauf vor:

- High-Level-Planung mit Claude: Ihr beschreibt eure Software-Idee in einfachem Englisch an Claude. "Ich möchte eine Python-Web-App, die die neuesten Tech-Nachrichten abruft, die Artikel zusammenfasst und mir eine tägliche Digest-E-Mail sendet." Claude kann dies dann in einen Entwicklungsplan aufschlüsseln: Backend mit FastAPI, ein Web-Scraper, eine Integration mit einer Zusammenfassungs-API und ein E-Mail-Versanddienst.

- Komponentengenerierung mit Minimax M2: Ihr nehmt eine dieser Komponenten – sagen wir, "erstellt einen FastAPI-Endpunkt, der eine E-Mail-Adresse akzeptiert und eine Erfolgsmeldung zurückgibt" – und gebt diese präzise Anweisung über seine API an Minimax M2. Es wird schnell den exakten Python-Code für diesen Endpunkt generieren.

- Überprüfung und Integration mit Claude: Schließlich bringt ihr den generierten Code zurück zu Claude. Ihr könnt fragen: "Claude, hier ist der FastAPI-Code von Minimax M2. Überprüfe ihn auf Best Practices, suche nach Sicherheitsproblemen und integriere ihn in unsere bestehende Datei

main.py."

Dieses Hin und Her nutzt die einzigartigen Stärken jedes Modells und führt letztendlich zu einem qualitativ hochwertigeren, robusteren Endprodukt, als man es durch die alleinige Verwendung eines einzigen Modells erhalten könnte. Es geht darum, eine leistungsstarke, iterative {{konversationelle}} Schleife zwischen euch und euren KI-Assistenten zu schaffen.

Die Grundlagen verstehen: Was sind Minimax M2 und Claude?

Was ist Minimax M2 und warum sollte es euch interessieren?

Minimax ist ein führendes chinesisches KI-Unternehmen, bekannt für seine großen multimodalen Modelle. Die M2-Serie repräsentiert ihre Fundamentmodelle der zweiten Generation, optimiert für Aufgaben wie natürliches Sprachverständnis, Codegenerierung und sogar multimodales Denken (denkt an: Bild + Text).

Im Gegensatz zu Allzweckmodellen ist Minimax M2 für chinesischsprachige Kontexte feinabgestimmt, unterstützt aber auch Englisch und andere Sprachen mit beeindruckender Flüssigkeit. Es glänzt in:

- Generierung hochwertiger Code-Snippets

- Erklärung komplexer Logik in einfachen Worten

- Übersetzung technischer Dokumentation

- Unterstützung bei der Skripterstellung für Cloud-Infrastrukturen (großartig, wenn ihr euch für Cybersicherheit oder Cloud Computing interessiert zwinker)

Aber hier ist der Haken: Während Minimax M2 leistungsstark ist, ist es nicht speziell als "Code-First"-Modell konzipiert. Hier kommt Claude Code ins Spiel.

Hier kommt Claude Code: Anthropic's entwicklerzentrierte KI

Anthropic’s Claude, insbesondere neuere Versionen wie Claude 3.5 Sonnet, enthält einen spezialisierten Modus, der informell oft als „Claude Code“ bezeichnet wird – kein offizieller Produktname, sondern ein Begriff der Community für Claudes verbesserte Fähigkeiten zum Code-Verständnis und zur Codegenerierung.

Claude Code zeichnet sich aus durch:

- Lesen und Erklären ganzer Codebasen

- Schreiben sicherer, effizienter und gut dokumentierter Funktionen

- Refactoring von Legacy-Code

- Erkennung potenzieller Fehler oder Sicherheitslücken

Es wurde auf einem riesigen Korpus von Open-Source-Code und technischer Dokumentation trainiert, was es zu einem der entwicklerfreundlichsten LLMs macht, die heute verfügbar sind.

Warum also nicht einfach nur Claude verwenden?

Gute Frage. Die Antwort liegt in der Komplementarität.

Minimax M2 könnte euch bessere Ergebnisse für regionsspezifische Logik, mehrsprachige Unterstützung oder domänenspezifische Aufgaben liefern (z. B. das Generieren von Cloud-Sicherheitsrichtlinien, die chinesischen Vorschriften entsprechen). Claude hingegen bietet robuste, allgemeine Codierungsintelligenz mit starkem Denkvermögen und weniger Halluzinationen.

Durch die Kombination beider schafft ihr einen hybriden KI-Assistenten, der das Beste aus Ost und West, Spezialisiertem und Allgemeinem, Sicherem und Skalierbarem nutzt.

Wann ist es sinnvoll, Minimax M2 und Claude Code zu kombinieren?

Nicht jedes Projekt benötigt zwei LLMs. Tatsächlich kann Over-Engineering euch verlangsamen. Seien wir also strategisch.

Verwendet beide, wenn:

✅ Ihr eine globale Anwendung entwickelt, die Benutzer in China und international bedient

✅ Euer Code eine tiefe Lokalisierung erfordert (z. B. das Generieren von AWS + Alibaba Cloud Bereitstellungsskripten)

✅ Ihr eine redundante Validierung benötigt, z. B. Minimax eine Funktion entwerfen lasst und dann Claude bittet, diese auf Sicherheitslücken zu überprüfen

✅ Ihr mit KI-Agentenarchitekturen experimentiert, bei denen verschiedene Modelle unterschiedliche Unteraufgaben übernehmen

Bleibt bei einem, wenn:

❌ Ihr an einer einfachen CRUD-App ohne Lokalisierungsanforderungen arbeitet

❌ Euer Team nur Englisch und öffentliche Cloud-Anbieter (AWS/GCP/Azure) verwendet

❌ Ihr eine enge Latenz- oder Budgetbeschränkung habt (zwei API-Aufrufe = doppelte Kosten & Verzögerung)

Angenommen, ihr wollt beide integrieren – wie macht ihr das eigentlich?

Eintauchen in die APIs: Eine praktische Erkundung mit Apidog

Nun zum spannenden Teil! Machen wir uns mit den APIs vertraut, die wir verwenden werden. Anstatt einfach nur Code zu schreiben, verwenden wir zuerst Apidog, um direkt mit ihnen zu interagieren. Das hilft uns, die Anforderungs- und Antwortstruktur ohne jeglichen Codierungsaufwand zu verstehen.

Testen der Minimax M2 API in Apidog

Zuerst starten wir Apidog und erstellen eine neue Anfrage.

- Anfragemethode und URL festlegen: Wählt

POSTund gebt den Minimax M2 API-Endpunkt ein:https://api.minimax.chat/v1/text/chat/completions_pro. - Header konfigurieren: Im Tab "Headers" fügt Folgendes hinzu:

Content-Type:application/jsonAuthorization:Bearer YOUR_MINIMAX_API_KEY

- Anfragetext erstellen: Wechselt zum Tab "Body" und wählt "raw" und "JSON". Hier ist eine grundlegende Struktur, um eine Codegenerierungsantwort zu erhalten:

json

{

"model": "abab6.5-chat",

"messages": [

{

"role": "user",

"content": "Write a Python function to calculate the factorial of a number using recursion."

}

],

"temperature": 0.7

}

Lasst uns diese {{}} Parameter aufschlüsseln:

model: Wir verwendenabab6.5-chat, das zum Zeitpunkt des Schreibens das neueste und leistungsstärkste Modell von Minimax ist.messages: Ein Array, in dem wir die Konversation definieren. Wir beginnen mit eineruser-Rolle und unserem Prompt.temperature: Dies steuert die Zufälligkeit der Ausgabe. Ein Wert von 0,7 bietet eine gute Balance zwischen Kreativität und Determinismus.

- Senden! Klickt auf die Schaltfläche "Send" in Apidog. Ihr solltet eine sauber formatierte Antwort von der Minimax API auf der rechten Seite sehen, die den generierten Python-Code enthält.

War das nicht einfach? Apidog zeigt euch sofort den Statuscode, die Antwortzeit und den vollständigen JSON-Body an. Ihr könnt eure Anfrage einfach anpassen und erneut senden, ohne mit Terminalbefehlen herumhantieren zu müssen.

Testen der Anthropic Claude API in Apidog

Nun, machen wir dasselbe für Claude. Der Prozess ist nahezu identisch.

- Neue Anfrage: Erstellt eine neue Anfrage in Apidog.

- Methode und URL:

POSTanhttps://api.anthropic.com/v1/messages. - Header:

Content-Type:application/jsonx-api-key:YOUR_ANTHROPIC_API_KEYanthropic-version:2023-06-01

4. Anfragetext:

json

{

"model": "claude-3-sonnet-20240229",

"max_tokens": 1000,

"messages": [

{

"role": "user",

"content": "Explain the concept of recursion in programming as if you were talking to a beginner."

}

]

}

model: Wir verwendenclaude-3-sonnet-20240229, eine großartige Balance aus Intelligenz und Geschwindigkeit für diese Aufgabe.max_tokens: Die maximale Länge der Antwort.messages: Dieselbe konversationelle Struktur.

Klickt erneut auf "Send", und voilà! Ihr erhaltet Claudes klare, gut begründete Erklärung im Antwortbereich. Durch die Verwendung von Apidog habt ihr gerade in weniger als einer Minute mit zwei verschiedenen, leistungsstarken KI-APIs interagiert und bestätigt, dass alles funktioniert, bevor ihr eine einzige Zeile Integrationscode schreibt.

Praxisbeispiel: Generator für sichere Cloud-Bereitstellungsskripte

Stellt euch vor, ihr seid ein Cloud-Sicherheitsingenieur (klingt bekannt?). Ihr müsst Bereitstellungsskripte für Kunden generieren, die AWS, Azure und Alibaba Cloud verwenden.

Mit Minimax + Claude:

- Minimax generiert regionsspezifische Terraform- oder CloudFormation-Vorlagen

- Claude prüft sie auf:

- Zu permissive IAM-Richtlinien

- Fehlende Verschlüsselungseinstellungen

- Öffentlich zugängliche Speicher-Buckets

Ihr verpackt dies dann in ein CLI-Tool oder eine interne Web-App – alles in Apidog getestet und dokumentiert.

Aufsteigen: Fortgeschrittene Techniken und Best Practices

Ihr habt den grundlegenden Ablauf verstanden! Lasst uns nun darüber sprechen, wie dieser Workflow wirklich robust und effektiv gestaltet werden kann.

Die Kunst des Prompt Engineering meistern

Die Qualität eurer Ausgabe hängt direkt von der Qualität eurer Eingabe ab. Hier sind einige Tipps:

- Seid spezifisch und gebt Kontext: Sagt nicht einfach "schreibe eine Funktion". Gebt die Eingabeparameter, die erwartete Ausgabe, zu berücksichtigende Grenzfälle und den von euch bevorzugten Codierungsstil an (z. B. "verwende Typ-Hints").

- Verwendet System-Prompts: Der

system-Parameter in der Claude API ist unglaublich leistungsstark. Ihr könnt eine dauerhafte Persona für Claude festlegen, wie z. B. "Du bist ein erfahrener Backend-Ingenieur bei einem FAANG-Unternehmen", was seine Antworten während der gesamten Konversation beeinflussen wird. - Iterative Verfeinerung: Euer erster Prompt liefert möglicherweise keine perfekten Ergebnisse. Behandelt es als eine Konversation. Wenn im Code von Minimax etwas fehlt, fangt nicht von vorne an. Sendet eine Folgemeldung: "Das ist gut, aber füge jetzt bitte eine Überprüfung hinzu, um sicherzustellen, dass das Passwort kein gängiges Wort ist."

Umgang mit komplexen, mehrteiligen Projekten

Wie verwaltet man ein größeres Projekt? Die Strategie ist ähnlich, erfordert aber mehr Organisation.

- Projekt-Blaupause mit Claude: Beginnt damit, Claude einen Überblick auf hoher Ebene zu geben. "Ich baue eine Flask-Webanwendung mit Benutzerauthentifizierung, einer SQLite-Datenbank und einem React-Frontend." Bittet Claude, eine Projektstruktur und eine

requirements.txt-Datei zu generieren. - Dateien sequenziell mit Minimax generieren: Geht dann Datei für Datei vor. "Schreibe nun, basierend auf der Blaupause, die Datei

app.pyfür das Flask-Backend. Sie sollte die folgenden Routen enthalten:/login,/registerund/dashboard." Ihr könnt ihm den Inhalt anderer verwandter Dateien als Kontext geben. - Kontinuierliche Integration mit Claude: Nachdem ihr einige Dateien generiert habt, fügt ihr sie alle in Claudes Kontextfenster ein und fragt: "Überprüft diese Dateien auf Konsistenz. Stimmen die Imports überein? Ist der Datenfluss zwischen Frontend und Backend logisch?"

Fehlerbehandlung und Debugging mit dem KI-Team

Unweigerlich werdet ihr auf Fehler stoßen. Euer KI-Team kann auch hier helfen.

- Fehler abrufen: Wenn euer Code fehlschlägt, kopiert den vollständigen Traceback.

- Diagnose mit Claude: Fügt den Traceback und den relevanten Code in Claude ein. "Claude, ich erhalte diesen Fehler, wenn ich meine Flask-App ausführe. Was bedeutet er, und wie kann ich ihn beheben?" Claude ist hervorragend darin, Fehler in einfachem Englisch zu erklären.

- Fix mit Minimax generieren: Sobald ihr das Problem verstanden habt, könnt ihr Minimax bitten, den korrigierten Code zu schreiben. "Der Fehler war eine Nullreferenz. Bitte schreibt die Funktion

get_user_profileum, um den Fall zu behandeln, dass ein Benutzer in der Datenbank nicht gefunden wird."

Prompt Engineering Tipps für Minimax + Claude

Um die besten Ergebnisse zu erzielen, passt eure Prompts an die Stärken jedes Modells an.

Für Minimax M2:

- Verwendet klare, direktive Sprache

- Gebt Sprache und Framework explizit an

- Fügt Kontext zu eurer Cloud-Umgebung hinzu (z. B. „Geht davon aus, dass IAM-Rollen bereits konfiguriert sind“)

Beispiel:

„Generiert eine Python Flask-Route, die einen Dateiupload akzeptiert und diesen in Alibaba Cloud OSS speichert. Verwendet das oss2 SDK. Fügt keine geheimen Schlüssel ein.“

Für Claude Code:

- Bittet um strukturiertes Feedback (z. B. „Listet Schwachstellen in Stichpunkten auf“)

- Fordert alternative Implementierungen an

- Gebt Compliance-Standards an (z. B. „Prüft gegen OWASP Top 10“)

Beispiel:

„Überprüft diesen Code auf Konformität mit den NIST SP 800-53 Sicherheitskontrollen. Konzentriert euch auf Authentifizierung, Protokollierung und Datenintegrität.“

Jenseits des Codes: Weitere leistungsstarke Anwendungsfälle

Diese {{Minimax M2 mit Claude Code}} Synergie ist nicht nur für das Schreiben neuer Anwendungen von Grund auf gedacht. Hier sind einige weitere Möglichkeiten, wie ihr diese Kombination nutzen könnt:

- Code-Übersetzung: Verwendet Claude, um die Logik eines komplexen Perl-Skripts zu verstehen, und dann Minimax, um es in modernes Python zu übersetzen.

- Dokumentationsgenerierung: Gebt eine komplexe Funktion aus eurer Codebasis an Minimax und bittet es, Docstrings zu schreiben. Gebt dann ein ganzes Modul an Claude und bittet es, eine umfassende README.md-Datei zu schreiben.

- Testfallgenerierung: Dies ist eine Killer-Funktion. Gebt euren Funktionscode an Minimax und fordert es auf: "Generiert umfassende Unit-Tests für diese Funktion unter Verwendung des Python-Frameworks

pytest. Deckt Grenzfälle und ungültige Eingaben ab." - Leistungsoptimierung: Bittet Claude, einen langsamen Codeabschnitt zu analysieren und Engpässe zu identifizieren. Fordert dann Minimax auf: "Schreibt die folgende Funktion effizienter um. Konzentriert euch auf algorithmische Verbesserungen. Der Engpass ist die verschachtelte Schleife."

Fazit: Die Zukunft des hybriden KI-Codierens

Und da habt ihr es! Wir sind von dem Verständnis des Warum der Kombination von {{Minimax M2}} und {{Claude}} bis hin zum Aufbau eines funktionalen Python-Skripts gereist, das sie zu einem kohärenten, leistungsstarken Codierungspartner orchestriert.

Wir haben gesehen, wie man:

- Unsere Umgebung und API-Schlüssel sicher einrichtet.

- Apidog verwendet, um visuell mit den APIs zu interagieren und sie zu verstehen, bevor man Code schreibt – eine enorme Zeitersparnis.

- Python-Clients für beide KI-Dienste erstellt.

- Einen praktischen,

{{konversationellen}}Workflow schafft, in dem diese Modelle ihre Stärken ausspielen. - Fortgeschrittene Techniken wie Prompt Engineering und Multi-File-Projektmanagement anwendet.

Die wichtigste Erkenntnis ist, dass die Zukunft der Entwicklung nicht darin besteht, dass KI Entwickler ersetzt; es geht darum, dass Entwickler, die KI nutzen, diejenigen ersetzen, die es nicht tun. Indem ihr lernt, diese leistungsstarken Tools effektiv zu orchestrieren, schreibt ihr nicht nur schneller Code – ihr löst komplexere Probleme, lernt Best Practices im Handumdrehen und steigert die gesamte Qualität eurer Arbeit.

Was werdet ihr also mit eurem neuen KI-Dreamteam bauen? Die Möglichkeiten sind wirklich endlos. Viel Spaß beim Codieren!