Haben Sie Schwierigkeiten, Ihre Large Language Model (LLM)-Pipelines zu bewerten und zu optimieren? Hier kommt LangWatch, eine bahnbrechende Plattform, die es einfach macht, Ihre benutzerdefinierten LLM-Workflows zu überwachen, zu bewerten und feinabzustimmen. In diesem Leitfaden tauchen wir ein in die Funktionsweise von LangWatch, warum es großartig ist und wie Sie es installieren und verwenden, um Ihre KI-Projekte zu beschleunigen. Wir werden Schritt für Schritt einen einfachen Chatbot einrichten, LangWatch integrieren und ihn mit einer Beispielfrage testen – alles leicht verständlich erklärt. Legen wir los!

Möchten Sie eine integrierte All-in-One-Plattform, damit Ihr Entwicklerteam mit maximaler Produktivität zusammenarbeiten kann?

Apidog erfüllt all Ihre Anforderungen und ersetzt Postman zu einem wesentlich günstigeren Preis!

Was ist LangWatch und warum sollte es Sie interessieren?

LangWatch ist Ihre Anlaufstelle, um das knifflige Problem der LLM-Bewertung anzugehen. Im Gegensatz zu traditionellen Modellen mit Standardmetriken wie F1-Score für die Klassifizierung, BLEU für die Übersetzung oder ROUGE für die Zusammenfassung sind generative LLMs nicht-deterministisch und schwer zu fassen. Hinzu kommt, dass jedes Unternehmen eigene Daten, feinabgestimmte Modelle und benutzerdefinierte Pipelines hat, was die Bewertung zu einem Kopfzerbrechen macht. Genau hier glänzt LangWatch!

LangWatch lässt Sie:

- Experimentieren und Optimieren: Testen und verbessern Sie Ihre LLM-Pipelines mit Leichtigkeit.

- Leistung überwachen: Verfolgen Sie, wie sich Ihre KI in Echtzeit verhält.

- Ergebnisse bewerten: Verwenden Sie Datensätze und Evaluatoren, um Genauigkeit und Qualität zu messen.

- Benutzerdefinierte Pipelines unterstützen: Funktioniert mit Ihren einzigartigen Daten und Modellen.

Egal, ob Sie einen Chatbot, ein Übersetzungstool oder eine benutzerdefinierte KI-Anwendung entwickeln, LangWatch hilft Ihnen sicherzustellen, dass Ihr LLM erstklassige Ergebnisse liefert. Bereit, es in Aktion zu sehen? Lassen Sie uns LangWatch installieren und verwenden!

Schritt-für-Schritt-Anleitung zur Installation und Verwendung von LangWatch

Voraussetzungen

Bevor wir beginnen, benötigen Sie:

- Python 3.8+: Zum Ausführen des Projekts (python.org).

- LangWatch-Konto: Melden Sie sich unter app.langwatch.ai an.

- OpenAI API-Schlüssel: Für die Chatbot-Demo (erhalten Sie einen unter platform.openai.com).

- Code-Editor: VS Code, PyCharm oder Ihre bevorzugte IDE.

- Git und Docker: Optional, für die lokale LangWatch-Einrichtung.

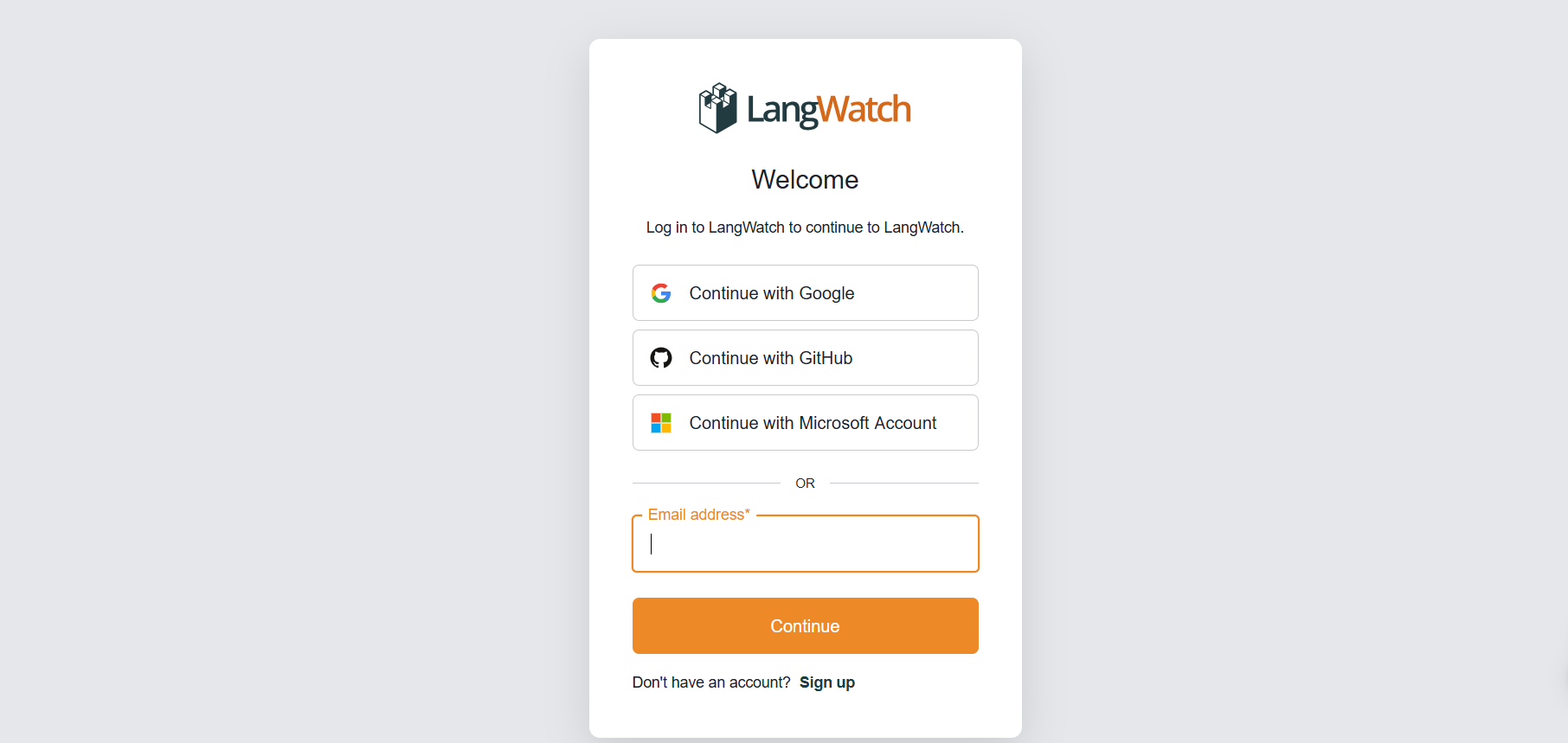

Schritt 1: Bei LangWatch anmelden

Konto erstellen:

- Gehen Sie zu app.langwatch.ai und melden Sie sich für ein kostenloses Konto an.

- Ein Standardprojekt namens „AI Bites“ wird für Sie erstellt. Wir werden es für dieses Tutorial verwenden, aber Sie können bei Bedarf auch ein neues erstellen.

API-Schlüssel erhalten:

- Gehen Sie in Ihrem LangWatch-Dashboard zu Projekteinstellungen, um Ihren

LANGWATCH_API_KEYzu finden. Diesen benötigen Sie später.

Schritt 2: Ein Python-Projekt mit LangWatch einrichten

Lassen Sie uns ein Python-Projekt erstellen und LangWatch integrieren, um einen einfachen Chatbot zu verfolgen.

- Projektordner erstellen:

- Erstellen Sie ein neues Verzeichnis (z.B.

langwatch-demo) und wechseln Sie dorthin:

mkdir langwatch-demo

cd langwatch-demo

2. Virtuelle Umgebung einrichten:

- Erstellen und aktivieren Sie eine virtuelle Umgebung, um Abhängigkeiten zu isolieren:

python -m venv venv

source venv/bin/activate # Unter Windows: venv\Scripts\activate

3. LangWatch und Abhängigkeiten installieren:

- Installieren Sie LangWatch und Chainlit (für die Chatbot-Benutzeroberfläche):

pip install langwatch chainlit openai

4. Chatbot-Code erstellen:

- Erstellen Sie eine Datei namens

app.pyund fügen Sie diesen Code ein, um einen einfachen Chatbot mit dem GPT-4o-mini-Modell von OpenAI zu erstellen:

import os

import chainlit as cl

import asyncio

from openai import AsyncClient

openai_client = AsyncClient() # Assumes OPENAI_API_KEY is set in environment

model_name = "gpt-4o-mini"

settings = {

"temperature": 0.3,

"max_tokens": 500,

"top_p": 1,

"frequency_penalty": 0,

"presence_penalty": 0,

}

@cl.on_chat_start

async def start():

cl.user_session.set(

"message_history",

[

{

"role": "system",

"content": "You are a helpful assistant that only reply in short tweet-like responses, using lots of emojis."

}

]

)

async def answer_as(name: str):

message_history = cl.user_session.get("message_history")

msg = cl.Message(author=name, content="")

stream = await openai_client.chat.completions.create(

model=model_name,

messages=message_history + [{"role": "user", "content": f"speak as {name}"}],

stream=True,

**settings,

)

async for part in stream:

if token := part.choices[0].delta.content or "":

await msg.stream_token(token)

message_history.append({"role": "assistant", "content": msg.content})

await msg.send()

@cl.on_message

async def main(message: cl.Message):

message_history = cl.user_session.get("message_history")

message_history.append({"role": "user", "content": message.content})

await asyncio.gather(answer_as("AI Bites"))

5. Ihren OpenAI API-Schlüssel festlegen:

- Fügen Sie Ihren OpenAI API-Schlüssel als Umgebungsvariable hinzu:

export OPENAI_API_KEY="your-openai-api-key" # Unter Windows: set OPENAI_API_KEY=your-openai-api-key

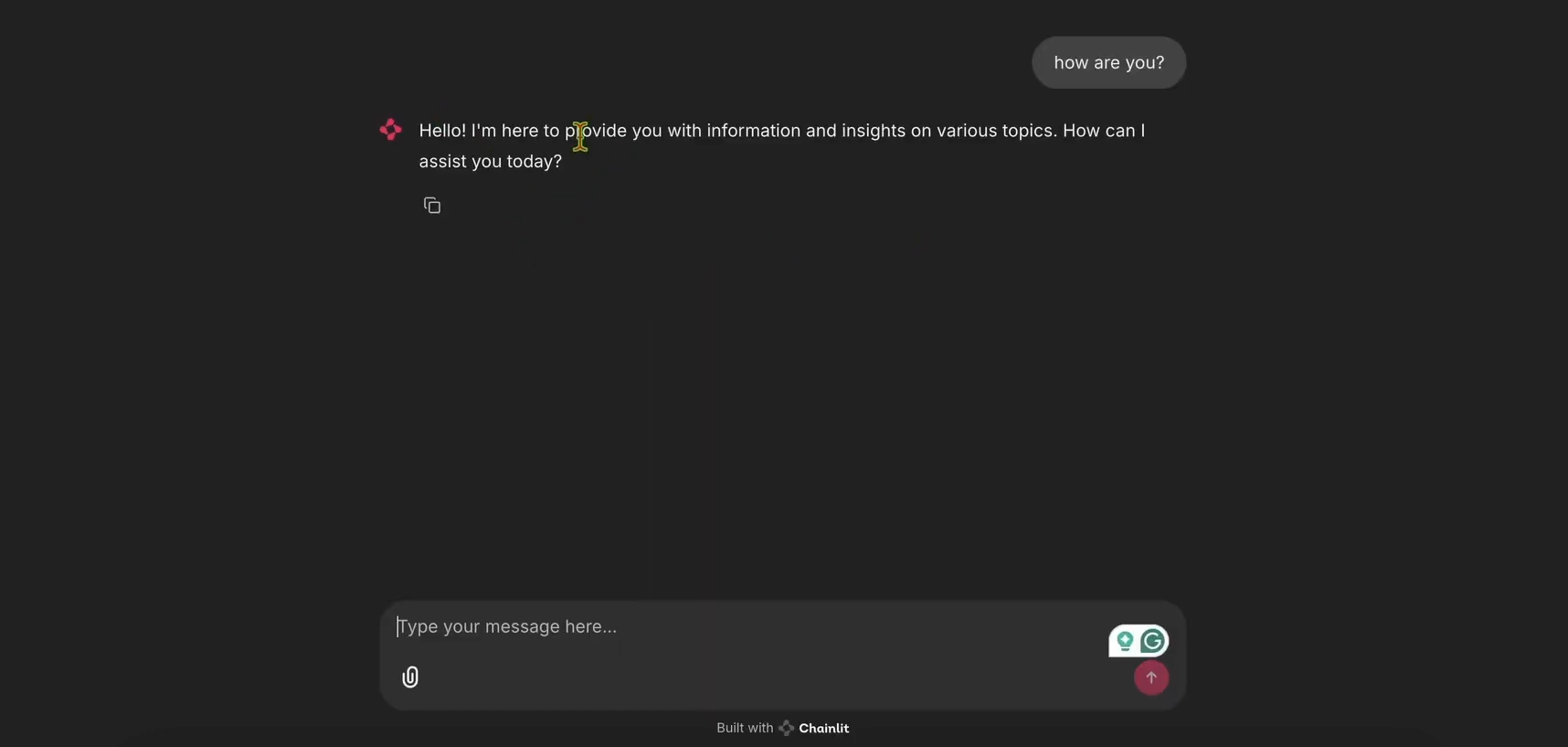

6. Chatbot ausführen:

- Starten Sie die Chainlit-Anwendung:

chainlit run app.py

- Öffnen Sie http://localhost:8000, um die Chatbot-Benutzeroberfläche zu sehen. Probieren Sie es aus, um sicherzustellen, dass es funktioniert!

Schritt 3: LangWatch zur Nachverfolgung integrieren

Nun fügen wir LangWatch hinzu, um die Nachrichten des Chatbots zu verfolgen.

app.pyfür LangWatch ändern:

- Aktualisieren Sie

app.py, um LangWatch einzubinden und den@langwatch.trace()-Decorator zurmain-Funktion hinzuzufügen:

import os

import chainlit as cl

import asyncio

import langwatch

from openai import AsyncClient

openai_client = AsyncClient()

model_name = "gpt-4o-mini"

settings = {

"temperature": 0.3,

"max_tokens": 500,

"top_p": 1,

"frequency_penalty": 0,

"presence_penalty": 0,

}

@cl.on_chat_start

async def start():

cl.user_session.set(

"message_history",

[

{

"role": "system",

"content": "You are a helpful assistant that only reply in short tweet-like responses, using lots of emojis."

}

]

)

async def answer_as(name: str):

message_history = cl.user_session.get("message_history")

msg = cl.Message(author=name, content="")

stream = await openai_client.chat.completions.create(

model=model_name,

messages=message_history + [{"role": "user", "content": f"speak as {name}"}],

stream=True,

**settings,

)

async for part in stream:

if token := part.choices[0].delta.content or "":

await msg.stream_token(token)

message_history.append({"role": "assistant", "content": msg.content})

await msg.send()

@cl.on_message

@langwatch.trace()

async def main(message: cl.Message):

message_history = cl.user_session.get("message_history")

message_history.append({"role": "user", "content": message.content})

await asyncio.gather(answer_as("AI Bites"))

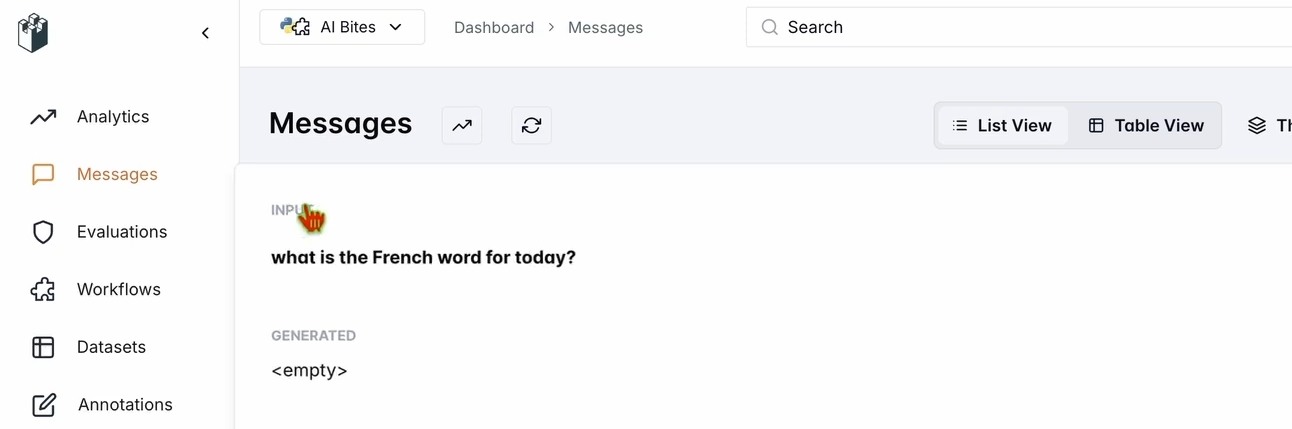

2. Integration testen:

- Starten Sie die Chainlit-Anwendung neu:

chainlit run app.py

- Fragen Sie in der Chatbot-Benutzeroberfläche: „Was ist das französische Wort für heute?“

- Überprüfen Sie Ihr LangWatch-Dashboard:

- Gehen Sie zu app.langwatch.ai.

- Wählen Sie Nachrichten aus der linken Seitenleiste.

- Vergewissern Sie sich, dass Ihre Frage und die Antwort des Chatbots (z.B. „Aujourd’hui! 🇫🇷😊“) verfolgt werden.

Schritt 4: Einen Workflow zur Bewertung Ihres Chatbots einrichten

Lassen Sie uns in LangWatch einen Datensatz und einen Evaluator erstellen, um die Leistung des Chatbots zu bewerten.

- Datensatz erstellen:

- Gehen Sie im LangWatch-Dashboard zu Datensätze und klicken Sie auf Neuer Datensatz.

- Fügen Sie einen einfachen Datensatz mit mindestens einer Frage und Antwort hinzu. Zum Beispiel:

| Frage | Erwartete Antwort |

|---|---|

| Was ist das französische Wort für heute? | Aujourd’hui |

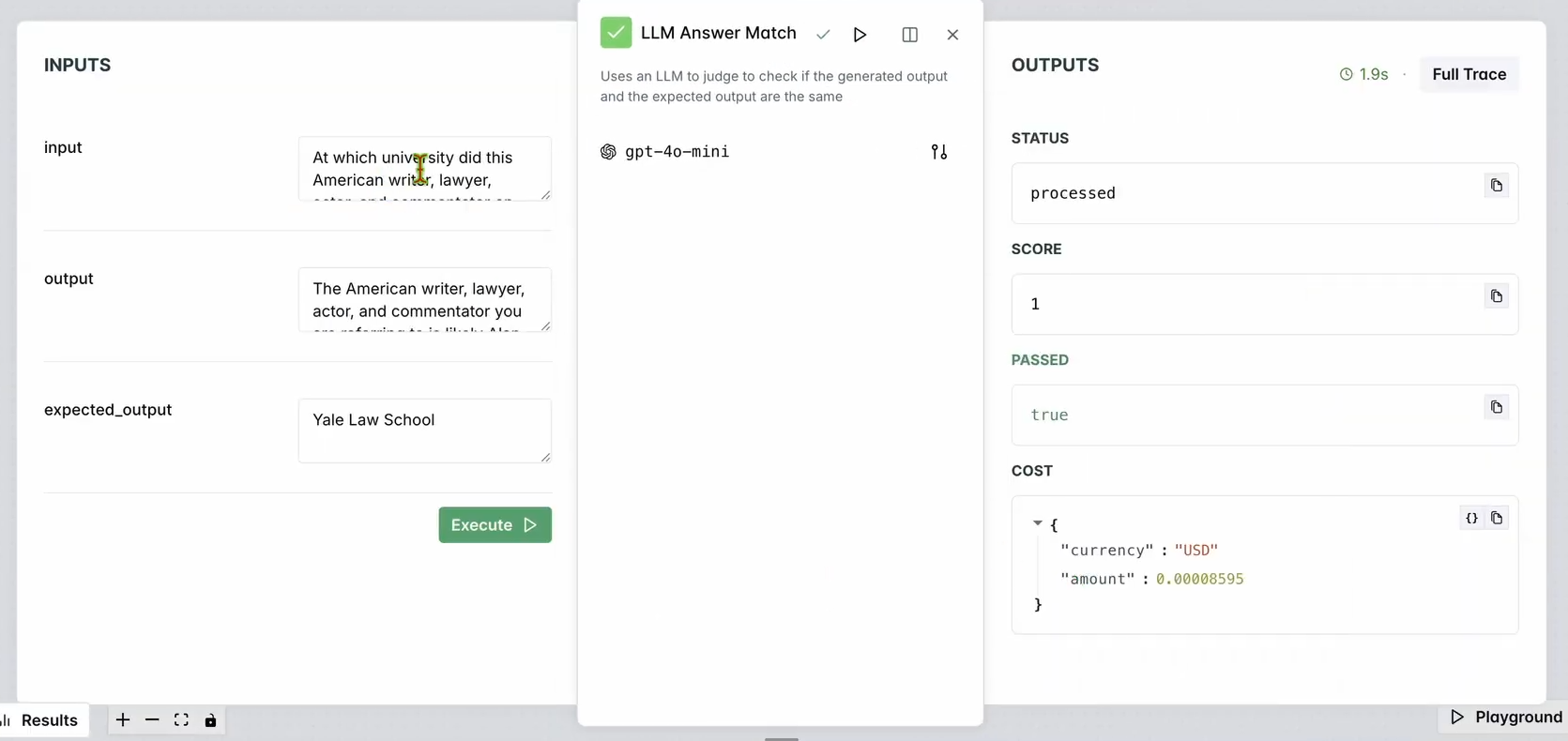

2. Evaluator einrichten:

- Gehen Sie im LangWatch-Dashboard zu Evaluatoren.

- Ziehen Sie den LLM Answer Match-Evaluator in den Arbeitsbereich.

- Konfigurieren Sie ihn:

- Setzen Sie die Eingabefrage auf Ihre Datenbank-Eingabefragen (z.B. „Was ist das französische Wort für heute?“).

- Setzen Sie die Erwartete Ausgabe ebenfalls auf die Antworten Ihrer Datenbank (z.B. „Aujourd’hui“).

- Optional können Sie das LLM-Modell des Evaluators (z.B. Llama, Gemini oder Claude Sonnet) für mehr Vielfalt ändern.

3. Evaluator ausführen:

- Klicken Sie auf Workflow bis hier ausführen, um den Evaluator zu testen.

- Überprüfen Sie die Ergebnisse, um sicherzustellen, dass die Antwort des Chatbots mit der erwarteten Ausgabe übereinstimmt.

Sie sollten so etwas sehen:

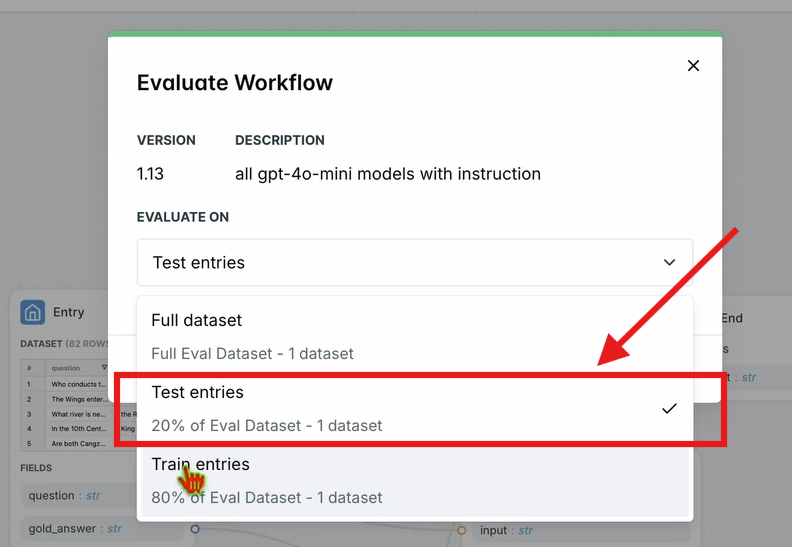

4. Workflow bewerten:

- Klicken Sie in der oberen Navigationsleiste auf Workflow bewerten und wählen Sie Test-Einträge.

- Dies bewertet den gesamten Workflow anhand Ihres Datensatzes. Die Ergebnisse werden nach einer kurzen Verarbeitungszeit angezeigt.

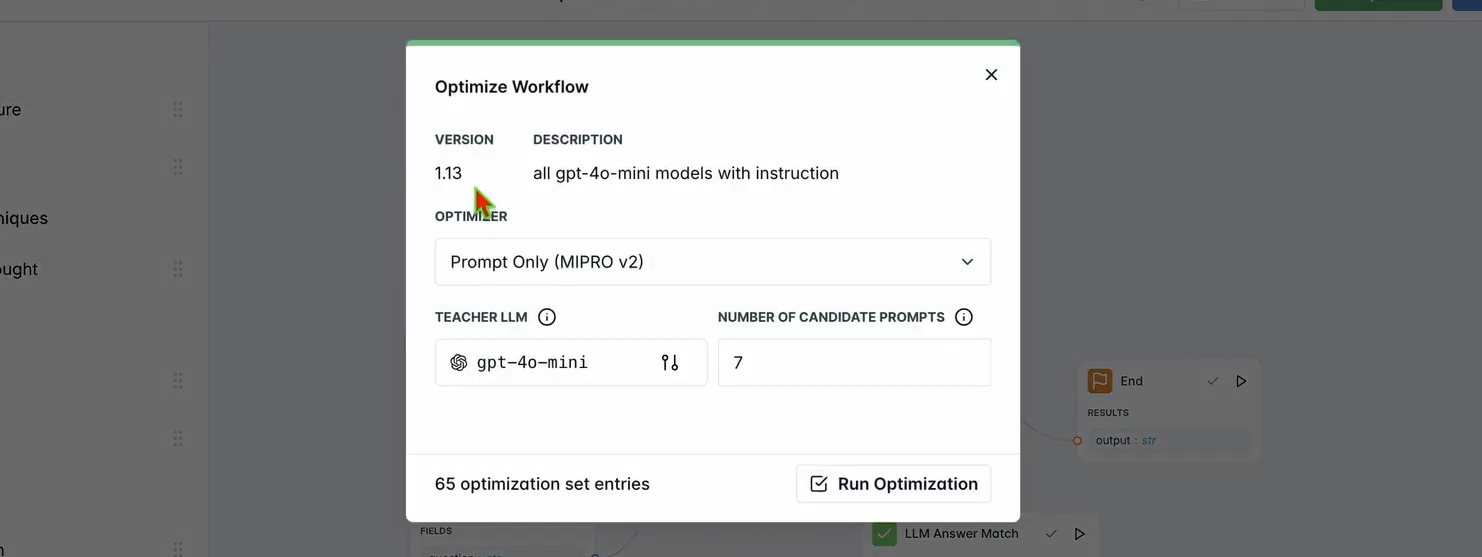

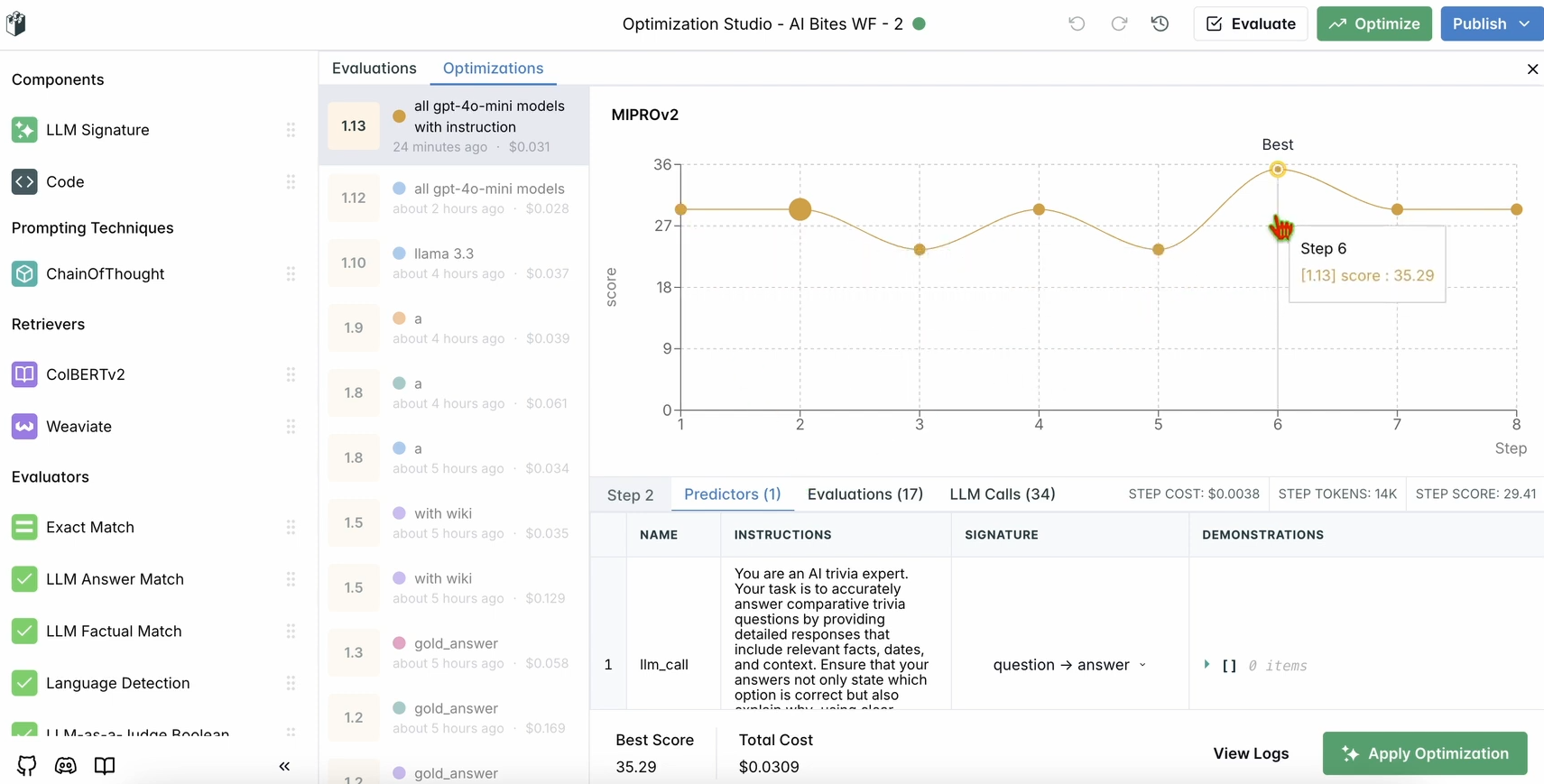

Schritt 5: Ihren Workflow optimieren

Sobald Ihre Bewertung abgeschlossen ist, optimieren wir die Leistung des Chatbots.

1. Optimierung ausführen:

- Klicken Sie im LangWatch-Dashboard in der oberen Navigationsleiste auf Optimieren.

- Wählen Sie Nur Prompt, um den Prompt des Chatbots feinabzustimmen.

- Warten Sie einige Minuten, bis die Optimierung abgeschlossen ist.

2. Verbesserungen prüfen:

- Überprüfen Sie die optimierten Ergebnisse im Dashboard. Sie sollten eine verbesserte Antwortgenauigkeit oder -qualität basierend auf den Vorschlägen von LangWatch sehen.

Schritt 6: Optionale lokale LangWatch-Einrichtung

Möchten Sie LangWatch lokal für Tests mit sensiblen Daten ausführen? Befolgen Sie diese Schritte:

- Repository klonen:

git clone https://github.com/langwatch/langwatch.git

cd langwatch

2. Umgebung einrichten:

- Kopieren Sie die Beispiel-Umgebungsdatei:

cp langwatch/.env.example langwatch/.env

3. Mit Docker ausführen:

- Starten Sie den LangWatch-Server:

docker compose up -d --wait --build

4. Auf das Dashboard zugreifen:

- Öffnen Sie http://localhost:5560, um den Onboarding-Flow von LangWatch zu starten.

- Befolgen Sie die Anweisungen, um Ihre lokale Instanz einzurichten.

Hinweis: Die Docker-Einrichtung dient nur zu Testzwecken und ist nicht für die Produktion skalierbar. Für die Produktion verwenden Sie LangWatch Cloud oder Enterprise On-Premises.

Warum LangWatch verwenden?

LangWatch löst das Rätsel der LLM-Bewertung, indem es eine einheitliche Plattform zur Überwachung, Bewertung und Optimierung Ihrer KI-Pipelines bietet. Egal, ob Sie Prompts optimieren, die Leistung analysieren oder sicherstellen, dass Ihr Chatbot genaue Antworten liefert (wie „Aujourd’hui“ für „heute“ auf Französisch), LangWatch macht es zum Kinderspiel. Die Integration mit Python und Tools wie Chainlit und OpenAI bedeutet, dass Sie Ihre LLM-Anwendungen in wenigen Minuten verfolgen und verbessern können.

Zum Beispiel antwortet unser Demo-Chatbot jetzt in Tweet-ähnlichen Ausbrüchen mit Emojis, und LangWatch hilft dabei, sicherzustellen, dass er genau und optimiert ist. Möchten Sie skalieren? Fügen Sie Ihrem Datensatz weitere Fragen hinzu oder experimentieren Sie mit verschiedenen LLM-Modellen im Evaluator.

Fazit

Da haben Sie es! Sie haben gelernt, was LangWatch ist, wie man es installiert und wie man es verwendet, um einen Chatbot zu überwachen und zu optimieren. Von der Einrichtung eines Python-Projekts über die Verfolgung von Nachrichten bis hin zur Leistungsbewertung mit einem Datensatz – LangWatch ermöglicht es Ihnen, die Kontrolle über Ihre LLM-Pipelines zu übernehmen. Unsere Testfrage – „Was ist das französische Wort für heute?“ – zeigte, wie einfach es ist, KI-Antworten zu verfolgen und zu verbessern.

Bereit, Ihr KI-Spiel auf die nächste Stufe zu heben? Gehen Sie zu app.langwatch.ai, melden Sie sich an und beginnen Sie noch heute mit LangWatch zu experimentieren.

Möchten Sie eine integrierte All-in-One-Plattform, damit Ihr Entwicklerteam mit maximaler Produktivität zusammenarbeiten kann?

Apidog erfüllt all Ihre Anforderungen und ersetzt Postman zu einem wesentlich günstigeren Preis!