```html

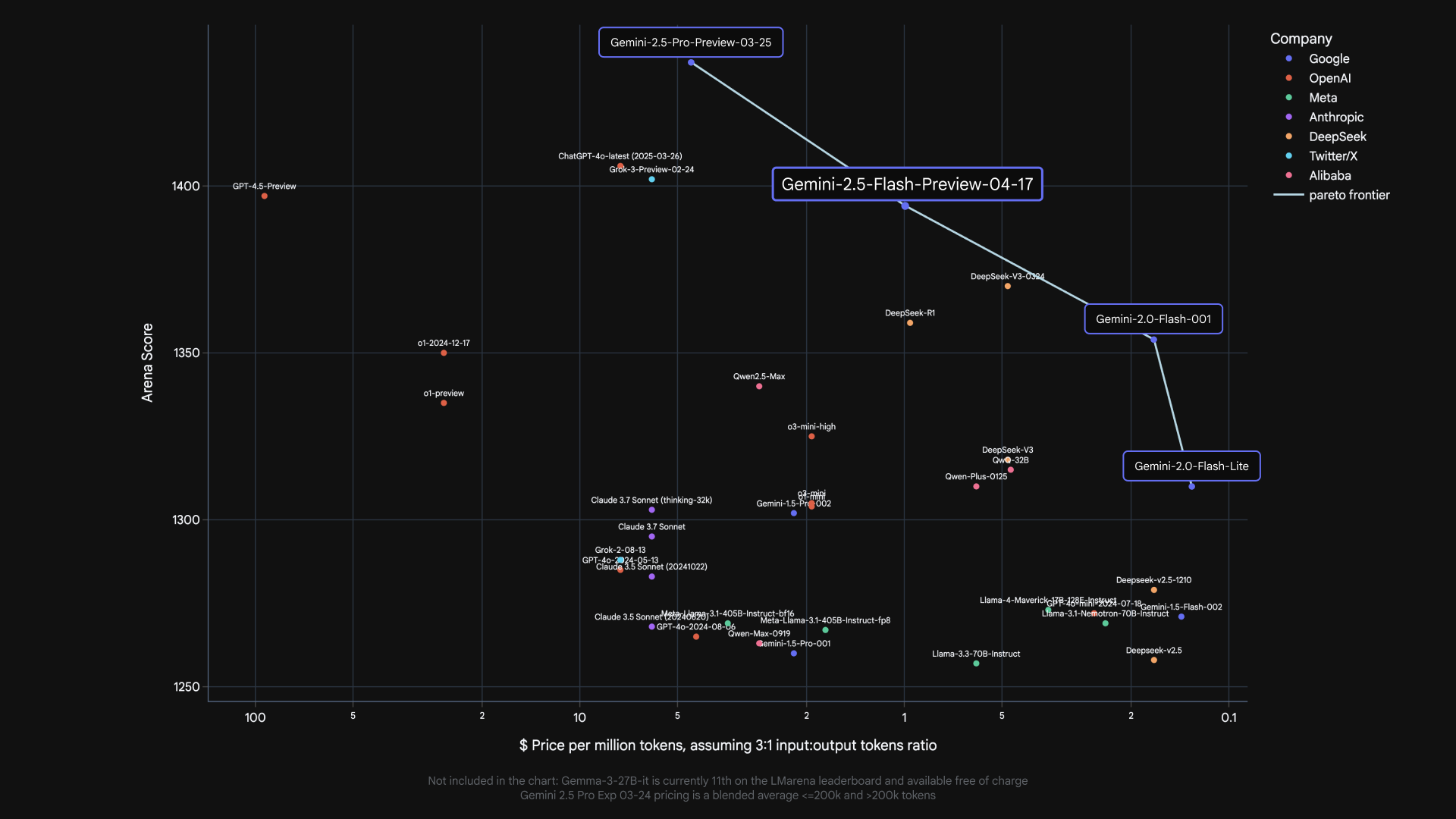

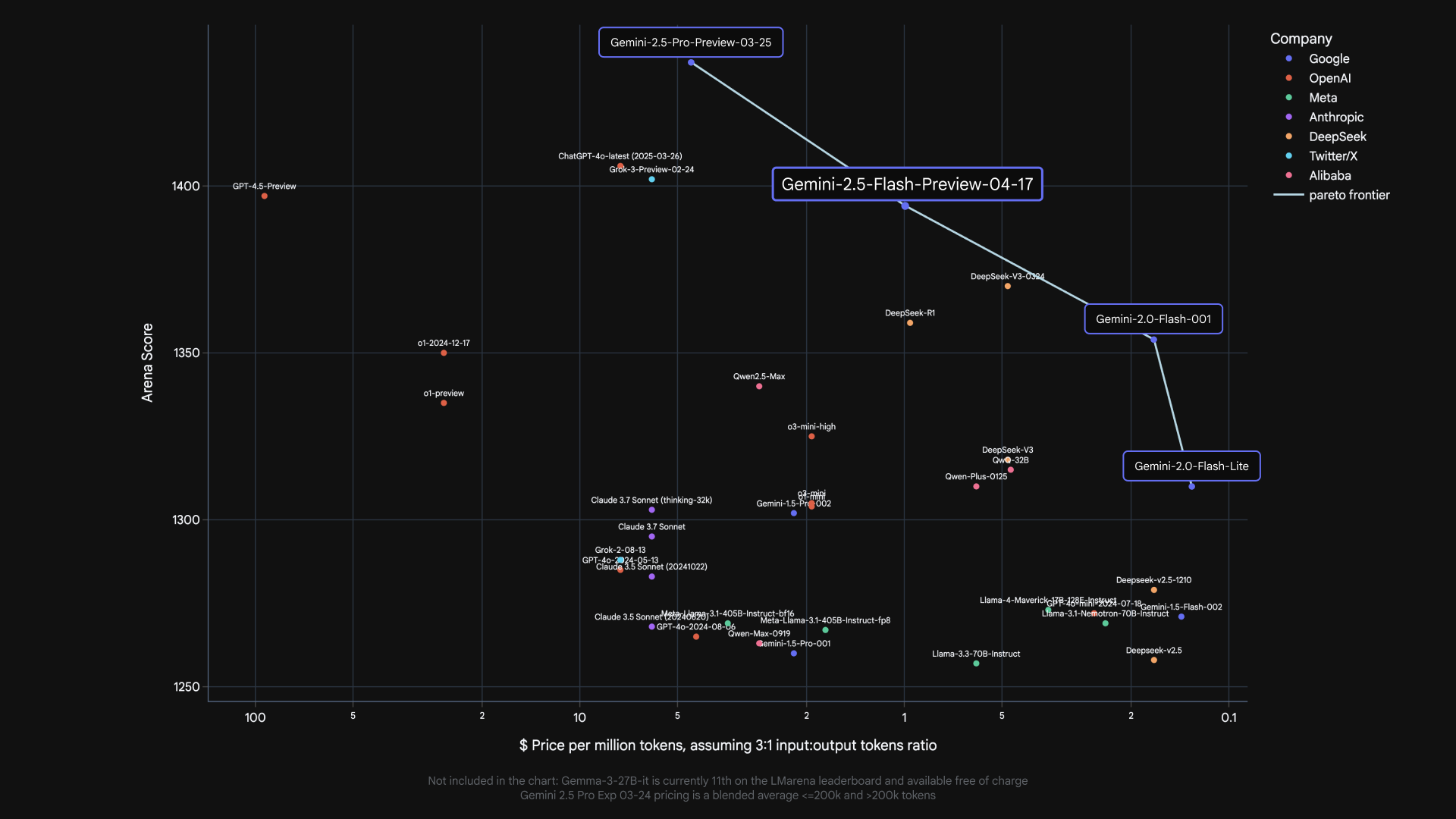

Die Fortschritte von Google im Bereich der künstlichen Intelligenz beschleunigen sich weiter, und die Einführung von Gemini 2.5 Flash markiert einen weiteren bedeutenden Schritt. Dieses Modell, das als Vorschau verfügbar ist, baut auf der Geschwindigkeit und Effizienz seines Vorgängers (2.0 Flash) auf und integriert gleichzeitig leistungsstarke neue Denkfähigkeiten. Was 2.5 Flash für Entwickler besonders attraktiv macht, ist sein einzigartiges hybrides Denk-System und die Einführung eines steuerbaren "Thinking Budget", das die Feinabstimmung des Gleichgewichts zwischen Antwortqualität, Latenz und Kosten ermöglicht.

Dieser Artikel bietet eine praktische Anleitung, wie Sie das Google Gemini 2.5 Flash-Modell über seine API verwenden können. Wir werden die Beschaffung des erforderlichen API-Schlüssels, die Einrichtung Ihrer Umgebung, das Tätigen von API-Aufrufen mit spezifischen Konfigurationen für 2.5 Flash und das Verständnis, wie Studenten kostenlos auf erweiterte Gemini-Funktionen zugreifen können, behandeln.

Want an integrated, All-in-One platform for your Developer Team to work together with maximum productivity?

Apidog delivers all your demans, and replaces Postman at a much more affordable price!

Google Gemini 2.5 Flash: the Most Cost-Efficient Thinking Model Yet

Bevor wir uns mit den API-Aufrufen befassen, wollen wir kurz zusammenfassen, was 2.5 Flash auszeichnet:

Hybrid Reasoning: Im Gegensatz zu Modellen, die sofort Ergebnisse generieren, kann 2.5 Flash einen internen "Denk"-Prozess durchführen, bevor es antwortet. Dies ermöglicht es ihm, Prompts besser zu verstehen, komplexe Aufgaben aufzuschlüsseln und genauere, umfassendere Antworten zu planen, insbesondere bei mehrstufigen Problemen.

Controllable Thinking Budget: Entwickler können über die API ein thinking_budget (in Tokens, von 0 bis 24.576) festlegen. Dieses Budget begrenzt die Menge an internem Denken, die das Modell durchführt.

- Ein Budget von

0priorisiert Geschwindigkeit und Kosten und verhält sich wie eine schnellere Version von 2.0 Flash. - Höhere Budgets ermöglichen mehr Denken, was möglicherweise die Qualität bei komplexen Aufgaben verbessert, aber die Latenz und die Kosten erhöht.

- Das Modell verwendet intelligent nur das Budget, das für die Komplexität des jeweiligen Prompts benötigt wird.

Cost-Efficiency: Es wurde entwickelt, um eine Leistung zu bieten, die mit anderen führenden Modellen vergleichbar ist, aber zu einem Bruchteil der Kosten, wodurch fortschrittliche KI zugänglicher wird.

Lassen Sie uns nun die API in der Praxis einsetzen.

How to Use Google Gemini 2.5 Flash Via API

Step 1: Obtaining Your Gemini API Key

Um mit einem Gemini-Modell über die API zu interagieren, benötigen Sie zunächst einen API-Schlüssel. Dieser Schlüssel authentifiziert Ihre Anfragen. So erhalten Sie einen:

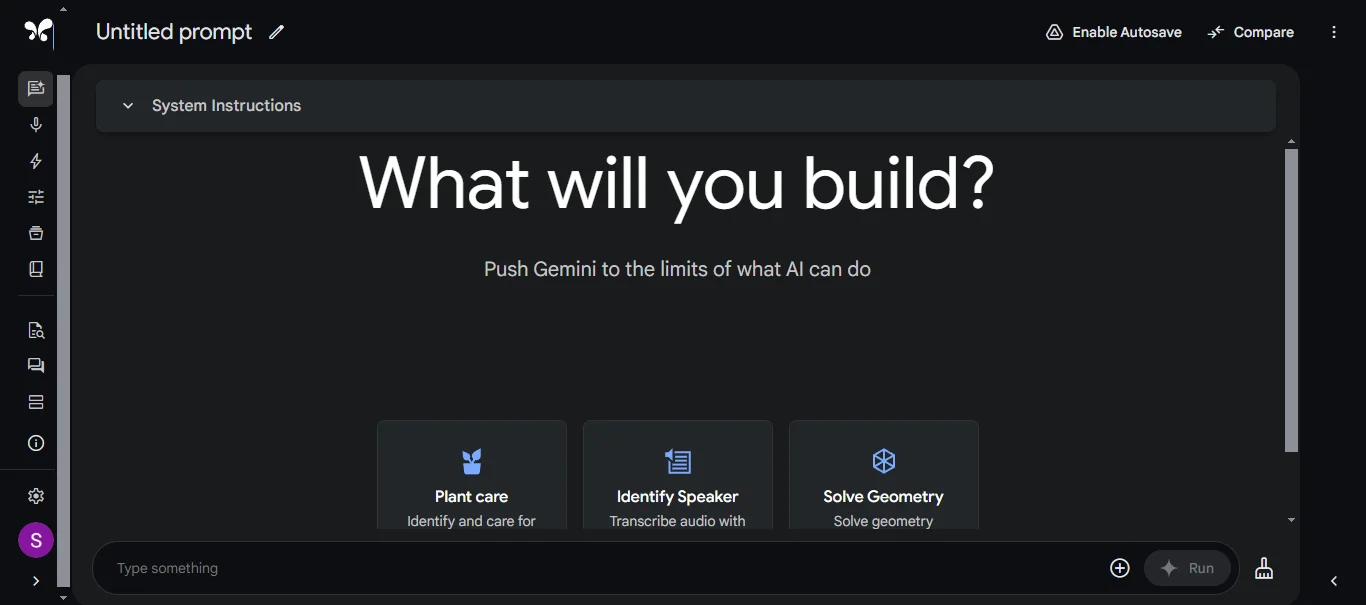

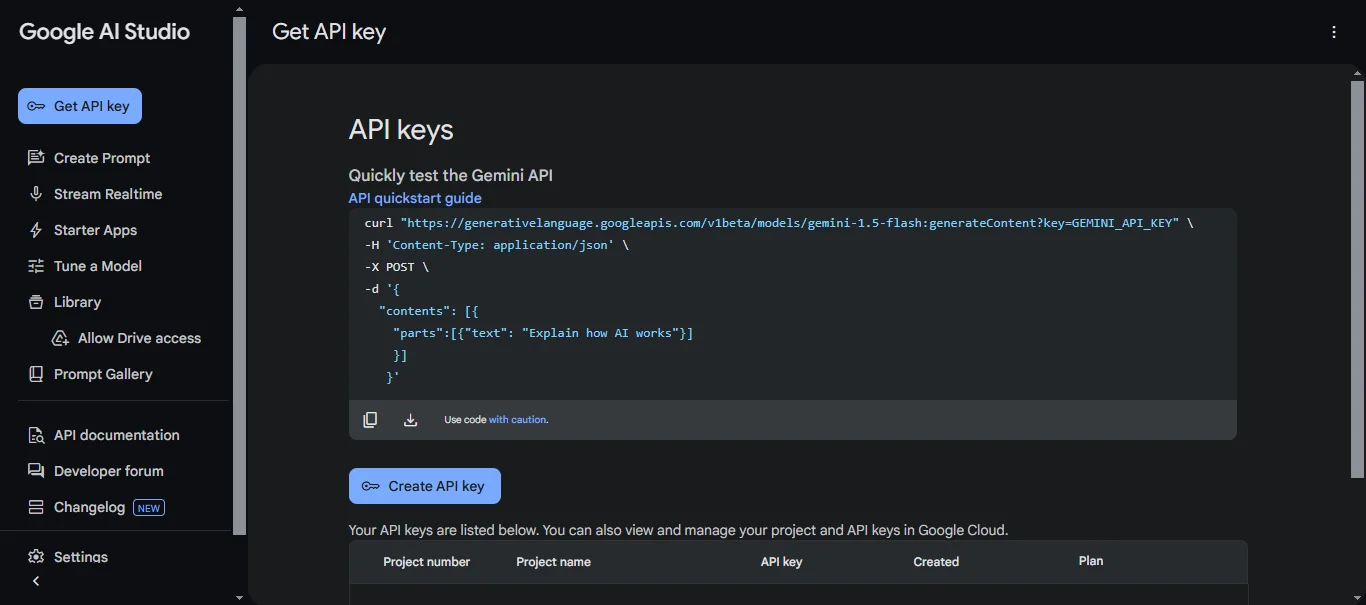

Navigieren Sie zu Google AI Studio: Der primäre Ort, um loszulegen und API-Schlüssel für die individuelle Nutzung zu erhalten, ist Google AI Studio (https://aistudio.google.com/).

Sign In: Sie müssen sich mit Ihrem Google-Konto anmelden.

Generate API Key: Suchen Sie nach dem Anmelden nach einer Option wie "Get API key" oder navigieren Sie zum Abschnitt zur API-Schlüsselverwaltung (die genaue Position in der Benutzeroberfläche kann sich ändern). In der Regel finden Sie Optionen zum Erstellen eines neuen API-Schlüssels.

Create Key: Befolgen Sie die Anweisungen, um einen neuen Schlüssel zu erstellen. Google AI Studio generiert eine eindeutige Zeichenfolge – dies ist Ihr API-Schlüssel.

Secure Your Key: Behandeln Sie Ihren API-Schlüssel wie ein Passwort. Geben Sie ihn nicht öffentlich weiter, betten Sie ihn nicht direkt in Ihren Code ein (insbesondere, wenn der Code in die Versionskontrolle eingecheckt wird), und legen Sie ihn nicht in clientseitigen Anwendungen offen. Speichern Sie ihn sicher, z. B. mithilfe von Umgebungsvariablen oder einem dedizierten Geheimnisverwaltungssystem.

Hinweis: Für die Verwendung auf Unternehmensebene wird häufig die Bereitstellung von Modellen über die Vertex AI-Plattform von Google Cloud bevorzugt, die verschiedene Authentifizierungsmechanismen (wie Dienstkonten) beinhaltet, aber für die erste Entwicklung und kleinere Projekte ist ein API-Schlüssel von Google AI Studio der schnellste Weg, um zu beginnen.

Step 2: Setting Up Your Development Environment

Mit Ihrem API-Schlüssel in der Hand müssen Sie Ihre Programmierumgebung einrichten. Wir verwenden Python als Beispiel, da Google eine gut unterstützte Client-Bibliothek bereitstellt.

Install the Client Library: Öffnen Sie Ihr Terminal oder Ihre Eingabeaufforderung und installieren Sie das erforderliche Paket mit pip:

pip install google-generativeai

Configure Authentication (Securely): Die Best Practice ist, Ihren API-Schlüssel Ihrer Anwendung über eine Umgebungsvariable zur Verfügung zu stellen. Wie Sie eine Umgebungsvariable festlegen, hängt von Ihrem Betriebssystem ab:

- Linux/macOS:

export GEMINI_API_KEY="YOUR_API_KEY"

(Ersetzen Sie "YOUR_API_KEY" durch den tatsächlichen Schlüssel, den Sie generiert haben). Sie können diese Zeile möglicherweise zu Ihrem Shell-Profil (.bashrc, .zshrc usw.) hinzufügen, um die Persistenz über Sitzungen hinweg zu gewährleisten.

- Windows (Command Prompt):

set GEMINI_API_KEY=YOUR_API_KEY

- Windows (PowerShell):

$env:GEMINI_API_KEY="YOUR_API_KEY"

Dann können Sie in Ihrem Python-Code die Bibliothek so konfigurieren, dass sie den Schlüssel automatisch abruft:

import google.generativeai as genai

import os

# Load the API key from the environment variable

api_key = os.getenv("GEMINI_API_KEY")

if not api_key:

raise ValueError("GEMINI_API_KEY environment variable not set.")

genai.configure(api_key=api_key)

Step 3: Making an API Call to Gemini 2.5 Flash

Jetzt können Sie Ihren ersten API-Aufruf speziell auf das Gemini 2.5 Flash-Modell ausrichten.

Import Libraries and Initialize Model: Beginnen Sie mit dem Importieren der erforderlichen Bibliothek (falls noch nicht geschehen) und der Instanziierung der GenerativeModel-Klasse, wobei Sie den korrekten Modellnamen für die 2.5 Flash-Vorschau angeben.

import google.generativeai as genai

import os

# Configure API Key (as shown in Step 2)

api_key = os.getenv("GEMINI_API_KEY")

if not api_key:

raise ValueError("GEMINI_API_KEY environment variable not set.")

genai.configure(api_key=api_key)

# Specify the Gemini 2.5 Flash preview model

# Note: This model name might change after the preview phase.

model_name = "gemini-2.5-flash-preview-04-17"

model = genai.GenerativeModel(model_name=model_name)

Define Your Prompt: Erstellen Sie die Texteingabe, die das Modell verarbeiten soll.

prompt = "Erklären Sie das Konzept des hybriden Denkens in Gemini 2.5 Flash in einfachen Worten."

Configure the Thinking Budget (Crucial for 2.5 Flash): Hier nutzen Sie die einzigartigen Fähigkeiten von 2.5 Flash. Erstellen Sie ein GenerationConfig-Objekt und darin ein ThinkingConfig, um das thinking_budget festzulegen.

# --- Option 1: Prioritize Speed/Cost (Disable Thinking) ---

config_no_thinking = genai.types.GenerationConfig(

thinking_config=genai.types.ThinkingConfig(

thinking_budget=0

)

# You can also add other generation parameters here like temperature, top_p, etc.

# Example: temperature=0.7

)

# --- Option 2: Allow Moderate Reasoning ---

config_moderate_thinking = genai.types.GenerationConfig(

thinking_config=genai.types.ThinkingConfig(

thinking_budget=1024 # Allow up to 1024 tokens for internal thinking

)

)

# --- Option 3: Allow Extensive Reasoning ---

config_high_thinking = genai.types.GenerationConfig(

thinking_config=genai.types.ThinkingConfig(

thinking_budget=8192 # Allow a larger budget for complex tasks

)

)

# --- Option 4: Use Default (Model Decides) ---

# Simply omit the thinking_config or the entire generation_config

# if you want the model's default behavior.

config_default = genai.types.GenerationConfig() # Or just don't pass config later

Generate Content: Rufen Sie die Methode generate_content für Ihre Modellinstanz auf und übergeben Sie den Prompt und Ihre gewählte Konfiguration.

print(f"--- Generating with NO thinking (budget=0) ---")

try:

response_no_thinking = model.generate_content(

prompt,

generation_config=config_no_thinking

)

print(response_no_thinking.text)

except Exception as e:

print(f"An error occurred: {e}")

print(f"\n--- Generating with MODERATE thinking (budget=1024) ---")

try:

response_moderate_thinking = model.generate_content(

prompt,

generation_config=config_moderate_thinking

)

print(response_moderate_thinking.text)

except Exception as e:

print(f"An error occurred: {e}")

# Example for a more complex prompt potentially benefiting from higher budget:

complex_prompt = """

Write a Python function `evaluate_cells(cells: Dict[str, str]) -> Dict[str, float]`

that computes the values of spreadsheet cells.

Each cell contains:

- A number (e.g., "3")

- Or a formula like "=A1 + B1 * 2" using +, -, *, / and other cells.

Requirements:

- Resolve dependencies between cells.

- Handle operator precedence (*/ before +-).

- Detect cycles and raise ValueError("Cycle detected at <cell>").

- No eval(). Use only built-in libraries.

"""

print(f"\n--- Generating COMPLEX prompt with HIGH thinking (budget=8192) ---")

try:

response_complex = model.generate_content(

complex_prompt,

generation_config=config_high_thinking

)

# For code, you might want to inspect parts or check for specific attributes

print(response_complex.text)

except Exception as e:

print(f"An error occurred: {e}")

Process the Response: Das response-Objekt enthält den generierten Text (zugänglich über response.text) zusammen mit anderen potenziellen Informationen wie Sicherheitsbewertungen oder Nutzungsmetadaten (abhängig von der API-Version und -Konfiguration).

Durch das Experimentieren mit verschiedenen thinking_budget-Werten für verschiedene Prompts können Sie direkt deren Auswirkungen auf die Qualität, Tiefe und Latenz der Antworten beobachten und so für die spezifischen Anforderungen Ihrer Anwendung optimieren.

Want an integrated, All-in-One platform for your Developer Team to work together with maximum productivity?

Apidog delivers all your demans, and replaces Postman at a much more affordable price!

How to Use Google Gemini 2.5 Flash for Free

Google hat einen bedeutenden Schritt unternommen, um Studenten zu unterstützen, indem es den Google One AI Premium-Plan für berechtigte College-Studenten in den USA kostenlos anbietet. Dieser Plan bietet Zugriff auf eine Reihe der fortschrittlichsten KI-Funktionen von Google.

Was beinhaltet das kostenlose Google One AI Premium für Studenten?

- Zugriff auf erweiterte Gemini-Modelle: Verwenden Sie die Top-Modelle von Google (wie Gemini Advanced) in integrierten Umgebungen wie der Gemini-App.

- Gemini in Google Workspace: Erhalten Sie KI-Unterstützung direkt in Google Docs, Sheets, Slides und Gmail zum Schreiben, Analysieren, Erstellen von Präsentationen und mehr.

- NotebookLM Plus: Ein KI-gestütztes Recherche-Tool, das hilft, Informationen aus hochgeladenen Dokumenten (wie Kursmaterialien) zu verstehen und zu synthetisieren, Lernhilfen zu erstellen und neue Quellen zu entdecken.

- Creative Tools: Experimentieren Sie mit Funktionen, die oft in Google Labs zu finden sind, wie z. B. Veo 2 für die Text-zu-Video-Generierung und Whisk für das Mischen von Bildern.

- Gemini Live & Deep Research: Führen Sie freie Gespräche und führen Sie eingehende Recherchen zu komplexen Themen innerhalb der Gemini-Oberfläche durch.

- 2 TB Cloud-Speicher: Erheblicher Speicherplatz in Google Drive, Fotos und Gmail.

Wie hängt dies mit der Gemini 2.5 Flash API zusammen?

Es ist wichtig, den Unterschied zu verstehen: Der kostenlose Google One AI Premium-Plan für Studenten gewährt in erster Linie Zugriff auf erweiterte KI-Funktionen innerhalb der eigenen Anwendungen und Dienste von Google (Gemini-App, Workspace, NotebookLM). Diese Funktionen werden von fortschrittlichen Modellen betrieben, die Gemini 2.5 Flash oder ähnliche Stufen im Hintergrund enthalten könnten.

Dieses Studentenangebot führt jedoch in der Regel nicht zu kostenlosen API-Guthaben für direkte programmgesteuerte Aufrufe der Gemini-API (wie die oben gezeigten generate_content-Beispiele). Die API-Nutzung folgt im Allgemeinen den Standardpreisstufen, die auf dem Token-Verbrauch basieren, obwohl kostenlose Stufen oder Einführungs-Guthaben möglicherweise separat über Google AI Studio oder Google Cloud verfügbar sind.

Der Wert für Studenten liegt darin, die Fähigkeiten von Modellen wie 2.5 Flash über benutzerfreundliche Oberflächen zu nutzen, die in Tools integriert sind, die sie bereits für das Lernen und die Produktivität verwenden, ohne die Google One-Abonnementgebühr zahlen oder die API-Abrechnung direkt für diese Nutzung verwalten zu müssen.

Fazit

Gemini 2.5 Flash bietet eine überzeugende Mischung aus Geschwindigkeit, Wirtschaftlichkeit und anspruchsvollen Denkfähigkeiten, die durch sein steuerbares Denkbudget noch vielseitiger wird. Der Einstieg in die API beinhaltet das Abrufen eines Schlüssels von Google AI Studio, das Einrichten Ihrer Umgebung mit der Client-Bibliothek und das Tätigen von Aufrufen unter Verwendung des spezifischen Modellnamens und des gewünschten thinking_config. Durch die sorgfältige Auswahl des Denkbudgets können Entwickler das Verhalten des Modells an ihre genauen Bedürfnisse anpassen.

Während der kostenlose Google One AI Premium-Plan für Studenten den Zugriff auf Erfahrungen ermöglicht, die von diesen fortschrittlichen Modellen innerhalb des Google-Ökosystems betrieben werden, bleibt die direkte API-Nutzung im Allgemeinen ein separater, abgerechneter Dienst. Nichtsdestotrotz eröffnet die Verfügbarkeit von 2.5 Flash als Vorschau über die API aufregende Möglichkeiten für den Aufbau der nächsten Generation intelligenter Anwendungen. Da sich das Modell noch in der Vorschau befindet, sollten Entwickler die Dokumentation von Google auf Aktualisierungen zu Modellnamen, Funktionen und allgemeiner Verfügbarkeit im Auge behalten.

```