Möchten Sie Ihren Coding-Workflow mit GPT-OSS, Open AIs Open-Weight-Modell, direkt in Claude Code beschleunigen? Sie erwartet ein echtes Highlight! Im August 2025 veröffentlicht, ist GPT-OSS (20B oder 120B Varianten) ein Kraftpaket für Codierung und logisches Denken, und Sie können es mit der eleganten CLI-Oberfläche von Claude Code für kostenlose oder kostengünstige Setups kombinieren. In diesem konversationsorientierten Leitfaden führen wir Sie durch drei Wege, um GPT-OSS mit Claude Code mithilfe von Hugging Face, OpenRouter oder LiteLLM zu integrieren. Tauchen wir ein und bringen Sie Ihren KI-Programmier-Sidekick zum Laufen!

Möchten Sie eine integrierte All-in-One-Plattform, damit Ihr Entwicklerteam mit maximaler Produktivität zusammenarbeiten kann?

Apidog erfüllt all Ihre Anforderungen und ersetzt Postman zu einem wesentlich günstigeren Preis!

Was ist GPT-OSS und warum sollte man es mit Claude Code verwenden?

GPT-OSS ist Open AIs Open-Weight-Modellfamilie, deren 20B- und 120B-Varianten hervorragende Leistung für Codierung, logisches Denken und agentische Aufgaben bieten. Mit einem 128K Token Kontextfenster und einer Apache 2.0-Lizenz ist es perfekt für Entwickler, die Flexibilität und Kontrolle wünschen. Claude Code, Anthropic’s CLI-Tool (Version 0.5.3+), ist ein Entwicklerliebling aufgrund seiner konversationsbasierten Programmierfähigkeiten. Indem Sie Claude Code über OpenAI-kompatible APIs an GPT-OSS weiterleiten, können Sie Claudes vertraute Oberfläche nutzen und gleichzeitig die Open-Source-Leistung von GPT-OSS ausschöpfen – ohne die Abonnementkosten von Anthropic. Bereit, es umzusetzen? Lassen Sie uns die Einrichtungsoptionen erkunden!

Voraussetzungen für die Verwendung von GPT-OSS mit Claude Code

Bevor wir beginnen, stellen Sie sicher, dass Sie Folgendes haben:

- Claude Code ≥ 0.5.3: Überprüfen Sie dies mit

claude --version. Installieren Sie es überpip install claude-codeoder aktualisieren Sie es mitpip install --upgrade claude-code. - Hugging Face-Konto: Registrieren Sie sich auf huggingface.co und erstellen Sie ein Lese-/Schreib-Token (Einstellungen > Zugriffstoken).

- OpenRouter API-Schlüssel: Optional, für Pfad B. Holen Sie sich einen unter openrouter.ai.

- Python 3.10+ und Docker: Für lokale Setups oder LiteLLM (Pfad C).

- Grundlegende CLI-Kenntnisse: Vertrautheit mit Umgebungsvariablen und Terminalbefehlen ist hilfreich.

Pfad A: GPT-OSS selbst auf Hugging Face hosten

Möchten Sie die volle Kontrolle? Hosten Sie GPT-OSS auf den Inference Endpoints von Hugging Face für ein privates, skalierbares Setup. So geht's:

Schritt 1: Das Modell abrufen

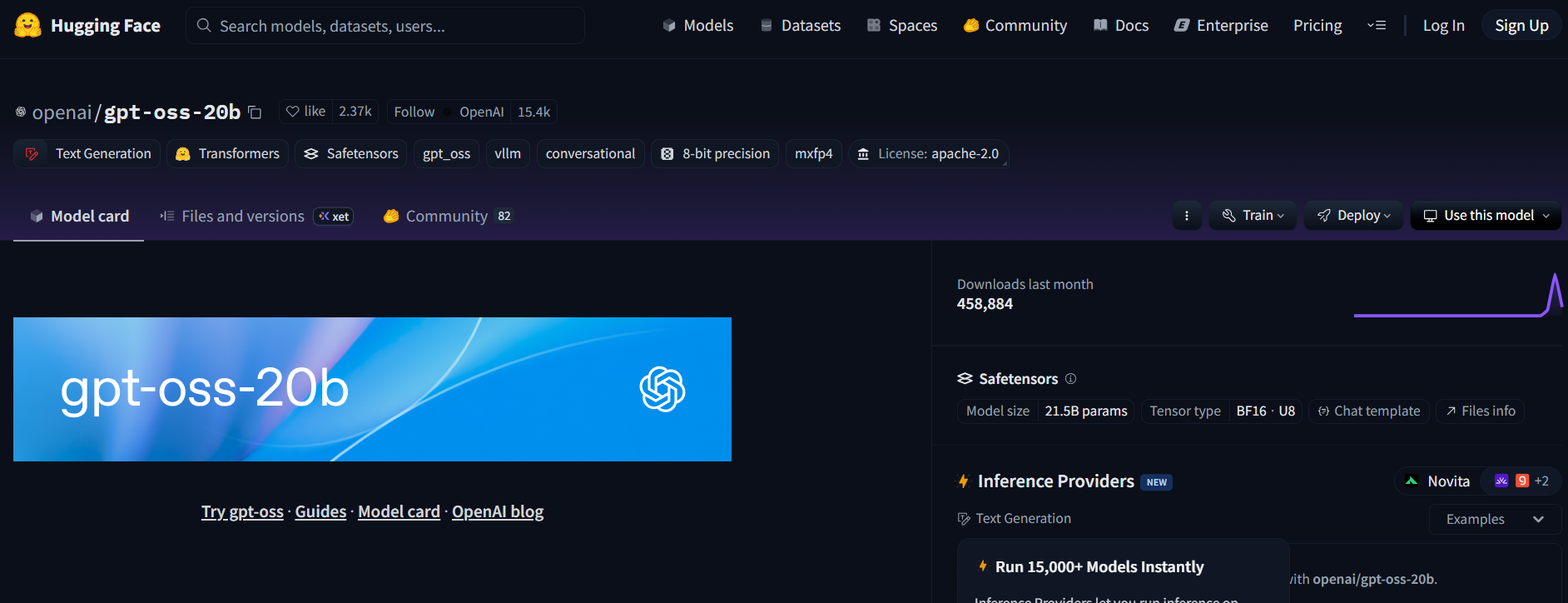

- Besuchen Sie das GPT-OSS-Repository auf Hugging Face (openai/gpt-oss-20b oder openai/gpt-oss-120b).

- Akzeptieren Sie die Apache 2.0-Lizenz, um auf das Modell zuzugreifen.

- Alternativ können Sie Qwen3-Coder-480B-A35B-Instruct (Qwen/Qwen3-Coder-480B-A35B-Instruct) für ein auf Codierung spezialisiertes Modell ausprobieren (verwenden Sie eine GGUF-Version für leichtere Hardware).

Schritt 2: Einen Textgenerierungs-Inferenz-Endpunkt bereitstellen

- Klicken Sie auf der Modellseite auf Bereitstellen > Inferenz-Endpunkt.

- Wählen Sie die Text Generation Inference (TGI)-Vorlage (≥ v1.4.0).

- Aktivieren Sie die OpenAI-Kompatibilität, indem Sie „Enable OpenAI compatibility“ ankreuzen oder

--enable-openaiin den erweiterten Einstellungen hinzufügen. - Wählen Sie die Hardware: A10G oder CPU für 20B, A100 für 120B. Erstellen Sie den Endpunkt.

Schritt 3: Anmeldeinformationen sammeln

- Sobald der Endpunkt-Status „Running“ (Läuft) ist, kopieren Sie:

- ENDPOINT_URL: Sieht aus wie

https://<Ihr-Endpunkt>.us-east-1.aws.endpoints.huggingface.cloud. - HF_API_TOKEN: Ihr Hugging Face-Token aus Einstellungen > Zugriffstoken.

2. Notieren Sie sich die Modell-ID (z.B. gpt-oss-20b oder gpt-oss-120b).

Schritt 4: Claude Code konfigurieren

- Setzen Sie Umgebungsvariablen in Ihrem Terminal:

export ANTHROPIC_BASE_URL="https://<your-endpoint>.us-east-1.aws.endpoints.huggingface.cloud"

export ANTHROPIC_AUTH_TOKEN="hf_xxxxxxxxxxxxxxxxx"

export ANTHROPIC_MODEL="gpt-oss-20b" # or gpt-oss-120b

Ersetzen Sie <your-endpoint> und hf_xxxxxxxxxxxxxxxxx durch Ihre Werte.

2. Testen Sie das Setup:

claude --model gpt-oss-20b

Claude Code leitet Anfragen an Ihren GPT-OSS-Endpunkt weiter und streamt Antworten über die /v1/chat/completions API von TGI, die das OpenAI-Schema nachahmt.

Schritt 5: Hinweise zu Kosten und Skalierung

- Hugging Face Kosten: Inference Endpoints skalieren automatisch, überwachen Sie daher die Nutzung, um einen Kreditverbrauch zu vermeiden. A10G kostet ca. 0,60 $/Stunde, A100 ca. 3 $/Stunde.

- Lokale Option: Für null Cloud-Kosten führen Sie TGI lokal mit Docker aus:

docker run --name tgi -p 8080:80 -e HF_TOKEN=hf_xxxxxxxxxxxxxxxxx ghcr.io/huggingface/text-generation-inference:latest --model-id openai/gpt-oss-20b --enable-openai

Setzen Sie dann ANTHROPIC_BASE_URL="http://localhost:8080".

Pfad B: GPT-OSS über OpenRouter proxyn

Kein DevOps? Kein Problem! Nutzen Sie OpenRouter, um mit minimalem Aufwand auf GPT-OSS zuzugreifen. Es ist schnell und übernimmt die Abrechnung für Sie.

Schritt 1: Registrieren und ein Modell auswählen

- Registrieren Sie sich auf openrouter.ai und kopieren Sie Ihren API-Schlüssel aus dem Bereich „Keys“.

- Wählen Sie einen Modell-Slug:

openai/gpt-oss-20bopenai/gpt-oss-120bqwen/qwen3-coder-480b(für Qwens Coder-Modell)

Schritt 2: Claude Code konfigurieren

- Setzen Sie Umgebungsvariablen:

export ANTHROPIC_BASE_URL="https://openrouter.ai/api/v1"

export ANTHROPIC_AUTH_TOKEN="or_xxxxxxxxx"

export ANTHROPIC_MODEL="openai/gpt-oss-20b"

Ersetzen Sie or_xxxxxxxxx durch Ihren OpenRouter API-Schlüssel.

2. Testen Sie es:

claude --model openai/gpt-oss-20b

Claude Code verbindet sich über die vereinheitlichte API von OpenRouter mit GPT-OSS, inklusive Streaming- und Fallback-Unterstützung.

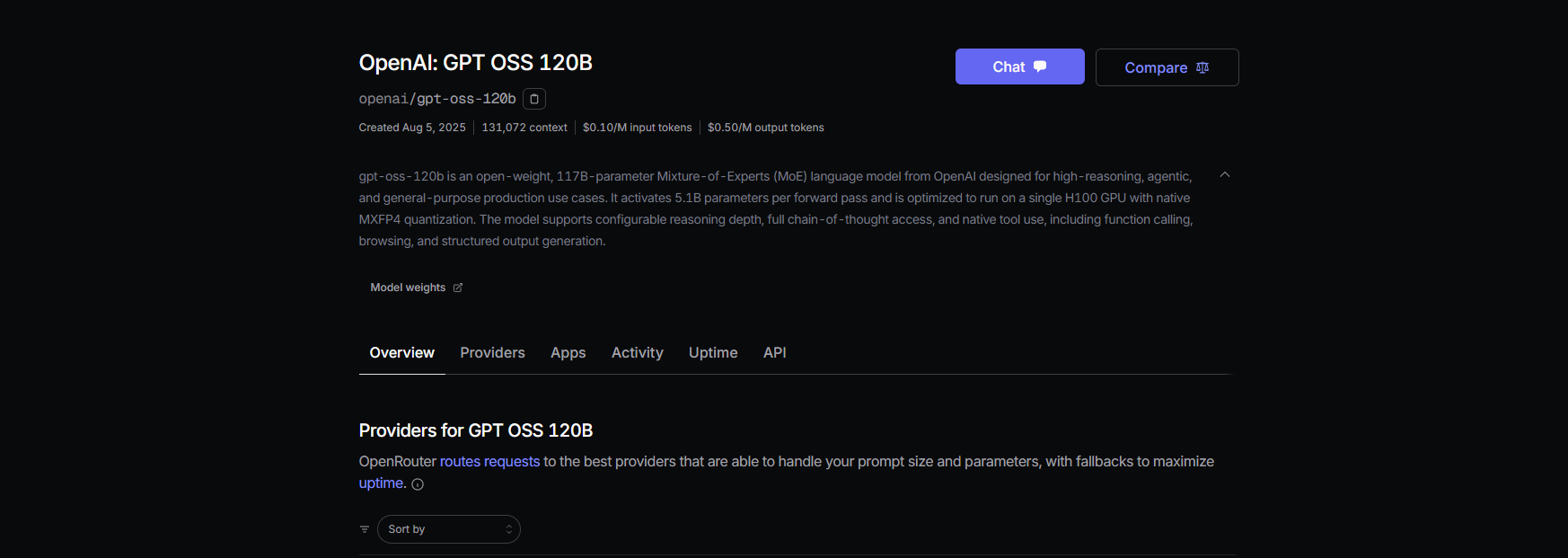

Schritt 3: Kostenhinweise

- OpenRouter Preise: ca. 0,50 $/M Eingabe-Tokens, ca. 2,00 $/M Ausgabe-Tokens für GPT-OSS-120B, deutlich günstiger als proprietäre Modelle wie GPT-4 (ca. 20,00 $/M).

- Abrechnung: OpenRouter verwaltet die Nutzung, sodass Sie nur für das bezahlen, was Sie verbrauchen.

Pfad C: LiteLLM für gemischte Modell-Flotten verwenden

Möchten Sie GPT-OSS, Qwen und Anthropic-Modelle in einem Workflow jonglieren? LiteLLM fungiert als Proxy, um Modelle nahtlos im laufenden Betrieb zu wechseln.

Schritt 1: LiteLLM installieren und konfigurieren

- LiteLLM installieren:

pip install litellm

2. Eine Konfigurationsdatei erstellen (litellm.yaml):

model_list:

- model_name: gpt-oss-20b

litellm_params:

model: openai/gpt-oss-20b

api_key: or_xxxxxxxxx # OpenRouter key

api_base: https://openrouter.ai/api/v1

- model_name: qwen3-coder

litellm_params:

model: openrouter/qwen/qwen3-coder

api_key: or_xxxxxxxxx

api_base: https://openrouter.ai/api/v1

Ersetzen Sie or_xxxxxxxxx durch Ihren OpenRouter-Schlüssel.

3. Den Proxy starten:

litellm --config litellm.yaml

Schritt 2: Claude Code auf LiteLLM verweisen

- Setzen Sie Umgebungsvariablen:

export ANTHROPIC_BASE_URL="http://localhost:4000"

export ANTHROPIC_AUTH_TOKEN="litellm_master"

export ANTHROPIC_MODEL="gpt-oss-20b"

2. Testen Sie es:

claude --model gpt-oss-20b

LiteLLM leitet Anfragen an GPT-OSS über OpenRouter weiter, mit Kostenprotokollierung und Simple-Shuffle-Routing für Zuverlässigkeit.

Schritt 3: Hinweise

- Latenz-Routing vermeiden: Verwenden Sie den Simple-Shuffle-Modus in LiteLLM, um Probleme mit Anthropic-Modellen zu vermeiden.

- Kostenverfolgung: LiteLLM protokolliert die Nutzung für Transparenz.

GPT-OSS mit Claude Code testen

Stellen wir sicher, dass GPT-OSS funktioniert! Öffnen Sie Claude Code und probieren Sie diese Befehle aus:

Codegenerierung:

claude --model gpt-oss-20b "Write a Python REST API with Flask"

Erwarten Sie eine Antwort wie:

from flask import Flask, jsonify

app = Flask(__name__)

@app.route('/api', methods=['GET'])

def get_data():

return jsonify({"message": "Hello from GPT-OSS!"})

if __name__ == '__main__':

app.run(debug=True)

Codebasis-Analyse:

claude --model gpt-oss-20b "Summarize src/server.js"

GPT-OSS nutzt sein 128K Kontextfenster, um Ihre JavaScript-Datei zu analysieren und eine Zusammenfassung zurückzugeben.

Debugging:

claude --model gpt-oss-20b "Debug this buggy Python code: [paste code]"

Mit einer HumanEval-Passrate von 87,3 % sollte GPT-OSS Probleme genau erkennen und beheben.

Fehlerbehebungstipps

- 404 bei /v1/chat/completions? Stellen Sie sicher, dass

--enable-openaiin TGI (Pfad A) aktiv ist oder überprüfen Sie die Modellverfügbarkeit von OpenRouter (Pfad B). - Leere Antworten? Überprüfen Sie, ob

ANTHROPIC_MODELmit dem Slug (z.B.gpt-oss-20b) übereinstimmt. - 400-Fehler nach Modellwechsel? Verwenden Sie Simple-Shuffle-Routing in LiteLLM (Pfad C).

- Langsamer erster Token? Wärmen Sie Hugging Face-Endpunkte mit einem kleinen Prompt auf, nachdem Sie auf Null skaliert haben.

- Claude Code stürzt ab? Aktualisieren Sie auf ≥ 0.5.3 und stellen Sie sicher, dass die Umgebungsvariablen korrekt gesetzt sind.

Warum GPT-OSS mit Claude Code verwenden?

Die Kombination von GPT-OSS mit Claude Code ist der Traum eines jeden Entwicklers. Sie erhalten:

- Kostenersparnis: OpenRouters 0,50 $/M Eingabe-Tokens schlagen proprietäre Modelle, und lokale TGI-Setups sind nach Hardwarekosten kostenlos.

- Open-Source-Leistung: Die Apache 2.0-Lizenz von GPT-OSS ermöglicht es Ihnen, es anzupassen oder privat bereitzustellen.

- Nahtloser Workflow: Claudes Code-CLI fühlt sich an wie ein Gespräch mit einem Programmier-Buddy, während GPT-OSS die Schwerstarbeit mit 94,2 % MMLU- und 96,6 % AIME-Scores erledigt.

- Flexibilität: Wechseln Sie mit LiteLLM oder OpenRouter zwischen GPT-OSS-, Qwen- oder Anthropic-Modellen.

Benutzer schwärmen von der Programmierleistung von GPT-OSS und nennen es „ein budgetfreundliches Biest für Multi-Datei-Projekte“. Ob Sie selbst hosten oder über OpenRouter proxyn, dieses Setup hält die Kosten niedrig und die Produktivität hoch.

Fazit

Sie sind jetzt bereit, GPT-OSS mit Claude Code zu rocken! Egal, ob Sie selbst auf Hugging Face hosten, über OpenRouter proxyn oder LiteLLM zum Jonglieren von Modellen verwenden, Sie haben ein leistungsstarkes, kostengünstiges Programmier-Setup. Von der Generierung von REST-APIs bis zum Debugging von Code liefert GPT-OSS ab, und Claude Code lässt es mühelos erscheinen. Probieren Sie es aus, teilen Sie Ihre Lieblings-Prompts in den Kommentaren und lassen Sie uns über KI-Codierung fachsimpeln!

Möchten Sie eine integrierte All-in-One-Plattform, damit Ihr Entwicklerteam mit maximaler Produktivität zusammenarbeiten kann?

Apidog erfüllt all Ihre Anforderungen und ersetzt Postman zu einem wesentlich günstigeren Preis!