Die GPT-5 API von OpenAI stellt einen bedeutenden Sprung in den KI-Fähigkeiten dar und bietet Entwicklern unübertroffene Leistung für den Aufbau intelligenter Anwendungen. Egal, ob Sie fortschrittliche Chatbots erstellen, komplexe Arbeitsabläufe automatisieren oder dynamische Inhalte generieren, die GPT-5 API bietet die Werkzeuge, um Ihre Ideen zum Leben zu erwecken.

Was ist GPT 5 und warum ist es wichtig?

GPT 5 ist die neueste KI-Generation von OpenAI, die am **7. August 2025** veröffentlicht wurde. Sie dient als einheitliches System mit integriertem Denkvermögen, das je nach Komplexität der Anfrage zwischen schnellem oder tiefem Denken wählt. Sie übertrifft frühere Modelle in den Bereichen Schreiben, Programmieren, Gesundheitsberatung und vielem mehr, während Halluzinationen und Kriecherei deutlich reduziert werden.

Dieses Modell eignet sich für Szenarien, in denen Intelligenz und Zuverlässigkeit auf Expertenniveau einen Unterschied machen.

Um zu beginnen, benötigen Sie ein OpenAI-Konto, einen generierten API-Schlüssel und eine Entwicklungsumgebung. Tools wie Apidog vereinfachen das Testen und Debuggen und erleichtern die Integration der GPT-5 API in Ihre Projekte. Lassen Sie uns die Voraussetzungen erkunden, um eine reibungslose Einrichtung zu gewährleisten.

Voraussetzungen für die Nutzung der GPT-5 API

Bevor Sie die GPT-5 API integrieren, stellen Sie sicher, dass Sie Folgendes haben:

- **OpenAI-Konto und API-Schlüssel**: Melden Sie sich auf der OpenAI-Plattform an und generieren Sie einen API-Schlüssel über das Dashboard, um Anfragen zu authentifizieren.

- **Entwicklungsumgebung**: Richten Sie eine Programmierumgebung mit einer Sprache wie Python, Node.js oder cURL ein, die HTTP-Anfragen unterstützt.

- **Apidog-Installation**: Laden Sie Apidog herunter, um API-Aufrufe effizient zu testen und zu verwalten. Die intuitive Benutzeroberfläche hilft bei der Validierung von Antworten und der Fehlerbehebung.

- **Grundlegendes API-Wissen**: Verstehen Sie HTTP-Methoden (POST, GET) und das JSON-Format zum Strukturieren von Anfragen.

Mit diesen Voraussetzungen sind Sie bereit, Ihre Umgebung für die GPT-5 API zu konfigurieren. Als Nächstes werden wir den Einrichtungsprozess detailliert behandeln.

Einrichtung Ihrer Umgebung für die GPT-5 API

Um mit der GPT-5 API zu interagieren, konfigurieren Sie Ihre Entwicklungsumgebung mit Python, einer beliebten Wahl aufgrund ihrer Einfachheit und des robusten OpenAI SDK. Befolgen Sie diese Schritte:

Schritt 1: Installieren Sie das OpenAI SDK

Installieren Sie die OpenAI Python-Bibliothek, um API-Interaktionen zu vereinfachen. Führen Sie den folgenden Befehl in Ihrem Terminal aus:

pip install openai

Dies installiert die neueste Version des OpenAI SDK, kompatibel mit GPT-5.

Schritt 2: Sichern Sie Ihren API-Schlüssel

Generieren Sie einen API-Schlüssel über das OpenAI-Dashboard. Speichern Sie ihn sicher in einer Umgebungsvariable, um eine versehentliche Offenlegung zu verhindern. Verwenden Sie beispielsweise in Python das `os`-Modul:

import os

os.environ["OPENAI_API_KEY"] = "your-api-key-here"

Alternativ können Sie eine `.env`-Datei mit einer Bibliothek wie `python-dotenv` für bessere Sicherheit verwenden.

Schritt 3: Überprüfen Sie die Apidog-Installation

Installieren Sie Apidog, um das Testen zu optimieren. Konfigurieren Sie es nach dem Download so, dass es Anfragen an den GPT-5 API-Endpunkt (`https://api.openai.com/v1/chat/completions`) sendet. Fügen Sie Ihren API-Schlüssel dem `Authorization`-Header in der Apidog-Oberfläche für schnelle Tests hinzu.

Schritt 4: Konnektivität testen

Senden Sie eine einfache Testanfrage, um Ihre Einrichtung zu überprüfen. Hier ist ein Python-Beispiel:

from openai import OpenAI

client = OpenAI()

response = client.chat.completions.create(

model="gpt-5",

messages=[{"role": "user", "content": "Hallo, GPT-5!"}]

)

print(response.choices[0].message.content)

Bei Erfolg erhalten Sie eine Antwort von GPT-5. Verwenden Sie Apidog, um die Anfrage und Antwort zum Debuggen zu überwachen. Nun strukturieren wir API-Anfragen für optimale Leistung.

Strukturierung von GPT-5 API-Anfragen

Die GPT-5 API verwendet den Endpunkt `/v1/chat/completions` und akzeptiert JSON-formatierte POST-Anfragen. Eine typische Anfrage umfasst das Modell, Nachrichten und optionale Parameter wie `temperature` und `max_tokens`. Hier ist ein Beispiel:

from openai import OpenAI

client = OpenAI()

response = client.chat.completions.create(

model="gpt-5",

messages=[

{"role": "system", "content": "Sie sind ein Programmierassistent."},

{"role": "user", "content": "Schreiben Sie eine Python-Funktion zur Berechnung von Fibonacci-Zahlen."}

],

temperature=0.7,

max_tokens=500

)

print(response.choices[0].message.content)

Schlüsselparameter

- **Modell**: Geben Sie `gpt-5`, `gpt-5-mini` oder `gpt-5-nano` je nach Ihren Bedürfnissen an.

- **Nachrichten**: Ein Array von Nachrichtenobjekten, die den Konversationskontext definieren.

- **Temperatur**: Steuert die Zufälligkeit (0,0–2,0). Niedrigere Werte (z.B. 0,7) sorgen für fokussiertere Ausgaben.

- **Max. Token**: Begrenzt die Antwortlänge, um Kosten und Leistung zu verwalten.

- **Ausführlichkeit (Verbosity)**: Ein neuer GPT-5-Parameter (`low`, `medium`, `high`) zur Steuerung der Antwortdetails.

Verwenden Sie Apidog, um verschiedene Parameterkombinationen zu testen und Antwortstrukturen zu analysieren. Als Nächstes werden wir untersuchen, wie API-Antworten effektiv verarbeitet werden können.

Umgang mit GPT-5 API-Antworten

Die GPT-5 API gibt JSON-Antworten zurück, die die Ausgabe des Modells, Metadaten und Nutzungsdetails enthalten. Eine Beispielantwort sieht wie folgt aus:

{

"id": "chatcmpl-123",

"object": "chat.completion",

"created": 1694016000,

"model": "gpt-5",

"choices": [

{

"index": 0,

"message": {

"role": "assistant",

"content": "Hier ist eine Python-Funktion zur Berechnung von Fibonacci-Zahlen:\n```python\ndef fibonacci(n):\n if n <= 0:\n return []\n if n == 1:\n return [0]\n fib = [0, 1]\n for i in range(2, n):\n fib.append(fib[i-1] + fib[i-2])\n return fib\n```"

},

"finish_reason": "stop"

}

],

"usage": {

"prompt_tokens": 20,

"completion_tokens": 80,

"total_tokens": 100

}

}

Antworten parsen

Extrahieren Sie den Antwortinhalt mit Python:

content = response.choices[0].message.content

print(content)

Überwachen Sie die Token-Nutzung (`usage.total_tokens`), um die Kosten zu verfolgen. Die Oberfläche von Apidog zeigt Antwortdaten klar an und hilft Ihnen, Probleme wie unvollständige Ausgaben zu identifizieren. Wenn Fehler auftreten, überprüfen Sie das Feld `error` in der Antwort für Details.

Praktische Anwendungsfälle für die GPT-5 API

Die Vielseitigkeit der GPT-5 API macht sie ideal für verschiedene Anwendungen. Hier sind drei praktische Anwendungsfälle:

1. Code-Generierung

GPT-5 zeichnet sich durch die Generierung von funktionsfähigem Code für komplexe Aufgaben aus. Fordern Sie es beispielsweise auf, eine Web-App zu erstellen:

response = client.chat.completions.create(

model="gpt-5",

messages=[

{"role": "user", "content": "Erstellen Sie eine einseitige HTML-App für eine To-Do-Liste mit JavaScript."}

]

)

Die Antwort enthält vollständigen, ausführbaren Code. Testen Sie die Ausgabe mit Apidog, um die Korrektheit sicherzustellen.

2. Inhaltserstellung

Automatisieren Sie die Blogbeitragsgenerierung, indem Sie ein Thema und Richtlinien angeben:

response = client.chat.completions.create(

model="gpt-5",

messages=[

{"role": "user", "content": "Schreiben Sie einen 500 Wörter langen Blogbeitrag über KI-Trends im Jahr 2025."}

]

)

Verfeinern Sie die Ausgaben mit Apidog, um sicherzustellen, dass der Inhalt Ihren Stil- und Längenanforderungen entspricht.

3. Datenanalyse

Verwenden Sie GPT-5, um Datensätze zu analysieren oder Erkenntnisse zu generieren:

response = client.chat.completions.create(

model="gpt-5",

messages=[

{"role": "user", "content": "Analysieren Sie diese CSV-Daten und fassen Sie Trends zusammen: [Daten einfügen]."}

]

)

Apidog hilft bei der Validierung der API-Antwortstruktur für große Datensätze.

Optimierung der GPT-5 API-Leistung

Um die Effizienz zu maximieren und die Kosten zu minimieren, befolgen Sie diese Optimierungsstrategien:

- **Spezifische Prompts verwenden**: Erstellen Sie klare, detaillierte Prompts, um irrelevante Ausgaben zu reduzieren. Zum Beispiel, anstatt „Schreiben Sie über KI“, verwenden Sie „Schreiben Sie einen 300-Wörter-Artikel über KI-Ethik im Gesundheitswesen.“

- **Varianten nutzen**: Wählen Sie `gpt-5-mini` (0,25 $/1 Mio. Eingabetoken, 2 $/1 Mio. Ausgabetoken) oder `gpt-5-nano` (0,05 $/1 Mio. Eingabetoken, 0,40 $/1 Mio. Ausgabetoken) für kostensensitive Aufgaben. Das vollständige `gpt-5`-Modell kostet 1,25 $/1 Mio. Eingabetoken und 10 $/1 Mio. Ausgabetoken.

- **Token-Nutzung überwachen**: Verfolgen Sie die `usage` in den Antworten, um das Budget einzuhalten. Details finden Sie auf der OpenAI-Preisseite.

- **Mit Apidog testen**: Führen Sie kleine Tests durch, um Prompts vor der Skalierung zu optimieren.

- **Ausführlichkeit anpassen**: Stellen Sie den `verbosity`-Parameter ein, um die Balance zwischen Antwortdetails und Token-Nutzung zu finden.

Durch die Optimierung von Prompts und die Auswahl der richtigen Modellvariante können Sie hohe Leistung zu geringeren Kosten erzielen. Nun gehen wir auf häufig auftretende Probleme ein.

Behebung häufiger GPT-5 API-Probleme

Trotz ihrer Robustheit kann die GPT-5 API Herausforderungen mit sich bringen. Hier sind häufige Probleme und Lösungen:

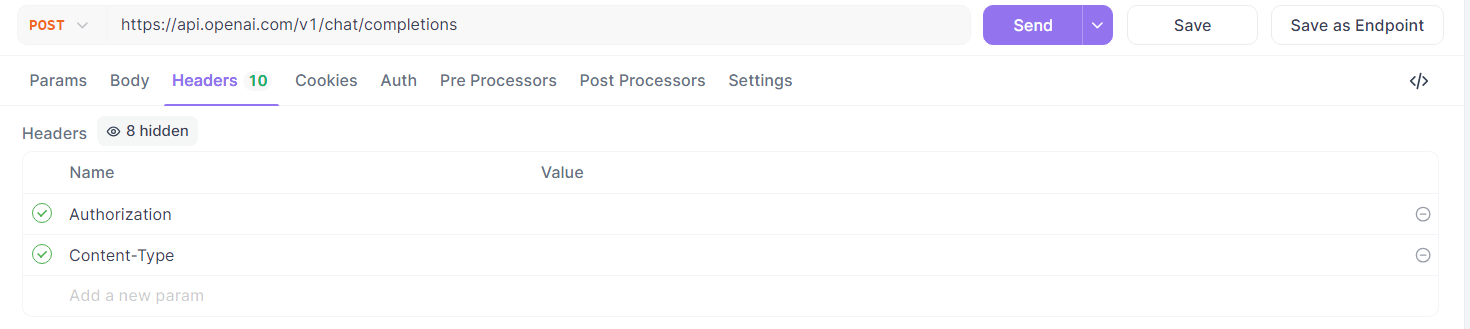

- **Authentifizierungsfehler**: Stellen Sie sicher, dass Ihr API-Schlüssel gültig und korrekt im `Authorization`-Header enthalten ist. Überprüfen Sie dies in den Einstellungen von Apidog.

- **Ratenbegrenzungen**: Das Überschreiten von Nutzungslimits löst Fehler aus. Überwachen Sie Ihr Kontingent im OpenAI-Dashboard und wechseln Sie bei Bedarf zu einem kostenpflichtigen Tarif (z.B. Pro für 200 $/Monat für unbegrenzten GPT-5-Zugriff).

- **Unerwartete Ausgaben**: Verfeinern Sie Prompts für mehr Klarheit und testen Sie Variationen in Apidog, um die optimale Formulierung zu finden.

- **Hohe Kosten**: Verwenden Sie `gpt-5-mini` oder `gpt-5-nano` für weniger komplexe Aufgaben, um den Token-Verbrauch zu reduzieren.

Die Debugging-Tools von Apidog helfen, Probleme schnell zu identifizieren, indem sie Anfrage- und Antwortdaten visualisieren. Als Nächstes werden wir untersuchen, wie Apidog die GPT-5 API-Integration verbessert.

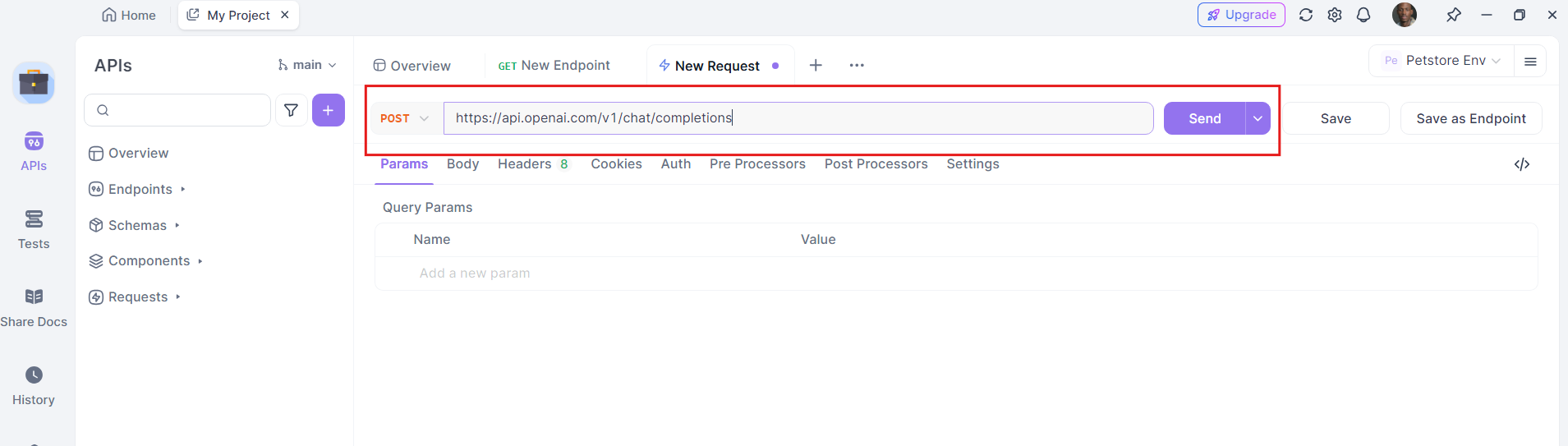

Schnelleinrichtung: GPT 5 API mit Apidog verwenden

Beginnen Sie reibungslos, indem Sie diese Schritte befolgen:

**Apidog installieren**: Herunterladen und starten – es ist kostenlos.

**Neue API-Anfrage einrichten**:

Methode: `POST`

URL: `https://api.openai.com/v1/chat/completions`

Header:

`Authorization: Bearer YOUR_API_KEY`

`Content-Type: application/json`

**Ihre Payload erstellen**:

{

"model": "gpt-5",

"messages": [

{"role": "system", "content": "Sie sind ein hilfreicher Assistent."},

{"role": "user", "content": "Erklären Sie klar die Vor- und Nachteile der GPT-5 Preisgestaltung."}

],

"reasoning_effort": "low",

"verbosity": "medium"

}

Passen Sie `"model"` bei Bedarf an `"gpt-5-mini"` oder `"gpt-5-nano"` an und verwenden Sie die Parameter `"reasoning_effort"` oder `"verbosity"`, um die Ausgabedetails zu steuern. (OpenAI)

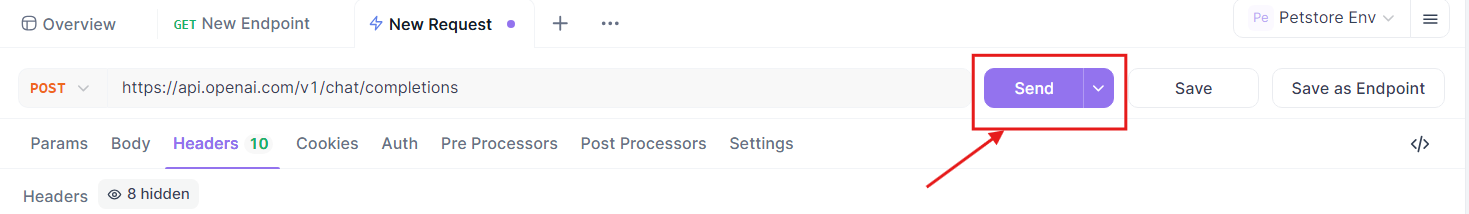

**Ausführen und Validieren**: Senden Sie die Anfrage über Apidog. Überprüfen Sie die Vervollständigungsantwort direkt in Apidog.

**Schrittweise iterieren**: Wechseln Sie reibungslos von Mini- zu Voll-GPT 5, je nach Kosten- und Komplexitätsanforderungen.

Best Practices für die Nutzung der GPT-5 API

Um optimale Ergebnisse zu gewährleisten, sollten Sie diese Best Practices anwenden:

- **API-Schlüssel sichern**: Speichern Sie Schlüssel in Umgebungsvariablen oder einer Tresorlösung.

- **Kosten überwachen**: Überprüfen Sie regelmäßig die Token-Nutzung im OpenAI-Dashboard und optimieren Sie Prompts.

- **Iteratives Testen**: Verwenden Sie Apidog, um Prompts schrittweise zu testen, bevor Sie sie im großen Maßstab bereitstellen.

- **Auf dem Laufenden bleiben**: Verfolgen Sie den OpenAI-Blog für API-Updates und neue Funktionen.

- **Sichere Vervollständigungen verwenden**: Das Training von GPT-5 für sichere Vervollständigungen gewährleistet sicherere Antworten bei sensiblen Anfragen. Erstellen Sie Prompts, um diese Funktion zu nutzen.

Durch Befolgen dieser Praktiken maximieren Sie das Potenzial der GPT-5 API, während Sie Sicherheit und Effizienz aufrechterhalten.

API-Preise, die Sie kennen sollten

OpenAI bietet GPT 5 in drei Versionen an – **gpt-5**, **gpt-5-mini** und **gpt-5-nano**. Sie ermöglichen es Ihnen, Leistung, Geschwindigkeit und Kosten auszugleichen:

| Modell | Eingabetoken (pro 1 Mio.) | Ausgabetoken (pro 1 Mio.) |

|---|---|---|

| gpt-5 | $1.25 | $10.00 |

| gpt-5-mini | $0.25 | $2.00 |

| gpt-5-nano | $0.05 | $0.40 |

Zum Vergleich: Konkurrierende Modelle wie Gemini 2.5 Flash sind für ähnliche Aufgaben teurer. Der Pro-Tarif (200 $/Monat) bietet unbegrenzten GPT-5-Zugriff, ideal für Vielnutzer. Überprüfen Sie immer die Preisseite von OpenAI auf Aktualisierungen.

Fazit

Sie haben nun eine unkomplizierte Anleitung zur Nutzung der GPT 5 API, komplett mit Einblicken in die Preisgestaltung, Anleitungen zur API-Nutzung und wie Apidog alles optimiert – kostenlos verfügbar, um schnell einsatzbereit zu sein.

Passen Sie weiterhin `reasoning_effort`, `verbosity` und die Modellgröße an die Anforderungen Ihres Projekts an. Kombinieren Sie dies mit dem klaren Design von Apidog für schnelle Iterationen.