Am 13. Mai wurde ein neues ChatGPT-Modell namens GPT-4o angekündigt. Im Vergleich zu früheren Modellen hat GPT-4o eine doppelt so schnelle Reaktionszeit wie die vorherigen Modelle und kann Text, Bilder, Audio und Video verstehen. In diesem Artikel geben wir eine umfassende Erklärung der grundlegenden Informationen über OpenAIs neuestes GPT-4o-Modell und stellen vor, wie Sie die GPT-4o-API in Ihre eigenen Dienste integrieren können.

Apidog ist auch ein völlig kostenloses Tool, also legen Sie los, indem Sie auf die Schaltfläche unten klicken! 👇👇👇

Was ist GPT-4o?

GPT-4o ist das neueste KI-Modell, das von OpenAI am 13. Mai angekündigt wurde. Das "o" in "4o" steht für "omni", was "allumfassend" bedeutet. Im Gegensatz zu den bisherigen text- und bildbasierten Interaktionen mit ChatGPT können Sie mit GPT-4o über eine Kombination aus Text, Audio, Bildern und Video interagieren.

Weitere Details finden Sie auf der offiziellen Website: https://openai.com/index/hello-gpt-4o/

Hauptmerkmale von GPT-4o

Welche Funktionen hat das neueste Modell von OpenAI, GPT-4o, im Vergleich zu früheren Modellen?

2x schnellere Reaktionszeit

Laut OpenAI sind für GPT-4 drei Schritte erforderlich, um sich mit Menschen zu unterhalten:

- Sprache in Text umwandeln

- Antworttext generieren

- Text in Sprache umwandeln

In früheren Modellen betrug die durchschnittliche Verzögerung in diesem Prozess 2,8 Sekunden für GPT-3.5 und 5,4 Sekunden für GPT-4. Das aktuelle GPT-4o kann jedoch in nur 232 Millisekunden antworten, mit einer durchschnittlichen Reaktionszeit von 320 Millisekunden, was fast der gleichen Reaktionsgeschwindigkeit wie ein Mensch entspricht. Mit anderen Worten: Die Verwendung des neuesten GPT-4o-Modells ermöglicht eine nahezu Echtzeit-Interaktion mit KI.

Versteht Audioton

Frühere GPT-Modelle konnten den Tonfall der Stimme des Sprechers oder Hintergrundgeräusche nicht erkennen, wodurch einige Informationen in Gesprächen verloren gingen. Mit der Einführung von GPT-4o kann es nun die Audiotokens oder Emotionen des Sprechers verstehen, was es menschenähnlicher macht.

Token-Reduzierung für viele Sprachen

Darüber hinaus hat GPT-4o die Anzahl der für 20 Sprachen, wie z. B. Japanisch, verwendeten Token komprimiert. Am Beispiel von Japanisch bedeutet dies, dass bei der Verwendung von ChatGPT auf Japanisch weniger Token verwendet werden.

- Für die Interaktion "Hallo, mein Name ist GPT-4o. Ich bin ein neuer Typ von Sprachmodell. Schön, dich kennenzulernen" ist die Anzahl der verwendeten Token von 37 auf 26 gesunken, eine 1,4-fache Reduzierung.

Weitere wichtige Informationen aus der GPT-4o-Ankündigung

Zusätzlich zu den Funktionen des GPT-4o-Modells selbst wurden bei der GPT-4o-Ankündigung auch folgende Informationen hervorgehoben:

Fast alle Dienste sind kostenlos

Zuvor kostenpflichtige Dienste wie GPTs, GPT Store und GPT-4 werden nach der Ankündigung von GPT-4o kostenlos verfügbar gemacht.

Desktop-App bereitgestellt

Während ChatGPT bisher nur online verfügbar war, wurde bei der Ankündigung des GPT-4o-Modells eine neue macOS ChatGPT Desktop-App angekündigt. Eine Windows-App wird voraussichtlich in der zweiten Jahreshälfte dieses Jahres veröffentlicht.

Die Details von GPT-4o verstehen

Wenn Sie die detaillierten Informationen über das neue KI-Modell von OpenAI - GPT-4o - erfahren möchten, können Sie hier die Videoaufzeichnung der Pressekonferenz einsehen.

Wie greift man auf die GPT-4o-API zu?

Bei der Entwicklung von Webanwendungen ist es sehr praktisch, APIs zu verwenden, um KI-Funktionen in Ihre eigenen Dienste zu integrieren. Mit der Ankündigung des GPT-4o-Modells müssen Sie die GPT-4o-API verwenden, um die herausragenden Fähigkeiten des GPT-4o-Modells in Ihre eigenen Dienste einzuführen. Ist die GPT-4o-API also verwendbar? Wie viel kostet es? Werfen wir einen genaueren Blick auf diese Fragen.

Ist die GPT-4o-API verfügbar?

Den neuesten Informationen von OpenAI zufolge ist die GPT-4o-Modell-API bereits als Text- und Vision-Modell in der Chat Completions API, Assistants API und Batch API verfügbar.

Updates der GPT-4o-API

Im Vergleich zu den vorherigen ChatGPT-Modell-APIs wird die GPT-4o-API in den folgenden Bereichen als besser angesehen:

- Höhere Intelligenz: Bietet GPT-4 Turbo-Leistung in Bezug auf Text-, Argumentations- und Codierungsfähigkeiten und setzt neue hohe Standards in Bezug auf mehrsprachige, Audio- und visuelle Fähigkeiten.

- 2x schnellere Reaktionsgeschwindigkeit: Die Token-Generierungsgeschwindigkeit hat sich im Vergleich zu GPT-4 Turbo verdoppelt.

- 50 % günstigerer Preis: 50 % günstiger als GPT-4 Turbo für Eingangs- und Ausgangs-Token.

- 5x höhere Ratenbegrenzung: Die Ratenbegrenzung ist 5-mal höher als bei GPT-4 Turbo, bis zu 10 Millionen Token pro Minute.

- Verbesserte visuelle Fähigkeiten: Die visuellen Fähigkeiten wurden für die meisten Aufgaben verbessert.

- Verbesserte Fähigkeiten in nicht-englischen Sprachen: Verbesserte Verarbeitung nicht-englischer Sprachen und Verwendung eines neuen Tokenizers, um nicht-englischen Text effizienter zu tokenisieren.

GPT-4o API-Preise

Wie viel kostet also die Nutzung dieses neuesten GPT-4o-API-Modells? Laut der offiziellen OpenAI-API-Website ist GPT-4o schneller und kostengünstiger als GPT-4 Turbo und bietet gleichzeitig leistungsfähigere Vision-Funktionen. Dieses Modell hat einen 128K-Kontext und deckt das Wissen bis Oktober 2023 ab. Außerdem ist es 50 % günstiger als GPT-4 Turbo. Der spezifische Preisplan ist wie folgt:

Laut der OpenAI API-Preisseite sind die Kosten/Preise für GPT-4o wie folgt:

- Texteingabe: 5 $ / 1 Mio. Token

- Textausgabe: 15 $ / 1 Mio. Token

Und die Kosten für die Bildverarbeitung (Bilderzeugung) werden basierend auf der Breite und Höhe des Bildes berechnet. Beispielsweise betragen die Kosten für die Verarbeitung eines 150 Pixel hohen und 150 Pixel breiten Bildes 0,001275 $. Benutzer können die Auflösung des Bildes frei anpassen, und der Preis basiert auf der Anzahl der Pixel.

Ob Eingabe, Ausgabe oder Bilderzeugung, die Kosten für die Verwendung der GPT-4o-API sind halb so hoch wie die von GPT-4 Turbo.

Wichtige Hinweise zur Verwendung der GPT-4o-API

Bei der Verwendung der GPT-4o-API oder beim Versuch, von anderen Modellen zur GPT-4o-API zu wechseln, müssen Sie Folgendes beachten:

- Die GPT-4o-API kann Video ohne Audio durch die Wahrnehmungsfähigkeit verstehen. Konkret müssen Sie das Video in Frames umwandeln (2-4 Frames pro Sekunde, entweder gleichmäßig abgetastet oder mithilfe eines Keyframe-Auswahlalgorithmus) und diese Frames dann in das Modell eingeben.

- Ab dem 14. Mai 2024 unterstützt die GPT-4o-API noch keine Audiomodalität. OpenAI erwartet jedoch, die Audiomodalität innerhalb der nächsten Wochen vertrauenswürdigen Testern zur Verfügung zu stellen.

- Ab dem 14. Mai 2024 unterstützt die GPT-4o-API vorerst keine Bilderzeugung. Wenn Sie also eine Bilderzeugung benötigen, wird empfohlen, die DALL-E 3 API zu verwenden.

- OpenAI empfiehlt, dass alle Benutzer, die derzeit GPT-4 oder GPT-4 Turbo verwenden, einen Wechsel zu GPT-4o in Betracht ziehen. GPT-4o ist nicht in allen Fällen unbedingt leistungsfähiger als GPT-4 oder GPT-4 Turbo, daher schlägt OpenAI vor, die Ausgaben zu vergleichen und GPT-4o auszuprobieren, um seine Fähigkeiten zu beurteilen, bevor ein Wechsel in Betracht gezogen wird.

Testen und Verwalten Sie die GPT-4o-API einfach mit Apidog

Bei der Verwendung der GPT-4o-API sind Aufgaben wie API-Tests und -Verwaltung unerlässlich.

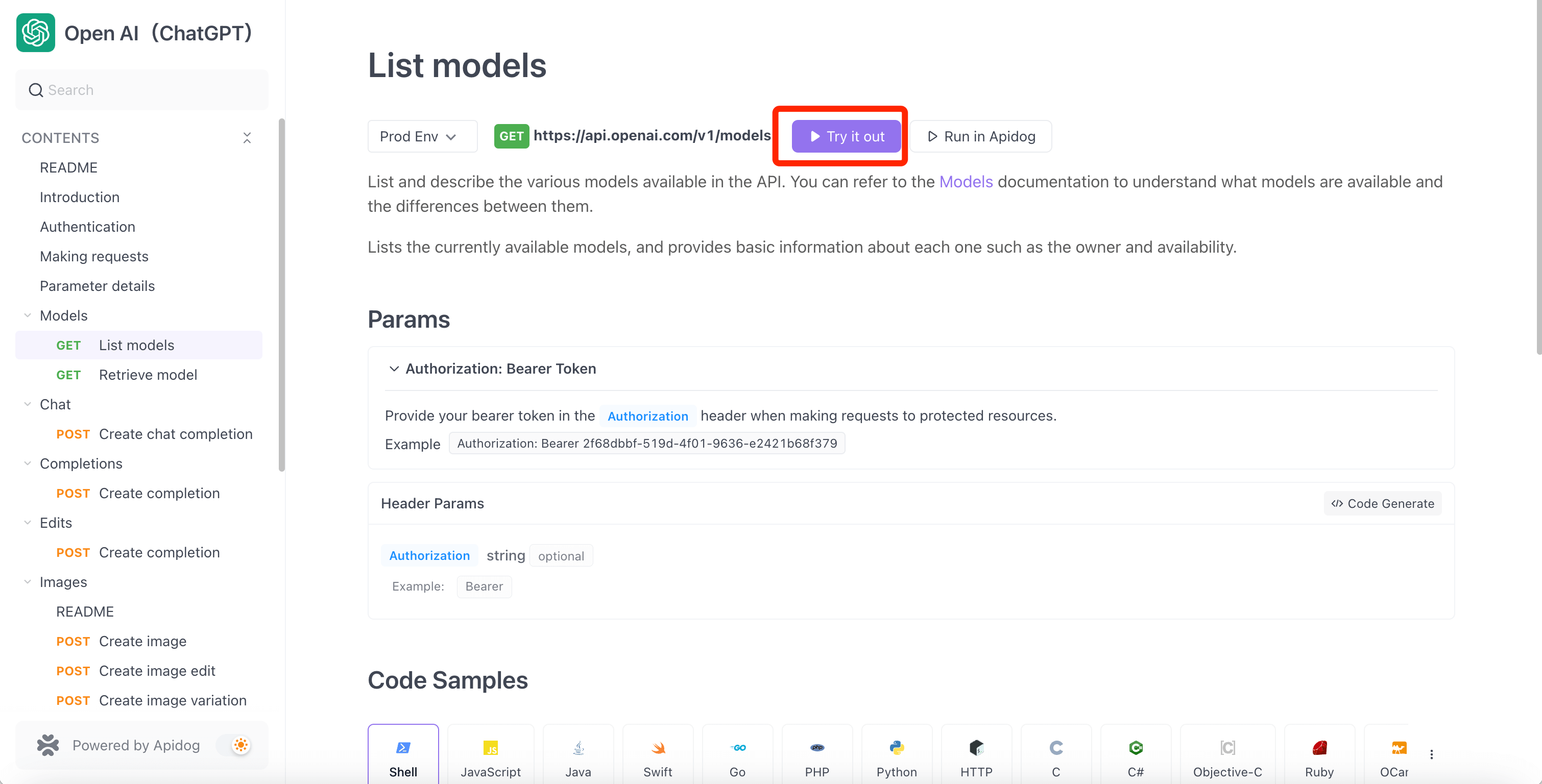

Mit dem bequemsten API-Verwaltungstool - Apidog - können Sie jede API bequemer und effizienter verarbeiten. Da die GPT-4o-API bereits verfügbar ist, können Sie auf den API Hub auf Apidog zugreifen und einfach auf das OpenAI-API-Projekt zugreifen. Anschließend können Sie das GPT-4o-API-Projekt in Ihr Projekt klonen, die GPT-4o-API verwenden und testen und es bequem mit Apidog verwalten.

Darüber hinaus unterstützt Apidog Server-Sent Events (SSE), wodurch das Streaming der GPT-4o-API einfach wird! Weitere Details finden Sie in diesem Artikel:

Voraussetzung für die Verwendung der GPT-4o-API: OpenAI-API-Schlüssel

Um mit der Verwendung der GPT-4o-API zu beginnen, müssen Sie zunächst ein OpenAI-API-Token erhalten. Befolgen Sie die folgende Anleitung, um Ihren OpenAI-API-Schlüssel zu erhalten.

1. Melden Sie sich für ein OpenAI-Konto an

Um mit der Verwendung der GPT-4o-API zu beginnen, müssen Sie zunächst ein OpenAI-Konto erstellen. Rufen Sie die offizielle OpenAI-Website auf und klicken Sie in der oberen rechten Ecke auf die Schaltfläche "Erste Schritte", um ein Konto zu erstellen.

2. Erhalten Sie den OpenAI-API-Schlüssel

Nachdem Sie Ihr OpenAI-Konto erstellt haben, müssen Sie einen API-Schlüssel zur Authentifizierung erhalten, was eine Voraussetzung für die Verwendung der GPT-4o-API ist. Befolgen Sie diese Schritte, um Ihren ChatGPT-API-Schlüssel zu erhalten:

Schritt 1: Rufen Sie die API Keys-Seite auf OpenAI auf und melden Sie sich mit Ihrem Konto an (oder erstellen Sie ein neues Konto, falls Sie noch keines haben).

Schritt 2: Klicken Sie auf die Schaltfläche "Create new secret key", um einen neuen API-Schlüssel zu generieren.

Nachdem der API-Schlüssel generiert wurde, wird er sofort auf dem Bildschirm angezeigt. Sie können den API-Schlüssel jedoch nicht erneut anzeigen, daher wird empfohlen, ihn aufzuzeichnen und sicher zu speichern.

Testen und Verwalten der GPT-4o-API mit Apidog

Apidog ist ein unglaublich praktisches Tool für die Verwendung der GPT-4o-API. Apidog verfügt über ein OpenAI-API-Projekt, das alle von OpenAI bereitgestellten APIs abdeckt. Wenn Sie die von OpenAI bereitgestellten APIs überprüfen möchten, greifen Sie auf die folgende Seite zu:

Derzeit ist die GPT-4o-API nur in der Chat Completions API, Assistants API und Batch API verfügbar. Wählen Sie also jede aus dem linken Menü des OpenAI-API-Projekts aus, um mit der Verwendung der GPT-4o-API zu beginnen.

Schritt für Schritt: Verwenden der GPT-4o-API mit Apidog

Wenn Sie auf das OpenAI-API-Projekt auf Apidog zugreifen, können Sie die OpenAI-APIs ganz einfach testen, indem Sie diese Schritte ausführen. Gehen wir durch, wie Sie das GPT-4o mit der Chat Completions API verwenden.

Schritt 1: Greifen Sie auf das OpenAI-API-Projekt auf Apidog zu, wählen Sie den Chat Completions API-Endpunkt aus dem linken Menü aus und geben Sie auf dem neuen Anforderungsbildschirm die HTTP-Methode und die Endpunkt-URL gemäß der ChatGPT-Spezifikation ein. Schreiben Sie dann im Tab "Body" die Nachricht, die Sie an ChatGPT senden möchten, im JSON-Format.

Hinweis: Um GPT-4o zu verwenden, geben Sie das Modell als "gpt-4o" an, indem Sie "model":"gpt-4o" einschließen.

Schritt 2: Wechseln Sie zum Tab "Header", fügen Sie den Parameter "Authorization" hinzu, um sich bei der ChatGPT-API zu authentifizieren, geben Sie den ChatGPT-API-Schlüssel ein, den Sie erhalten haben, und klicken Sie auf die Schaltfläche "Senden".

Hinweis: In Apidog können Sie Ihren OpenAI-API-Schlüssel als Umgebungsvariable speichern. Das Speichern des OpenAI-API-Schlüssels als Umgebungsvariable bedeutet, dass Sie später direkt auf die Umgebungsvariable verweisen können, ohne den API-Schlüssel wiederholt eingeben zu müssen, was praktisch ist.

Zusammenfassung

In diesem Artikel haben wir eine detaillierte Erklärung des neuesten Modells von OpenAI, GPT-4o, gegeben. GPT-4o hat eine doppelt so lange Reaktionszeit wie frühere Modelle und kann Text, Bilder, Audio und Video verstehen. Darüber hinaus wurde die Anzahl der für Japanisch verwendeten Token reduziert, was die Kostenleistung verbessert.

Die GPT-4o-API ist in der Chat Completions API, Assistants API und Batch API verfügbar und bietet Funktionen wie höhere Intelligenz, 2x schnellere Reaktionsgeschwindigkeit, 50 % günstigere Preise, 5x höhere Ratenbegrenzung, verbesserte visuelle Fähigkeiten und verbesserte Fähigkeiten in nicht-englischen Sprachen im Vergleich zu den vorherigen ChatGPT-Modell-APIs.

Um die GPT-4o-API zu verwenden, müssen Sie zunächst ein OpenAI-Konto erstellen und einen API-Schlüssel erhalten. Dann können Sie mit Apidog die GPT-4o-API einfach testen und verwalten. Apidog verfügt über ein OpenAI-API-Projekt, das die GPT-4o-API-Spezifikationen abdeckt, und Sie können Ihren API-Schlüssel als Umgebungsvariable speichern, um eine erneute Eingabe zu vermeiden.

In Zukunft wird der GPT-4o-API Audio-Unterstützung hinzugefügt. Indem Sie die hervorragenden Funktionen von GPT-4o nutzen und in Ihre Dienste integrieren, können Sie ein noch besseres KI-Erlebnis bieten.