Die Veröffentlichung fortschrittlicher KI-Modelle wie Gemini 2.5 Pro von Google erzeugt große Begeisterung in der Entwickler-Community. Seine verbesserten Fähigkeiten in Bezug auf Argumentation, Programmierung und multimodales Verständnis versprechen, die Art und Weise, wie wir Anwendungen erstellen, zu revolutionieren. Der Zugriff auf modernste Modelle wirft jedoch oft Fragen zu Kosten und Verfügbarkeit auf. Viele Entwickler fragen sich: „Wie kann ich Gemini 2.5 Pro kostenlos nutzen?“ Während der direkte, unbegrenzte API-Zugriff in der Regel mit Kosten verbunden ist, gibt es legitime Möglichkeiten, mit diesem leistungsstarken Modell ohne Kosten zu interagieren, hauptsächlich über seine Weboberfläche und sogar programmatisch über Community-Projekte.

Der offizielle Weg, Gemini 2.5 Pro kostenlos zu nutzen: Die Weboberfläche

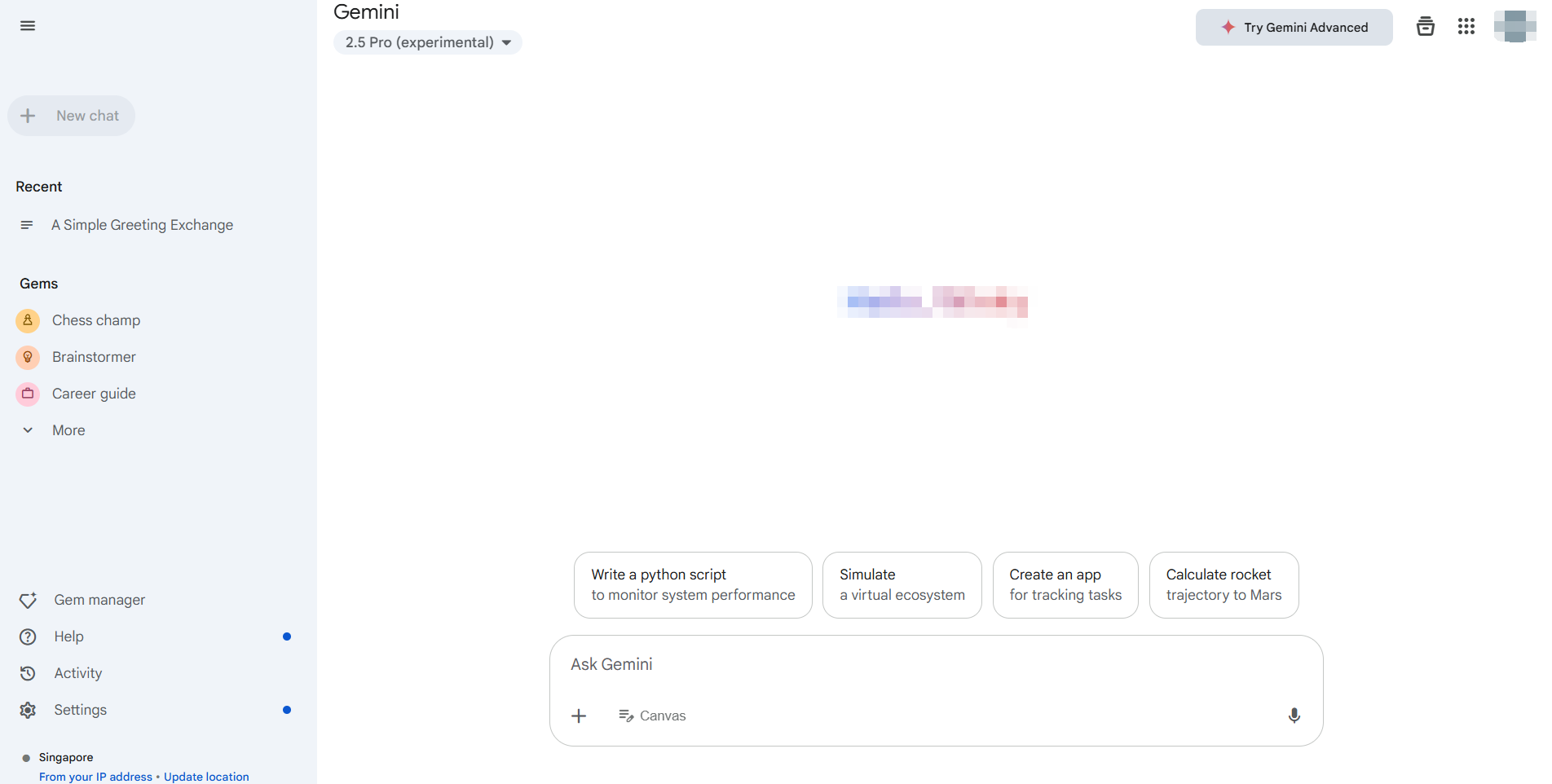

Die einfachste und offiziell unterstützte Methode, Gemini 2.5 Pro ohne Kosten zu nutzen, ist über die dedizierte Webanwendung, die in der Regel unter https://gemini.google.com/ erreichbar ist. Google bietet über diese Oberfläche allgemeinen Nutzern Zugriff auf seine neuesten Modelle, einschließlich Gemini 2.5 Pro (die Verfügbarkeit kann je nach Region und Kontostatus variieren).

Wichtige Vorteile der Weboberfläche:

- Keine Kosten: Dies ist das Standardangebot der kostenlosen Stufe für die direkte Interaktion.

- Voller Funktionszugriff: Sie können in der Regel die Kernfunktionen des Modells nutzen, einschließlich Texterstellung, Brainstorming, Programmierunterstützung und potenziell Bilderzeugung (wie bei Imagen3, je nach Verfügbarkeit) und Interaktionen mit Google Workspace-Erweiterungen (Gmail, Docs, Drive usw.).

- Benutzerfreundliche Benutzeroberfläche: Die Weboberfläche ist auf Benutzerfreundlichkeit ausgelegt und erfordert keine Einrichtung, außer der Anmeldung in Ihrem Google-Konto.

So verwenden Sie es:

- Navigieren Sie zur Gemini-Webanwendung.

- Melden Sie sich mit Ihrem Google-Konto an.

- Stellen Sie sicher, dass Gemini 2.5 Pro ausgewählt ist, wenn mehrere Modelle verfügbar sind (oft in den Einstellungen oder in der Nähe der Eingabeaufforderung angegeben).

5. Beginnen Sie mit der Interaktion! Geben Sie Ihre Eingabeaufforderungen ein, laden Sie Dateien hoch (falls unterstützt) und erkunden Sie die Möglichkeiten.

Für viele Benutzer und Entwickler, die Gemini 2.5 Pro evaluieren, Eingabeaufforderungen testen oder nicht-programmatische Aufgaben ausführen müssen, ist die offizielle Weboberfläche die ideale, kostenlose Lösung. Sie bietet direkten Zugriff auf die Leistung des Modells, ohne API-Schlüssel zu benötigen oder sich mit Nutzungsquoten auseinandersetzen zu müssen, die mit der kostenpflichtigen API verbunden sind. Diese Methode erfüllt perfekt die Notwendigkeit, Gemini 2.5 Pro kostenlos für die Erkundung und manuelle Interaktion zu nutzen.

Wie man Gemini 2.5 Pro programmatisch ohne direkte API-Kosten verwendet

Während die Weboberfläche für die manuelle Verwendung großartig ist, benötigen Entwickler oft programmatischen Zugriff für Integration, Automatisierung oder Stapelverarbeitung. Die offizielle Google Generative AI API für Modelle wie Gemini 2.5 Pro ist in der Regel mit Kosten verbunden, die auf der Token-Nutzung basieren. Die Entwickler-Community erstellt jedoch oft Tools, um diese Lücke zu schließen.

Ein solches Tool, das in Community-Ressourcen wie der Gemini API Python-Bibliothek hervorgehoben wird, ermöglicht es Entwicklern, programmatisch mit der kostenlosen Gemini-Weboberfläche zu interagieren.

Wichtiger Haftungsausschluss: Es ist wichtig zu verstehen, dass dies NICHT die offizielle Google Generative AI API ist. Diese Bibliotheken arbeiten, indem sie die privaten API-Aufrufe der Webanwendung reverse-engineeren und Browser-Cookies zur Authentifizierung verwenden.

- Inoffiziell: Nicht von Google unterstützt oder empfohlen.

- Potenziell instabil: Verlässt sich auf Elemente der Weboberfläche, die sich ohne Vorankündigung ändern können, wodurch die Bibliothek beschädigt wird.

- Sicherheitsaspekte: Erfordert das Extrahieren von Authentifizierungs-Cookies aus Ihrem Browser, was inhärente Sicherheitsrisiken birgt, wenn es nicht sorgfältig gehandhabt wird.

- Nutzungsbedingungen: Die Nutzung könnte gegen die Nutzungsbedingungen von Google für die Webanwendung verstoßen.

Trotz dieser Vorbehalte bieten solche Bibliotheken Entwicklern eine Möglichkeit, zu experimentieren und Gemini 2.5 Pro ohne Kosten zu nutzen, die über die Einschränkungen der kostenlosen Stufe der Weboberfläche selbst hinausgehen, jedoch auf automatisierte Weise.

Schritt-für-Schritt-Anleitung:

Voraussetzungen: Stellen Sie sicher, dass Sie Python 3.10+ installiert haben.

Installation: Installieren Sie die Bibliothek mit pip:

pip install -U gemini_webapi

# Optional: Install browser-cookie3 for easier cookie fetching

pip install -U browser-cookie3Authentifizierung (Der knifflige Teil):

- Melden Sie sich in Ihrem Webbrowser bei

gemini.google.coman. - Öffnen Sie die Entwickler-Tools (F12), gehen Sie zur Registerkarte

Networkund aktualisieren Sie die Seite. - Suchen Sie eine Anfrage (jede Anfrage funktioniert normalerweise).

- Suchen Sie in den Anforderungsheadern (normalerweise unter "Cookies") die Werte für

__Secure-1PSIDund__Secure-1PSIDTSund kopieren Sie sie. Behandeln Sie diese wie Passwörter! - Alternative: Wenn

browser-cookie3installiert ist, kann die Bibliothek möglicherweise Cookies automatisch importieren, wenn Sie sich über einen unterstützten Browser angemeldet haben, wodurch dieser Schritt vereinfacht wird, aber dennoch vom lokalen Browserzustand abhängig ist.

Initialisierung & Grundlegende Verwendung:

import asyncio

from gemini_webapi import GeminiClient

from gemini_webapi.constants import Model # Import Model constants

# --- Authentication ---

# Method 1: Manually paste cookies (handle securely!)

Secure_1PSID = "YOUR__SECURE_1PSID_COOKIE_VALUE"

Secure_1PSIDTS = "YOUR__SECURE_1PSIDTS_COOKIE_VALUE" # May be optional

async def run_gemini():

# Method 2: Use browser-cookie3 (if installed and logged in)

# client = GeminiClient(proxy=None) # Attempts auto-cookie import

# Initialize with manual cookies

client = GeminiClient(Secure_1PSID, Secure_1PSIDTS, proxy=None)

await client.init(timeout=30) # Initialize connection

# --- Select Model and Generate Content ---

prompt = "Explain the difference between REST and GraphQL APIs."

# Use the Gemini 2.5 Pro model identifier

print(f"Sending prompt to Gemini 2.5 Pro...")

response = await client.generate_content(prompt, model=Model.G_2_5_PRO) # Use the specific model

print("\nResponse:")

print(response.text)

# Close the client session (important for resource management)

await client.close()

if __name__ == "__main__":

asyncio.run(run_gemini())Hier finden Sie weitere Integrationsdetails.

Weitere Erkundung: Bibliotheken wie diese unterstützen oft Funktionen, die in der Weboberfläche verfügbar sind, wie z. B. Multi-Turn-Chat (client.start_chat()), Datei-Uploads, Bilderzeugungsanfragen und die Verwendung von Erweiterungen (@Gmail, @Youtube), die die Funktionen der Web-App programmatisch widerspiegeln.

Denken Sie daran, dass dieser Ansatz die Interaktion mit der kostenlosen Weboberfläche automatisiert, nicht die kostenpflichtige API. Er ermöglicht programmatisches Experimentieren mit Gemini 2.5 Pro ohne direkte API-Kosten, birgt aber erhebliche Zuverlässigkeits- und Sicherheitswarnungen.

Die Debugging-Herausforderung mit LLMs

Unabhängig davon, ob Sie über das Web, die offizielle API oder inoffizielle Bibliotheken mit Gemini 2.5 Pro interagieren, ist das Verstehen und Debuggen der Antworten entscheidend, insbesondere wenn es um komplexe oder Streaming-Ausgaben geht. Viele LLMs, insbesondere in API-Form, verwenden Server-Sent Events (SSE), um Antworten Token für Token oder Chunk für Chunk zu streamen. Dies vermittelt ein Echtzeitgefühl, kann aber mit Standard-HTTP-Clients schwer zu debuggen sein.

Traditionelle API-Testtools zeigen möglicherweise einfach Rohdaten von SSE an: Chunks, wodurch es schwierig wird, die vollständige Nachricht zusammenzusetzen oder den Informationsfluss zu verstehen, insbesondere den „Denkprozess“ des Modells, falls vorhanden. Hier wird ein spezialisiertes Tool unschätzbar wertvoll.

Einführung von Apidog: Eine umfassende All-in-One-API-Entwicklungsplattform, die für den gesamten API-Lebenszyklus entwickelt wurde – von Design und Dokumentation bis hin zu Debugging, automatisiertem Testen und Mocking. Obwohl Apidog in allen Bereichen leistungsstark ist, zeichnet es sich insbesondere durch die Handhabung moderner API-Protokolle aus, was es zu einem außergewöhnlichen API-Testtool für Entwickler macht, die mit LLMs arbeiten. Seine SSE-Debugging-Funktionen sind speziell darauf ausgelegt, die Herausforderungen von Streaming-Antworten zu bewältigen.

Beherrschen Sie Echtzeit-LLM-Antworten

Die Arbeit mit LLMs wie Gemini 2.5 Pro beinhaltet oft Server-Sent Events (SSE) für das Streaming von Ergebnissen. Diese Technologie ermöglicht es dem KI-Modell, Daten in Echtzeit an Ihren Client zu senden und generierten Text oder sogar Argumentationsschritte anzuzeigen, während sie geschehen. Obwohl dies für die Benutzererfahrung großartig ist, kann das Debuggen von rohen SSE-Streams in einfachen Tools ein Albtraum aus fragmentierten Nachrichten sein.

Apidog verwandelt als führendes API-Testtool das SSE-Debugging von einer lästigen Pflicht in einen klaren Prozess. So hilft Ihnen Apidog, LLM-Streams zu zähmen:

- Automatische SSE-Erkennung: Wenn Sie mit Apidog eine Anfrage an einen LLM-Endpunkt senden und der Antwortheader

Content-Typetext/event-streamist, erkennt Apidog ihn automatisch als SSE-Stream. - Echtzeit-Zeitachsenansicht: Anstatt nur rohe

data:-Zeilen auszugeben, präsentiert Apidog die eingehenden Nachrichten chronologisch in einer dedizierten „Zeitachsen“-Ansicht. Auf diese Weise können Sie den Informationsfluss genau so sehen, wie der Server ihn sendet. - Intelligentes automatisches Zusammenführen: Dies ist ein Game-Changer für das LLM-SSE-Debugging. Apidog verfügt über eine integrierte Intelligenz, um gängige Streaming-Formate zu erkennen, die von großen KI-Anbietern verwendet werden, darunter:

- OpenAI API Compatible Format (von vielen verwendet)

- Gemini API Compatible Format

- Claude API Compatible Format

- Ollama API Compatible Format (für lokal ausgeführte Modelle, oft JSON Streaming/NDJSON)

Wenn der Stream mit diesen Formaten übereinstimmt, führt Apidog automatisch die einzelnen Nachrichtenfragmente (data:-Chunks) in die vollständige, kohärente endgültige Antwort oder Zwischenschritte zusammen. Kein manuelles Kopieren und Einfügen von Chunks mehr! Sie sehen das ganze Bild, wie die KI es beabsichtigt hat.

4. Visualisierung des Denkprozesses: Für Modelle, die ihre Argumentation oder „Gedanken“ zusammen mit dem Hauptinhalt streamen (wie bestimmte Konfigurationen von DeepSeek), kann Apidog diese Metainformationen oft übersichtlich in der Zeitachse anzeigen und so unschätzbare Einblicke in den Prozess des Modells liefern.

Die Verwendung von Apidog für das SSE-Debugging bedeutet, dass Sie eine klare, Echtzeit- und oft automatisch strukturierte Ansicht erhalten, wie Ihr LLM-Endpunkt antwortet. Dies macht es deutlich einfacher, Probleme zu identifizieren, den Generierungsprozess zu verstehen und sicherzustellen, dass die endgültige Ausgabe korrekt ist, im Vergleich zu generischen HTTP-Clients oder herkömmlichen API-Testtools, denen die spezialisierte SSE-Verarbeitung fehlt.

Fazit: Kostenloser Zugriff auf Gemini 2.5 Pro

Sie können Gemini 2.5 Pro kostenlos über seine offizielle Weboberfläche erkunden. Entwickler, die nach API-ähnlichem Zugriff ohne Gebühren suchen, können community-basierte Tools ausprobieren, obwohl diese mit Risiken wie Instabilität und potenziellen Nutzungsbedingungen verbunden sind.

Für die Arbeit mit LLMs wie Gemini – insbesondere beim Umgang mit Streaming-Antworten – schießen herkömmliche Tools zu kurz. Hier glänzt Apidog. Mit Funktionen wie automatischer SSE-Erkennung, Zeitachsenansichten und intelligentem Zusammenführen fragmentierter Daten macht Apidog das Debuggen von Echtzeit-Antworten viel einfacher. Seine benutzerdefinierte Parser-Unterstützung rationalisiert zudem komplexe Workflows und macht es zu einem Muss für die moderne API- und LLM-Entwicklung.