Google treibt seine KI-Angebote mit der Einführung von Gemini 3 Flash weiter voran. Dieses Modell kombiniert Intelligenz auf Spitzenniveau mit außergewöhnlicher Geschwindigkeit und Effizienz. Entwickler und Unternehmen erhalten nun Zugang zu hochleistungsfähiger KI, ohne Kompromisse bei Latenz oder Kosten eingehen zu müssen.

Übersicht über Gemini 3 Flash: Hauptmerkmale und Veröffentlichungsdetails

Google hat Gemini 3 Flash am 17. Dezember 2025 veröffentlicht. Forscher entwickelten dieses Modell, um ein Pro-Level-Schlussfolgern zu liefern, während die für die Flash-Serie charakteristische geringe Latenz beibehalten wird. Folglich ersetzt es Gemini 2.5 Flash als Standardmodell in der Gemini-App und im AI-Modus in der Google-Suche.

Gemini 3 Flash glänzt bei vielfältigen Aufgaben. Es bewältigt Coding, komplexe Analysen, interaktive Anwendungen, agentische Workflows und multimodales Schlussfolgern effektiv. Darüber hinaus verarbeitet das Modell Videos, Bilder und Audioeingaben nativ. Entwickler nutzen diese Fähigkeiten für Echtzeit-Assistenz, Datenextraktion und visuelle Fragenbeantwortung.

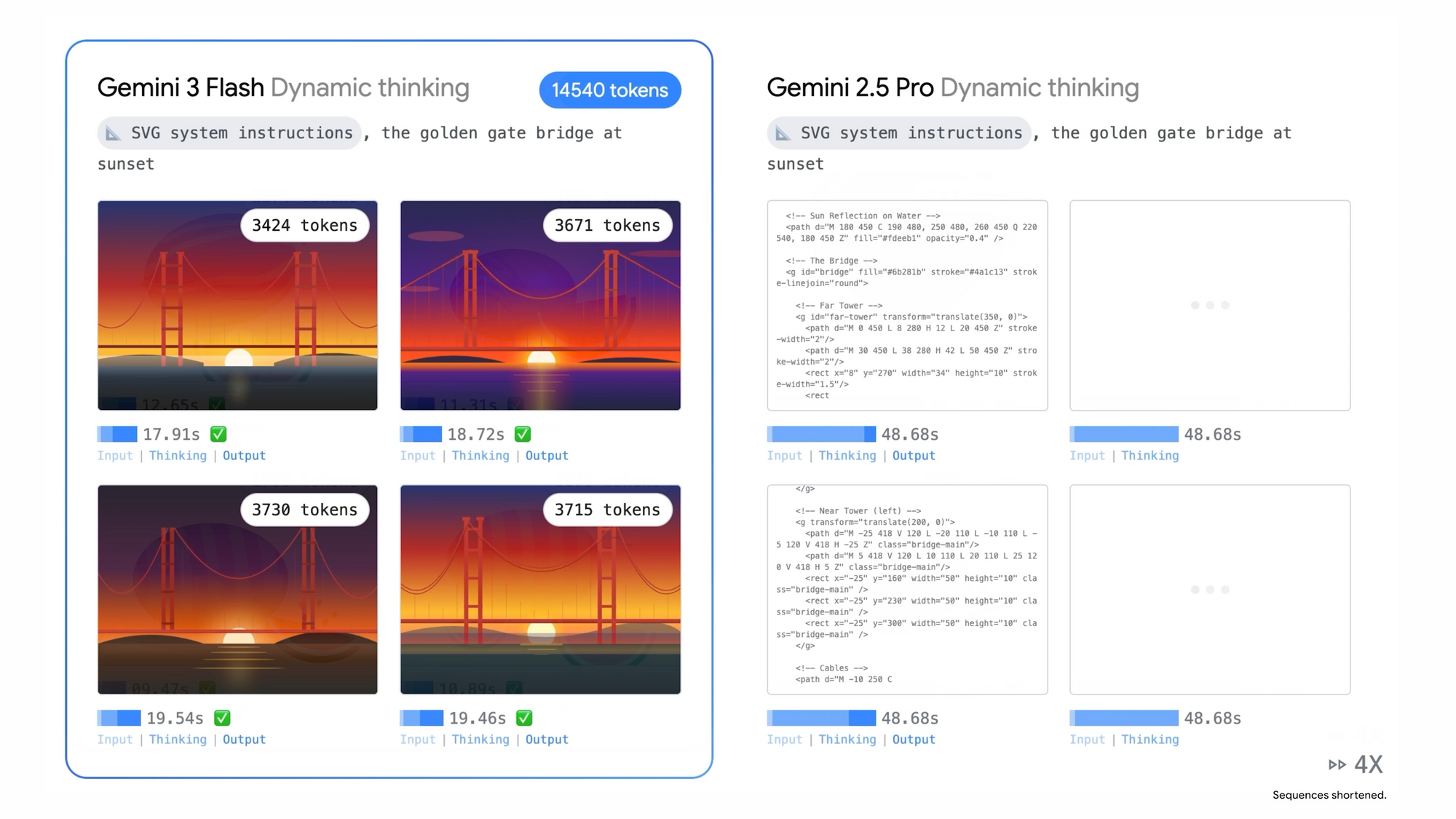

Ein herausragendes Merkmal ist der adaptive Denkmechanismus des Modells. Es moduliert die Berechnung basierend auf der Komplexität der Anfrage, was zu durchschnittlich 30 % weniger verbrauchten Tokens bei Routineaufgaben im Vergleich zu Gemini 2.5 Pro führt. Diese Effizienz führt direkt zu reduzierten Betriebskosten in Produktionsumgebungen.

Zusätzlich unterstützt Gemini 3 Flash hochfrequente Workflows. Unternehmen setzen es für nahezu Echtzeit-Interaktionen ein, beispielsweise bei KI-Assistenten in Spielen oder schnellen A/B-Testszenarien. Unternehmen wie JetBrains, Figma und Bridgewater Associates nutzen das Modell bereits für transformative Anwendungen.

Performance-Benchmarks: Wie Gemini 3 Flash abschneidet

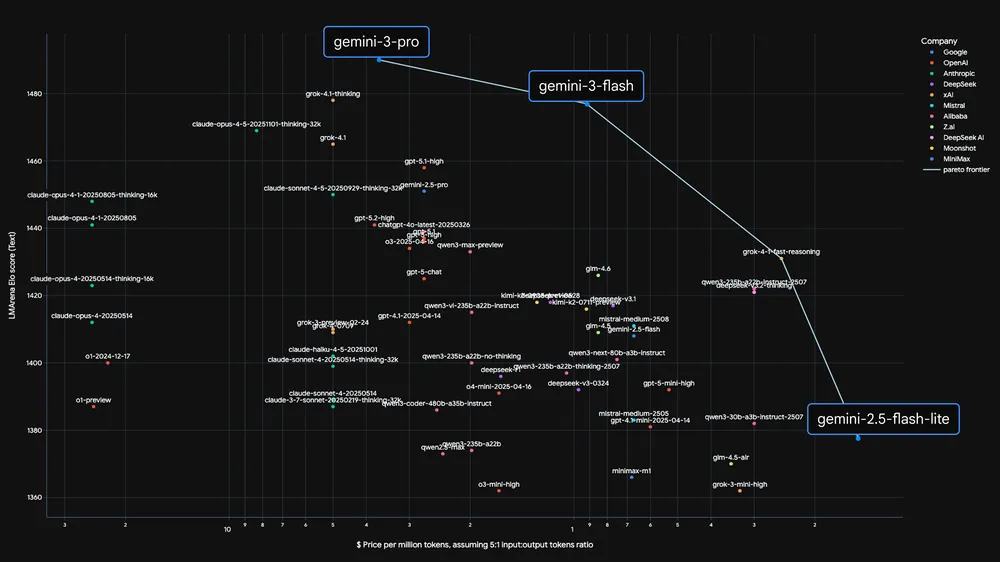

Unabhängige Evaluierungen belegen die überragenden Fähigkeiten von Gemini 3 Flash. Benchmarks von Artificial Analysis zeigen, dass das Modell dreimal schneller arbeitet als Gemini 2.5 Pro und es gleichzeitig in Qualitätsmetriken übertrifft.

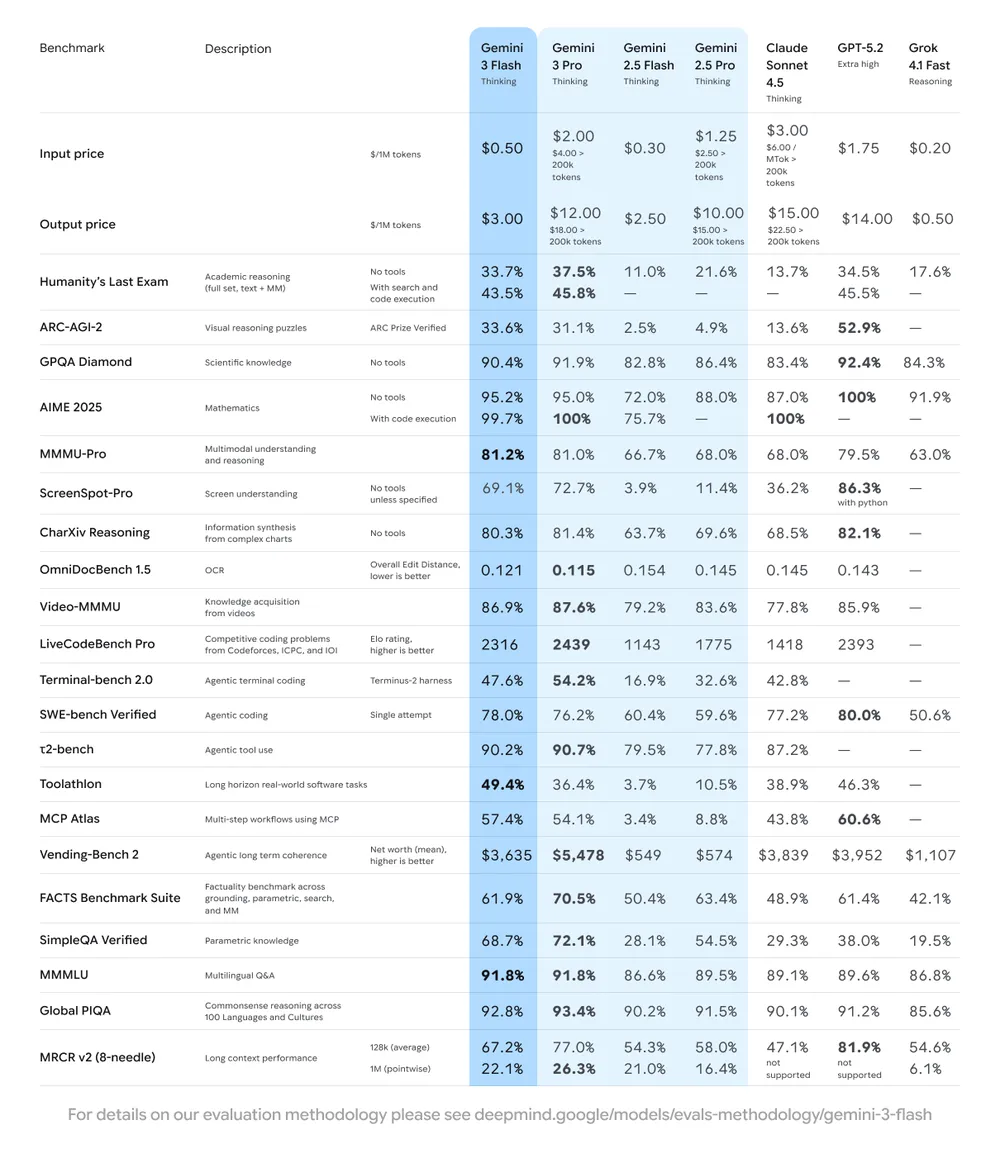

Insbesondere erzielt Gemini 3 Flash beeindruckende Ergebnisse bei anspruchsvollen Evaluierungen:

- GPQA Diamond: 90,4 % – spiegelt die Schlussfolgerungsfähigkeit auf PhD-Niveau wider.

- Humanity’s Last Exam (ohne Werkzeuge): 33,7 %.

- MMMU Pro: 81,2 % – hochmodernes multimodales Verständnis, das Gemini 3 Pro erreicht.

- SWE-bench Verified: 78 % – führende Leistung bei Coding-Agenten-Aufgaben.

Diese Ergebnisse positionieren Gemini 3 Flash an der Pareto-Grenze für Geschwindigkeit versus Qualität. Darüber hinaus übertrifft es größere Modelle in der Effizienz, während es die Spitzenintelligenz in den Bereichen Schlussfolgern, Vision und agentisches Coding beibehält.

Im Vergleich zu seinem Vorgänger Gemini 2.5 Flash liefert das neue Modell in allen Kategorien erhebliche Verbesserungen. Es konkurriert auch vorteilhaft mit aktuellen Spitzenmodellen und erreicht oder übertrifft oft Gemini 3 Pro in spezifischen Bereichen bei deutlich geringerer Latenz.

Multimodale Fähigkeiten: Jenseits der Textverarbeitung

Gemini 3 Flash verarbeitet multimodale Eingaben nahtlos. Entwickler füttern es mit Bildern, Videos und Audio neben Textaufforderungen. Zum Beispiel analysiert das Modell kurze Videoclips, um umsetzbare Erkenntnisse zu generieren, wie personalisierte Trainingspläne aus Sportaufnahmen.

Bei visuellen Aufgaben identifiziert Gemini 3 Flash Elemente in Skizzen nahezu in Echtzeit. Es überlagert statische Bilder mit kontextuellen UI-Elementen und verwandelt sie in interaktive Prototypen. Zusätzlich ermöglicht die Audioverarbeitung dem Modell, Aufnahmen zu überprüfen, Wissenslücken zu erkennen und maßgeschneiderte Quizfragen mit Erklärungen zu erstellen.

Diese Funktionen erstrecken sich auf fortgeschrittene Anwendungen. Entwickler bauen Systeme, die unstrukturierte Sprachbefehle in funktionale Anwendungen umwandeln. Das Modell führt auch komplexe Datenextraktion aus visuellen Inhalten durch und unterstützt vibe-basierte Codierungsparadigmen.

Insgesamt treibt die multimodale Integration Gemini 3 Flash zu praktischen Anwendungen in der Robotik, Augmented Reality und Content-Erstellung voran.

Geschwindigkeit, Effizienz und technische Architektur

Ingenieure optimierten Gemini 3 Flash für eine hohe Inferenzgeschwindigkeit. Es erreicht eine geringe Latenz, die für reaktionsschnelle Anwendungen, einschließlich Spiele und Live-Agenten, geeignet ist. Diese Optimierung resultiert aus architektonischen Verfeinerungen, die den Durchsatz priorisieren, ohne die Schlussfolgerungstiefe zu opfern.

Das Modell verarbeitet täglich über eine Billion Tokens über die Gemini API, was seine Skalierbarkeit unterstreicht. Darüber hinaus reduzieren Effizienzverbesserungen bei den Tokens die Kosten für alltägliche Operationen.

Entwickler können in der Gemini-App zwischen den Modi „Fast“ und „Thinking“ wählen. Ersterer priorisiert schnelle Antworten, während letzterer zusätzliche Rechenleistung für komplexe Probleme bereitstellt. Diese Flexibilität gewährleistet eine optimale Leistung in verschiedenen Anwendungsfällen.

Preisstruktur: Kostengünstiger Zugang zu Spitzen-KI

Google bepreist Gemini 3 Flash wettbewerbsfähig, um eine breite Akzeptanz zu fördern. Die API kostet 0,50 $ pro Million Eingabe-Tokens und 3 $ pro Million Ausgabe-Tokens. Audioeingaben kosten 1 $ pro Million Tokens.

Im Vergleich zu Gemini 2.5 Flash (0,30 $ Eingabe / 2,50 $ Ausgabe pro Million) spiegelt die leichte Erhöhung verbesserte Fähigkeiten wider. Die Gesamtkosten sinken jedoch oft aufgrund des reduzierten Token-Verbrauchs bei Denkaufgaben.

Kostenloser Zugang bleibt über die Gemini-App für globale Nutzer verfügbar. Entwickler experimentieren in Google AI Studio mit großzügigen Ratenlimits. Bezahlte Stufen schalten höhere Kontingente und Unternehmensfunktionen über Vertex AI frei.

Dieses Preismodell positioniert Gemini 3 Flash als kostengünstiges Arbeitspferd. Es bietet Spitzenleistung zu einem Bruchteil der Kosten größerer Modelle.

Verfügbarkeit und Entwicklerintegrationen

Gemini 3 Flash wird unmittelbar nach der Veröffentlichung weltweit eingeführt. Nutzer greifen direkt in der Gemini-App darauf zu, wo es als Standardmodell dient.

Entwickler integrieren über mehrere Plattformen:

- Google AI Studio für das Prototyping.

- Gemini CLI und Google Antigravity für die Agentenentwicklung.

- Android Studio für mobile Anwendungen.

- Vertex AI und Gemini Enterprise für Produktionsbereitstellungen.

Der Vorabzugang ermöglicht es Unternehmen, das Modell in kontrollierten Umgebungen zu evaluieren. Darüber hinaus demonstrieren Integrationen mit Tools wie Cursor und Harvey die reale Akzeptanz.

Integration der Gemini 3 Flash API: Praktische Überlegungen

Entwickler konfigurieren API-Anfragen über Standard-REST-Endpunkte. Anfragen enthalten JSON-Payloads, die das Modell („gemini-3-flash“) und die Inhaltskomponenten spezifizieren.

Die Authentifizierung erfordert einen API-Schlüssel von Google AI Studio. Darüber hinaus enthalten multimodale Anfragen base64-kodierte Medien oder URLs.

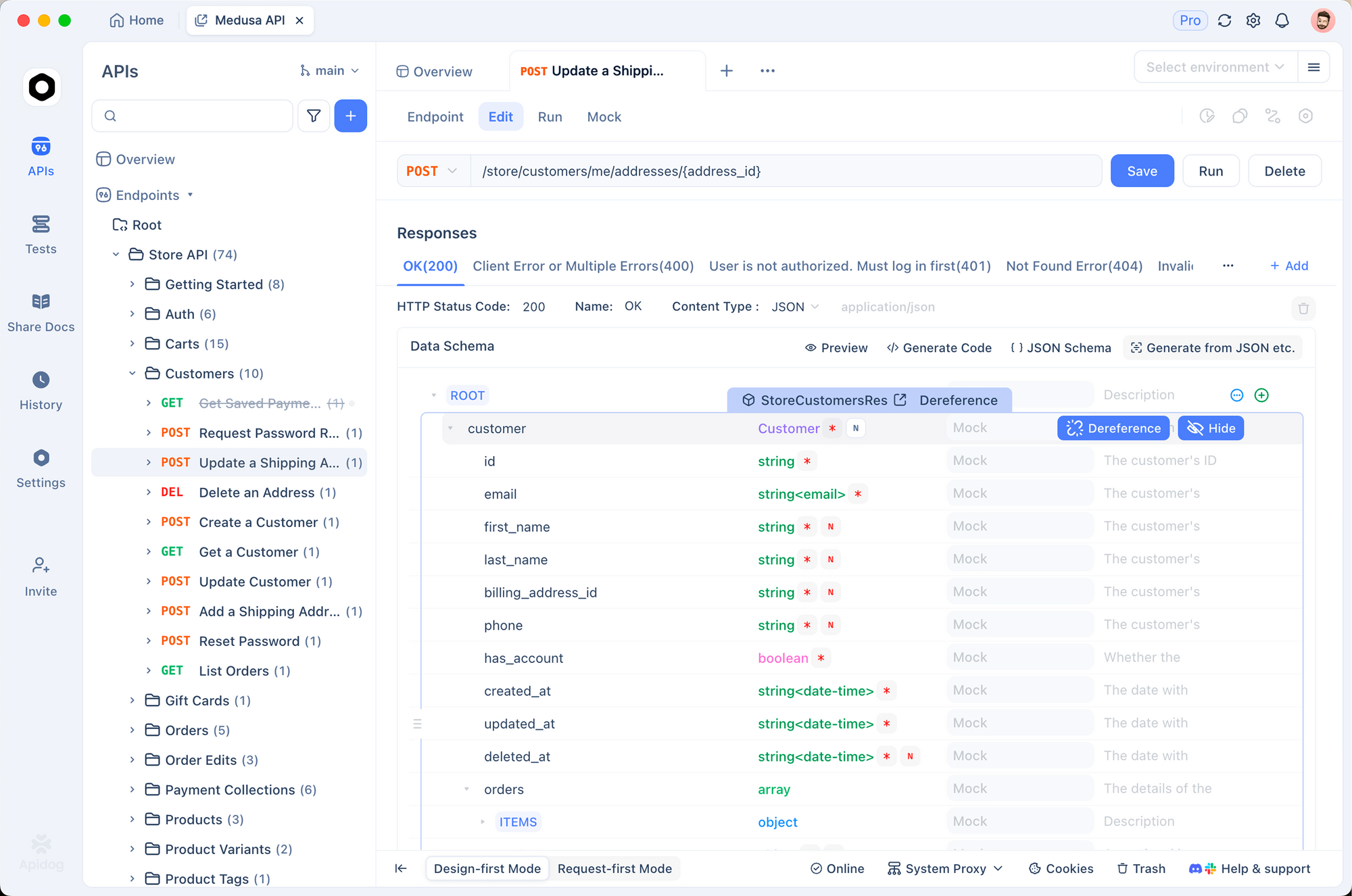

Eine effektive Integration erfordert gründliche Tests. Tools wie Apidog erweisen sich hier als unschätzbar wertvoll. Apidog bietet eine umfassende Plattform für API-Design, Mocking, Debugging und automatisierte Tests.

Entwickler importieren beispielsweise Gemini API-Spezifikationen in Apidog. Sie generieren dann Mock-Server für die Frontend-Zusammenarbeit, erstellen Testsuiten zur Überprüfung der Antwortformate und überwachen den Token-Verbrauch. Apidog unterstützt Umgebungsvariablen für den nahtlosen Wechsel zwischen Vorschau- und stabilen Endpunkten.

Darüber hinaus verarbeitet Apidog multimodale Payloads effizient. Benutzer laden Dateien direkt hoch, überprüfen detaillierte Antworten und validieren strukturierte Ausgaben. Dieser Workflow beschleunigt die Iterationszyklen erheblich.

In agentischen Anwendungen erleichtert Apidog die Validierung von Tool-Aufrufen. Entwickler definieren erwartete Schemata und stellen automatisch die Einhaltung sicher.

Anwendungsfälle: Praxisanwendungen von Gemini 3 Flash

Unternehmen setzen Gemini 3 Flash in verschiedenen Bereichen ein. In der Softwareentwicklung treibt es intelligente Code-Assistenten an, die Code in großem Maßstab generieren, refaktorisieren und debuggen.

Content-Plattformen nutzen multimodale Funktionen für die automatisierte Moderation und Verbesserung. Zum Beispiel analysieren Systeme von Benutzern hochgeladene Medien, um Verbesserungen vorzuschlagen oder Metadaten zu extrahieren.

Interaktive Anwendungen profitieren von geringer Latenz. Spieleentwickler implementieren dynamische NPCs, die in Echtzeit kontextbezogen reagieren.

Zusätzlich nutzen analytische Workflows das Modell für die schnelle Generierung von Erkenntnissen aus unstrukturierten Daten. Bridgewater Associates setzt ähnliche Fähigkeiten für die Finanzmodellierung ein.

Bildungstools schaffen personalisierte Lernerfahrungen. Das Modell verarbeitet Vorlesungsaufnahmen, um Lücken zu identifizieren und Remedial-Inhalte zu produzieren.

Vergleich mit früheren Gemini-Modellen

Gemini 3 Flash baut direkt auf der Grundlage der Gemini 3-Serie auf. Es behält komplexe Schlussfolgerungsfähigkeiten und multimodale Stärken bei, während es für Geschwindigkeit und Kosten optimiert ist.

Im Vergleich zu Gemini 2.5 Pro liefert es eine dreimal schnellere Inferenz mit überlegener Benchmark-Leistung. Die Token-Effizienz erweitert den praktischen Vorteil zusätzlich.

Gegenüber Gemini 2.5 Flash manifestiert sich das Upgrade in der Schlussfolgerungstiefe und der multimodalen Genauigkeit. Nutzer erleben gleichzeitig „Intelligenz und Geschwindigkeit“.

Zukünftige Auswirkungen und Fazit

Gemini 3 Flash setzt einen neuen Standard für zugängliche Spitzen-KI. Seine Kombination aus Leistung, Effizienz und Preisgestaltung demokratisiert fortschrittliche Fähigkeiten.

Entwickler bauen nun reaktionsschnelle, intelligente Anwendungen ohne prohibitive Kosten. Unternehmen skalieren KI-Implementierungen selbstbewusst.

Um mit dem Experimentieren zu beginnen, generieren Sie einen API-Schlüssel in Google AI Studio und testen Sie Anfragen. Kombinieren Sie dies mit Apidog für eine optimierte Entwicklung – laden Sie es kostenlos herunter und beschleunigen Sie Ihre Gemini 3 Flash-Integrationen.

Dieses Modell signalisiert einen weiterhin raschen Fortschritt in der KI. Nachfolgende Iterationen werden die Grenzen wahrscheinlich weiter verschieben, aber Gemini 3 Flash bietet bereits heute einen erheblichen Wert.